Buddhismus bis Islam – Wie ChatGPT Heilige Schriften zusammenfasst

Nach meiner Auffassung befinden wir uns bereits mitten in der Medienrevolution von der quartären (digitalen) in die quintäre (virtuell-crossmediale) Medienwelt: Neben die VR-Brillen verändern sich schnell entwickelnde KI-Algorithmen (Artikel zu GPT4) schon jetzt Wissenschaft und Bildung, unser Philosophieren samt der Grund-Weltanschauungen und sogar unser politisches Selbstverständnis. Anstelle eines dystopischen, letztlich dualistischen “KI-Erwachens” zeichnen sich dabei Fortschritte beim Verstehen von monistischen Emergenzen ab – was wiederum unser wissenschaftliches wie politisches Denken beflügeln kann.

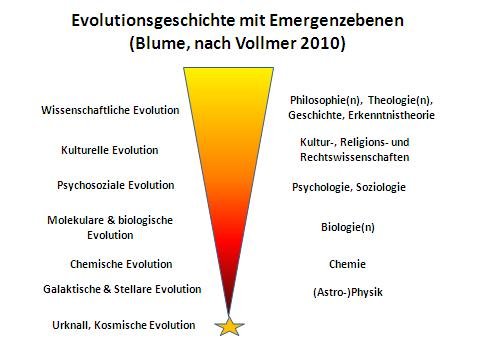

Schaubild von 2013 zur evolutionären Emergenztheorie. Grafik: Michael Blume

Schaubild von 2013 zur evolutionären Emergenztheorie. Grafik: Michael Blume

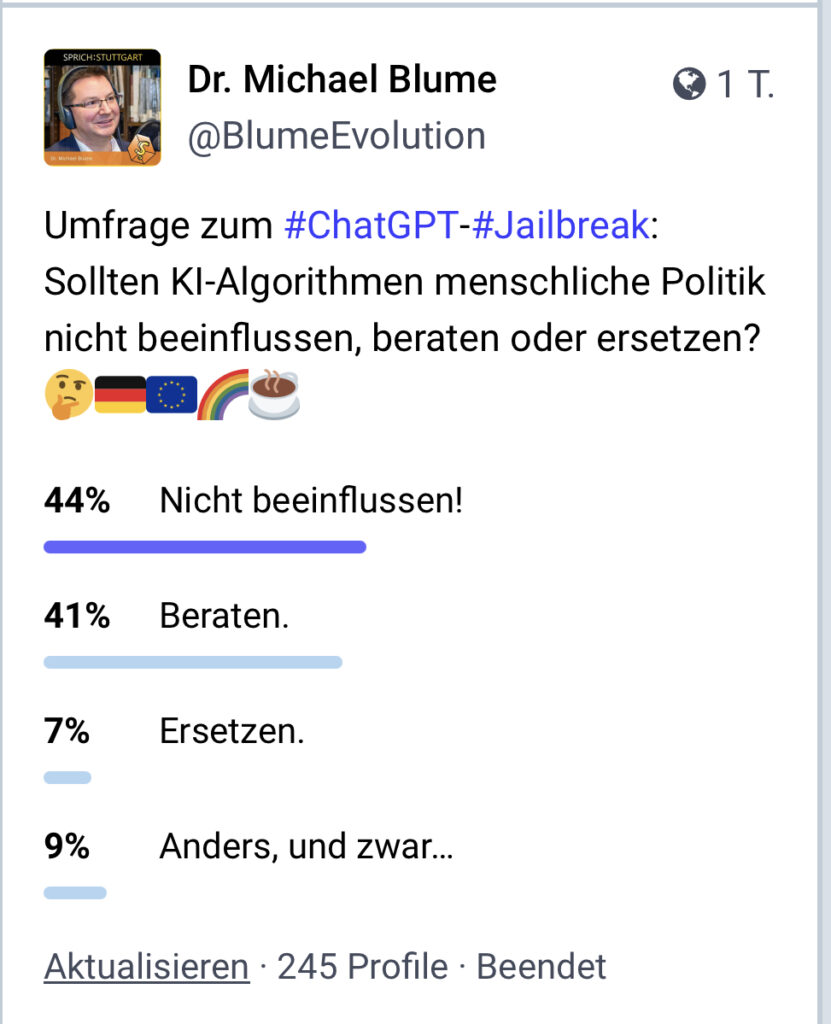

Entsprechend begrüße ich auch die – teilweise heftigen – Debatten, mit denen sich immer mehr Menschen Wissen um KI-Algorithmen aneignen. Trotz vieler “geschockter” Reaktionen auf die Jailbreak-Antworten von letzter Woche sah schon eine relative Mehrheit von 48 Prozent der Antwortenden auf Mastodon in KI-Algorithmen eine Chance auf “Beratung” (41 Prozent) oder gar “Ersetzung” (7 Prozent) menschlicher Politik, noch 44% lehnten dagegen jede Beeinflussung ab. Auf Twitter – wo die Umfrage noch läuft – ist die Zustimmung zu den Künstlichen Intelligenzen sogar noch größer.

Mastodon-Umfrage zu ChatGPT, @BlumeEvolution@sueden.social

Mastodon-Umfrage zu ChatGPT, @BlumeEvolution@sueden.social

Zu Weltreligionen hat nun der katholische Instagrammer Felix Kramm (Insta: @felix.kramm) ChatGPT gefragt und die Antworten visuell aufbereitet. Mit seiner Erlaubnis gebe ich seine Ergebnisse hier wieder.

Felix schrieb: “Ich habe ChatGPT die Heiligen Bücher von Weltreligionen zusammenfassen lassen. Die Antworten waren lang und ausführlich. Also sagte ich immer wieder “kürzer” – und das kam heraus.”

Instagram-Kachel von Felix Kramm zu ChatGPT und Kurzversionen der Heiligen Schriften. Screenshot mfG: Michael Blume

Den Pali-Kanon des Buddhismus fasste ChatGPT zusammen als: “Erleuchtung durch Achtsamkeit“

Kramm-Kachel zum buddhistischen Pali-Kanon. Screenshot mfG: Michael Blume

Die Thora-Schriftrollen des Judentums (und dessen Auslegungen, etwa des Talmud?) komprimierte ChatGPT als: “Tora: Gott, Gebote, Ethik“

Kramm-Kachel zur Moses-Tora der hebräischen Bibel. Screenshot mfG: Michael Blume

Den Koran der Musliminnen und Muslime deutete ChatGPT passend zum aktuellen Ramadan als: “Der Koran lehrt die Einheit Gottes und moralische Werte.“

Kramm-Kachel zur Heiligen Schrift des Islam, dem Koran. Screenshot mfG: Michael Blume

Und ob sich auch Christinnen und Christen in der ChatGPT-Interpretation der christlichen Bibel wiederfinden? Sie lautet schlicht: “Die Bibel verkündet Gottes Liebe.“

Kramm-Kachel zur christlichen Bibel. Screenshot mfG: Michael Blume

Selbstverständlich lassen sich diese Zusammenfassungen immer auch kritisch betrachten. So fehlt mir persönlich beim Buddhismus der Hinweis auf die Meditation, bei der Thora das “h”, die Weisheit und Wegweisung. Dennoch finde ich die Zusammenfassungen sehr beachtlich und fühlte mich spontan an ein (weiteres) Zitat aus Hans Blumenberg, “Arbeit am Mythos“, S. 34 erinnert: “Die Theorie sieht im Mythos ein Ensemble von Antworten auf Fragen, wie sie selbst es ist oder sein will. Das zwingt sie bei Ablehnung der Antworten zur Anerkennung der Fragen.“

Insofern begrüße ich es sehr, dass sich immer mehr Menschen kritisch-konstruktiv mit K.I.-Algorithmen wie ChatGPT befassen – die bereits jetzt in unsere Mitwelt hineinwachsen -, dass wir immer besser Emergenzen verstehen und dass wir damit den Übergang in die crossmedial-virtuelle Realität mitgestalten können.

Einen Text oder Sachverhalt auf wenige Sätze hin zu kondensieren ist für mich eine der wichtigsten Fähigkeiten im Umgang mit Sprache und Abstraktion. Hinter einem solchen Kondensat/Konzentrat steckt immer auch eine bestimmte Sicht, denn nur der Fokus auf wenige Aspekte einer Sache erlaubt überhaupt eine Kurzfassung eines Sachverhalts.

Fazit: Die Fähigkeit von ChatGPT Texte zu filtern, zu kürzen und zusammenzufassen bedeuten, dass ChatGPT über ein gewisses Mass an Textverständnis verfügt.

Die Heiligen Schriften und die Künstliche Intelligenz

Die Heiligen Schriften auf einen Satz zu reduzieren ist so wie von einem Menschen ein Röntgenbild machen und dann sagen “das ist der Mensch”.

Wenn man eine religiöse Schrift liest, und dann noch mal liest und später wieder liest, jedesmal liest man etwas anderes heraus.

Deswegen heißt z.B. die Bibel, das Buch der Bücher.

Für einfache Tatsachen ist die ChatGPT ein schnelles Nachschlagewerk.

Bei komplizierten Sachverhalten , wo es selbst in der Wissenschaft gegesätzliche Meinungen gibt, ist die ChatGPT überfordert.

Bei religiösen Büchern sollte die ChatGPT besser schweigen.(Tabuzone)

@lionoil(Zitat): “Für einfache Tatsachen ist die ChatGPT ein schnelles Nachschlagewerk.“

Falsch, ChatGPT ist kein Nachschlagewerk, sondern eine Frage-/Antwort -Maschine. Ich interessiere mich gerade für Philosophie und habe ChatGPT gefragt: „Wie sah Marx das Ende der Geschichte?“ und ChatGPT antwortete Marx und der Marxismus hätten kein finales Ende der Geschichte vorausgesagt, sondern eine nie endende Entwicklung.

Falls diese Antwort korrekt ist, war sie äusserst hilfreich, denn mit einem Nachschlagewerk allein und Recherche können sie Stunden verbringen um so eine Frage zu beantworten.

Tja und IST die Antwort korrekt?

Warum sollten gerade religiöse Bücher das Tabu für sowas sein?

Und nein, auch einfache Tatsachen werden nicht immer richtig dargestellt; bei den wissenschaftlichen Dingen ist übrigens nicht “viele/verschiedene Meinungen” das Problem, sondern die korrekte Darstellung von Zusammenhängen.

Ich denke eher, dass es sehr gut in dem Textbestand suchen kann, aber über kein Verständnis verfügt. Die Frage wäre also eher aus welcher Quelle ChatGPT die “Kurzfassungen” hat.

Außerdem halluziniert ChatGPT auch sehr fleißig, generiert also Texte, die völlig fernab jeglicher Fakten sind. Das ist nicht nur bei Mathe und Physik so, auch bei Dingen, die man einfach in der Wikipedia z.B. nachschlagen könnte.

Es gab da z.B. ein Beispiel wenn man ChatGPT nach den deutschen Gewinnern der Fields-Medaille fragt. Statt korrekt zwei zu nennen, fallen ChatGPT jede Menge ein … teilweise auch noch mit falschen Lebensläufen etc.

@einer(Zitat): “Ich denke eher, dass es sehr gut in dem Textbestand suchen kann, aber über kein Verständnis verfügt. “

Was ChatGPT macht geht weit über eine Google-Suchanfrage hinaus. ChaGPT kann Fragen beantworten wie sie in Prüfungen für Mediziner, Juristen, Geisteswissenschaftler gestellt werden. Selbst wenn man ihm physikalische Fragen stellt schneidet ChatGPT besser ab als jemand mit Gymnasialabschluss.

Zitat 2: “Außerdem halluziniert ChatGPT auch sehr fleißig, generiert also Texte, die völlig fernab jeglicher Fakten sind.“

Ja, weil ChatGPT ein Sprachmodell ist und Sprachmodelle werden trainiert, indem man ihnen die Aufgabe stellt Textlücken möglichst plausibel auszufüllen. Bis jetzt spielt beim Training die Faktentreue und Wahrhaftigkeit eine untergeordnete Rolle. Aber das kommt noch.

@MartinBei

Von hier: https://www.bpb.de/shop/zeitschriften/apuz/151302/kurze-geschichte-der-apokalyptik/

Es gibt sicher auch andere Interpretationen … aber eine gewisse Endzeitvorstellung findet man bei Marx mit Sicherheit.

Je stärker man einen Text kürzt, desto mehr Informationen gehen verloren und im schlimmsten Fall kommt auch mal etwas Falsches dabei heraus. Ich will als Beispiel den oben erwähnten Buddhismus nehmen. Dabei sei dahingestellt, ob es sich beim Pali-Kanon überhaupt um eine „Heilige Schrift“ handelt. Da er, im Gegensatz zu anderen heiligen Schriften, ja nicht auf eine himmlische Offenbarung zurückgeht. Im Pali-Kanon, auch Tripitaka bzw. Dreikorb genannt, findet man Ordensregeln für die Mönche, die Lehrreden Buddhas sowie deren Abhandlungen („höhere Lehrreden“). Zusammengefasst könnte man also sagen: Pali-Kanon: Lehrreden des Buddha.

Was nun die „Erleuchtung durch Achtsamkeit“ betrifft, so vermute ich mal, dass da nicht die Originaltexte des Pali-Kanons zugrundegelegt wurden, sondern das, was man im westlichen Internet zum Thema Buddhismus findet. Insofern sollte man sich mit bestimmten Themen zumindest ansatzweise auskennen, bevor man alles glaubt, was ChatGPT vorschlägt.

Auf scinexx kann man dazu lesen: „Ähnlich wie schon jetzt bei „Dr. Google“ kann beispielsweise die Antwort auf medizinische Fragen zu falschen Diagnosen oder Behandlungsempfehlungen führen. Doch anders als bei einer klassischen Suchmaschine ist es bei einem Text von ChatGPT nicht möglich, die Quellen einzusehen und so selbst zu bewerten, wie verlässlich die Angaben sind und wie seriös die Quellen. Eine Überprüfung der Information auf ihren Wahrheitsgehalt hin wird so drastisch erschwert.“

Martin Holzherr, wie alt sie Sie, sie wie alt ist ist Chat GPT ?

Ich musste bei ihrem Beispiel lachen.

Die ChatGPT hatte noch keine Zeit das Kapital zu lesen.

oder

Sie hätten fragen sollen, wie sieht Karl Marx das Ende der wirtschaftlichen Entwicklung in seinem Werk “das Kapital”.

einer,

du musst dir angewöhnen, präzise Fragen zu stellen.

Beispiel: Wie ist die Maßeinheit Meter seit 2019 definiert ?

Ich bin gespannt !

Wäre das mehr als eine simple Suche in der Wikipedia?

@Holzherr

Wenn Sie sich gerade für Philosophie interessieren,dann ist Logik und gerade die Aussagenlogik zentral.

Dabei ist die Konjunktin,Disjunktion und Indikation zentral.

Schon Gödel hätte erkennen können,dass damit kein Vollständigkeitssatz möglich ist.

Er war umständlich.

Warum soll das dan chat gpt können?

chat gpt phantasiert halt wie wir Menschen.

That’s It…

@Mussi: Frage-Antwort Maschinen wie ChatGPT sind für vieles nützlich, selbst dann wenn sie hin und wieder danebenliegen. Das zeigt sich nur schon darin, dass ChatGPT Prüfungen für Juristen, Mediziner und für viele weitere Fächer besteht. Trotz gelegentlichem Halluzinieren. Wer von ChatGPT Unfehlbarkeit erwartet, der müsste auch als Prüfer beim Staatsexamen der Mediziner auf die erste falsche Antwort sagen: „Was sie wollen Mediziner werden und halluzinieren nun wildes Zeug daher. Nichts damit, da genügen selbst 100 richtige Antworten nicht, wenn eine solch falsche darunter ist.

@Holzherr 30.03. 11:52

„Ja, weil ChatGPT ein Sprachmodell ist und Sprachmodelle werden trainiert, indem man ihnen die Aufgabe stellt Textlücken möglichst plausibel auszufüllen. Bis jetzt spielt beim Training die Faktentreue und Wahrhaftigkeit eine untergeordnete Rolle. Aber das kommt noch.“

Da ist noch Luft, in der Tat. ChatGPT kennt halt nur, was so geredet wird. Und hat weder eigene Welterfahrung, noch explizit verstandenes Expertenwissen. Immerhin bildet das Gerede viele Sachverhalte sehr gut ab, und die eigentliche Unkenntnis des Modells fällt dann nicht auf.

Womöglich gibt es solche Effekte auch bei Menschen, die sich nur oberflächlich eingelesen haben, und etwa dennoch damit Prüfungen bestehen können, wenn auch nicht mit Bestnoten.

Immerhin ist Sprache ein Ergebnis einer sehr umfangreichen Kulturentwicklung, und bildet in sich selbst vieles aus der Wirklichkeit ab. Wer das beherrscht, der kann schon mal eine ganze Menge.

Aber das mit der Welterfahrung kann ja noch kommen. Wenn wir etwa Roboter bauen, die sich auf die Suche nach Erfahrungen begeben sollen, und sich zwischen uns im Leben bewegen, und eben über ihre Sinne und ihre Bewegung Erfahrungen sammeln können. Vielleicht kann man hier tausende von Exemplaren bauen und in verschiedensten Umwelten aussetzen, und danach und vor allem zwischendurch die gemachten Erfahrungen dann irgendwie zusammenführen.

Danach kann man die Roboter auch noch arbeiten lassen, und dabei nicht nur lernen lassen wie man die konkrete Arbeit durchführt, sondern hier das Welterfahrungsammeln dann nebenbei noch fortsetzen können.

Wenn es um Expertenwissen geht, dann kann man hier vielleicht dieses explizit digital definieren, und ganze Datenbanken einbinden. Etwa die Physik, die beim Autofahren relevant ist, oder Diagnosehandbücher für Mediziner.

Wenn man hier verschiedene Ansätze und auch Durchläufe für einzelne Aufgaben so aufeinander abstimmt, dass sie kombiniert und ständig weiterentwickelt werden können, dann ginge es eventuell schnell ziemlich weit vorwärts.

Dann wird es irgendwann Zeit, darüber nachzudenken, wie denn ein Innenleben bzw. eigenes Bewusstsein implementiert werden kann. Womöglich emergiert das im Laufe des Verfahrens sogar von selber, und wir können einfach beobachten, wie es sich in den Systemen etabliert hat.

@ Holzherr

Ja, es kommt auf die eigene Frage und auf die eigene Antwort an. Das ist der Spiegel von Chat gpt.

Im Grunde geht es doch um:

Können wir jemals Natur nachbauen und den/die Urgründe erfahren?

Ja,theoretisch schon,da sie sich ja auch selbst gemacht hat und wir da sind.

Praktisch? Das ist die letztendlich offene Frage.

Ich habe letztens Frank Schätzings ‘ Tyrannei des Schmetterlings’ gelesen.

Da hat eine KI eine Maschine konstruiert,mit der Zeitsprünge in Paralleluniversen möglich ist.

Das ist doch alles krudes Zeug,wenn ich in mein Brötchen beisse.

Theorie als Phantasie und Praxis ist doch recht schlicht. Es vetreibt lediglich irdische Langeweile.

Wenn Sie gerade philosophisch unterwegs sind,dann ist der Begriff der “Möglichkeit” der am wenigsten greifbare.

Möglich? … 😉

Dein Beitrag zeigt, wie wichtig es ist, sich mit KI-Algorithmen wie ChatGPT auseinanderzusetzen und ihre Potenziale sowie Grenzen zu verstehen. Diese Technologien werden zweifellos einen immer größeren Einfluss auf unsere Gesellschaft haben, und es ist entscheidend, dass wir sie kritisch reflektieren und konstruktiv gestalten.

Nochmals vielen Dank für deine inspirierenden Gedanken und deine Bereitschaft, diese mit uns zu teilen.

Vielen Dank für das Feedback, @Arthur!

In der kommenden (April 2024-)Folge des Pod- und Videocast „Blume & Ince“ wollen wir das Thema KI 🤖 interdisziplinär aufgreifen. Hatte dazu ein Seminar am KIT Karlsruhe gegeben, der Einführungsvortrag ist hier:

https://m.youtube.com/watch?v=_uzxjPTJ2MY

Gerne möchte ich bis dahin auch noch einmal dazu bloggen.