Abzock-Zeitschriften Teil 5: Fazit

BLOG: RELATIV EINFACH

In den letzten Wochen hat eine mehrmonatige Recherche von NDR, WDR und SZ-Magazin in Zusammenarbeit mit ausländischen Partnern das Thema wissenschaftliche Abzock-Zeitschriften und Abzock-Konferenzen in Deutschland auf die Tagesordnung gebracht. Links zu den verschiedenen Berichten finden sich in diesem NDR-Dossier. Inzwischen hat der NDR auch einen FAQ mit einer Reihe von Antworten zu seinem Vorgehen online gestellt. Zur Erinnerung: Abzock-Fachzeitschriften, auch “predatory journals” genannt, sind selbsternannte wissenschaftliche Fachzeitschriften, die zwar vorgeben, den üblichen Qualitätsstandards des “Peer review” zu folgen, aber die in Wirklichkeit gegen Gebühr jeden Mist veröffentlichen. Parallel dazu geht es um Abzock-Konferenzen: vorgeblich wissenschaftliche Konferenzen ohne nennenswerte Qualitätsstandards, deren Geschäftsmodell entsprechend darin besteht, die Teilnahmegebühren einzustreichen.

Ich habe mich während der letzten Woche intensiv mit dem Thema beschäftigt – gerade am Anfang war die Berichterstattung ja in Teilen ärgerlich vage, ohne konkrete Zahlen bis auf die pauschale Aussage zu angeblich betroffenen 5000 deutschen Wissenschaftlern. Und auf eine Reihe von Rückfragen, die ich naheliegend fand, fand ich in der Berichterstattung keine Antworten. Deswegen begann ich, eine eigene Stichprobe von 17500 Artikeln eines in der Berichterstattung erwähnten Journals auszuwerten: in Teil 1 näheres zu Methoden, Ländervergleich, Gesamtzahl, in Teil 2 eine gesonderte Betrachtung der “Vielveröffentlicher” in meiner Stichprobe, in Teil 3 etwas zu den Institutionen und in Teil 4 etwas zu den Themengebieten.

Parallel dazu habe ich natürlich auch mit Kollegen diskutiert und mich auf Twitter zum Thema ausgetauscht. Jetzt möchte ich diese Blogbeitragserie zumindest für’s erste zum Abschluss bringen. Hier mein Fazit.

Gibt es mit Abzock-Journalen Probleme?

Ja, die gibt es. Wer in einem Predatory Journal veröffentlicht, das zwar vorgibt, ein Peer-Review-Verfahren durchzuführen, das aber in Wirklichkeit jeden eingereichten Mist durchwinkt, der beteiligt sich an einer Täuschung – er oder sie veröffentlicht seinen entsprechenden Artikel unter falscher Flagge. Diese Täuschung fördert wissentlich, wer sich bewusst für ein Predatory Journal entscheidet; unwissentlich, wer selbst auf den Schwindel hereinfällt.

Zumindest in einigen Arbeitsgruppen scheint sich mindestens eine Raubzeitschrift als regelmäßiges Publikationsorgan der Wahl etabliert zu haben – ich hatte als Beispiel in Teil 4 gefunden, dass von den 31 Artikeln mit deutscher Beteiligung in meiner Stichprobe, die ich dem Bereich Lebenswissenschaften (ohne medizinische Themen) zugeordnet hatte, ganze 13 aus dem Umfeld eines einzigen Lehrstuhls an einer prestigeträchtigen Universität stammen. Solche Häufungen sind zu erwarten – unter anderem gilt ja: wenn junge Wissenschaftler sich auf die Suche nach einer geeigneten Fachzeitschrift für eine anstehende Veröffentlichung machen, werden sie sich unter anderem daran orientieren, wo denn die Kollegen derselben Arbeitsgruppe veröffentlicht haben.

Hier ist Aufklärungsarbeit nötig. Informationen über Publikationen, Publikationsmodelle und eben auch Predatory Journals gehören in die studentische Ausbildung, gehört den Doktoranden erzählt, gehört in die Regeln für angemessenes wissenschaftliches Verhalten (“good scientific conduct”). Das Aufsehen, das die jetzige Berichterstattung erzeugt hat, sollte da hoffentlich einiges in Bewegung setzen.

Insbesondere ist wichtig, dass denjenigen, die Publikationslisten von Bewerbern oder Antragsstellern begutachten, das Predatory-Journal-Problem bewusst ist. Ich weiß nicht, ein wie großer Anteil der Wissenschaftler, die in Predatory Journals veröffentlichen, das tun, um ihre Publikationsliste für die nächste Bewerbung oder den nächsten Antrag zu frisieren; was ich von der NDR-et-al.-Recherche mitbekommen habe, macht da ja auch keine quantitativen Angaben.

Genau bei diesem Aspekt habe ich in der Berichterstattung allerdings wichtige Informationen darüber vermisst, dass es zum allgemeinen Problem der Publikationszahl – wo Wissenschaftler nur danach beurteilt werden, wieviel sie publiziert haben – bereits offizielle und aus meiner Sicht durchaus sinnvolle Reaktionen gibt. Bei bestimmten Antragsverfahren der Deutschen Forschungsgemeinschaft DFG (evt. ja sogar bei allen, das weiß ich nicht) als wichtigstem Drittmittel-Förderer universitärer Forschung wird eben nicht mehr nach der vollständigen Publikationsliste gefragt, sondern nach einer begrenzten Zahl (beim letzten Antrag, an dem ich beteiligt war, waren es 5, glaube ich) der wichtigsten Publikationen aus den letzten Jahren. Das soll “Masse statt Klasse” einen Riegel vorschieben und begrenzt auch die Nützlichkeit von Veröffentlichungen in Raubjournalen für solche Anträge; durch die Begrenzung wird die Aufmerksamkeit schließlich verstärkt darauf gelenkt, was publiziert wurde und wo es publiziert wurde.

Wie mit Raubjournalen umgehen?

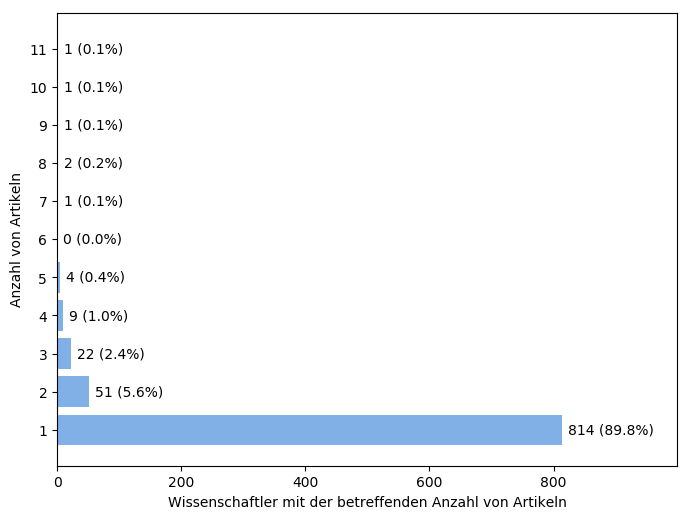

Wenn denn das Bewusstsein da wäre – wie sollte man dann mit Raubjournalen umgehen? Für die individuellen Wissenschaftler ergibt sich hoffentlich allein aus dem Wissen über Raubzeitschriften, dass sie bei der Auswahl von Fachzeitschriften für ihre eigenen Veröffentlichungen genauer hingucken. Hoffnung, dass alleine das schon große Verbesserungen brächte, gibt mir ein Ergebnis aus meiner Stichprobe. Ich hatte in Teil 1 festgestellt, dass ganze 90% der Autoren mit deutschsprachiger Affiliation nur zu einem einzigen Artikel meiner knapp 3 Jahre umfassenden Stichprobe beigetragen haben, siehe hier:

Das ist ein deutlicher Unterschied zu dem, was ich aus meinem engeren Umfeld kenne. Da publizieren Kollegen typischerweise regelmäßig in einer Handvoll von Journalen, ihre etwaigen Doktoranden und/oder Postdocs haben ein ähnliches Journal-Auswahl-Profil, und die betreffenden Kollegen veröffentlichen dann über drei Jahre hinweg typischerweise mehr als einen Artikel in diesen Journalen. Ich habe gerade bei den ersten drei Gruppenleitern im Max-Planck-Institut für Astronomie, die mir in den Sinn kamen, nach Veröffentlichungsmustern geschaut, jeweils von 2016 bis 2018: Im ersten Falle waren es vier Artikel im Astrophysical Journal, drei in Astronomy & Astrophysics. Im zweiten Falle acht Artikel im Astrophysical Journal, sechs in den Monthly Notes of the Royal Astronomical Society. Im dritten Falle waren es sogar ganze 24 Artikel in den Monthly Notes of the Royal Astronomical Society. In meiner Predatory-Journal-Stichprobe dagegen gab es unter den “Top 5” der Viel-Veröffentlicher (siehe Teil 2) nur einem, den ich dem regulären Wissenschaftsbetrieb zuordnen würde: ein Lehrstuhlinhaber, in dessen Umfeld sich eine der SCIRP-Zeitschriften offenbar als gern genutztes Publikationsmedium etabliert hatte.

Das ist ein deutlicher Unterschied zu dem, was ich aus meinem engeren Umfeld kenne. Da publizieren Kollegen typischerweise regelmäßig in einer Handvoll von Journalen, ihre etwaigen Doktoranden und/oder Postdocs haben ein ähnliches Journal-Auswahl-Profil, und die betreffenden Kollegen veröffentlichen dann über drei Jahre hinweg typischerweise mehr als einen Artikel in diesen Journalen. Ich habe gerade bei den ersten drei Gruppenleitern im Max-Planck-Institut für Astronomie, die mir in den Sinn kamen, nach Veröffentlichungsmustern geschaut, jeweils von 2016 bis 2018: Im ersten Falle waren es vier Artikel im Astrophysical Journal, drei in Astronomy & Astrophysics. Im zweiten Falle acht Artikel im Astrophysical Journal, sechs in den Monthly Notes of the Royal Astronomical Society. Im dritten Falle waren es sogar ganze 24 Artikel in den Monthly Notes of the Royal Astronomical Society. In meiner Predatory-Journal-Stichprobe dagegen gab es unter den “Top 5” der Viel-Veröffentlicher (siehe Teil 2) nur einem, den ich dem regulären Wissenschaftsbetrieb zuordnen würde: ein Lehrstuhlinhaber, in dessen Umfeld sich eine der SCIRP-Zeitschriften offenbar als gern genutztes Publikationsmedium etabliert hatte.

Die Häufung von nur-einmal-Veröffentlichern in meiner Stichprobe finde ich vor diesem Hintergrund sehr ungewöhnlich. Entweder die Einmal-Autoren in meiner Stichprobe haben tatsächlich insgesamt nur einmal veröffentlicht und dann die Wissenschaft verlassen. Unter meinen Viel-Veröffentlichern in Teil 2 war ja z.B. eine Ko-Autorin von sieben Artikeln, bei denen es sich vornehmlich um von ihr betreute medizinische Doktorarbeiten handelte. Für die meisten, die medizinische Doktorarbeiten schreiben, dürfte das dann bereits die letzte wissenschaftliche Fachveröffentlichung gewesen sein.

Alternativ dürften unter den Einmal-Autoren solche sein, die während des Publikationsprozesses oder direkt danach gemerkt haben, dass das betreffende Journal doch nicht so das Wahre ist. Wenn beim Peer-Review kaum konkrete Rückmeldungen kommen, sondern nur recht oberflächliche Anmerkungen (“die Zwischenkapitelüberschrift sollten Sie ändern, aber dann publizieren wir den Artikel” ist ein Beispiel, das ich aus der Berichterstattung erinnere), dann läuten zwar noch nicht genügend Alarmglocken, dass man den Artikel zurückzieht (was bei Raubjournalen ja zudem gemeinerweise auch saftige Gebühren nach sich ziehen kann), aber vielleicht ist es ja Anlass genug, sich beim nächsten Mal ein anderes Journal zu suchen. Oder den Betreffenden hat direkt nach der Veröffentlichung jemand gesteckt: nee, diese Zeitschrift hat keine gute Reputation, reicht nächstes Mal woanders ein.

Dass diese gebranntes-Kind-Autoren einen Großteil der Einmal-und-nie-wieder-Autoren stellen, ist nur eine Vermutung; um sie zu erhärten, wären weitere Nachforschungen nötig. Aber wenn diese Vermutung zutrifft, dann besteht die Hoffnung, dass man auch mit einer Aufklärungskampagne über Existenz und Vorgehen von Predatory Journals den Großteil derer erreichen würde, die sonst (einmal) in einem solchen Journal veröffentlichen. Und die Hürde für diejenigen, die in Versuchung waren/sind, mit Predatory Journals ihre Bibliografie zu friesieren, wäre auch höher gelegt – ist die Aufklärungsarbeit effektiv genug, fällt damit auch “Aber ich wusste doch nicht…” als Entschuldigung weg.

Über die konkrete Umsetzung müsste man reden. Die jetzige Berichterstattung dürfte das Thema bereits einigermaßen weit bekannt gemacht haben; das ist bereits eine gute Ausgangssituation. Die Übertreibungen in der Berichterstattung dürften der Sache andererseits eher geschadet haben; ich würde es keiner Wissenschaftsorganisation verdenken, jetzt erstmal zu warten, bis sich der Hype gelegt hat, und dann erst eigene Maßnahmeh zu implementieren. Wie diese Maßnahmen über die Aufklärung hinaus aussehen könnten? Eine Möglichkeit wären “Schwarze Listen” von problematischen Fachjournalen oder “Weiße Listen” von guten Journalen; allerdings – wie Richard Friebe hier schreibt – sind beide Lösungen nicht unproblematisch. Auch die nicht bereits jahrzehntelang etablierten Fachzeitschriften sollten fair behandelt werden, und nicht unverdient auf einer Blacklist landen oder auf einer weißen Liste fehlen.

Vielleicht reicht es ja wirklich bereits aus, das Bewusstsein für das Problem zu schärfen? In diese Richtung geht eine Kampagne wie Think – Check – Submit, mir einer einfachen Checkliste, die explizit macht, was einem der gesunde Menschenverstand in punkto wissenschaftliche Fachveröffentlichungen sowieso raten sollte.

Die Analogie von Predatory Journals zu Spam oder Phishing, die z.B. in diesem Blogbeitrag gezogen wird, halte ich für hilfreich. Ein Teil der Predatory Journals ist tatsächlich ebenso auffällig unseriös wie herkömmlicher Spam. Kurioserweise haben sich bei typischen Predatory-Journal-E-Mails sogar bestimmte Anreden wie “Greetings of the day” eingebürgert. Wo ich so etwas sehe, drücke ich genau so reflexhaft auf die Löschtaste wie wenn mich eine E-Mail mit “Dearly Beloved…” anredet. Insofern: Wer nicht auf die Angebote nigerianischer Prinzen oder der Nachkommen jüngst verstorbener Diktatoren eingeht, wird den meisten Werbe-Emails von Predatory Journals oder Fake-Konferenzen, wie ich sie in meiner E-Mail-Inbox vorfinde, ebenso wenig auf den Leim gehen. Bei besser aufgemachten Predatory Journals und ihren Werbe-E-Mails ist dann halt ähnliche Vorsicht wie bei Phishing-E-Mails geboten, die auf täuschend echt wirkende, aber eben doch gefälschte Bank-Webseiten führen, sich aber in der Regel durch ein paar gezielte kritische Nachforschungen entlarven lassen (sofern man nicht sowieso nur via der üblichen URL auf die Webseiten der eigenen Bank geht).

Behindern Predatory Journals den wissenschaftlichen Fortschritt?

Fachartikel sind Mittel zu einem hauptsächlichen Zweck: die eigenen Forschungsergebnisse der weiteren Gemeinschaft der auf demselben Gebiet Forschenden zugänglich zu machen und so die Forschung als Ganzes voranzubringen. Schaden Predatory Journals diesem wissenschaftlichen Fortschritt?

Ein wenig tun sie das sicherlich, aber an dieser Stelle bietet ein Großteil der Berichterstattung ein falsches Bild, wie ich finde. Das fängt mit dem Hashtag “Fake Science” an, der zu Recht von verschiedenen Seiten kritisiert wurde (hier stellvertretend Robert Gast bei spektrum.de, Thomas Beschorner in der Zeit und Arndt Leininger im Tagesspiegel). Im Fragebogen hat der NDR ob dieser Kritik noch einmal nachgelegt: es ginge um “scheinwissenschaftliche Publikationen handelt – das heißt um Publikationen, die vorgeben (“faken”), wissenschaftlich (“science”) zu sein, indem sie angeben, den Prozess des “Peer Review” durchlaufen zu haben” – so sei der Hashtag gemeint gewesen, und man sei sich sicher, damit den hohen Ansprüchen an “sorgsame Abwägung und eine ruhige Sprache” gerecht geworden zu sein.

Ähm – nein, nicht wirklich. Fake Science, also gefälschte Wissenschaft, ist ein weites Feld. Das fängt bei Komplettfälschungen an, mit erfundenen Datensätzen, duplizierten und dann leicht veränderten Diagrammen oder Abbildungen, Beschreibungen von Experimenten, die in der beschriebenen Form nie stattgefunden haben (erinnert sich noch jemand an Jan Hendrik Schön?). Sicher hat das Veröffentlichen in Predatory Journals eine potenzielle Betrugskomponente – dann nämlich, wenn der Autor oder die Autorin ganz bewusst in solch einem Journal veröffentlicht, um richtigen Peer Review zu umgehen. Aber das ist, sogar wenn es bewusst geschieht, eine ganz andere Größenklasse an Fakery. Wer ein Experiment sorgfältig und ordnungsgemäß durchführt, wahrheitsgemäß aufschreibt und dann bei einem Predatory Journal einreicht gehört in eine gänzlich andere Kategorie als jemand, der Forschungsdaten fälscht und/oder manipuliert.

Was in der Berichterstattung ebenfalls verlorenging, aber genau hier wichtig wird: Nur, weil ein Artikel in einem Predatory Journal erscheint, muss der Inhalt nicht falsch und von Methodik und Ausführung her keine schlechte Wissenschaft sein. Dort, wo ein Artikel, der mir bei der Auswertung begegnete, den Bullshit-Detektor ausschlagen ließ, war der Autor in der Regel jemand ohne zugehörige Institution (in meiner Klassifikation habe ich das “Privatgelehrte” genannt). Aber von jenen Artikeln kann man halt nicht auf den normalen Wissenschaftsbetrieb zurückschließen. Dass ein Arzt die Weltformel der Physik zu entdecken gemeint und sein Ergebnis in einem Predatory Journal veröffentlicht hat, sagt mir nichts über den Stand der theoretischen Physik an deutschen Universitäten und außeruniversitären Instituten.

Die Rolle des Peer Review

Hinzu kommt, dass die Rolle des Peer Review in Teilen der Berichterstattung nicht richtig wiedergegeben wurde (siehe dazu auch Joachim Schulz nebenan auf Quantenwelt). Peer Review ist ein Schritt der Qualitätssicherung. Bestimmte der eingereichten Artikel werden aufgrund der Empfehlungen der Gutachter gar nicht in der betreffenden Zeitschrift veröffentlicht. Andere Einreichungen werden erst veröffentlicht, wenn die Autoren spezifische grundlegende Verbesserungen vorgenommen haben, oder einige kleinere Verbesserungen. Manche Einreichungen werden auch ohne Änderungen akzeptiert.

Aber das Peer-Review-Verfahren ist nicht unfehlbar (und hat auch nur begrenzte Wirkung, dazu unten mehr). Unter Wissenschaftlern kursieren Geschichten von durchaus hahnebüchenen Gutachten – der Folklore folgend ist “Reviewer 3” (die Namen der Reviewer werden dem Autor im Verfahren jeweils nicht genannt; meist sind es ein bis zwei, manchmal drei oder sogar noch mehr) besonders übel. Wer Interesse hat, möge mal unter dem Hashtag #Reviewer3 auf Twitter schauen. Da kann man beispielsweise von einem Reviewer lesen, der Autorin X bescheinigte, sie sei offenbar nicht vertraut genug mit der Arbeit von Wissenschaftlerin X (und ja, X steht beide Male für dieselbe Wissenschaftlerin – aber das konnte der Reviewer aufgrund doppelter Anonymisierung nicht wissen).

Außerdem hat Peer Review bei den meisten Journals nicht nur die Funktion, die Qualität der dort beschriebenen wissenschaftlichen Arbeit sicherzustellen – indem der Gutachter die dort beschriebenen Methoden abklopft, Verbesserungen anmahnt wenn etwas nicht den üblichen Standards entspricht, und so weiter. Gutachter sollen meist auch angeben, ob sie die eingereichte Arbeit für herausragend und wichtig halten – denn die meisten Fachzeitschriften halten sich ja zugute, nur besonders wichtige Arbeiten zu veröffentlichen (das ist nicht bei allen so, Gegenbeispiele z.B. PlosONE und Scientific Reports). Die Einschätzung der Wichtigkeit ist allerdings durchaus subjektiv, und macht es gänzlich neuen Ansätzen überproportional schwer. Dass zu #Reviewer3 auch eine Kollegin twittert, die das vernichtende Urteil von Reviewer 3 über das wiedergefunden hat, was jetzt, Jahre später, ein extrem oft zitierter (und damit als sehr wichtig identifizierter) Fachartikel von ihr ist, ist so ungewöhnlich nicht.

Was also würde wegfallen, wenn man den Peer Review, wie bei den Predatory Journals, heimlich wegließe? Die meisten veröffentlichten Artikel, nämlich diejenigen, die von der Rückmeldung der Gutachter profitieren, wären vermutlich etwas weniger lesbar und weniger gut und schlüssig geschrieben. Einige, nämlich die von den Reviewern unverändert akzeptierten, wären unverändert. Einige, bei denen die Kommentare der Gutachter zu einer Verschlimmbesserung geführt haben, wären etwas schlechter. Zahlreiche Artikel würden erscheinen, die von den Reviewern zu recht abgelehnt wurden. Und einige Artikel würden erscheinen, die von den Reviewern zu Unrecht abgelehnt wurden. Schwer zu sagen, ob das netto eine Verbesserung wäre oder nicht.

Alles in einen Topf?

Nun werden vermutlich die allerbesten Arbeiten von vornherein gar nicht bei Predatory Journals eingereicht werden, sondern bei den besonders renommierten Fachzeitschriften – Nature, Science, in den Lebenswissenschaften noch Cell als Spitzenreiter, dahinter fachspezifischere Zeitschriften, die sich in jeweiligen Feld etabliert haben. Aber das ist ein gesonderter Faktor; die Rolle des Peer Review zeigt, dass seine Abwesenheit bei Predatory Journals zwar das Mix an besseren und schlechteren Artikeln beeinflussen dürfte, dass aber auch ohne Peer Review solide wissenschaftliche Arbeit unter dem zu erwarten ist, was dort erscheint. Dann nämlich, wenn die Fehler des oder der Autoren nicht darin bestehen, was sie konkret an Forschung gemacht und wie sie ihre Ergebnisse aufgeschrieben haben, sondern nur darin, im letzten Schritt auf ein Predatory Journal hereingefallen zu sein.

Das alles in einen Topf zu werfen und den Label “Fake Science” darauf zu bappen ist das Gegenteil der “sorgsame[n] Abwägung”, die die NDR-Autoren für sich reklamieren.

Peer Review ist bei weitem nicht alles

Hinzu kommt (auch darauf ist Joachim in seinem Blogbeitrag eingegangen): Dass ein Artikel den Peer-Review-Prozess glücklich überstanden hat und daraufhin veröffentlicht wurde, steht zwar für einen bestimmten Grad an Qualitätskontrolle. Aber es sagt noch nichts darüber aus, ob das, was in dem Artikel steht, richtig ist, ob es sich bewähren wird, über die nächsten Jahre hinweg Bestand haben wird und, wenn es um hinreichend grundlegende Themen geht, ob es langfristig Teil des Lehrbuchwissens werden wird.

Aber genau so scheint ein Teil der Beschwerden über Predatory Journals die Rolle des Peer Review zu sehen: was Peer Review durchlaufen hat, ist verlässlich, auch für Journalisten und Öffentlichkeit. Wo Peer Review vorgetäuscht werde, werde Verlässlichkeit vorgetäuscht, und werde die Öffentlichkeit so über die Verlässlichkeit von Ergebnissen getäuscht.

Das überschätzt, was Peer Review leisten kann – und diese Überschätzung birgt meiner Ansicht nach eine deutlich größere Gefahr als die Predatory Journals. Ein Artikel in einer Fachzeitschrift, mit oder ohne Peer Review, ist zunächst einmal nur ein Diskussionsangebot an die wissenschaftliche Gemeinschaft. Was daraus wird, zeigt sich erst über die nächsten Jahre hinweg, wenn andere Wissenschaftler die betreffenden Ergebnisse aufgegriffen, weitergeführt, dadurch bestätigt oder eben herausgefunden haben, dass sie doch nicht so stimmen, wie sie der Fachartikel präsentiert hat. Dieses Aufgreifen und Weiterführen von Forschung ist das viel stärkere Korrektiv, der viel wirksamere Qualitäts-Kontrollmechanismus.

Man muss an dieser Stelle zwischen den verschiedenen Wissenschaften unterscheiden. Aus der Mathematik weiß ich von Kollegen, dass es zumindest in deren Teilgebieten beim Peer Review dazugehört, die Beweise in einem zu begutachtenden Artikel Schritt für Schritt zu überprüfen. Zumindest in der klassischen reinen Mathematik würde solch eine Prüfung wirklich etablieren, ob das, was da behauptet wurde, stimmt oder nicht. (Bei aufwändigen computerbasierten Beweisen würde das bereits nicht mehr so sein.)

Replikation von Ergebnissen/Experimenten

In experimentellen Wissenschaften, etwa experimenteller Physik, Chemie, Biologie, Medizin, ist das anders. Da wird ein Peer-Review-Gutachter das Experiment nicht automatisch selbst aufbauen und nachmessen, ob alles stimmt. Nachbauen werden das Experiment nach der Veröffentlichung allerdings einige derjenigen Forscher, die vorhaben, dass betreffende Experiment abzuwandeln oder zu erweitern, um so auf ein eigenes, neues Resultat zu kommen.

Dass es schwierig ist, reine Replikationen, also erfolgreiche oder eben nicht erfolgreiche Wiederholungen, als Fachartikel zu veröffentlichen, ist ein wieder anderes Problem der Wissenschaft; immerhin gibt es in Bezug auf dieses Problem ein paar Fortschritte. Aber bereits das Erlernen eines neuen Messaufbaus oder einer neuen Methode, oder die Möglichkeit des Nutzens neuartiger Gerätschaften, stellt eine Motivation für die Fachkollegen dar, ein bestimmtes Experiment für sich selbst nachzuvollziehen. In Fällen, wo die Methode weitgehend zum Standardrepertoir gehört, fehlt diese Zusatzmotivation allerdings – ich würde vermuten, dass genau dieser Umstand zur Replikations-Krise ab 2010 mit Fällen insbesondere aus der Psychologie beigetragen hat.

Am wirksamsten ist der Korrektureffekt dort, wo unterschiedliche Experimente innerhalb ein und desselben, möglichst festen Theorie-Rahmens stattfinden. Je belastbarer die Verbindung zwischen dem, was Experiment A ergibt und dem, was Experiment B ergibt, umso stärker die Kontrolle – entsprechend größer ist ja die Chance, dass Erfolg oder Misserfolg von Experiment B Rückschlüsse auf Experiment A zulässt. In der Physik mit ihren mathematisch formulierten Theorien ist diese Verbindung recht stark. In Psychologie, Medizin & Co. dürften die verschiedenen Experimente und Studien eine wesentlich weniger direkte Bedeutung füreinander haben – zu groß ist die Zahl der zusätzlichen, nicht gut kontrollierbaren Faktoren, die dazwischen kommen können.

(Und last but not least gibt es noch die Geisteswissenschaften, in denen Peer Review meines Wissens nach deutlich weniger verbreitet ist als in den Naturwissenschaften. Die entsprechenden Kolleg/innen wundern sich vermutlich, was die ganze aktuelle Debatte soll – falls sie sich nicht stattdessen darüber ärgern, dass in dieser Debatte wieder einmal Natur-, Ingenieurs- und allenfalls noch Sozialwissenschaften mit “der Wissenschaft” im Ganzen gleichgesetzt werden.)

All diese Aspekte und Grenzen von Peer Review sowie die weiteren wissenschaftlichen Kontrollmechanismen zusammengefasst, denke ich: Dort, wo Wissenschaft so funktioniert, wie sie soll, behindern Predatory Journals den wissenschaftlichen Fortschritt nicht nenneswert. Falls ihre Ergebnisse nicht aufgegriffen werden, werden sie auch nicht Teil des wachsenden Wissens einer Fachdisziplin. Und wenn sie aufgegriffen werden, werden sie dabei in der Regel auch überprüft.

Unsinn in die Öffentlichkeit?

Tragen Pseudo-Publikationen Unsinn in die Öffentlichkeit? Genau das ist das Argument eines etwas sonderbaren und auffällig defensiven Artikels von Patrick Illinger in der Süddeutschen Zeitung. Der Artikel ist offenbar eine Reaktion auf die Kritik an der ursprünglichen Berichterstattung von NDR, SZ-Magazin et al. – aber leider keine sehr konstruktive Reaktion. Das zeigt sich schon ganz am Anfang, denn der Text beginnt mit einer kruden Schwarz-Weiß-Zeichnung, die Reaktionen auf die NDR-et-al.-Recherche einteilt in jene, die “zum Kampf gegen den blühenden Unsinn” aufrufen versus “[e]rschreckend viele”, die sich bemühten, “das Problem kleinzureden.” Allein dieses verzerrende Framing ist bereits eine Unverschämtheit. Alles oder nichts; wer nicht für uns ist, ist gegen uns; schwarz oder weiß?

Was da als “kleinreden” abgetan wird, umfasst eine ganze Reihe eigentlich recht differenzierter Stimmen: Menschen, die zwar einerseits Aufklärungsbedarf über Raubjournale sehen, aber andererseits auch auf die zweifellosen Übertreibungen der Berichterstattung hinweisen, siehe oben. Menschen, die darauf hinweisen, dass “Fake Science” ein irreführender Begriff ist. Die die zur Einordnung wichtigen Zahlen, die jene Berichterstattung seltsamerweise gar nicht erwähnt hat, an die Öffentlichkeit gebracht haben. (Dass sich die Angabe “5000 deutsche Wissenschaftler” auf einen Zeitraum von zehn [!] Jahren bezog, habe ich selbst z.B. erst aus dem nachgereichten FAQ erfahren, der bereits eine Reaktion auf die ersten kritischen Rückfragen darstellte.) Oder Menschen, die darauf hinweisen, dass die pauschale Gleichsetzung von in Raubjournalen erschienenen Artikeln mit “blühende[m] Unsinn” selbst, nun ja, blüheneder Unsinn ist. All das beiseite zu wischen und in die diffamierende Schublade “kleinreden” zu drücken ist schon ein ausnehmend unsouveräner Umgang mit Kritik.

Machen Raubjournale Unsinn salonfähig?

Im Anschluss kommt dann die defensive Volte: Es möge ja sein, dass die Artikel in den Raubjournalen innerhalb der Wissenschaft nicht ernstgenommen würden. Aber die Wissenschaftler sollten nicht ignorieren, wenn unter dem Deckmantel der Wissenschaft Unsinn veröffentlich würde. Ganz katastrophal sei es, wenn auch renommierte Forscher in Raubzeitschriften veröffentlichten, denn dann stünde “[d]er wissenschaftliche Unsinn [nun] scheinbar gleichwertig neben den Ausführungen eines anerkannten Akademikers”. Für Talkshows, Stammtisch, Flugblatt, Sonntagsrede sei das gut genug.

Eventuell sehe ich ja nur nicht die richtigen Talkshows, aber die Vorstellung, dass dort eine Detaildiskussion stattfinden könnte, in der zur Stützung einer These nicht nur ein konkreter Fachartikel sondern zusätzlich noch der Umstand ins Feld geführt würde, in derselben Fachzeitschrift habe schließlich auch der renommierte Wissenschaftler XYZ veröffentlicht, kommt mir reichlich unrealistisch vor. Abgesehen davon, dass die meisten Namen renommierter Wissenschaftler dem typischen Talkshowpublikum sowieso nichts sagen dürften – na, wieviele Menschen können den Namen eines lebenden Wissenschafts-Nobelpreisträgers nennen? – setzt so eine Argumentation ja bereits gehöriges Vorwissen über wissenschaftliche Veröffentlichungsgepflogenheiten, das Renommé von Fachzeitschriften etc. voraus.

Ähnliches dürfte für Stammtische oder Sonntagsreden gelten: Für die dürfte das vage “Wissenschaftler haben gezeigt” oder “aber andere Wissenschaftler haben gezeigt, dass…” vollkommen ausreichen. Ob die Wissenschaftler das dann auch noch veröffentlicht haben, und ob die Veröffentlichung dann auch noch (angeblich) einen Peer-Review durchlaufen hat, ist doch schon weit jenseits dessen, was da geredet oder geschrieben wird.

Kompetenter Wissenschaftsjournalismus: ja bitte!

Wer bei Illingers Argument durch Abwesenheit glänzt ist eine Gruppe von Menschen, die viel, viel wichtiger ist als die Autoren von Raubjournal-Artikeln, wenn es darum geht, wie Wissenschaft in die Öffentlichkeit gelangt. Die meisten Menschen dürften ja kaum je eine Fachzeitschrift mit wissenschaftlichen Originalartikeln in die Hand nehmen. Ein Großteil dessen, was sie über Wissenschaft erfahren, kommt auch in Zeiten des Internet von den Massenmedien – die haben nach wie vor, zumal Online und Print zusammengenommen, die größte Reichweite.

Damit sollte allerdings klar sein: Ob Unsinn aus den Raubjournalen, oder auch aus den Nicht-Raubjournalen, in großem Stil an die Öffentlichkeit gelangt, hängt nicht in erster Linie an der Existenz von Raubjournalen sondern daran, ob Wissenschaft allgemein in den Massenmedien kompetent und kritisch aufgearbeitet wird. In dieser Hinsicht gibt es ja leider durchaus Probleme – Stellenabbau in den Wissenschaftsredaktionen ist ein großes Problem, und ja vermutlich eines, bei dem Herr Illinger und ich (und viele andere) uns vermutlich einig sind, dass das ein unguter Trend ist und wir stattdessen kompetente Wissenschaftsjournalisten in den Redaktionen brauchen.

Es gibt aber auch systemische Probleme. Eines davon hat mit den Gepflogenheiten der Wissenschaftsberichterstattung zu tun. Da ist der Peer Review nämlich trotz seiner Unzulänglichkeiten das Standard-Schlüsselkriterium: berichtet wird über Ergebnisse, die just (Aktualität!) in einer Fachzeitschrift (mit Peer Review) erschienen sind. Dass sich, siehe oben, vielleicht erst Jahre später zeigt, ob die Ergebnisse Bestand haben, fällt bei dieser Konstruktion weg. Auch so entsteht ein verzerrtes Bild vo Wissenschaft – weil der Wissenschaft ein Aktualitätskriterium aufgedrückt wird, das zwar bei Berichten über das Tagesgeschehen sinnvoll sein mag, dem Wesen der Wissenschaft aber eigentlich widerspricht. Was wirklich wichtig war, sehen wir erst im Rückblick. Und wenn solche Rückblicke keinen ausreichenden Platz in der Berichterstattung haben, sondern stattdessen jeweils aktuelle, aber dementsprechend auch noch unsichere Veröffentlichungen die Spalten füllen, dann fehlt etwas, das eigentlich eine wichtige Funktion des Journalismus sein sollte: Informationen richtig einzuordnen.

Wissenschaft(sprozesse) transparent machen

Dass Illinger anschließend von der Wissenschaft fordert, die “Mühen und Rückschläge des empirischen Erkenntnisprozesses transparent zu machen, statt Wissenschaft als unfehlbaren Herstellungsbetrieb ewiger Wahrheiten darzustellen” finde ich einigermaßen zynisch. Da einer meiner Aufgaben in der Öffentlichkeitsarbeit für das Max-Planck-Institut für Astronomie besteht, inklusive dem Schreiben von Pressemitteilungen, schaue ich natürlich darauf, welche von den Meldungen von uns oder von anderen Instituten dann auch in den Medien aufgegriffen werden.

Aufgegriffen werden in der Regel die spektakulären Meldungen – der am weitesten entfernte Quasar; ein Exoplanet, der kurz davor ist, von seinem Stern verschlungen zu werden; der erdnächste Exoplanet, und bis vor kurzem Exoplaneten (also Planeten um andere Sterne als die Sonne) generell. Dass nachträgliche Korrekturen aufgegriffen wurden, habe ich nur ganz selten erlebt – bei den BICEP2-Gravitationswellen-in-der-kosmischen-Hintergrundstrahlung-Ergebnissen ja, das erinnere ich natürlich, aber sonst? Da erinnere ich vielmehr Fälle, wo die ursprüngliche spektakuläre Mitteilung durch die Presse ging, Korrekturen und Relativierungen dann aber nur noch in den sozialen Medien und in Blogbeiträgen zu finden waren und nicht mehr von den Massenmedien aufgegriffen wurden. Wer seine Informationen nur aus den Massenmedien bezog, blieb mit Fehlvorstellungen zurück. Vermutlich wäre es etwas anderes gewesen, wenn die Korrektur mit einem handfesten Skandal verbunden gewesen wäre. Waren sie in den Fällen allerdings nicht, sondern Teil des unspektakulären Standard-Wissenschaftsbetriebs. DIe mangels allgemeinem Interesse (in moderner Variante: Klickzahl-Potenzial) von den Massenmedien komplett beiseite gelassen wurden.

Insofern unterstütze ich gerne Illingers Forderung, die Praxis des Forschungsprozesses sichtbarer zu machen. Dazu muss aber mehr als eine Seite beitragen: neben den Wissenschaftlern auch diejenigen, die über Wissenschaft berichten. Sonst bleibt das, was die Wissenschaftler an Transparenz liefern, weitgehend unsichtbar.

Medizinische Themen

Medizinische Themen sind ein Spezialfall. Ich schrieb, dass Nicht-Wissenschaftler kaum je eine Fachzeitschrift mit Original-Artikeln in die Hand nehmen. In der Medizin gibt es den wichtigen Ausnahmefall: Menschen die, mit einer eigenen Krankheit oder einer Krankheit von Verwandten oder Freunden konfrontiert, in dem Versuch, zu verstehen, was da passiert und was es für Hilfemöglichkeiten gibt, nach Informationen suchen. Das ist ein Kontext, in dem Abzock-Journale tatsächlich großen persönlichen Schaden anrichten können, dann nämlich, wenn unter dem Unsinn, den sie veröffentlichen, medizinischer Unsinn ist, der unwirksame Therapien schönredet, falsche Kausalzusammenhänge behauptet und/oder letztlich falsche Hoffnungen weckt. Im schlimmsten Falle kann das dazu führen, dass die Betroffenen der ärztlichen Behandlung misstrauen und sich selbst schädigen. Einer der NDR-Berichte zu “Fake Science” beschäftigt sich mit dem Fall der Moderatorin Miriam Pielhau, die auf ein mit Predatory-Journal-Fachartikeln “untermauertes” alternatives Krebs-Heilungsmittel hereinfiel und 2016 verstarb.

Aber letztlich scheint mir der Einfluss des Umstandes, dass auch herkömmliche oder sogar renommierte Wissenschaftler in einem Predatory Journal veröffentlicht haben, auch in diesem Zusammenhang gering zu sein. Der Regelfall dürfte doch wohl sein, dass die Betroffenen schauen, was sie auf einer Google-Suche finden und (im günstigen Falle) die entsprechenden Artikelausdrucke mit zu ihrem Arzt nehmen. Dass jemand an diesem Punkt innehält, erst schaut ob auch Forscher von angesehenen Universitätskliniken in der gleichen Zeitschrift veröffentlicht haben, und erst bei positivem Ausgang der Suche den Fachartikel akzeptiert bzw. ausdruckt, scheint mir ein wiederum recht unwahrscheinliches Szenario, da es wiederum Wissen über den wissenschaftlichen Publikationsbetrieb und die Reputation von Zeitschriften voraussetzt, das bei den meisten Menschen schlicht nicht vorhanden sein dürfte.

Das Thema, wie Patienten mit Informationen umgehen, halte ich als solches für sehr wichtig. Das Internet als Informationsquelle hat Patienten viel mehr Informationen ungleich leichter und direkter zugänglich gemacht als früher. Wie wir damit umgehen, kann das Leben vieler Menschen maßgeblich beeinflussen. Wenn wir überlegen wollen, was dabei problematisch ist und wie man möglichst gut mit dem Thema umgeht, müssen wir uns um mehrere wichtige Aspekte kümmern. Um die Frage, ob Ärzte genügend Zeit haben, solche Informationen, die ein Patient sich selbst verschafft hat, mit den Patienten zu diskutieren – angesichts des Umstandes, dass längere Beratungsgespräche von den Krankenkassen nur unzureichend vergütet werden dürfte die Antwort nein lauten, beziehungsweise: Ärzte, die sich trotzdem die Zeit für die nötigen Gespräche nehmen, betreiben Selbstausbeutung. Da besteht ganz sicher Korrekturbedarf. Und es d darum gehen, dass es eine Illusion ist, allein schon der Zugang zu Informationen im Internet mache uns alle zu Experten, und wir müssten deswegen nichtmehr diejenigen befragen, die eine entsprechende Ausbildung und jahrelange Erfahrung in dem betreffenden Fachgebiet hätten. (Dass der NDR-Beitrag mit keinem Satz erwähnt, dass es nicht normal und alles andere als ratsam ist, wie Frau Pielhau eigene Therapieentscheidungen durch Selbststudium von Fachartikeln zu treffen, sondern dass man sich tunlichst mit ausgebildeten Fachärzten darüber unterhalten sollte, ist für sich genommen bereits ein Unding.)

Und ja, in der Diskussion wird es auch um Täuschungsmanöver gehen. Sinnvoller Weise erst einmal um die wirkmächtigsten Täuschungsmanöver, diejenigen mit der größten Breitenwirkung und damit dem größten Schadenspotenzial. Dann sind wir bei sonderbaren Dingen wie dem Focus-Special zur Homöopathie, entstanden in Zusammenarbeit mit einer Herstellerfirma für homöopathische Mittel als undurchsichtiger Mix von platzierten Anzeigen und auffällig unkritischen “redaktionellen” Beiträgen (siehe Bezahlt von Globuli-Produzenten: Focus-Online hilft beim Einstieg in die Homöopathie auf Übermedien.de). Oder das genau so unkritische Verlags-Special Homöopathie beim Stern (ebenda). Betrachten wir dann näher, wo denn die meisten Menschen fragwürdige Informationen zu Wunderkuren, Alternativmedizin und ähnlichem herbekommen, sind wir vermutlich schnell bei der Regenbogenpresse und beim Boulevardjournalismus. Die Regenbogenpresse ist ja sozusagen das Predatory-Journal-Analog für den herkömmlichen Journalismus – von Aufmacher und Verkaufsorten her tut sie so, als gehöre sie dazu; wie es dann aber mit sorgfältiger Recherche und ähnlichen journalistischen Qualitätsmerkmalen steht, kann man bei Uebermedien in der Kategorie Topf voll Gold nachlesen. In diesem Zusammenhang werden wir uns auch darüber unterhalten müssen, inwiefern die “richtigen” Journalisten mithelfen, die Regenbogenpresse salonfähig zu machen. Ich weiß dazu eher wenig – distanzieren sich die richtigen Journalisten von denjenigen, die bei der Regenbogenpresse arbeiten? Mahnen sie an, dass jene sich nicht Journalisten nennen oder Journalistenverbänden beitreten sollten? Wenn wir all das geklärt haben dürfte irgendwann, unter ferner liefen, auch das Gespräch auf die ungute Wirkung von Predatory Journals in diesem Bereich kommen. Aber wenn wir unsere Diskussion fair gewichten, von den wichtigsten Aspekten zu den unwichtigeren, sollte dieses Thema vermutlich ganz am Ende, und vergleichsweise kurz, abgehandelt werden.

Fazit vom Fazit

Noch einmal: Ich finde gut, dass das Thema Raubjournale in die öffentliche Diskussion gekommen ist, auch wenn die Berichterstattung ihre Schwächen hatte. Ich finde es wichtig, dass man sich den begrenzten Umfang des Problems klar macht (denn an dem muss sich schließlich bemessen, wieviel Aufwand etwaige Lösungsansätze wert sind), aber auch mit den Zahlen meiner Stichprobe komme ich zu dem Schluss: das ist selbst in der herkömmlichen Wissenschaft ein Problem, für das es angemessen ist, ein entsprechendes Bewusstsein zu schaffen; Studierende, Doktoranden und aktive Forscher sollten darauf hingewiesen werden, dass es so etwas wie Raubjournale gibt.

Zu den Raubjournalen selbst ist inzwischen, soweit ich sehen kann, das wesentliche gesagt. Aber es gibt eine Reihe von Themen, die sich an dieses hier direkt anschließen, und für die eine öffentliche Diskussion ebenfalls wünschenswert wäre. Da ist das Geschäftsmodell der herkömmlichen Subskriptionsjournale und das Gegen-Modell des Open Access – auch da gibt es gerade aktuelle Entwicklungen, an die sich anknüpfen ließe; Stephan Schleim hat letzte Woche bei Menschen-Bilder diesen wichtigen Bogen geschlagen. Der Umgang mit Patienten-Recherchen und Expertenwissen im Medizinbereich ist ein weiteres wichtiges Thema, das gerade jenseits der Predatory Journals spannend, siehe oben. Auch der Auftrag, die Forschungspraxis für die Öffentlichkeit transparenter zu machen, bietet viel Stoff für Berichte. NDR, SZ und Co., und natürlich auch die anderen Kollegen in den diversen Redaktionen: übernehmen Sie!

- Abzock-Zeitschriften: Wie groß ist das Problem? (“Vorstudie”)

- Teil 1: Methoden, Ländervergleich, Gesamtzahl

- Teil 2: Die Vielveröffentlicher

- Teil 3: Die Institutionen

- Teil 4: Themengebiete, Erstautoren

- Teil 5: Fazit

Hallo Markus,

vielen, vielen Dank für deine Fleißarbeit, deine umfangreiche Auseinandersetzung mit dem Thema und die Bereitstellung der Daten. Was dein Fazit angeht, so sehe ich das allerdings differenzierter. Das Problem scheint mir darin zu liegen, dass du (und andere, die sich z. B. kritisch zu dem Begriff “Fake Science” geäußert haben) explizit erst einmal von der Binnenperspektive des Wissenschaftlers und des Wissenschaftsprozesses ausgehst. Aus dieser Perspektive heraus stellen weder Predatory Journals noch Plagiate bei Dissertationen ein ernstzunehmendes Problem für den Forschungsprozess an sich dar, denn für die tatsächlich interessante Forschung spielen sie keine Rolle. Das wird in allen Disziplinen ähnlich sein, wer da bei einem Thema an der Forschungsfront ist, kennt seine Kollegen, weiß um den Forschungsstand, kann Ergebnisse einschätzen usw. Aus dieser Sicht sind diese Magazine bei den Akademikern, die hier publizieren, eher ein Sympton für die Auswirkungen des Publublikationsdrucks. Forschungsintern stellen sich in der Tat ganz andere Probleme und viel wichtigere Herausforderungen, die etwa mit dem Peer Review-Prozess verbunden sind.

Aber die Perspektive der Journalisten war – so meine Wahrnehmung – explizit eine nicht-akademische, eine von Fachfremden, die mit solchen Publikationen konfrontiert werden bzw. von Akteuren, die gar nicht am wissenschaftlichen Erkenntnisprozess interessiert sind, sondern die Autorität (oder den Nimbus) von Wissenschaft für ihre Zwecke verwenden wollen, sei es für kommerzielle Zwecke oder politische Einflussnahme. Letzteres ist ja inzwischen für die amerikanische Tabakindustrie im Bereich Medizin bzw. diverser Großkonzerne bezogen auf das Säen von Zweifel am menschlichen Anteil an der Erderwärmung umfangreich dokumentiert und aufgearbeitet worden, wie man hier “Institute”, “Fachtagungen” und “Fachzeitschriften” im Rahmen von Marketing-Kampagnen gezielt gegründet und finanziert hat.

Wenn Forscher schummeln, sich mit akademischen Graden schmücken, die sie nicht redlich erworben haben, oder finanzielle Abhängigkeiten bestehen, dann ist auch dem Laien klar, warum solche Ergebnisse zweifelhaft sind. Aber schon dass es überhaupt solche Predatory Journals gibt, dürfte kaum jemand außerhalb des akademischen Betriebs gewusst haben.

Ich habe mal in meinem Bekanntenkreis und unter Arbeitskollegen nachgefragt. Das sind ca. 25 Personen, fast alle Abitur, die meisten haben studiert und sind danach gleich ins Berufsleben übergegangen. Einige haben vor kurzem ihren Master gemacht. Das ist also keine irgendwie repräsentative Stichprobe.

Von diesen Leuten kannte KEINER den Ausdruck “Impact Factor” oder “Peer Review”. Wenn sie dann gefragt wurden, wie denn versucht wird, die Qualität der Artikel zu garantieren – Schulterzucken, darüber habe man noch nie nachgedacht. Teilweise gab’s die Idee, dass andere Professoren, die später die Artikel lesen, eine Art Leserbrief schreiben, teilweise, dass die Artikel erst Kollegen oder Mitarbeitern zur Korrektur vorgelegt werden. Wie viele wissenschaftliche Fachzeitschriften es denn gäbe – Schätzungen zwischen 1.000 und 4.000 weltweit. Ob die sich denn in ihrer Qualität und Relevanz unterscheiden würden – Schulterzucken. Selbst die Master-Leute haben ihre Artikel dank Google Scholar, Schneeballsystem oder sonstige Datenbanken per Stichworte gefunden, sich aber nie großartig Gedanken über deren Relevanz für das jeweilige Fach gemacht, auch nie, ob es vielleicht spätere Artikel gibt, die sich kritisch mit diesen beschäftigen und ggf. zu anderen Schlüssen kommen. Was es denn für große Wissenschaftsverlage gäbe – Schulterzucken. Open Access – Schulterzucken.

Von daher scheint mir die wissenschaftliche Binnenperspektive hier nicht das Problem zu sein, sondern das, was “draußen” damit passiert. Und es hilft da m.E. wenig, wenn man dann – mit guten Gründen – Entwarnung gibt, weil Außenstehende, und dazu zähle ich auch Gerichte, Behörden und Politiker, in einer ganz anderen Situation sind, wenn sie sich informieren bzw. mit Informationen konfrontiert werden. Das scheint mir ein sehr schönes Beispiel für den “curse of knowledge” zu sein.

Positiv finde ich, dass inzwischen einige Medien bei wissenschaftlichen Befunden (“Eine neue Studie x hat gezeigt, dass …”) inzwischen zusätzlich erwähnen, was und wie genau untersucht wurde, wie robust die Ergebnisse sind, inwieweit sie von anderen Befunden gestützt werden, was noch untersucht werden soll usw. Auch das wurde in den Filmbeiträgen recht gut angerissen – die Idee von Replikationen, Meta-Analysen usw. Mehr kann man m.E. im Rahmen einer Fernsehreportage nicht machen.

Spannend wäre es daher, welche Außenwirkung die von dir gefundenen Artikel hätten, wo sie zitiert werden und wie oft. Was ich damit meine? Ein Beispiel. In deiner Artikel-Liste findet man recht schnell einen Herrn, dessen Name so ähnlich wie die Vogelart “Gimpel” klingt. Eine kurze Recherche ergibt dann, dass es sich laut eigenen Angaben um einen Pharmakologen handelt, laut eigenen Angaben Honorarprofessor an einer deutschen Universität. Gleichzeitig ist er Freiberufler und arbeitet für eine Firma mit einem “Neuro” im Namen. Google sei Dank findet man dann immer mehr über ihn, etwa “He published more than 150 papers in peer-reviewed journals.” Und was macht er so? Laut Facebook “hat [er] die Wirkung homöopathischer Arzneien anhand von Messungen am EEG untersucht. Ergebnis: “Obwohl die aktiven pharmazeutischen Inhaltsstoffe der homöopathischen Zubereitung stark potenziert sind, zeigt sich im Gehirn eine starke Reaktion””. Und was findet man, wenn man noch Presseerklärungen mit seinem Namen sucht? Etwa Folgendes bei einer anderen Firma, die ein solches homöopathisches Medikament vertreibt: “Mit seinen Untersuchungen zur Wirksamkeit von Homöopathika nach anerkannten wissenschaftlichen Standards baut der Pharmahersteller xxx die Brücke zwischen Homöopathie und Schulmedizin.”

Interessant auch, wie die von dir aufgelisteten Artikel dann in die Literaturlisten von anderen Artikeln wandern (Forschungsstand?), die tatsächlich bei seriösen Zeitschriften landen, z. B. “Frontiers in Pharmacology”, und dann schließlich in der Datenbank der US National Library of Medicine geführt werden.

Da ich kein Mediziner bin, werde ich mich hüten, irgendwelche Aussagen über die Qualität diese Artikel zu treffen. Darum geht es mir auch gar nicht, das müssen andere machen. Ich finde es aber spannend, auch diese Form der “Veredelung” zu betrachten.

Hallo, und danke für den ausführlichen Kommentar! Bei Binnenwirkung und Außenwirkung habe ich übrigens durchaus differenziert. Und soweit ich sehen kann, ist das “uns ging es aber nur um die Außenwirkung!” (was ja auch in dem defensiven Illinger-Artikel steht) eine nachträgliche Kursänderung der Berichterstattung. Bei der anfänglichen Berichterstattung war immer noch “die Wissenschaft” allgemein mit allen Aspekten, Wissenschaftsbetrieb und Außenwirkung, betroffen. Insofern waren die Korrekturen (nicht nur von mir, das haben ja auch viele andere angemerkt) schon sinnvoll.

Recht haben Sie, dass ich zwar die Frage der direkten Wirkung auf die Öffentlichkeit angsprochen habe, aber nicht Interaktionen wie die von Ihnen erwähnten von Firmen. Und der Umstand, dass es ausgerechnet um homöopathische Mittel geht, war mir komplett entgangen, interessant zu wissen.

Anderseits sehe ich mich auch da bestärkt in meiner Aussage, dass es auch dort gar nicht um die Predatory Journals an sich geht. Ob so jemand nun in Predatory Journals veröffentlicht oder in Fachzeitschriften, die Homöopathen für Homöopathen herausgeben und wo sie sich gegenseitig positiv begutachten ist für den Werbeeffekt (und die damit verbundene Irreführung) egal. Gerade weil die meisten Menschen gar nicht wissen, wie Peer Review funktioniert (führe ich ja auch im Haupttext mehrmals an) ist an der Stelle der Gesamteindruck (oho, der ist wohl Teil der [regulären] Wissenschaft!) von den Details (predatory journal oder nicht, wer hat sonst noch in demselben Journal veröffentlicht) weitgehend unabhängig.

Der Frage, ob/wie die Artikel zitiert werden, bin ich nicht nachgegangen; das war jenseits dessen, was ich leisten kann, ist aber in der Tat eine hochinteressante Frage.

Hallo Alf, hallo Markus,

ich finde auch sehr positiv, dass einige Medien bei wissenschaftlichen Befunden inzwischen zusätzlich erwähnen, was und wie genau untersucht wurde, wie robust die Ergebnisse sind (z.B. Anzahl untersuchter Fälle!), inwieweit sie von anderen Befunden gestützt werden, was noch untersucht werden soll, sowie Replikationen, Meta-Analysen usw. zumindest angesprochen werden und sehe dies als eine (der) Möglichkeit(en) zur kritischen Enordnung von wissenschaftlichen Veröffentlichungen in Massenmedien. Ich weiß zwar nicht, ob diese Positiv-Beispiele von der gefährdeten Spezies der Wissenschaftsjournalisten stammen, vermute dies aber sehr stark. Hier würde ich mir für die Zukunft wünschen, dass sich diejenigen, die sich Gedanken und die Glaubwürdigkeit und die Rolle von Wissenschaft in der Gesellschaft machen (also auch die großen Wissenschaftsorganisationen), ab und an auch Vorschläge diskutieren, wie Wissenschaftsjournalismus gestärkt und ggf. weiterentwickelt werden kann (z.B. Ausbildung von Datenjournalisten? – z.B. die Volkswagenstiftung hat hierzu eine m.E. interessante Initiative). Hier sehe ich auch Verbindungen zu einer anderen Diskussion, die auf Scilogs geführt, aber leider nicht fortgesetzt wurde (https://scilogs.spektrum.de /Wissenschaftskommunikation-hoch-drei/).

Ansonsten stimme ich der Aussage von Dir, Markus, zu: “gefälschte Wissenschaft, ist ein weites Feld. Das fängt bei Komplettfälschungen an, mit erfundenen Datensätzen, duplizierten und dann leicht veränderten Diagrammen oder Abbildungen, Beschreibungen von Experimenten, die in der beschriebenen Form nie stattgefunden haben.” Zur Einordnung, wie häufig solche in der Fachdiskussion der Hochschul- und Wissenschaftsforschung auch als wissenschaftliches Fehlverhalten bezeichneten Verhaltensweisen in Deutschland vorkommen (und inwiefern sie mit Drittmitteln zusammenhängen), hatte ich mich ja in einem eigenen Blogbeitrag hier bei Scilogs bereits geäußert (https://scilogs.spektrum.de/wissenschaftssystem/fehlverhaltendrittmittel/). Auch da zeigte sich, dass es so einfach nicht ist wie oft vermutet…

Beste Grüße

René

Hallo Markus,Alf,Rene,

die bedenkliche Entwicklungen im Wissenschaftsbetrieb zeichnen sich schon lange ab.

In zunehmenden Maß gelten in der Wissenschaft neben einer totalen Ökonomisierung die Gesetze der Massenmedien und des Mainstreams.

Unser Wissenschaftssystem, die Massenmedien sowie die Gesellschaft durchwandern Umwälzungen unter den Stichworten Ökonomisierung und Medialisierung mit gewaltigen Veränderungen der jeweiligen Finanzierungs- Kommunikations- und Qualitätssicherungsstrukturen.

Sogenannte Fachzeitschriften und tatsächliche Fachzeitschriften veröffentlichen Studien in Blick auf die massenmediale Wirkung.

Die wissenschaftlicher Relevanz bleibt auf der Strecke. Bedient werden die Sensationslust, die vorher angeheizten Vorlieben des Mainstreams sowie die Notwendigkeit der Umsatzsteigerung.

Wo liegen die Ursachen der o.g. Fehlentwicklungen?

Auf der wissenschaftlichen Ebene meines Erachtens in den perversen Anreizsystemen, quasi in der Fehlsteuerung der Karrierewege und Belohnungssysteme in der akademischen Forschung.

Wissenschaftler müssen positive, am besten noch aufregende Studien, publizieren.

Je häufiger sie vom wissenschaftlichen Nachwuchs und Kollegen zitiert werden,desto erhöht sich ihre Chance nach einer befristeten Bewährungszeit eine Lebenszeitprofessur zu erhalten(Tenure-Track-Stellen).Meist ist da auch ein Aufstieg innerhalb des Professorenkollegiums verbunden.

Darüber hinaus ist der Druck auf die Universitäten Drittmittel bei privaten, der Geldvermehrung verpflichteten Unternehmen, zu akquirieren ,unerträglich geworden.(persönliche Meinung)

Insoweit ist es nicht verwunderlich, das sich Universitäten und Hochschulen mit Wissenschaftler/innen Aufmerksamkeit heischend brüsten.Immer mögliche Finanzierungen im Auge.

Ursache ist aus meiner Sicht der zu beobachtende Rückzug des Staates aus seiner Bildungsverantwortung.

Insoweit bleibt bei vielen Universitäten, Hochschulen, Fakultäten im Kampf um die knapper werdenden staatlichen Mittel nichts anderes übrig, so viel wie möglich zu publizieren und graduieren um Aufmerksamkeit auf sich zu ziehen.

Da bleibt oft die Prüfung (Peer Review)und letztlich die Qualität auf der Strecke.

Exzellenzstatus zu erreichen ist oberstes Gebot.

Der Verteilungsschlüssel der Zuschüsse an Unis und Hochschulen gewichtet sich nach Publikationen und Abschlüsse (inkl. Promotionen).

Soll heißen, wer viel publiziert und graduiert, bekommt auch viel Geld. Qualität spielt da meiner Ansicht nach keine Rolle mehr?

Hier wäre es angebracht dem Stellenpräkariat und Pseudo-Qualitätsmanagement durch einen verlässlichen Geldfluss zu Universitäten,Hochschulen zu beenden.

Erforderlich ist in der Ausbildung die Vermittlung von Methodenkompetenz, klare Auswahlkriterien in den akademischen Karrierewegen, Qualitätsbelohnung sowie nachvollziehbare Kriterien der Leistungsbewertung.

Und das unabhängig vom „vergötterten“ Impact Faktor, welcher die Anzahl der Zitierungen als Beurteilungskriterium für wissenschaftlicher Publikationsleistungen verwendet.

Peter

@Peter Ullmann: Viele der problematischen Einflüsse sehe ich genauso.

Bei einigen der Punkte ist es aber wichtig, genauer hinzugucken. Dass Fachzeitschriften Studien mit Blick auf die massenmediale Wirkung veröffentlichen, sehe ich anders. Dass darauf geschaut ist, ob etwas “spektakulär genug” ist kenne ich in der Astronomie allenfalls von Nature und Science. Bei den “Arbeitspferden” wie Astronomy & Astrophysics, Astrophysical Journal oder MNRAS stelle ich nichts dergleichen fest. Im Gegenteil: Wenn ich meinen Hut als Öffentlichkeitsarbeiter für mein Institut aufhabe, bin ich in der Regel in der Situation, dass da Dinge sind, die von den Wissenschaftlern, meinen Direktoren und/oder offenbar auch von den Gutachtern als richtig sensationell eingestuft werden, großer Fortschritt für das Fach etc., bei denen es aber echt schwer ist, dazu eine ansprechende Pressemitteilung zu schreiben – die haben nämlich massenmedial so gut wie gar keine Attraktivität.

Die Überlegungen der Subskriptionszeitschriften zur Umsatzsteigerung sind auch ganz andere. Die wollen möglichst viele teure Komplettpakete an Unis oder Forschungsinstitutionen verkaufen. Schon die einzelnen Fachzeitschriften fallen da nicht ins Gewicht; massenmediale Wirkung auch nicht. Wichtig ist da nur, dass die Wissenschaftler die Fachzeitschriften wichtig finden und dementsprechend ihre Uni drängen, die anzuschaffen.

Karriere-Anreize: Ja und nein. Ich bekomme von meinen Kollegen ja nebenbei ein bisschen mit, wer als vielversprechend eingestuft wird, oder sogar als “Star”. Aber da ist nie von Publikationszahlen die Rede, sondern immer davon, dass die Person eine bestimmte Sache herausgefunden hat, die dem Forschungsgebiet eine neue Richtung gegeben hat, oder ein Problem gelöst, das ganz lange ungelöst war oder dergleichen. Soweit ich sehen kann, findet die Auswahl für Postdoc- oder Gruppenleiterstellen nach ähnlichen Kriterien statt. Schwieriger wird es vermutlich im breiteren Rahmen, wenn z.B. bei einer Uni Menschen mit ganz unterschiedlichen Spezialisierungen um eine Professorenstelle konkurrieren. Ich kann mir vorstellen, dass die formalen Kriterien (wieviel und wo publiziert) dann wichtiger werden.

Drittmittel: Meiner Erfahrung nach sind solche Geldgeber wie DFG da wichtiger als private Firmen, aber das kann natürlich von Fachgebiet zu Fachgebiet variieren. In der Astronomie bzw. bei Max-Planck ist das natürlich anders als z.B. bei Fraunhofer-Instituten, die deutlich anwendungsorientierter sind. Die Drittmittel-Begutachtungen (Sonderforschungsbereich) die ich bislang mitbekommen habe, fand ich allerdings recht ermutigend. Da wurde den Wissenschaftlern wirklich auf den Zahn gefühlt, es ging ganz offensichtlich um Qualität und darum, ob das, was da versprochen wurde, auch würde gehalten werden können, und dort wo sich beim Nachfragen Schwachstellen gezeigt haben, wurde der Antrag dann auch konsequent gekürzt.

Bei solchen Anträgen gibt es ja (zumindest zum Teil) auch Verfahrensänderungen, die “Masse statt Klasse” vorbeugen sollen, indem z.B. die Anzahl der Publikationen, die genannt werden kann, begrenzt wird. Dadurch wird die reine Anzahl der Publikationen weniger wichtig als die Qualität der einzelnen Publikationen.

Darüber, dass es verlässlichere Karrierestrukturen für Wissenschaftler/innen und bessere Grundfinanzierung der Hochschulen geben sollte (wobei ein besonderes Problem ja der Schlüssel mit den Studienplätzen zu sein scheint, der verhindet, dass sich die Verhältnisse da entspannen), sind wir uns vermutlich einig. Dass es einen ganz allgemeinen Verteilungsschlüssel nach Publikationen und Abschlüssen geben würde, ist mir neu, und auch Googeln bringt mir da erstmal keine Antwort – dazu wäre ein Link nett.

Hallo Markus,

nur beim Erreichen des Exzellenzstatus(Universitäten) ist der Mittelzufluss gewährleistet.

Niemand wird offiziell zugeben, dass der Verteilungsschlüssel für die Zuschüsse und deren Gewichtung sich nach der Anzahl der Publikationen und Abschlüssen vollzieht.

Insoweit resultiert meine These aus Gesprächen und Erfahrungen.

Natürlich argumentiert die staatliche Ebene bezüglich der wissenschaftspolitischen Steuerungsmechanismen vom Anspruch her objektiv nach den sogenannten Leistungskriterien wie forschungsbezogene Handeln, Drittmittelakquisition, Praxisrelevanz, Patente, Produktinnovationen etc.

Da die Entscheider bezüglich des Exzellenzstatus unterschwellig subjektive vom Mainstream beeinflussten Urteilen unterliegen sowie sie häufig managerorientierten Ansätze(Lobbyisten?)präferieren hat dies auch Auswirkungen auf das Verhalten der Wissenschaftler in der Forschung und Lehre?

Ich meine ja.

Ob Eitelkeiten oder Karrieredenken oder das Durchschauen von Kausalitäten bei den Veröffentlichungen eine Rolle spielen?

Auch entscheidend innerhalb bzw.in der Außendarstellung von Universitäten und Hochschulen ist auch das Ranking in Hinblick auf die Attraktivität und Orientierungshilfe bei der Studien-und Ortswahl. Da schmückt man sich gerne mit Veröffentlichungen und Promotionen.

Peter

@Peter: Nein, ich denke das verkennt nicht zuletzt die unterschiedlichen Prioritäten der unterschiedlichen Länder. Bestimmte Länder haben nunmal auf Studierendenausbildung im großen Stil gesetzt. Anders gesagt: wenn der Landesregierung Forschung und exzellente Wissenschaft weniger wichtig ist als solide Studierendenausbildung um eine gut ausgebildete Bevölkerung zu haben, dann werden sie kaum nach Publikationen gewichten. Und ob sie nach Abschlüssen oder nach Studienplatzzahl gewichten, kommt dann auch darauf an.

Argumentiert die staatliche Ebene denn überhaupt nach Leistungskriterien? Wie gesagt, bei den Ländern spielen doch noch ganz andere Faktoren eine Rolle.

Attraktivität für Studierende ist für die Universitäten/Hochschulen aber in der Tat ein wichtiges Kriterium. Aber ob da Veröffentlichungen und Anzahl der Promotionen die entscheidende Rolle bei der Studienwahl spielen, bezweifle ich. Da dürften verfügbarer Wohnraum und gute Kennzahlen für die Lehre wichtiger sein.

PS.

aus meiner Sicht werden die staatlichen Zuschüsse an Universitäten und Hochschulen in Zukunft leider rückläufig sein? Dominieren und damit profitorientiert werden Finanzierungsmodelle sein, welche sich aus weltweit operierenden Konzernen speisen?

Peter

@Peter: Woher stammt diese Vermutung? 90% der Hochschulfinanzierung stammen aus der öffentlichen Hand (hier), und die Grundversorgung mit Studienplätzen zu gefährden ist sicher nichts, mit dem man als Landesregierung oder Bundesregierung Wahlen gewinnt.

Hallo Markus,

Unstreitig ist, dass die Hochschulfinanzierung zu 90% von den Ländern und dem Bund getragen wird.(Binsenweisheit) Interessant ist der detailorientierte Blick auf die staatlichen Finanzströme.

Mit den 90%(circa 75% die Länder und circa 15% der Bund) werden lediglich die Grundfinanzierung der Universitäten und Hochschulen abgedeckt.

Bekannt ist doch die Unterfinanzierung unseres Bildungs-und Wissenschaftssystems.

Dies speziell bei der Finanzierung der immer mehr an Bedeutung gewinnenden Forschung und Entwicklung.

Erkenne zwar die Beteiligung des Bundes an der Finanzierungsbeteiligung bei der Grundlagenforschung und über sogenannten Exzellenzinitiativen, Schwerpunktprogramme etc.

Aber die angewandte Forschung und experimentelle Entwicklung werden, von der Tendenz her, immer mehr durch profitorientierte private Mittel finanziert.

Sei es durch Auftragsforschung, arbeitsteilige Kooperation und Sponsoring.

Dies ist keine Vermutung sondern gängige Praxis.

Besonders betroffen sind hauptsächlich die Medizin-Natur-und Technikwissenschaft zumal sie immer mehr integraler Bestandteil internationaler Konkurrenz-und Innovationssysteme werden.

Das der private Finanzierungsanteil Anbetracht einer sich im tiefgreifenden Umbruch befindlichen Gesellschafts-und Bildungslandschaft(weltweit) ständig steigen muss kann m.E. niemand in Abrede stellen.

Ob die privaten Finanzierungen letztlich integrale Bestandteile einer neuen Wertschöpfungskette werden bzw. welche Auswirkungen sie auf den Wissenschaftsbetrieb haben, ist die noch zu beantwortende Frage ?

Ökonomisierung und Medialisierung, Simplifizierung sowie Reduktion komplexer Sachverhalte sind scheinbar notwendige Folgen.

Möglicherweise liegt in dieser tendenziellen zu beobachteten Ökonomisierung und Medialisierung die Veröffentlichung der geschätzten 5000 Wissenschaftlern von „Forschungsarbeiten“in dubiosen Verlagen?

Natürlich sind auch seriöse Zeitschriften nicht davor gefeit( Impact Faktor). Zumindest ist eine redaktionellen Strategie,welche sich den Massenmedien angleicht, aus meiner Sicht erkennbar??

Das diese stattfindende Änderung der Rahmenbedingungen ein Kommunikationsverhalten begünstigt ,welches durch vielleicht notwendiges Eigeninteresse motiviert ist?

Gerade bei Universitäten und Forschungseinrichtungen sieht man die Versuche des Umbaues ihrer Presseabteilungen zu Public-Relations-Abteilungen.

Persönlich sehe die Gefahr der Eigenwerbung auf Kosten einer sachgerechten Darstellung von Wissenschaft?

Neben der scheinbar unabänderlichen „Ökonomisierung“ tragen die perversen Anreizsystemen sowie Fehlsteuerung der Karrierewege und Belohnungssysteme in der akademischen Forschung die Hauptschuld.

Die zu beobachtenden neuen Handlungsstrategien(New Public Management)der Universitäten entsprechen immer mehr der Logik der Märkte im Sinne der Erwartungen der Auftraggeber bzw. Kooperationspartner.

Ob die im Hintergrund stehende scheinbar notwendige Einwerbung von privaten Forschungsgeldern im Zuge der geänderten Wettbewerbsbedingungen muss die Praxis erweisen.

Die Gefahr liegt meiner Ansicht nach in der Verschwommenheit zwischen Kommunikation und Marketing zwischen Aufmerksamkeit heischende Eigenwerbung und Vermittlung wissenschaftlicher Informationen ?

Die medialen und öffentlichkeitswirksamen Pressemitteilungen bekommen immer mehr Gewicht.

Apropos die von dir erwähnten Wahlen.

Hier fallen die Entscheidungen mit großer Sicherheit nicht auf dem Gebiete der Bildungspolitik und deren Finanzierung.

Peter

@Peter: Daran finde ich wiederum einige Aussagen falsch. Unterfinanzierung gerade bei Forschung und Entwicklung? Gerade anders herum: dort gibt es zumindest noch Drittmittel-Möglichkeiten; im Gegenteil sieht es bei der Finanzierung der Lehre deutlich schwieriger aus.

Ökonomisierung etc.: Das dürfte bei den angewandten Wissenschaften in der Tat wichtiger sein. Umso wichtiger, an der Stelle nicht zu verallgemeinern.

Ökonomisierung und die 5000 Wissenschaftler bei dubiosen Verlagen? Darauf ergab meine Analyse keinen direkten Hinweis.

Eigenwerbung auf Kosten einer sachgerechten Darstellung: Die Gefahr mag da sein; ob sie sooo relevant ist, weiß ich nicht. Wenn eine Universität sich mit wiederholt nicht sachgerechten Darstellungen hervortun würde muss bloß ein investigativer Journalist kommen und das kritisch dokumentieren, und der positive PR-Effekt ist geschwächt (siehe z.B. http://www.medien-doktor.de/).

Aussagen wie dass die “öffentlichkeitswirksamen Pressemitteilung” “immer mehr Gewicht” bekommen kann ich nicht nachvollziehen. Wo sind die Belege, dass das ein Trend ist? Öffentlichkeitswirksame Pressemitteilungen haben immer öffentlich mehr Gewicht bekommen, per Definition.

Wahlen, bei denen die Entscheidungen angeblich nicht auf dem Gebiete der Bildungspolitik fallen: Schau dir mal die Regierungskrise bei der Schwarz-Grünen Bildungsreform in Hamburg an. Die war einer der Gründe, warum die Grünen die Koalition dann aufgekündigt hatten und insgesamt zeitweise ein dermaßen beherrschendes Thema in Hamburg, dass die FAZ von vorgezogenem Wahlkampf sprach. Insofern: Falls es einer Landesregierung in den Sinn käme, die eigenen Hochschulen radikal zusammenstreichen zu wollen, gibt es sicherlich auf Landesebene wahlrelevante Proteste.

Hallo Markus,

bezüglich der „Gewichtszunahme“ medialer Pressemitteilungen hier ein Link der Nationale Akademie der Wissenschaften Leopoldina,

der Deutsche Akademie der Technikwissenschaften – acatech sowie der Union der deutschen Akademien der Wissenschaften zur Gestaltung

der Kommunikation zwischen Wissenschaft, Öffentlichkeit und den Medien vor dem Hintergrund aktueller Entwicklungen

http://docplayer.org/38002-Zur-gestaltung-der-kommunikation-zwischen-wissenschaft-oeffentlichkeit-und-den-medien.html

Hier noch ein weiterer Link zur gewissermaßen gleichen Problematik

https://link.springer.com/chapter/10.1007/978-3-662-47843-1_17

Peter

@Peter: Ach ja, die gute alte WÖM-Stellungnahme. Die sich vor allem dadurch hervortat, dass sie, und das im Jahre 2014 (!), den gesamten Komplex Soziale Medien komplett vernachlässigte. Die und ihren ebenso problematischen Nachfolger WÖM2 sollte man nie verlinken, ohne gleichzeitig auf die große Linkliste von Marcus Anhäuser zu verweisen, die auf die Vielzahl kritischer Antworten zu diesen Stellungnahmen verweist. Ich hatte auf diesem Blog ja auch auf die Schwachstellen der beiden Stellungnahmen aufmerksam gemacht (hier und hier). Und nein: die sollte man nicht unkommentiert als Beleg anführen – dazu stehen zuviele Aussagen darin, die einfach nicht belegt sind.

In dem Springer-Kapitel sehe ich auch keine Belege für die “‘Gewichtszunahme’ medialer Pressemitteilungen”. Auf die dort erwähnte Sonderrolle von Nature und Science war ich ja in einer früheren Antwort an Sie bereits eingegangen.

@Markus,danke dir für die Linkhinweise.

Insbesondere für die Linkliste von Marcus Anhäuser.

Peter