Wissenschaftliches Fehlverhalten und Drittmittel – empirische Befunde

BLOG: Über das Wissenschaftssystem

Wohlstand und Entwicklung moderner Gesellschaften hängen in hohem Maße von der Qualität wissenschaftlicher Erkenntnis ab. Fälle von Fehlverhalten beeinträchtigen das Vertrauen darin, worauf die Wissenschaft reagieren muss. Vergangene Woche wurde das Open Science Center an der LMU München mit dem Ziel eröffnet, offene und replizierbare Forschung zu stärken, indem der wissenschaftliche Nachwuchs sensibilisiert und der Prozess der Forschung selbst Gegenstand der Forschung wird. Bislang sind zu dieser Thematik in Deutschland nur wenige empirische Arbeiten bekannt. Insbesondere der Zusammenhang von Drittmittelfinanzierung und Fehlverhalten ist bislang kaum empirisch untersucht worden. Hier werden daher Ergebnisse empirischer Analysen zum wissenschaftlichen Fehlverhalten in Deutschland vorgestellt.[1]

Mögliche Ursachen und Rahmenbedingungen von Fehlverhalten

In den Leitlinien der Deutschen Forschungsgemeinschaft (DFG 2016) wurden wiederholt Plagiate und andere Autorschaftsvergehen, „Ideendiebstahl“ und inhaltliche Verfälschungen thematisiert[2] und der Umgang damit konkretisiert. Zuvor hatte bereits der Wissenschaftsrat (2015) seine Empfehlungen zu wissenschaftlicher Integrität veröffentlicht, danach die Deutsche Forschungsgemeinschaft 2017 Empfehlungen zur Replizierbarkeit, und kürzlich der Deutsche Hochschulverband (2018) seine Empfehlungen zum Umgang mit Whistleblowern. Die Entwicklungen, auf die hier reagiert wird, haben auch mit Rahmenbedingungen wie sich verändernden Steuerungsmechanismen bzw. sich verändernder Governance der Wissenschaft zu tun. Neben ihrem Anspruch auf Wahrheitssuche verstärkt laut Wissenschaftsrat (2015) der gestiegene Anspruch auf Autonomie[3] die Verantwortung der Wissenschaft für wissenschaftliche Integrität. Darüber hinaus veränderten sich im Zusammenhang mit der veränderten Governance der Wissenschaft in der letzten Dekade stärker auch die Rahmenbedingungen der Forschung (vgl. Grande u.a. 2013, Krempkow u.a. 2014, Welpe u.a. 2015), so u.a. durch die mit einer stärkeren Wettbewerbsorientierung einhergehende stärkere Drittmittelfinanzierung. Zum Zusammenhang von Drittmitteln und wissenschaftlichem Fehlverhalten zitiert der Wissenschaftsrat (2015, S. 10) die DFG-Denkschrift (2013): „Dabei wird der Wandel des Wissenschaftssystems hin zu ´großbetrieblicher´ Wissensproduktion und die damit einhergehende Produktivitäts- und Quantitätsideologie in der wettbewerblichen Wissenschaft als wichtiger Einflussfaktor für die Motivation gesehen, durch regelwidriges Verhalten zum Erfolg zu kommen.“ Er verweist auf seine Empfehlungen zur Bewertung und Steuerung von Forschungsleistung (Wissenschaftsrat 2011), in denen er Drittmittelabhängigkeit und Wettbewerb in der Wissenschaft als „mitverursachende Rahmenbedingungen wissenschaftlichen Fehlverhaltens“ hinterfragt.[4] Allerdings beklagt der Wissenschaftsrat, Fehlverhaltensaspekte seien unterschiedlich gut dokumentiert und statistisch erfasst. Nachfolgend möchte ich daher einen kurzen Überblick über die bisherige Forschung zum Ausmaß des wissenschaftlichen Fehlverhaltens in Deutschland geben und ausgewählte Ergebnisse dazu berichten. Leitfragen hierfür sind:

- Sind öffentlich gewordene Fälle wissenschaftlichen Fehlverhaltens nur „die Spitze eines Eisbergs“ (Dannemann/Weber-Wulff 2015, S. 278; Dirnagl in Borgwardt 2014, S. 16) und hat die Wissenschaft demnach ein generelles Qualitätsproblem; oder sind dies Einzelfälle, deren Aufdeckung „Beleg für die Wirksamkeit der Selbstreinigungskräfte des Wissenschaftssystems“ sind (Neufeld 2014, S. 3)?

- Inwiefern geht eine Dominanz bestimmter Drittmittelquellen mit häufigerem Fehlverhalten einher?

Was sagt die bisherige Forschung zum wissenschaftlichen Fehlverhalten?

Aus der o.g. Empfehlung des Wissenschaftsrates (2015) ist zunächst die von ihm selbst durchgeführte Erhebung zu nennen. Sie fokussiert v.a. die Bekanntheit und Anwendung von (Verfahrens-)Leitlinien zu wissenschaftlichem Fehlverhalten/Integrität (Wissenschaftsrat 2015, S. 17f.). Zur Häufigkeit von Fehlverhalten wird lediglich eine Studie für Deutschland zitiert: Die iFQ-Wissenschaftler-Befragung[5] (vgl. Böhmer u.a. 2011). Dies war eine Befragung v.a. zu Forschungsaktivitäten und Arbeitsbedingungen, wobei auch Fragen zu wissenschaftlichem Fehlverhalten und Integrität integriert wurden.[6]

Neben der iFQ-Wissenschaftler-Befragung gibt es mit der Studie „Governance Hochschulmedizin – GOMED“ noch eine spezifisch auf die Medizin ausgerichtete Erhebung, die Fehlverhalten intensiver empirisch analysierte (vgl. Krempkow u.a. 2013).[7] Weitere Studien, die für Deutschland die Häufigkeit von Fehlverhalten berichten, sind derzeit nicht bekannt.[8] International gibt es zwar weitere Studien (vgl. Fanelli 2009), allerdings sind gerade Aussagen zum Fehlverhalten in starkem Maße im Kontext des jeweiligen Wissenschaftssystems zu sehen (vgl. auch Neufeld 2014, S. 3). Deshalb und wegen unterschiedlicher Erhebungsmethoden und Operationalisierungen erfolgen hier keine länderübergreifenden Vergleiche, sondern eine Fokusierung auf Deutschland.[9]

Wie verbreitet ist wissenschaftliches Fehlverhalten in Deutschland?

Wissenschaftliches Fehlverhalten umfasst nicht nur Plagiate oder Datenfälschung, sondern auch die Grauzone verschiedener Formen nicht integren oder unverantwortlichen Verhaltens (Wissenschaftsrat 2015). In der iFQ-Wissenschaftlerbefragung wurden neben Plagiaten oder Datenfälschung eine Reihe weiterer Aspekte adressiert. Zudem wurden Aspekte ergänzt, die in den DFG-Richtlinien (DFG 1998, ähnlich 2015) dargelegt sind (vgl. Böhmer u.a. 2011, S. 149f.).[10]

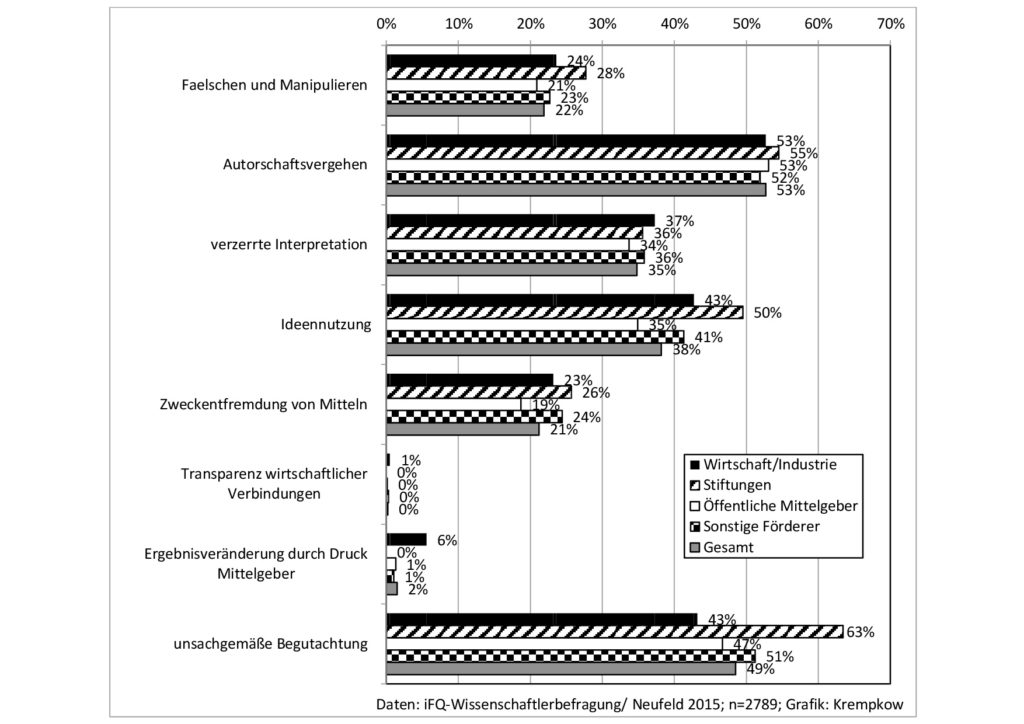

Das häufigste erfasste Fehlverhalten betrifft Autorschaftsfragen (mit 53% Fehlverhalten[11]) sowie Begutachtungsfragen (49%). Relativ häufig genannt werden auch die Ideennutzung von Dritten ohne deren Einverständnis (mit 38%), und die verzerrende bzw. einseitige Interpretation von Daten und Befunden (35%). Eher selten bzw. so gut wie überhaupt nicht angegeben wird dagegen die Ergebnisveränderung durch Druck von Mittelgebern (2%) und die fehlende Offenlegung/Transparenz wirtschaftlicher Verbindungen (0%). Die Gesamtverteilung des wissenschaftlichen Fehlverhaltens in Deutschland ist in Abb. 1 nachfolgend mit dargestellt.

Wie unterscheidet sich wissenschaftliches Fehlverhalten in den Fächergruppen?

Das Fehlverhalten ist keineswegs gleichmäßig über die Fächergruppen verteilt. Vielmehr tritt es in einzelnen Fächergruppen deutlich häufiger auf als in anderen, was hier anhand der am stärksten beobachteten Fehlverhaltensaspekte vorgestellt wird (vgl. auch Böhmer u.a. 2011: 152f.):

- Die unrechtmäßige Autorschaftsvergabe wird von 37% der Geisteswissenschaftler/innen in mindestens einem Fall genannt. In den Lebenswissenschaften wird die unrechtmäßige Autorschaftsvergabe etwa doppelt so häufig erlebt (z.B. Medizin 78%). Die übrigen Fächergruppen liegen etwa im Gesamtschnitt. Die Unterschiede zwischen Fächergruppen können allerdings auch auf Unterschiede in der (Wahrnehmung der) Autorschaftsvergabepraxis zurückgehen.[12] Da es bei der Erfassung von Fehlverhalten letztlich um Regelverletzungen geht, sind die Unterschiede zwischen den Fächerkulturen bei der Interpretation zu berücksichtigen. Häufigere Regelverletzungen markieren gleichwohl häufigeres Fehlverhalten.

- Unsachgemäße bzw. nachlässige Begutachtung oder Nichtanzeige von Befangenheit wird in den Ingenieurwissenschaften von 39% genannt, in den Geisteswissenschaftler von 50% und in der Medizin wie auch in der Mathematik und den Geowissenschaften von 56%.

- Unerlaubte Ideennutzung erlebten in der Mathematik und den Geowissenschaften 32, in den Wirtschafts- und Sozialwissenschaften 42%, den Geisteswissenschaften 44% und in der Medizin 46%. Die anderen Fächergruppen liegen etwa im Gesamtdurchschnitt.

- Verzerrte Interpretationen werden ähnlich wie bei der unerlaubten Ideennutzung ebenfalls in der Mathematik und Geowissenschaftlen mit 24% am seltensten genannt, außerdem hier von den Geisteswissenschaften mit 25% ähnlich selten. Am häufigsten betrifft dies wiederum die Lebenswissenschaften mit rund 52%.

Die Fächergruppenunterschiede zeigen, dass Fehlverhalten in den Lebenswissenschaften und v.a. in der Medizin in den häufigsten Fehlverhaltensaspekten deutlich weiter verbreitet ist als im Gesamtschnitt aller Fächergruppen (vgl. ähnlich dazu Dirnagl in Borgwardt 2014). Auf die Medizin soll zu einem späteren Zeitpunkt in einem ergänzenden Blogbeitrag noch genauer eingegangen werden. Nachfolgend wird nun die bislang einzige Analyse zum Zusammenhang von Drittmitteln und Fehlverhalten in Deutschland vorgestellt.

Welche Rolle spielen dabei Drittmittel?

In der Literatur wie auch in öffentlichen Diskussionen wurde mehrfach darauf hingewiesen, dass der zunehmende Druck zur Einwerbung von Drittmitteln negative Auswirkungen auf die Qualität der wissenschaftlichen Arbeiten haben kann (vgl. z.B. Winterfeldt 1999, Borgwardt 2014). Bislang wurde dies für Deutschland jedoch kaum anhand empirischer Studien überprüft. Ausgangsbasis hierfür sind Ergebnisse zur Relevanz von Drittmitteln für die Forschung: Nach der letzten veröffentlichten Studie für Deutschland insgesamt von Böhmer u.a. (2011) nahm die Professorenschaft in Deutschland bereits zu diesem Zeitpunkt einen hohen Druck zur Einwerbung von Drittmitteln wahr, so dass Forschung ohne Drittmittel aus Sicht der Befragten kaum möglich war: Nur 18% der Professor/inn/en gaben an, auch ohne Drittmittel ihren Forschungsfragen nachgehen zu können (Böhmer u.a. 2011, S. 85f.). Die Notwendigkeit, eine Finanzierungsquelle für die Umsetzung von Forschungsideen zu finden, wurde für Lebenswissenschaften wie für experimentelle Naturwissenschaften ähnlich in stärkerer Weise wahrgenommen. Dagegen gilt dies z.B. für die Geisteswissenschaften und die Wirtschafts-/ Sozialwissenschaften deutlich weniger, aber auch dort immer noch für etwa die Hälfte. Die Angaben korrespondieren mit der bekannten unterschiedlichen Drittmittelintensität der Fächer. Dies ist aber nur einer von mehreren wichtigen Faktoren. Ebenfalls wichtig sind nach den Ergebnissen der iFQ-Befragung die Weiterfinanzierung der Mitarbeitenden, die Steigerung der eigenen Reputation und der Aufbau von Forschungsinfrastruktur (ebd.). Für einzelne Fächergruppen sind jedoch auch noch andere Faktoren relevant: So ist z.B. für die Medizin zusätzlich auch bedeutsam, dass die Professorenschaft von eingeworbenen Drittmitteln im Rahmen leistungsorientierter Mittelzuweisungen profitiert[13]

Einleitend wurde bereits dargelegt, dass aus Sicht des Wissenschaftsrates (2015) die stärkere Drittmittelfinanzierung zu einem gestiegenen Problemdruck beiträgt. Zum Zusammenhang von Drittmitteln und wissenschaftlichem Fehlverhalten hieß es, dies werde als wichtiger Einflussfaktor für die Motivation gesehen, durch regelwidriges Verhalten zum Erfolg zu kommen, weshalb Drittmittelabhängigkeit als mitverursachende Rahmenbedingung wissenschaftlichen Fehlverhaltens hinterfragt wird (vgl. Wissenschaftsrat 2015). Insbesondere bei starker Abhängigkeit von Drittmitteln aus der Wirtschaft bzw. Industrie wird vermutet, dass dies hier deutlich häufiger zu Fehlverhalten kommt (vgl. z.B. Winterfeldt 1999, Münch 2011).[14] In der Tat stieg der Anteil der Drittmittel an den Einnahmen der Hochschulen insgesamt (ohne Verwaltungseinnahmen) laut letztem DFG-Förderatlas (DFG 2015, S. 25) von 19% in 2003 auf zuletzt 28 Prozent (vgl. ähnlich Hornbostel/ Patzwaldt 2015, sowie StBA 2018). Allerdings stieg innerhalb der Drittmittel der Anteil der Gelder aus der Wirtschaft/ Industrie keineswegs. Vielmehr sank der Wirtschafts-/Industrieanteil an den Drittmitteln von 28% in 2005 auf zuletzt 20% (DFG 2015, S. 27). Im Gegenzug stieg die Bedeutung öffentlicher Drittmittel deutlich. Aufgrund der Reputationsrelevanz[15] von öffentlichen Drittmitteln wie der DFG oder EU könnte man aber auch bei DFG-Förderungen die Motivation vermuten, durch regelwidriges Verhalten zum Erfolg zu kommen. Andererseits könnte die Forderung nach (späterer) Verfügbarkeit der Daten als Scientific Use Files bei öffentlichen Drittmitteln dazu führen, dass hier z.B. weniger manipuliert wird. Zur Überprüfung dieser Thesen wurde gemeinsam mit dem iFQ Berlin (der jetztigen DZHW-Abteilung 2) eine Sonderauswertung der Wissenschaftlerbefragung zum Zusammenhang von Drittmittelquellen und wissenschaftlichem Fehlverhalten konzipiert und von diesem durchgeführt.[16] Hierbei wurden die erfassten Aspekte wissenschaftlichen Fehlverhaltens nach der primären Quelle der Drittmittelfinanzierung differenziert ausgewertet (vgl. auch Böhmer u.a. 2011: 38). So wird prüfbar, ob bei Dominanz bestimmter Drittmittelquellen (wenn sie den größten Anteil umfassen) ggf. bestimmtes Fehlverhalten häufiger auftritt (siehe Abb. 1):

Abb. 1: Wissenschaftliches Fehlverhalten in Deutschland und Quelle der Drittmittelfinanzierung

Im Ergebnis lässt sich die These, dass bei primärer Drittmittelvergabe aus der Wirtschaft/Industrie deutlich häufiger wissenschaftliches Fehlverhalten auftritt, so nicht bestätigen. Fälschen und Manipulieren, Autorschaftsvergehen, verzerrte Interpretation und Zweckentfremdung von Mitteln kommt bei diesen Drittmittelgebern nicht häufiger vor als insgesamt. Lediglich die Ideennutzung von Dritten ohne deren Einverständnis (43 vs. 38%) wird fünf Prozentpunkte häufiger genannt, Ergebnisveränderungen durch Druck von Mittelgebern vier Prozentpunkte häufiger (6% vs. 2%). Unsachgemäße Begutachtung kommt dagegen bei Drittmitteln aus der Wirtschaft/Industrie deutlich seltener vor und die fehlende Transparenz wirtschaftlicher Verbindungen wurde wie bei anderen Drittmittelgebern so gut wie überhaupt nicht angegeben. Allerdings treten bei Dominanz von Stiftungen als Drittmittelquelle unsachgemäße Begutachtung und unerlaubte Ideennutzung häufiger auf als insgesamt. Bei überwiegend öffentlichen Drittmittelgebern lässt sich mit den verfügbaren Daten wiederum kein Zusammenhang bestätigen, dass weniger oder mehr Fehlverhalten berichtet wird als insgesamt; immerhin ist die unerlaubte Ideennutzung hier etwas seltener als insgesamt.

Folgerungen

Die Verantwortung für wissenschaftliche Integrität wird „in vielen Fällen zuverlässig wahrgenommen, wichtige Veränderungen wurden in den letzten Jahren angestoßen und Empfehlungen der zentralen Leitlinien umgesetzt. In einigen Bereichen sind jedoch weitere Anstrengungen und Entwicklungen nötig, um die Kultur wissenschaftlicher Integrität nachhaltig zu stärken“ – formulierte der Wissenschaftsrat (2015). Die hier dargestellten Ergebnisse empirischer Erhebungen geben zusätzliche Hinweise dafür, bei welchen Aspekten die wissenschaftliche Integrität relativ gut gewahrt wird und bei welchen ggf. noch stärker angesetzt werden müsste. So zeigt sich, dass die übergroße Mehrheit der Wissenschaftler bezüglich der Transparenz wirtschaftlicher Verbindungen kein Fehlverhalten beobachteten bzw. für sich selbst angaben. Deutlich anders sieht dies jedoch insbesondere bei Autorschaften aus. Dies gilt auch bei unsachgemäßen Begutachtungen, die ebenfalls häufig vorkommen, was bislang nur selten thematisiert wurde.

Die These, dass bei primärer Drittmittelvergabe aus der Wirtschaft/Industrie deutlich häufiger wissenschaftliches Fehlverhalten auftreten würde, hat sich allerdings nicht bestätigt. Dies verweist darauf, dass an erster Stelle die wissenschaftlichen Gemeinschaft und die Hochschulen selbst große Eigenverantwortung haben (vgl. auch Borgwardt 2014). Sie müssen diese verstärkt wahrnehmen, um Fehlverhalten zurückzudrängen. Wenn die Wirtschaft/Industrie als Drittmittelgeber dominiert, sind v.a. Ergebnisveränderungen und diese um wenige Prozentpunkte häufiger. Aber auch solche Differenzen sollten nicht unterbewertet und die vom Wissenschaftsrat (2015: 42) empfohlenen Maßnahmen verstärkt werden; so die (an Forschungsförderer insgesamt gerichtete) Empfehlung, klare Verfahrensordnungen und Zuständigkeiten bei Konfliktfällen und Ombudsstellen zur Auflage für die Finanzierung zu machen. Darüber hinaus könnte die bei Dominanz von Stiftungen als Drittmittelquelle deutlich häufiger festgestellte unsachgemäße Begutachtung ein Anlass sein, seitens der Hochschulen und der Stiftungen sachgemäße Begutachtungsverfahren z.B. stärker durch entsprechende Leitlinien zu fördern. Der Wissenschaftsrat empfiehlt zudem, bei der Gutachterauswahl stärker auf Unbefangenheit zu achten und Gutachtertätigkeiten sowie entspr. Problembewusstsein bei der Leistungsbewertung aktiv zu unterstützen.[17] In Borgwardt (2014, S. 59) werden bei grobem Fehlverhalten über den befristeten Ausschluss aus der (DFG-)Förderung hinaus weitere Sanktionierungen empfohlen.

Darüber hinaus ist an dieser Stelle auf die Rolle förderlicher oder hinderlicher Rahmenbedingungen für die Prävention von Fehlverhalten bzw. für wissenschaftliche Integrität in Deutschland hinzuweisen: Dies betrifft die Beschäftigungsbedingungen und Abhängigkeitsverhältnisse, die einen mehr oder weniger subtilen Druck z.B. zur Aufnahme von Vorgesetzten als (Ko-)Autoren ohne eigenständigen Beitrag wahrscheinlicher machen (vgl. Wissenschaftsrat 2015: 37f., Kramer 2016). In einzelnen privatwirtschaftlichen Forschungs- und Beratungsinstituten reicht dies z.T. bis zum vorformulierten Verzicht auf Urheberrechte in Arbeitsverträgen für wissenschaftliche Mitarbeiter, aufgrund dessen Institutsleiter für die von ihren Mitarbeitern erstellten Manuskripte die Ko- oder sogar Allein-Autorschaft beanspruchten. Wenngleich sich dies aufgrund der u.a. von Publikationsorganen eingeforderten Einhaltung der Regeln guter wissenschaftlicher Praxis glücklicherweise nicht immer in Veröffentlichungen niederschlägt, erhellt dies doch schlaglichtartig die Beschäftigungssituation, in der teilweise gearbeitet wird, und wo anzusetzen ist.

Auch der durch eine stark quantitativ ausgerichtete Leistungsbewertung verstärkte Publikationsdruck trägt zu solchem Verhalten bei (vgl. Wissenschaftsrat 2015: 31). Ähnlich muss dies für die Forderung einer bestimmten Mindestzahl an einschlägigen Publikationen zu einer bestimmten Zeitspanne bei einigen Förderausschreibungen für die Drittmittelakquise konstatiert werden (vgl. Wissenschaftsrat 2015: 37). Dagegen hat die DFG (2010) mit ihrer Initiative „Qualität statt Quantität“ eine Höchstzahl von Publikationen festgelegt („Best-Five“-Regelung), die der Wissenschaftsrat zur Übernahme empfiehlt. Einige Förderinitiativen z.B. des Bundes haben sich dieser Praxis bereits angeschlossen, weitere sollten folgen. Da dies nur begrenzt erfolgreich sein kann, solange bei Berufungsverfahren und LOM noch die Publikationszahl zentraler Maßstab ist, wäre auch über diese nachzudenken. Zudem wird die Aufwertung/ finanzielle Förderung von Replikationsstudien empfohlen (Borgwardt 2014, S. 64), wie es durch die eingangs erwähnte Open Science Center erfolgen soll. Der gestiegene Publikationsdruck trägt auch zur Gutachterüberlastung bei, für die Lösungen gefunden werden müssen. Als Alternativen für klassische Begutachtungen werden z.B. Post-Publication-Reviews und Open-Review-Verfahren diskutiert, aber auch die Gutachten vergebenden Instanzen gemahnt, den Umfang zu bedenken (vgl. Wissenschaftsrat 2015: 32f.). Darüber hinaus wird auch hier die LOM angesprochen, die v.a. quantitative Indikatoren berücksichtigt und teils ungewollte Effekte erziele, welche erfasst und vermieden werden sollten.

Für eine langfristige, nachhaltige Veränderung der Praxis hin zu einer wissenschaftlichen Kultur, „in der die Bewertung von Forschungsleistungen von Qualitätskriterien abhängt (etwa Originalität, Kohärenz, Erkenntnisfortschritt, Belastbarkeit)“ (Wissenschaftsrat 2015: 37) wären aber nicht nur Veränderungen der Kriterien bei der Drittmittelakquise, bei der LOM, bei Beschäftigungsbedingungen und Begutachtungsverfahren nötig. Vielmehr gilt dies auch bei der Transparenz der Kriterien für Berufungen (vgl. Wissenschaftsrat 2015: 41) bzw. insgesamt für transparente Karrierewege in der Wissenschaft (vgl. Borgwardt 2014, Krempkow u.a. 2016) und eine weitere Stärkung der Bestenauswahl (Krempkow 2017b). Mit der weiteren Ausgestaltung und v.a. Umsetzung von Personalentwicklungskonzepten in Wissenschaftseinrichtungen besteht die Möglichkeit, durch die Forderung transparenter Kriterien auch hier Qualität stärker Geltung zu verleihen.

Literatur

Böhmer, Susan/ Neufeld, Jörg/ Hinze, Sybille/ Klode, Christian/ Hornbostel, Stefan, 2011: Wissenschaftler-Befragung 2010: Forschungsbedingungen von Professorinnen und Professoren an deutschen Universitäten. iFQ-Working Paper 8. Bonn.

Borgwardt, Angela, 2014: Wissenschaft auf Abwegen? – Zum drohenden Qualitätsverlust in der Wissenschaft. Schriftenreihe des Netzwerk Exzellenz an deutschen Hochschulen. Berlin.

Bös, Nadine, 2015: Erschlichene Stellen, erkaufte Titel. Frankfurter Allgemeine Zeitung, 9.12.2015.

BuWiN, 2017: Konsortium Bundesbericht Wissenschaftlicher Nachwuchs. Statistische Daten und Forschungsbefunde zu Promovierenden und Promovierten in Deutschland. Bielefeld: Bertelsmann.

Dannemann, Gerhard/Weber-Wulff, Debora, 2015: Viel Licht und noch mehr Schatten. Wie Universitäten auf Plagiatsdokumentationen reagieren. In: Forschung & Lehre 22 (4), S. 278-280.

DFG 1998: Vorschläge zur Sicherung guter wissenschaftlicher Praxis: Empfehlungen der Kommission „Selbstkontrolle in der Wissenschaft“, Weinheim: Wiley-VCH.

DFG 2010: „Qualität statt Quantität“ – DFG setzt Regeln gegen Publikationsflut in der Wissenschaft, Pressemitteilung Nr. 7, 23. Februar 2010.

DFG 2016: Verfahrensleitfaden zur guten wissenschaftlichen Praxis, Bonn: DFG.

Fanelli, Daniele, 2009: How Many Scientists Fabricate and Falsify Research? A Systematic Review and Meta-Analysis of Survey Data. PLoS ONE 4(5): e5738. doi:10.1371/journal.pone.0005738.

Grande, Edgar, Dorothea Jansen, Otfried Jarren, Arie Rip, Uwe Schimank, Peter Weingart (Hrsg.), 2013: Neue Governance der Wissenschaft: Reorganisation, Externe Anforderungen, Medialisierung. Bielefeld: Transkript.

Hornbostel, Stefan/ Patzwaldt, Katja, 2015: Simulierter Markt, Gutachter für den Wettbewerb. Forschung und Lehre, August 2015, o.S.

Kramer, Bernd, 2016: Übermächtige Promotionsbetreuer: Doktorvater unser. Spiegel-Online vom 7. Februar 2016.

Krempkow, René, 2017a: Hochschulautonomie, Forschungs- und Innovationsperformanz im deutschen Hochschulsystem. In: Hochschulmanagement (HM) 2+3/2017, S.51-58.

Krempkow, René, 2017b: Können wir die Besten für die Wissenschaft gewinnen? Zur Rekrutierung von Nachwuchsforschenden in Wissenschaft und Wirtschaft. In: Personal- und Organisationsentwicklung (P-OE) 2+3/2017, S. 59-64.

Krempkow, René, 2016: Wissenschaftliche Integrität, Drittmittel und Qualität in der Wissenschaft: Empirische Befunde. In: Qualität in der Wissenschaft (QiW) 2/2016, S.46-52.

Krempkow, René/ Sembritzki, Thorben/ Schürmann, Ramona/ Winde, Mathias, 2016: Personalentwicklung für den wissenschaftlichen Nachwuchs 2016. Bedarf, Angebote und Perspektiven – eine empirische Bestandsaufnahme im Zeitvergleich. Berlin: Stifterverband für die Deutsche Wissenschaft (Hg.).

Krempkow, Rene/ Landrock, Uta, 2014: Welche Effekte hat die LOM? Das Beispiel der deutschen Universitätsmedizin. In: Krempkow, Rene/ Möller, Torger/ Lottmann, Andre (Hrsg.): Völlig losgelöst? Governance der Wissenschaft. iFQ-Working Paper 15. Berlin: IFQ Berlin. S. 69-97.

Krempkow, Rene/ Landrock, Uta/ Neufeld, Jörg/ Schulz, Patricia, 2013: Intendierte und nicht-intendierte Effekte dezentraler Anreizsysteme am Beispiel der fakultätsinternen leistungsorientierten Mittelvergabe in der Medizin. Berlin: IFQ Berlin.

Münch, Richard, 2011: Akademischer Kapitalismus – Über die politische Ökonomie der Hochschulreform. Berlin: Suhrkamp.

Neufeld, Jörg, 2014: Wissenschaftliches Fehlverhalten – Selbstauskünfte des wissenschaftlichen Personals in Österreich und Deutschland. OeAWI 2014.

Statistisches Bundesamt (Hg.), 2018: Fachserie 11 Reihe 4.5, Finanzen der Hochschulen 2016, Wiesbaden.

Welpe, Isabell/ Jutta Wollersheim, Stefanie Ringelhan, Margit Osterloh (Eds), 2015: Incentives and Performance: Governance of Knowledge-Intensive Organizations. Munich: Springer.

Winterfeldt, Ekkehard, 1999: Die Abhängigkeit von Drittmitteln als auslösender Faktor für Fehlverhalten? In: Ethos der Forschung: Ringberg-Symposium. München: Max-Planck-Gesellschaft.

Wissenschaftsrat, 2015: Empfehlungen zu wissenschaftlicher Integrität, Positionspapier, Drs.4609-15.

Wissenschaftsrat, 2011: Empfehlungen zur Bewertung und Steuerung von Forschungsleistungen, Drs.1656-11.

_________________________________________________

Fußnoten:

[1] Dieser Beitrag ist die gekürzte und aktualisierte Fassung eines früheren wissenschaftlichen Artikels (Krempkow 2016).

[2] Auch wenn es international keine allgemein gültige Definition von Fehlverhalten gibt, so besteht Einigkeit darüber, was als grobes Fehlverhalten zu werten ist (vgl. auch Fräßdorf/Tesch 2016).

[3] Während sich die von der Gesetzgebung in den Bundesländern gewährte Autonomie von 2005 zu 2010 deutlich erhöhte, stagnierte sie insgesamt gesehen in Deutschland im Zeitraum 2010 bis 2015, allerdings bei deutlichen Forderungen der Hochschulen nach einer weiteren Autonomiesteigerung (vgl. Krempkow 2017a).

[4] Für den wissenschaftlichen Nachwuchs, dem die wissenschaftlichen Mitarbeiter/innen größtenteils zugerechnet werden (vgl. BuWiN 2017), gilt dies in besonderem Maße – erst recht bei steigender Anzahl von Doktoranden und Promovierten und i.W. stagnierender Professurenzahl. Der Wissenschaftsrat (2015) zählt daher auch seine Empfehlungen zur Neugestaltung wissenschaftlicher Karrierewege zu den Rahmenbedingungen wissenschaftlicher Integrität (ausführlicher zu Stand und Entwicklungen von Karrierewegen und Personalentwicklung für den wissenschaftlichen Nachwuchs in Deutschland vgl. Krempkow u.a. 2016).

[5] Zwischenzeitlich wurde eine ähnliche Studie für Österreich durchgeführt, die auch wissenschaftliches Fehlverhalten adressierte und zu ähnlichen Ergebnissen kam wie die erste iFQ-Wissenschaftlerbefragung (vgl. Neufeld 2014, S. 7). Zudem gab es eine erneute Wissenschaftlerbefragung für Deutschland durch das DZHW (mit dem das iFQ fusionierte), wozu aber bislang keine Auswertung bzgl. wissenschaftlichem Fehlverhalten bekannt wurde.

[6] Insgesamt waren hier die Angaben von 3131 befragten Professor/inn/en auswertbar, die Rücklaufquote betrug 32%. Die Überprüfung der Fächerzusammensetzung zeigt eine leichte Überrepräsentanz der Naturwissenschaften und leichte Unterrepräsentanz der Geistes-, Sozial- und Verhaltenswissenschaften. (vgl. Böhmer u.a. 2011, S. 24f.). Weitere Überprüfungen von Stichprobenmerkmalen wie Geschlechter- und Altersverteilung zeigten einen nur um 1 Prozentpunkt höheren Frauenanteil als in der Grundgesamtheit und ein um 1 Jahr höheres Durchschnittsalter (ebd., S. 32).

[7] Ziel des Projektes war die Untersuchung der Effekte wissenschaftspolitischer Steuerungs- und Regelungssysteme am Beispiel der deutschen Hochschulmedizin und dabei insbesondere der leistungsorientierten Mittelvergabe (LOM) und den in ihr verwendeten Indikatoren.

[8] In einschlägigen Literaturdatenbanken zur Hochschul- und Wissenschaftsforschung in Deutschland fand sich dazu für die letzte Dekade lediglich noch wissenschaftsrechtliche Literatur, die sich z.B. mit der Rechtsprechung des Bundesverwaltungsgerichts befasst, oder z.B. rechtsvergleichende Untersuchungen verschiedener Länder.

[9] In einer Studie zur akademischen Korruption in Europa befand sich Deutschland im Mittelfeld (vgl.Bös 2015).

[10] Die Erhebung von Fehlverhalten mittels Befragungen wirft methodische Fragen auf, die auch in der Kriminologie bzw. Dunkelfeldforschung diskutiert werden: In der iFQ-Wissenschaftlerbefragung wurden die Professor/inn/en gebeten, für die einzelnen Aspekte anzugeben, ob sie das entsprechende Verhalten bei Kolleg(inn)en beobachtet hätten und ob sie selbst bereits entsprechend gehandelt hätten. Die wichtigste Unwägbarkeit hierbei ist, wie fehlende Angaben zu interpretieren sind. Wurde für die abgefragten Varianten von Fehlverhalten weder fremdes noch eigenes Fehlverhalten von den Befragten markiert, so wurde dies bei Böhmer u.a. (2011) so interpretiert, als läge kein Fehlverhalten vor. Dies dürfte – wie auch die Autoren selbst einräumen – aber zu einer deutlichen Unterschätzung des Problems führen, da davon ausgegangen werden kann, dass ein erheblicher Teil der Befragten nicht willens war, zu diesen Fragen Stellung zu nehmen (vgl. ebd.). Für die nachfolgend dargestellten Ergebnisse ist also zu beachten, dass sie wahrscheinlich sogar eine Untererfassung des tatsächlichen Fehlverhaltens darstellen. Böhmer u.a. (2011, S. 151) weisen darauf hin, dass für einige Items nur geringe Fallzahlen vorliegen. Um Analysen nach Fächergruppen zu ermöglichen, wurden thematisch zusammengehörige Items zu Gruppenvariablen zusammengefasst, sofern sich ein deutlicher Zusammenhang mittels Korrelationsanalyse nachweisen ließ. Für die Zuordnung der Items sowie den Wortlaut der Fragen vgl. Böhmer (2011: 150/151).

[11] In der iFQ-Studie wurde hier eigenes und beobachtetes fremdes Fehlverhalten zu einem Wert zusammengefasst.

[12] So hat in den Lebenswissenschaften und insbes. in der Medizin neben der Erstautorschaft z.T. auch die Letztautorschaft eine besondere Bedeutung und für beides gibt es z.B. in Modellen der Leistungsorientierten Mittelverteilung Regeln zur besonderen Honorierung (ausführlicher vgl. Krempkow u.a. 2013). Dagegen spielt die Letztautorschaft in den Geisteswissenschaften im Allgemeinen keine besondere Rolle und ist kaum geregelt; sie kann daher auch kaum Anlass für wahrgenommenes Fehlverhalten sein.

[13] Zu intendierten und nichtintendierten Effekten leistungsorientierter Mittelzuweisungen in der Medizin vgl. zusammenfassend Krempkow/ Landrock (2014).

[14] Vgl. hierzu auch z.B. die Beiträge in der Zeitschrift „Forschung und Lehre“ von Zäh (Juni 2015), Vogt (Februar 2014) sowie unter dem Titel „Drittmittel und Erpressung“ von Anonym (Juli 2013).

[15] In früheren Veröffentlichungen wurde die Reputationsverteilung innerhalb der Wissenschaft über Drittmittel als eine Form intentionaler Koordination beschrieben, die sich wettbewerbliche Mechanismen zu Nutze macht (vgl. Wissenschaftsrat 2011, für die Medizin vgl. Krempkow u.a. 2013: 24).

[16] Hierfür möchte ich Jörg Neufeld danken.

[17] Der Wissenschaftsrat empfiehlt generell eine stärkere Einbeziehung weiterer Kriterien in der Leistungsbewertung der Forschung, so z.B. auch Tätigkeiten als Herausgeber und Gutachter.

Ich habe aus persönlicher Erfahrung als naturwissenschaftlich interessierte Bürgerin über zwei Fälle von wissenschaftlichem Fehlverhalten gegenüber der Öffentlichkeit aus der jüngsten Vergangenheit zu berichten, und zwar beide Fälle wegen zwei Experimenten in Millionen- bzw. Milliardenhöhe aus der Steuerkasse in der theoretischen Physik:

1. CERN-Neutrinoexperiment OPERA zur experimentellen Nachprüfung der Speziellen Relativitätstheorie:

Ich habe bereit 2012 versucht, im Rahmen des Informationsfreiheitsgesetzes von der Bundesbehörde PTB (Physikalisch-Technische Bundesanstalt) die Information zu erhalten, welche Synchronisationsmethode der Uhren bei diesem Experiment verwendet wurde: Entweder unter der Voraussetzung einer absoluten konstanten Lichtgeschwindigkeit c=const nach dem Postulat Albert Einsteins, oder aber im Gegenteil unter der Voraussetzung einer variablen Lichtgeschwindigkeit c +/- v nach den experimentellen Erkenntnissen von Georges Sagnac. Die PTB, die für dieses Experiment beauftragt wurde die Uhren zu synchronisieren, teilte mir mit, dass sie diese Frage nicht beantworten könne, sie wisse es selbst nicht, sie habe ja lediglich eine Software des französischen Metrologie-Instituts verwendet und habe nicht den Code für diese Software. Ich solle mich bitte an das französische Metrologie-Institut wenden. Es darf nicht hingenommen werden und es ist auch absolut unglaubwürdig und gegenüber der Öffentlichkeit unzumutbar, dass die PTB behauptet, sie wisse selbst nicht, wie sie die Uhren bei diesem Millionenexperiment synchronisiert hat…

2016 habe ich mit einer erneuten Anfrage nach Informationsfreiheitsgesetz einen zweiten Versuch gestartet, um die Beantwortung dieser Frage zu erhalten. Diesmal hat die PTB geantwortet, sie lehne die Beantwortung der Frage ab, weil sie keine amtliche Information sei und dementsprechend vom Informationsfreiheitsgesetz ausgeschlossen wird. Daraufhin habe ich einen Rechtsanwalt beauftragt, ein Klageverfahren nach Informationsfreiheitsgesetz einzuleiten. Auf dem Widerspruchsbrief meines Rechtsanwalts reagierte die Behörde PTB doch vorsichtig und einsichtig, um eine Klage zu vermeiden: Sie hat mein Recht auf Beantwortung der Frage im Rahmen des Informationsfreiheitsgesetzes uneingeschränkt anerkannt und die Frage beantwortet: Die Uhren wurden unter Zugrundelegung einer variablen Lichtgeschwindigkeit c +/- v synchronisiert. Meine Rechtsanwaltskosten hat die PTB freiwillig sofort erstattet.

Ich halte es für ein wissenschaftliches Fehlverhalten, dass Bürger und Steuerzahler einen Rechtsanwalt einschalten müssen, um eine entscheidende Information zur Interpretation eines millionenschweren Experiments der öffentlichen Forschung zu erhalten. Über diesen Fall habe ich ausführlicher unter diesem Link berichtet.

.

2. LIGO-Experiment zur experimentellen Nachprüfung der Allgemeinen Relativitätstheorie mit der Messung von Gravitationswellen:

Auch in diesem Fall habe ich 3 einfachen und ganz konkreten Fragen an das Albert Einstein Institut / Max Planck Gesellschaft im Rahmen des Informationsfreiheitgesetzes gestellt, und zwar über die Meßdaten, die bei der Kalibration der LIGO-Meßanlage gesammelt wurden und in der offiziellen Publikation „Discovery Paper“ unter der Referenz [63] beschrieben wurde. Diese Daten wurden nicht veröffentlicht. Das Albert Einstein Institut verweigert seit 2 Jahren jegliche Informationen darüber, trotz einer online-Petition, die inzwischen von 1088 Unterzeichnern unterstützt wird.

Ich halte es ebenfalls für ein gravierendes wissenschaftliches Fehlverhalten, wenn eine öffentliche Forschungseinrichtung maßgebliche Meßdaten über ein milliardenschweres Experiment der Öffentlichkeit vorenthält.

1. es gibt keine variable Lichtgeschwindigkeit, Sagnac-Effekt tritt bei c=const auf, der

Laufzeiteffekt nach Sagnac ist selbstverständlich zu berücksichtigen: Anfrage=Laien-Unsinn.

Solche Kommentare passieren natürlich, wenn man die Antworten nicht verstanden hat.

2. Die Datenhoheit von LIGO liegt bei der LIGO-Kollaberation, nicht beim AEI, das IFG

greift nicht, zumal alle Unterlagen von LIGO frei verfügbar sind, auch wenn Sie immer

wieder das Gegenteil zu jedem neuen Aufhänger lügen – Propagandamasche, von der

alle wissen, daß Sie von den Themen, die Sie belügen, keine Ahnung haben.

Hallo Herr Senf,

Danke für den Kommentar! Wie bereits erwähnt – das im Kommentar von Jocelyne Dargestellte zu prüfen kann ich nicht leisten, daher halte ich mich hierzu inhaltlich zürück.

Und ein freundlicher Ton ist immer schöner für alle Beteiligten…

Beste Grüße

René Krempkow

Hallo Jocelyne Lopez,

Danke für den Kommentar! Wenn die Darstellung zutreffen sollte (was zu prüfen ich nicht leisten kann) könnte dies in der Tat unter wissenschaftliches Fehlverhalten fallen, z.B. unter den Aspekt

‚Zurückhalten von Daten/Befunden’ oder anderenfalls, falls es tatsächlich nicht dokumentiert sein sollte, unter ‚unzureichendes Dokumentieren des Projektverlauf bzw. Archivieren der Daten’. Diese Aspekte wurden in den meinem Blogbeitrag zugrunde liegenden Studien auch separat erfragt. Ich werde dies in meinem derzeit in Vorbereitung befindlichem Blogbeitrag zu noch differenzierteren Auswertungen am Beispiel der deutschen Hochschulmedizin dann zu einem späteren Zeitpunkt auch noch genauer für diese einzelnen Aspekte vorstellen. (Wobei hierbei auch immer die Mediziner selbst eigenes und beobachtetes fremdes Fehlverhalten angeben, also vor dem Hintergrund der Regeln ihrer eigenen Community.)

Grundsätzlich möchte ich aber auch darauf hinweisen, dass die Tatsache allein, dass bestimmte Daten bislang nicht veröffentlicht wurden, nicht zwingend wissenschaftliches Fehlverhalten begründen. Denn es kann manchmal auch vorkommen, dass ein Veröffentlichen ohne gründliche Prüfung und idealerweise unabhängige Bestätigung sich als vorschnell erweist (auch über solche Beispiele wurde ja bereits vielerorts berichtet).

Beste Grüße

René Krempkow

Hallo Herr Krempkow,

Sie schreiben über den Fall LIGO-Experiment: „Wenn die Darstellung zutreffen sollte (was zu prüfen ich nicht leisten kann) könnte dies in der Tat unter wissenschaftliches Fehlverhalten fallen, z.B. unter den Aspekt ‚Zurückhalten von Daten/Befunden’ oder anderenfalls, falls es tatsächlich nicht dokumentiert sein sollte, unter ‚unzureichendes Dokumentieren des Projektverlauf bzw. Archivieren der Daten’.“

Dieser Aspekt trifft auf jeden Fall für das Zurückhalten der Daten/Befunden zu, die bei der Durchführung des Kalibrationsverfahrens Referenz [63] aus der offiziellen Publikation „Discovery Paper PRL 116, 061102 (2016)” des LIGO-Experiments gesammelt wurden. Dieses Kalibrationsverfahren Referenz [63] und seine entsprechend gesammelten Daten sind nämlich von grundlegender Bedeutung, um zu testen bzw. zu dokumentieren, dass die LIGO-Meßanlage in der Lage war, den Druck einer Gravitationswelle während 0.2 Sekunde zu registrieren, wie es am 14. September 2015 registriert wurde (sogar noch während der Testphase der Anlage). Ohne Durchführung dieses Kalibrationsverfahrens und die Auswertung der entsprechenden gesammelten Daten können weder die Experimentatoren selbst noch die Fachleute aus der Öffentlichkeit wissen bzw. den Nachweis bringen, dass die LIGO Meßanlage zu diesem Zeitpunkt überhaupt in der Lage war, einen so extrem winzigen Druck während 0.2 Sekunde zu registrieren. Die zurückgehaltene Daten/Befunden aus diesem äußerst wichtigen Kalibrationsverfahren fällt auf jeden Fall unter „unzureichendes Dokumentieren des Projektverlaufs“.

Sie schreiben weiter: „Grundsätzlich möchte ich aber auch darauf hinweisen, dass die Tatsache allein, dass bestimmte Daten bislang nicht veröffentlicht wurden, nicht zwingend wissenschaftliches Fehlverhalten begründen. Denn es kann manchmal auch vorkommen, dass ein Veröffentlichen ohne gründliche Prüfung und idealerweise unabhängige Bestätigung sich als vorschnell erweist (auch über solche Beispiele wurde ja bereits vielerorts berichtet).“

Die Begründung, dass die Daten aus diesem Kalibrationsverfahren Referenz [63] zurückgehalten wurden, um die Gefahr eine vorschnelle Veröffentlichung zu vermeiden kann hier nicht zutreffen. Ein Kalibrationsverfahren wird immer vor den echten Messungen durchgeführt, das ist eine Eichung der Meßanlage, die gesammelten Daten aus dem Kalibrationsverfahren Referenz [63] mussten also zwingend vor der Veröffentlichung der Meßergebnisse selbst vorliegen, also vor dem 14. September 2015, am Tag wo die erste Gravitationswelle mit der LIGO-Anlage registriert wurde.

Das Kalibrationsverfahren wurde vor 2015 mehrfach durchgeführt und veröffentlicht,

z.B. 2010 (!) https://arxiv.org/abs/1007.3973 LIGO wurde “laufend modernisiert”

Was für ein interessanter und origineller Artikel. Wie gut, dass wir Sie hier bei den SciLogs haben, Herr Krempkow!

Hallo Herr Krempkow,

aufgrund der zwei von mir dargestellten Fälle von wissenschaftlichem Fehlverhalten in der theoretischen Physik zeichnet sich aus, dass es von der Seite der Öffentlichkeit bei der Feststellung eines Fehlverhaltens kaum eine Möglichkeit gibt, eine Lösung herbeizuführen.

Im Fall des Zurückhaltens von grundlegenden Daten/Befunden bei dem LIGO-Experiment ist die Situation für die Öffentlichkeit blockiert: Das öffentliche Forschungsinstitut Albert Einstein Institut / Max Planck Institut für Gravitationsphysik weigert sich, die 3 Fragen nach den erhobenen Daten bei der Durchführung des Kalibrationsverfahrens gemäß Referenz [63] der offiziellen LIGO-Publikation „Discovery Paper“ zu beantworten, trotz Bürgeranfrage nach Informationsfreiheitsgesetz.

Auf einem Brief von unserem Rechtsanwalt teilte die Max Planck Gesellschaft mit, dass sie diese 3 Fragen nicht beantworten muss, weil sie als Verein dem Informationsfreiheitsgesetz nicht unterliegen würde. Dieser fragwürdigen Haltung bedient sich allerdings auch die DFG, wie zum Beispiel die zwei Universitätsprofessoren Roland Reuß und Volker Rieble in ihrer kritischen Studie aus dem Jahre 2011 in der FAZ über die Strukturen der öffentlichen Forschung darüber berichten:

Kritik an der DFG : Die freie Wissenschaft ist bedroht – Fördert die mächtige Deutsche Forschungsgemeinschaft (DFG) den Ideenklau und die Selbstbedienung? Transparenz ist für sie ein Fremdwort. Dieses Monopol ist bedenklich.

Zitat: […]„Denn die DFG hat Macht – eine Macht, die nur scheinbar demokratisch von innen gebändigt wird und die sich auch keiner Kontrolle von außen unterwirft oder sich einer Diskussion mit der Öffentlichkeit oder gar dem Steuerbürger stellt, der das alles bezahlt. Immerhin kann die Öffentlichkeit über die sogenannte Gepris-Datenbank erfahren, welche Projekte gefördert worden sind. Das Informationsfreiheitsgesetz hingegen soll nicht anwendbar sein, weil die DFG ja nur ein Verein ist.“

Zwar ist diese Rechtsauffassung der DFG und der Max Planck Gesellschaft anfechtbar, weil das Informationsfreiheitsgesetz sehr wohl juristische Personen wie Vereine einschließt:

Zitat Informationsfreiheitsgesetz des Bundes:

Grundsatz (1) “Jeder hat nach Maßgabe dieses Gesetzes gegenüber den Behörden des Bundes einen Anspruch auf Zugang zu amtlichen Informationen. Für sonstige Bundesorgane und -einrichtungen gilt dieses Gesetz, soweit sie öffentlich-rechtliche Verwaltungsaufgaben wahrnehmen. Einer Behörde im Sinne dieser Vorschrift steht eine natürliche Person oder juristische Person des Privatrechts gleich, soweit eine Behörde sich dieser Person zur Erfüllung ihrer öffentlich-rechtlichen Aufgaben bedient.”

Dies würde jedoch für private Bürger bedeuten, einen aufwändigen und teuren Rechtskampf zu führen, u.U. über mehrere Instanzen, um zu Informationen zu gelangen, die ihnen ohnehin per Gesetz zustehen und die sie ohnehin schon mit ihrem Steuergeld bezahlt haben.

Herr Krempkow, was sehen Sie sonst als Möglichkeit für die Öffentlichkeit, zu den zurückgehaltenen Daten des Kalibrationsverfahren Referenz [63] des LIGO-Experiments zu gelangen?

Hallo Frau Lopez,

zunächst müsste einmal geklärt sein, inwieweit tatsächlich in der jeweiligen Situation Fehlverhalten vorliegt; Sie scheinen mir da etwas sehr von vornherein davon auszugehen (statt der m.E. zunächst jeweils anzunehmenden Unschuldsvermutung). Für diese Klärung gibt es auch die Ombudspersonen (z.B. bei der MPG siehe https://www.mpg.de/ueber-uns/vereinsorgane/ombudswesen). Die Ombudspersonen haben sich übrigens bundesweit u.a. zu der Frage, was man noch tun könne, vor einigen Wochen zu einem Symposium in Berlin getroffen, da gibt es auch einige Anregungen zur Durchsetzung guter wissenschaftlicher Praxis (http://www.ombudsman-fuer-die-wissenschaft.de/symposien/).

Wenn Sie dies für nicht ausreichend halten, dann bleibt Ihnen in einem Staat wie Deutschland immer noch der Rechtsweg (da gibt es bekanntlich auch andere Staaten), den Sie dann ggf. auch nutzen sollten.

Beste Grüße

René Krempkow

Hallo Herr Krempkow,

die bloße Stellung von 3 Fragen bzgl. der Erhebung von grundlegenden Daten bei der Durchführung des Kalibrationsverfahrens Referenz [63], das 2016 in der offiziellen LIGO-Publikation „Discovery Paper“ beschrieben wurde, beinhaltet per se eine Unschuldsvermutung: Es geht nur darum zu erfahren von welchen Autoren, wo und wann dieses Verfahren zuletzt konkret durchgeführt wurde und wo seine Ergebnisse veröffentlicht sind. Die Fragen sind ja neutral. Wie sonst könnte man in einem konkreten Fall ohne zu fragen die Aspekte „Zurückhalten von Daten/Befunden“ oder „unzureichendes Dokumentieren des Projektverlaufs“ ansprechen, die Sie als wissenschaftliches Fehlverhalten genannt haben? Ohne zu fragen geht es gar nicht.

Ich danke für Ihren Link zu dem Ombudswesen an den Max-Planck-Instituten, jedoch glaube ich nicht, dass diese Einrichtung geeignet ist, diesen Fall zu prüfen. So wie ich es verstanden habe handelt es sich um eine Einrichtung zur Lösung von hausinternen Konflikten der Max Planck Gesellschaft, hauptsächlich Autorenschaftskonflikten, wobei „die wissenschaftliche Qualität der jeweiligen Veröffentlichung dabei so gut wie nie zur Debatte steht“. Es ist auch rein psychologisch utopisch anzunehmen, dass Mitarbeiter der Max Planck Gesellschaft die wissenschaftliche Qualität der Veröffentlichungen der obersten Hierarchie in Frage stellen würden: Co-Autoren der offiziellen LIGO-Publikation “Discovery Paper” (sowie übrigens ursprünglich auch des Kalibrationspapers Referenz [63]) sind ja Direktoren am Albert Einstein Institut / Max Planck Institut für Gravitationsphysik…

.

Der “Tagesspiegel” berichtete kürzlich von einer Umfrage an der TU Berlin. Darin heißt es: “Erstaunen lösten Zahlen zum Umgang mit der Autorenschaft von wissenschaftlichen Arbeiten aus. Zwanzig Prozent der Befragten gaben an, schon einmal an Aufsätzen mitgearbeitet zu haben, ohne dann auch als Co-Autor aufgeführt zu werden. Sogar 30 Prozent sagten, ihr Professor sei als Co-Autor bei einem Papier aufgetreten, dass sie erstellt hätten, ohne dass der Professor daran mitgeschrieben habe. Das sei „alarmierend“, sagte das Kuratoriumsmitglied Matthias Kleiner, Präsident der Leibniz-Gemeinschaft: Die Praxis widerspreche der Integrität von Wissenschaft.”

Mich erstaunen die Ergebnisse der TU Berlin nicht. In der Tendenz deckt es sich mit den in obigem Blogbeitrag genannten bundesweiten Ergebnissen. Demnach betrifft das häufigste erfasste Fehlverhalten Autorschaftsfragen (mit 53% Fehlverhalten).

In der Medizin wurde die “Vergabe von (Ko-)Autorschaften ohne substanziellen Beitrag” sogar von nahezu zwei Dritteln der wissenschaftlichen Mitarbeiter/innen angegeben; gefolgt von einem Drittel bei der “Nicht-Aufnahme von Wissenschaftler/innen mit substanziellem Beitrag als Koautoren” (Krempkow 2016, mein Blogbeitrag speziell zur Medizin findet sich hier).

Teilweise ist das Fehlverhalten den bislang verfügbaren Ergebnissen zufolge an der TU Berlin offenbar sogar weniger verbreitet als anderswo.