KI übersetzt Hirnsignale in Sprache

Ann Johnson, eine 48 Jahre alte Kanadierin, hat das Gefühl, „wieder ein ganzer Mensch zu sein“, nachdem ein Schlaganfall an ihrem Hirnstamm sie 18 Jahre zuvor gelähmt zurückgelassen hat und ihr unter anderem die Möglichkeit zu sprechen nahm. Dank einer Gehirn-OP, künstlicher Intelligenz und eines Avatars kann sie jetzt wieder sprechen.

Das Schicksal vieler

Ann Johnson verbrachte ein Jahr im Krankenhaus und einer neurologischen Rehabilitationseinrichtung. Es dauert fünf Jahre, bis sie eigenständig lächeln konnte. Sie kommunizierte über ein Brett oder einen Bildschirm mit Buchstaben, die sie mit ihren Augen anfixierte.

2021 berichtete ein neurowissenschaftliches Team, dass es ihnen gelungen sei, einen durch einen Schlaganfall gelähmten Patienten das Aussprechen einzelner Wörter über die Dekodierung seiner Gehirnsignale zu ermöglichen. Mit der Unterstützung ihres Ehemanns kontaktierte Ann Johnson das Team mit dem Wunsch, selbst Teil der Entwicklung neuer Methoden, Menschen wie ihr das Sprechen zu ermöglichen, zu sein.

Was ist Sprache?

Sprache ist die Fähigkeit, unsere Gedanken, Ideen und Ansichten durch gesprochene Worte auszudrücken. Der Verlust dieser Fähigkeit hat weitreichende Konsequenzen, da uns parallel die Fähigkeit, mit anderen zu Kommunizieren abhanden geht. Der Mensch ist ein grundlegend soziales Wesen und ohne Kommunikation kommt es schnell zu Gefühlen der Einsamkeit und sozialer Isolation, unter denen unser psychisches Wohlbefinden leidet. Das Ziel, Sprechen für Menschen zu ermöglichen, die diese Fähigkeit zuvor verloren haben, ist eine der zentralen Missionen der Wissenschaftlerinnen und Wissenschaftler, die an Schnittstellen von Computer und Gehirn forschen.

Wie funktioniert das Sprechen?

Sprechen ist die komplexeste Art zu kommunizieren, die wir kennen. Das würden wir nie merken, denn wenn wir etwas sagen wollen, so sprechen wir es einfach aus, in etwa 16.000 Wörter pro Tag. Für unser Gehirn steckt mehr dahinter. Es steuert in etwa 100 Muskeln, die uns durch genaue Koordination dazu befähigen, zu sprechen. Wir brauchen unter anderem unsere Lunge, unsere Lippen, unsere Zunge, unseren Kehlkopf oder unseren Gaumen. Dies ist der Teil, der bei Ann Johnson nicht funktioniert. Durch ihr Locked-in-Syndrom sind unter anderem fast alle ihre Gesichtsmuskeln gelähmt und das Sprechen scheitert an dem motorischen Aufwand der Artikulation. Doch bevor unser Mund Laute produzieren kann, leistet unser Gehirn viel mehr Vorarbeit.

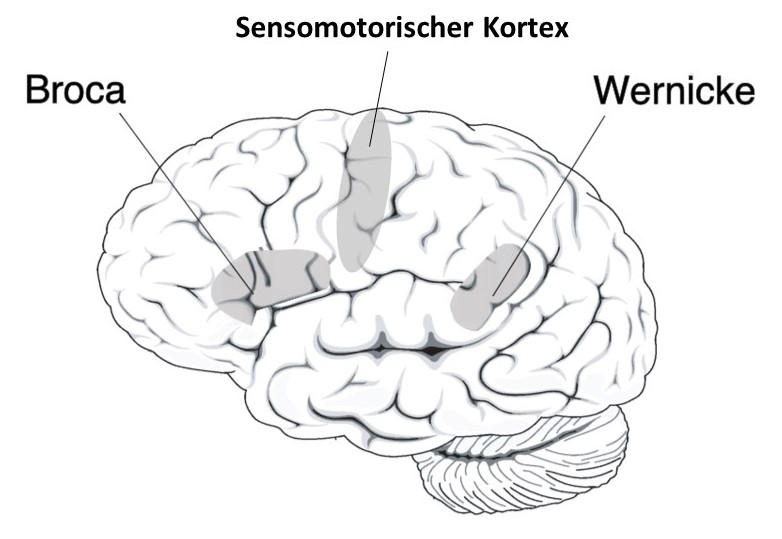

Schon lange sind uns zwei wichtige Sprachareale bekannt: Das Broca-Areal, welches für die Sprachproduktion zuständig ist, und das Wernicke-Areal, welches für das Verstehen und den Sinninhalt der Sprache zuständig ist. Beide Areale sind über Leitungen verbunden, die unter Anderem die Analyse der gehörten Wörter oder das Nachsprechen von Sätzen ermöglichen. Die Nervenzellen dieser Areale senden ihre Impulse an den sensomotorischen Kortex, der die notwendige Sprechmuskulatur aktiviert, so dass Laute geformt werden und Wörter entstehen. Das ist jedoch ein stark vereinfachtes Modell von den Vorgängen, die beim Sprechen eine Rolle spielen. In Wirklichkeit ist eine Vielzahl an anderen Hirnregionen beteiligt. Verschiedene Regionen steuern die Aufmerksamkeit, planen Inhalte, entschlüsseln Satzbau, Grammatik und Bedeutung, und Faserbündel verbinden diese Systeme mit dem auditiven System (zum Hören), dem exekutiven System (z.B. zum Planen und Reflektieren) und weiteren Systemen, die wir zum Lesen und Schreiben brauchen.

Wie Ann ihre Sprache zurückerlangte

Die Forschenden konnten Ann Johnson das Sprechen ermöglichen, da der Teil, der der verbalen Aussprache der Wörter vorgeschaltet ist, keinen Schaden durch den Schlaganfall genommen hatte. In ihrem Kopf kann sie Wörter stumm formulieren, nur der Außenwelt kann sie diese nicht mitteilen.

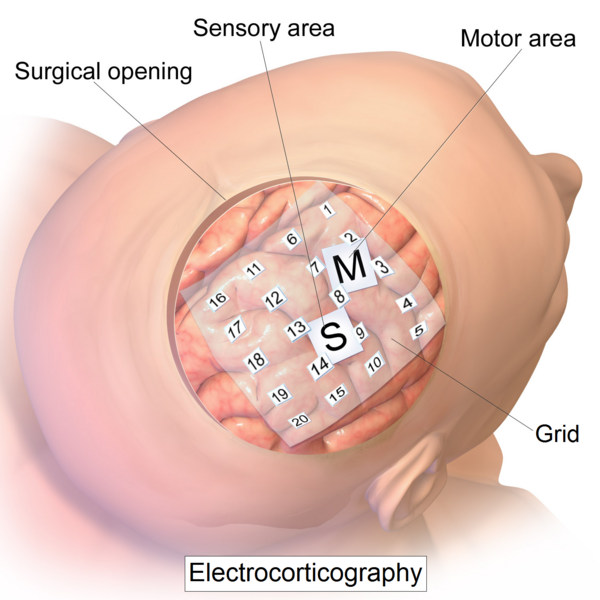

Das chirurgische Team öffnete ihre Schädeldecke und setzte ihr eine dünne Folie auf den sensomotorischen Kortex. Diese Folie ist mit mehreren hunderten von Sensoren ausgestattet, die die Aktivität der Nervenzellen an der Oberfläche der motorischen Sprachrinde lesen können. Sie zeichnen die elektronischen Impulse auf, durch die Nervenzellen mit ihrer Umgebung kommunizieren. Mit Kabeln, die an einen Anschluss außerhalb der Schädeldecke angedockt werden können, wird sie mit einem Computer verbunden. Die Forschenden hatten sogenannte deep-learning models programmiert, Algorithmen die lernen können, anhand der Strukturen neuronaler Netze Daten zu entnehmen und deren Merkmale zu interpretieren. Zwei Wochen lang wurde diese künstliche Intelligenz (KI), die nun mit dem Gehirn von Ann Johnson verbunden wurde, trainiert. Die KI nimmt die Aufzeichnungen der Sensoren, entschlüsselt die Signale und formt sie zu Worten. Ein Avatar auf einem Bildschirm, der Ann Johnson ähnlich sieht und sogar eine ähnliche Stimme hat, spricht das aus, was sie denkt.

Der Avatar redet für sie, und das gar nicht mal so schlecht. Bis zu 78 Wörter pro Minute können kommuniziert werden. Ein gesunder Mensch spricht in etwa 160 Wörter pro Minute. Noch ist jedes vierte Wort fehlerhaft, doch der Fortschritt der Forschung ist gewaltig.

Das Forschungsteam der UC San Francisco veröffentlichte folgendes Video von Ann Johnson, das zeigt, wie sie nach all den vergangenen Jahren wieder mit ihrem Mann kommunizieren kann.

Spannende Entwicklungen in der Forschung

Einem anderen Forschungsteam war Ähnliches gelungen: Die Neuroprothese wurde bei einer von Amyotrophe Lateralsklerose, kurz ALS,-Betroffenen angebracht. ALS ist eine fortschreitende neurodegenerative Krankheit, die zu Muskellähmung führt. Die KI umfasst 125.000 Wörter und ermöglicht 62 Wörter pro Minute. Den gleichen Forschungsgruppe war es zwei Jahre zuvor gelungen, einem gelähmten Probanden das Schreiben am Computer ermöglichen, indem er sich Sätze vorstellen sollte und die KI lernte, Buchstaben und Wörter zu antizipieren, wodurch die Fehlerquote sehr gering gehalten werden konnte. Zwischen 74 und 90 Zeichen pro Minute konnten getippt werden (die gesunde Vergleichsgruppe des gleichen Alters erreichten im Schnitt 115 Zeichen in der Minute) und die Fehlerquote lag bei 8,5 Prozent.

Und weiter…Kann ein Computer bald unsere Gedanken lesen?

Noch nicht ganz. Das Programm entnimmt nicht die Gedanken der Personen, es interpretiert viel eher die Intentionen und die Bewegungsmuster unseres Gehirns beim Sprechen, wie eine lernende Übersetzungs-Software. Die Zukunft dieses Forschungsfelds ist vielversprechend. Das Verfahren ist jedoch nicht für alle Betroffene passend, denn Schlaganfallpatientinnen und -patienten haben oft weitreichendere Schädigungen, die nicht nur die Unfähigkeit zur passenden motorischen Ausführung umfassen. Aktuell steht die Forschung noch am Anfang und doch liegt die Fehlerrate bei nur 25%. Expertinnen und Experten gehen davon aus, dass diese schnell reduziert werden kann und es bereits in den nächsten zehn Jahren möglich sein könnte, geeigneten Personen ihre Sprache zurückzugeben und so die Integration in den Alltag deutlich zu verbessern.

Quellen

Belluck, P. (2021, July 14). Tapping Into the Brain to Help a Paralyzed Man Speak. The New York Times. https://www.nytimes.com/2021/07/14/health/speech-brain-implant-computer.html

Belluck, P. (2023, August 23). A Stroke Stole Her Ability to Speak at 30. A.I. Is Helping to Restore It Years Later. The New York Times. https://www.nytimes.com/2023/08/23/health/ai-stroke-speech-neuroscience.html

Berger, R. (2018, March 9). Neurolinguistik: Was beim Sprechen im Kopf passiert. Spektrum.de – Nachrichten aus Wissenschaft und Forschung. https://www.spektrum.de/news/neurolinguistik-was-beim-sprechen-im-kopf-passiert/1547713

Kattwinkel, T. (2023, August 24). Sie kann wieder sprechen. Zeit Online. https://www.zeit.de/gesundheit/2023-08/gehirn-computer-schnittstellen-ki-sprache-schlaganfall/komplettansicht

Megbel, E. (2021, May 12). Handschriftlich kommunizieren MIT Gedankenkraft. Spektrum.de – Nachrichten aus Wissenschaft und Forschung. https://www.spektrum.de/news/brain-computer-interface-uebersetzt-hirnsignale-in-handschrift/1873186

Metzger, S. L., Littlejohn, K. T., Silva, A. B., Moses, D. A., Seaton, M. P., Wang, R., Dougherty, M. E., Liu, J. R., Wu, P., Berger, M. A., Zhuravleva, I., Tu-Chan, A., Ganguly, K., Anumanchipalli, G. K., & Chang, E. F. (2023). A high-performance neuroprosthesis for speech decoding and avatar control. Nature, 620(7976), 1037-1046. https://doi.org/10.1038/s41586-023-06443-4

Willett, F. R., Avansino, D. T., Hochberg, L. R., Henderson, J. M., & Shenoy, K. V. (2021). High-performance brain-to-text communication via handwriting. Nature, 593(7858), 249-254. https://doi.org/10.1038/s41586-021-03506-2

Willett, F. R., Kunz, E. M., Fan, C., Avansino, D. T., Wilson, G. H., Choi, E. Y., Kamdar, F., Hochberg, L. R., Druckmann, S., Shenoy, K. V., & Henderson, J. M. (2023). A high-performance speech neuroprosthesis. Nature, 620, 1031–1036. https://doi.org/10.1101/2023.01.21.524489

Unglaublich! Und eine Trefferquote von 75% ist auch wirklich gut. Ich bin erstaunt, wie gut diese deep learning models funktionieren. Was mich interesseren würde, wären die Arten der Fehler, die passieren. Ob das motorisch-nahe Worte sind, semantisch verwandte und so. Die Forschung in dem Bereich ist so spannend!

Eine Trefferquote von 75% ist sehr schlecht. Als die ersten Voice to Text -Systeme eine Trefferquote von 75% hatten, waren sie unbrauchbar. Allerdings ist 75% sehr gut gegenüber der Situation, wo der Patient überhaupt nichts mitteilen kann.

Naja, selbstverständlich ist da Raum nach oben, aber solche Zahlen sind ja alles andere als absolut sondern im Kontext zu betrachten. Meiner Meinung nach ist ein wirklich bemerkenswerter Schritt, dem ich auch Tribut zollen kann.

das liest sich vielversprechend. Eine app, die die Aktivitäten des Hirns interpretiert.

Und wenn die Sensoren noch empfindlicher werden, dann braucht man vielleicht die Schädeldecke nicht mehr zu öfnen.

Zitat: „ wenn die Sensoren noch empfindlicher werden, dann braucht man vielleicht die Schädeldecke nicht mehr zu öfnen.“

Eine externe Ableitung ist aussichtslos, denn man muss die Signale genau vom motosensorischen Cortex ableiten, der etwa die Zungenmuskulatur steuert. Und das ist eine eng umgrenzte Stelle in der Hirnrinde. Ohne eine Elektrode dort geht es nicht.

Es gibt aber eine Möglichkeit ohne Schädelöffnung auszukommen. Dann nämlich, wenn man Elektroden in Hirnvenen unterbringt. Dann würde der Zugang über eine grosse Vene genügen.

Nur ein Gedanke, vielen Dank für diese Nachricht :

Sprache ist die Fähigkeit innere und äußere Einflüsse, auch Lagen, zu erkennen, zu verarbeiten und zu benachrichtigen.

Die Sprache dient dem Sozialen, derartige Sozialität ist einem sich fortpflanzenden Wesen nützlich, damit es sich fortpflanzt, dies mit sozusagen höherer Wahrscheinlichkeit als dies ohne Sprache möglich wäre.

Zu beachten ist beim, bei den Sprechenden die Außen- und die Innenwelt.

Zurückgekommen auf das Thema des dankenswerterweise bereit gestellten WebLog-Eintrags, idT scheint es nun möglich zu sein Personen, die nicht (mehr) in gewohnter Hinsicht zum sprachlichen Output fähig sind, durch Apparat zu ergänzen, der dann doch irgendwie so erlaubt.

Wichtig ist in diesem Fall das Verstehen des oder der so Betroffenen.

Klappt es so, ist es gut, klappt es nicht so, schaut es so aus, als ob das irgendwas “aufoktrojiert” wird, was nicht gut wäre – und hoffentlich nicht der Fall ist.

Mit freundlichen Grüßen

Dr. Webbaer

Um keine Leitungen durch die Körperoberfläche hindurch verlegen zu müssen,

könnte man die Energie und die Informationen mit einer

Hochfrequenz-Induktionsschleife hin- und her-übertragen.

Für höhere Informationsübertragungsraten wäre auch eine

gepulste Nah-Infrarot-Laserdiode geeignet.

Die implantierbaren Chips und die Induktionsschleife dafür

lassen sich sehr flach gestalten.

K.Bednarik,

Die Nah-Infrarot Übertrragung wäre nicht schlecht. Wenn jemand sich schämt läuft er rot an. Die Idee ist passend.

Den Beitrag finde ich extrem interessant.

Die Erkenntnisse deuten darauf hin, dass „Bewusstseins relevante Informationen“ als Ergebnisse oder Zwischenergebnisse, tatsächlich nach der Verarbeitung im neuronalen Netz auf hautartigen Schichten, als elektrische Neuronenaktivierung zur „informellen Abbildung“ gelangen. Diese Informationen werden z.B. über Outputorgane als Sprache ausgegeben.

Neuerdings kann man diese Informationen mittels einer Sensorik aufnehmen, entsprechend umkodieren und technisch ausgeben um damit defekte organische Strukturen zu „umgehen“.

Könnte man sich ganz grob so vorstellen, wie das Geschehen auf einem flachen Fernsehbildschirm.

Die rund 2 Millionen „Bildpunkte“ leuchten in bestimmter Helligkeit und Farbe auf und so entsteht der Eindruck des bekannten Bildes. Im Beispiel der Forscher wird aber Sprachinformation, in der Mathematik/Technik sagt man „abgebildet“, obwohl es gar keine optische Information sein muss.

Information wird aber nicht nur an der relativ leicht zugänglichen Hirnhautoberfläche, sondern auch in den „Haut Furchen“ der Hirnhautoberfläche abgebildet. Wenn man da auch noch mit einer Mikro Sensorik herankommt, so käme man an mehr Information, was die Auswertung eventuell verbessern könnte.

Wenn man die Gene für ein fluoreszierendes Protein mit Hilfe

eines harmlosen viralen Vektors in die Gehirnzellen einbringt,

so dass die Fluoreszenz von der neuronalen Aktivität abhängt,

dann entsteht praktisch ein Gehirn-Bildschirm.

@Elektroniker 11.11. 13:40

„Information wird aber nicht nur an der relativ leicht zugänglichen Hirnhautoberfläche, sondern auch in den „Haut Furchen“ der Hirnhautoberfläche abgebildet.“

Wenn hier tatsächlich vielfältige Inhalte in zweidimensionalen Repräsentationen angelegt sind, dann ist das eine Gelegenheit, hier umfassend zu spionieren. Und zu gucken, was da gerade in der gesamten Psyche diskutiert wird.

Wie wäre es mit beweglichen Mirkobots von vielleicht einem zehntel Millimeter Größe, die bis in alle Furchen vordringen, und sich dann per Infrarot-Schnittstellen untereinander so vernetzen, dass ein Gesamtbild der Aktivitäten der gesamten inneren Hirnoberfläche aufgezeichnet wird. Dieses wir dann ebenso über Infrarotschnittstellen nach außen übertragen, und von KI weiter verarbeitet.

Wo wir die ganzen Bots schon mal installiert haben, können die auch gleich versuchen, mittels Mikroimpulsen die entsprechenden Nervenzellen anzusprechen.

Das könnte zu einer ganz neuen Schnittstelle zwischen uns und der Außenwelt heranwachsen. Und nicht nur bei krankhaften Störungen Abhilfe schaffen, sondern eine wirkliche Aufrüstung möglich machen.

Mit Risiken und Nebenwirkungen.