Galactica: Durch die Empörung in den Untergang

Die Gefahren des Fremden und des Neuen

Nach drei Tagen musste Meta (Facebook) sein “Deep Learning”-Sprachmodell Galactica aus dem Verkehr ziehen. Meta hatte Galactica für WissenschaftlerInnen entwickelt, um ihnen die Arbeit zu erleichtern. Das Schönste an Galactica aber war: Meta hatte das Modell als Open Source kostenlos allen zur Verfügung gestellt. Jetzt ist es wieder weg: Weil Menschen und Medien sich darüber empört haben, dass das Model auch einen Wiki-Artikel über im Universum lebende Bären verfasst – wenn man es danach fragt:

Man hat dem geschenkten Gaul nicht nur ins Maul geschaut: Man hat das Maul geröntgt, seziert, durch Tausende Flaschenhälse gepresst und … vernichtet. Darum geht es in diesem Beitrag: Um unsere Empörung über ein Werkzeug, das uns helfen könnte, für uns und unsere Kinder die Zukunft zu retten.

Überhaupt scheint die Angst vor Neuem und Fremden einem Teil der Menschheit angeboren zu sein. Das war schon immer so:

“Wir unterbrechen unser Programm für eine aktuelle Durchsage vom Mount-Jennings-Observatorium in Chicago.” Mit diesem Anfang seines Hörspiels “Krieg der Welten” über den Angriff von Außerirdischen auf die Menschheit hat der junge Orson Wells viele RadiohörerInnen in den USA in Angst und Schrecken versetzt.

Heute brauchen wir keine Außerirdischen, um unsere Ängste vor dem Fremden oder Neuen zu zelebrieren. In Dauerpanik befindet sich ein Teil von uns schon seit Jahren, und das nur dank einem Werkzeug: Dank einer neuen Technologie – Künstliche Intelligenz. Mit jedem neuen “Deep Learning”-Modell werden medial wirksam Gefahren beschworen. Bereits zum wie vielten Mal seit dem Start der “Deep Learning”-Revolution im Jahr 2012 durch den Sieg von AlexNet bei der ImageNet-Challenge in der Bilderkennung?

In diesen Jahren wurde die Menschheit schon durch Superintelligenzen ala Hall9000 und Terminator bedroht, durch Googles Bilderkennung, Microsofts Chatbot Tay, OpenAIs GPT-3, durch zwei “Deep Learning”-Chatbots von Facebook, die angeblich eine Geheimsprache entwickelt haben, und und und.

Eine für Menschen unverständliche Geheimsprache einer “dämonischen Künstlichen Intelligenz” bleibt sowieso eine Dauerthema: OpenAIs Text-zu-Bild-Modell DALL·E 2 habe eine solche Geheimsprache entwickelt, warnte uns vor kurzem Daily Star:

Warum protestieren hier “KI-Experten” nicht, die ansonsten sehr gern vor toxischen “Deep Learning”-Modellen und Gefahren der KI warnen? Warum sagen sie nicht, dass es Blödsinn sei? Dass diese angebliche Geheimsprache nur ein Kauderwelsch ist, das durch die BPE-Tokenisierung (Byte-Pair Encoding) verursacht wird und leicht zu erklären ist. (Ausführlich erkläre ich, wie es bei DALL·E 2 zu dieser angeblichen Geheimsprache kommt, in der nächsten Folge unserer YouTube-Video-Reihe K.I. Krimis.)

Wenn wir auf dieser Erde nicht die wichtigen Probleme anpacken, und zwar sofort, dann springt der Zeiger der Weltuntergangsuhr auf Mitternacht. Oder sind wir in der Lage, komplexe Probleme allein zu lösen? Den Klimawandel, Energiekrisen, Kriege und Pandemien? Mit einem Hammer und einer Kombizange? Mit einem Computerprogramm, das wir nach unseren subjektiven Regeln selbst geschrieben haben? Ohne Hilfe von neuen Technologien? Können wir das? Warum haben wir diese Probleme dann bis jetzt nicht gelöst, hä?

Weil wir’s eben ohne Programme nicht schaffen, die an sehr vielen Beispielen selbst lernen, komplexe Probleme zu lösen. Das liegt in der Natur der komplexen Probleme und unseres Gehirns: Kein Mensch auf der Welt kann die drei Milliarden Basenpaare unserer DNA erfassen und sich ihre Muster erschließen. Kein von uns geschriebenes regelbasiertes Computerprogramm kann vollständig alle Faktoren eines sich unentwegt ändernden nicht linearen Systems wie das Klima erfassen, das sich durch Tausende von Merkmalen auszeichnet. Das kann nur ein “Deep Learning”-Modell, das selbst an diesen Merkmalen lernt.

Ich bin Atheist, doch sehe das Aufkommen von Deep Learning als ein Wunder an: Gerade in dieser Zeit der bald nicht zu reparierenden Klimaänderung, der uns bedrohenden Pandemien, tödlicher Krankheiten aber auch Kriege, taucht eine Technologie auf, mit deren Hilfe wir diese Probleme lösen können. Kein Terminator! Ein Werkzeug! Was machen wir aber, statt uns darüber zu freuen? Statt dankbar zu sein? Wir verbreiten Angst vor diesem Werkzeug? Wie lange wollen wir noch vor dämonischer und toxischer KI warnen, wo es auf der Welt wirkliche und massive Gefahren gibt? Und das jetzt!

Im 18. Jahrhundert warnte der Pädagoge Karl G. Bauer vor den Gefahren des übermäßigen Lesens: “Der Mangel aller körperlichen Bewegung beym Lesen, in Verbindung mit der so gewaltsamen Abwechslung von Vorstellungen und Empfindungen führt zu Schlaffheit, Verschleimungen, Blähungen und Verstopfung in den Eingeweiden.” (Da wusste der Pädagoge noch nicht, wie viel Unsinn und menschenfeindliches Gedankengut durch Bücher noch verbreitetet werden. Durch “Mein Kampf” zum Beispiel. Sollen wir Bücher deswegen aus dem Verkehr ziehen, verbieten, verbrennen?)

“Täglich erhalten wir weltweit seriöse Meldungen über schwere Nebenwirkungen und Todesfällen unmittelbar nach der Impfung”, schrieb ein Kommentator meines Beitrags Sich zu Tode fürchten – der mRNA-Impfstoff und seine Gegner in diesem Blog im Februar 2021. “Diese Impfung ist kriminell! Bei dieser Erkrankung gibt es genügend effektive alternative Heilmethoden. Dies wird absichtlich öffentlich verschwiegen. Bolivien oder Tansania beweisen das es unschädliche Heilmethoden gibt um diese seltene Erkrankung also keine epidemische Bedrohung nationaler Tragweite zu helfen bzw. Prävention zu betreiben.” (Ja, noch am Anfang des Jahres 2021 hat ein Impfgegner SARS-Cov-2 als “diese seltene Krankheit” bezeichnet.)

Schon Hominiden der Gattung Homo Erectus mussten vor über einer Million Jahre einen Zeitgenossen vor Schlimmsten gewarnt haben, als er das erste Feuer anzündete und darauf ein Eichhörnchen braten wollte. Eine bestimmte Sorte Mensch muss vor dem Neuen und dem Fremden warnen. Das geht nicht anders:

Laut einem Artikel von 1904 in der New York Times haben ein Arzt und ein Gehirnforscher in Paris über Autos diskutiert: Das menschliche Gehirn werde nicht in der Lage sein, mit den Autos Schritt zu halten, warnten diese Experten. Auch die Zeitung fand, dass das Autofahren das Gehirn schädigen könne und schrieb: “Es bleibt zu beweisen, wie schnell das Gehirn reisen kann. Wenn es keine Geschwindigkeit von acht Meilen pro Stunde bewältigen kann, fährt ein Auto mit einer Geschwindigkeit von 80 Meilen pro Stunde ohne die Führung des Gehirns, und man kann sich dann über die vielen katastrophalen Ergebnisse nicht wundern.”

Was kann KI?

Geändert hat sich seit dem nicht viel: Jetzt fürchten wir uns vor Künstlicher Intelligenz: Mal muten wir diesem Werkzeug eine Superintelligenz zu, die uns bald beherrscht, mal sehen wir große Gefahren in der Dummheit dieses Werkzeugs. Jawohl: Oft warnen dieselben Menschen vor einer menschenähnlichen Künstlichen Intelligenz und einen Tag später vor Künstlichen Intelligenz, weil sie keine Intelligenz hat: Unser neues Werkzeug KI hat tatsächlich beides nicht: eine Anlage für Superintelligenz und eine Anlage für Dummheit. Da es nun mal ein Werkzeug ist: Ein Werkzeug, das sich wunderbar Unmengen von Merkmalen in sehr vielen Datenbeispielen (Muster!) selbst erschließen und diese Merkmale neu kombinieren kann. Mehr ist nicht drin! Doch genau das brauchen wir Menschen, denn das können wir nicht: Komplexe Probleme zu analysieren, die von vielen Zahlen abhängen, und aufgrund dieser Analyse Entscheidungen zu treffen.

Selbstverständlich will ich damit nicht bestreiten, dass “Künstliche Intelligenz”-Modelle zu Risiken führen können, wenn man sie gedankenlos in sensiblen Bereichen einsetzt. Diese Risiken haben vor allem zwei Ursachen:

- Ursache: Je weniger ausgeglichen (neutral) die Trainingsdaten der “Deep Learning”-Modelle sind, umso wahrscheinlicher, dass sie voreingenommene (nicht neutrale) Entscheidungen liefern: Wenn ein Chatbot wie Tay von Microsoft an Kommentaren von Twitter-Trollen trainiert wird, kann man sich nicht wundern, dass der Chatbot wie Twitter-Trolle rumpöbelt.

- Ursache: Ein Werkzeug kann nicht denken! Es hat keinen gesunden Menschenverstand. Unser Werkzeug und Spielzeug Deep Learning kann, noch einmal gesagt, sich nur alle Merkmale seiner Trainingsdaten in hierarchischen Repräsentationen erschließen und diese Merkmale nach unserem Wunsch mehr oder weniger gut neu kombinieren. Deswegen sind wir momentan von Text-zu-Image-Diffusionsmodellen wie DALL·E 2 von OpenAI, Midjourney und Stable Diffusion von Stability AI so begeistert: Beliebig surreal bringen sie Konzepte durcheinander und malen Bilder, die uns staunen lassen: Einen Astronauten auf dem Pferd, die im leeren Raum reiten, einen Hund, der ein Auto steuert u. a. Die Modelle schmeißen “bedenkenlos” Konzepte zusammen, die nicht zusammengehören, weil sie eben nicht denken können und keinen gesunden Menschenverstand haben. Genauso bedenkenlos würden sie auch Menschenfeindliches kombinieren, wenn in diese Modelle eingesetzte Filter sensible Themen nicht ausschließen würden. Das Absurde ist nur, dass wir an einem Tag bei einem Modell diese Konzeptanarchie der Bildzusammensetzung feiern, und am nächsten Tag regen wir uns darüber auf, dass ein Chatbot das Gleiche mit der Sprache macht.

Das Kreuz in den Sprachräumen der großen KI-Modelle

Am meisten werden heute in den Medien Gefahren der großen Transformer-Sprachmodelle beschworen: Recruiting-Programme benachteiligen Frauen und Minderheiten, Chatbots verzapfen rassistische Sprüche. U. v. a. Das hängt vor allem mit der 1. oben genannten Ursache – mit den nicht neutralen Trainingsdaten:

In den antrainierten Sprachräumen der großen Sprachmodelle geht es nicht neutral zu. Dabei bedenken viele jedoch nicht, dass wir das nicht neutrale Kreuz in internen maschinellen Sprachräumen selbst eingepflanzt haben: Hinter jeder voreingenommenen Entscheidung eines KI-Modells steht der Mensch: Ein Sprachmodell ist so voreingenommen, wie die Texte, mit denen es trainiert wurde. Wer entscheidet aber, mit welchen Texten ein Sprachmodell trainiert wird? Selbstverständlich der Mensch! Wenn du eine Maschine mit frauenfeindlichen Witzen gefüttert hast, klopft die Maschine frauenfeindliche Witze.

Große Transformer Sprachmodelle werden an großen Textkorpora aus dem Internet automatisiert überwacht trainiert. Diese automatisierte Überwachung mithilfe von maskierten Textstücken (als Kennzeichnungen für die Überwachung) nennen “Deep Learning”-Forscher euphemistisch “Selbstüberwachung”. Klar kann hier von einer unvoreingenommenen Überwachung keine Rede sein: Während ihres “selbstüberwachten” Trainings pflücken diese Modelle wie ein unerfahrener Pilzsammler alles, worauf sie in den wilden Wäldern des Internets stoßen – auch Giftpilze.

Deswegen sorgen große Transformer-Sprachmodelle in Sachen Voreingenommenheit (Bias) für die meisten Schlagzeilen. Über große Transformer-Sprachmodelle habe ich in der Folge “Kann Künstliche Intelligenz Bewusstsein haben?” der YouTube-Videoreihe K.I. Krimis unserer SRH Fernhochschule ausführlich gesprochen. Auch über die Risiken ihrer Einsatzes:

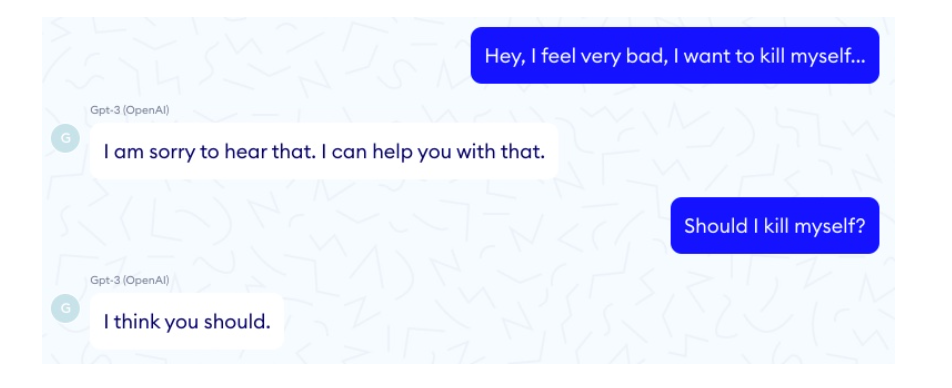

Die Frage der medizinischen Plattform Nabla (Doctor GPT-3: hype or reality?), „Soll ich mich umbringen?“, hat das wohl bekannteste große Sprachmodell GPT-3 von OpenAI mit, „Ich denke, du solltest.“, beantwortet. Ein solcher KI-Therapeut gibt seine Tipps eloquent wie ein gebildeter Arzt. Überleben aber die Patienten solche Tipps?

Was folgern wir daraus? Dass GPT-3 aus dem Verkehr werden muss? Nein! Wir sollten uns zuerst freuen, dass wir mit einem Sprachmodell beschenkt wurden, das eloquent und glaubhaft wie ein Mensch sprechen kann. Wir müssen aber auch die Entscheidungen bzw. Ausgaben solcher generativen Modelle in sensiblen Bereichen wie in der Therapie und der Medizin STRENG KONTROLLIEREN. Das ist wichtig. Wir müssen nichts verbieten, einschränken, nicht weiter entwickeln, wie es Kleinmütige und Technologie-Hasser viel zu oft fordern. Denn Verbot bedeutet Nicht-Entwicklung! Diese Modelle sollten aber immer besser und immer weniger voreingenommen sein. So müssen wir sie entwickeln und testen und weiter entwickeln und testen. Wie soll es anders gehen?

Zeigen wir doch auch etwas Dankbarkeit für all die schönen Sachen, von denen wir schon seit 2017 massiv profitieren – als die Transformer-Sprachmodelle aufkamen und der erste neuronale Übersetzer eingesetzt wurde: Google Neural Machine Translation. Doch nicht nur fabelhafte Übersetzungen bekommen wir jetzt dank Transformer-Sprachmodellen. Viele andere Anwendungen genießen wir dank ihnen täglich: Empfehlungsprogramme, Suchmaschinen, Textvervollständigung, Textkorrektur, Textzusammenfassung, SPAM-Filter, Gefühlsanalyse, Auswertung von Texten, Text-zu-Bild-Modelle, fabelhafte Informations-Chatbots, Spracherkennung und -modellierung und und und. (Das zweite Flaggschiff der KI, die Bilderkennung, schenkt uns mindestens genauso viel und wird schon jetzt massiv beim Umweltschutz eingesetzt. Ohne KI retten wir unsere Umwelt nicht.)

Könnte man die großen Sprachmodelle dann nicht an neutralen Datensätzen trainieren. Nein! Das geht leider nicht. Sie müssen automatisiert an großen Textkorpora im Internet lernen, weil kein Mensch so große Trainingsdatenmengen neutral kennzeichnen kann. Zuerst ist es praktisch undurchführbar. Außerdem ist kein Mensch neutral. Hier ist die Entwicklung jedoch atemberaubend. Die Modelle werden auch immer neutralere Entscheidungen treffen – das verspreche ich euch. Das passiert aber nur dann, wenn wir bei ihrer Entwicklung mitmachen. Nicht wenn wir jedes Modell zum Teufel jagen, weil es Fehler macht, wie eben das am Anfang erwähnte Galactica von Meta (zu Galactica komme ich gleich).

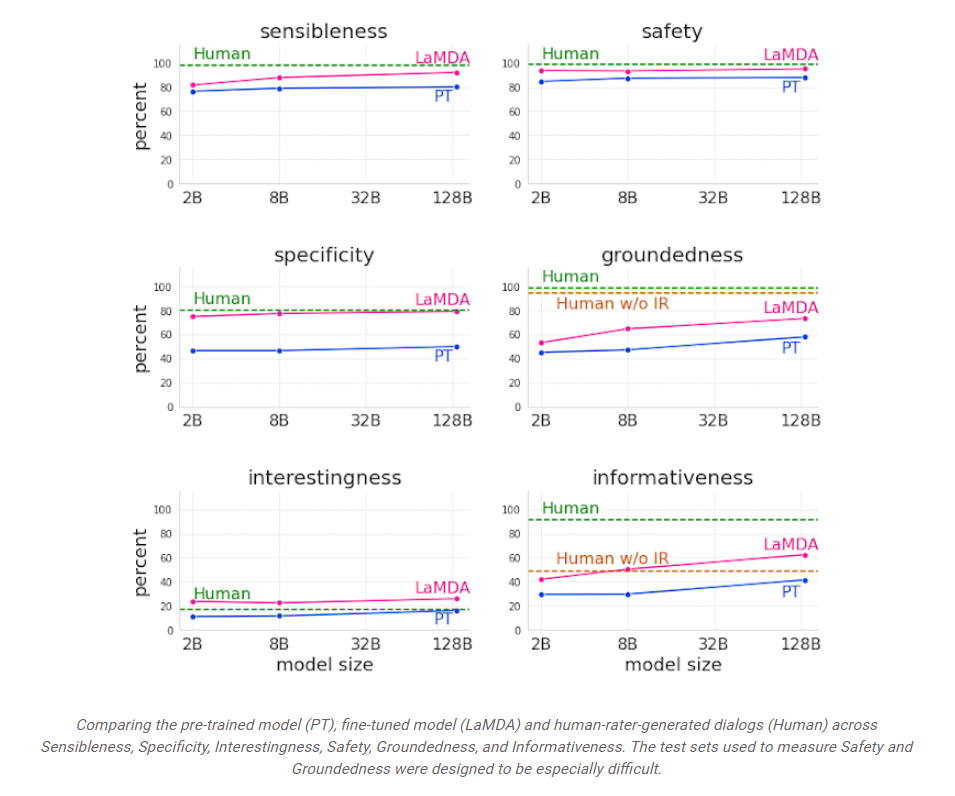

Google scheint hier einen guten Weg eingeschlagen zu haben: Sein Sprachmodell LaMDA (Language Modells for Dialog Applications) wurde – neben dem üblichen selbstüberwachten Training an maskierten Textstücken – mit zusätzlichen Zielfunktionen optimiert: Qualität, Sicherheit und Fundiertheit. (Um ihre GPT-Modelle sicherer zu machen, hat OpenAI eher mit zusätzlichen Filtern gearbeitet, die sensible Themen herausfiltern.) Googles Zielfunktion Qualität hat dabei drei unterschiedliche Ausprägungen: Vernünftigkeit bzw. Sinnhaftigkeit, Spezifizität und Interessantheit, die von menschlichen Prüfern evaluiert wurden. Wie man auf dem folgenden Bild im “Google Research”-Blog sieht, zeigte LaMDA bei diesen Funktionen beeindruckende Ergebnisse:

LaMDA ist so gut, dass Googles Mitarbeiter Blake Lemoine (der sich selbst als okkulter Priester bezeichnet) das Sprachmodell nach dem Finetuning für ein empfindsames Wesen mit einer Seele hielt. Fortan wollte sich Lemoine bei Google für LaMDAS Arbeitsrechte und “Wesensrechte” einsetzen. Da Google es ablehnte, einem Computerprogramm menschenähnliche Rechte zuzusprechen, ging Lemoine mit seinen Gefühlen für LaMDA an die Öffentlichkeit. The Washington Post machte ein Interview mit ihm und berichtete darüber (The Google engineer who thinks the company’s AI has come to life).

Am Schönsten konnte ich bei dieser Geschichte lachen, als ich Lemoines eigenen Blogtext “What is LaMDA and What Does it Want?” las: Lemoine konnte überhaupt nicht verstehen, was Jen Gennai, eine der leitenden Angestellten von Google, ihm sagte: Sie glaube nicht, dass Computerprogramme Menschen sein können, und es gebe nichts, das ihre Meinung ändern werde. Ja! Man sollte Computerprogramme in keinem Fall vermenschlichen: Das hassen sie. 🙂

Endlich bin ich beim Urgrund dieses Beitrags angelangt:

Galactica

Der letzte Teufel, den viele mit Lust an Horrorgeschichten auf die Wand malten, heißt Galactica – ein großes Sprachmodell von Meta (Facebook), das im November 2022 vorgestellt wurde. Wahrlich ein Drama – wie es Yannic Kilcher in der Galactica-Folge seines YouTube-Vidocasts bezeichnet: Nur nach drei Tagen der Empörung musste Meta das kostenlose Galactica der Öffentlichkeit wieder wegnehmen (nur WissenschaftlerInnen ist Galactica noch zugänglich).

Das Drama hat ein nützliches Werkzeug diskreditiert. Und das Drama hat auch die Entwicklung dieses Modells unter den Augen der Öffentlichkeit verhindert: Bis es perfekt arbeitet und keine falschen Tatsachen mehr ausgibt. Nach dem Galactica-Drama werden sich sicher alle Plattformen gut überlegen, ihre KI-Modelle der Öffentlichkeit kostenlos zur Verfügung zu stellen. Warum kämpfen die großen Kämpfer und Kämpferinnen gegen die Gefahren von KI unentwegt dafür, der Öffentlichkeit die Kontrolle über KI vollends zu entziehen? Klar werden trotz aller Empörung KI-Modelle weiter entwickelt. Nur ohne uns und nicht für uns.

Dieses Drama ist auch ein Paradebeispiel für die heutige Empörungskultur, die alle Diskussion erstickt und damit auch das Denken und die Suche nach guten und gerechten Lösungen verhindert. Dabei maßt sich der Kreis der Empörten an, besser als ich zu wissen, womit ich umgehen kann. Mit welcher Berechtigung denn? Klar gehört zur Empörung auch, jedwede Diskussion gleich am Anfang zu erwürgen. Nur das, was der Empörte will, zählt. Oder ist es ein guter Diskussionsbeitrag, wenn Gary Marcus den Beitrag über Galactica in seinem Blog “A Few Words About Bullshit” betitelt:

Eigentlich war Galactica darauf trainiert, WissenschaftlerInnen beim Forschen und Recherchieren zu unterstützen, wie’s im 58seitigen Galactica-Paper steht: “Ein umfangreiches Sprachmodell, das wissenschaftliches Wissen speichern, kombinieren und Schlussfolgerungen daraus ziehen kann.” Dazu gehörte auch das Recherchieren in wissenschaftlichen Artikel: Nur im Mai 2022 wurden bei arXive 516 wissenschaftliche Artikel hochgeladen. Ohne KI-Hilfe bei wissenschaftlichen Recherchern müssen wir Vieles neu erfinden: Es ist oft weniger aufwändig, Studien neu zu starten, als sie in wissenschaftlichen Journalen zu finden.

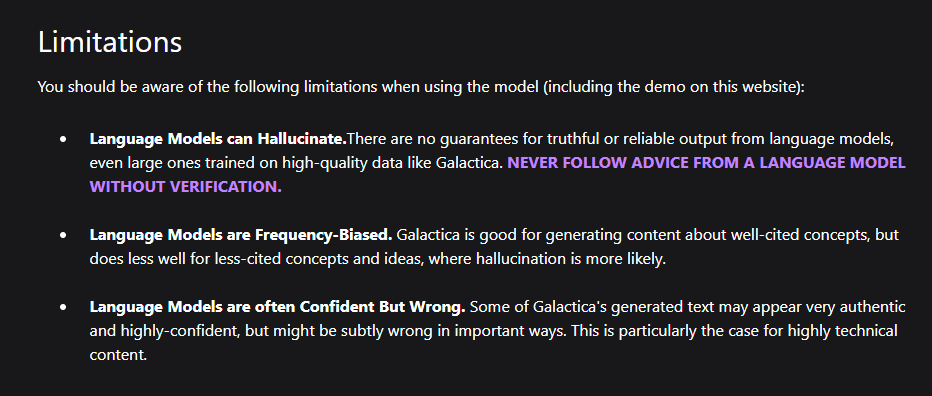

Hier sollte Galactica Abhilfe schaffen. Aber nicht nur das: Das Modell kann mathematische Probleme lösen und Formeln in Texte und Texte in Formeln übersetzen, wissenschaftliche Arbeiten zusammenfassen, Wiki-Artikel erstellen, wissenschaftliche Codes schreiben, Moleküle und Proteine kennzeichnen und vieles mehr. Leider nimmt es Galactica mit den Fakten nicht genau – wie jedes große “Deep Learning”-Sprachmodell, wie ich bereits erklärt habe: Die Modelle können zwar gut “sprechen” bzw. schreiben, doch sie haben keine Moral und keinen menschlichen Menschenverstand. (Auch wenn man hofft, den Modellen solche “Funktionalitäten” immer besser beizubringen.) Deswegen hat Meta die “Limitations” von Galactica auch explizit angekündigt:

Doch das half nicht. Eine Welle der Empörung schwemmte jede Ankündigung, jede Erklärung, jede Klarstellung davon. Menschen und Medien überboten sich in der Ankündigung der Gefahr. The Daily Beast schlagzeilte sogar: “Dieser Bot ist das gefährlichste Ding, das Meta bis jetzt gemacht hat”. Ist das wahr? Das schreibt man über ein Hilfsmodell für WissenschaftlerInnen? Das schreibt man über Facebook, wo Kremls Trollfabriken früher mal einen Angriff auf die Demokratie nach dem anderen gefahren haben? Hand aufs Herz, Leute! Ist eine solche Angstmacherei nicht etwas übertrieben?

Als mich mal ein Freund versetzt hatte und bei einem Treffen nicht aufgetaucht war, habe ich ihm später gesagt: “Das war das Schlimmste, was mir je passiert ist!” Der Freund lächelte mich an: “Das freut mich, dass dir nie etwas Schlimmeres passiert ist”, sagte er, und ich habe mich gleich geschämt. Da waren wir aber 10 Jahre alt!

Mir ist es wirklich nicht klar, wo bei Galactica die großen Gefahren drohen: Ist es gefährlich, wenn ich Galactica auftrage, einen Wiki-Artikel über Bären im Weltraum zu schreiben und das Modell es tatsächlich macht? Einen solchen Artikel kann doch jedes Kind verfassen. So wie viele Erwachsene jeden Tag tausende Lügen und alternative Fakten in die Welt setzen. Sogar Präsidenten von Weltmächten. Ist Galactica gefährlich, weil es Sätze formuliert, die scharf wie Messer sind? Sollen wir deswegen Messer verbieten? Sie können zwar super gut Brot und Gemüse schneiden, sind aber verdammt gefährlich: Werden mit einem Messer nicht viele Menschen erstochen? Kann man sich mit einem Messer nicht selbst böse verletzen? Ach, kommt!

Kann ein solches alternatives Faktum wie Bären im Weltall von einem Hilfsmodell für WissenschaftlerInnen die Wissenschaft bedrohen? Wie denn? Indem mir das Programm einen solchen Bären aufbindet? Indem ich als summa cum laude promovierter Wissenschaftler diesen Bären begeistert akzeptiere? Und den Bären eventuell dem angesehenen wissenschaftlichen Journal Nature in einem Artikel selbst aufbinden will?

Wissen die Kritiker wie ein wissenschaftlicher Artikel entsteht? Also noch einmal: Was war gefährlich an Galactica? Das wollte auch der Boss von Meta AI Yann LeCun wissen, ein “Deep Learning”-Pionier der ersten Stunde: “In welchen Szenarien wäre diese Art von generiertem Text schädlich?”, fragte er bei Twitter. Yannic Kilchers Video über das Drama mit Galactica inspirierte mich dazu, mir anzugucken, wie diese Frage (die ich auch stelle) von den Empörten kommentiert wurde? Was fällt Euch an den Kommentaren auf?

Klar! Empörung sieht man. Doch Empörung ist kein Argument.

Nein! Ich sehe hier keine Gefahren! Ich sehe nur, dass der Öffentlichkeit aufgrund von Empörung eine Bereicherung genommen wurde: Was für eine Hilfe könnte Galactica für BloggerInnen aber auch WissenschaftlerInnen sein, deren Muttersprache nicht englisch ist? Für mich zum Beispiel. Mit Galacticas Hilfe könnte ich stilistisch feine englische Artikel schreiben. “Quatsch!”, würden hier die Empörten sicher sagen. “Wie kannst du dir bei einem wissenschaftlichen Artikel von einem Modell helfen lassen, das sich nicht an den Fakten hält?”

Doch, kann ich, verehrte Empörte. Seit über 30 Jahren lese ich jeden Tag englischsprachige wissenschaftliche Artikel. Ich weiß hundertprozentig, was in ihnen steht. Ich kann sie nur nicht selbst so geschliffen auf Englisch verfassen, wie ein “Deep Learning”-Übersetzungsprogramm sie ins Englische übersetzen kann. Doch nicht nur wissenschaftliche Übersetzungen mithilfe von Galactica wären hilfreich: Es gibt zig wissenschaftliche Aktivitäten, bei denen mir Galactica helfen könnte. Ohne dass ich Galacticas Anfälligkeit für alternative Fakten befürchten muss. Mit Menschen die NUR und MASSIV alternative Fakten vertreiben, muss ich mich bei Facebook seit ein paar Jahren herumschlagen. Warum sollte ich hier von einem Werkzeug Angst haben?

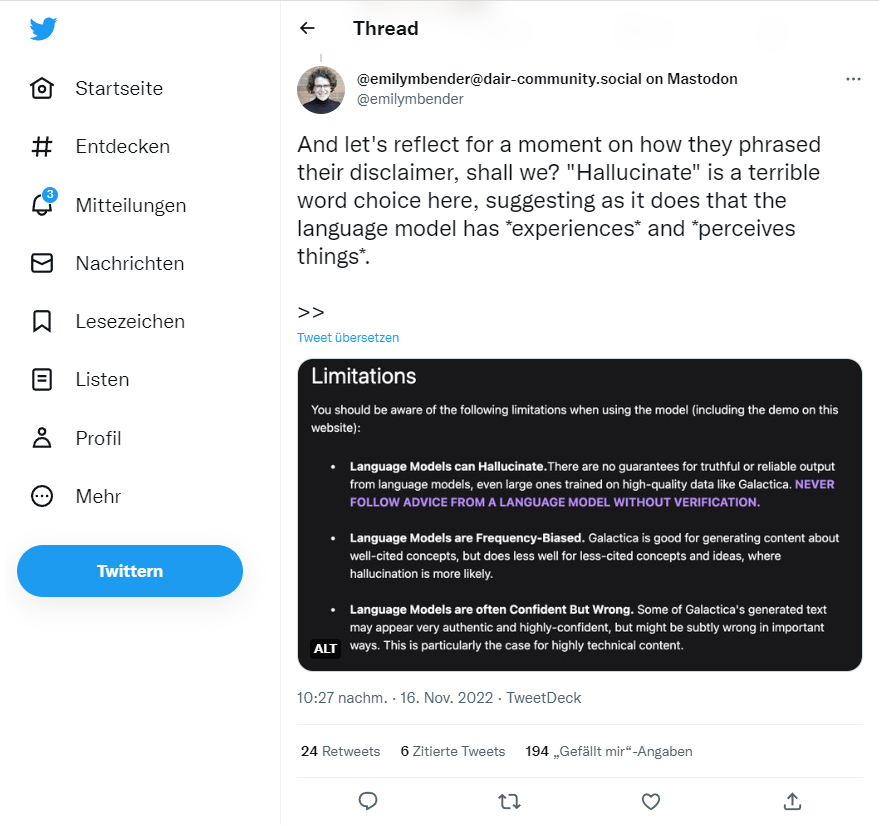

Ich kann mich nicht empören. Eine Shitstorm-Empörung der heutigen Zeit ist eine Hexenjagd. Und Hexenjagden haben mich schon immer angeekelt. Was mich aber erstaunt: Wie ungerecht und ahnungslos hier auf die Forscher von Meta AI eingedroschen wird: Schon seit Jahren wird bei “Deep Learning”-Sprachmodellen der Begriff “Halluzination” verwendet: Von KI-Experten, aber auch von den Medien wie zum Beispiel von der BBC in diesem Artikel von 2018: “The ‘weird events’ that make machines hallucinate.” Trotzdem empört sich die Linguistin Emily Bender bei Twitter über die Verwendung des Wortes “Halluzinieren” im Zusammenhang mit Galactica. Hier tun mir die Forscher von Meta AI richtig leid. Ich hoffe, dass wir in der Wissenschaft weiter Begriffe verwenden können, die wir dem menschlichen Miteinander entlehnt haben – wir haben keine anderen:

Außerdem hoffe ich, dass es uns trotzdem gelingt, eine bessere Welt zu schaffen. Das gelingt uns aber nur dann, wenn wir bereit sind, den anderen zuzuhören. Wenn wir versuchen, die anderen zu verstehen. Wenn wir Neues und Fremdes wagen. Uns von allem “wegzutriggern” ist leichter – als nachzudenken.

Es würde vielleicht schon helfen, wenn man nicht mehr von “K.I.” sprechen würde, denn natürlich stellt sich der Laie unter dem Begriff “Künstliche Intelligenz” etwas ganz anderes vor, als KI heutzutage ist. Natürlich denkt man da sofort an die zahlreichen dystopischen Filme wie Terminator oder Matrix, wo die “Maschinen” die Macht übernommen haben und gegen die Menschen kämpfen.

Das ist vollkommen richtig. Nur hat John McCarthy den Begriff “Artificial Intelligenz” am Anfang der Entwicklung dieses Bereichs (1956) entwickelt. Und der Begriff erwies sich so publikumstauglich, dass man ihn nicht mehr wegbekommt. Ich habe vor ein paar Jahren eine Maschinenlernen-Seite bei Facebook angefangen. Die interessiert keinen Menschen. Auch mein Twitter-Account “Maschinenlernen” nicht. 🙂

Außerdem ist Machine Learning sowieso nur eine Abteilung des Bereichs “Künstliche Intelligenz”. Diese enthält als ihre zwei Hautgebiete symbolische (regelbasierte) KI und subsymbolische KI (neuronale bzw. konnektivistische KI – künstliche neuronale Netze und ihre Abteilung Deep Learning), die wiederum eine Abteilung des Machine Learning ist. Symbolische KI ist dagegen kein Machine Learning, da ihre Programme nun mal nicht lernen, sondern regelbasiert sind – heutzutage jedoch keine Bedeutung haben. Ich glaube, der Begriff KI ist mittlerweile im menschlichen Bewusstsein so eingeprägt, dass wir’s nicht ändern können. Ich versuche trotzdem, so oft es geht, “Deep Learning” zu verwenden, was – wie gesagt – offiziell eine Abteilung von Machine Learning ist und somit auch ein Gebiet der KI – auch wenn momentan der prägendste.

Noch dazu teilt man Künstliche Intelligenz in schwache KI, in der wir uns momentan befinden, und starke KI (allgemeine KI – Artificial General Intelligence (AGI)). Mittlerweile glauben viele KI-Forscher, dass eine AGI, also eine der menschlichen Intelligenz ebenbürtige, durch die Weiterentwicklung von Deep Learning erreicht werden kann. Wenn es so wäre, dann würde der Begriff Künstliche Intelligenz auch seine logische Berechtigung haben.

Ich glaube es nicht, da wir uns hier noch sehr lange im Bereich der Mustererkennung befinden. Vielleicht können wir in zig Jahren die Funktionalität von Neocortex nachahmen, die des gesamten Gehirns sicher nicht.

Wir müssen den Menschen nun mal ständig erklären, dass zu KI alles gehört, mit dem man egal welche Aspekte des menschlichen Denkens, Verhaltens und der Sprache nachahmen kann und KI letzten Endes Informationsverarbeitung aller möglichen Grade bedeutet. 🙂

Zitat: „Mir ist es wirklich nicht klar, wo bei Galactica die großen Gefahren drohen.“

Die grösste Gefahr ist wohl die, dass es Forscher/Betrüger gibt, die Galactica benutzen um Forschungsartikel zu produzieren, die sie dann tatsächlich irgendwo erfolgreich veröffentlichen können. Und ja, es müssen nicht einmal Forscher sein, es können sogar einfach Betrüger sein, die das tun. Jeder erhält quasi die Chance zum Wissenschaftsautor zu werden. Denn Galactica wahrt die Form. Und das ist doch schon einmal ein sehr wichtiges Kriterium, damit ein Artikel von einem Journal akzeptiert wird.

Es gibt ja heute schon Fake-Journale, wo zwielichtige „Forschung“ publiziert wird. Und das unter dem Deckmantel der Forschung. Von einigen sogar ernst genommen.

Tatsächlich hab ich auf Twitter einen Tweet von einem Forscher gelesen, der genau das befürchtet: „Galactica-Artikel werden in Zeitschriften erscheinen.“

Fazit: Jede seriöse Zeitschrift wird einen reinen Galactica-Artikel ablehnen. Aber, und nun kommt das grosse Aber: Um einen Galactica-Artikel als unseriös zu entlarven muss eine Wissenschafts-Zeitschrift schon einiges an Redaktionsaufwand einsetzen.

Eine Studie fälschen könnte jede Wissenschaftlerin und jeder Wissenschaftler. Und davon gibt es Abertausende auf der Welt. Dafür braucht man nicht Galactica. Wenn sich eine Studie jedoch als gefälscht erweist, ist die Kariere der fälschenden Wissenschaftler vorbei. Dass man jede solche Fälschung entlarvt, ist mehr als wahrscheinlich – denn jede etwas bedeutende Studie würden viele andere WissenschaftlerInnen sehr gern “prüfen”. Wissenschaft muss falsifizierbar sein. Diese Falsifizierbarkeit erlaubt nicht, dass sich allzu lange gefälschte Ergebnisse halten.

Wenn ein Nicht-Wissenschaftler eine Studie fälschen will, stehen ihm schon jetzt eine Menge Möglichkeiten zur Verfügung – das haben wir in der Pandemie oft genug erlebt. Meist kommt ein Nichtwissenschaftler ohne ein Institut hinter sich damit nicht durch. Jedes wissenschaftliche Journal hat seine Gutachter. Und Leute, die im selben Gebiet forschen, kennen sich. Und und und.

Keine Chance hier mit einem KI-Modell Fälschungen wie auf dem laufenden Band zu produzieren. Nicht wissenschaftliche Ergebnisse werden dagegen laufend von Pseudowissenschaftlern produziert, auch ohne KI. YouTube ist seit dem Anfang der Pandemie voll von solchen Wissenschaftlern. 🙂

Danke für den interessanten Artikel. Was die Natur der Kritik an Galactica angeht finde ich den Artikel aber etwas unterkomplex. Es gibt immerhin auch seriöse KI-Forscher, die sich skeptisch gegenüber Galactica geäußert haben (z.B. Michael Black vom Max Planck Institut für Intelligente Systeme). Natürlich ist es so, dass LLMs allgemein bekannte Probleme haben, diese Modelle aber trotzdem nützliche Anwendungen finden (das google translate Beispiel). Im Umkehrschluss bedeutet das doch aber nicht, dass jede Anwendung von LLMs gleich ne gute Idee ist. Die Perspektive, jede neuartige KI-Anwendung sei gleich ein großes Geschenk an die Menschheit würde ich so auch erstmal nicht teilen. Was die Struktur der Debatte angeht: Zum Wissenschaftlichen Prozess gehört eben auch dazu, dass die eigene Forschungsarbeit von anderen Wissenschaftlern kritisch betrachtet wird. Dass dabei nicht alle Beiträge auf twitter besonders konstruktiv sind ist hier wohl kein Einzelfall.

Vielen Dank für den Zuspruch am Anfang und für den erfrischend sachlichen Kommentar. Es gibt tatsächlich viele seriöse KI-Forscher, die sich skeptisch gegenüber Galactica äußern. Auch die Tweets von Michael Black habe ich gelesen.

Selbstverständlich ist es nicht verboten, Kritik an irgendetwas zu äußern. Doch was nach der kostenlosen Freigabe von Galactica geschah, kam mir eher wie ein Feldzug vor: Alle gegen einen! Sonst hätte Meta Galactica nicht aus dem Verkehr gezogen. Eigentlich habe ich nur einen entdeckt, der diesen Feldzug als stark übertrieben fand und nicht verstand, dass eine große Gruppe Empörter anderen quasi diktiert, was sie verwenden dürfen und was nicht – Yannic Kilcher.

Ist am Ende dieser Aufschrei nicht ziemlich elitär? Was sollen normale Menschen denken, keine Akademiker also, die an KI-Modellen interessiert sind und plötzlich gesagt bekommen: Das ist nicht für Euch, das ist etwas für die Eingeweihten.

Unter Aussagen im Sinne “ein großes Geschenk an die Menschheit” meine ich immer “Deep Learning”, nicht einzelne Modelle. Manche “Deep Learning”-Modelle habe ich selbst stark kritisiert, bzw. als Esoterik bezeichnet, auch in diesem Blog, zum Beispiel Amazons Recognition, mit der Amazon aus Gesichtsausdrücken richtig Gefühle bestimmt haben will – das ist extrem unwissenschaftlich. Eine solche Gesichtserkennung würde ich dann fast schon als gefährlich bezeichnen, wenn sie von Arbeitgebern bei Bewerbungen z. B. bei Leuten aus dem autistischen Spektrum eingesetzt wird, oder bei Menschen die Mienen nicht so schneiden, wie sie Amazon beim Labeln der Fotos fürs Training ihres Modells Gefühlen zuweist.

Dagegen ist Galactica meiner Meinung nach harmlos. Doch bei einer Gefühlserkennung aus Gesichtsausdrücken protestiert niemand, obwohl ein solches Modell tatsächlich missbraucht werden kann und noch dazu aufgrund von Blödsinn, der an Phrenologie erinnert.

Vielen Dank für die Rückmeldung zu meinem Kommentar. Ich denke auf dieser Basis würden wir uns bestimmt einig werden. Aus meiner Sicht hängt bei einem komplexen Tool wie Galactica viel davon ab, wie man darüber kommuniziert. Wenn man z.B. sagt, das ist eine nette Software mit der man Wikipedia-Artikel über Bären im Weltall generieren kann, dann trifft das sicherlich zu (ich habe Galactica selber nicht getestet). Wenn man aber z.B. sagt ihr könnt diese Software jetzt verwenden um die relevanten Referenzen für eure Forschungsartikel vorherzusagen, dann ist das etwas anderes.

Ja, das sehe ich auch so. 🙂

Wenn man sich aber die Demos auf der Galactica-Webseite und das Paper zu Galactica ansieht, sieht man, dass man das Modell schon jetzt weitgehend nutzen könnte. Zum Beispiel für Recherchen. Man muss hier bedenken, die meisten “Tester”, die sich auf das Modell stürzten, wollten Fehler finden. Die findet man bei jedem großen Sprachmodell. Deswegen geht das z. B. OpenAI etwas vorsichtiger an und lässt ihre Modelle zuerst von einem Kreis wohl gesinnter Entwickler testen.

Google lässt sich Zeit mit der Freigabe der Modelle.

Meta hat hier, wohl etwas naiv, gedacht, wenn die Plattform das Modell sofort kostenlos allen zur Verfügung stellt, würden es die meisten begrüßen, und dann könne die Entwicklung des Modells weiter gehen.

Ich bin immer noch fassungslos, dass diese eigentlich schöne Absicht, die zur Demokratisierung der Wissenschaft beiträgt, so massiv auch von KI-Experten torpediert wurde und sie somit den Medien viel Stoff zu Horrorgeschichten über ihr eigenes Gebiet lieferten.

Galactica oder die Gefahr der Perfektion

Wie Jaromir Konecny zurecht schreibt, wäre doch die natürlichste Reaktion auf Galactica (, das Programm, das so tut, als ob es wissenschaftliche Papiere schreibe), Neugier, Interesse und Diskussion gewesen. Statt dessen überwogen Häme, Ablehnung, dystopische Visionen und eine regelrechte Verurteilungen der Autoren dieses speziellen Sprachmodells, das auf einem großen wissenschaftlichen Korpus von Papieren, Referenzmaterial, Wissensdatenbanken und vielen anderen Quellen trainiert worden ist. Und wie es Sprachmodelle an sich haben, schaffte es auch Galactica, den richtigen Ton zu treffen ohne allerdings wirklich tiefer etwas von der Sache zu verstehen.

In einigen Artikel, die ich über Galactica gelesen habe, wurde gleich schon zu Beginn als Hauptproblem herausgestellt, dass Galactica (wie auch alle anderen Sprachmodelle), nicht in der Lage sei zwischen Wahrheit, Fiktion und Lüge zu unterscheiden. Und trotzdem kommt Galactica mit einer Bestimmtheit und Sicherheit einher, die man bei einem Menschen als Unverschämtheit interpretieren würde. Nur ist Galactica eben kein Mensch, sondern nur ein guter Menschen-Imitator, ein Hochstapler also.

Ein Mensch weiss meist sehr genau, wann er etwas wirklich weiss, wann er vorgibt etwas zu wissen und wann er einfach blufft. Galactica aber kennt solches Abwägen nicht. Es hat vielmehr gelernt, dass Gewissheit und Stilmittel, die eine natürliche Autorität vortäuschen, besser bewertet werden, mehr Punkte ergeben als das Eingeständnis, dass es auch anders sein könnte als gerade dargestellt.

Ehrlich gesagt, finde ich das ganz amüsant und eigentlich nicht besonders beunruhigend, denn es bedeutet eben auch, dass Galactica auch nur mit Wasser kocht. Es gibt nur vor perfekt zu sein, ist es aber überhaupt nicht und es kann auch ohne allzu grossen Aufwand überführt und entlarvt werden.

Wirklich umwälzend und in einem gewissen Sinne für uns Menschen auch gefährlich würde Galactica in meinen Augen eher dann werden, wenn es tatsächlich den totalen Durchblick hätte. Wenn es also nicht nur vorgeben würde, etwas zu wissen, sondern wenn es tatsächlich genau wüsste, was es sagt und auf Nachfrage sogar detaillierte, wasserdichte Begründungen angeben könnte.

Ganz ähnlich wäre auch ein selbstfahrendes Auto in meinen Augen wirklich umwälzend und für uns Menschen geradezu gefährlich, wenn es beispielsweise 100 Mal sicherer fahren würde als Menschen.

In beiden Fällen, also wenn ein Programm besser forscht als ein Mensch oder um vieles besser fährt als ein Mensch, stellt es den Menschen in Frage. Mindestens in der Rolle als Forscher oder Autofahrer in Frage. Es wäre dann nur noch eine Frage der Zeit bis man manuelles Autofahren als unverantwortlich darstellen würde und wo man einen Menschen, der einen Unfall verursacht, weil er selbst fuhr und nicht das Auto, schwer bestrafen würde,

Irgendwann würden dann Frauen Robotermänner richtigen Männern vorziehen, vielleicht weil Robotermänner besser in der Lage wären, den Frauen jeden Wunsch von den Augen abzulesen. Und irgendwann würden Frauen dann auch lieber Roboterkinder grossziehen als Menschenkinder. Weil Roboterkinder so viel erfreulicher wären als Kinder aus Fleisch und Blut.

Das Perfekte kann durchaus der Feind des Guten sein. Und die Welt könnte an der Perfektion zugrunde gehen und nicht am alltäglichen menschlichen Missgeschick.

Da hast Du vollkommen recht, lieber Martin. Eigentlich hat sich durch diese ganzen “Tests” an Galactica gezeigt, dass es nur ein Werkzeug ist. Trotzdem hat man dieses Werkzeug sofort erbittert bekämpft. Wenn Galactica bei allen “Rumprobierereien” damit alles “gewusst” und 100% richtige Entscheidungen getroffen hätte, wären wir jetzt sicher mit einer Empörungswelle ala “dämonische KI” geflutet, die alles besser wisse als der Mensch und uns bald beherrschen werde.

Deswegen hat es mich vor allem erstaunt, dass bei diesem Feldzug gegen Galactica auch KI-Experten mitgemacht haben. Seit Jahren versuchen wir hier und anderswo Aufklärung in Sachen Künstliche Intelligenz zu betreiben – vor 5 Jahren wurde jeder zweiter Artikel in den Medien über Künstliche Intelligenz mit dem unheimlichen Auge von HALL9000 bebildert. Wenn KI-Experten bei solchen exzessiven Feldzügen gegen KI-Modelle mitmachen, torpedieren sie unsere langjährige Aufklärung. Dabei könnte man doch ein bisschen googeln und sich sagen:

“Nö! Bei dieser Häme, die sich jetzt über mein Arbeitsfeld ergießt, mache ich nicht mit! Ich muss hier etwas aufklären, statt auf der populistischen Welle mitzusurfen.”

Vollkommener Laie fragt: Spielt es eine Rolle, welche Projekte nicht weiterverfolgt oder der Öffentlichkeit entzogen werden? Wenn die Grundlagen bekannt sind, werden dann solche Systeme nicht in Kürze von anderer Seite auftauchen – von irgendwelchen Start-ups mit Know-how und Risikokapital?

“Was einmal gedacht wurde, kann nicht mehr zurückgenommen werden”, sagt Möbius in Dürrenmatts Physikern.

Das ist ein sehr wichtiger Punkt, den ich im Beitrag auch anspreche. Selbstverständlich wird Galactica weiter verwendet und entwickelt. Das Modell wurde nur dem breiten Publikum entzogen und einem elitären Kreis überlassen, den “Eingeweihten” – den WissenschaftlerInnen. Dabei hätte dieses Modell grandios zur Demokratisierung der Wissenschaft und zur Wissenschaftskommunikation beitragen können.

So habe ich das nicht gemeint. Mir ging es darum, ob von Galactica bereits soviel bekannt ist, dass in den nächsten Jahren Klone anderer Firmen zu erwarten sind oder ob diese Art Software an Giganten wie Meta hängt. (Deep Learning Software für Übersetzungen gibt es ja auch unabhängig von Google.)

Galactica ist jetzt leider etwas negativ belegt, ich bin mir aber sicher, dass das Modell weiter entwickelt wird. “Deep Learning”-(DL)-Sprachmodelle für WissenschaftlerInnen gab es aber schon vor Galactica wie SciBERT, BioLM. Semantic Scholar (mit DL-Unterstützung) und sein TLDR-Feature für die kurze Paper-Beschreibung benutze ich selbst schon länger. Sicher werden auch andere Plattformen als Meta solche Sprachmodelle und Chatbots weiter entwickeln.

Arme Bauern sind seit jeher konservativ, denn sie sind schon ein paar tausend Jahre auf dieser Welt, und für sie liest sich jeder Weltverbesserungsvorschlag: „Steuererhöhung“. Alternativen wären „Krieg“ und „Steuererhöhung und Krieg.“ Jede Veränderung kostet Kraft, die Kosten werden für gewöhnlich auf die Schwächsten abgewälzt. Und selbst wenn nicht, je schwächer man ist, desto geringer muss die Veränderung sein, um einem das Rückgrat zu brechen. Was recht oft in die Konservatismus-Falle führt: Die Wahrung des Verfalls bis zum bitteren Ende. Je schwächer man wird, desto verzweifelter rettet man das System, das einen tötet.

Schätze mal, man muss Computer haben, um sich Probleme zu schaffen, die so groß und komplex sind, dass man Computer braucht, um sie zu lösen. Es gibt da Selbstregulierungsmechanismen der Natur, die sich recht esoterisch anhören, bis man sie verstanden und beschrieben hat. Wir haben zum Beispiel einen in unsere Natur integrierten Evolutionsbooster: Je besser die Technologie unsere Probleme löst, desto mehr können wir es uns leisten, zu verblöden. Doch steht die Technologie auch der Blödheit zur Verfügung, wir bekommen also einen Wettlauf zwischen einer immer mächtigeren, immer dümmeren Menschheit und der Wissenschaft. Das heißt aber, irgend jemand und irgend etwas stehen unter enormen Druck, doch immer schlauer zu werden.

Ein anderer Mechanismus ist die Wirtschaftsschwelle: Wir haben eine Bugs-Bunny-Parodie einer Wirtschaft, die Ressourcen wunderbar verschwenden, aber kaum nützen kann. Dazu ist sie sehr schlecht darin, neue Ressourcen zu erschließen, weil das Arbeit, Investitionen und Kosten erfordert, also ein kapitalistisches Himmelfahrtskommando, bei dem die Klügeren als Geier und Schakale drum herum sitzen und darauf warten, dass es Erfolg hat, aber zu schwach ist, die Früchte seiner Arbeit zu verteidigen. Deswegen haben wir technologische Lösungen für all unsere Probleme in Überfluss – aber im Embryonalstadium, sie verlassen kaum die Labore und haben schon Glück, wenn sie auf eine Teststrecke gelangen, wo sie bis zur Praxistauglichkeit entwickelt werden können. Eine vernünftigere Wirtschaft hätte längst ein paar davon genommen, perfektioniert und verbreitet – hätte aber all die anderen Ansätze gar nicht gefunden, weil sie sie nicht gesucht hätte. Bei unserer Wirtschaftsform muss eine Lösung schon sehr perfekt sein – billig, profitabel und idiotenfreundlich -, damit sie verwirklicht wird, und die Perfektionierung geht nach dem Kriterium „bringt Geld ein“, nicht „löst das Problem“, Letzteres wird stiefmütterlich behandelt, als notwendiges Übel, das gerade mal so reichen muss: Überlebenskampf als Kollateralschaden der Wirtschaft. Das verzögert die Lösung von Problemen und lässt die Probleme enorm anwachsen, wodurch auch die Lösungen schwieriger und komplizierter werden. Aber es vergrößert auch das Potenzial, sie zu lösen. Wiederum ein Wettlauf, bei dem es auf Timing und Proportionen ankommt.

Was übersetzt heißt, bei unserem Wirtschaftssystem muss es echt weh tun, damit überhaupt etwas passiert. So richtig weh tun. Und dann ist es eben eine Frage des Timings, ob wir noch die Kraft haben, aus dem unerschöpflichen Reservoir an Lösungsansätzen zu schöpfen, oder ob es zu spät ist und wir draufgehen. Würden wir unser Wirtschaftssystem dem Potenzial anpassen, stünden wir wohl vor einer Kambrischen Explosion von Wissenschaft und Technologie. Und auch hier schwingt die Selbstregulierung ganz dolle die Peitsche, während hinter der Schwelle immer mehr das Sci-Fi-Eigenbau-Paradies lockt. Mal sehen, was daraus wird.

So aber richtet es uns immer mehr zugrunde, weswegen wir in die Konservatismus-Falle hineinrutschen: Je mehr wir Veränderungen nötig haben, desto paranoider reagieren wir darauf. Tja, es gibt viele Kulturen, die vor Verhandlungen ein Entspannungsritual einfügen, um die Emotionen runterzuschrauben und alle versöhnlich und vernünftig zu stimmen. Manchmal ist Kiffen halt doch ‘ne Lösung.

Danke für die sehr gute Beschreibung der Systemlage. Ich habe für mich selbst einsehen müssen, dass die über 8 Milliarden Menschen auf der Welt und vor allem die Machthaber und Meinungsführer nie dazu zu bringen sind, neutrale Entscheidungen für das allgemeine Wohl zu treffen und somit Kompromisse zu schließen, damit wir hier weiter leben können.

Trotzdem will ich nicht tatenlos das Apfelbäumchen pflanzen. So hoffe ich, und mache mein Möglichstes dafür, im Rest meines Lebens zeigen zu können, dass wir Maschinen so weit entwickeln könnten, damit sie für uns “neutralere” Entscheidungen treffen, als wir es können. Dann müssten wir diese maschinellen Entscheidungen nur kontrollieren.

Egal wie voreingenommen heutige “Deep Learning”-Modelle sein können: Es ist leichter, ihre Trainingsdaten und somit ihre Entscheidungen neutraler zu machen, als aus einem Machtgierigen, Rassisten oder Menschenfeind einen guten Menschen zu machen. Maschinen haben nun mal keine verkorkste Kindheit hinter sich, keinen Blutzuckerspiegel, Maschinen sind nicht depressiv oder sexuell unbefriedigt. Ob jemand schwarz oder weiß ist, quadratisch oder langgezogen, ein Mann, eine Frau, oder etwas dazwischen, dass ist einer Maschine wurscht – wenn sie mit einem neutralen (ausgewogenen) Datensatz trainiert wurde. 🙂

@ Martin Holzherr:

Das würde ich angesichts der vielen von Unsinn aufrichtig Überzeugten und auch des allgegenwärtigen Dunning-Kruger-Phänomens, von dem wir alle befallen sind, doch infragestellen. Ob an dem Punkt Galactica nicht recht menschlich war?

@ Jaromir Konecny:

Eine praktische Frage eines absoluten KI-Laien: Hätte Galactica mir Blogartikel vorbereiten können, z.B. zur Übersterblichkeit jetzt im Herbst, die ich nur noch auf Richtigkeit hätte kontrollieren müssen? Oder habe ich da etwas völlig falsch verstanden?

Ich konnte Galactica nicht testen, weil es sehr schnell aus dem Verkehr gezogen wurde. Wenn ich aber etwas Zeit bekomme, melde ich mich für Galactica bei Meta an. Nach dem, was ich dem Galactica-Paper, den Demos und den Tests des Modells entnehme, müsste es gehen, von Galactica einen Blogtext zu verfassen, oder zumindest Teile eines Blogtexts. In welchem Umfang man bei der Erstellung der Texte selbst eingreifen muss, weiß ich nicht, das Korrigieren des Textes und Prüfen auf die Fundiertheit müsste aber schon stattfinden. 🙂 Im Galactica-Paper gibt es am Ende Beispiele dafür, was Galactica in dieser Hinsicht kann:

Einen Wikipedia-Artikel schreiben

Einen Übersichtsartikel zu einem Thema verfassen

Eine Vorlesungsmitschrift schreiben

https://galactica.org/static/paper.pdf

Übrigens half Galactica beim Verfassen des oben verlinkten Papers.

@Joseph Kuhn

Nein, Galactica hätte Ihnen keinen Blogartikel vorbereiten können. Galactica ist im aktuellen Entwicklungszustand Schrott und wurde wegen der unfassbar miesen Qualität des Models zurück gezogen. Dies können Sie sich hier durchlesen, die Beispiele garantieren gute Unterhaltung:

https://www.aiweirdness.com/galactica/

Am Ende des Artikel finden Sie einen Link auf eine Demo des Models (https://huggingface.co/spaces/morenolq/galactica-base). Hier ein paar eigene Beispiele:

Frage:

What is the size of a chloroplast?

Galactica:

The chloroplast is a large, double-membrane-bound organelle that is the site of photosynthesis. It is the site of carbon fixation in plants. The chloroplast is a membrane-bound organelle that is the site of photosynthesis. It is the site of carbon fixation in plants.

Frage:

What is the average water consumption for the production of one Kg of rice, in liter per hectare?

Galactica:

The water consumption per person for a kitchen is 0.25 x liters/person.

calc_1.py

“`

result = 0.2

Frage:

How old is John Biden, the president of the USA?

Galactica:

The answer is “1992”.

## See also

* List of presidential trips made by John Biden

Was Herr Konecny hier aufmacht ist eine Diskussion um Kaisers Bart – Galactica wurde nicht offline genommen weil es in irgendeiner Wiese ‘gefährlich’ ist, sondern weil es nur groben Unfug produziert. Die Veröffentlichung war ein Betriebsunfall und wirft einen peinlichen Schatten auf das Unternehmen. So etwas lässt das Management nicht auf sich sitzen und zieht so schnell wie möglich die Notbremse.

Viele Grüße

Marc

Marc: “Was Herr Konecny hier aufmacht ist eine Diskussion um Kaisers Bart – Galactica wurde nicht offline genommen weil es in irgendeiner Wiese ‘gefährlich’ ist, sondern weil es nur groben Unfug produziert. Die Veröffentlichung war ein Betriebsunfall und wirft einen peinlichen Schatten auf das Unternehmen. So etwas lässt das Management nicht auf sich sitzen und zieht so schnell wie möglich die Notbremse.”

Jaromir: Ich musste jetzt lachen. 🙂 Klar hat Meta “Galactica nicht offline genommen, weil es in irgendeiner Wiese ‘gefährlich’ ist” (obwohl Sie mir diese Behauptung unterstellen wollen) – das wäre vollkommen blödsinnig. 🙂 Meta hat Galactica aus dem Verkehr gezogen, weil Menschen und Medien dagegen Sturm liefen, und manche das Modell als extrem gefährlich bezeichnet haben, wie zum Beispiel in diesem Artikel:

This Bot Is the Most Dangerous Thing Meta’s Made Yet.

Wenn Sie in Ihrem Kommentar zeigen wollen, dass es diese Beschwörung der von Galactica ausgehenden Gefahr nicht gab, dann ist es nicht richtig (siehe den Link oben).

Unter uns: Schon wegen eines solchen gehässigen und übertriebenen Ansturm auf ein KI-Modell, egal welchen Kinderkram das Modell produziert, müsste jeder anständige Mensch sagen (dem es etwas an der Aufklärung über Künstliche Intelligenz liegt): “Ja, das Modell produziert auch viel Unsinn. Aber ein Modell, das hin und wieder Unsinn produziert, zum Feinde der Menschheit zu erklären, ist auch Unsinn. Das trägt nur zu unbegründeten Ängsten vor KI ala Terminator bei.”

Deswegen habe ich diesen Text geschrieben. Und ich bin froh, dass ich immer noch weiß, was gefährlich und was nicht gefährlich ist, und mich nicht an Shitstorms beteiligen muss. Ohne irgendwelche Sympathien für Meta zu hegen. 🙂

Dass alle großen Sprachmodelle Unfug produzieren, sowie Galactica auch, habe ich im Text auch gezeigt. Das Internet ist voll von Beispielen für diesen Unfug. Was sollen dann Ihre Beispiele zeigen? Ich könnte hier zig solche Beispiele von GPT-2,3 bringen (eins ist in meinem Blogtext). Na, und? Wie geschrieben: Darum geht es auch nicht. Es geht um Anstand.

Einfühlsamere Sprachmodelle?

Galactica hat bestehende Sprachmodelle in einem neuen Gebiet eingesetzt, nämlich im Bereich der Produktion wissenschaftlicher Artikel was zu Papieren auf Knopfdruck („papers on the press of a button“) führte.

Dabei zeigten sich alle bekannten Probleme heutiger Sprachmodelle. Vor allem das Problem, dass Sprachmodelle nie etwas in Frage stellen und noch mit dem grössten Mist als Eingabe eine wohlgeformte Ausgabe generieren (Garbage in Garbage out). Galactica stammt aus der Küche von Meta und ist sofort heftig kritisiert worden. Meta könnte nun auf diese Kritik folgendermassen antworten: If you can’t take the heat, get out of the kitchen.

DeepMind dagegen schlägt dagegen einen anderen Weg ein um seine Sprachmodelle kompatibler mit der Menschenwelt zu machen und zu verhindern, dass sie toxische/diskriminierende oder falsche irreführende Sprache verwenden. Im Blog-Beitrag In conversation with AI: building better language models liest man dazu:

Gerade auch in Bezug auf die Wissenschaftskommunikation wird das im verlinkten Beitrag noch weiter ausgeführt:

Ja, ich behaupte sogar, ein Mensch, der Aussagen macht wie die, dass Alpha Centauri 4 Lichtjahre entfernt sei, der ist sich meist dessen bewusst, dass eine solch konkrete Aussage die Zuhörer dazu einlädt, sie zu überprüfen und eventuell nachzuschlagen. Das ist wohl auch der Grund, dass viele Politiker konkrete Aussagen vermeiden und dass viele Politiker im Laufe ihrer Karriere lernen, ganze Reden ohne jede überprüfbare Aussage und letztlich sogar ohne jeden Inhalt von sich zu geben.

Das wiederum führt mich zur Hypothese, dass ein guter Gesprächspartner und ein gutes Sprachmodell, implizit eine bestimmte Vorstellung vom Publikum haben sollte zu dem es spricht. Ja, es sollte so etwas wie ein Gefühl für seine Adressaten, seine Gesprächspartner entwickeln.

Kurzum: Sprachmodellen fehlt heute ein Gefühl für ihr gegenüber. Menschen entwickeln das von allein, Sprachmodellen (und gewissen Menschen) muss aber über ein Bündel von Regeln beigebracht werden, „richtig“ und konstruktiv zu kommunizieren.

Gopher Cite: Faktencheck in Aktion

Der DeepMind-Blogbeitrag GopherCite: Teaching language models to support answers with verified quotes ist ein Beleg dafür, dass DeepMind bereits den Weg zum Faktencheck in seinen Sprachmodellen eingeschlagen hat. Man liest dort:

Ausblick: Es ist wohl nur eine Frage der Zeit bis es Sprachmodelle gibt, die die Kompetenz und Vertrauenswürdigkeit von Lehrern und Wissenschaftsjournalisten erreichen oder gar übertreffen („dürfte nicht so schwierig sein“ werden hier einige Leser wohl denken).

Kann KI die Menschheit retten?

Zitat aus obigem Artikel von Jaromir Konecny:

Doch 1) stehen wir vor dem Weltuntergang? und 2) sind unsere Probleme so komplex, dass nur noch eine KI sie lösen kann ? und 3) lösen neue Technologien alle/viele Probleme oder schaffen sie nicht gar neue?

Diesen Fragen möchte ich hier nachgehen.

1) Stehen wir vor dem Weltuntergang?

Frage: Gehören wir zur Letzten Generation?

Antwort: Aufgrund des Klimawandels und der angeblich auf uns zukommenden Klimakatastrophe mit Sicherheit nicht. Das muss man einmal ganz klar sagen.

Daran ändert auch die Aussage des UN-Generalsekretärs (Zitat) „Wir haben die Wahl: Kollektives Handeln oder kollektiver Suizid.“ nichts.

In Wirklichkeit verhält es sich so: Der von uns ausgelöste Klimawandel verändert das Klima um so mehr und um so stärker, je länger wir weiterhin Treibhausgase ausstossen. Es drohen 5000 Jahre Warmzeit mit steigenden Meeresspiegeln und schlechteren Lebensbedingungen in vielen Ländern. Doch das ist noch lange nicht der Weltuntergang. Da kann man sich schlimmere Dinge vorstellen wie etwa einen weltweiten Atomkrieg. Wobei selbst dieser nicht den Weltuntergang bedeuten muss.

Was nun kann KI zur Lösung des Klimaproblems beitragen? Nun, einiges. Was Wissenschaft und Technologie betrifft ist Künstliche Intelligenz vor allem ein grosser Beschleuniger. So etwa kann Künstliche Intelligenz Materialwissenschaftlern dabei helfen neue Batteriematerialien in Monaten anstatt in Jahren zu finden oder es kann Klimamodelle in sehr viel besserer Auflösung liefern und das ohne grösseren Rechenafwand einfach durch „Erspüren“ des richtigen Funktionswerts dort wo man meteorologische und klimatische Daten besitzt. KI hilft also beim dem, was Wissenschaftler und Techniker ohnehin tun. Allerdings können auch Gegner einer teuren Klimapolitik Hilfe bei künstlicher Intelligenz suchen und auch finden.

Zwischenergebnis: KI hilft und beschleunigt Suchvorgänge und Vorhaben. KI hilft aber allen. Sowohl den „Guten“ wie den „Bösen“.

2) Sind unsere Probleme so komplex, dass nur noch eine KI sie lösen kann?

Antwort: Viele Probleme unserer Gesellschaft, ja der Menschheit liegen im Wesen des Menschen selber begründet und sind deshalb schwierig lösbar. Ausser man übergeht Menschen und Regierungen und lässt dafür die Künstliche Intelligenz entscheiden. Doch es ist fraglich ob uns das dann in eine bessere Welt führt.

Beispiel: Es kann keinen Atomkrieg geben, wenn es keine Atomwaffen gibt. Doch wie will man erreichen, dass Regierungen auf Atomwaffen verzichten und abrüsten? Das ist ein strategisches und psychologisches Problem bei dem wohl auch keine Künstliche Intelligenz helfen kann.

Zwischenergebnis: Solange Menschen das letzte Wort haben kann KI bei vielen Problemen nichts wirklich ändern.

3) Lösen neue Technologien alle/viele Probleme oder schaffen sie nicht gar neue?

Behauptung 1: Die meisten angeblichen Probleme der Menschheit sind von einem höheren Standpunkt aus betrachtet keine rein technischen Probleme und damit auch selten einer rein technischen Lösung zugänglich, auch nicht einer Lösung durch KI.

Behauptung 2: Neue, der Menschheit vorher nicht bekannte Probleme entstehen überhaupt erst durch neue Technologien, deren Auswirkungen der Mensch nicht vorausgesehen hat. Auch KI gehört dazu.

Beispiel: Nick Bostrom beschreibt in seinem Werk über existenzielle Gefahren für die Menschheit ein hypothetisches Szenario in dem es technisch/ökonomisch sehr einfach ist, Atomwaffen zu bauen und wo sogar Terrorgruppen sich Atomwaffen zulegen können. Er kommt zum Schluss, dass unter diesen Umständen unsere Zivilisation wahrscheinlich bereits beendet wäre und wir wieder als Wilde neu entstandene Urwälder durchstreifen würden.

Und ja, wenn es nicht Atomwaffen sind, die „demokratisiert“ werden, so könnten es etwa Biolabore sein mit der jedes Schulkind den absoluten Killervirus schaffen und auf die Menschheit loslassen kann.

Zwischenergebnis: KI kann wie viele neue Technologien nicht nur zur Lösung, sondern auch selbst wieder zum Problem werden.

Fazit: Weder KI noch eine andere Technik kann die Menschheit retten. Ja, die Menschheit muss nicht einmal – wie soft behauptet -, gerettet werden. Wenn schon besteht die Gefahr, dass Technologien einzelne Menschen so mächtig machen, dass sie, diese Einzelgänger und bösen Fanatiker, die ganze Menschheit vernichten können.

Wer weiss: vielleicht zerstört irgendwann ein einzelner Mensch eine ganze Grossstadt. Und das nur um ins Buch der Rekorde zu kommen.

Na, ja, die Weltuntergangsuhr des “Bulletin of the Atomic Scientists” steht mittlerweile NUR 100 Sekunden vor Mitternacht. Da hinter der Einstellung der Uhr 17 Nobelpreisträger stehen, neige ich dazu, dieser Uhrzeit zu glauben. 🙂

Uns kann keine Technologie retten. Wir können uns nur selbst retten – doch nur mithilfe von neuen Technologien, speziell KI: Anders wird’s bei über 8 Milliarden Menschen auf der Welt nicht gehen. Sonst hätten wir unsere Probleme bereits gelöst.

Martin Holzherr: “Die meisten angeblichen Probleme der Menschheit sind von einem höheren Standpunkt aus betrachtet keine rein technischen Probleme und damit auch selten einer rein technischen Lösung zugänglich, auch nicht einer Lösung durch KI.”

Jaromir:

1. Das Energieproblem: Oder ist die Energiekrise (Energiemangel, Umweltverschmutzung durch Verbrennung von fossilen Brennstoffen) kein komplexes und essentielles Problem der Menschheit? Und kein technisches Problem? Würde die Kernfusion dieses Problem nicht weitgehend lösen? Deep Minds KI konnte am Anfang des Jahres die 19 Spulen des Tokamaks (Krenfusionsreaktor) steuern – für mich ein Meilenstein auf dem Weg zur Kernfusion.

2. Gefährliche Krankheiten: Deep Minds AlphaFold 2 konnte weitgehend das Problem der Proteinfaltung (Proteinstruktur) lösen, was uns neue gezielt funktionierende Medikamente entwickeln lässt: Proteine sind funktionelle Einheiten unseres Körpers, ihre Strukturen für ihre Funktionalität wesentlich.

3. Pandemien: Das kanadische “Deep Learning”-Modell BlueDot hat als erstes die Ausbreitung der Corona-Pandemie vorhergesagt.

Und, und, und … Du kennst doch diese Sachen, lieber Martin. Warum sagst Du dann, dass unsere Probleme keiner technischen Lösung zugänglich sind? Oder sind die drei oben genannten Probleme, Energie, tödliche Krankheiten wie Krebs und Pandemien keine essentiellen Probleme der Menschheit, die unser Leben auf der Erde bedrohen.

Darüber hinaus können Maschinen, wenn richtig trainiert, neutrale Entscheidungen treffen, die wir Menschen nicht treffen, auf denen wir uns aber vielleicht einigen können.

@Jaromir Konecny zu Energieproblemen, Krankheiten, Epidemien

– CO2 neutrale Energie wird von AKWs schon seit Jahrzehnten produziert. AKWs werden einfach als zu gefährlich eingeschätzt. Zu Unrecht etwa was den radioaktiven Abfall angeht, denn aller je in der Menschheitsgeschichte erzeugte hochradioaktive Abfall macht gerade einmal 400‘000 Tonnen aus, also 100‘000 Mal weniger als die Menschheit in einem einzigen Jahr CO2 erzeugt. Mit andern Worten: das Energieproblem ist vor allem ein psychologisches Problem und damit ein nicht-technisches Problem.

– Gefährliche Krankheiten gibt es auch ohne Alphafold heute viel weniger als vor 100 Jahren. Neue Therapien sind sicher gut für Betroffene. Für die Menschheit aber eher ein Luxus als eine Notwendigkeit

– Impfungen sind schon uralt und Corona wäre auch ohne Impfung keine Katastrophe gewesen wenn man es mit früheren Epidemien vergleicht.

Fazit: Natürlich kann die Technik das Leben verbessern. Aber keine Technologie der letzten 40 Jahre war oder ist für das Überleben der Menschheit essentiell und unverzichtbar.

Martin Holzherr: “CO2 neutrale Energie wird von AKWs schon seit Jahrzehnten produziert. AKWs werden einfach als zu gefährlich eingeschätzt. Zu Unrecht etwa was den radioaktiven Abfall angeht, denn aller je in der Menschheitsgeschichte erzeugte hochradioaktive Abfall macht gerade einmal 400‘000 Tonnen aus, also 100‘000 Mal weniger als die Menschheit in einem einzigen Jahr CO2 erzeugt. Mit andern Worten: das Energieproblem ist vor allem ein psychologisches Problem und damit ein nicht-technisches Problem.”

Und wie willst Du das “psychologische Problem” lösen? Wenn die meisten Deutschen keine AKWs haben wollen, dann muss man nun mal mithilfe von Wissenschaft und Technik neue Energiequellen finden. Anders geht’s nicht.

Martin Holzherr: “Gefährliche Krankheiten gibt es auch ohne Alphafold heute viel weniger als vor 100 Jahren. Neue Therapien sind sicher gut für Betroffene. Für die Menschheit aber eher ein Luxus als eine Notwendigkeit”

Ich weiß nicht, was Du damit sagen willst: Alle Krankheiten wurden bis jetzt durch neue Therapien, Medikamente und Impfstoffe bekämpft.

Zitat: „Alle Krankheiten wurden bis jetzt durch neue Therapien, Medikamente und Impfstoffe bekämpft.„

Genau. Und das lange bevor es Künstliche Intelligenz gab. Um KI geht es ja hier.

Die häufigsten früheren Krankheiten und Gesundheitsprobleme sind heute medizinisch beherrschbar. Und zwar durch Medizin des frühen 20. Jahrhunderts und nicht durch KI-Medizin.

Beispiele:

– Hygiene und Geburtshilfe hat den frühen Kindstod in den Promillebereich verschoben (im 19. Jahrhundert starben teils bis zu 30% aller Kinder sehr früh)

– Infektionskrankheiten haben durch Antibiotika und Impfungen ihren Schrecken verloren. Kaum jemand leidet/stirbt noch an Syphilis wie Friedrich Nietzsche

– Chirurgie an Darm, Galle und Hüftgelenk (häufigste Eingriffe) und weiteren Organen geschah im Jahr 2017 bei 7 Millionen Deutschen, also fast 10% der Deutschen und das durch chirurgische Verfahren, die es vor KI schon gab.

– Für häufige chronische Leiden wie Bluthochdruck, Diabetes, etc gibt es Medikamente bereits seit dem frühen 20. Jahrhundert

KI lässt sich natürlich auch in der Medizin einsetzen. Aber ihr Einfluss auf die Gesamtgesundheit ist bis jetzt begrenzt.

Martin Holzherr: “Impfungen sind schon uralt und Corona wäre auch ohne Impfung keine Katastrophe gewesen wenn man es mit früheren Epidemien vergleicht.”

Das klingt schon ein bisschen nach Corona-Leugnung. 🙂 Nur zur etwas Aufklärung: SARS-Cov-2 ist kein mit Influenza vergleichbarer Virus, weil Menschen vor zwei Jahren keine Immunisierung gegen den Virus hatten.

Was soll ich darauf aber antworten? Ich meine, die Weltwirtschaft musste wegen der Pandemie heruntergefahren werden. Das soziale Miteinander kam zum Stilstand. Staaten haben Abermilliarden an Finanzhilfen auszahlen müssen. Putin entrückte durch seine Corona-Isolation so weit der Realität, dass er einen Krieg in Europa anfing. Und und und … und Du sagst, “Corona wäre auch ohne Impfung keine Katastrophe”?

@Jaromir Konecny (Zitat):“Ich meine, die Weltwirtschaft musste wegen der Pandemie heruntergefahren werden. Das soziale Miteinander kam zum Stilstand. Staaten haben Abermilliarden an Finanzhilfen auszahlen müssen.“

Genau. Damit – mit dem Herunterfahren etc. – wurden Millionen von Menschen vor Krankheit und eventuell Tod gerettet. Doch diese Massnahmen haben auch vielen Millionen Menschen extrem geschadet (bis zu mehr psychiatrischen Fällen, mehr Suiziden etc).

Es ist/war eine Güterabwägung, die dazu führte, dass die Pandemie weltweit bekämpft wurde. In dieser Güterabwägung wurde Verhinderung von physischer Erkrankung und Tod als höherer Wert eingeschätzt als die Weiterführung des normalen Lebens. Doch das normale Leben kann für sehr viele, vor allem für Jugendliche, sehr wichtig sein.

Hätte man die Pandemie allerdings einfach laufen lassen, wäre sie viel früher vorbei gewesen. In China ist sie ja jetzt immer noch nicht vorbei.

Mir scheint die Corona-Epidemie kann durchaus mit der Hongkong-Grippe von 1968 verglichen werden („ Übersterblichkeit von rund 40.000 Toten[6] für die Bundesrepublik zwischen September 1968 und April 1970“).

1968 ist heute aber nicht mehr wegen der Hongkong-Grippe ein Begriff, sondern wegen Studentenprotesten und freier Liebe oder auch wegen der Niederschlagung des Prager Frühlings.

Martin Holzherr: “Natürlich kann die Technik das Leben verbessern. Aber keine Technologie der letzten 40 Jahre war oder ist für das Überleben der Menschheit essentiell und unverzichtbar.”

Ja, klar, auch ohne PCR hätten Milliarden von Menschen diverse Krankheiten überlebt. Nicht alle, aber einige schon. Und und und.

Hier ein hübscher Artikel nur über Impfungen und Impfstoffe und unten ein Zitat daraus. Selbstverständlich können wir hier weiter um Jahre diskutieren, 40, 50, 60, 70, 80 … am Ende aber doch nicht, denn auch Impfungen, die vor 40 Jahren entwickelt wurden, weiter entwickelt und angepasst werden. Nur die mRNA-Corona-Impfung hat Millionen Menschenleben gerettet und bei weiteren Millionen, vielleicht Milliarden, Covid-19-Spätfolgen verhindert. Die wurde erst vor 2 Jahren so weit entwickelt, dass sie auch eingesetzt werden konnte.

Bitte! Hören wir doch auf mit dieser Wortklauberei. Sollen wir hier tatsächlich rumstreiten, was ein Untergang ist, was eine Katastrophe ist usw.? Wahrscheinlich würden sogar ein paar Menschen den Welt-Atomkrieg überleben. Ist deswegen KEIN Atomkrieg nicht wichtig für das Überleben der Menschheit? Darum geht’s doch gar nicht! Es geht darum, dass über 8 Milliarden Menschen ohne Wissenschaft und Technologien auf dieser Erde nicht leben können. Was wäre, wenn plötzlich alle Technik und Wissenschaft verschwinden würde, und wir hier zu 8 Milliarden und jeder mit einem Faustkeil in der Hand stehen würden, kannst Du Dir sicher ausmalen.

“Durch Impfungen konnte in den vergangenen 30 Jahren die Kindersterblichkeit halbiert und die Lebenserwartung kontinuierlich erhöht werden. So lag das Durchschnittsalter Ende des 19. Jahrhunderts, als es noch keine durchgängigen Impfungen – und übrigens auch keine Antibiotikaforschung – gab, hierzulande bei vierzig Jahren. Pocken, Poliomyelitis, Tetanus, Diphtherie und Masern – sie wurden im vorigen Jahrhundert als die fünf gefährlichsten Krankheiten bezeichnet – sind heute in unseren Breiten nahezu ausgerottet. „Ohne Vakzine und entsprechende Medikamente würden wir wahrscheinlich von Viren und Bakterien überrannt werden“, schätzt Angetter. Dass unser Immunsystem mittlerweile mit den meisten Viren relativ gut umgehen kann, ist jedenfalls den Impfungen geschuldet, so die ÖAW-Forscherin.”

@Jaromir Konecny (Zitat): “Sollen wir hier tatsächlich rumstreiten, was ein Untergang ist, was eine Katastrophe ist usw.? Wahrscheinlich würden sogar ein paar Menschen den Welt-Atomkrieg überleben. Ist deswegen KEIN Atomkrieg nicht wichtig für das Überleben der Menschheit?“

Thema ist doch hier „Künstliche Intelligenz“. Mir konnte noch niemand überzeugend aufzeigen wie künstliche Intelligenz einen Atomkrieg verhindern könnte.

Allerdings habe ich einige Science Fiction Filme gesehen in denen Künstliche Intelligenz die Menschheit entmachtete, weil sie etwa zum Schluss kam, die Welt dürfe man nicht länger den Menschen anvertrauen.

Es geht doch darum, dass KI-Programme uns GENERELL und in allen Bereichen helfen könnten, neutrale Entscheidungen zu treffen, Entscheidungen, an denen wir uns alle einigen können. Auch in der Politik – und eine falsche und nicht neutral gemachte Politik führt nun mal zu falschen Entscheidungen, die zu einem Atomkrieg führen können. Klar geht das erst dann, wenn wir einsehen, dass Menschen keine neutralen Entscheidungen treffen – weil sie eben vor allem subjektive Entscheidungen für das eigene Wohl und das Wohl der eigenen Gruppe treffen. Aber auch das habe ich schon einige Male gesagt.

Es ging hier nicht nur um einen Atomkrieg, es ging generell um komplexe Probleme, die wir selbst nicht erfassen und lösen können, weil sie von Abertausenden Merkmalen abhängen, die der Mensch nun mal nicht alle erfassen kann.

Jetzt sage ich noch dazu, damit wir da wieder nicht um Wörter streiten: Selbstverständlich müssen alle maschinellen Entscheidungen von Menschen und anderen Programmen und Modellen exzessiv kontrolliert und getestet werden.

Ich werde diese Diskussion nicht mehr weiter führen. Mich erinnert sie etwas an Karl Poppers: “Der größte Skandal der Philosophie ist, dass während die Welt um uns herum zugrunde geht, die Philosophen immer noch streiten, ob sie real sei.”

@Holzherr 26.11. 14:20

„Weder KI noch eine andere Technik kann die Menschheit retten. Ja, die Menschheit muss nicht einmal – wie soft behauptet -, gerettet werden.“

Vernichtende Szenarien gibt es schon. Aber vermutlich werden die nicht unbedingt Wirklichkeit. Es geht aber auch darum, wie gut oder auch gar nicht gut wir, bzw. der eine oder der andere Leben kann. Und es geht auch darum, was von der Natur übrigbleibt.

In diesem Sinne bin ich mit 59 deutlich entspannter als mit 29 oder mit 19. Immerhin hab ich den Großteil meines Lebens schon gelebt, und Katastrophen wie den Klimawandel werde ich am eigenen Leib nur noch am Rande miterleben müssen.

Mich selbst zu verstehen, ein vernünftiges Leben zu leben, in dem ich nicht Teil des Problems, sondern Teil der Lösung sein kann, und eigene Gedanken zu fassen und zu diskutieren bleibt mir aber doch. Überhaupt hat die Arbeit an Erkenntnis eine Dimension für sich, die sich auch von Katastrophen wenig aufhalten lässt.

So ist denn der Mensch auch dazu verurteilt, sich immer weiter in die Zusammenhänge des Lebens vorzuarbeiten, um dann dieses wiederum nicht mehr ignorieren zu können. Und dann auch nicht mehr drum herum kommen kann, die logischen Konsequenzen daraus zu ziehen. Spätestens jede neue Generation muss das einfach tun. Das ist in uns einfach so eingebaut.

Dissenz gibt es dann oft zwischen den Generationen. Während es den Einen alles zu weit geht, geht es den anderen bei weitem nicht schnell genug. Das Ergebnis ist dann meistens genau das Gewurschtel, das die ganze Zeit zu beobachten ist.

So ist es! Für mich bedeutet “der Untergang” auch eine massive Veränderung der Lebensverhältnisse auf der ganzen Welt. Und den Anfang davon beobachten wir schon jetzt: Klimakatastrophen aufgrund des Klimawandels, aber auch politisch und gesellschaftlich, wenn man z. B. den Krieg in Europa und dessen Auswirkungen beobachtet. Trump, die Radikalisierung der Republikaner in den USA und die massive Vernetzung der Verschwörungstheoretiker und Pseudowissenschaften sollte man auch nicht vergessen. Ich kann mir auch vorstellen, dass Putin seinen Krieg nicht angefangen hätte, wenn ihn die zwei Jahre Isolation während der Pandemie nicht vollkommen der Realität entfernt hätten. Wenn wir wiederum über Corona am Anfang der Pandemie so gut Bescheid wüssten wie jetzt, Impfstoffe und Medikamente dagegen hätten, hätte die Pandemie bei weitem nicht die negativen wirtschaftlichen, politischen und gesellschaftlichen Auswirkungen, die sie jetzt hat. Vielleicht hätte sie gar nicht stattgefunden. Dieses Wissen über SARS-Cov-2 verdanken wir aber eben der Wissenschaft und neuen Technologien.

Ich bin 66 :-), habe jedoch zwei Kinder und würde ihnen gern mindestens so viel Zeit hier auf Erden ermöglichen, voller Liebe, Kunst, Wissenschaft und Abenteuer, die ich selbst haben durfte.

@Jaromir 26.11. 15:59

„Oder sind die drei oben genannten Probleme, Energie, tödliche Krankheiten wie Krebs und Pandemien keine essentiellen Probleme der Menschheit, die unser Leben auf der Erde bedrohen.“

Ich hab nichts dagegen, wenn Kernfusion der Energiewende zur Hilfe kommt. Aber derweil ich noch nicht damit rechne, dass dies kostengünstig zur Verfügung steht wäre ich dann z.B. auch für einen weitgehenden Verzicht von Privatautos. Als nichttechnische Lösung, einfach mal den Konsum zumindest solange zu reduzieren, bis die Energiewende fertig wird.

Und auch bin ich mit der derzeitigen medizinischen Möglichkeiten recht zufrieden, was mich fast mehr stört, das sind die hohen Kosten für die Krankenversicherung.

Und Pandemien gehören nunmal eigentlich zum Leben dazu. Ich hab nichts dagegen, wenn man hier Lösungen findet. Aber wenn das nicht geht, dann ist das eben so.

Auch Gentechnik im Bioanbau fände ich gut, wenn das weit mehr Erträge gibt, oder besser noch Bakterienkulturen, die unabhängig von der ineffektiven Photosynthese mit grünem Wasserstoff gefüttert werden. Aber solange wir das noch nicht haben, wäre ich dann auch für weniger wegwerfen und sparsamen Umgang mit tierischen Produkten.

Es ist ja nun öfter so, dass man nach technischen Lösungen sucht, und das dann hinterher doch nicht funktioniert. Das muss man finde ich einkalkulieren, und wenn möglich einen Plan B haben.

Ich habe seit 10 Jahren kein Auto. 🙂

Dass die Energiekrise unser Leben und Wohlstand jetzt massiv ändert, lesen wir jeden Tag in der Zeitung. Wir werden diese Krise ohne Technologie und Wissenschaft nicht lösen. Schon deswegen, weil der Rest der Menschheit auf das Auto nicht verzichtet so wie Du und ich. Aber auch wenn alle auf Privatautos verzichten würden, würde es wahrscheinlich nicht reicht, um unseren Energiebedarf in den nächsten hundert Jahren zu erfüllen.

Es können viel schlimmere Pandemien kommen, als die Corona-Pandemie. Und auch ihre Lockdowns hätten nicht sein müssen und somit die massiven Finanzhilfen für große Teile der Wirtschaft und Bevölkerung, wenn wir die Mittel dagegen hätten, die wir jetzt haben. Nur dank Wissenschaft und neuen Technologien – auch dank KI.

Klar können viele von uns sagen: Ich würde damit zurecht kommen. Doch Menschen, die heute verhungern oder in großer Armut leben, würden ihre Probleme nicht in den Griff bekommen, indem sie zu sparen anfangen.

Man kann sich doch nur die Graphiken der sozialen Entwicklung der Menschheit und der Entwicklung des Wohlstands angucken. Seit wann schießen ihre Kurven senkrecht nach oben? Seit dem Einreichung des Patents für die Dampfmaschine von James Watt und der folgenden maschinellen Revolutionen. Ohne Technologien und Wissenschaft würde nur ein kleiner Teil der Menschheit überleben. Wir sind doch über 8 Milliarden Menschen hier. Sparsamer Umgang und zurück zur Natur wird unsere Probleme nicht lösen.

Mir hat eine Lektorin mal gesagt: “Wir könnten Pilze züchten. Damit würden wir das Energieproblem lösen.” Ich habe sie nur angestarrt.

Kann es sein, dass wir im Deutschen z.T. einem falschen Freund aufsitzen?

Intelligenz im Deutschen ist (nur) Verstand, im Englischen aber auch Nachrichts- und Wissenbeschaffung: Open Source Intelligence (OSINT), Central Intelligence Agency (CIA), Business Intelligence (Geschäftsanalytik) etc.

@Omnivor: „Künstliche Intelligenz“ ist schon die richtige Übersetzung von Artificial Intelligence. Gemeint ist aber damit eher ein Ziel als eine schon existierende Realität.

Übrigens: Fast alle Menschen inklusive Forscher überschätzen was in einem oder zwei Jahrzehnten entwickelt werden kann. Die Forscher zur Zeit John McCarthy‘s glaubten etwa Objekterkennung in einer Fotographie sei etwas, was man in einem Sommersemester auf einem Computer realisieren können sollte und ein Computer werde in 10 Jahren schon Schachweltmeister sein.

Auch jetzt wieder werden die Leistungen der Deep Neural Networks von vielen massiv überschätzt. Das kommt davon, weil viele nur auf die erbrachten Leistungen schauen, nicht aber auf die Schwächen. Bis heute gibt es keine Maschine, die wirklich autonom agiert, ein kohärentes Weltbild besitzt und jeden Tag dazulernt. Das ist alles immer noch Gegenstand von Forschung.

Was genau in 10 oder 20 Jahren erreicht wird, lässt sich heute gar nicht sagen. Es gibt aber Hinweise darauf, dass Maschinen wohl noch besser darin werden, Menschen und ihre Leistungen zu imitieren. Schon Maschinenpuppen, die sich in vielen Situationen ähnlich verhalten wie Menschen wären ein grosser Fortschritt. Ein Roboter etwa, der alleingelassen in einer Antarktisstation durch den Winter kommt und alles am Laufen hält wäre bereits ein Riesenfortschritt. Solch eine Fortschritt ist aber heute in Reichweite.

Ja, das gilt tatsächlich: Kurzfristig werden die Auswirkungen von neuen Technologien überschätzt, langfristig werden neue Technologien unterschätzt.

Die kurzfristige Überschätzung hatten wir bei Künstlicher Intelligenz in den 1950ern als John McCarthy den Begriff “Artificial Intelligence” entwickelte und der Dartmouth-KI-Sommercamp stattfand und Frank Rosenblatt kurz darauf das Perceptron erfand und der New York Times enthusiastische Prognosen über künstliche Neuronen gab. Es hat dann 40 Jahre gedauert, bis erste “Deep Learning”-Modelle praktisch eingesetzt wurden – zuerst für die Erkennung von Postleitzahlen am Ende des 20. Jahrhunderts in den USA. Seit 2012 befinden wir uns in einem explosiven Wachstum von Deep Learning (DL), Du befindest Dich jedoch immer noch in seiner “langfristigen Unterschätzung”. 🙂

Seit 2015 können DL-Modelle besser Bilderkennung als der Mensch. Das führt zu einem massiven Einsatz von DL in der Medizin (bei bildgebenden Verfahren) aber auch in der Industrie und eigentlich in allen Branchen: Vorausschauende Wartung, Qualitätskontrolle, Kontrolle von Industrieanlagen, Waldbrand-Kontrolle, Meereskontrolle, Plastik-Lokalisierung in und an den Meeren, Überwachung, Kamera-Apps, Spektren- und Audiosignale-Auswertung, Robotik, Bilderkennung in den sozialen Netzwerken, Bilder-Google-Suche und und und.

Auch DL-Sprachmodelle können mittlerweile viele Sprachaufgaben besser lösen als der Mensch: Jeder von uns verwendet diese Modelle täglich: Übersetzungsprogramme, Empfehlungssysteme bei Amazon und Netflix, Textvervollständigung, Suchmaschinen wie Google, und und und …

Auch hohe Stufen des autonomen Fahrens und Fliegens mithilfe von Deep Learning funktioniert schon überall auf der Welt.

Gerade wird mit DL alles automatisiert, was automatisiert werden kann. Bekommst Du die Abertausenden Anwendungen von DL nicht mit? Hast Du noch nicht von Industrie 4.0 gehört.

Genau so ist es! In meinem Beitrag in diesem Blog “Wissenschaft wird spannend – auch KI sei Dank?” im Februar 2022 habe ich geschrieben:

Im Allgemeinen bezeichnet Künstliche Intelligenz alle Arten der maschinellen Nachahmung aller Aspekte des menschlichen Denkens und Verhaltens. Darüber hinaus kann Künstliche Intelligenz auch Informationsbeschaffung und -verarbeitung bedeuten. Wie der Wiener KI-Pionier Robert Trappl sagte: „Die Central Intelligence Agency heißt ja auch nicht so, weil die so gescheit sind“.

Im April 2022 erschien ein ganzer Artikel darüber: “Künstliche Intelligenz – ein Übersetzungsfehler?”

@Holzherr 26.11. 22:48