Mit Euclid auf den Spuren von Dunkler Materie und Dunkler Energie

BLOG: RELATIV EINFACH

Manchmal geht es dann ganz schnell. Das Euclid-Weltraumteleskop der ESA begleitet mich in der Öffentlichkeitsarbeit für das Max-Planck-Institut für Astronomie jetzt schon einige Jahre. Und der Starttermin war eines von jenen Daten, die eigentlich immer irgendwo in der Zukunft sind – wenn auch nicht ganz so schlimm in punkto Verschiebungen wie beim JWST. Und dann ging es plötzlich doch überraschend schnell, mit dem Umstieg von einem Start auf einer russischen Rakete auf SpaceX, und jetzt ist tatsächlich der Tag da, wo Euclid starten soll.

Eine große Durchmusterung

In der Astronomie gibt es grob gesprochen zwei Arten von Teleskopen. Die einen, wie das Hubble-Weltraumteleskop und das JWST sind vor allem dafür gedacht, einzelne Objekte sehr genau zu untersuchen. Die andere Sorte Teleskop ist für bestimmte Arten von Durchmusterung optimiert, also dafür, für eine große Zahl von Objekten einer bestimmten Klasse bestimmte Daten zu erfassen. Die Teleskope des SDSS-Survey sind solche Teleskope, oder das VISTA-Teleskop der ESA, oder das gerade im Bau befindliche Rubin-Observatory – und im Weltraum dann eben hoffentlich bald Euclid. Hier ist ein kleiner Einstieg von meinen Öffentlichkeitsarbeits-Kollegen am Max-Planck-Institut für Astronomie (MPIA), allerdings auf Englisch:

Das Ziel der Euclid-Durchmusterung sind dabei ferne Galaxien. Euclid erstellt dabei zum einen Farbbilder, auf denen jene Galaxien zu sehen sind – nicht nur im sichtbaren Farbbereich, sondern auch im Nahinfraroten. Aus diesen Farbbildern wird die Form von mehr als einer Milliarde Galaxien bestimmt: Wie rundlich erscheinen sie auf dem Bild bzw. wie länglich? Für einige Dutzend Millionen Galaxie bestimmt ein an Bord befindlicher Spektrograf außerdem mit großer Genauigkeit deren Rotverschiebung – wieweit das Licht jener Galaxien hin zu längeren Wellenlängen verschoben ist, im Vergleich mit derselben Art von Licht, die wir hier im Labor erzeugen können. Die entferntesten Galaxien, die dabei berücksichtigt werden, sind soweit entfernt, dass ihr Licht mehr als 10 Milliarden Jahre gebraucht hat, uns zu erreichen (z>2) – im Vergleich damit, dass unser Kosmos als Ganzes seit der Urknallphase ja nur knapp 14 Milliarden Jahre alt ist, ist das schon ein beträchtliches Teilvolumen des gesamten beobachtbaren Universums.

Schwacher Gravitationslinseneffekt

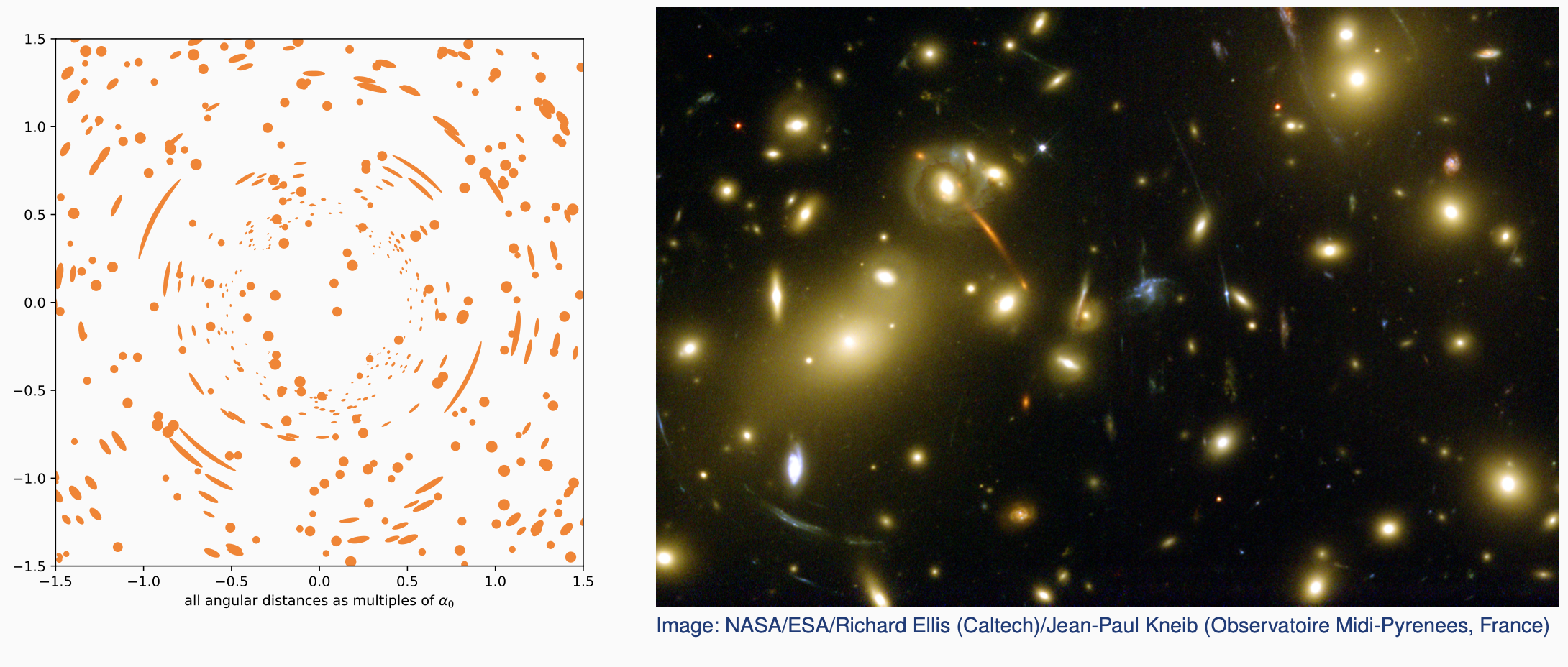

Und warum das ganze? Fangen wir mit den Formen an. Massen im Universum lenken das Licht, das an ihnen vorbeistreicht, ab. Das ist der sogenannte Gravitationslinseneffekt, im Detail vorausgesagt von Einsteins Allgemeiner Relativitätstheorie. Beim sogenannten starken Gravitationslinseneffekt sieht man die Lichtablenkung in Form von verzerrten Bildern ferner Himmelsobjekte, meist von Galaxien. Im Extremfall sind das regelrechte Kreisbogenabschnitte, wie bei diesem Galaxienhaufen hier rechts:

Im linken Bild habe ich das mal simuliert – kreisförmige Galaxien in den Hintergrundgesetzt und dann eine einzelne Masse als Gravitationslinse davor. In der idealisierten Darstellung sind die Kreisbogenabschnitte, sämtlich konzentrisch um die in der Mitte befindliche Masse, dann natürlich noch besser zu sehen.

Im linken Bild habe ich das mal simuliert – kreisförmige Galaxien in den Hintergrundgesetzt und dann eine einzelne Masse als Gravitationslinse davor. In der idealisierten Darstellung sind die Kreisbogenabschnitte, sämtlich konzentrisch um die in der Mitte befindliche Masse, dann natürlich noch besser zu sehen.

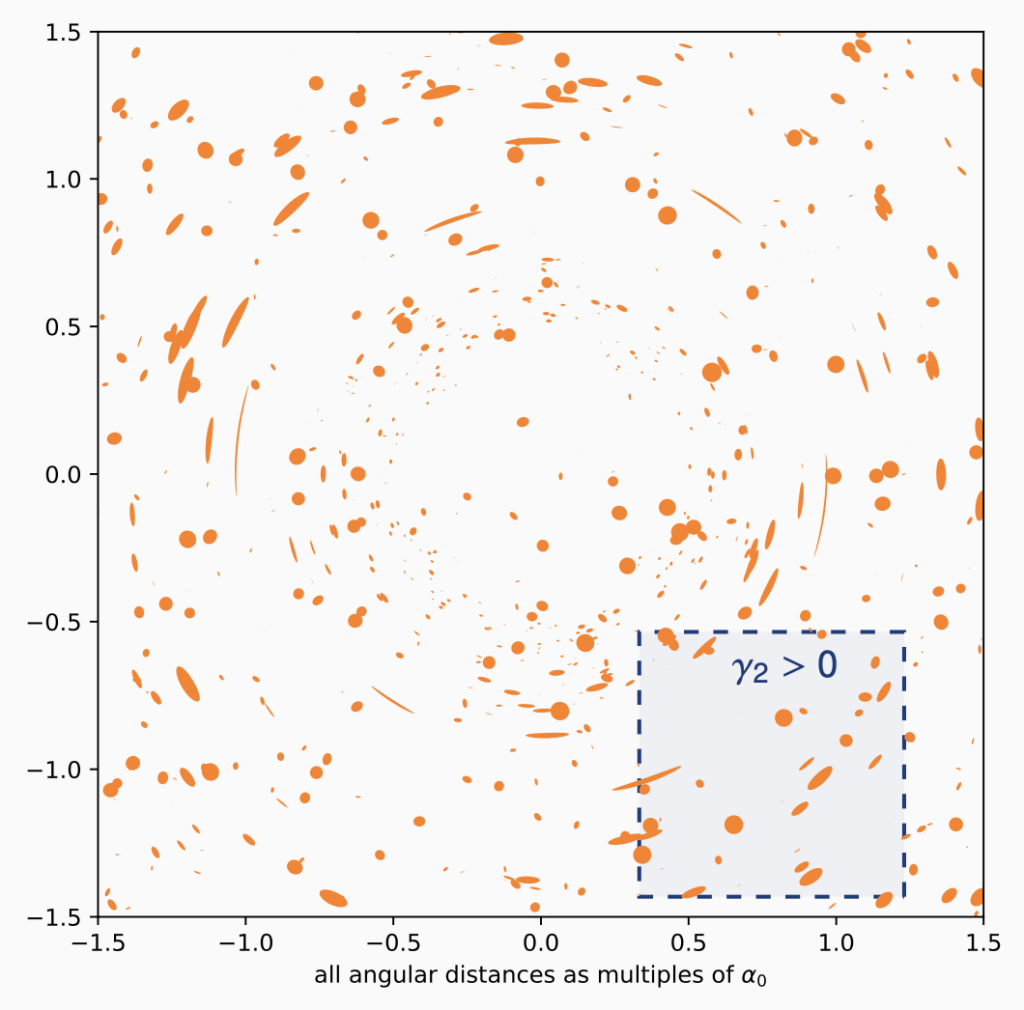

Aber was, wenn die Verzerrungen nicht so deutlich sind? Betrachten wir dazu das folgende, einmal mehr simulierte Bild: Was, wenn wir nur den Ausschnitt unten rechts beobachten könnten – könnten wir dann noch den Gravitationslinseneffekt nachweisen? Für die charakteristischen Kreisbogenausschnitte wird es schwierig, wenn der Gravitationslinseneffekt nicht besonders ausgeprägt ist. Bei einigen der individuellen Galaxien in jenem Ausschnitt ist nicht klar: Sind das jetzt einfach etwas ellipsenförmige, längliche Galaxien – z.B. Scheiben, die wir etwas von der Seite sehen, oder direkt elliptische Galaxien? Solche Galaxien gibt es ja in der Tat. Oder ist die Länglichkeit auf einen Gravitationslinseneffekt zurückzuführen? Das lässt sich im Einzelfall nicht unterscheiden, aber mit Hilfe von Statistik. In dem obigen Bild ist ja sehr deutlich zu sehen: Die Verzerrungen sind Teil eines Musters, und die Verlänglichung durch Gravitationslinsen verläuft in dem gezeigten Ausschnitt systematisch diagonal von links unten nach rechts oben. Eine statistische Analyse der Galaxienformen in jenem Ausschnitt würde das zeigen. Bei den natürlichen Galaxienformen ist die Ausrichtung nämlich zufällig; ob wir eine elliptische Galaxie in jenem Ausschnitt diagonal oder z.B. waagerecht ausgerichtet sehen, hängt vom Zufall ab. Die Gravitationslinsen-Verzerrung dagegen verläuft innerhalb eines solchen kleinen Himmelsausschnitts in eine bevorzugte Richtung. Das kann man statistisch nachweisen, und überall dort, wo erst solch eine statistische Analyse den Nachweis eines Gravitationslinseneffekts erbringt, nennen wir das schwachen Gravitationslinseneffekt (“weak lensing”).

Was, wenn wir nur den Ausschnitt unten rechts beobachten könnten – könnten wir dann noch den Gravitationslinseneffekt nachweisen? Für die charakteristischen Kreisbogenausschnitte wird es schwierig, wenn der Gravitationslinseneffekt nicht besonders ausgeprägt ist. Bei einigen der individuellen Galaxien in jenem Ausschnitt ist nicht klar: Sind das jetzt einfach etwas ellipsenförmige, längliche Galaxien – z.B. Scheiben, die wir etwas von der Seite sehen, oder direkt elliptische Galaxien? Solche Galaxien gibt es ja in der Tat. Oder ist die Länglichkeit auf einen Gravitationslinseneffekt zurückzuführen? Das lässt sich im Einzelfall nicht unterscheiden, aber mit Hilfe von Statistik. In dem obigen Bild ist ja sehr deutlich zu sehen: Die Verzerrungen sind Teil eines Musters, und die Verlänglichung durch Gravitationslinsen verläuft in dem gezeigten Ausschnitt systematisch diagonal von links unten nach rechts oben. Eine statistische Analyse der Galaxienformen in jenem Ausschnitt würde das zeigen. Bei den natürlichen Galaxienformen ist die Ausrichtung nämlich zufällig; ob wir eine elliptische Galaxie in jenem Ausschnitt diagonal oder z.B. waagerecht ausgerichtet sehen, hängt vom Zufall ab. Die Gravitationslinsen-Verzerrung dagegen verläuft innerhalb eines solchen kleinen Himmelsausschnitts in eine bevorzugte Richtung. Das kann man statistisch nachweisen, und überall dort, wo erst solch eine statistische Analyse den Nachweis eines Gravitationslinseneffekts erbringt, nennen wir das schwachen Gravitationslinseneffekt (“weak lensing”).

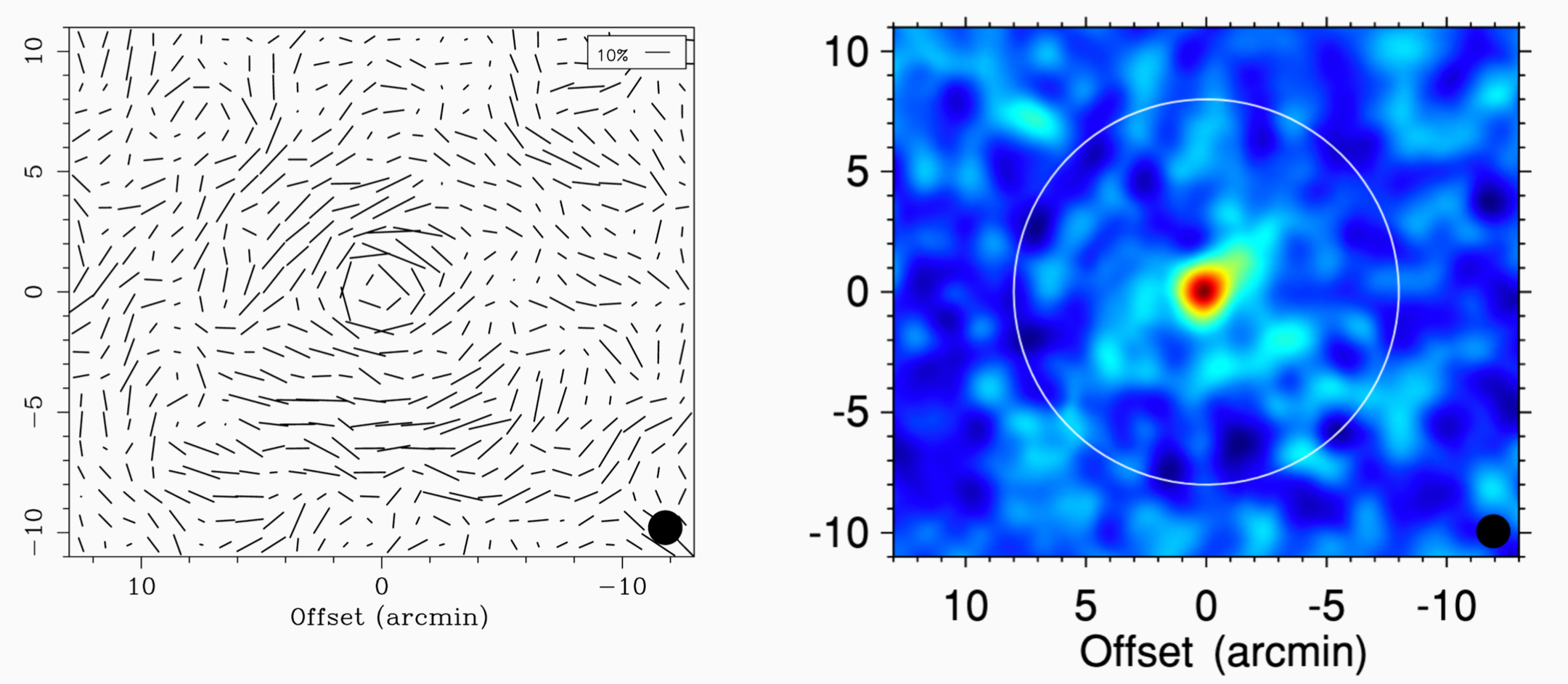

Damit kann man beispielsweise, wie in dem folgenden Bild, die Massenverteilung innerhalb eines Galaxienhaufens rekonstruieren. Links die statistisch ermittelten Vorzugsrichtungen der Formverzerrung in jedem kleinen Bereich, rechts die Konstruktion der Massenverteilung, die jene Art von Verzerrungsmuster erzeugt, aus einer Arbeit von Keiichi Umetsu et al. 2010:

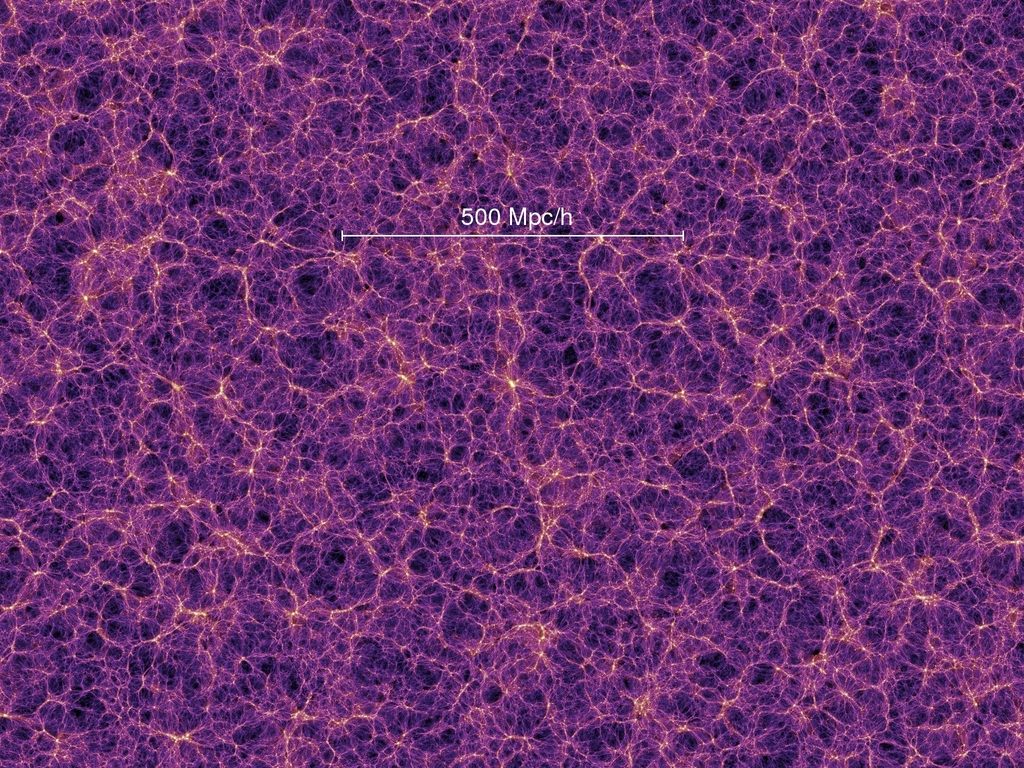

Das kosmische Netzwerk

Diese Art von Rekonstruktion kann man auch auf ganz großen Größenskalen im Kosmos vornehmen. Auf großen Größenskalen sind die Galaxien eben nicht gleichmäßig verteilt, sondern bilden Filamente mit Leerräumen dazwischen; die größten Galaxienhaufen sind dort, wo Filamente sich in Knoten schneiden. Das wissen wir unter anderem aus aufwändigen Simulationen die zeigen, wie sich die Materie im Universum seit der sehr homogenen Urknallphase immer mehr verklumpt hat. Hier ein Ausschnitt aus der Millennium-Simulation von Volker Springel und Kollegen:

Der Skalen-Balken “500 Mpc/h” hat dabei eine Länge von rund 2,3 Milliarden Lichtjahren. Was dort dargestellt ist, ist zunächst einmal die Verteilung der dunklen Materie im Kosmos, die knapp fünfmal mehr zur Gesamtmasse beiträgt als die herkömmliche atomare Materie – also jene Materie, aus der Galaxien, Sterne, Planeten und wir bestehen, und die mit Licht bzw. elektromagnetischer Strahlung wechselwirkt. Im kosmischen Netzwerk der Massenverteilungen bestimmt die dunkle Materie unseres Wissens nach, wo es langgeht – und die Galaxien sind dann sozusagen die “i-Tüpfelchen”, die Regionen besonders hoher dunkle-Materie-Dichte markieren.

Verklumpungsgrad, Homogenität und Inhomogenität

Der “Verklumpungsgrad” hängt dabei von der Größenskala bzw. von der Massenskala ab. Wer Inhomogenität misst, muss immer dazu sagen auf welchen Größenskalen. Vereinfacht kann man das einfach in zwei Dimensionen sehen. Stellen Sie sich ein unendlich (oder zumindest sehr groß) ausgedehntes Schachbrett vor, weit größer als die handelsüblichen Modelle. Nehmen Sie eine “Helligkeitsmessung” vor, indem Sie in einem gegebenen Ausschnitt des Schachbretts die Gesamtfläche aller weißen Flächen messen. Ist ihr Ausschnitt kleiner als ein einziges Feld des Schachbretts, sind die Ergebnisse sehr inhomogen – wenn Ihr Ausschnitt zufällig ein einziges schwarzes Feld erfasst, ist das Ergebnis Null, erfasst Ihr Ausschnitt dagegen zufällig ein weißes Feld, ist der Flächenwert gleich ihrer gesamten Ausschnittfläche. Auf solch kleinen Größenskalen ist das Schachbrett inhomogen.

Für größere Ausschnitte ist das anders. Ist ihr Ausschnitt so groß gewählt, dass er hunderte von Schachfeldern erfasst, dann werden immer ungefähr gleich viele weiße und schwarze Felder in ihrem Ausschnitt liegen. Der Wert für die Gesamt-Weißfläche im Ausschnitt wird, mit kleineren Abweichungen, immer ungefähr derselbe sein. Auf solch großen Größenskalen ist das Super-Schachbrett also einigermaßen homogen, hat im Mittel also jeweils dieselben Eigenschaften.

Ganz analog dafür gilt auch für das Universum: Wenn wir z.B. die Gesamtmasse in einem Teilausschnitt bestimmter Größe erfassen, hängt das Ergebnis von der Größe unseres Ausschnitts ab. Auf Längenskalen von hunderten Millionen Lichtjahren enthält ein Ausschnitt immer ungefähr gleich viel Masse, egal wo im Universum wir unsere Messung vornehmen. Auf kleineren Längenskalen ist die Inhomogenität größer – liegt unser Ausschnitt komplett in einem der Leerräume, dann kommen wir auf eine deutlich geringere Gesamtmasse als wenn unser Ausschnitt direkt einen der Knoten des Netzwerks umfasst. Misst man die Verteilung der Galaxien oder, wie im Falle des schwachen Gravitationslinseneffekts, direkt die Verteilung der Massen im Weltall, kann man quantitativ beschreiben, wie die Inhomogenität der Materieverteilung in unserem Universum von der Größenskala abhängt.

Man kann statt der Größenskala auch eine Massenskala nehmen: Wenn ich einen Raumbereich betrachte, der in unserem Universum im Mittel die Masse M enthält, wie groß sind die Schwankungen der tatsächlich gemessenen Massenwerte je nachdem wo im Kosmos ich den Ausschnitt platziere, dessen Masse ich bestimme?

Ein Nachhall des Schalls im frühen Universum

Es kommt noch besser. Während der Urknallphase, also während der ersten 380.000 Jahre kosmischer Geschichte, als unser Universum mit einem dichten, strahlungsdurchflutenden Plasma gefüllt war, konnten sich in diesem Plasma Schallwellen ausbreiten. Allerdings eben nur während jener 380.000 Jahre, denn danach entstanden die ersten Atome, das Universum wurde elektrisch neutral, und der Mechanismus, der geladene Teilchen und Strahlung aneinander gekoppelt und den für die Schallwellen nötigen Gegendruck ermöglicht hatte, konnte nicht mehr funktionieren.

Die Schallgeschwindigkeit in jenem Plasma lässt sich berechnen; sie ist in erster Näherung konstant und hängt in zweiter Näherung davon ab, wieviel reguläre (nicht-dunkle) Materie es damals im Vergleich zur Menge an Strahlung gab. Damit lässt sich auch berechne, wie weit sich die Schallwellen im damaligen Universum höchstens ausbreiten konnten.

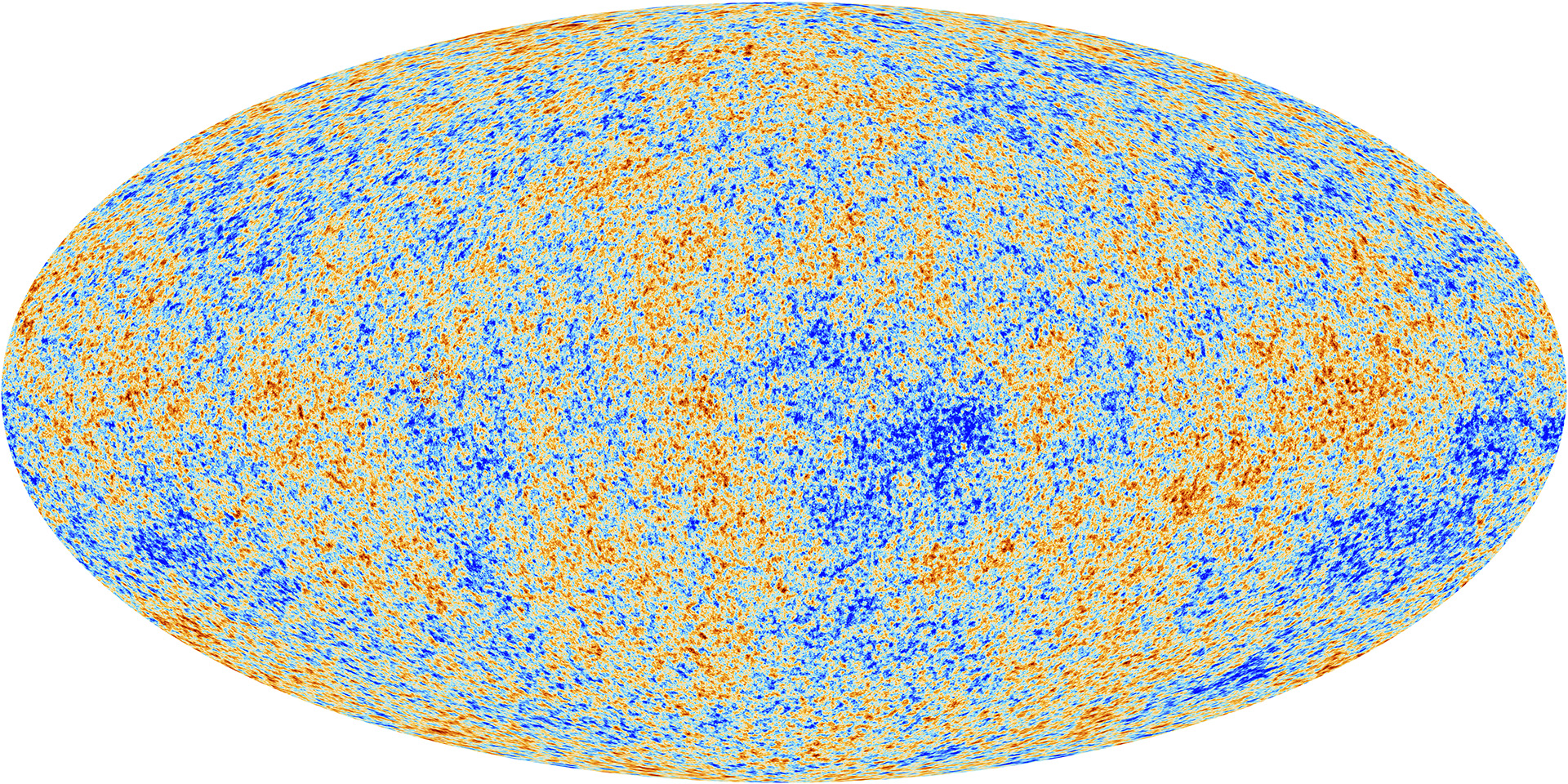

Man kann sich das ganze vereinfacht so vorstellen, als würde man eine Handvoll Steine auf ein Mal in einen stillen Teich werfen. Um jeden Einschlagsort eines Steins bildet sich eine Kreiswelle. Und wenn ich eine bestimmte Zeit warte, sind all jene Kreiswellen gleich groß. Analog war es mit den frühen Dichtestörungen im Universum (das sind sozusagen die auf das Wasser treffenden Steine) und mit den Schallwellen, die sich in den darauffolgenden 380.000 Jahren von jeder dieser Dichtestörungen aus im All ausgebreitet haben. Am Ende jener 380.000 Jahre hatten wir deswegen eine Kombination aus den ursprünglichen Dichtestörungen und aus kugelförmigen Dichtewellen, eben den Schallwellen, alle mit derselben Größe. Die Informationen über das entsprechende Muster an Dichtestörungen ist in der sogenannten kosmischen Hintergrundstrahlung enthalten, nämlich in der Wärmestrahlung, die eben gerade zu jener Zeit 380.000 Jahre kosmischer Zeit freigesetzt wurde und uns auch heute noch aus fernen Regionen des Weltalls erreicht. Das Muster ist bei der kosmischen Hintergrundstrahlung dann ein Muster nicht von Dichte- sondern Temperaturschwankungen, und sieht so aus (Bild: ESA und die Planck Collaboration):

In rötlichen Bereichen ist die Temperatur dabei um einige hunderttausendstel Grad wärmer, in bläulichen Bereichen in derselben Größenordnung kühler als die mittlere Temperatur.

Um solch ein chaotisches Muster zu analysieren, braucht man einiges an Mathematik; darauf will ich hier nicht eingehen, sondern nur die Aussage treffen: so eine Analyse ist möglich. Und das heißt: aus den Daten lässt sich erschließen, wie groß die damalige maximale Distanz ist, auf die sich Schallwellen im frühen Universum ausbreiten konnten. Eine bekannte Längenskala zu haben ist in der Kosmologie viel wert! Man kann insbesondere schauen, unter welchem Winkel uns jene Längenskala erscheint. Das liefert Informationen zum einen dazu, wie weit die beobachtete Längenskala von uns entfernt ist; da die scheinbare Größe aber aufgrund des Gravitationslinseneffekts auch dadurch beeinflusst wird, wieviel Masse bzw. Energie im Universum ist, geht auch dieser Parameter in das Ergebnis ein. Matthias Bartelmann hat vor einigen Jahren für Einstein Online eingängig beschrieben, wie das geht.

Der Clous ist: Aus genau diesen frühen Dichteschwankungen (ursprüngliche Schwankungen plus die Schallwellen) entsteht im Laufe der Milliarden von Jahren das kosmische Netzwerk! Denn klar: da, wo die Dichte schon etwas höher ist, wird auch mehr Materie hingezogen. Die Dichtestrukturen werden mit der Zeit also immer deutlicher ausgeprägt. Das heißt aber: Auch dem kosmischen Netzwerk ist die Größe der Schallwellen-Längenskala sozusagen aufgeprägt – und lässt sich durch eine statistische Analyse ermitteln. Diese aufgeprägten Überreste der Schallwellen im frühen Universum heißen “baryonische akustische Oszillationen” (BAO). Allerdings wird jene Längenskala durch die kosmische Expansion natürlich im Laufe der Zeit weiter und weiter auseinandergezogen, und das heißt: Wenn wir die Längenskala über die kosmische Geschichte hinweg verfolgen, können wir direkt verfolgen, wie die kosmische Expansion abgelaufen ist!

Das über-die-kosmische-Geschichte-hinweg-verfolgen mag erst einmal ungewohnt klingen. Im Alltag ist Geschichte ja etwas, das wir nicht unmittelbar sehen können. In der Astronomie dagegen ist der Blick in die Vergangenheit unvermeidbar. Wir sehen ferne Objekte immer so wie sie zu jener Zeit waren, als sie das Licht, das unsere Teleskope jetzt erreicht, ausgesandt haben. Die Andromeda-Galaxie beispielsweise sehen wir immer so, wie sie vor 2,5 Millionen Jahren war, einfach weil ihr Licht jeweils 2,5 Millionen Jahre benötigt, um uns zu erreichen.

Unsere kosmologischen Modelle liefern einen direkten Zusammenhang zwischen der Lichtlaufzeit für das Licht einer fernen Galaxie und der Rotverschiebung, üblicherweise mit z bezeichnet, mit der uns jenes Licht erreicht. Wenn wir die Verteilung der Galaxien in einem bestimmten z-Bereich analysieren und die charakteristische Schallenwellenlänge bestimmen, haben wir damit einen ganz bestimmten Zeitraum der kosmischen Geschichte untersucht.

Kosmologische Parameter

Bei Euclid laufen jetzt alle diese Stränge zusammen. Euclid bestimmt die räumliche Verteilung von Galaxien in verschiedenen Rotverschiebungs-Bereichen, kann damit die Schallwellen-Maximallänge zu verschiedenen Zeitpunkten der kosmischen Geschichte bestimmen und auf diesem Wege die Expansionsgeschichte des Universums rekonstruieren. Jene Expansionsgeschichte hängt in den Modellen davon ab, wie groß die Energiedichte des Universums ist und um welche Art von Inhaltsstoff es sich dabei handelt. Hier kommt die sogenannte dunkle Energie ins Spiel – im wesentlichen ein Parameter, den die Kosmolog*innen in ihre Modelle einführen mussten um zu erklären, warum die Expansion unseres Kosmos nicht abbremst, sondern im Gegenteil beschleunigt verläuft. Euclid kann über seine Rekonstruktion der Expansionsgeschichte genau vermessen, was für Eigenschaften jene dunkle Energie hat – insbesondere auch: ob die Energiedichte jener dunklen Energie mit der Zeit konstant bleibt (das ist das einfachste derzeitige Modell, die sogenannte kosmologische Konstante) oder ob sie sich ändert.

Außerdem misst Euclid sowohl auf diesem Wege als auch über den schwachen Gravitationswelleneffekt, wieviel Materie (zunächst einmal: dunkle plus nicht-dunkle) Materie es in unserem Kosmos gibt, und wie inhomogen jene Materia auf den verschiedenen Größen- bzw. Massenskalen ist – sprich: wie verklumpt. Und auch dieses Muster enthält, wenn man Rotverschiebungen der entsprechenden Galaxien dazunimmt, Informationen über die dreidimensionale Struktur – und damit auch über die Expansionsgeschichte.

Das ist eine große Stärke von Euclid: da werden bestimmte Parameter unseres Kosmos auf unterschiedliche Arten und Weisen, nämlich einmal direkt über die räumliche Verteilung, zum anderen über den schwachen Gravitationslinseneffekt, bestimmt, aber anhand derselben Daten. Das ermöglicht es den Forscher*innen, die unvermeidbaren Messunsicherheiten jedes einzelnen der beiden Verfahren zumindest etwas auszugleichen – und die Messgenauigkeit entsprechend zu erhöhen.

Diese grundlegenden Messungen (und noch ein paar weitere, die ich hier nicht schildere) liefern direkt Informationen zu zwei Inhaltsstoffen unseres Universums, über die wir dringend mehr wissen möchten: dunkle Energie und dunkle Materie. Insofern ist es kein Wunder, dass der Euclid-Start jetzt von so gut wie allen Kosmolog*innen fieberhaft erwartet wird. (Und klar, die eigentlichen Ergebnisse werden dann noch einige Jahre auf sich warten lassen – die Mission ist auf eine Dauer von 7 Jahren ausgelegt.)

Aber ein Schritt nach dem anderen. Die ESA hat hier Informationen dazu zusammengestellt, wie man den Euclid-Launch heute um kurz nach 17 Uhr live mitansehen kann.

Hier ist der Livestream von SpaceX:

…und falls es heute nicht klappen sollte, gibt es morgen (Sonntag, 2. Juli) noch eine weitere Gelegenheit. Also: Daumen drücken für ein Projekt, was uns dann hoffentlich in ein paar Jahren schöne neue Daten zu den Eigenschaften unseres Universums als Ganzes liefert!

Hallo Herr Pössel,

danke für die Erläuterungen zu den erwarteten Ergebnissen der Euclid-Mission. Ich nutze die Gelegenheit mal zu einer technischen Frage bzgl. der thermischen Regelung.

Ich habe bei der ESA nur die Bemerkung einer passiven (vermutlich also die Reflektoren und thermische Isolation) und aktiven Kühlung gefunden. Da die Beobachtungen im optischen und Nahinfrarot-Bereich stattfinden, dürfte die Kühlung ein kleineres Problem darstellen, sie läßt sich wohl in einem geschlossenen System machen, d. h. die erwartete Lebensdauer wird nicht durch Freisetzung eines mitgeführten Kühlmittels begrenzt?

Oder anders ausgrdrückt wird die Missionsdauer zunächst mal nur durch die erwartete Funktionsdauer der einzelnen Komponenten bestimmt, wie es bei den meisten Raumfahrtprojekten üblich ist? Dann könnte man also auf eine Verlängerung hoffen.

Zusatzfrage: Beim Transit zum LP2 wird die Sonde vermutlich langsam und kontrolliert runtergekühlt, finden sonst noch Aktionen (abgesehen von Triebwerkszündungen zur Lage und Beschleunigung) statt?

Hallo Herr Kühn, das Design, das letztlich genommen wurde, sieht wohl in der Tat nur eine passive Kühlung vor: https://arxiv.org/abs/1610.05508

Die Missionsdauer wird soweit ich weiß durch den Treibstoff begrenzt, konkret durch den Stickstoff, mit dem die Mikro-Thruster betrieben werden – also diejenigen Elemente, die Euclid auf seine verschiedenen Beobachtungs-Ziel-Regionen ausrichten, siehe https://www.esa.int/Science_Exploration/Space_Science/Euclid/Euclid_fuelled_for_launch