Wie funktioniert die eigentlich, die Wissenschaft?

Spätestens seitdem Corona-Sars-Cov2 aus uns allen Hobby-VirologInnen gemacht hat, hört (oder liest) man vermehrt Sätze wie „Eine Studie hat letztens bewiesen, dass…“ oder „Das wurde wissenschaftlich bewiesen!“. Doch was bedeutet das eigentlich, wenn eine Studie irgendetwas „bewiesen“ hat?

von Nadine Herzog

Die zuerst nüchtern erscheinende Antwort lautet: Eine Studie beweist leider erst einmal gar nichts. Denn:

- eine Studie ist nie genug, um eine definitive Aussage über einen bestimmten Zusammenhang zu treffen und

- Studien beweisen generell nicht

Um diese Aussagen besser nachvollziehen zu können, ist es sinnvoll sich einmal etwas genauer mit dem generellen Ablauf der wissenschaftlichen Methode zu beschäftigen. Hier einmal der schrittweise Ablauf anhand des Beispiels essen und Übergewicht:

- Beobachtung: Menschen, die dick sind, essen viel bzw. mehr als Menschen, die dünn sind

- Formulierung einer Hypothese, also einer Vermutung: Viel essen führt zu Übergewicht.

- Systematische Überprüfung der Hypothese in einem Experiment: Eine Befragung von vielen Menschen zu ihrem Essverhalten und ihrem derzeitigen Gewicht.

- Statistische Auswertung der gesammelten Daten: Mathematische Berechnung des Zusammenhangs zw. der Menge des Essen und Gewichts – z.b. mittels einer Korrelation.

- Interpretation der Ergebnisse: Die Beobachtung hat sich formell bestätigt – Menschen, die viel essen, haben ein höheres Körpergewicht als Menschen, die weniger essen.

- Diskussion der Ergebnisse und der Interpretation: Gibt es noch andere Erklärungen für das was ich beobachtet habe? Wie passt das, was ich gefunden habe, mit dem zusammen was schon bekannt ist?

Wir sehen, das liest sich erst einmal wie ein einfaches Rezept, um wissenschaftliche Erkenntnisse zu erlangen, oder? Aber so simpel ist es leider nicht. Im Prinzip arbeitet jede/r WissenschaftlerIn zwar nach dieser Vorgehensweise, allerdings brauchen die meisten dieser Schritte noch viel mehr Details, um der wissenschaftlichen Methode gerecht zu werden. Schauen wir uns also einige der Schritte nochmal genauer an. Nach einer ersten Beobachtung (Schritt 1), folgen

Schritt 2 und 3: Ein Experiment entwerfen, um eine Hypothese zu testen

Ich habe also, basierend auf Schritt 1, eine Hypothese formuliert. Hierzu sei gesagt, dass man nicht einfach willkürlich irgendeine Hypothese aufstellen sollte/kann. Hypothesen müssen genau formuliert und objektiv messbar sein. Erfüllt die oben aufgestellte Hypothese „Viel essen führt zu Übergewicht“ diese Kriterien? Geht so. Was genau ist denn „viel“? Für die eine Person ist eine halbe Pizza vielleicht schon viel, während für die andere Person erst zwei Pizzen viel sind. Man könnte die Hypothese z.B. so umformulieren: „Eine höhere Menge an Kalorien pro Tag, führt zu Übergewicht“. Dies ist jedenfalls schon etwas genauer formuliert. Anschließend muss man ein adäquates Experiment entwerfen, um seine Hypothese zu testen.

Ich glaube, zusammen mit Schritt 4, könnte dies der schwierigste Schritt der wissenschaftlichen Methode sein. Denn um eine Hypothese adäquat testen zu können, muss man am besten so viele Dinge wie möglich, aber gleichzeitig auch nur so wenige Dinge wie nötig einfließen lassen. So viele Dinge wie möglich, soll meinen, dass man – neben seinen Haupt-Interessensfaktoren – auch noch versucht, andere Faktoren zu bedenken, die den zu erforschenden Zusammenhang ebenfalls beeinflussen könnten. In unserem Beispiel könnte dies sportliche Aktivität sein. Denn wer viel Sport macht, kann auch mehr essen ohne übergewichtig zu werden. Es wäre für unseren Test also wichtig, ebenfalls den Faktor “Sport“ zu messen, um diesen dann hinterher von dem Zusammenhang Essen und Übergewicht abziehen zu können. So wenige Dinge wie nötig, soll meinen, dass man aber auch nicht ALLE möglichen Einflussfaktoren in seinen Test mit aufnehmen kann, da dies zu einem statistischen Problem führen würde. Weil dann die Zusammenhänge untereinander so komplex werden, dass sie schwer auf die gesamte Bevölkerung generalisierbar wären, sprich mit hoher Wahrscheinlichkeit eigentlich nur für die befragte Gruppe gelten.

Am besten lassen wir also nur alle wirklich wichtigen Faktoren mit einfließen. Und welche Faktoren sind wirklich wichtig? Um dies herauszufinden muss man lesen, lesen, lesen. Man muss gut informiert sein, was andere Studien schon zu dem Thema (oder einem ähnlichen Thema) gefunden haben.

Als nächstes müssen wir uns überlegen wie wir all die Faktoren, die wir mit einfließen lassen wollen, messbar machen. Um beispielsweise „Kalorien pro Tag“ messbar zu machen, könnte man die Menschen fragen, wie viele Kalorien sie am Tag zu sich nehmen. Aber weiß denn wirklich jeder, wie viele Kalorien bestimmte Nahrungsmittel haben bzw. wie viele Kalorien er/sie pro Tag aufgenommen hat? Man müsste also vielleicht besser danach fragen, was und wieviel in den vergangenen sieben Tagen zum Frühstück, Mittag- und Abendessen gegessen wurde. Hieraus kann man dann einen Durchschnittskalorienwert errechnen, der für jede befragte Person vergleichbar ist. Genauso verhält es sich mit Übergewicht und Sport. Man muss genau bedenken, wie man diese Faktoren messen will und ob das Maß, für welches wir uns letztendlich entschieden haben, präzise und fehlerfrei genug ist.

Nun gut, ich habe mir also sehr viele Gedanken zu meinem Test gemacht und mich (meist zusammen mit KollegInnen) auf eine bestimmte Vorgehensweise festgelegt. Dennoch: man kann nie an alles denken bzw. niemals alle möglichen Einflussfaktoren in einen Test packen. Und dies führt uns auch direkt zum nächsten Schritt – die (teilweise) Lösung dieses Problems liegt nämlich in der Statistik.

Schritt 4 und 5: Auswertung und Interpretation meiner Daten

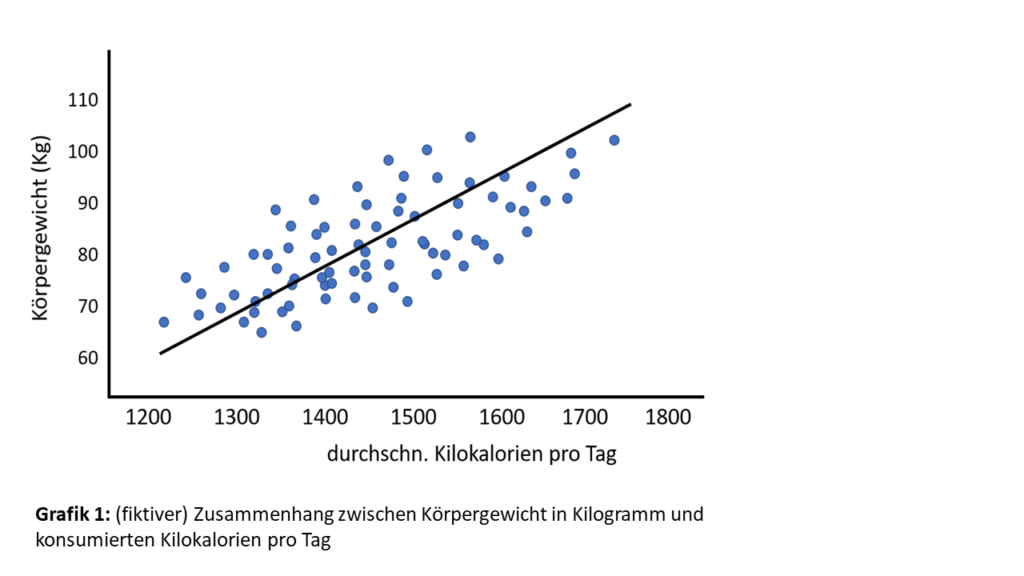

Warum braucht man zum Auswerten seiner Daten eigentlich Statistik? Man kann doch anhand einer grafischen Darstellung (Beispiel siehe Grafik 1) schon sehen, dass die Anzahl an konsumierten Kalorien positiv mit dem Körpergewicht zusammenhängt. Leider ist es auch hier (mal wieder) nicht so einfach. Denn, wie oben bereits gesagt, kann ein Experiment nie wirklich alle zu bedenkenden Faktoren abdecken und außerdem habe ich ja nur eine bestimmte Anzahl an Personen befragt und nicht die allgemeine Bevölkerung.

Es stellt sich also die Frage, inwiefern die Ergebnisse meiner Befragung Rückschlüsse auf den wahren Zusammenhang zwischen Essen und Übergewicht in der gesamten Population zulassen. Und hierfür braucht man Statistik.

Statistik arbeitet mit Wahrscheinlichkeiten. Die Frage, die Statistik beantwortet, ist „Wie hoch ist die Wahrscheinlichkeit, dass man sich irrt, anhand seiner studienbezogenen Ergebnisse Rückschlüsse auf die gesamte Population zu ziehen?“. Das heißt, man testet nie wirklich, ob man mit seiner Hypothese Recht hat, sondern wie groß die Wahrscheinlichkeit ist, dass man sich irrt (weil man eben nicht alles bedenken kann). In der Forschung wird hierzu ein bestimmter Grenzwert benutzt. Dieser Wert liegt bei fünf Prozent. Das bedeutet also, wenn meine Resultate mir zeigen, dass ich mich mit einer Wahrscheinlichkeit von weniger als diesen fünf Prozent irre, ist es wahrscheinlich, dass ich mich nicht irre. Ein solches Ergebnis nennt man dann signifikant. Eine hundertprozentige Sicherheit gibt es also nicht. Eine Studie kann daher auch niemals etwas beweisen.

Und nun? Wie kann es dann sein, dass sich Forscher trotzdem einig sind, dass eine hohe Menge an Kalorien zu Übergewicht führt? Hier komme ich wieder zu meiner Aussage, dass eine Studie nicht genug ist. Betrachten wir es einmal aus einer anderen Perspektive: Wenn ich ein und dieselbe Studie (gleiche Fragestellung, gleiches Experiment) zehnmal an verschiedenen Stichproben durchführe, und dabei achtmal zu demselben Ergebnis komme, dann addiert sich die Wahrscheinlichkeit, dass ich mich nicht irre mit jedem Mal. Ich kann mir also mit jeder Studie, die zu dem gleichen (oder ähnlichen) Ergebnis kommt, sicherer sein, dass ich mich nicht irre.

Schritt 6: Diskussion der Resultate

Nachdem ich nun weiß, wie hoch die Wahrscheinlichkeit ist, dass mein beobachteter Zusammenhang wahr ist, gilt es kritisch zu reflektieren, warum ich diesen Zusammenhang beobachtet habe. Wie oben schon gesagt, man kann niemals alles bedenken bzw. mit einfließen lassen. Man macht sich in diesem Schritt also darüber Gedanken, welche weiteren Faktoren zu einem Ergebnis geführt haben könnten.

In unserem Beispiel könnten unsere Ergebnisse beispielsweise durch das Erinnerungsvermögen der Befragten verzerrt worden sein. Wer weiß denn schon noch genau, was er/sie vor sieben Tagen zum Frühstück gegessen hat? Hierauf könnte man sich selber dann direkt die Antwort geben, dass man ja einen Durchschnittswert berechnet hat und sich dieser Fehler deswegen über die Stichprobe hinweg ausgleichen sollte. Oder es könnte sein, dass ein Experiment nicht so funktioniert hat, wie man sich das vorgestellt hat. Zum Beispiel haben bei der Befragung durch Zufall viel mehr Frauen als Männer mitgemacht. Es ist also schwer eine Aussage über den Zusammenhang zwischen Essen und Gewicht bei Männern zu treffen. Oder ich habe, als ich meine Hypothese messbar machen wollte, nicht daran gedacht, dass Menschen, die mehr wiegen auch einen höheren Bedarf an Kalorien haben. Das Maß „Kalorien pro Tag“ ist also im Vorhinein schon durch das Gewicht beeinflusst.

Ich hätte also vielleicht lieber ausrechnen sollen, wieviel die jeweilige Person durchschnittlich über dem – auf ihr Gewicht angepassten – Kalorienbedarf liegt. Und so gibt es in jedem Experiment bestimmte Schwachstellen, die es zu diskutieren gilt, damit andere Forscher darauf aufbauen und zukünftige Studien entsprechend verbessern können.

Zusätzlicher Schritt: Dokumentation und peer-review

Ich habe also eine interessante Fragestellung, ein tolles Experiment und spannende Resultate. Um das Ganze nun mit der Öffentlichkeit teilen zu können, muss ich natürlich erst einmal alles detailliert und nachvollziehbar aufschreiben. Das mache ich aber nicht nur für mich, sondern primär aus zwei Gründen:

- Nur so können KollegInnen meine Studie exakt wiederholen und herausfinden, ob sie zu demselben Ergebnis kommen.

- Nur so können meine Kollegen meine Vorgehensweise genau unter die Lupe nehmen und mir helfen, Dinge zu verbessern.

Diesen zweiten Prozess nennt man übrigens Peer-Review (zu deutsch: Begutachtung durch Kollegen). Denn vielleicht habe ich das falsche statistische Verfahren gewählt und meine Resultate sind deshalb nicht aussagekräftig. Oder ich kenne ein superneue „Up-to-date hot shit Studie“ noch nicht, die komplett das Gegenteil von dem zeigt, was ich gefunden habe. Dann müsste ich das wieder in meine Diskussion mit einfließen lassen. Und erst wenn sich zwei (oder manchmal sogar drei) KollegInnen einig sind, dass das, was ich da jetzt so stehen habe, Sinn ergibt und methodisch korrekt ist, wird meine Studie auch veröffentlicht.

Was folgt daraus? Ein Fazit

Tja, wie funktioniert denn nun Wissenschaft? Hier noch einmal die wichtigsten Punkte im Überblick:

- Studien beweisen nicht, sondern arbeiten mit Wahrscheinlichkeiten

- Wissenschaft lebt von der Summe der Erkenntnisse, nicht aber von einzelnen Studien

- Wissenschaft lebt von Kritik und ständiger Veränderung und Verbesserung

Ich denke, dass es besonders in Zeiten von Verschwörungstheorien und dem zunehmenden Zweifel an der Wissenschaft wichtig ist, dies zu verstehen. Denn auch, wenn das Wissenschaftliche Prinzip „nur“ mit Wahrscheinlichkeiten hantiert, so ist es doch “die beste Annährung an die Wahrheit, die wir haben.“ Es gibt da einen Spruch: „Lieber glaube ich Wissenschaftlern, die sich mal irren, als Irren, die glauben, sie wären Wissenschaftler.“

Interessanter Überblick.

Ich hadere allerdings damit, eine Beobachtung bzw. eine Befragung als ein Experiment zu bezeichnen. Machen zum Beispiel Astrophysiker, die das Weltall beobachten, Experimente mit den Sternen? Eher nicht.

Ich weiß nicht, ob ich den Zusammenhang zwischen der Anzahl der Faktoren und der Repräsentativität verstehe. Wie repräsentativ eine Studie ist, liegt doch vor allem an der Auswahl der Stichprobe. Wie wäre es damit: So wenige Faktoren wie möglich (um es nicht zu komplex werden zu lassen) und so viele wie nötig (um möglichst viel relevante Faktoren zu identifizieren).

Hallo und vielen Dank für das Feedback.

In der Tat ist das Wort ‘Experiment’ etwas irreführend, da es intuitiv erstmal eine Manipulation/Intervention suggeriert. Allerdings ist die Definition des Begriffs Experiment: “Ein Experiment[…], im Sinne der Wissenschaft, ist eine methodisch angelegte Untersuchung zur empirischen Gewinnung von Information (Daten)” (Wikipedia).

Nach meinem Verständnis, würde dies bedeuten, dass eine methodisch angelegte Untersuchung (die Untersuchung ob die Hypothese stimmt), auch anhand einer Befragung durchgeführt werden kann. Denn die Befragung erhebt ja bestimmte Typen von Daten, deren Zusammenhang mittels eines statistischen Tests getestet werden. Und dann wäre eine Beobachtung ein Experiment.

Zu dem Zusammenhang bzgl. Anzahl der Faktoren und Repräsentativität: Hier ist das Stichwort ‘overfitting’.

“there is a trade-off between model fit and generalizability (i.e. how well the model explains different data sets that were all generated from the same underlying process). As the number of free parameters is increased, model fit increases monotonically, whereas beyond a certain point, model generalizability decreases. The reason for this is ‘over-fitting’; an increasingly complex model will, at some point, start to fit noise that is specific to one dataset and thus become less generalizable across multiple realizations of the same underlying generative process”

Aus diesem paper: https://www.sciencedirect.com/science/article/pii/B9780123725608500437

Und genau deswegen, stimmt das was Sie schreiben vollkommen: So wenige Faktoren wie möglich (um es nicht zu komplex werden zu lassen) und so viele wie nötig (um möglichst viel relevante Faktoren zu identifizieren) 🙂

Vielen Dank nochmal und liebe Grüße

Und noch ein Gedanke zum Problem mit den Korrelationen: Wenn man schon fünf, sechs… Studien hat, die alle einen Zusammenhang zwischen Kalorienaufnahme und Körpergewicht nahelegen, der Form: Je mehr Kalorien jemand aufnimmt, desto höher ist ihr/sein Körpergewicht. Fügen dann immer mehr Studien, die denselben Zusammenhang finden, etwas Relevantes hinzu?

Ein nächster Schritt wäre dann, meiner Meinung nach, nach einem plausiblen Mechanismus zu suchen. Man könnte dann biologisch/physiologisch zu erklären versuchen, wie sich Kohlenhydrate, Proteine und Fette der Nahrung in Fett- und andere Gewebe des Körpers verwandeln.

Man denke zum Vergleich an die Homöopathie: Korrelationen mögen belegen, dass es Menschen, die hom. Mittel verwenden, besser geht. Weil es aber schlicht keinen plausiblen biologischen/physiologischen Mechanismus hierfür gibt, gilt der Placebo-Effekt (als ein psychologischer Mechanismus) bis auf Weiteres als plausibelste Erklärung.

Auch hier haben Sie vollkommen Recht. Sie beschreiben hier sehr anschaulich, die weiterführende wissenschaftliche Methode.

Denn neben der Replikation (also der möglichst exakten Nachahmung einer Studie, um die Robustheit des initial beobachteten Effekts zu testen), ist es auch wichtig, systematisch zu testen inwiefern dann noch Faktor XY (z.B. die Zusammensetzung der Nahrung) einen Einfluss hat. Beispiel: Studie A zeigt einen Zusammenhang zwischen Kalorien und Gewicht. Studie B repliziert diesen Zusammen und testet zusätzlich noch, welchen Einfluss die Zusammensetzung der Nahrung hat. Studie C repliziert wieder den Zusammenhang Kalorien und Gewicht und testet zusätzlich noch welchen Einfluss Gen XY hat.

Wenn Studie B und C dann zeigen konnten, dass sowohl die Zusammensetzung als auch Gen XY einen Einfluss haben, wäre es wahrscheinlich sinnvoll zu gucken inwiefern sich diese beiden Faktoren wiederum gegenseitig beeinflussen. usw. usw.

(Ich möchte hier anmerken, dass man natürlich bis zu einem gewissen Grad auch direkt mehrere Faktoren mit einfließen lassen kann… aber eben auch nicht alle denkbaren (siehe meine Antwort auf Ihr anderes Kommentar –> “overfitting”)

Und nach einer gewissen Anzahl an Studien, ergibt sich dann – idealerweise – ein Bild dieser ziemlich komplexen Mechanismen.

@Herzog: Experiment

Danke – doch wenn wir schon Wikipedia wissenschaftliche Termini definieren lassen, dann bitte auch noch einen Satz weiterlesen, wo dann steht:

P.S. Wo Sie Replikationen ansprechen – Wissen Sie, warum Psychologinnen und Neurowissenschaftlerinnen so wenige Experimente direkt replizieren?

Aha! Vielen Dank für diesen Hinweis!

Was die Replikationen angeht: Da kann ich nur Vermutungen anstellen. Evtl. hat das auch was mit dem Publikationsdruck zu tun? Man ist ja angehalten, möglichst viele innovative Studien zu pubilizieren. Wenn jetzt eine Studie “nur” eine Replikation ist, ist das vielleicht nicht so fancy?

Aber wie gesagt: nur eine Vermutung.

Um mal etwas ganz Banales zu sagen. Wenn Schüler Versuche zum Hebelgesetz machen, dann erkennt der Schüler die Gesetzmäßigkeit. Er lernt sie in Worte zu gleiten und später dann als Formel darzustellen. Und er erkennt , was eine Gesetzmäßigkeit ist gegenüber einer plausiblen Vorstellung. Das ist Wissenschaft.

Wissenschaft benützt gesicherte Methoden zur Erlangung von Wissen.

Jetzt zu dem Versuch mit dem Essen und dem Körpergewicht.

Unsere plausible Vorstellung geht davon aus, dass je mehr, desto schwerer.

Das muss aber nicht so sein, denn die Stoffwechselvorgänge sind etwas komplexer. Wenn man mehr Fett zu sich nimmt, dann ist die Verweildauer der Nahrung im Darm kürzer. Die wissenschaftliche Schlussfolgerung wird also immer ungenauer; JE KOMPLEXER DIE ZUSAMMENHÄNGE WERDEN:

Logik und Wissenschaft sind also nicht immer deckungsgleich. Deswegen sind Versuche unverzichtbar.

@Herzog

A) Nach dem Ehrencodex ´Gute wissenschaftlich Praxis´ müssen Wissenschaftler aktiv werden, wenn sie von konkreten Hinweisen auf wissenschaftliches Fehlverhalten erfahren – und diesen Hinweisen nachgehen.

B) Die Wissenschaftsfreiheit ist durch Art 5 III Grundgesetz geschützt. Dies bedeutet konkret, dass Wissenschaftler konkreten Hinweisen auf wissenschaftliches Fehlverhalten nicht nachgehen müssen.

So funktioniert Wissenschaft in der Realität.

Ich habe heute einen Brief an Sie abgeschickt – mit der Kopie eines Schreibens welches ich vom MPG-Präsidium/Generalverwaltung erhalten habe:

Als Antwort auf eine Beschwerde von mir, in der ich mich ausdrücklich auf den Qualitätsstandard ´Gute wissenschaftliche Praxis´ berufen habe – und am konkreten Beispiel (mit Belegen) gezeigt habe, dass und warum die wissenschaftliche Lehrmeinung ´infantile Amnesie´ nicht stimmen kann.

(Diese Lehrmeinung besagt, dass Erlebnisse aus der frühen Kindheit nicht erinnert werden können.

Es lässt sich aber zeigen/belegen, dass Erlebnisse ab dem 5. Schwangerschaftsmonat LEBENSLANG dem bewussten Erinnern zugänglich sind.)

Das ist spannend. Vielen Dank für den Brief. Ist dieser persönlich an mich addressiert? Oder an die MPG allgemein?

Ich bin, was das Thema ‘infantile Amnesie’ angeht nicht versiert. Aber es kann ja durchaus sein, dass der heute vorherschende wissenschaftliche Konsens zu diesem Thema sich aufgrund neuer Erkenntnisse noch wandelt. Das sollte er zumindest, insofern nach und nach Studien publiziert werden, die in eine andere Richtung weisen. Dieser Prozess dauert allerdings ein bisschen und bis das dann in der Lehrmeinung angekommen ist, dauert es auch nochmal etwas – leider.

Könnten Sie einige Ihrer Quellen auch hier schon posten? Würde mich interessieren.

Was genau war Ihre Kritik in Bezug auf die Gute wissenschaftliche Praxis?

Bzgl. des Fehlverhaltens in der Wissenschaft:

Auch in der wissenschaft gibt es Menschen, die Fehlverhalten zeigen (da fallen wir z.B. die Stichwörter “p-hacking”, oder “Hypothese post hoc anpassen” ein). Es gibt innderhalb der wissenschaftlichen Community allerdings auch verschiedene Bewegungen, um diesem entgegen zu wirken. Wie zum beispiel der Prozess der “pre-registration”. Hier veröffentlicht man eine genaue Beschreibung seiner Forschungsidee und alle geplanten Methoden BEVOR man die Studie durchführt. D.h. zu diesem Zeitpunkt hat man also noch keine Daten mit denen man ‘rumspielen’ kann um seine Frage an die Daten anzupassen oder so. Das fürht auch dazu, dass man dann in seiner Veröffentlichung genau erklären muss, wieso man methodisch doch abgewichen ist.

Außerdem gibt es den Prozess des “peer-reviews” (wie kurz in meinem Artikel auch angeschnitten).

Dennoch: Auch ich glaube, dass es auch in der Wissenschaft “schwarze Schafe” gibt, die sich leider nicht an die gute wissenschaftliche Praxis halten – wie in jeder Gesellschaftsgruppe. Und die Wissenschaft hat durchaus ihre Probleme. Vielleicht ist da auch noch dieses Video für Sie interessant, indem diese Probleme auch nochmal erklärt werden:

https://www.youtube.com/watch?v=DHyRaUeHcGY

Liebe Grüße

@Herzog

Der Brief ist an Sie/O´BRAIN LAB addressiert. Dabei finden Sie ausreichend Zusatzinformationen – die Sie gerne für Ihre wissenschaftliche Arbeit verwenden dürfen.

Mein Aufhänger für die Beschwerde an das MPG-Präsidium war eine geplante Forschungsarbeit am MPI-Bildungsforschung/Berlin – dort war geplant, über neuronale(!) Grundlagen für die Grenze des Erinnerns ´infantile Amnesie´ zu forschen.

Diese Forschung ist – so meine Beschwerde – aus zwei Gründen fragwürdig/sinnlos:

1) Es kann konkret belegt werden, dass Erlebnisse ab dem 5. Schwangerschaftsmonat lebenslang dem bewussten Erinnern zugänglich sind (damit kann die Lehrmeinung nicht stimmen) – dabei ist sogar die Reihenfolge deutlich erkennbar, wie sich Sinne beim Foetus entwickeln: Fühlen(Hautkontakt) > Hören > Sehen > Geburt(indirekt) > erste Sozialerfahrungen > … (Korrelation = 1)

Dieses Beispiel zeigt, dass die bisherige Lehrmeinung nicht stimmen kann.

2) Kulturübergreifende Untersuchungen zeigten, dass die Grenze des Erinnerns ´infantile Amnesie´ für Maori beim 2.5.-, für Europäer beim 3,5.- und für Ostasiaten beim 6.-Lebensjahr liegt. Derartig große Unterschiede deuten darauf hin, dass die ´infantile Amnesie´ wohl eher keine neuronale Grundlagen haben kann – denn man kann davon ausgehen, dass sich die Gehirne in allen Kulturen biologisch gleich entwickeln.

Diese Arbeit hätte man bei einer vorbereitenden Recherche finden müssen!

Sie sollten sich zum Thema ´infantile Amnesie´ kundig machen – denn diese Idee ist in der Kognitionswissenschaft / Entwicklungspsychologie ein sehr wichtiges Thema. D.h. wenn diese Lehrmeinung falsch ist, dann sind viele darauf aufbauenden wissenschaftliche Arbeiten ebenfalls falsch; welche diese Idee übernommen haben.

Das Ganze hat auch enorme finanzielle Auswirkungen – so wurden in diesem Jahr von der EU über 2 Mio. Euro Forschungsgelder bewilligt, um neuronale Grundlagen der infantilen Amnesie zu erforschen. Dazu sind Versuche mit Ratten geplant: sinnlose Forschung mit Tieren betrachte ich als Tierquälerei.

z.B. https://cordis.europa.eu/project/id/818906/de

Learning to remember: The development of the neural mechanisms supporting memory processing

Mein persönlicher Rat: Wenn Sie als Wissenschaftlerin berufliche Karriere machen wollen, sollten Sie meine Hinweise genau studieren. Denn wer als Erste/r eine Arbeit dazu schreibt, dass/warum die Lehrmeinung ´infantile Amnesie´ falsch ist – muss in allen zukünftigen Arbeiten der Gehirn-/Gedächtnisforschung zu diesem Thema als Erstquelle genannt werden.

sorry – beim Link habe ich mich vertippt

https://cordis.europa.eu/project/id/818996/de

Jeder Text, auch ein wissenschaftlicher, richtet sich an ein Publikum

Albert Einsteins 1905 in den Annalen der Physik erschienener Artikel Zur Elektrodynamik bewegter Körper richtet sich an Physiker, nicht an das allgemeine Publikum und auch nicht an Ernährungswissenschaftler, die sich mit dem Zusammenhang Kalorienaufnahme und Übergewicht befassen.

Einsteins Papier muss also von Physikern nachvollzogen werden können, nicht unbedingt von Ernährungswissenschaftlern. Auch die oben erwähnte peer-review wird im Falle eines Artikels, der in den Annalen der Physik erscheint, von Physikern, nicht von Ernährungswissenschaftlern durchgeführt.

Mir scheint, allein schon diese Tatsache, dass ein Text sich an eine Gemeinschaft von Lesern mit einem bestimmten Hintergrund richtet, erklärt sehr viel. Es erklärt die unterschiedlichen Erwartungen unterschiedlicher Leser, es erklärt aber auch die Gemeinsamkeiten. Denn obwohl Physiker sich deutlich von Ernährungswissenschaftlern unterscheiden, haben sie doch etwas gemeinsam: die wissenschaftliche Methode. Und damit die empirische Herangehensweise mit einer Verbindung von Beobachtung, Experiment, Hypothese, Rückführung wenn immer möglich auf gesichertes Wissen und einer von Skepsis begleiteten Bildung neuer Erklärungsversuche.

Doch es gibt dennoch grosse Unterschiede: Einstein argumentiert in seinem Artikel Zur Elektrodynamik bewegter Körper ganz anders als ein Ernährungswissenschaftler. So sagt Einstein nicht, die spezielle Relativitätstheorie sei zu 95% gesichert, denn solche Wahrscheinlichkeiten machen bei einer physikalischen Theorie wenig Sinn, sehr wohl aber in der Ernährungswissenschaft. Eine neue physikalische Theorie ist entweder richtig oder falsch, eine These in der Ernährungswissenschaft aber ist häufig nur unter bestimmten Bedingungen richtig, denn hier haben wir es mit sehr vielen Einflussfaktoren zu tun.

Auch Ihnen vielen Dank für diesen spannenden Kommentar!

Das habe ich mich ehrlich gesagt schon öfter gefragt, wie die Methoden in anderen wissenschaftlichen Disziplinen genau implementiert werden. Führen Physiker z.b. auch statistische Tests durch? Und wenn ja: Dann geht es doch auch hier wieder um Wahrscheinlichkeiten, oder?

Wo mögliche Messfehler ins Spiel kommen spielen Wahrscheinlichkeiten immer eine Rolle. Aber auch dort wo aus vielen Individuen ein Durchschnittsindividuum erzeugt wird: denn (um ein Beispiel zu geben) DEN Menschen gibt es gar nicht, es gibt nur sehr viele Einzelmenschen und es ist immer ein Wagnis eine Aussage über DEN Menschen zu machen, wenn man doch nur Wissen über Einzelmenschen hat.

Diese Frage kommt wirklich aus einer unwissenden Neurgier heraus: Bei der Relativitätstheorie kann also ein Messfehler ausgeschlossen werden? Und deswegen ist sie zu 100% sicher?

@Herzog – zur Relativitätstheorie

Vielleicht kennen Sie noch eine alte mechanische Kuckucksuhr – wo Metallgewichte in Form eines Tannenzapfens als Antriebsgewichte dienten.

Wenn man die Kette mit dem Gewicht hochzog, fügte man potentielle Energie zu. Wenn die Uhr lief, wurde diese potentielle Energie in kinetische Ernergie umgewandelt und trieb das Uhrwerk an.

Es gäbe vier verschiedene Möglichkeiten, mit der Uhr das Vergehen von Zeit zu messen:

A) wenn man die Tannenzapfen gewogen hat, dann kann man über dieses Gewicht und die Strecke des Absinkens beim Vergehen von Uhrzeit – die Energiedifferenz ausrechnen; welche dafür verbraucht wurde.

B) man kann auch einfach nur messen, wieviele Zentimeter sich das Gewicht absenkt, wenn die Uhr läuft

C) man kann die Strecke messen, welche die Spitze des großen Zeigers zurücklegt, wenn die Uhr läuft

D) man kann die Kalenderdaten in Form der Uhrzeit von der Uhr ablesen

Es hat sich aus praktischen Gründen eingebürgert, dass man nur die abgelesenen Kalenderdaten (=Uhrzeit) als Grundlage für Berechnungen verwendet – z.B. für die Relativitätstheorie.

Und genau dieses Vorgehen ist wissenschaftlich fragwürdig. Wenn es – wie im Beispiel – vier verschiedene Möglichkeiten gibt, um Zeiträume messtechnisch zu erfassen, dann müsste man alle vier Möglichkeiten und deren wissenschaftlichen Konsequenzen diskutieren.

Das ist aber bisher nicht passiert – weil die Relativitätstheorie mittlerweile zu einer Glaubensangelegenheit wurde; wo Diskussion nicht zulässig ist.

Es gibt in der Physik bisher noch nicht einmal eine Defintion dafür, was ´Zeit´ genau ist (Was vergeht, wenn Zeit vergeht).

Nadine Herzog schrieb (24.11.2020, 12:02 Uhr):

> […] Führen Physiker z.b. auch statistische Tests durch?

Durchaus —

ganz besonders dann, wenn die durchgeführten Messungen letztlich als “search(es)” und die erhaltenen Ergebnisse als “upper limit(s)” bezeichnet werden,

aber auch sonst.

(Weitergehende Bemerkungen zum Zusammenhang mit anderen hier schon vorliegenden Kommentaren, von mir, oder von anderen, ließen sich wohl machen; aber ich verbleibe zunächst lieber in Erwartung noch konkreterer Anregungen dazu.)

Nadine Herzog schrieb (23. Nov 2020):

> […] Ablauf der wissenschaftlichen Methode […]

> Schritt 2 und 3: […] Als nächstes müssen wir uns überlegen wie wir all die Faktoren, die wir mit einfließen lassen wollen, messbar machen.

Es lässt sich aber schon von Anfang an eine Bestandsaufnahme machen, welche definierten Messgrößen denn überhaupt zur Auswahl stehen, um ausschließlich damit (d.h. jeweils mit bestimmten Werten aus deren Wertebereichen, als “Faktoren”) bestimmte Hypothesen zu formulieren.

Das verhindert nämlich, dass “einfach willkürlich irgendeine” in Form einer Vermutung gestellte Frage oder Äußerung als “Hypothese” angesprochen und mit einer experimentell falsifizierbaren Hypothese verwechselt würde.

Und zu aller erst kann und sollte man sich vergewissern, welche selbstverständlichen, unverzichtbaren Begriffe denn überhaupt vorausgesetzt werden können, um damit “etwas anzufangen”, d.h. unter Verwendung ausschließlich solcher Begriffe jeweils bestimmte Messgrößen bzw. Messoperatoren zu definieren.

> Um beispielsweise „Kalorien pro Tag“ messbar zu machen, könnte man […]

Die Definition der Messgröße Physiologischer Brennwert ist doch recht eindeutig:

Vom thermodynamischen Brennwert der Nahrungsmittel (die an einem Tag verzehrt wurden) soll der thermodynamische Brennwert der verdauten (und wieder ausgeschiedenen) Überreste dieser (und selbstverständlich ausschließlich genau dieser) Nahrungsmittel abgezogen werden.

(Diese Definition ist wohl nur verkürzt dargestellt … weil, u.a., ein-und-die-selbe (Tages-)Portion von Nahrungsmitteln sicherlich nicht sowohl “vom Teller weg” ganz zu Asche verbrannt als auch zunächst aufgegessen und verdaut und ausgeschieden und erst danach ganz zu Asche verbrannt werden kann. Es wird wohl eine weitere Methodik vorausgesetzt, um “Gleichheit” verschiedener Portionen auch ohne Kenntnis ihrer jeweiligen Brennwerte festzustellen; z.B. “Gleichheit der chemischen Zusammensetzung ihrer Bestandteile” und “Gleichheit der Massenanteile von entsprechenden Bestandteilen”; was etwa als “gleiche Portionen aus dem selben Topf” zu bezeichnen wäre).

Besondere Herausforderungen ergeben sich aber, wenn man die definitive Messoperation (durch deren Anwendung jeweils der wahre Wert der betreffenden Messgröße im betreffenden Versuch definiert ist und ggf. so ermittelt würde) überhaupt nicht anwendet (wg. “Ökonomie”, “Ethik”, “Dringlichkeit” …), sondern “eine geeignete ersatzweise Bewertungs- bzw. Abschätzungsmethode”;

deren Ergebnisse wiederum erst durch Bestimmung ihrer systematischen Unsicherheit in Zusammenhang mit dem (eigentlich interessanten) wahren Wert der Messgröße gebracht werden können.

> […] man kann nie an alles denken bzw. niemals alle möglichen Einflussfaktoren in einen Test packen.

Hinsichtlich allem Denkbaren, was nicht ausdrücklich in einer Messgrößendefinition angeordnet ist, gilt natürlich Unbefangenheit bzw. Unbedingtheit. Sonst wäre die Definition ja gar nicht nachvollziehbar. Folglich sind auch alle Hypothesen (die Erwartungen bestimmter Messwerte in bestimmten Versuchen ausdrücken) und alle Modelle (die bestimmte Hypothesen zusammenfassen) “unbedingt”. Entsprechend verstehen sich Modelle hinsichtlich aller Versuche (insbesondere: “Das Standard-Modell gilt immer.”).

> Statistik […] man testet nie wirklich, ob man mit seiner Hypothese Recht hat, sondern wie groß die Wahrscheinlichkeit ist, dass man sich irrt

Daher die Unterscheidung zwischen “[[Hypothese]]” (an sich) und “[[Hypothese (Statistik)]]” …

Nadine Herzog schrieb (23. Nov 2020):

> […] Ablauf der wissenschaftlichen Methode […]

> Schritt 2 und 3: […] Als nächstes müssen wir uns überlegen wie wir all die Faktoren, die wir mit einfließen lassen wollen, messbar machen.

Es lässt sich aber schon von Anfang an eine Bestandsaufnahme machen, welche definierten Messgrößen denn überhaupt zur Auswahl stehen, um ausschließlich damit (d.h. jeweils mit bestimmten Werten aus deren Wertebereichen, als “Faktoren”) bestimmte Hypothesen zu formulieren.

Das verhindert nämlich, dass “einfach willkürlich irgendeine” in Form einer Vermutung gestellte Frage oder Äußerung als “Hypothese” angesprochen und mit einer experimentell falsifizierbaren Hypothese verwechselt würde.

Und zu aller erst kann und sollte man sich vergewissern, welche selbstverständlichen, unverzichtbaren Begriffe denn überhaupt vorausgesetzt werden können, um damit “etwas anzufangen”, d.h. unter Verwendung ausschließlich solcher Begriffe jeweils bestimmte Messgrößen bzw. Messoperatoren zu definieren.

> Um beispielsweise „Kalorien pro Tag“ messbar zu machen, könnte man […]

Die Definition der Messgröße [[Physiologischer Brennwert]] ist doch recht eindeutig:

Vom thermodynamischen Brennwert der Nahrungsmittel (die an einem Tag verzehrt wurden) soll der thermodynamische Brennwert der verdauten (und wieder ausgeschiedenen) Überreste dieser (und selbstverständlich ausschließlich genau dieser) Nahrungsmittel abgezogen werden.

(Diese Definition ist wohl nur verkürzt dargestellt … weil, u.a., ein-und-die-selbe (Tages-)Portion von Nahrungsmitteln sicherlich nicht sowohl “vom Teller weg” ganz zu Asche verbrannt als auch zunächst aufgegessen und verdaut und ausgeschieden und erst danach ganz zu Asche verbrannt werden kann. Es wird wohl eine weitere Methodik vorausgesetzt, um “Gleichheit” verschiedener Portionen auch ohne Kenntnis ihrer jeweiligen Brennwerte festzustellen; z.B. “Gleichheit der chemischen Zusammensetzung ihrer Bestandteile” und “Gleichheit der Massenanteile von entsprechenden Bestandteilen”; was etwa als “verschiedene aber gleiche Portionen des selben Gerichts, aus dem selben Topf” zu bezeichnen wäre).

Besondere Herausforderungen ergeben sich aber, wenn man die definitive Messoperation (durch deren Anwendung jeweils der wahre Wert der betreffenden Messgröße im betreffenden Versuch definiert ist und ggf. so ermittelt würde) überhaupt nicht anwendet (wg. “Ökonomie”, “Ethik”, “Dringlichkeit” …), sondern “eine geeignete ersatzweise Bewertungs- bzw. Abschätzungsmethode”;

deren Ergebnisse wiederum erst durch Bestimmung ihrer systematischen Unsicherheit in Zusammenhang mit dem (eigentlich interessanten) wahren Wert der Messgröße gebracht werden können.

> […] man kann nie an alles denken bzw. niemals alle möglichen Einflussfaktoren in einen Test packen.

Hinsichtlich allem Denkbaren, was nicht ausdrücklich in einer Messgrößendefinition angeordnet ist, gilt natürlich Unbefangenheit bzw. Unbedingtheit. Sonst wäre die Definition ja gar nicht nachvollziehbar. Folglich sind auch alle Hypothesen (die Erwartungen bestimmter Messwerte in bestimmten Versuchen ausdrücken) und alle Modelle (die bestimmte Hypothesen zusammenfassen) “unbedingt”. Entsprechend verstehen sich Modelle hinsichtlich aller Versuche (insbesondere: “Das Standard-Modell gilt immer.”).

> Statistik […] man testet nie wirklich, ob man mit seiner Hypothese Recht hat, sondern wie groß die Wahrscheinlichkeit ist, dass man sich irrt

Daher die Unterscheidung zwischen “[[Hypothese]]” (an sich) und “[[Hypothese (Statistik)]]” …

Zum Folgenden:

“….. Weil es aber schlicht keinen plausiblen biologischen/physiologischen Mechanismus hierfür gibt, gilt der Placebo-Effekt (als ein psychologischer Mechanismus) bis auf Weiteres als plausibelste Erklärung…”

(Zitatende ,Hervorhebung von mir)

Der Teufel (eventuell auch der Täuschung) liegt hier im Detail:

Gemeint kann nur sein :

Weil , aus welchem Grund auch immer; (mir oder allen) keine plausible Theorie eines biophysiologischen Mechanismus bekannt ist...

Denn der Grund für eine Nichtexistenz eines Mechanismus könnte auch nur schlichte wissenschaftliche Ignoranz oder ein “Nichtwissen” aus Zufall oder weiteren Gründen sein. Denn wer nichts sucht bzw. nichts suchen will, der findet halt mal weniger.

Das ist ein (ur- ) altes erkenntnistheoretisches Lied , das manche aber meinen, immer wieder neu “hermeneutisieren” bzw. “auslegen” oder gar ignorieren zu dürfen.

Zum Folgenden:

“… So wenige Dinge wie nötig, soll meinen, dass man aber auch nicht ALLE möglichen Einflussfaktoren in seinen Test mit aufnehmen kann, da dies zu einem statistischen Problem führen würde. Weil dann die Zusammenhänge untereinander so komplex werden, dass sie schwer auf die gesamte Bevölkerung generalisierbar wären, sprich mit hoher Wahrscheinlichkeit eigentlich nur für die befragte Gruppe gelten. ….”

(Zitatende)

Das sind halt die Probleme des “Reduktionismus”.

Und ich dachte immer, die “Ergebnisse ” eines Experiments würden immer nur etwas darüber aussagen, was “gemessen” wurde. Und dass alle weiteren “Folgerungen ” deshalb nur spekulative Interpolationen oder mehr oder weniger starke Hypothesen seien.

Zum Folgenden:

” …. In der Forschung wird hierzu ein bestimmter Grenzwert benutzt. Dieser Wert liegt bei fünf Prozent. Das bedeutet also, wenn meine Resultate mir zeigen, dass ich mich mit einer Wahrscheinlichkeit von weniger als diesen fünf Prozent irre, ist es wahrscheinlich, dass ich mich nicht irre. Ein solches Ergebnis nennt man dann signifikant. Eine hundertprozentige Sicherheit gibt es also nicht. Eine Studie kann daher auch niemals etwas beweisen….”

(Zitatende)

Etwas weniger euphemistisch könnte man auch sagen, es zeigt den Grad an reiner Spekulation an.

Dazu kommen noch die weitern Unsicherheiten wie Schlamperei, Voreingenommenheit, bewusster Betrug , unbewusste Manipulation usw. usw. Vor Letzterem schützt auch die beste “peer review” oft nur bedingt.

Es bleibt deshalb also nur die absolut unabhängige mehrfache Replikation. Das war (lange) “früher mal ” überwiegender Konsens in “der Wissenschaft”. (Besonders der Naturwissenschaft)

Neuerdings scheint man da anderer Meinung zu sein:

Als “wissenwschaftlich (vorläufig) belegt” gilt nur bzw. schon das , worüber sich eine Mehrheit der Forscher (angeblich) einig ist. Und von mehrfacher Replikation durch weitere unabhängige Forscher (-Gruppen) scheint man gerade bei teuren Großexperimenten mit erheblichen theoretischen Auswirkungen immer mehr abzukommen. Ebenso z.B. bei weltweiter statistischer Datenerfassung (u.A. bei den Klimadaten)

Manche sehen da System. (-:

Aber selbst wenn Mehheitskonsense bei Wissenschaftlern eine Art von “Beweiskraft ” hätten:

Wie belegt bzw. beweist man, dass sich “eine Mehrheit” über eine wissenschaftliche Streitfrage einig ist??