Publizierbar oder doch nur reproduzierbar?

BLOG: Quantenwelt

In den Sozialwissenschaften, erfahren wir bei Spektrum der Wissenschaft, ist es keine Seltenheit, dass Ergebnisse das Licht der Veröffentlichung erblicken, die bei genauem Hinsehen nicht reproduzierbar sind. Reproduzierbarkeit ist unbestritten eine entscheidende Forderung an wissenschaftlicher Arbeit. Sie ist aber nicht das wichtigste, wenn es darum geht, was veröffentlicht wird.

Wenn ich an meine Diplomanden- und Doktorandenzeit zurückdenke, fallen mir zum Thema Veröffentlichungen zwei Running Gags ein: Wenn wir unter Studierenden darüber nachdachten, wie wir neue Forschungsergebnisse publizieren könnten und was vielversprechende neue Ansätze sein könnten, wurde die eine oder andere farblose Idee mit den Worten kommentiert: „Das ist doch was für NCL: Nobody Cares Letters“ (die Wen-kümmert’s-Briefe). Wenn wir später während der Datennahme oder -auswertung auf Probleme stießen und keinen rechten Sinn in die Messungen bringen konnten, pflegte mein Doktorvater anzumerken: „Das ist etwas für das Journal of Irreproducible Results“ (Das Journal für nicht-reproduzierbare Ergebnisse).

Der ernste Kern dieser Späße zeigt ganz gut, in welchen Spannungsfeld sich wissenschaftliche Publikationen befinden. Der zweite Punkt, Reproduzierbarkeit, wird oft als das entscheidende Kriterium für Wissenschaft dargestellt. Das will ich auch gar nicht klein reden. Aber woher wissen wir eigentlich, ob ein Ergebnis reproduzierbar ist? In unseren konkreten Fall, wir haben damals Spektroskopie an Selten-Erd-Atomen durchgeführt, wussten wir recht gut, welche Ergebnisse zu erwarten waren.

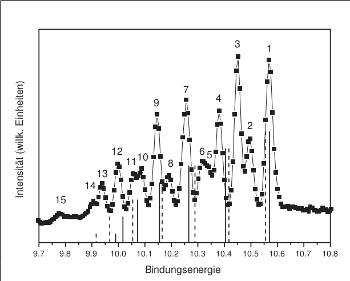

Ein hochauflösendes Photoemissionsspektrum von atomarem Europium. Sind alle Linien reproduzierbar?

Die Theorie gab uns eine Richtlinie, wo wir suchen mussten, wenn unerwartete Ergebnisse auftraten. Ist eine unerwartet im Spektrum auftretende Linie ein echtes Signal des beobachteten Atoms, oder ist es irgendeine Verunreinigung des Vakuums oder gar vorübergehendes elektrisches Rauschen im Detektor gewesen? Manche Linien bestätigen sich beim Wiederholungen des Experiments. Sie treten mit gleicher Form und Höhe jedes Mal wieder auf. Das sind echte atomare Linien. Wenn diese in der Theorie nicht vorhanden sind, müssen wir uns ansehen, welche Näherung fallen gelassen werden muss. Andere Linien treten zwar in derselben Forum und an derselben Stelle immer wieder auf, aber nicht mit gleicher Intensität. Das sind dann Linien des Restgases in der Vakuumkammer und wir können in der Literatur suchen, welches Gas das ist. Finden wir es, können wir es in der Veröffentlichung benennen, finden wir es nicht, müssen wir erwähnen, dass da eine Linie unbekannten Ursprungs ist.

Der Fall einer nicht reproduzierbaren Linie ist unspektakulär. In der Atomphysik würden wir Spektren gar nicht erst veröffentlichen, in denen Spektrallinien nur einmal auftauchen, beim Wiederholen des Versuchs aber weg sind. Solche nicht reproduzierbaren Ergebnisse sind nicht relevant. Es ist manchmal schwer herauszubekommen, was da eigentlich passiert ist, aber Atomphysik ist es nicht. Eher elektronisches Rauschen im Detektor oder ein Softwarefehler. Wenn das immer wieder an verschiedenen Stellen auftaucht, muss das Experiment verbessert werden. Vielleicht ist irgendwo eine Lötstelle kaputt, oder die Software liest manchmal einen Kanal länger aus als sie sollte. Kleinere experimentelle Verbesserungen sind nur selten eine Veröffentlichung wert.

Aber in der Atomphysik haben wir das Glück, dass unsere Untersuchungsobjekte alle gleich sind und in praktisch unbegrenzter Menge zur Verfügung stehen. Wir brauchen nur ein paar Gramm Metall für Millionen von Messpunkten. In anderen Bereichen der Physik oder gar in den Sozialwissenschaften dagegen ist es ein Riesenproblem, einen Versuch unter gleichen Bedingungen zu wiederholen, wenn das Ergebnis unklar ist.

Was wir schreiben

Aber gehen wir mal davon aus, dass alles in Ordnung ist. Ein Experiment wurde durchgeführt, die Daten scheinen reproduzierbar zu sein. Wir haben eine schöne Grafik angefertigt, in der wir die experimentellen Daten mit der Theorie vergleichen. Wir haben eine Tabelle aufgestellt, in der Interessierte schnell sehen können, welche experimentellen Linien mit welchem Atomorbital zusammenhängen. Wir haben in einem Text herausgestellt, was passt und wo Abweichungen vom mathematischen Modell zu erkennen sind. Können wir die Ergebnisse dann veröffentlichen? Werden andere Wissenschaftlerinnen* es zur Kenntnis nehmen?

Dazu braucht es etwas mehr. Wir wollen es ja nicht in Nobody Cares Letters unterbringen, sondern in einem der renommierten Wissenschaftsjournalen. Zum Beispiel in der Physical Review Reihe, in einem der Journal of Physics oder sogar bei Nature oder Science. Qualitätsjournale erwarten mehr als valide, reproduzierbare Daten.

Experimentalphysikerinnen erzeugen nicht nur Daten. Sie vergleichen sie auch mit der Theorie. Vor allem stellen sie sie in einen Zusammenhang. Um etwas veröffentlichen zu können, müssen sie eine Geschichte erzählen. Hier gilt ähnliches, wie bei jedem anderen Presseerzeugnis: Die Überschrift muss Aufmerksamkeit erzeugen. Die Einleitung muss die Forschung motivieren, in einen Zusammenhang mit vorhergehenden Arbeiten stellen und die Erwartung der Lesenden eines spannenden Textes entfachen. Der Experimentalteil muss das Experiment in genügend Einzelheiten beschreiben um es vor die Lesenden nachvollziehbar zu machen, ohne sie zu langweilen. Der Theorieteil gibt alle relevanten Formeln und Modelle an. indem er andere Veröffentlichungen nennt oder selbst ein Modell herleitet. Die Ergebnis-Sektion vergleicht schließlich Experiment mit Theorie und mündet in eine Zusammenfassung, die meist einen Ausblick darauf gibt, wohin die Forschung weitergehen könnte oder was die Menschheit einmal mit den Ergebnissen anfangen werden kann.

Zu guter Letzt schreibt die Wissenschaftlerin eine Kurzzusammenfassung, den Abstract, der ganz am Anfang des Artikels erscheinen wird und den Inhalt des Artikels in einem möglichst guten Licht erscheinen lassen soll. Machen wir uns nichts vor: Der Abstact wird bei einem Großteil des Publikums das einzige bleiben, was sie gelesen haben. Hier holen sich die Rezipienten ihre Take-Home-Message ab. Zugleich ist es aber auch in Teil, in dem gerne etwas übertrieben wird, in dem auch mal kritische Einschränkungen weggelassen werden, weil sie ja im Haupttext ausreichend gewürdigt werden.

Bevor ein Artikel veröffentlicht wird, durchläuft er das Peer-Review: Zunächst sieht sich eine Redakteurin den Artikel an und entscheidet, ob der Artikel von Aufmachung und Thema überhaupt in die Zeitschrift passt. Wenn diese Abschätzung positiv ausfällt, schickt sie die Arbeit an ein bis drei externe Gutachterinnen, die den Artikel auf Herz und Nieren prüfen sollen. Wenn die Begutachtung positiv ausfällt, kann der Artikel schließlich veröffentlicht werden, oft mit ein paar Korrekturen und zusätzlichen Informationen versehen.

…und was wir lesen wollen

Weder Die Gutachterinnen, noch die Redakteurin des Wissenschaftsverlages können beurteilen, ob unsere gemessenen Spektrallinien reproduzierbar sind. Sie prüfen, ob der Text interessant ist, ob der aktuelle Stand der Forschung ausreichend gewürdigt wurde und ob die Ergebnisse sauber erklärt sind und der Zusammenhang mit der Theorie nachvollziehbar ist. Reproduzierbarkeit können die Verlage und ihre Gutachterinnen gar nicht überprüfen, selbst wenn sie daran ein Interesse haben. Dazu müsste ihnen ja exakt derselbe experimentelle Aufbau zur Verfügung stehen, den die Autorin hatte.

Aber Reproduzierbarkeit festzustellen ist nicht die Aufgabe der Verlage. Ihr Job besteht darin, wissenschaftliche Publikationen dem Fachpublikum darzustellen. Dabei ist wesentlich, das sie für ihr Publikum eine Auswahl treffen. Niemand hat Zeit, alle Publikationen, die täglich erscheinen, auch nur anzusehen. Deshalb gehen wir Inhaltsverzeichnisse ausgewählter Fachzeitschriften durch und suchen uns dort die interessanten Artikel heraus.

Die Redakteurinnen wollen dafür sorgen, dass die Lesenden ihr Interesse nicht verlieren. Deshalb wählen sie solche Artikel aus, die neues darstellen, gut geschrieben sind, eine Geschichte erzählen, plausibel erscheinen. Wir Lesenden wollen genau das finden. Wir wollen nicht mit Überprüfungen längst bekannter Phänomene gelangweilt werden. Oder mit trockenen Studien, die anderen ebenso trockenen Studien widersprechen. Widerlegungen von Experimenten finden genau dann Eingang in die beliebten Journale, wenn sie ebenso gut geschrieben sind, wie die Originalartikel. Sonst müssen sich ihre Urheberinnen mit weniger gut besuchten Journalen abfinden.

Wir machen uns etwas vor, wenn wir denken, Open-Source oder eine Widerlegungsdatenbank würden das Problem nicht reproduzierbarer Studien lösen. Es wäre sicher ein Teil der Lösung, weil es die Widerlegungsversuche wenigstens denen zur Verfügung stellte, die aktiv danach suchen. Aber das eigentliche Problem, dass der Erfolg einer Arbeit nicht durch sorgfältige und reproduzierbare Wissenschaft, sondern vor allem durch eine gute Geschichte gesichert wird, wird damit nicht aufgelöst. Ich bin mir nicht einmal sicher, ob ich dieses Problem auflösen will. Denn gerade spannende, teilweise spekulative Wissenschaft lese ich gern.

Was ich vorschlage ist, dass wir uns alle angewöhnen, wissenschaftliche Veröffentlichungen kritisch zu betrachten. Statt zu sagen, “die Wissenschaft hat festgestellt”, können wir es mal versuchen mit: “Wissenschaftlerin B hat dieunddie Behauptung aufgestellt und dafür folgende Hinweise gefunden.“

Anmerkung:

*Männer sind selbstverständlich mitgemeint.

The Journal of Irreproducible Results

http://www.jir.com/

Have fun 🙂

Wissenschaft als Geschichtenerzählen

Wissenschaft und Wahrheit

Die Geschichte, die eine wissenschaftliche Arbeit erzählt ist das, was die Arbeit herausstechen lässt und sie überhaupt beachtenswert macht. Die Reproduzierbarkeit hat dann etwas mit dem Wahrheitsgehalt der Geschichte zu tun. Diese Frage stellt sich nicht nur in der Naturwissenschaft, sondern auf fast jedem Gebiet. Wenn ein Historiker über die Bombardierung einer Stadt im 2. Weltkrieg durch die deutsche Luftwaffe schreibt, so erwarten wir, dass der Historiker sein Zahlenmaterial dazu überprüft hat und nicht einfach Lücken (des Wissens) so füllt, dass sie zwar zu seinen Aussageabsichten passen aber schlicht und einfach aus der Luft gegriffen sind.

Es geht also um Ehrlichkeit und lautere Absichten. Wenn aber – wie im Spektrum der Wissenschaft 2/13 berichtet – Zeitschriften und Autoren von sozialwissenschaftlichen Studien nicht einmal über die Wiederholbarkeit ihrer Studien diskutieren wollen und man letztlich herausspürt, dass es gar nicht um Fakten sondern nur um die Konstruktion eines Renommes out of thin air geht, so dürfen wir auch hier die gleichen Schlussfolgerungen ziehen wie bei anderen Geschichten: Wer Dinge aus dem Hut zaubert ist ein Gaukler, möglicherweise sogar ein Betrüger, sicher aber kein seriöser Mensch und schon gar kein Wissenschaftler.

Es wurde schon einmal hier in scilogs über die “wissenschaftlichen” Praktiken von Psychologen und anderen Sozialwissenschaftlern berichtet und dannzumal war ich noch schockiert, weil ich davon ausging, dass auch Psychologen etwas erforschen wollen und nicht nur Geschichten erfinden. Doch der Beitrag von Thomas Grüter liess kaum einen anderen Schluss zu als dass es in gewissen “Wissenschaften” gar nicht mehr um die Wahrheit sondern nur noch um das Profil geht, das der Autor sich mit einer Arbeit schafft. Und wenn es gar nicht mehr um Wissenschaft geht stört die Wahrheit und muss unterdrückt werden.

Wissenschaftliche Artikel haben – da kann ich diesem Beitrag voll zustimmen – viel mit Herstellung eines Kontexts und dem Sichtbarmachen von Verbindungen zu tun. Und weil der Autor das weiss ist die Versuchung gross, Verbindungen herzustellen und bestätigt zu sehen, wo es in Wirklichkeit durch die konkrete Arbeit Zweifel daran gibt.

Damit gilt für wissenschaftliche Arbeiten etwas ähnliches wie für andere “Geschichten”: Eine Arbeit kann brilliant scheinen, ist aber erstunken und erlogen.

Reproduzierbarkeit und Fortschritt

Reproduzierbarkeit von Versuchen und Messungen hat aber nicht nur etwas mit dem Wahrheitsgehalt der wissenschaftlichen Aussage zu tun, auf der das Experiment beruht. Sie kann auch darum wichtig sein,

1) weil andere Wissenschaftler auf den Versuchungen und Messungen aufbauen wollen

2) Sie kann wichtig sein, weil man durch Verfeinerung des Experiments und genaueren Messungen die zugrundeliegende Theorie herausfordern kann und eventuell “neue Physik” oder allgemein “neue Wissenschaft” finden kann

3) Sie kann wichtig sein, weil sie konkrete Pfade und Wege aufzeigt etwas zu realisieren.

Lässt sich etwas reproduzieren hat man im günstigsten Fall etwas, worauf man aufbauen kann. Und selbst wenn man es nicht selbst reproduziert so ist das Wissen das jemand schon mal etwas erreicht hat sehr viel Wert. Das ist wiederum ganz ähnlich wie in anderen Lebensbereichen. Nachdem die ersten Bergsteiger den Mount Everest erklommen hatten war es vielen anderen Bergsteigern klar, dass auch sie das können und sie haben es dann auch getan.

@Martin Holzherr

Sie haben recht. Was ich hier nur ausführen wollte ist, dass die Redakteurinnen in den Fachverlagen nicht die Reproduzierbarkeit prüfen können. Sie würden sicher gerne, weil eine Sensation, die sich später als zweifelhaft herausstellt, auch die Zeitschrift in ein schlechtes Licht stellt. Aber sie können es einfach nicht.

Thomas Grüters Fazit ist mit meinem kompatibel: Er appelliert dafür, unter den Ergebnissen aufzuräumen, damit es keine nicht reproduzierbaren Daten als Fakten in die Lehrbücher schaffen. Mein Vorschlag ist, wissenschaftliche Publikationen als Beitrag zur Wahrheitsfindung, nicht als Wahrheit zu lesen. Und, zwischen den Zeilen, doch bitte mehr als nur das Abstact zu lesen.

@Joachim: Zustimmung!

Lieber Joachim,

dieser Blogpost von Dir hat mir außerordentlich gut gefallen, da er m.E. sowohl die Chancen, Mühen wie aber auch Grenzen wissenschaftlichen Arbeitens aufzeigt. Selbst in meinem doch eher speziellen Forschungsgebiet werden inzwischen pro Quartal (!) mehrere Dutzend empirischer Studien publiziert, so dass es faktisch unmöglich ist, alles im Blick zu behalten – oder gar zu überprüfen. Und natürlich haben es dann auch dort die spektakulären, spannenden Befunde leichter, wahrgenommen und weiter-zitiert zu werden als die vielleicht handwerklich saubereren Grundlagenarbeiten.

Auch sehe ich genau den Unterschied, den wir neulich im Bereich der sog. “harten” und “weichen” Wissenschaften diskutierten. Während physikalisch-chemische Prozesse leicht zu “reproduzieren” sind, kann die Demoskopie die letzte Niedersachsen-Wahl (in der sie fast ausnahmslos grausam danebenlag) nie mehr unter gleichen Bedingungen beobachten. Verrückter noch: Berücksichtigt sie Erkenntnisse aus dieser (z.B. sog. “FDP-Leihstimmen”), so könnte sie das nächste Wahlergebnis damit wiederum ungewollt beeinflussen (z.B. weil potentielle “Leihwählende” glauben, die FDP benötige ihre Stimme gar nicht für die 5%-Hürde). Biologische und erst Recht biokulturelle Prozesse sind nur noch in laborartigen Details reproduzierbar, insgesamt aber je historisch einzigartig.

Und so hat mich das Nachdenken über Deinen Blogpost zu einer Science-Fiction-Kurzgeschichte als Beitrag zum Bloggewitter angestiftet.

https://scilogs.spektrum.de/…schichte-zum-bloggewitter

Dir damit auch vielen Dank für die interdisziplinären Anregungen!

@Joachim: Followers on scientific work

Zustimmung zu (Zitat):Redakteurinnen können die Reproduzierbarkeit nicht prüfen. Das wäre wohl zu viel verlangt (übrigens auch für Redakteure).

Bei der Flut von Papieren lohnt es sich vielleicht auch gar nicht alle Papiere akribisch zu prüfen. Doch “wichtige” Arbeiten sollten überprüft werden. Eigenltiche eine ideale Anwendung des Community-Prinzips: Es sollte sich um viel zitierte oder irgendwie als wichtig eingestufte Arbeiten und Papiere eine Art von Followers bilden. Diese würden dann die Arbeit akribisch überprüfen und reproduzieren – so ähnlich wie die Plagiateüberprüfer von denen man aus aktuellem Anlass so viel gehört hat. Fortschritte in der Überprüfung würden auf einer eigenen Scientific-Paper-Followers-Website vermerkt.

Anders als bei der Reproducability Intiative würde es bei meinem Follower-Ansatz nicht primär um das Publizieren von reproduzierten Arbeiten gehen, sonder um die Diskussion, umd die Plausibilitisierung und alles andere was mit der Arbeit zu tun hat gehen und die Reproduktion wäre nur ein Teil davon.

Jede wichtige Arbeit würde damit einen Kreis von Leuten erhalten, die diese Arbeit versuchen ernst zu nehmen und die ihre Erfahrungen mit diesem Versuch untereinander austauschen.