Künstliche Intelligenz unter Kontrolle

Für seine Bewerbung um den KlarText-Preis für Wissenschaftskommunikation 2022 in der Kategorie Informatik veranschaulichte Benedikt Loepp, was er in seiner Promotion erforscht hat.

Was kaufen bei Amazon, schauen bei Netflix, hören bei Spotify? All dies beantwortet uns heute künstliche Intelligenz: Sie empfiehlt interessante Produkte, zeigt Serien passend zum eigenen Geschmack, und führt Playlists fort, ohne dass wir es bemerken. Doch mitbestimmen, was empfohlen wird? Fehlanzeige! Unsere Forschung an der Universität Duisburg-Essen zeigt, dass es auch anders ginge, und sich die zugrundeliegenden Algorithmen unter Kontrolle bringen lassen.

In vielen Bereichen des täglichen Lebens, so vermitteln es Medien und Werbung, profitieren wir schon heute massiv von künstlicher Intelligenz (kurz: KI). Doch denkt man darüber nach, stellt sich schnell die Frage: Wo genau im Alltag begegnen wir denn nun diesem technischen Fortschritt, der als Lösung für nahezu jedes Problem gepriesen wird? Womöglich kommen dann Smart-Home-Geräte oder Assistenzsysteme moderner Pkw in den Sinn. Tatsächlich geraten wir aber viel öfter mit typischen Vertretern für den Einsatz von KI in Kontakt. Die Rede ist von Empfehlungssystemen, die sich zu überaus populären Hilfsmitteln entwickelt haben, um die Informationsflut zu bewältigen, mit der wir uns alle tagtäglich im World Wide Web konfrontiert sehen.

Am bekanntesten sind solche Systeme wohl aus Onlineshops, bei Amazon etwa zu finden unter Überschriften wie: „Kunden, die diesen Artikel gekauft haben, kauften auch.” Dort stehen dann Produkte, von denen angenommen wird, sie würden unseren Bedürfnissen entsprechen. Und das mit gehörigem Erfolg: Einem Bericht der Unternehmensberatung McKinsey zufolge gingen bereits 2013 mehr als ein Drittel aller bei Amazon getätigten Einkäufe auf diese Empfehlungen zurück. Während dies natürlich den Unternehmenszielen zuträglich ist – man empfiehlt, was den Umsatz eben so steigert – profitieren auch wir als Kund*innen von dieser Technik, und werden etwa auf Produkte aufmerksam, die wir sonst nicht oder nur mit viel Mühe gefunden hätten. Zugleich bleibt einem oft nichts anderes übrig, als genau das zu konsumieren, was die KI an Produkten vorschlägt: Möchte man ein anderes, gerade aktuelles Bedürfnis befriedigen, ist es meist schwierig bis unmöglich, dies den Systemen mitzuteilen, sprich, nach alternativen Empfehlungen zu verlangen. Dass es auch anders geht, zeigt die Arbeit unserer Forschungsgruppe an der Universität Duisburg-Essen. In dieser beschäftigen wir uns nämlich unter anderem mit der Frage, wie herkömmliche Empfehlungssysteme um interaktive Mechanismen ergänzt werden können, die den Nutzer*innen Kontrolle über die Empfehlungen zurückgeben.

Doch bevor wir auf diese Forschung eingehen und uns der Frage widmen, ob die weit verbreitete Sorge tatsächlich berechtigt ist, dass die KI uns Menschen zunehmend in eine passive Rolle drängt, sei klargestellt, dass Empfehlungssysteme weit mehr sind als profitmaximierende Werkzeuge von Onlineshop-Betreibern: Netflix etwa präsentiert Listen von Empfehlungen für Serien und Filme, gruppiert nach Genres und persönlichen Interessen, über die wir sonst längst den Überblick verloren hätten. Streaming-Apps wie Spotify führen Playlists in Eigenregie fort, indem sie Songs ähnlicher Machart spielen, sobald der letzte Track verklungen ist. Soziale Netzwerke, von Facebook bis LinkedIn, reduzieren die Feeds auf ihren Startseiten auf einen überschaubaren Bruchteil dessen, was befreundete Personen und gefolgte Unternehmen tatsächlich posten. Instagram und TikTok fesseln ihre Nutzer*innen mit einer geschickten Auswahl von Bildern und Videos ans Smartphone. So häufen sie einerseits Verhaltensdaten an, um immer stärker personalisierte Werbeanzeigen zu schalten, sowohl auf den Portalen selbst, aber auch überall sonst im Internet. Andererseits gäbe es ohne die automatisierten Empfehlungen wohl kaum eine Möglichkeit, die Millionen neuer Inhalte zu erschließen, die weltweit minütlich hochgeladen werden. Dies gilt genauso auf einer gesellschaftlich bedeutsameren Ebene, denn ohne Empfehlungssysteme ließen sich in unserem unübersichtlichen Weltgeschehen wohl kaum noch jene Nachrichtenartikel identifizieren, die wirklich von Interesse sind.

Letztlich aber spielt es keine Rolle, ob Konsumgüter, Schminktipps oder Kriegsberichterstattung: Die Empfehlungen sind das Ergebnis ausgeklügelter KI-Algorithmen, die allerdings meist auf weit weniger komplizierten Ideen beruhen, als man zunächst vermuten könnte: Heißt es wie bei Amazon nämlich „andere Kunden”, dann kommt das sogenannte „kollaborative Filtern” zum Einsatz, dessen Basis schlichtweg die Meinung „der Anderen” ist, ausgedrückt in Form von ein bis fünf Sternen, durch ein einfaches „Gefällt mir” oder lediglich den Umstand, dass ein Video zu Ende angeschaut wurde. Was dann folgt, entspricht immer demselben Prinzip, welches schon den ersten Empfehlungssystemen Anfang der 1990er Jahre zugrunde lag und ganz unabhängig von den zahllosen Verbesserungen funktioniert, die seitdem an Universitäten und in Entwicklungsabteilungen ersonnen und nur allzu oft als bahnbrechende Fortschritte der KI lobgepriesen wurden: Der jeweilige Algorithmus analysiert, welche Nutzer*innen in der Vergangenheit ähnlich wie man selbst bewertet haben. Anhand der Produkte, die diese Personen außerdem mit positiven Bewertungen versehen haben, trifft er dann eine Vorhersage darüber, wie wohl die eigene Bewertung dieser Produkte ausfallen würde, und ob es sich folglich um lohnende Vorschläge handeln könnte. Weil die Datengrundlage somit durch die Nutzer*innen selbst geschaffen wird – und nicht wie bei anderen Algorithmen üblich, sämtliche Eigenschaften der Produkte bekannt sein und umständlich ausgewertet werden müssen – ist diese Form der Empfehlungsgenerierung bis heute die mit Abstand meist genutzte.

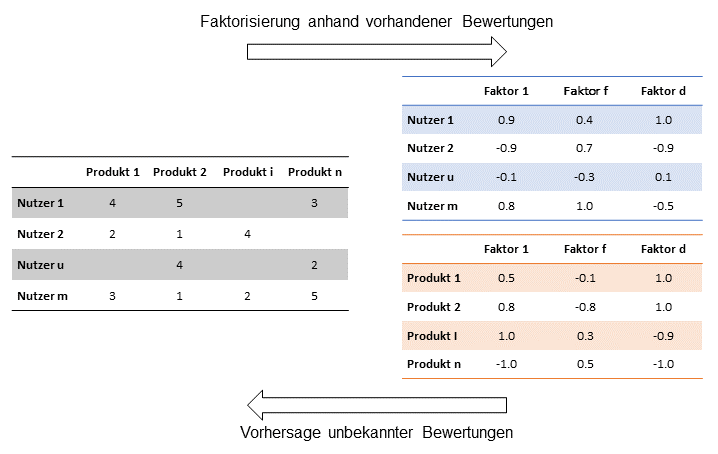

Eine besonders populäre Variante ist die der Matrixfaktorisierung. Hierbei werden wie unten gezeigt Faktoren aus den Bewertungsdaten extrahiert, die sowohl die Nutzer*innen als auch die Produkte beschreiben, und es in umgekehrter Richtung auf besonders effiziente Weise ermöglichen, die fehlenden Bewertungen zu ermitteln. Auch unsere Arbeitsgruppe an der Universität Duisburg-Essen hat sich intensiv mit dieser Methode beschäftigt. Doch anstatt Verbesserungen wie die oben genannten anzustreben, die fast immer nur versuchen, die Geschwindigkeit oder Genauigkeit weiter zu steigern, mit der die Vorhersagen getroffen werden, verfolgten wir ein anderes Ziel: So wie es zwei der renommiertesten Forscher für Empfehlungssysteme, Joseph A. Konstan und John Riedl von der University of Minnesota, schon vor Jahren als viel bedeutsamer für die empfundene Zufriedenheit mit den Systemen erkannt haben, ging es uns von vornherein darum, die „Nutzer*innen in Kontrolle zu versetzen”.

Wie ein erneuter Blick in den Alltag zeigt, bleibt diese Form der Mitbestimmung bislang jedoch weitgehend auf der Strecke: Amazon sagen, dass gerade Geschenke und folglich andere Produkte gesucht werden? Netflix informieren, dass die ganze Familie vor dem TV sitzt, und Horrorfilme daher völlig unpassend sind? Angesichts von Fake News Einfluss darauf nehmen, welche Nachrichtenquellen angezapft werden? Alles Fehlanzeige! Forschungsarbeiten, die versuchen, diese Interaktion zwischen Menschen und KI-basierten Computerprogrammen zu stärken? Ebenfalls äußerst selten – vor allem im deutschsprachigen Raum! Entsprechend schien uns das kollaborative Filtern, bei dem (wenn überhaupt) die einzige Möglichkeit Kontrolle auszuüben darin besteht, nach und nach weitere Produkte zu bewerten, ein prädestiniertes Beispiel zu sein, um zu zeigen, dass es auch anders geht.

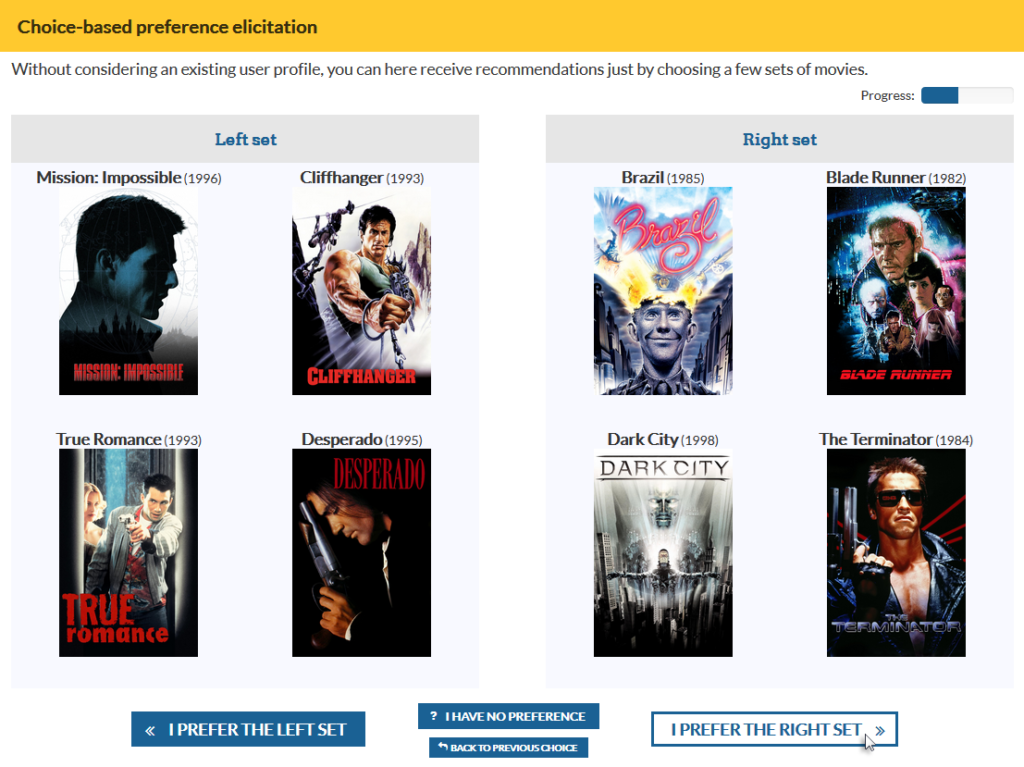

Mit diesem Vorsatz entwickelten wir unter Berücksichtigung von Erkenntnissen aus der Entscheidungspsychologie als Erstes eine Methode, die es neuen Nutzer*innen gestattet, ihre Präferenzen mitzuteilen, indem sie lediglich wenige Produkte miteinander vergleichen, anstatt sie wie von Amazon bekannt mit Sternen bewerten zu müssen. Die Methode wählt die Produkte dabei geschickt auf Basis der automatisch extrahierten Faktoren, wodurch ohne weiteres Zutun gut nachvollziehbare Gegenüberstellungen wie die unten gezeigte entstehen, und vor allem, ohne dass hierfür inhaltliche Informationen gleich welcher Art erforderlich wären. Dennoch programmierten wir anschließend eine spezielle Erweiterung der Matrixfaktorisierung, um die eigentlich rein auf Bewertungsdaten basierenden Algorithmen auch mit textuellen Informationen über die Produkte füttern zu können, beispielsweise mit von den Nutzer*innen vergebenen Schlagworten. Dies haben andere Forschende auch schon vor uns getan – erneut aber „nur“ zur Optimierung der Algorithmen, nicht aber, um die Nutzer*innen in eine aktivere Rolle zu versetzen. Unsere Erweiterung zielte jedoch speziell darauf ab, die Nutzungsoberfläche etwa mit Schiebereglern ausrüsten zu können, die es dann eben doch ermöglichen, dem System mitzuteilen, dass gerade weniger Wert auf Horror und mehr auf Familienfreundlichkeit gelegt wird. Schließlich haben wir diese interaktive Form der Empfehlungsgenerierung noch weiter gesteigert, und mit den klassischen Mechanismen kombiniert, mit denen in Onlineshops schon lange manuell nach Produkten eines Herstellers gesucht oder aus einer bestimmten Preisspanne gefiltert werden kann.

Auch um die Effektivität dieser Methoden zu bestätigen, mussten wir die ausgetretenen Pfade bisheriger Forschung verlassen. Dort wurde bislang nämlich meist nur gemessen, wie viel schneller oder genauer neue Algorithmen und Verbesserungen sind. Unsere Fragestellung erforderte hingegen, die Entwicklungen im praktischen Einsatz zu testen. Entsprechend luden wir Proband*innen zu mehreren Laborstudien ein, in denen sie Zugang zu einem eigens für diesen Zweck programmierten, online abrufbaren Filmempfehlungssystem erhielten. Neben ähnlichen Funktionalitäten wie Netflix stellte dieses System unsere interaktiven Methoden zum Ausprobieren bereit, wie beispielsweise die in der Abbildung gezeigten Gegenüberstellungen. Die Proband*innen wurden daraufhin gebeten, die Methoden anhand von Fragebögen zu beurteilen und miteinander sowie mit den bekannten Alternativen zu vergleichen. Nach umfangreicher statistischer Analyse konnten wir so bestätigen, dass sich überall dort ein höheres Maß an Kontrolle realisieren lässt, wo bisher schon kollaboratives Filtern auf Basis von Bewertungsdaten zum Einsatz kommt – also praktisch in jedem Empfehlungssystem im World Wide Web! Zugleich zeigte sich, dass das Mehr an Kontrolle dazu führt, dass die subjektiv wahrgenommene Qualität der Empfehlungen steigt, ohne dass etwa der höhere Aufwand, den die Nutzer*innen investieren müssen, um an diese zu gelangen, ihre Zufriedenheit beeinträchtigt.

Trotz dieser ermutigenden Ergebnisse ist klar, dass sich nicht jeder unserer Vorschläge in vollem Umfang zur Umsetzung eignet – nicht zuletzt, weil Unternehmensziele wie kurzfristige Gewinnmaximierung nur schwerlich mit uneingeschränkter Mitbestimmung einhergehen. Doch entscheidender ist die Antwort auf die Frage, ob aus dem zunehmenden Einsatz von KI nun tatsächlich folgt, dass wir Menschen zwangsläufig an Kontrolle verlieren? Nein, zeigt unsere Forschung zumindest exemplarisch, aus technischer Perspektive ist dies keinesfalls eine unausweichliche Konsequenz. Und wenn es für Empfehlungssysteme möglich ist, komplexe Algorithmen derart zu ergänzen, dann lässt sich das sicher auch auf andere KI-basierte Computerprogramme übertragen. Es wird nur hier wie dort erfordern, dass die Verbesserung der Algorithmen nicht alleinig im Mittelpunkt verbleibt, sondern das Drumherum künftig mindestens die gleiche Beachtung in der Forschung erfährt!

Benedikt Loepp studierte Angewandte Informatik an der Universität Duisburg-Essen und promovierte dort anschließend zum Thema Empfehlungssysteme. In diesem auf die Algorithmen fokussierten Forschungsgebiet beschäftigte er sich früh mit einer Verbesserung von Aspekten wie der Interaktivität und der Transparenz. Seit 2021 führt er diese Forschung an der Schnittstelle von Mensch-Computer-Interaktion und maschinellem Lernen als Postdoktorand fort und weitet diese auf andere Bereiche der KI-basierten Entscheidungsunterstützung aus. Benedikt ist Mitbegründer und Teil des Leitungsgremiums der Fachgruppe „Nutzerzentrierte künstliche Intelligenz“ (NKI) in der Gesellschaft für Informatik.

Liest sich gut, vielen Dank!

Dr. Webbaer nutzt zeitgenössische AI in der Tat bereits dazu sich Empfehlungen geben zu lassen, im Dialogfenstern mit dem GPT-3 basierten “ChatGPT” zum Beispiel; es geht dann u.a. um das Kochen, um Filme, um Computerspiele, um öffentlich verfügbare Datenlagen zu verschiedenen Themen und um philophische Sichten samt Bücher.

Was ganz wunderbar ist und viel besser greift als gewohnte Suchmaschinenrecherche.

Auch weil dieser AI der gesamte Sitzungskontext (eines Dialogs mit dem Nutzer) ständig verfügbar ist und sie über eine gewisse Empathie verfügt, mitdenken kann, vorfühlen sozusagen ebenfalls und vor allem auch sehr gut reden kann.

Wobei statt sprachlichem Dialog,.nicht jeder redet gerne, auch andere Benutzerschnittstellen möglich sind, die auf Schaltflächen und auf Daten basieren könnten, die diese AI bereits von anderer Seite über den Nutzer hat, was dann stark vereinfachen könnte, bei womöglich annähernd gleicher Nutzerzufriedenheit.

—

Kleiner Exkurs, diesmal vor den Gefahren warnend :

“ChatGPT” zum Beispiel besteht aus einem zugrunde liegenden AI-Model, das auf Grund einer großer Menge verfügbarer Textdaten “trainiert” (das Fachwort an dieser Stelle) worden ist.

Dieses AI-Model ist nett und fair und sachnah und so weiter…

Dann gibt es noch eine dieses AI-Model zwiebelförmig umschließende Schicht, die ebenfalls AI-basiert ist, sich dabei aber, von vielen (menschlichen) Experten unterstützt, um die Sozialverträglichkeit (!) des AI-Outputs kümmert.

Damit insbesondere sensible Personen hier nicht zu klagen beginnen, “OpenAI” stellt Produkt der Wirtschaft für die Wirtschaft bereit, ist dieses sozialverträgliche Output “politisch korrekt” bis “woke”, was nicht jedem gefällt, so aber nicht weiter kommentiert werden soll.

Und drittens gibt es noch die Möglichkeit AI wie “ChatGPT” von Firmenseite (Unternehmen der Wirtschaft sind also gemeint) einzukaufen und dann noch einmal en detail einzustellen, so wie es die Firma, die diese AI-Dienstleistung eingekauft hat, wünscht.

Und hier entsteht der begründete Verdacht, dass dann auch gelogen werden könnte, wenn in dieser Schicht also fine getunt werden kann, von einer Firma, die den Verkauf eigener Produkte anstrebt.

Mit freundlichen Grüßen

Dr. Webbaer