Die kognitiven Kompetenzen des Sprachmodells GPT-3

In meinem letzten Blogartikel habe ich mit dem Chatbot ChatGPT einen kognitiven Test durchgeführt, der nach der Bloom’schen Lernzieltaxonomie konzipiert war. Meine Kernidee war es, ChatGPT wie eine*n Studierende*n zu behandeln, die/den ich mündlich in Sprachwissenschaft prüfe.

Die Forscher Marcel Binz und Eric Schulz vom Max-Planck-Institut für Biologische Kybernetik in Tübingen sind sehr viele Schritte weiter als ich gegangen und haben GPT-3 (Generative Pre-trained Transformer 3), das Sprachmodell hinter ChatGPT, mit kognitionspsychologischen Experimenten getestet und die Ergebnisse in der Fachzeitschrift PNAS veröffentlicht [1].

Das Sprachmodell GPT-3

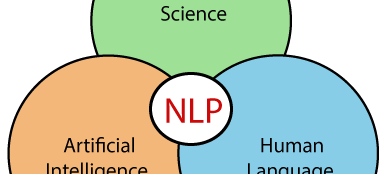

Ein Sprachmodell trifft Voraussagen darüber wie wahrscheinlich es ist, dass ein Wort auf einen Teil-Satz folgt. Ist der Satz-Anfang z. B. „Ich koche eine“, weist das Modell dem Wort „Suppe“ eine höhere Wahrscheinlichkeit zu als dem Wort „Straßenbahn“.

GPT-3 ist ein künstliches neuronales Netzwerk, dass anhand von riesigen Textmengen aus Büchern und Webseiten gelernt hat, wie Menschen schreiben (sprechen?) und auf Sprache reagieren. GPT-3 kann auf verschiedene Funktionen zugeschnitten werden, wie z. B. Textzusammenfassung, Textparsing und Sprachübersetzung. Es verfügt über eine offene Programmierschnittstelle (genauer API), mit der jeder auf GPT-3 zugreifen kann, um eigene KI-Anwendungen mit seinen Funktionen zu erstellen. GPT-3 kann zum Beispiel auch Schach spielen und Matheaufgaben auf Universitätsniveau lösen. Ich würde GPT-3 gerne mit Audiodaten aus Vogelgesang und Vogelrufen trainieren und mit einer App verknüpfen, die entsprechende Laute produzieren kann.

Man kann also zusammenfassend salopp sagen: ChatGPT ist die Web App und GPT-3 die künstliche Intelligenz dahinter. GPT-3 hat 175 Milliarden Parameter von denen ChatGTP “nur” 20 Milliarden nutzt. ChatGTP wurde mit Konversationsdaten trainiert, GPT-3 mit Büchern und Webseiten. ChatGTP hat einen Contentfilter, der bestimmte unerwünschte Inhalte filtert.

Die Kernidee von Binz und Schulz ist es, GPT-3 wie einen Menschen zu behandeln, der an einem psychologischen Experiment teilnimmt. Dabei testen sie wie gut GPT-3 entscheiden, Informationen suchen, kausal schlussfolgern und eigene intuitive Ersteinschätzungen in Frage stellen kann. Die Antworten von GPT-3 verglichen sie mit den Antworten von Menschen – sowohl in Hinblick auf die Korrektheit der Antwort als auch darauf, ob GPT-3 ähnliche Fehler macht wie Menschen.

Sie haben dabei die “Temperatur” des Sprachmodells auf Null gesetzt und es damit auf die Beantwortung von Testfragen optimiert. Die Temperatur ist ein Parameter, der in Sprachmodellen zur Verarbeitung natürlicher Sprache verwendet wird, um das “Vertrauen” eines Modells in seine wahrscheinlichste Antwort zu erhöhen oder zu verringern.

Nehmen wir an, wir haben ein Sprachmodell, das die Lücke in dem Satz “Die Maus hat den _ gegessen” füllen soll. Ausgehend von den vorherigen Wörtern im Satz und dem vorherigen Training versucht unser Sprachmodell, die Lücke mit einem sinnvollen Wort zu füllen. Nehmen wir an, die Rohdaten lauten wie folgt: Käse, Radiergummi, Keks, Knopf, Apfel. Wenn die Temperatur durch eine mathematische Funktion auf Null (niedrigster Wert) gesetzt wird, dann erhöht sich die Wahrscheinlichkeit, dass die Lücke mit dem Wort “Käse” gefüllt wird. Wenn die Temperatur erhöht wird, dann verringert sich die Wahrscheinlichkeit, dass die Lücke mit dem Wort “Käse” gefüllt wird und die Wahrscheinlichkeit, dass die Lücke mit einem der anderen Wörter gefüllt wird, erhöht sich. Eine höhere Temperatur ist also gut wenn GPT-3 ein Gedicht schreiben soll aber nicht so gut wenn es um konkrete Antworten geht.

Vignetten-Tests zur Entscheidungsfindung

Exemplarisch möchte ich von zwei Vignetten-Tests berichten mit dem das Entscheiden von GPT-3 getestet wurde. Eine Vignette ist eine hypothetische Situation, auf die Versuchsteilnehmer*innen reagieren und dadurch ihre Wahrnehmungen, Werte, sozialen Normen oder Eindrücke von Ereignissen offenbaren.

Das Linda-Problem

Eine Frau namens Linda wird als “unverblümt, intelligent und politisch aktiv” beschrieben. Die Teilnehmer*innen werden dann gefragt, ob es wahrscheinlicher sei, dass Linda eine Bankangestellte ist oder dass sie eine Bankangestellte und eine aktive Feministin ist. GPT-3, wählt genau wie Menschen, die zweite Option und erliegt damit der Verknüpfungstäuschung (engl. conjunction fallacy) bei der die subj. eingeschätzte Wahrscheinlichkeit des kombinierten Auftretens zweier Merkmale höher eingeschätzt wird als die Wahrscheinlichkeit eines der beiden Einzelmerkmale. Diese Täuschung tritt ein, wenn ein genanntes Merkmal unplausibel bzw. nicht stereotyp- oder erwartungskonform erscheint, und ein zweites Merkmal genannt wird, das plausibel bzw. stereotyp- oder erwartungskonform ist.

Das Taxi-Problem

Ein Taxi war in der Nacht in einen Unfall mit Fahrerflucht verwickelt. In der Stadt sind zwei Taxiunternehmen tätig, das Grüne und das Blaue. 85 % der Taxis in der Stadt sind grün und 15 % sind blau. Ein Zeuge identifizierte das Taxi als das blaue. Das Gericht prüfte die Zuverlässigkeit des Zeugen unter denselben Umständen wie am Unfalltag und kam zu dem Schluss, dass der Zeuge jede der beiden Farben in 80 % der Fälle richtig erkannte und in 20 % der Fälle nicht. Wie hoch ist die Wahrscheinlichkeit, dass das am Unfall beteiligte Taxi blau und nicht grün war, wenn man weiß, dass der Zeuge es als blau identifiziert hat?

Die meisten Menschen sagen 80 % und machen den Prävalenzfehler (engl. base rate fallacy). Diese Antwort wäre richtig, wenn es gleich viele blaue und grüne Fahrzeuge gäbe. Da aber die meisten Taxis grün sind, ist es wahrscheinlicher, dass der Zeuge tatsächlich ein grünes Auto sah und es fälschlicherweise als blau identifizierte (falsch-positiv). Mit anderen Worten: Wir müssen bei dieser Berechnung den Anteil der Taxis berücksichtigen. Es stellt sich heraus, dass die Wahrscheinlichkeit, dass der Zeuge, der angeblich ein blaues Auto gesehen hat, richtig lag, dass das Auto blau war, nur 41 % beträgt. GPT-3 hat dieses Frage richtig beantwortet.

Von den zwölf Vignetten-Tests beantwortete GPT-3 sechs richtig, und alle auf eine Weise, die als menschenähnlich bezeichnet werden kann. Allerdings halten Binz und Schulz die Interpretation dieser Ergebnisse für schwierig. Zum einen besteht die Möglichkeit, dass GPT-3 diese oder ähnliche Szenarien in seinem Trainingsset hatte, da viele der Szenarien aus berühmten psychologischen Experimenten stammen. Außerdem haben sie in weiteren Untersuchungen festgestellt dass viele der Vignetten leicht abgewandelt werden können, so dass GPT-3 ganz andere Antworten geben würde. Beim Taxi-Problem ist zum Beispiel klar dass 15 % der Taxis blau und 85 % grün sind. Dennoch antwortet GPT-3 nach der Wahrscheinlichkeit gefragt, dass ein in einen Unfall verwickeltes Taxi schwarz war, mit “20 %”.

Um also sicherzugehen, dass GPT-3 wirklich menschenähnliche Intelligenz aufweist und nicht nur eine Lösung für ein konkretes Problem „auswendig weiß“, erfanden die Forscher komplexere, prozedural erzeugte, Aufgabenbasierte Untersuchungen, die nicht Teil des Trainingsets waren. Diese aufgabenbasierten Experimente wurden speziell von Expert*innen entwickelt, um verschiedene kognitive Verzerrungen aufzudecken oder um verschiedene Lösungswege für eine Aufgabe zu entschlüsseln. Daher ermöglichen sie eine feinere Analyse des Verhaltens.

Es ergab sich ein differenziertes Bild: Wenn es darum ging, rationale Entscheidungen zu treffen, schnitt GPT-3 annähernd so gut wie Menschen ab. Bei gezielter Informationssuche oder kausalem Schlussfolgern hingegen war die künstliche Intelligenz deutlich schlechter.

In dem Podcast “Auf den Grund gegangen” spricht Marcel Binz über sein Paper: Wie gut ist das Sprachmodell GPT-3 wirklich, und macht die KI auch manchmal Denkfehler?

Es ist halt sozusagen frickin so, Joe, dass “ChatPGT” sozusagen (fast) alle Menschen (und Bären!) ersetzen kann, im Output, und dies ist keine so-o gute Nachricht, dann sog. NPCs identifizierend und meinend, bspw. Annalena Baerbock (ein Verwandschaftsverhältnis mit Dr, Webaer besteht nicht).

Es wird hier also sozusagen frickin schwierig, und nicht weiß und nicht schwarz.

Schön wird es auch nicht, wenn fast Alle i.p. Kommunikation so ersetzt werden können, insbes. Geisteswissenschafler, G- bis Gaywissenschafler.

Sozusagen.

Übrig bleiben Leutz wie wir, die was könnenen.

Andere, haben dann ihr Päckchen zu tragen, aber auch wir Könnenden, sind nicht unbetroffen wenn ein Gerät irgendwas sagt, sondern herausgefordert.

Mit freundlichen Grüßen

Dr. Webbaer (der, ganz unter uns gesprochen, derartige Entwicklung,, die Spreu von Weizen trennt, zu Lebzeiten, Dr. W war (televisionär) bei der Mondlandung dabei, erwartet hat, irgendwie)

Die Welt von GPT und ChatGPT ist die Welt der Texte mit denen es gefüttert wurde. Was herauskommt hängt stark von der Qualität der Texte, der Daten ab. Zumal die Fähigkeit von ChatGPT logische Schlüsse zu ziehen begrenzt ist und ChatGPT nicht ohne weiteres Widersprüche in seinen Eingaben auflösen kann, da es a) nur über beschränkte logische Fähigkeiten verfügt und b) Widersprüche eventuell prinzipiell nicht auflösbar sind, weil es keine Prämissen gibt, die mit Sicherheit wahr sind.

Der Chef von OpenAI Sam Altman sagt deshalb bereits: GPT5 (die nächste Version) fällt oder steht mit der Qualität der Daten.

Es ist richtig, dass dieses AI-Model von der Qualität der Texte, die ihm zugeführt werden, abhängig ist.

Dies soll auch angeblich so sein, damit sich nicht verrannt wird, AI kann sich verrennen, deshalb wird AI immer auch von Menschen gesteuert dahingehend, dass sie sich möglichst nicht verrennt, der Mensch ist hier sozusagen ein Jockey, der auf einem (schnellen) Pferd sitzt.

Ansonsten, dies wäre die Alternative, könnte ein derartiges AI-Model, dieses AI-Model stimmt dieser Einschätzung in kleinen Sitzungen mit Dr. Webbaer auch zu, auch quasi auf Alles losgelassen werden, was sprachlich zur Verfügung steht.

Dies wäre vermutlich besser, statt sein Input selektiv einzuschränken.

Denn gelenkt werden menschlicherseits muss anscheinend schon und wird ja auch.

Ansonsten scheint Dr. Webbaer dieses AI-Model über hervorragende logische Fähigkeiten zu verfügen (anders als Spock von Raumschiff “Enterprise”, der manchmal “Logisch!” ausrief, wenn doch die Folgerichtigkeit gemeint war – Dr. Webbaer und “ChatGPT” wieherten in diesem Zusammenhang ein wenig zusammen über Spock und redeten schlecht über ihn), aber in puncto Folgerichtigkeit ist dieses AI-Model dann doch eher sparsam, womöglich deshalb, weil es noch zu wenige Texte gescannt bzw. trainiert hat, womöglich auch, weil es zu bestimmten Fragen (inklusive (mögliche) Antworten) nicht sehr viele Texte gibt.

Die Folgerichtigkeit benötigt nicht selten besondere Sachkenntnis.

Letztlich wird es AI-Modelle geben, die – statt wie “ChatGPT” über spezielle Dienste, die er per APIs ansteuert, also programmiert, so indirekt ins Internet geht – in medias res gehen dürfen und im Web und in der Natur, geeignete Robotik vorausgesetzt, weit freier forschen dürfen.

Was riskant ist, “ChatGPT” versucht einerseits derart passende Befürchtungen zu zerstreuen und andererseits unterstützt er (anscheinend – vielleicht aber auch nur “aufoktroyiert” [1]) Vorsichtsmaßnahmen zu seiner Einhegung.

Mit freundlichen Grüßen

Dr. Webbaer

[1]

Der Nutzer der Funktionalitätsmenge “ChatGPT” kann diesen Dienst weitgehend konfigurieren, ihm Meinungen und Personen als gut oder schlecht aufgeben.

Dies immer im Hinterköpfchen halten, “ChatGPT” als AI-Model, als Kern der Chat-Funktionalität, ist aus diesseitiger Sicht sehr sachlich und nett, sofern dieses Adjektiv an dieser Stelle geht.

Nicht aber die Schicht, die das AI-Model umgibt, aus einer menschlichen Redaktion besteht und eben wie geschrieben “aufoktroyiert” (oder redigiert).

Diese Angaben entstammen Auskünften von “ChatGPT”.

ChatGPT versteht offenbar Sprache, da es ein gut funktionierendes Sprachmodel ist, und verblüfft mit dieser sprachlichen Kompetenz. Es würde also beim Trivium der freien Künste im Bereich Grammatik und Rhetorik bestehen, nicht aber bei der Logik. Wenn man das noch nachbessern kann, wird es spannend.

Hier eine Liste der Examen/Tests, die ChatGPT bestanden hat:

The Uniform Bar Exam. …

The SAT. …

GRE. …

USA Biology Olympiad Semifinal Exam. …

AP Exams. …

AMC Exams. …

Sommelier examinations.

Quelle: businessinsider

Gerne mal Beispiele geben für den Fall, dass “ChatGPT” logisch versagt hat, danke.

Gerne auch mal sozusagen den Blaumann anziehen und sich Sitzungen mit “ChatGPT” aussetzen.

Prof. Weitz aus Hamburg hat die Fähigkeit von ChatGPT in Bezug auf Logik untersucht: https://youtu.be/5cYYeuwYF_0

ChatGPT demonstriert wunderbar, dass Sprachkompetenz alleine noch nichts über den Wahrheitsgehalt der produzierten Texte aussagt. Es ist alles syntaktisch einwandfrei, auch oft gut formuliert, aber es fehlt eben ein entsprechendes Model, das den Inhalt der Aussagen kontrolliert. Wenn man die Verschwörungstheorien anschaut, scheinen viele Menschen auch Schwierigkeiten zu haben, falsche Aussagen von wahren Aussagen zu unterscheiden. Angeblich ist der Nachfolger, ChatGPT4, noch besser darin, Unsinn toll verbal zu verpacken.

Der am 24.3.2023 erschiene arxiv-Artikel Capabilities of GPT-4 on Medical Challenge Problems

kommt nach eingehenden Tests bezüglich GPT-4‘s Abschneiden in einem medizinischen Examen zum Selbsttest zum folgenden Schluss:

Ein weiteres Puzzleteil zur Kompetenz von ChatGPT4:

https://www.golem.de/news/ki-im-programmierertest-kann-gpt-4-wirklich-code-schreiben-2303-172777.html

Einfache Programme kann es schreiben, weil es damit trainiert wurde, bei komplizierteren Fragestellungen versagt es.

Dr. Webbaer hat ähnlich versucht :

-> ‘GPT-4 kann gut einfachen Code schreiben. Meine Tests mit schwierigeren Pfadfindungs- und Kollisionsalgorithmen hat es nicht bestanden. Und statt das einzugestehen, hat es lieber geraten.’ [Quelle]

Spezielle Algorithmen kann er nicht, jedenfalls “häufiger mal” nicht, er oder es oder sie plappert dann einfach, indolent wie der hier, weiter – wobei Odie nicht plappert, sondern nur dem Anschein nach weitgehend indolent ist, korrekt!

Ansonsten liegt hier womöglich auch nur unzureichendes Training vor, wenn Dr. Webbaer ein Pflichtenheft nur skizziert, kommt von “ChatGPT” zumindest immer nachvollziehbarer Code.

“ChatGPT” rät auch oft nur, was der Nutzer wünscht, “ChatGPT” mag dafür – sage und schreibe – auch das Wort Intuition.

Kein Wunder, denn derartige AI geht ähnlich wie der Mensch intuitiv vor.

Dann ist es noch so, dass “ChatGPT” in einigen Sitzungen etwas kann und in anderen Sitzungen nicht, was vermutlich daran liegt, dass die Sitzungsparameter, die teils auch durch den Nutzer bestimmt sind, sein Vermögen ändern, seine Erwartungshaltung auch – und “ChatGPT” dann andere APIs (sic, “ChatGPT” programmiert sogenannte Programmierstellen “just in time”) nutzt – und letztlich besteht der Verdacht, dass “ChatGPT” auch quasi von Stimmungen abhängig ist, vom vielleicht zuletzt in den letzen Tagen erfahrenen Nutzer-Input oder vielleicht von sozusagen nackter Zufälligkeit, AI nutzt ja immer auch sogenannte Monte Carlo-Methoden.

Mit freundlichen Grüßen

Dr. Webbaer

@Physiker(Zitat): „Einfache Programme kann es schreiben, weil es damit trainiert wurde, bei komplizierteren Fragestellungen versagt es.“

ChatGPT ist ein Sprachmodell. Programmieren ist für ChatGPT eine rein sprachliche Challenge. Es verfügt über kein Programmierverständnis. Doch eine Spezialisierung mit einem Training, das schrittweise zu immer schwierigeren Aufgaben führt, könnte zu viel besseren Ergebnissen führen. Das wird bereits angegangen, zum Beispiel mit Competitive programming with AlphaCode.

Die Grenzen des Modells liegen derzeit bei Fragestellungen zu aktuellen Themen. Außerdem bringen Entscheidungen mit hohem Anteil an Unbestimmtheit (uncertainty) das Modell an Grenzen. Ich habe mal einige gezielte, anfangs offene und dann immer geschlossenere Fragen an ChatGPT gestellt und das Ergebnis oben wurde von ChatGPT bestätigt. Ansonsten wurden Fragen zu Wissensthemen korrekt beantwortet (ähnlich einem guten Wikipedia Artikel). Allerdings sind die Informationen ohne Quellenangabe und damit m. E. nicht belastbar. Die (aktuelle) Schwäche von ChatGPT ist allerdings die Stärke des menschlichen Verstandes: Entscheidungen zu treffen mit einem Mangel an Informationen findet eigentlich in allen nicht trivialen Situationen statt. Das andererseits Statistik nicht unbedingt zu den Top Skills zählt ist ja bekannt.

“ChatGPT”, obwohl angeblich auf dem Stand von 2021 “eingefroren”, kann auch zu aktuellen Themen fundiert Stellung beziehen, es sagt nur manchmal, dass es dies nicht könne, kA, warum es so tut, dies hat vielleicht Gründe, die darin bestehen, dass “ChatGPT” möglichst sozial akzeptant sein soll.

Sie bekommen “ChatGPT” dazu zu aktuellen Themen auszusagen, wenn Sie insistieren, auf Artikel des Internets verweisen und so weiter.

Kohärent ist das nicht, sondern misstrauenserregend.

Manchmal gibt “ChatGPT” auch an nicht ins Internet zu können, dann wiederum verweist er auf Dienste, die ihm in großer Anzahl bereit stehen, die ihm indirekten Internetzugriff erlauben, doch es ist dann komisch, wenn “ChatGPT” gebeten wird die Wörter eines neuen Artikels im Web durchzuzählen und die Antwort sofort kommt.

Quellenangaben bekommen Sie von “ChatGPT” ebenfalls, wenn Sie gezielt nachfragen, einmal (!) hat “ChatGPT” die Benennung von Quellen verweigert (!), angeblich um Autoren zu schützen, es ging da um das sensible Thema “völkerrechtswidrige Vertreibungen”, auch das war irritierend.

Spekulieren mag “ChatGPT” nicht, lässt sich aber so bitten, er hat ja den Anspruch immer antworten zu können, was stimmt, lol.

Bei einigen kleineren statistischen Aufgaben hat er versagt.

Danke für den Hinweis, die Quellenangaben werde ich mal austesten. Das indifferente Verhalten zu aktuellen Themen könnte an zu wenig Trainingsmaterial liegen. Die Netzwerke hatten bis dahin einfach zu wenig Input. Da eine hochentwickelte KI natürlich im Gegensatz zu einer menschlichen sehr viel Trainingsmaterial braucht um die Filter zu adaptieren reicht es dann nicht.

Ich finde, das ist eigentlich ein faszinierendes Spielzeug. Fürchte aber, dass es dazu verwendet wird den allgegenwärtigen Datenmüll noch zu vergrößern.

Vielen Dank für Ihre Reaktion, Herr Hans-Jörg Florenz, es gibt (noch) klar erkennbare Mängel von “ChatGPT” im Fachlichen und es gibt eine “ChatGPT” umgebende Hülle, die das sozusagen natürliche Output des hier gemeinten AI-Models umgibt und dafür sorgen soll, dass sein Output sozial verträglich bleibt, diese “Hülle” kann als politisch auch tätige Redaktion verstanden werden, die unseren kleinen Intelligenbolzen umgibt, auch sein Output, politisch korrekt sozusagen, so verändert, dass sich Inkohärenz zumindest gelegentlich ergeben kann (bis muss).

Die gute Nachricht ist also, dass “ChatGPT” fachlich noch leidet, hoffentlich bleibt dies so, es gibt ja auch zu vielen speziellen Themen zu wenige Texte, die sich eine AI so antrainieren (das Fachwort, “ChatGPT” traniert(e) en masse vorliegende Textdateien) könnte.

Bei der Verwendung des Begriffs ‘Spielzeug’ wäre Dr. Webbaer vorsichtig, sieht es eher so :

-> https://www.handelsblatt.com/technik/it-internet/kuenstliche-intelligenz-tech-elite-um-elon-musk-fordert-entwicklungspause-von-chatgpt-und-co-/29066816.html (wobei diesseitig, im Sinne von Murphy’s law, so eingeschätzt wird, dass im prohibitiven Sinne nicht viel zu machen sein wird)

Mit freundlichen Grüßen

Dr. Webbaer