Fritz Vahrenholt und Sebastian Lüning beharren auf Abkühlung

BLOG: KlimaLounge

Abkühlung vorhergesagt, aber die globale Temperatur eilt von Wärmerekord zu Wärmerekord? Wenn Klimaleugner nicht mehr weiter wissen, weil die Messdaten partout nicht zu ihren Thesen passen, greifen manche zur Ultima Ratio: dem Bestreiten und Diskreditieren der Messdaten.

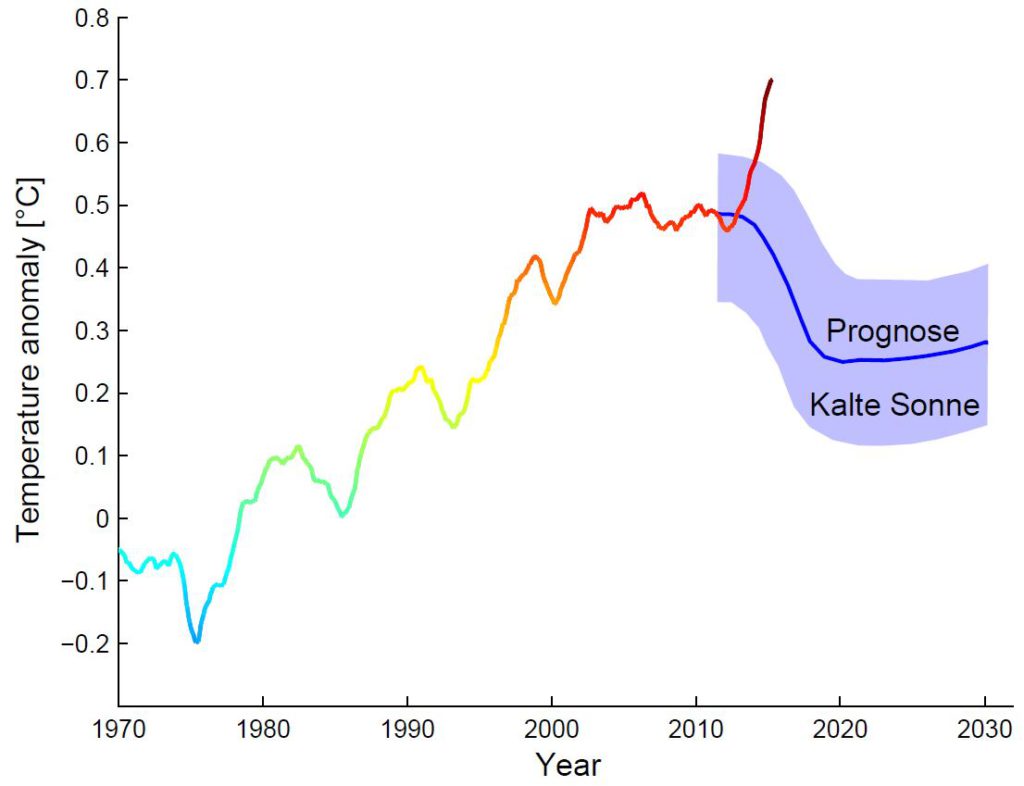

Fritz Vahrenholt und Sebastian Lüning (beide ehemals beschäftigt bei Europas größtem CO2-Emittenten, RWE) führen seit Jahren einen Kreuzzug gegen Klimaschutz. Dazu gehört das Verbreiten von #Fakenews wie „Grönland war im Mittelalter fast eisfrei“ oder die Prognose einer kurz bevorstehenden globalen Abkühlung. Leider ignoriert das Klima solch pseudowissenschaftliche Prognosen, die auch gar nicht erst in der Fachliteratur publiziert werden sondern nur das staunende Laienpublikum beeindrucken sollen. Die Jahre 2014 und 2015 erreichten neue Rekorde in der globalen Temperatur, und 2016 wird das wieder tun. Drei Wärmerekorde in drei aufeinanderfolgenden Jahren – das gab es seit Beginn der Messreihen im Jahr 1880 noch nie.

Im September hatte ich in einer Grafik die Kalte-Sonne-Prognose von Vahrenholt und Lüning mit den NASA-Messdaten verglichen. Dieser Vergleich fiel, sagen wir, ein wenig unvorteilhaft für die Prognose aus. Als Antwort präsentieren Vahrenholt und Lüning nun eine interessante Verschwörungstheorie auf der US-amerikanischen Klimaskeptiker-Website WUWT. Dort versuchen sie die Diskrepanz zwischen Messdaten und ihrer Prognose damit zu erklären, dass das renommierte Goddard Institute for Space Studies der NASA die Messdaten verändert hat.

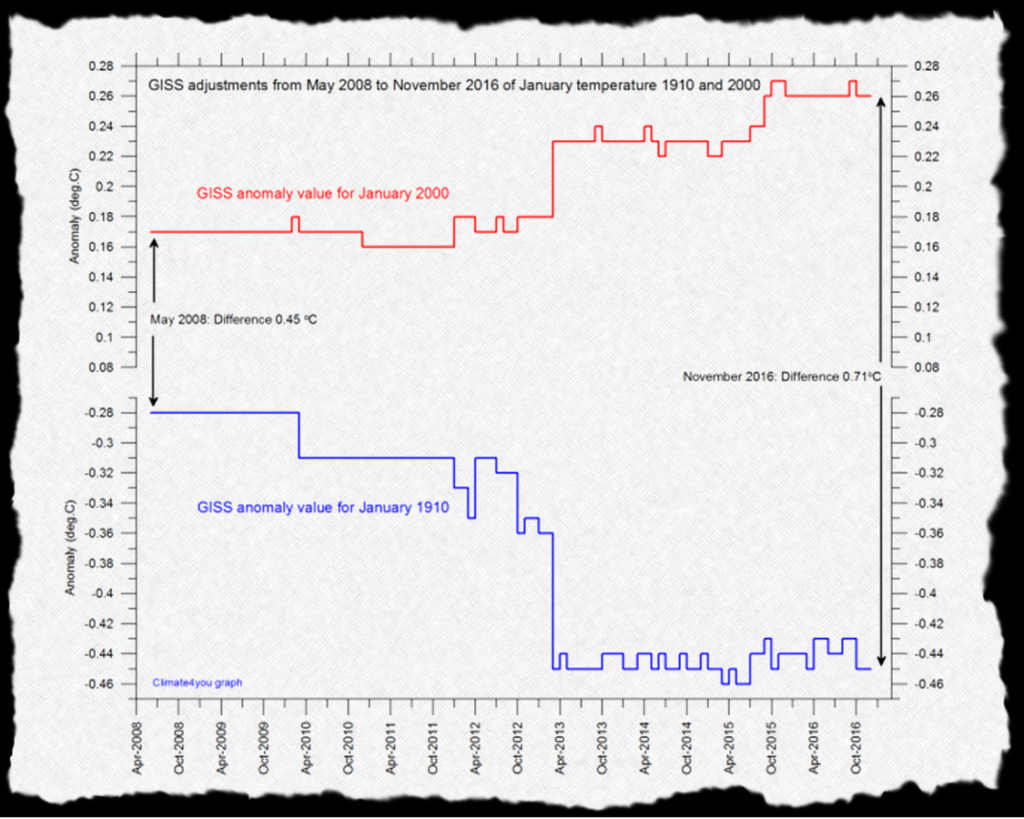

Zum Beleg präsentieren sie die folgende Grafik, die sehr schön gleich zwei der Lieblingstricks der Klimaleugner illustriert: Rosinenpickerei und täuschende Trickgrafiken.

Abb. 1 Versionsgeschichte von zwei einzelnen Monatswerten, Januar 1910 und Januar 2000, in den globalen Temperaturdaten der NASA. (Quelle: WUWT)

Abb. 1 Versionsgeschichte von zwei einzelnen Monatswerten, Januar 1910 und Januar 2000, in den globalen Temperaturdaten der NASA. (Quelle: WUWT)

Haben Sie beim Betrachten der schwarzen Pfeile vielleicht auch den Eindruck, die 0,71 °C Temperaturdifferenz sei überwiegend durch Datenkorrekturen entstanden? Weit gefehlt – erkennen Sie den Trick? In der senkrechten Achse fehlen in der Mitte ganze 0,3 °C! Die Korrektur beträgt in Wahrheit nur 0,26 °C. Auch das ist viel – weil es ein Extrembeispiel ist. Der gezeigte Januar 1910 ist der Monat mit der zweitgrößten Korrektur nach unten, gezielt herausgepickt aus den 1.643 Monaten der Datenreihe.

Warum gibt es überhaupt solche Korrekturen? U.a. durch Hinzufügen weiterer historischer Datensätze, die aus verschiedenen Weltteilen digitalisiert werden, und durch Korrekturen für Veränderungen in den Messmethoden – so waren Thermometer früher oft nicht gut gegen die Sonne geschützt. Mehr dazu in diesem Blogartikel von Victor Venema von der Uni Bonn, einem führenden Fachmann für die Datenhomogenisierung.

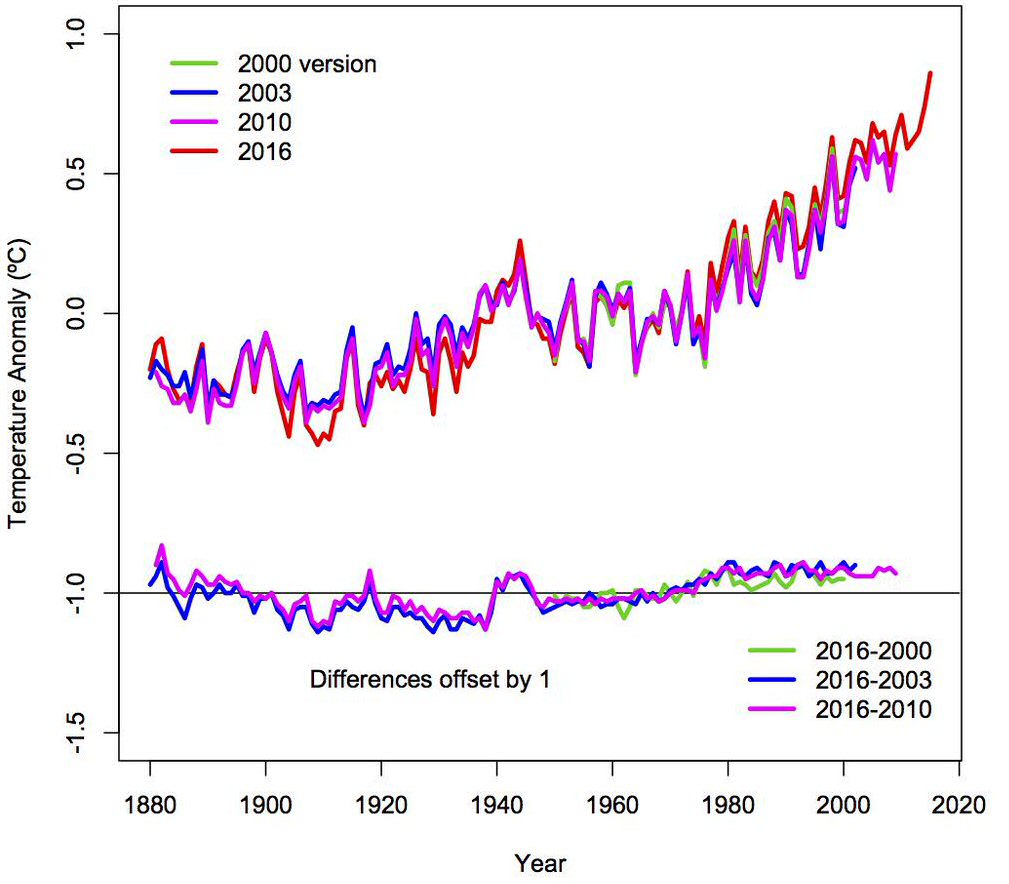

In den Jahresmittelwerten, und vor allem für die Klimaentwicklung nach dem 2. Weltkrieg, sind die Korrekturen minimal, wie die folgende Grafik zeigt:

Abb. 2 Versionsgeschichte des globalen Temperaturdatensatzes der NASA. Auch hier sieht man, dass im Jahr 1910 die größte Korrektur anfällt. (Quelle: Goddard Institute for Space Studies)

Abb. 2 Versionsgeschichte des globalen Temperaturdatensatzes der NASA. Auch hier sieht man, dass im Jahr 1910 die größte Korrektur anfällt. (Quelle: Goddard Institute for Space Studies)

Diese Grafik muss jedem bekannt sein, der mit den NASA-Daten arbeitet, denn sie ist bei den Erläuterungen zu den Daten auf der NASA-Website mit dabei (sogar interaktiv). Im Übrigen hat der Direktor des Goddard Institute for Space Studies, Gavin Schmidt, die irreführende Darstellung in Abb. 1 schon im vergangenen März auf Twitter zurückgewiesen. Doch Vahrenholt & Co verlieren kein Wort darüber, dass Abb. 1 ein Extrembeispiel ist und wie das Gesamtbild aussieht. Dies ist nur ein weiterer Beleg dafür, dass es diesen Autoren nicht darum geht, ihr Laienpublikum in der Sache aufzuklären. Sondern darum, es für dumm zu verkaufen.

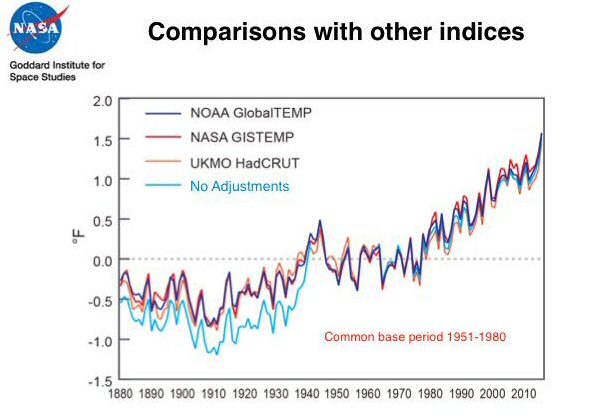

Auch der gern geweckte Eindruck, dass die NASA die Erwärmung nach oben korrigiert um die globale Erwärmung zu übertreiben, wird durch die Fakten ad absurdum geführt: der Nettoeffekt der Datenkorrekturen verringert nämlich die globale Erwärmung. Das belegt die nächste Grafik.

Abb. 3 Die NASA-Daten der globalen Temperatur im Vergleich zu den unkorrigierten Rohdaten (hellblau) und zwei globalen Temperaturdatensätzen anderer Institute. (Quelle: Goddard Institute for Space Studies)

Abb. 3 Die NASA-Daten der globalen Temperatur im Vergleich zu den unkorrigierten Rohdaten (hellblau) und zwei globalen Temperaturdatensätzen anderer Institute. (Quelle: Goddard Institute for Space Studies)

So oder so haben die Datenkorrekturen der NASA nicht das Geringste mit der Fehlprognose von Vahrenholt und Lüning zu tun – sie bleibt falsch, egal welche Datenversion man nimmt. Fritz Vahrenholt, einst Umweltsenator in Hamburg, dann als Topmanager von RWE Millionen verdient: sein Abstieg in eine Schmuddelecke des Internets, zu Anthony Watts‘ Sektiererblog WUWT, ist ebenso verblüffend wie unverständlich. WUWT, wo klimawissenschaftliche Laien sich und ihrer Echokammer wissend zuraunen: am CO2-Anstieg sind nicht etwa fossile Energien, sondern Insekten Schuld! Die globale Erwärmung liegt am Atomreaktor im Erdkern! Die Erwärmung der Antarktis kommt von der Abwärme der dort lebenden Menschen („waste heat from little pockets of humanity“)! Der grönlandische Eisschild kann höchstens 650 Jahre alt sein! (Logisch, wie hätten die Wikinger dort auch sonst Ackerbau betreiben können?) Die NASA manipuliert Klimadaten! Hand aufs Herz, Herr Prof. Vahrenholt, was meinen Sie: hat die NASA auch die Mondlandung nur fingiert?

Zurück zur Abkühlungsprognose

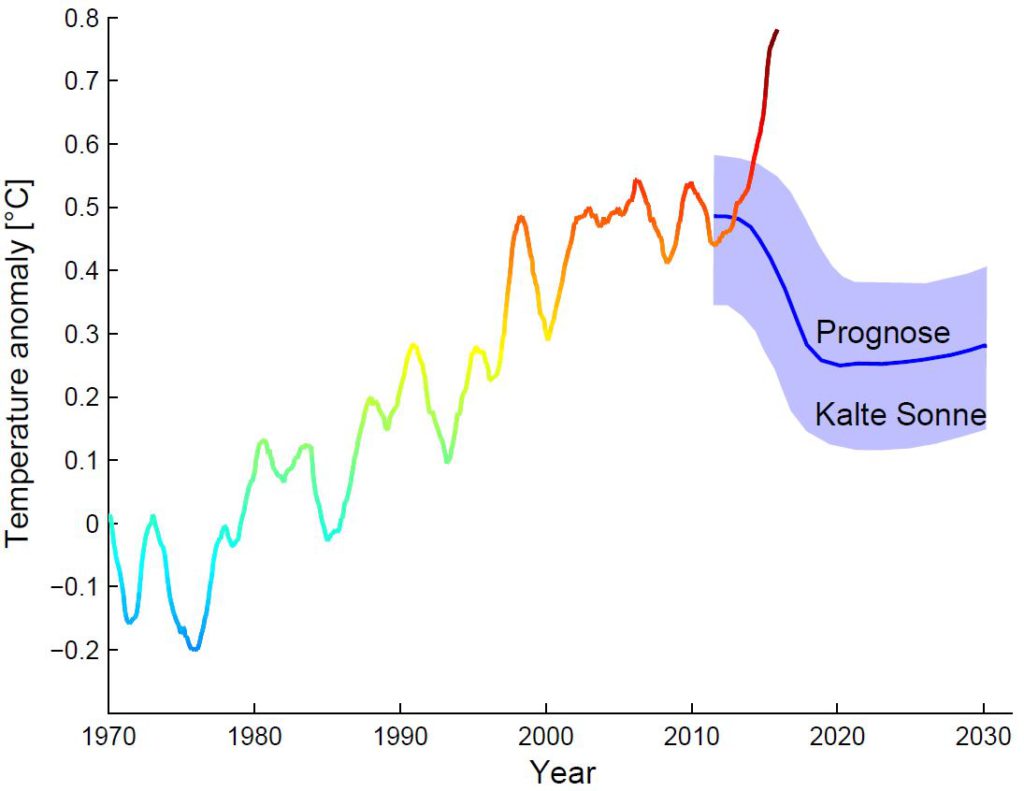

Doch lassen wir die NASA-Daten beiseite und messen wir die Prognose von Vahrenholt und Lüning doch an ihrem eigenen Maßstab. Nehmen wir die Daten, die sie selbst in ihrer Prognosegrafik in Die Kalte Sonne verwenden: die globalen Temperaturen des britischen Wetterdienstes, über 23 Monate gleitend gemittelt. An diese Datenkurve schließt die Prognose in ihrem Buch an. Und so sieht der Vergleich mit diesen Daten bis heute aus:

Abb. 4 Die “Kalte Sonne” Prognose von Vahrenholt und Lüning im Vergleich mit den globalen Oberflächentemperaturen des britischen Wetterdienstes (HadCRUT Daten), gleitend gemittelt über 23 Monate bis einschließlich Oktober 2016. Grafik: Prof. Stefan Rahmstorf, Creative Commons BY-SA 4.0.

Abb. 4 Die “Kalte Sonne” Prognose von Vahrenholt und Lüning im Vergleich mit den globalen Oberflächentemperaturen des britischen Wetterdienstes (HadCRUT Daten), gleitend gemittelt über 23 Monate bis einschließlich Oktober 2016. Grafik: Prof. Stefan Rahmstorf, Creative Commons BY-SA 4.0.

Hmm. Immer noch nicht so überzeugend für die Kalte-Sonne-Prognose.

Also haben Vahrenholt und Lüning in ihrer neuen Prognose Grafik gleich drei Tricks angewandt, die die Diskrepanz von Daten und Prognose verringern.

- Sie nehmen jetzt nicht mehr das gleitende Mittel über 23 Monate sondern über 37. Das verringert die beobachtete Erwärmung seit 2011 (dem Start ihres Prognosezeitraums) bis zum Ende der Datenkurve schon mal von 0,34 auf 0,22 Grad.

- Sie nehmen jetzt nicht mehr die oberflächennahen Temperaturen, sondern Satellitendaten für die Troposphäre (RSS-Daten). Über die Probleme dieser Daten könnte man viel sagen – das überlassen wir am besten dem leitenden Wissenschaftler hinter den RSS-Daten, Carl Mears, der in diesem Video selbst erklärt, weshalb die Bodendaten genauer sind. Vor allem aber sind für uns Menschen nur die bodennahen Temperaturen unmittelbar relevant. Wir leben nun mal an der Erdoberfläche und nicht in Höhenballons. Dass Vahrenholt und Lüning von den ursprünglich in ihrem Buch gezeigten Bodendaten jetzt auf einmal zu den weniger genauen und kaum relevanten Troposphärendaten wechseln, kann eigentlich nur einen Grund haben: das lässt ihre Prognose weniger daneben aussehen. Konkret schrumpft die Erwärmung dadurch weiter von 0,22 auf 0,13 Grad.

- Die Prognosekurve schließt in ihrer neuen Grafik in 2011 nicht mehr an die Messdatenkurve an, sondern ist schon zu Beginn ein Stück nach oben verschoben – damit laufen die Daten dann am Ende nicht so weit nach oben aus dem Prognose-Intervall heraus.

Doch selbst mit diesen drei Veränderungen gegenüber der ursprünglichen Prognosegrafik in Die kalte Sonne gelingt es Vahrenholt und Lüning nicht zu verhindern, dass die Messdaten in ihrer neuen Grafik aus ihrem Prognose-Intervall hinaussteigen. Sie entschuldigen das damit, dass der letzte Monatswert ja haarscharf wieder an den obersten Rand des Intervalls zurückkehrt – was allerdings irrelevant ist, weil diese Prognose ja nicht für einzelne Monate gilt, die immer stark streuen.

Der zweite Schritt alleine – nur auf die Satellitendaten zu wechseln – hätte übrigens wenig gebracht: nur eine Reduktion von 0,34 auf 0,30 Grad. Man ahnt: deshalb haben Vahrenholt und Lüning zusätzlich den Glättungszeitraum von zwei auf drei Jahre verlängert. Aber akzeptieren wir diesen längeren Zeitraum dennoch einmal als fachlich legitime Wahl – die Prognose gilt ja für die mittelfristige Entwicklung des Klimas und nicht die kurzfristigen Schwankungen, sodass man letztere durch Glättung herausfiltern kann. Dabei über rund drei Jahre zu mitteln statt nur über zwei beseitigt den Einfluss von El Niño-Schwankungen noch wirkungsvoller. Mit den 37 Monaten Glättungsperiode sieht der Vergleich dann so aus:

Abb. 5 Die “Kalte Sonne” Prognose von Vahrenholt und Lüning im Vergleich mit den globalen Oberflächentemperaturen des britischen Wetterdienstes (HadCRUT Daten), gleitend gemittelt über 37 Monate. Grafik: Prof. Stefan Rahmstorf, Creative Commons BY-SA 4.0.

Abb. 5 Die “Kalte Sonne” Prognose von Vahrenholt und Lüning im Vergleich mit den globalen Oberflächentemperaturen des britischen Wetterdienstes (HadCRUT Daten), gleitend gemittelt über 37 Monate. Grafik: Prof. Stefan Rahmstorf, Creative Commons BY-SA 4.0.

Das falsifiziert allerdings immer noch klar die Abkühlungsprognose von Vahrenholt und Lüning.

Was nun? Vielleicht hören wir bald eine neue Verschwörungstheorie von diesen beiden Helden der Klimawissenschaft: nicht nur die NASA, sondern auch der britische Wetterdienst manipuliert seine Daten, um die Abkühlung zu vertuschen?

Fazit

Ich habe dieses Beispiel hier genauer besprochen, weil es exemplarisch für die Methoden der sogenannten „Klimaskeptiker“ ist und konkret illustriert, was ich in meinem letzten Beitrag über #fakenews und Propaganda geschrieben habe. Leute wie Vahrenholt und Lüning bauen darauf, dass ein Laie ihre diversen Tricks nicht bemerkt – und auch nicht die systematische Verdrehung dessen, was in der Fachliteratur steht. Ein Außenstehender kann das letztlich auch kaum bemerken, es sei denn er arbeitet sich selbst sehr intensiv in die verfügbaren Daten und Fachliteratur ein. Die von mir am Ende des letzten Artikels genannten Kriterien hätten aber auch einem Laien klare Hinweise auf die mangelnde Glaubwürdigkeit gegeben: die Quelle ist eine „Klimaskeptiker”-Website, es stehen keine Forschungseinrichtung und keine professionellen Klimaforscher hinter diesen Thesen, und es gibt keine Fachpublikation mit der „Kalte-Sonne-Prognose“, sondern sie richtet sich ausschließlich an ein Laienpublikum.

Ähnlich wie im professionellen Journalismus gibt es in der professionellen Wissenschaft mehrere Stufen der Qualitätssicherung. Eine langjährige Ausbildung, die Methoden und Ethos vermittelt (wie die Suche nach Wahrheit und das stetige Hinterfragen der eigenen Annahmen). Die Standards der guten wissenschaftlichen Praxis (deren Nichteinhaltung, etwa durch Manipulation von Daten, einen Wissenschaftler um Job und Zukunft bringen kann.) Die Reputation als höchstes Gut des Wissenschaftlers und seiner Forschungseinrichtung, die schnell verloren geht, wenn er Falsches behauptet. Der „peer review“, also die Begutachtung der Fachpublikationen (und auch Institute) durch unabhängige Dritte (meist Konkurrenten). Und nicht zuletzt die u.a. auf Konferenzen ständig gelebte Kultur der kritischen, offenen Debatten, durch die viele Probleme oder Fehler rasch erkannt werden.

Nichts davon ist allein unfehlbar, und auch professionelle Wissenschaftler machen manchmal Fehler. Deshalb sollte man auch nicht jede Einzelaussage eines Wissenschaftlers unbedingt glauben, auch nicht jeder Fachpublikation, sondern sich am Gesamtbild orientieren. Nicht umsonst machen sich alle paar Jahre wieder hunderte Klimaforscher aus aller Welt freiwillig und unentgeltlich die Mühe, die Fachliteratur zu sichten und zu debattieren und den Kenntnisstand in den Berichten des Weltklimarats IPCC zusammenzufassen. Zu den Grundtatsachen der globalen Erwärmung gibt es seit langem einen überwältigenden Konsens von mindestens 97%. Wer ernsthafte, begründbare Gegenargumente hätte könnte damit rasch berühmt werden – ein Platz in den Top-Journalen Nature, Science oder PNAS wäre ihm sicher. Die Wahrscheinlichkeit, dass man ausgerechnet auf einer schrillen Laien-Website die wissenschaftliche Sensation findet, ist unendlich viel kleiner als die, dass man dort schlicht an der Nase herumgeführt wird.

Weblinks

Klimafakten.de: Wie redlich ist Fritz Vahrenholts Buch “Die kalte Sonne”?

RWE Manager Vahrenholt zum Klima

In eigener Sache. Die KlimaLounge macht vom 24. Dezember bis 1. Januar Weihnachtspause (keine Kommentarfreischaltung). Wir wünschen allen Lesern friedvolle und erholsame Weihnachtstage!

Klimawandel ja oder nein, mir scheint, dieses Thema wird zwar kontrovers diskutiert, aber wen betrifft das?

Mich nicht, ich fahre weiterhin mit einem Verbrennungsmotor, die Automobilindustrie nicht, die produziert weiterhin immer schwerere Autos, Donald Trump nicht, der kündigt die Klimaschutzabkommen, Die Braunkohleindustrie nicht. Das ist die Realität.

Findet jemand eine optimistischere Sicht?

Herr Rahmstorf, Herr Vahrenholt hat sich bzgl. des eisfreien Grönlands im Mittelalter lediglich versprochen. Richtig wäre, die Küstenregionen, an denen die Wikinger siedelten, waren eisfrei. Das zeigen die Siedlungen der Wikinger, die immer noch heute unter den weichenden Gletschern an der Küste hervortreten.

Und das wir in den letzten Jahren neue Temperaturrekorde zu verzeichnen haben, liegt vor allem an den El-Nino-Ereignis der letzten Jahre. Dieses klingt derzeit ab, die Temperatur fällt in der Satellitendaten gerade so schnell wie noch nie seit Aufzeichnungsbeginn.

Und die Satellitendaten zeigen seit dem letzten großen El-Nino-Ereignis von 1998 keinen signifikanten Temperaturanstieg:

http://woodfortrees.org/plot/rss/from:1997/plot/rss/from:1997/mean:12/plot/rss/from:1997/mean:12/trend

Die Satellitendaten decken wie gesagt den Globus am besten ab und messen den Atmosphäreneffekt. Denn der Treibhauseffekt ist kein Bodeneffekt, sondern ein Atmosphäreneffekt. Die Erwärmung durch Treibhausgase zeigt sich zuerst in der Atmosphäre, vor allem über den Tropen. Hotspot. Der Boden erwärmt sich ganz zuletzt.

MfG

Michael Krüger

Was ist der Beleg, dass Herr Vahrenholt sich versprochen hat? Ich habe bei dem Journalisten, der das Interview geführt hat, damals extra nachgefragt: Herr Vahrenholt hat den Wortlaut des Interviews genau so schriftlich autorisiert.

@Michael Krüger;

Es ist schon ärgerlich, mit welcher Penetranz Sie unsinnige Behauptungen alias Fakenews verbreiten. El-Nino-Ereignisse hat es schon immer gegeben, auch stärkere. Das heißt, diese Ereignisse sind in den historischen Temperaturdaten bereits enthalten und liefern daher kein Argument für Temperaturskepsis. Aus Wiki:

Der Treibhauseffekt wird hauptsächlich in der Luftschicht an der Erdoberfläche als Erwärmung wirksam, infolge der Gegenstrahlung. Das wird durch die realen Temperaturmessungen bestätigt. Dass der Anstieg der Temperatur nicht überall und nicht immer gleichmäßig erfolgt, das ist trivial. Ihre Einwände sind unbegründet und völlig irrelevant.

Warum soll man nur die Satellitendaten nehmen. Die sind nicht so genau und der Treibhauseffekt entfaltet seine Wirkung am meisten nah an der Erdoberfläche. Außerdem liegt Vahrenholt mit seiner Prognose auch mächtig daneben, selbst wenn man nur die Satellitendaten nimmt. Des weiteren operiert der Kohlefreund mit getricksten Grafiken und selektiert auf einen Januar im Jahr 1910 mit der zweitgrößten Korrektur nach unten, wo doch die Datenreihe 1.643 Monate hat, worüber Sie sich bis jetzt auch ausschweigen.

Die Temperatur fällt laut der Satellitendaten so schnell wie noch nie seit Aufzeichnungsbeginn?

https://wobleibtdieglobaleerwaermung.files.wordpress.com/2016/11/uahspencergrafikoktober2016vergleich1998zu2016-e1478009045222.jpg?w=720&h=426&crop=1

Kann ich so nicht erkennen.

Und das wir in den letzten Jahren neue Temperaturrekorde zu verzeichnen haben, liegt vor allem an den El-Nino-Ereignis der letzten Jahre? Oder ist es so, dass der Klimawandel El-Ninos stärker macht?

http://www.scinexx.de/wissen-aktuell-16341-2013-07-01.html

Sehr geehrter Herr Krüger, wenn die aktuellen Temperaturrekorde wie Sie sagen auf den El-Nino-Effekt zurückzuführen sind, wirft das die Frage auf, ob es früher auch solche Phänomene gab und -wenn ja, warum die rezenten 2-3 El-Nino Jahre wärmer waren als El-Nino-Jahre vergangener Zeiten…

Nehmen wir das Jahr 1998 als Beispiel, ein Jahr mit starkem El-Nino-Effekt, das seinerseits alle vorangegangenen bekannten El-Nino-Jahre hinsichtlich der gemessenen (!) Temperatur in den Schatten stellte. Die damalige Globaltemperatur bzw. Rekordtemperatur wird im nun ausgehenden Jahr um ca. 0,4 K übertroffen werden, der Anstieg ist erheblich, fast ein halbes Grad! Spätestens an dieser Stelle greift Ihre Begründung zu kurz, das sollte Ihnen doch nicht entgangen sein.

@Michael Krüger;

El-Nino-Ereignisse gab es schon immer, auch unterschiedlicher Stärke. Sie sind also bereits in den historischen Temperaturdaten enthalten, insbesondere in der Temperatur von 1998. Ihre Argumente mit dem El-Nino-Effekt sind somit hinfällig und irrelevant. Bei näherer Betrachtung betreiben Sie penetrant bewusste Täuschung, alias Fakenews! In Wiki steht zu lesen:

Der Treibhauseffekt zeigt sich hauptsächlich in einer Erwärmung der unteren Luftschichten, infolge der Gegenstrahlung. Die realen Temperaturmessungen bestätigen die Erwärmungstendenz eindrucksvoll, genauso wie viele andere Indizien. Dass die Erwärmung nicht überall und jederzeit gleichmäßig fortschreitet, das ist trivial. Insgesamt steht die Erwärmung erst am Anfang.

Die Fachliteratur weist den zahlreichen Oberflächenmessungen der Temperatur höhere Zuverlässigkeit zu, als den mit nicht wenigen Störquellen behafteten lower troposphere Temperatur-Satellitenmessungen.

Da ja die Sonne nachweislich schwächer strahlt innerhalb ihres letzten Zyklus’, woher soll die langfristige oberflächennahe Temperaturerhöhung kommen, wenn nicht von der Zunahme der Treibhausgase? El Nino ist erst seit 2015 stärker als normal, die Temperaturen waren auch während La Nina weit überdurchschnittlich. Es gibt keinen anderen Grund für deltaT als AGW, zumal die ebenfalls gemessene IR-Rückstrahlungsleistung (https://scienceofdoom.com/2010/07/17/the-amazing-case-of-back-radiation/ + 2 Folgekapitel) die passende Größe liefert.

Ganz abgesehen davon, dass die Größenordnung des Treibhauseffektes auch durch die Planetologie unseres Sonnensystems “constrained” (eingrenzbar) ist (vgl. NASA-Studien), und damit als direkte Folge auch unser menschlicher Beitrag via CO2 & Methan.

Werte Klimaschützer,

Fakt ist, die Satellitendaten decken wie gesagt den Globus am besten ab und messen den Atmosphäreneffekt. Denn der Treibhauseffekt ist kein Bodeneffekt, sondern ein Atmosphäreneffekt. Die Erwärmung durch Treibhausgase zeigt sich zuerst in der Atmosphäre, vor allem über den Tropen. Hotspot. Der Boden erwärmt sich ganz zuletzt.

Mit einer Erhöhung der Treibhausgaskonzentration wird unmittelbar weniger Wärme ins All abgestrahlt. Dadurch erwärmt sich dann zunächst die untere Atmosphäre und ganz zuletzt der Erdboden. Das sind die Grundlagen zum Strahlungstranfer und Treibhauseffekt, die seit den frühen 1960er Jahren bekannt sind. Siehe Manabe.

Somit sind die Satellitendaten, aufgrund der besseren globalen Abdeckung und Bestimmung der Atmosphärentemperatur der erste und flächendeckenste Nachweis für einen anthropogenen Treibhauseffekt. ERBE (1985-1999) und CERES (2000-2016) messen zudem die Strahlungsflüsse, die für den Treibhauseffekt entscheidend sind.

MfG

Michael Krüger

Ziemlicher Unsinn – aber doch schön für Sie, dass Sie von sich überzeugt sind es besser zu wissen als selbst Carl Mears, der seit vielen Jahren diesen Satellitendatensatz aufgebaut hat.

@ Krüger

Ihre Verliebtheit in Satdaten allen Ehre, aber gerade die Satdaten und deren Helligkeitstemperatur ist massiv anfällig für Drifts der Instrumente im Orbit, sowie deren Geschwindigkeit und müssen ständig angepaßt werden.

Sie sind sogar so unverschämt, die RSS TLT3.3v hier zu verlinken und gleichzeitig nicht darauf hinzuweisen, dass der Abieter RSS die Benutzung der Daten unter vorbehalt gestellt hat:

“The V3.3 TLT data suffer from the same problems with the adjustment for drifting measurement times that led us to update the TMT dataset. V3.3 TLT data should be used with caution.”

Dämnächst erscheint übringens eine Korrektur und dann werdet ihr “Skeptiker” wieder nix von RSS wissen wollen^^

Moin Moin Herr Krüger,

Sie halten es doch Grundsätzlich für Möglich das sich Experten irren können. Rational betrachtet, muss es aus Ihrer Sicht ja sehr viele Klimaforscher aka Experten geben, die etwas anscheinend nur nicht verstehen wollen oder eben verstehen können.

Meine Frage an Sie. Haben Sie mal in Betracht gezogen, ob Sie sich vielleicht irren könnten? Immerhin argumentieren Sie mit einem Syukuro Manabe , der aber offensichtlich selber, zu ganz anderen Erkenntnissen gelangte, als Sie dies tun.

Mich würde das schon verunsichern. Sie nicht?

Nehmen wir mal Ihre die Grundlagen [!] zum Strahlungstranfer.

Selbst die meisten “Skeptiker” würden nie behaupten, das sich erst die untere Atmosphäre und dann ganz zuletzt der Erdboden erwärmt.

Vielleicht kennen Sie das ja… Wenn sie dunkle Sachen tragen, dann wird Ihnen bei Sonnenschein schneller warm, als wenn sie helle Sachen tragen. Stichwort. Albedo.

Dieser „Effekt“ hat wohl kaum etwas mit der Atmosphäre zu tun, sondern wohl eher die „Strahlung“ der Sonne, die eben nicht vollständig in der unteren Atmosphäre (Troposphäre?) „hängengeblieben“ ist, um diese zu wärmen, bevor diese mich dann wärmt.

Wenn Sie also schon die „Grundlagen der Strahlungstransfers“ nicht korrekt widergeben, wäre es dann nicht auch möglich, dass sie sich an anderer Stelle ebenso irren könnten?

MfG

PS Frohe Weihnachten allen und ein Dankeschön für die vielen tollen Beiträge in diesem Blog, die hoffentlich auch nächstes Jahr wilde Thesen und Manipulationen gerade Rücken.

Sven Plöger schreibt, dass die Satellitendaten nach den notwendigen Korrekturen (siehe Christians Kommentar) mit den Bodendaten gut übereinstimmen. (0,18 Grad Anstieg pro Jahrzehnt gegenüber 0,17 Grad bei den Bodendaten)

Werte Klimaschützer,

anbei die Grundlagen zum Treibhauseffekt, da es hier einige Fehlinformationen zu geben scheint:

http://clivebest.com/blog/wp-content/uploads/2014/06/Greenhouse3.png

Eine Erhöhung der Treibhausgaskonzentration bewirkt eine Rechtsverschiebung des Temperaturprofiles, zu höheren Temperaturen. In der mittleren bis oberen Troposphäre (ca. 5-10 km Höhe) ist die Temperaturverschiebung dTa am größten. Am Boden tritt die Temperaturverschiebung dTs zeitverzögert ein und ist weitaus kleiner als in der oberen Troposphäre. Das sind die Auswirkungen des sog. Treibhauseffektes. Seit Manabe frühe 1960er ist das bekannt und wird in allen Strahlungstransfermodellen verwendet. Modtran, Hitran, etc.

Der Treibhauseffekt ist also ein Atmosphäreneffekt. Und genau den messen die Satelliten zuerst und mit bester globaler Abdeckung. Gerade die Bodentemperaturen sind von diversen anderen Effekten überlagert. Zudem zeigt sich am Boden die Auswirkungen des Treibhauseffektes zuletzt und weniger ausgeprägt, als in der mittleren bis oberen Troposphäre.

Und genau wie die Satellitendaten unterliegen natürlich auch die Bodendaten Messungenauigkeiten. Würden die Satellitendaten nicht halbwegs zuverlässig sein, so würde man sie nicht veröffentlichen.

Und die Satellitendaten zeigen seit dem letzten großen El-Nino-Ereignis von 1998 keinen signifikanten Temperaturanstieg:

http://woodfortrees.org/plot/rss/from:1997/plot/rss/from:1997/mean:12/plot/rss/from:1997/mean:12/trend

MfG und frohe Weihnachten

Michael Krüger

Lieber Herr Krüger, sicher können Sie uns dann zwei Fragen beantworten:

1. Wie groß (ungefähr) ist denn die von Ihnen behauptete Zeitverzögerung?

2. Wieso zeigen sie in der Grafik einen Trend ausgerechnet ab 1998, dem größten El Niño Ereignis des 20. Jahrhunderts?

@Rahmstorf

Herr Rahmstorf, wie gesagt, der Treibhauseffekt ist ein Atmosphäreneffekt, der sich zuerst in der mittlerem bis oberen Troposhäre zeigt, dort wo die Satelliten messen. Hier eine Übersicht:

http://img5.fotos-hochladen.net/uploads/thehotspot5xj9we1pt2.jpg

Die Einstellzeit (Response Time) am Erdboden beträgt einige Monate bis Jahre. Die der unteren Atmosphäre 1-3 Monate, die des oberen Ozeans, die Erde besteht zu ca. 70% aus Wasser, ca. 4-10 Jahre. Das ergibt sich direkt aus der Wärmekapazität.

Wie gesagt, die Satellitendaten zeigen seit dem letzten großen El-Nino-Ereignis von 1998 keinen signifikanten Temperaturanstieg:

http://woodfortrees.org/plot/rss/from:1997/plot/rss/from:1997/mean:12/plot/rss/from:1997/mean:12/trend

Also vom letzten großen El Nino 1997/98 zum El Nino von 2015/16 keinen signifikanten Temperaturanstieg. Um die Temperaturen vergleichen zu können muss man selbe Bezugspunkte (Ei Nino) nehmen.

MfG

Michael Krüger

Aha.

Zu 1: Sie glauben also nicht, dass die Troposphäre auf kurzen Zeitskalen gut durchmischt wird, sodass z.B. die Peaks durch El Niño in den Bodendaten im selben Monat auftauchen wie in den Troposphärendaten? http://woodfortrees.org/plot/rss/from:1997/plot/gistemp/from:1997

Zu 2: Klimatrends zu bestimmen erfordert bekanntlich die Betrachtung eines längeren Zeitraums. Ich nenne es Rosinenpickerei – aufschlussreicher ist auf jeden Fall, sich die gesamte Zeitreihe anzusehen, z.B. die schöne aktuelle Analyse hier, wo Ihnen ein Profi-Statistiker auch nochmals den Unterschied zwischen Trend und Flukuation erklärt: https://tamino.wordpress.com/2016/12/05/how-much-from-el-nino/

@Rahmstorf

Ich sagte ja bereits, die Response Time der unteren Atmosphäre auf den Strahlungsantrieb beträgt 1-3 Monate, die des oberen Ozeans 4-10 Jahre. Der obere Ozean, ca. 70% der Erdoberfläche, also dort wo die Meerestemperaturen gemessen werden, reagiert also auf den Strahlungsantrieb in der Atmosphäre mit einen Nachlauf von 4-10 Jahren Zeitverzögerung. Bei einen El Nino ist es genau umgekehrt. Die Meeresoberfläche erwärmt sich zuerst durch den El Nino (Änderung der Meeresströmung) und anschließend durch Wärmeaustausch zwischen Ozean und Atmosphäre die untere Atmosphäre. Das geht wesentlich schneller.

Vom El Nino 1997/98 zum El Nino 2015/16 sind es immerhin fast 20 Jahre, in dem kein signifikanter Temperaturanstieg stattgefunden hat.

MfG

Michael Krüger

Seufz… Die Satellitendaten messen die Temperaturen innerhalb der Troposphäre, die innert einiger Tage komplett vertikal durchmischt wird, weil sie von unten beheizt wird (die Sonnenstrahlung wird hauptsächlich an der Oberfläche absorbiert) und damit statisch instabil ist. Daher gibt es ja auch das (von Ihnen in einer Abbildung verlinkte) adiabatische Temperaturprofil in der Troposphäre.

Hier übrigens eine Grafik, die die RSS-Satellitendaten mit den NASA Bodentemperaturen über den gesamten von Satelliten erfassten Zeitraum vergleicht. Der Erwärmungstrend ist praktisch der gleiche, in der Troposphäre (RSS) sogar geringfügig größer, nur die kurzfristigen Schwankungen sind in der Troposhäre erheblich größer. Das ist ja auch seit langem bekannt. Auch deshalb lieben “Klimaskeptiker” diese Satellitendaten ja so: je größer die Schwankungen, desto weniger statistisch signifikant ist ein Trend über kurze Zeiträume, und desto effektiver kann man Rosinenpickerei betreiben und das Laienpublikum durch geschickt herausgepickte Zeitintervalle verwirren.

Hallo Herr Krüger,

ich bin ja grundsätzlich auch Ihrer Meinung, “um die Temperaturen vergleichen zu können muss man selbe Bezugspunkte (Ei Nino) nehmen.”

Wenn ich mir in der Zeitung die Börsenkurse ansehe, mache ich das ja genauso. Ich vergleiche mit dem Kassakurs vom Vortag.

Aber würden Sie auf Grundlage dieser Information Aktien kaufen?

Natürlich nicht. Sie müssen schon den Trend wissen.

Wenn Sie aber den Trend über einen langen Zeitraum wählen, brauchen Sie doch gar keine “selben Bezugspunkte”. Wie an der Börse. Je länger der Zeitraum, umso bedeutungsloser, ob das zu Beginn und Ende Kassakurse waren.

Übrigens schreibt Sven Plöger in seinem Buch (von 2011), dass Satelliten für Langzeittrends weniger geeignet sind, weil sie zu solchen Messungen erst seit 1979 genutzt werden können.

So urteilt Plöger über einen zweiunddreißigjährigen Zeitraum – dagegen ist aber ihr gewählter Zeitraum von 18 Jahren schon arg verkümmert.

Wie siehts denn aus, wenn Sie einfach die Daten komplett ab 1979 auswerten? Das gibt m.E. auf jeden Fall mehr her!

@ Michael Krüger: “Herr Rahmstorf, Herr Vahrenholt hat sich bzgl. des eisfreien Grönlands im Mittelalter lediglich versprochen.”

Ach er hat sich versprochen?! Gibt es für diesen Ihren Rückzieher seiner Aussage einen Beleg?

Auch verteidigten Sie erst vor einigen Jahren den Klimaskeptiker Beck mit seiner Behauptungen, die Alpen seien in den letzten 2000 Jahren zweimal eisfrei gewesen!

Auch Prof. Kirstein vertrat 2010 die Auffassung Grönland sei im MIttelalter nahezu eisfrei gewesen! War das auch ein Versprecher?

http://scienceblogs.de/primaklima/2010/10/15/klimaschmock-september-2010-professor-kirstein-und-die-uni-leipzig/

Und warum haben Sie Herr Krüger die Einschätzung Kirsteins damals auch noch öffentlich bei Readers-Edition und anderswo verteidigt? Haben Sie sich da auch versprochen?

Herr Krüger, ich erinnere Sie auch an einen Ihrer zahllosen Beiträge im Science-Skeptical Blog. Hier haben Sie ein Zitat von Mojib Latif aus dem Zusammenhang gerissen und sich darüber lustig gemacht:

http://www.science-skeptical.de/blog/frueher-schnee-in-deutschland/0014652/

Mojib Latif meinte damals ausdrücklich Winter nach 2050! Dies hat er wiederholt klargestellt und das ergab sich auch aus dem Gesamtzusammenhang.

Und jetzt beanspruchen Sie für Herrn Vahrenholt, seine Aussage sei nur ein Versprecher gewesen? Ihre fortlaufende Rosinenpickerei ist nichts Anderes als der ständige Versuch, Ihre immer stärker widerlegten Dogmen zum Klimawandel irgendwie doch noch zu rechtfertigen…!

Herr Krüger, ich empfehle Ihnen dass Sie die Temperatur Ihres nächsten Rollbratens auch aus der Umgebungstemperatur in 20 cm Entfernung messen und nicht punktuell im Brateninnern wie dies die Köche weltweit unkorrekterweise tun!

Nordpoll – plus 10 Grad C

Ein Vorschlag für Axel B.:

Kalte Sonne bestätigt – An Weihnachten ist es am Nordpol 10 Grad wärmer als Normal

Wie verschiedene internationale Forschergruppen beeindruckend nachgewiesen haben, ist die Sonne zur Zeit kälter als Normal. Damit wurde diese Annahme von Fritz Varenholt und Sebastian Lüning (beide ehemalige RWE-Mitarbeiter) eindrucksvoll bestätigt. Wie weiter bekannt wurde, ist die stattfindende globale Aufheizung durch die ungebremste Freisetzung von CO2 unabhängig von der kalten Sonne. Deshalb ist die Arktis jetzt schon wieder deutlich wärmer als Normal. Für Heilig Abend ist am Nordpol T-Shirt-Wetter angesagt: Das Thermometer soll auf 10 Grad über Normal klettern.

Als Falschmeldung wurde hingegen aufgedeckt, dass Unbekannte mit Reichsflugscheiben von der Antarktis aus noch nicht bekannte wärmeverströmende Insekten am Nordpol ausgesetzt hätten. Die weiter voran schreitende globale Aufheizung ist also tatsächlich durch die vom Menschen freigesetzten Klimagase Kohlendioxid (CO2) und Methan (CH4) verursacht.

Mahlzeit!

Wieso das? Der Unterschied zwischen dem “blauen” und dem “roten” Wert ist doch der Unterschied zwischen -0,28 und +0,17, und der ist doch nun mal +0,45, unabhängig davon, ob in der Graphik nun – wahrscheinlich aus Gründen der Anschaulichkeit – ein 0,3-Bereich herausgelassen wurde oder nicht.

Sie haben die Grafik nicht verstanden.

2008 wurde die Differenz zwischen den beiden Januarmittelwerten 1910 und 2000 mit +0,45°C angegeben, aktuell wird sie mit +0,71°C angegeben. Das ist eine Änderung von +0,26°C.

Die fehlenden 0,3°C in der Skala dient einer besseren Ablesbarkeit, hat aber visuelle Nachteil. 0,71°C ist nur ca. 58% größer als 0,45°C, aber der rechte Differenzenpfeil ist ganze 220% länger als der linke. Das suggeriert eine riesige (je nach Lesart) Korrektur bzw. Verfälschung, dabei ist sie vergleichsweise moderat. Vor allem wenn man bedenkt, welche Fortschritte es in diesen 90 Jahren bei der weltweiten Temperaturmessung gab.

Es geht doch um die “Korrekturen”.

Wenn ich die rote Kurve betrachte, dann wurde die Anomalie innerhalb der letzten achteinhalb Jahre vom Wert +0,17 auf +0,26 nach oben korrigiert. Der Januar 2000 wurde also von Giss um 0,09 Grad wärmer gemacht.

Betrachte ich dagegen die blaue Kurve, so wurde der Wert von -0,28 auf -0,45 nach unten korrigiert. Der Januar 1910 wurde also von Giss (achteinhalb Jahre später) um 0,17 Grad kälter gemacht.

Das macht also summa summarum eine Korrektur von (0,26-0,17) + (-0,28-(-0,45)) = 0,26 Grad.

Warum vergleicht die WUWT jetzt ausgerechnet die Januare 1910 und 2000 miteinander? Tja.

Die rote Kurve zeigt die Versionsgeschichte der Januar 2000 Temperaturdaten. Die blaue Kurve die der 1910 Temperaturdaten. Zwischen diesen Daten ist ein Temperaturunterschied festgestellt worden (2008 hätte man gedacht es sind 0,45 K Unterschied, nach neueren Datenkorrekturen stellt sich heraus es sind 0,71 K). Es ist ein Irrtum, dass diese Korrekturen eine generelle Änderung zu größeren Temperatursteigerungen zeigen.

Wie Herr Rahmstorf zeigt, ist diese Anpassung eine derjenigen, wo sich so ein Unterschied feststellen lässt. Die 0,26 sind die Änderung durch die Anpassungen seit 2008. Dieses Anpassungsmuster alter Daten aus der 1. Hälfte des 20. Jahrhunderts nach unten und neuer Temperaturdaten nach oben ist aber kein generelles Muster, wie Abb. 2 zu sehen (Frühere Temperaturdaten sind eher nach oben korrigiert worden durch die Anpassungen).

Der Vergleich dieser beiden Anpassungen ist sog. “cherry picking” bei dem durch die Auswahl von 2 Anpassungen unter sehr viel mehr (es werden ja nur 2 Monate ausgewählt, einer aus dem frühen 20. Jahrhundert und einer von 2000). Diese Auswahl zeigt aber nicht einen Gesamtüberblick über die Anpassungen.

Der graphische Effekt durch das Weglassen der gesamten Skala ist, dass die Anpassung im Vergleich zum Temperaturunterschied größer wirkt.

S. Rahmsdorf: “Ein Außenstehender [gemeint ist ein Laie bzw. ein den Wissenschaften fernstehender] kann das letztlich auch kaum bemerken, es sei denn er arbeitet sich selbst sehr intensiv in die verfügbaren Daten und Fachliteratur ein.”

Ich weiß durchaus, was Herr Rahmstorf hier zum Ausdruck bringen möchte: das exakte Messen, die gesamte Analytik, die Prozessbeobachtung und -beschreibung, die gesamte (notwendige) gigantische Datenhuberei (despektierlich formuliert), all der unfassbare Kleinkram, der vor allem in einem Globalzusammenhang zu beachten und zu wissen ist… das kann man nur mit langjährigem, gut geschulten Expertenblick auf einem jeweils kleinen Teilfeld überreißen. Geschweige denn mal eben so aus der Hüfte be- und aburteilen.

Aber in gewisser Hinsicht verfehlt das den Punkt, den ein Laie zu irgendeinem weltlichen Sachverhalt erreichen will bzw. soll. Und da jeder Beliebige in praktisch allen Dingen immer und überall ein Laie ist (bis eben auf den jeweiligen winzigen Bereich, in dem Kompetenz hart erworben wurde), würde eine Art Forderung, man müsse sich in komplexe Sachverhalte einarbeiten um zu einer Beurteilung überhaupt gelangen zu können, nicht nur letztlich eine grenzenlose Überforderung sein für jeden, sondern auch unmöglich. Deshalb ist tatsächlich und ganz banal anderes erforderlich zur Aufteilung in Good- und Bullshit 😉 .

Man erwirbt (hoffentlich) ein gewisses Mass an Weltwissen grundsätzlicher Natur, der nach bestimmten Grundprizipien erlaubt, das Richtigere vom Falscheren zu trennen ohne im endlosen Detail zu versinken. Immer dann zum Beispiel, wenn absurde und übertriebene ad personam-Angriffe in Kommentaren oder Blogs auftauchen (und da gab/gibt es nun leider überreichlich Anschauungsmaterial von der Art “Schellnhuber ist ein ahnungsloser Blender” oder “Rahmstorf fälscht” ad infinitum auf den angesprochenen Internetplattformen), dann muss oder müsste man schon klar und eindeutig begreifen können, dass es nicht um Tatsachen, sondern um Agenden und Meinungsmache geht. Umso mehr dann, wenn sich ganze Heerscharen von nationalen Akademien über Jahrzehnte hinweg eindeutig gegen die Meinungsblogger stellen. Erforderlich ist für den Laien mediale Kompetenz (oder altmodischer: das Durchschauen von rhetorischen Mitteln zur Verschleierung und Abwehr von Faktenlagen), nicht die Nacharbeit von an Experten und Spezialisten absichtsvoll übertragene Tätigkeit.

Wie Sie, Herr Rahmstorf, schon im letzten Beitrag „Fake News,…“ schrieben, sollte man die Quellen checken und sich dort informieren.

Deshalb hier ein Link zu einer „Super-Internetseite“, denn der Betreiber hat sich die Mühe gemacht eine Software zu schreiben und kostenlos zur Verfügung zu stellen, mit der man die 4 bekannten und vom IPCC genutzten globalen Temperaturmeßreihen HADCRUT, GISTEMP, UAH und RSS, dann Temperaturmeßreihen für Land (CRUTEMP, RSS und UAH) und für die Ozeane (JISAO, ESRL, HADSST), die CO2-Daten vom Mauna Loa, die Sonnenaktivität und die Meereisfläche der beiden Pole (NSDIC) mit den aktuellsten Daten interaktiv anschauen kann:

http://woodfortrees.org/plot/

Mit einer ganzen Reihe von Funktionen, wie „von“ und „bis“, einer Skalierung oder dem linearen Trend lassen sich die Meßreihen auf verschiedene Art darstellen.

Was auffällt, wenn man einen kurzen Zeitraum bis zu den aktuellen Daten von heute wählt, also z.B. vom Jahr 2000 bis 2017 ist, dass alle 4 globalen Temperaturwerte nach der hohen Spitze von 2015 nun wieder stark gefallen sind – 2015, das war wohl der El Niño. Nun sind die Werte wieder gesunken und 2016 scheint entgegen der Prognosen kein Jahr mit einem neuen Spitzenwert zu werden. Die aktuellen Werte setzen wohl den ansteigenden Trend der Vorjahre fort und 2015 war eine extreme „Ausnahme“.

„HADCRUT 4 global mean“ ist aktuell gegenüber dem Spitzenwert von 2015 um etwa 0,5° gefallen, bei GISTEMP sind es etwa 0,4°, bei RSS sind es 0,6° und bei UAH5.6 sind es 0,3°. Noch höher sind die Temperaturdifferenzen bei den Landtemperaturen, CRUTEM4 zeigt einen Rüclgang um etwa 1,2°. Die globalen Oberflächentemperaturen der Ozean sind noch „oben“, was kein Widerspruch zu den Landtemperaturen darstellt, da sich die Ozeane viel langsamer erwärmen oder abkühlen.

Seltsamerweise ist die bisher noch nie beobachtete verzögerte Eisbildung des Meereises in der Arktis hier auf dieser Seite nicht zu sehen, auch wenn man die Auflösung der Daten vergrößert. Doch das kann man dann besser hier, den Originalquellen der Daten, beobachten:

http://nsidc.org/arcticseaicenews/

http://ocean.dmi.dk/arctic/icethickness/thk.uk.php

http://ocean.dmi.dk/arctic/icecover.uk.php

und zuletzt noch die dieses Jahr abnormen Arktistemperaturen:

http://ocean.dmi.dk/arctic/meant80n.uk.php

Der Erwärmungstrend geht ungebrochen weiter. Kurzfristige Schwankungen in der Temperatur sind normal, wie sie ja leicht an den Temperaturdatenreihen sehen können. Kurzfristige Schwankungen sind jederzeit möglich, vielen Dank für ihre Übersicht über diese Variabilität. Der El Nino hat zu einer höheren Temperatur beigetragen, dass aber der Erwärmungstrend weitergeht können Sie unter anderem daran sehen, wie weit die neueren Messdaten über den El Nino von 1998 hinausragen.

2016 wird wohl einen neuen Rekord in einigen Datensätzen zeigen, in anderen nicht (Bei den NASA-Daten wohl neuer Rekord bei HadCRUT vielleicht nicht). Dieser Unterschied ist aber nicht unbedingt signifikant. Signifikant ist aber, dass es einen Trend zu höheren Temperaturen gibt.

…. und wahnsinnigerweise zeigt die Karte “Sea Ice Extent” für den 22.12. d.J. Eis in unserem Teil der Ostsee…

Mit den Abbildungen 1, 2 und 3 hier im Beitrag kann ich nichts anfangen. Mir geht’s ähnlich wie Herrn v. Oehsen – sie zeigen genau das, was die Leugner behaupten und zeigen auch nicht, daß die korrigierten Temperaturen die Erwärmung verringern.

Bin über eine Berichtigung meiner eventuellen Leseschwäche oder Begriffsstutzigkeit nicht böse.

Verstehe das Problem nicht ganz.

In Abb. 2 sehen Sie, dass die Korrekturen in den Jahreswerten minimal sind (meist kleiner als ein Zehntel Grad) und (siehe das untere Panel mit den Differenzen) ab 1980 komplett flach, sodass die Steigung der Kurve ab 1980 sich gar nicht ändert.

In Abb. 3 zeigt die hellblaue Kurve (ohne Korrekturen) doch deutlich mehr Erwärmung über die letzten hundert Jahre als die dunkelblaue (mit Korrekturen).

@ Andreas Neuthe

Als Ergänzung zu Prof. Rahmstorf, möchte ich noch extra auf das Cherry Picking hinweisen.

Angenommen Sie haben ein Restaurant und erstellen jede Woche eine Endabrechnung. Am Jahresende erstellen Sie dann noch eine Bilanz, um diese dann mit dem Vorjahr zu vergleichen.

2015 haben Sie 10.000 € Gewinn

2016 haben Sie 10.500 € Gewinn

Weil Sie dieses Jahr ein neues Abrechnungssystem benutzt haben, rechnen Sie noch einmal das vergangene Jahr mit diesem neuen Abrechnungssystem durch, um beide Jahre besser vergleichen zu können.

Jetzt stellen Sie ein paar leichte Schwankungen in den einzelnen Wochen fest. Mal haben Sie nach dem neuen Abrechnungssystem mehr Gewinn erwirtschaftet, manchmal haben Sie nach dem alten System mehr Gewinn erwirtschaftet.

Als Sie am Ende alles durchgerechnet haben, stellen Sie fest, das Sie im Jahr 2015 auch nach dem neuen System “nur” 10.000 € Gewinn erwirtschaftet haben.

Es hat sich also, obwohl es bei den einzelnen Wochen kleine Schwankungen gibt, grundlegend wenig geändert.

Also behaupten Sie in Ihrer Bilanz wahrheitsgemäß, das Sie dieses Jahr 500 € unabhängig vom System und Korrekturen, mehr Gewinn erwirtschaftet haben.

Ein “Leugner” würde jetzt eine spezielle Wochen herauspicken, um Ihnen oder anderen zu „beweisen“, das Sie massiv manipuliert haben müssen. Dabei ignoriert er die Gesamtrechnung und die Methodik. Er nimmt nur ein einzelnes „Messergebnis“ (Woche), das Ihm gerade zu passen scheint, um seinen Verdacht zu belegen.

Das soll natürlich nur veranschaulichen, wie Herr Vahrenholt und Sebastian Lüning argumentieren und wie bei Vergleichen üblich, hinkt auch dieser ein klein wenig. Aber es soll ja nur das Prinzip verdeutlichen.

MfG

@ Stefan_G und Michael Fischer

Sie haben recht, ich habe die Grafik falsch interpretiert. Als eine “Trickgrafik” wie Rahmstorf würde ich sie dennoch nicht bezeichnen. Die “visuellen Nachteile” durch Herauslassen eines Bereiches der y-Achse sind schließlich bei der Darstellung der Temperaturverlaüfe mit Hilfe von Anomalien in noch stärkerem Maße gegeben, und eine solche Darstellung, bei der die Zeitachse um ganze 14° C nach oben verschoben wird, ist ja gängige Praxis. Das Ausmaß der relativen Veränderungen der Temperaturen ist dort auch nicht auszumachen. Also: “Rosinenpickerei” wohl, “Trickgrafik” nein.

Lieber Herr von Oehsen, relevant sind doch allein Temperaturänderungen und nicht der Absolutwert – eine “Verschiebung” der Kurve um 14°C oder auch 300°C hat nichts zu bedeuten, die Kurve sieht danach immer noch genauso aus wie vorher (schließlich können Sie die Kurve auch in Kelvin statt Celsius zeigen, was an der Aussage nicht das geringste ändert). Bei der Abbildung 1 dagegen geht es doch darum, wie groß die Differenz vom Januar 1910 zum Januar 2000 ist, mit Korrektur im Vergleich zu der Differenz in den Rohdaten. Es kommt also auf die relative Länge der beiden schwarzen Pfeile an. Die ist in der Grafik extrem übertrieben – durch die Lücke in der y-Achse, die man erst auf den zweiten Blick wahrnimmt. Dadurch soll die Größe der Korrekturen optisch übertrieben werden. Ich halte das für einen Trick – ich habe die Grafik mehreren Testpersonen gezeigt, keiner hat dabei die Lücke in der y-Achse bemerkt, bis ich sie darauf aufmerksam gemacht habe.

Mir war ehrlich gesagt zunächst auch überhaupt nicht klar, was der Witz an der Abb.1 sein sollte, und Ihre Erläuterung unter der Graphik hatte mich eher verwirrt. Ich musste mir das erst ein paar Minuten ansehen, um zu kapieren, was die Abbildung darstellen sollte.

Erlauben Sie mir daher, eine kleine Lanze für Herrn von Oehsen zu brechen – es ist für einen Ungeübten nicht ganz einfach, mit einem Blick bei derartigen Graphiken zu erkennen, worum es geht.

> Zum Beleg präsentieren sie die folgende Grafik, die sehr schön gleich zwei der Lieblingstricks der Klimaleugner illustriert: Rosinenpickerei und täuschende Trickgrafiken.

Das Verhalten von Vahrenholdt und Lüning erinnert mich stark an Prosper-René Blondlot: https://de.wikipedia.org/wiki/Ren%C3%A9_Blondlot Dieser hatte durchaus Bemerkenswertes geleistet, sich aber später ziemlich verstiegen.

Lieber Herr Rahmstorf,

so ganz ohne Relevanz sind aber doch auch die “relativen” Temperaturänderungen nicht, und die gehen bei der Darstellung von Anomalien nun einmal völlig unter. Ich würde das aber auch immer akzeptieren, schon wegen der Anschaulichkeit, die bei einer grafischen Abbildung der Veränderungen der absoluten Temperaturen praktisch nicht mehr gegeben wäre. Aber das trifft m.E. eben auch für eine Darstellung der Abb. 1 ohne Lücke in der y-Achse zu. Stellen Sie sich diese Abbildung doch nur mal mit vollständiger y-Achse vor. Schwer auszumachende Kurvenverläufe am unteren und oberen Ende.

Sollte man den Verfassern der Abbildung nicht auch zugestehen, was man bei den üblichen Darstellungen von Temperaturänderungen tut: Dass sie aus Gründen der Anschaulichkeit die y-Achse entsprechend gestalten?

Lieber Herr Rahmstorf,

noch eine Anmerkung. Ich habe über die Zeit immer mal wieder mit den GISS-Datensätzen Trends nachgerechnet und dabei z.B. für die vier letzten Korrekturen immer gefunden, dass der Jahrhundert-Trend (ab 1880) durch diese Korrekturen verstärkt wurde. Nicht immer sehr bedeutend, aber immer verstärkt.

… was auch Abb. 2 oben ja direkt zeigt.

Das Jahr 2016 neigt sich dem Ende zu. Und ich fürchte, dass trotz der hier seit Jahren bereits stattfindenden unermüdlichen Aufklärungsarbeit von Ihnen, lieber Prof. Rahmsdorf, nicht gelingen wird, die Zweifler mit Sachargumenten zu überzeugen. Schade eigentlich, wohl aber auch ein Abbild unserer Gesellschaft.

Troztdem ist es sicher all der Mühen Wert und ich hoffe doch sehr, auch im Jahr 2017 hier weiterhin umfangreiche Beiträge lesen zu dürfen. In diesem Jahr waren es 14 Beiträge mit 846 Kommentaren zu diesen Beiträgen. Danke für die Mühen!

Ich hoffe allerdings auch, dass persönliche Anfeindungen und Beleidigungen, wie sie leider in der Vergangenheit viel zu häufig vorgekommen sind, im Jahr 2017 ausbleiben, der eine oder andere sich vielleicht sogar für seine Entgleisungen entschuldigt (man wird ja wohl noch hoffen dürfen…?).

In diesem Sinne – Auf ein gutes Jahr 2017 !

Manfred

Herr Krüger,

schön dass Sie die Diskussion in Ermangelung von Unterstützern Ihrer Thesen nun nach hierhin verlegt haben. Dort finden Ihre Gedankengänge sicherlich die nötige Beachtung:

http://www.science-skeptical.de/klimawandel/der-treibhauseffekt-fuer-rahmstorf-anhaenger-wie-klimaschuetzer-den-treibhauseffekt-leugnen/0015734/

Bei den Statistiken zur Klimaerwärmung wird die Temperatur der Luft kurz über der Erdoberfläche herangezogen. Wäre es nicht sinnvoller, wenn man den Energiegehalt der Luft messen würde, der ist nämlich auch von der Luftfeuchtigkeit abhängig.

Ein Liter Luft mit einem Feuchtigkeitsgehalt von z. B. 80 % und 5 Grad Celsius hat einen höheren Energiegehalt als 1l Luft mit einem Feuchtigkeitsgehalt von 20 % und einer Temperatur von 10 Grad Celsius. Nur zum Nachdenken!

Hängt von der Fragestellung ab; bei energetischen Betrachtungen zu Tropenstürmen macht man das z.B. so, weil in der aufsteigenden Luft im Zentrum des Sturms die gespeicherte latente Wärme durch die Kondensation des Wasserdampfs freigesetzt wird. Da spielt diese Energie dann eine wichtige Rolle.

Auf die Frage, ob man anstatt Temperaturen den Energiegehalt der Luft betrachten sollte, gibt es eine ziemlich klare Antwort: Nein

Die Größe “Energieinhalt” ist für die Allgemeinheit völlig unanschaulich, allenfalls für Verfahrenstechniker, die sich mit Trocknungsvorgängen beschäftigen, nicht. Für die ist das “tägliches Brot”.

Anschaulichkeit ist das eine – vor allem aber hängen die Auswirkungen der globalen Erwärmung nicht nur auf Menschen sondern auch auf Ökosysteme überwiegend direkt von der Temperatur ab; der latente Wärmegehalt der Luft spielt nur in speziellen Fällen eine Rolle (wie beim Beispiel von Tropenstürmen oder auch der Intensität von Gewittern).

Stefan Rahmstorf,

bei der Betrachtung des Klimawandels sollte man das auch tun.

Wenn Sie 1l Eiswasser mit 0 Grad Celsius 2 Minuten erhitzen , hat es danach 80 Grad Celsius.

Wenn Sie 1 l Eiswasser mit 0 Grad Celsius aber noch Eiswürfel darin mit der gleichen Wärmequelle wieder 2 Minuten erhitzen, dann hat das Wasser nach 2 Minuten nur 1 Grad Celsius. Diesen Versuch haben alle Schüler bei mir zum Thema Wärme gemacht. Das ist schon eindrucksvoll.

Soviel zur Bedeutung des Gletschereises.

Richtig – jetzt bringen Sie neben der bislang diskutierten Verdunstungswärme noch die Schmelzwärme von Eis ins Spiel. Dabei wird aber übrigens die Geschwindigkeit, mit der Kontinentaleis schmilzt, nicht durch die dabei verbrauchte Wärmeenergie begrenzt (wie das in Ihrem Eiswasser-Beispiel der Fall ist) sondern durch die schlechte Wärmeübertragung in das Kontinentaleis. In dem Moment, wo das Eis in Kontakt mit Wasser kommt (durch die Eisströme, die von Grönland und der Antarktis ins Meer fließen), schmilzt es dramatisch schneller weg. Daher ist das Tempo des Eisverlustes vor allem durch die Frage bestimmt, wie rasch die Eisströme fließen bzw. sich im Zuge der Erwärmung beschleunigen. Die Schmelzwärme, um das Eis dann in flüssiges Wasser zu verwandeln, verbraucht dagegen nur einen winzigen Bruchteil der zusätzlich durch den wachsenden Treibhauseffekt eingefangenen Wärmeenergie. Mehr als 90% dieser Energie wird einfach dazu aufgewandt, das Meerwasser zu erwärmen (wie in Ihrem Becherbeispiel ohne Eis), geht also für Wärmespeicherung im Ozean drauf.

Stefan Rahmsdorf,

…..geht für die Wärmespeicherung im Ozean drauf.

Darum geht es mir. Langfristig werden unsere Ozeane wärmer. Und dieser Vorgang lässt sich nicht rückgängig machen, solange die eingestrahlte Sonnenenergie nicht durch die abgestrahlte Wärme kompensiert werden kann.

Die Lufttemperatur hat mehr den Charakter eines Indikators. Für langfristige Prognosen ist eine Energiebilanzrechnung notwendig.

Peter Stott, Acting Director of the Met Office Hadley Centre said, “A particularly strong El Nino event contributed about 0.2°C to the annual average for 2016.” This means that without the El Nino 2016 would have had a global temperature of about 0.57+/- 0.1°C which is the same as 2014 and within the errors of 2010 (0.56) and 2005 (0.54). It would also have been in the 95% confidence range of 2013, 2010, 2009, 2007, 2006, 2005, 2003 and 2002. In other words, using the Met Office’s 0.2°C El Nino (ENSO) correction 2016 has not been a record warm year but statistically in the same region as the previous 15 years.

Sinnvoller ist es m.E., El Niño dann nicht nur 2016 herauszurechnen, sondern den Effekt von El Niño und La Niña dann generell aus der ganzen Zeitreihe herauszunehmen, wie Gavin Schmidt von der NASA das getan hat. Dann sind 2015 und 2016 immer noch Rekordjahre.

Sechszehn?

Aber Spass beiseite.

Weltweit werden zur Agrarbewässerung 2.700 km³ Wasser zum Verdunsten gebracht.

Diese Wärme reicht aus, um 15.000 km³ Eis zu schmelzen, also etwa 5 Millionen km² 3 Meter dickes Meereis.

Abkühlung der semiariden Äcker und Erwärmung der Arktis?

Temperaturzunahme in den Regionen, in denen die meisten Thermometer stehen?