Erwärmung unterschätzt

BLOG: KlimaLounge

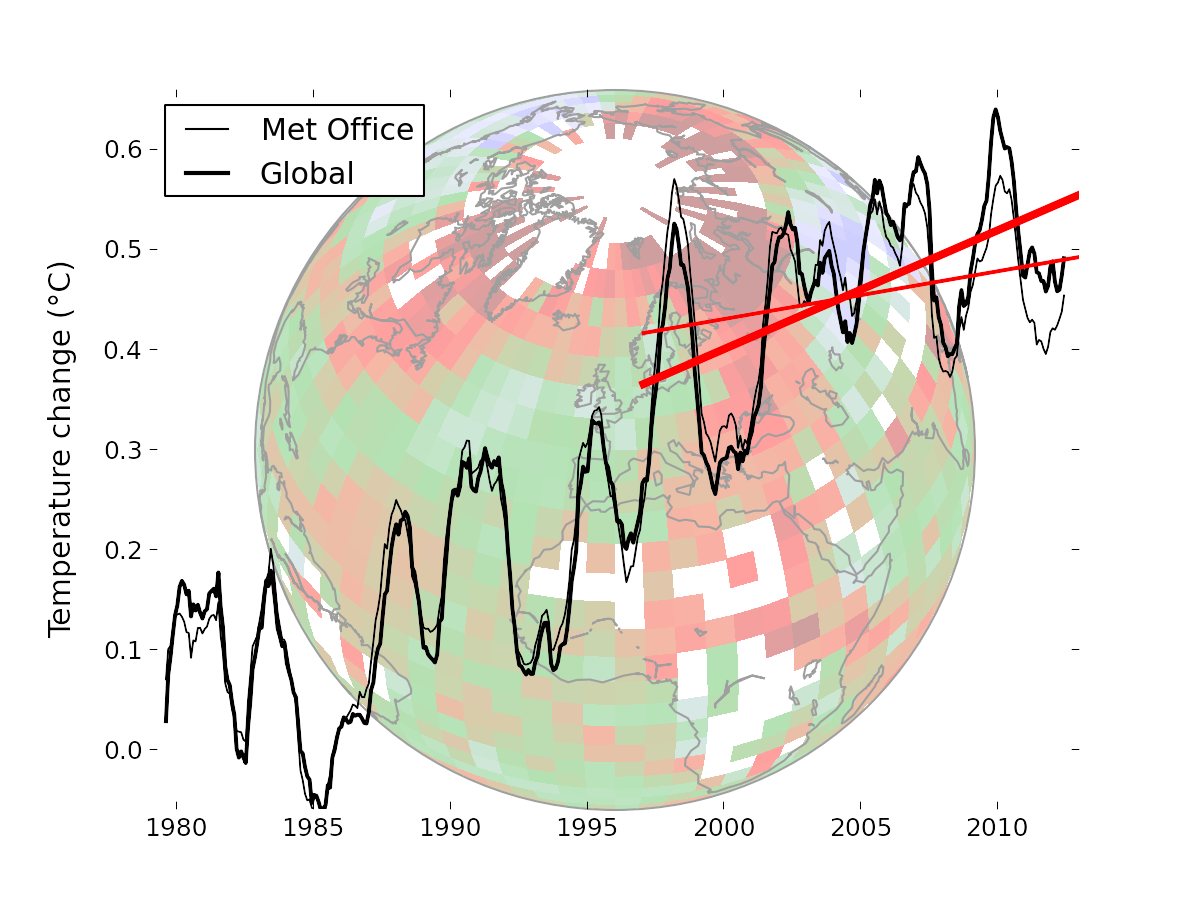

Eine neue Studie britischer und kanadischer Forscher zeigt, dass die globale Erwärmung der letzten 15 Jahre erheblich unterschätzt worden ist. Grund sind die Datenlücken im Temperatur-Messnetz, vor allem in der Arktis. Füllt man diese Datenlücken mithilfe von Satellitenmessungen, wird der Erwärmungstrend in den weithin verwendeten britischen HadCRUT4-Daten mehr als verdoppelt, und die zuletzt vieldiskutierte „Erwärmungspause“ ist praktisch verschwunden.

Die Bestimmung der globalen Temperatur aus Messungen von Wetterstationen hat ein bekanntes Problem: es gibt einige Datenlücken, vor allem in den Polargebieten und in Teilen Afrikas. Solange diese nicht erfassten Regionen sich ähnlich stark erwärmen wie der Rest der Welt, ändert das an der globalen Temperaturkurve nichts.

Fehler in den globalen Temperaturtrends entstehen aber genau dann, wenn diese Gebiete sich anders entwickeln. Das ist seit 15 Jahren in der Arktis der Fall, die sich ungewöhnlich stark erwärmt hat, wie andere Daten von Satelliten und Wettermodellen oder auch der starke Eisrückgang dort zeigen. Dieses Problem hat mein norwegischer Kollege Rasmus Benestad erstmals im Jahr 2008 bei RealClimate untersucht, und später wurde dies durch andere Autoren in der Fachliteratur bestätigt. Wir haben dieses „Arktisloch“ auch hier in der KlimaLounge mehrfach behandelt.

Das „Arktisloch“ ist der Hauptgrund für den Unterschied zwischen den NASA-GISS-Daten und den beiden anderen Datensätzen der bodennahen Temperatur, HadCRUT und NOAA. Denn die NASA füllt Datenlücken seit jeher durch Interpolation von den Rändern her, was jedenfalls besser ist als gar nicht.

Ein neuer Lückenfüller

Nun haben Kevin Cowtan (Universität York) und Robert Way (Universität Ottawa) ein cleveres Verfahren entwickelt, um die Datenlücken mithilfe von Satellitendaten zu füllen.

Klingt naheliegend und simpel, ist es aber nicht, denn erstens können die Satelliten nicht die bodennahen Temperaturen messen sondern nur Temperaturen über einen bestimmten Höhenbereich der Troposphäre, und zweitens gibt es ein paar Fragezeichen an der Langzeitstabilität dieser Messungen (zeitliche Drift).

Cowtan und Way umgehen beide Probleme, indem sie eine etablierte geostatistische Interpolationsmethode namens Kriging (oder Krigen) benutzen – sie aber nicht auf die Temperaturdaten selbst anwenden (was ähnlich den GISS-Daten wäre), sondern auf die Differenz zwischen Satelliten-und Bodendaten. Damit berechnen sie ein hybrides Temperaturfeld. Es besteht wie gehabt aus Bodendaten, dort wo es sie gibt. Aber in den Datenlücken besteht es aus in bodennahe Temperaturen umgerechneten Satellitendaten, wobei die Differenz zwischen beiden durch die Kriging-Interpolation von den Rändern her bestimmt wird. Da dies für jeden Monat wieder neu geschieht, ist eine mögliche Drift der Satellitendaten kein Thema mehr.

Voraussetzung für den Erfolg ist natürlich, dass diese Differenz hinreichend glatt ist, also keine starken kleinräumigen Änderungen aufweist. Das lässt sich an künstlich erzeugten Datenlücken testen, wo man die tatsächlichen Temperaturwerte kennt aber bei der Berechnung erstmal zurückhält. Cowtan und Way machen umfangreiche Validierungstests und belegen damit, dass ihre Hybrid-Methode deutlich bessere Ergebnisse liefert als eine normale Interpolation nur der Bodendaten, wie etwa die NASA sie macht.

Überraschendes Ergebnis

Cowtan und Way wenden die Methode auf die HadCRUT4-Daten an, die bis auf die Behandlung der Lücken state-of-the-art sind. Sie zeigen unkorrigiert für 1997-2012 einen relativ geringen Erwärmungstrend von nur 0,05 Grad pro Jahrzehnt – der oft etwas irreführend als „Erwärmungspause“ diskutiert wurde. Der aktuelle IPCC-Bericht schrieb dazu:

Due to natural variability, trends based on short records are very sensitive to the beginning and end dates and do not in general reflect long-term climate trends. As one example, the rate of warming over the past 15 years (1998–2012; 0.05 [–0.05 to +0.15] °C per decade), which begins with a strong El Niño, is smaller than the rate calculated since 1951 (1951–2012; 0.12 [0.08 to 0.14] °C per decade).

Nach Füllen der Datenlücken liegt dieser Trend aber bei 0,12 Grad pro Jahrzehnt und ist genau gleich dem vom IPCC genannten Langzeittrend.

Die korrigierten Daten (fette Linien) sind in der Grafik im Vergleich zu den unkorrigierten (dünne Linien) gezeigt. Die Temperaturen der letzten drei Jahre werden ein wenig wärmer, dafür das Jahr 1998 etwas kühler.

Der Trend von 0,12 Grad ist erstmal überraschend, denn erwartet hätte man ja vielleicht, dass der Trend nach Lückenfüllung einen Wert wie in den GISS-Daten hat, also 0,08 Grad pro Jahrzehnt. Auch diesem Unterschiede sind Cowtan und Way nachgegangen. Er kommt daher, dass die NASA eine Verbesserung der Meerestemperaturdaten noch nicht implementiert hat, die letztes Jahr in den HadCRUT-Daten eingeführt wurde (das war der Übergang von den HadSST2 auf die HadSST3 Daten – die Details findet man z.B. hier und hier). Dies erläutern die Autoren näher in ihrem ausführlichen Hintergrundmaterial. Wendet man die Korrektur der Meerestemperaturen auf die NASA-Daten an, wird der Trend dort 0,10 Grad pro Dekade, liegt also sehr nahe an der neuen optimalen Rekonstruktion.

Fazit

Die Autoren schreiben in ihrer Einleitung den allzu wahren Satz:

While short term trends are generally treated with a suitable level of caution by specialists in the field, they feature significantly in the public discourse on climate change.

Eine Medienanalyse hat gezeigt, dass zumindest in den USA rund die Hälfte aller Berichte zum neuen IPCC-Bericht das Thema “Erwärmungspause” aufgegriffen haben, obwohl es in den Aussagen des IPCC eine völlig untergeordnete Rolle spielt. Oft war der Tenor so, dass die angebliche Pause Zweifel an der globalen Erwärmung und den Warnungen des IPCC wecken sollte. Wir kannten natürlich die Arbeit von Cowtan und Way schon lange, und angesichts einer solchen Berichterstattung ist es für Forscher manchmal nicht leicht, solche Informationen für sich zu behalten. Ich achte aber die Haltung der Autoren, erst dann mit den Ergebnissen an die Öffentlichkeit zu gehen, wenn sie in der Fachliteratur publiziert sind. Das ist ein gute Grundregel, an die ich mich selbst auch seit jeher halte.

Die öffentliche Debatte über die angebliche “Erwärmungspause” war von vornherein überzogen, weil hier viel zu viel in einen herausgepickten kurzfristigen Trend hineininterpretiert wurde. Nun ist der Debatte vollends die Grundlage entzogen, weil der Trend der letzten 15 oder 16 Jahre – also selbst mit dem Rekord-El-Niño-Jahr zu Beginn des Zeitraums – nicht besonders auffällig ist. Er ist zwar noch ein Viertel geringer als der Aufwärtstrend seit 1980, der bei 0,16 Grad pro Dekade liegt. Aber das ist kein Wunder, wenn man mit einem extremen El Niño beginnt und mit anhaltenden La Niña Bedingungen endet, und zudem in der zweiten Hälte des Zeitraums durch ein besonders tiefes und anhaltendes Sonnenminimum gelaufen ist. Wie schon so oft gesagt: all dies bewegt sich im Rahmen der üblichen Schwankungen um den langfristigen globalen Erwärmungstrend herum und sollte nicht aufgeregt überinterpretiert werden.

Weblinks:

Der Guardian zur neuen Studie.

Und The Independent.

Media Matters analysiert die Medienreaktion: Faux Pause: Media Ignore Study Finding Globe Is Warming Twice As Fast As Thought

Satellitenmessungen zeigen für die untere Troposphäre keine Erwärmung seit ca. 16 Jahren und ca. 1,2 K/Dekade Trend für das letzte 1/4 Jahrhundert:

http://www.woodfortrees.org/plot/rss/from:1987/to:2013/plot/rss/from:1987/to:2013/trend/plot/rss/from:1996/to:2013/trend

Das steht im krassen Widerspruch zu allem, was auf dieser Seite je zum Thema AGW geschrieben wurde. Vielleicht kann einfach nicht sein, was nicht sein darf…?

Ich vermute mal, dass Sie nicht alles gelesen haben, was wir hier schreiben, denn die Satellitendaten wurden u.a. hier behandelt. In der Troposphäre ist der Effekt von El Niño und La Niña etwa doppelt so groß wie an der Oberfläche, daher ist es bei diesen Daten noch irreführender, ausgerechnet das Jahr mit dem stärksten El Niño an den Anfang zu nehmen. Probieren Sie doch einfach mal diese Variante mit den UAH-Satellitendaten und dem Trend ab 1999, dann sehen Sie wie wenig robust Ihre Analyse gegenüber kleinen Veränderungen ist.

Das Ergebnis ist schon interessant und muss halt wie alle Resultate noch weiter verarbeitet und bestaetigt werden. Ohne das Paper jetzt gelesen zu haben, stellen sich mir dann noch andere Fragen. Muss dann nicht die Unsicherheit der gesamten T_glob nochmal kritisch untersucht werden? Phasen, in denen das Meereis variierte (30er Jahr) oder in denen grosze Gebiete ohne direkte Beobachtungen waren, hatten wir ja auch vorher schon mal. Koennte man da auch pauschal eine zusaetzliche Unsicherheit von 0.06grad pro Dekade annehmen? Die MSU Daten zeigen einen ebenfalls zu niedrigen Trend (gemessen an den Modellen), aber ich nehme an, die sind wg des Beobachtungswinkels auch nicht so toll ueber der Arktis? Eduardo Zorita hat ja eine Art Muster der zu niedrig ausgefallenen Erwaermung berechnet http://klimazwiebel.blogspot.com.es/2013/09/the-intriguing-stagnation.html. Zu wenig Erwaermung sieht er insbesondere im Winter und in Eurasien. Ich bin mir nicht sicher, wie ich das jetzt mit dem neuen Paper hier vereinbaren kann. hmmm. Vielleicht muss ich doch erstmal das Paper in Ruhe lesen.

Georg, lesen ist immer gut. Ich weiß nicht, ob man jetzt gleich die frühere Unsicherheitsanalyse über den Haufen werfen muss, denn die korrigierte Kurve von Cowtan & Way liegt innerhalb der publizierten Unsicherheit der HadCRUT4-Daten. Nur der Trend ab 1997 wird drastisch korrigiert, aber das ist eben wieder Ausdruck der Tatsache, dass so kurze Trends nicht aussagekräftig sind. Innerhalb der Datenunsicherheit kann man alle möglichen Kurzzeittrends unterbringen – das zeigen ja auch die Unsicherheitsmargen in dem IPCC-Zitat sehr deutlich. Was die räumlichen Muster der Trends angeht: die sind ja schon seit Judah Cohens paper von 2012 bekannt und passen m.E. gut zu Kevins Analyse. Man sieht die Kaltlufteinbrüche aus der Arktis nach Eurasien im Winter, die wir hier in den letzten Jahren erlebt haben. Die machen an sich erstmal nichts an der globalen Mitteltemperatur – aber wenn Du die Arktis nicht drin hast in den Daten, sondern nur den kalten Teil dieses Musters, dann eben schon.

Herr Rahmstorf,

wie kommen sie auf starkes El Nino Jahr? Ich begann die Reihe ja nicht mit 1998 sondern mit 1996.

Das macht doch kaum einen Unterschied – probieren Sie es aus. Der Trend wird beeinflusst, wenn der große El Niño Peak am Anfang ist, ob im ersten oder dritten Jahr. Zumal man durch Hinzunahme von 1997 noch einen Teil dieses Peaks hinzubekommt.

Die Satellitendaten (RSS) reichen nur bis 82,5° Nord.

http://data.remss.com/msu/monthly_time_series/old_versions/RSS_Monthly_MSU_AMSU_Channel_TLT_Anomalies_Land_and_Ocean_v03_1.txt

Füllen also nicht das “Arktisloch” (82,5 – 90°N). Selbes gilt meines Wissens nach für die UAH-Satellitendaten. Und diese Satellitendaten (mit “Arktisloch”) wurden, wenn ich es richtig verstanden habe, doch in der Studie verwendet. Wie will man also ein “Arktisloch” mit Satellitendaten, die ebenfalls ein “Arktisloch” aufweisen, füllen?

Deshalb nehmen Cowtan&Way nicht die RSS-Daten sondern die UAH-Daten, die bis 85° Nord reichen. Die verbleibende Lücke ist nur 0,2 Prozent der Erdoberfläche.

Mal eine paar Fragen in die Diskussionsrunde geworfen. Wie groß ist denn die Datenlücke an den Polkappen im Vergleich zur restlichen Landmasse? Und welche Messstationerasterabstände gibt es überhaupt bzw. werden zur Zeit als ausreichend erachtet? Was ist mit kontinentalen unbewohnten Gebieten, nicht nur in Afrika, es gibt ja noch Asien, Südamerika, Australien, Kanada usw, usw.? Gibt es dort Messstationen? Ach ja, da fällt mir ein – zu wie viel Prozent ist unsere kleine Kugel von Meerwasser bedeckt? Wird dort gemessen? Wie? Wer hat auf den 7 Weltmeeren in der Vergangenheit überhaupt gemessen UND die Daten aufgezeichnet? Wenn ich in meinem kleinen Garten pro Quadratmeter eine Wettermesstation aufstelle und sagen wir mal 1 ganzen Monat rund um die Uhr die Daten erfasse – kann ich anhand meiner Aufzeichnungen die Temperaturentwicklung auf ein zehntel Grad genau für die ersten Woche im kommenden Monat berechnen? Freue mich auf die Antworten. 😉

Die meisten Ihrer Fragen haben wir hier im Blog schon behandelt, Sie können die Suchfunktion nutzen. Zu den Meerestemperaturen habe ich oben ja einen Artikel verlinkt. Wikipedia ist auch eine gute Quelle. Die ebenfalls oben verlinkte Webseite mit Hintergrundinfos, ebenso wie der Guardian-Artikel, haben Karten der Datenabdeckung. Hoffe das hilft!

Es wäre wichtig, dass bei den internationalen Klimaverhandlungen auch mal gesprochen wird über das Klimamessnetz. So einiges an Klimawandel lässt sich nicht mehr aufhalten und es wäre gut wenn wir dies genau beobachten könnten.

Die operationelle Messungen werden meist für die Wettervorhersage gemacht. Die sind nicht sehr interessiert an menschenleren Regionen. Und mann sollte eigentlich auch die ärmeren Länder hier unter die Arm greiffen. Vielleicht kann der WMO so etwas organisieren.

Guten Abend,

gibt es irgendwelche Modelle, die die langfristige Verteilung des Methans, das am Rande des Nordpolargebietes aus den Schelfen ausgast, berücksichtigt oder sind diese Einflüsse noch nicht in Klimamodelle eingegangen? Eine Vorstellung, was ein erhöhter Methangehalt bewirkt zeichnet sich doch schon ab:

http://www.klimafreak.de/BerichtUndBlogs/Klimawandel(XXVI)Arktisextrem2012.html

Wie lange wird es dauern, bis die Windsysteme das Methan verteilt haben?

Viele Grüße nach Potsdam

Wenn die Kriging Methode die Temperaturentwicklung ab 1998 um so viel korrigiert hat, wurde diese dann auch für weiter zurückliegende Perioden ebenfalls angewandt? Vielleicht ergibt das ja auch noch einmal andere Werte für die damalige Erwärmung?

wurde gemacht, die Korrektur fängt ab 1978 an. Ist auch in der Grafik zu sehen.

Ich halte diese Arbeit für extrem spannend und, so die Methodik hält, was sie verspricht, mit enormen Potential für viele offenen Fragen. Im Grunde gibt sie eine neue Temperaturreihe (wenn auch nur über die Ära der Sattelitenmessung), deren Qualität nochmals gesteigert wurde. Und die Veränderungen zur Bestehenden sind ja nicht marginal. Das heißt, die Konsequenzen daraus auch nicht. Besonders elegant, sie kann das Phänomen, dass gerade die Wintertemperaturen der Nordhemisphäre scheinbar eingebrochen sind, nachvollziehbar erklären. Denn im Sommer sollte der Bias auch deutlich geringer sein, da die Poltemperaturen durch den Schmelzvorgang sehr stabil gehalten werden. Im Winter genau das Kontrastprogramm. Wenn kalte Polarluft weit in die Bereiche mit Temperaturmessung geschoben wird und warme Luft sich im Gegenzug in der Arktis „verstecken“ kann, dann wird der Bias enorm verstärkt. Und da gerade die letzten Winter genau diese Kaltlufteinbrüche hatten, macht das für mich viel Sinn. Bin gespannt, wie die Liebhaber der Pause jetzt reagieren. Entweder total ignorieren, oder Fehler finden und Betrugsabsicht unterstellen. Aber wissenschaftlich interessanter, was lässt sich aus der neuen Temperaturreihe alles entnehmen und weiterentwickeln? Und natürlich sollte Tamino unbedingt die bekannten natürlichen Faktoren herausfiltern, die daraus entstehende Kurve wäre für David Rose sicher ein wahrer Alptraum 🙂

Grüße Lotte

Eine interessante Gedanke. Juddith Curry schreibt gerade als Kritik an dem Paper, dass die Interpolation nur im Winter gut funktionieren wurde. Wenn die Temperaturänderungen nur im Winter sind, wäre dies kein großes Problem.

Zumdem wurde die relativ konstante Temperatur wegen des Schmelzens auch erklären warum die Korrelationslänge in der Arktis in den anderen Saisonen so kurz ist, weil es dann kaum Variabilität zu erklären wäre.

Sollte man nachgehen.

Kevin Cowtan hat hier auf Curry geantwortet, und Robert Way hier.

@Stefan Rahmstorf

1. Also wird das “Arktisloch” mit den Satellitendaten nicht geschlossen, sondern nur in der Größe verringert. Es bleibt weiterhin ein “Arktisloch” (85-90°N) vorhanden.

2. Was mich auch stutzig macht, nehme ich die HadCRUT4-Bodendaten, welche in der Studie verwendet wurden, so weisen die seit Beginn der Satellitenaufzeichnungen im Dez. 1978 bis heute einen Trend von 0.0154707°C pro Jahr auf. Nehme ich die UAH-Satellitendaten, die verwendet wurden, um das “Arktisloch” zu “füllen”/ zu verkleinern, so weisen die seit Beginn der Satellitenaufzeichnungen im Dez. 1978 bis heute einen Trend von nur 0.0136837°C pro Jahr auf.

http://woodfortrees.org/plot/hadcrut4gl/from:1978.92/plot/hadcrut4gl/from:1978.92/trend/plot/uah/plot/uah/trend

http://woodfortrees.org/data/hadcrut4gl/from:1978.92/plot/hadcrut4gl/from:1978.92/trend/plot/uah/plot/uah/trend

D.h. die Satellitendaten (UAH) mit größerer Abdeckung der Arktis weisen also einen geringeren Temperaturanstieg auf, als die Bodendaten (HadCRUT4) mit “Arktisloch”.

Wie kann also ein größerer Temperaturanstieg herauskommen, wenn man die Satellitendaten (UAH) in die Bodendaten (HadCRUT4) mit einbindet?

Die Ergebnisse der Studie halte ich aus diesen Gründen für sehr zweifelhaft.

Zu 1: Das verbleibende Loch umfasst 0,2 % der Erdoberfläche – hier werden Sie nicht ernsthaft einen nennenswerten Effekt auf die globale Mitteltemperatur erwarten?

Zu 2: Wie im Artikel erklärt messen die Satelliten nicht die bodennahen Temperaturen sondern die in der Troposphäre, und sie haben außerdem Probleme mit der Langzeitstabilität – d.h. Drift. Bei der Methode von Cowtan und Way werden daher nur in jedem einzelnen Monat die räumlichen Muster der Satellitendaten zur Interpolation benutzt. Vereinfacht gesagt: wenn im Juli 1995 die von Satelliten gemessenen Troposphärentemperaturen um die Arktis herum 2 Grad kälter als die Bodentemperaturen waren, dann interpoliert man diese Differenz in den Datenlosen Bereich hinein. D.h. sie nehmen an, dass die bodennahe Temperatur in dieser Datenlücke die Troposphärentemperatur + 2 Grad war. (Das jetzt mal anhand einer konstanten Differenz erklärt – in Wahrheit benutzt man hier das Kriging-Verfahren zur Interpolation, aber mit demselben Prinzip.) Das Gleiche machen Sie dann im nächsten Monat wieder, usw. Dabei ist es dann egal, ob inzwischen ein neuer Satellit benutzt wird der nicht ganz dieselbe Kalibrierung hat – d.h. die Satellitendaten können ruhig in der Zeit Inhomogenitäten aufweisen, die haben hier überhaupt keinen Effekt.

Hoffe das hilft! (Es ist übrigens nicht unbedingt sinnvoll, eine Studie öffentlich als “sehr zweifelhaft” zu bezeichnen, nur weil man die Methode nicht verstanden hat.)

Sie sammeln für die Veröffentlichung ohne kostenpflichtigen Zugang auf OpenAccess:

http://www.skepticalscience.com/open_access_cw2013.html

Ist ein bisschen Off-Topic, aber herrlich zum Fremdschämen – Rede von FDP-MdL Gero Hocker im niedersächsischen Landtag vor 2 Wochen (7 Minuten):

http://www.youtube.com/watch?v=CyHTnqOturY

Ein paar Zitate:

“Das IPCC hat noch vor 6 Jahren behauptet, dass das Weltklima jedes Jahr um 0,2 Grad steigt” (na gut, war wohl ein Versprecher)

“vor tausend Jahren war Grönland eisfrei”

“in den letzten 15 Jahren gab es keinen nennenswerten Temperaturanstieg”

Wow! Ich habe der FDP Niedersachsen gerade mal den Link zur seinerzeit sehr populären KlimaLounge-Satire Grönland im Mittelalter „fast eisfrei“! getweetet.

Gelegenheit zum Frendschämen gibt es immer wieder, und zwar in reichlichem Maße. Kürzlich hat in der SZ online jemand in einem Leserkommentar behauptet, dass es völlig unerheblich sei, ob C02 in der Atmosphäre mit 0,04, 0,4 oder 100 Prozent vertreten ist – temperaturmäßig mache das keinen Unterschied.

Auch ein interessanter Link (die FDP ist darin natürlich auch vertreten):

http://politikwissenschaft.univie.ac.at/fileadmin/user_upload/inst_politikwiss/IPW_Working_Papers/IPW-WP-1_2013-Achim-Brunnengraeber.pdf

einen muss ich noch nachlegen – “Denkschrift” der Senioren AG der CSU in Bayern:

http://www.csu-portal.de/dateien/verband/1500300000/jahresbericht_eu_b2013.pdf

Zitate:

· Das Spurengas CO2 ist im Lauf der Weltgeschichte auf einen niederen Wert

gesunken.

· Der noch vorhandene CO2-Rest bildet die Lebensgrundlage der Pflanzenwelt, der

Menschheit.

· In den besten Zeiten der Erdgeschichte lag der CO2-Gehalt siebenmal so hoch wie heute!

· CO2 hat einen untergeordneten Einfluss auf das Klimageschehen.

· CO2 aus natürlichen Aktivitäten 0,038% – CO2 aus menschlichen Aktivitäten 0,001%

· Die Eismassen in der Antarktis haben seit 30 Jahren ständig zugenommen

· Der Meeresspiegelanstieg hat sich seit 2003 deutlich auf 2,3 mm p.a. verlangsamt.

· Die Starkwindereignisse haben weltweit nicht zu, sondern abgenommen.

usw…

Pingback:Können Zufallszahlengeneratoren Würfelergebnisse erklären? › KlimaLounge › SciLogs - Wissenschaftsblogs

Pingback:Globale Temperatur 2013 › KlimaLounge › SciLogs - Wissenschaftsblogs

Pingback:2014 wärmstes Jahr in Europa seit mindestens 500 Jahren › KlimaLounge › SciLogs - Wissenschaftsblogs