Das globale Temperatur-Puzzle

BLOG: KlimaLounge

Seit 1998 ist die globale Temperatur langsamer gestiegen als zuvor. Angesichts der vielen in den Medien und Fachliteratur diskutierten Erklärungen (El Niño, Wärmeaufnahme der Ozeane, arktische Datenlücke usw.) könnte man scherzhaft fragen, weshalb noch keine neue Eiszeit ausgebrochen ist. Das verkennt allerdings, dass die diversen Zutaten klein und auch nicht einfach additiv sind. Hier ein kleiner Überblick und Versuch zu erklären, wie die verschiedenen Puzzleteile zusammenpassen.

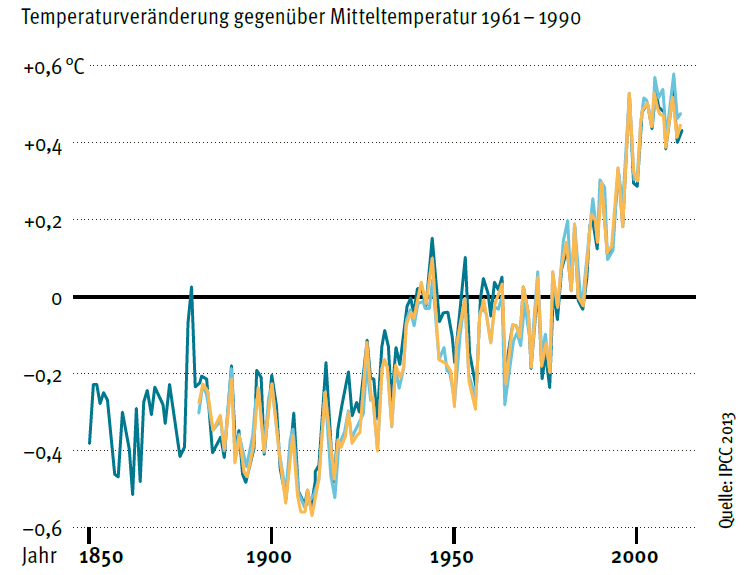

Abb. 1. Die globalen oberflächennahen Temperaturen (Jahreswerte) in den drei gängigen Datensätzen HadCRUT4 (dunkelblau), NOAA (gelb) und NASA GISS (hellblau). Grafik: Zeo2 nach IPCC 2013.

Vorab ein wichtiger Hinweis: der globale Temperaturtrend über nur 15 Jahre ist weder robust noch aussagekräftig für die längerfristige Klimaentwicklung. Ich wiederhole das nun schon seit sechs Jahren in diversen Artikeln, weil dies oft missverstanden wird. Auch der IPCC hat das nochmals klar gesagt (Summary for Policy Makers S. 3):

Due to natural variability, trends based on short records are very sensitive to the beginning and end dates and do not in general reflect long-term climate trends.

Jeder kann das selbst nachvollziehen, indem er den Trend ab Mitte 1997 mit dem Trend ab 1999 vergleicht: letzterer ist mehr als doppelt so groß: 0,07 statt 0,03 Grad pro Jahrzehnt (HadCRUT4-Daten).

Ähnlich sieht es mit Datenfehlern aus: die Trends von HadCRUT- und NASA-Daten unterscheiden sich langfristig kaum, über die letzten 15 Jahre aber deutlich. Und die kürzlich von Cowtan & Way vorgeschlagene kleine Korrektur zum Ausgleich der Datenlücke in der Arktis ändert den HadCRUT4-Langzeittrend fast nicht, den über die letzten 15 Jahre aber gleich um den Faktor 2,5.

Deshalb ist es ein (von manchen allerdings kräftig geschürtes) Missverständnis, aus einem so kurzen Trend Schlüsse über den künftigen Verlauf der globalen Erwärmung oder gar für die Klimapolitik zu ziehen. Zur Illustration zeigt die folgende Grafik eine Modellrechnung aus dem CMIP3-Modellensemble:

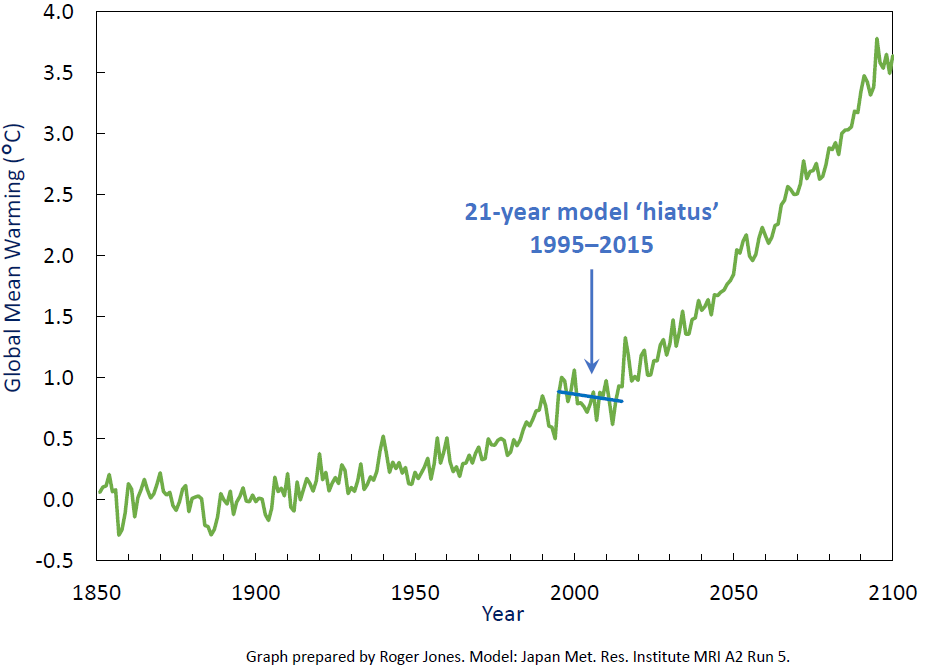

Abb. 2. Temperaturverlauf in einer Modellsimulation mit dem MRI-Modell. Auch in anderen Modellen treten vergleichbare “Pausen” aufgrund der natürlichen Klimaschwankungen auf. Dies ist eine der Standardsimulationen, die im Rahmen von CMIP3 für den IPCC-Bericht von 2007 durchgeführt wurde. Grafik: Roger Jones.

In dieser Modellrechnung gibt es eine „Erwärmungspause“ in den letzten 15 Jahren; deshalb fällt aber die weitere globale Erwärmung keineswegs geringer aus. Die langfristige Erwärmung und die kurzfristige „Pause“ haben nichts miteinander zu tun, haben sie doch ganz verschiedene Ursachen. Nebenbei widerlegt das Beispiel die von „Klimaskeptikern“ gern verbreitete Behauptung, Klimamodelle könnten eine solche „Pause“ nicht erklären – dazu später mehr.

Nun zu den Ursachen des geringeren Trends der letzten 15 Jahre. Grundsätzlich kommen für Klimaänderungen zwei Typen von Ursachen infrage: äußere Antriebe oder interne Schwankungen im Klimasystem.

Äußere Antriebe: Sonne, Vulkane & co.

Zu den möglichen äußeren Antrieben gehört die Abschattung der Sonne durch Aerosolverschmutzung der Atmosphäre durch Vulkane (Neely et al. 2013) oder chinesische Kraftwerke (Kaufmann et al. 2011). Zweitens eine Reduktion des Treibhauseffekts von FCKW, weil diese klimaschädlichen Gase im Montreal-Protokoll weitgehend verboten wurden (Estrada et al. 2013). Und drittens der Übergang vom Sonnenmaximum in der ersten Hälfte zu einem besonders tiefen und langen Sonnenminimum in der zweiten Hälfte des Zeitraums – das ist durch Messungen der Sonnenaktivität belegt, reicht aber quantitativ nur zur Erklärung eines Teils der Verlangsamung (etwa ein Drittel nach unserer Korrelationsanalyse).

Sehr wahrscheinlich haben alle diese Faktoren tatsächlich zu einer Verlangsamung der Erwärmung beigetragen, und sie sind auch additiv – laut IPCC-Bericht (Kap. 9.4) dürfte etwa die Hälfte der Verlangsamung durch einen langsamer zunehmenden Strahlungsantrieb erklärt werden. Problem dabei: die Daten über den Netto-Strahlungsantrieb sind zu ungenau, um seinen Beitrag besser zu quantifizieren. Was wiederum an dem kurzen betrachteten Zeitraum liegt: in dem sind die Änderungen so gering, dass Messungenauigkeiten stark ins Gewicht fallen, anders als bei der langfristigen Klimaentwicklung.

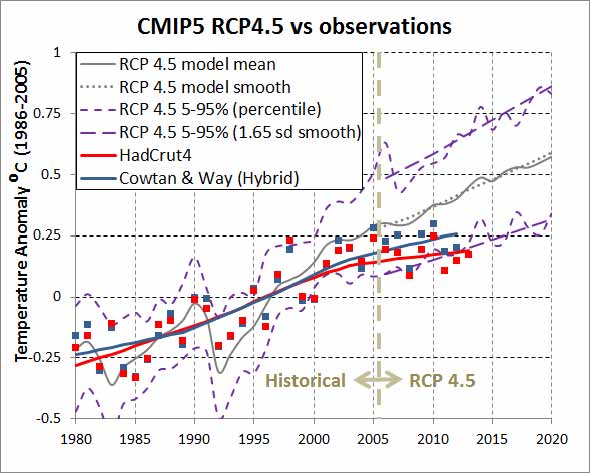

Die Klimamodelle enthalten wegen des langen Vorlaufs bei der Planung und Durchführung solcher Supercomputer-Simulationen die neuesten Daten und Erkenntnisse zu den Antrieben noch nicht. Deshalb laufen auch die aktuellen CMIP5-Simulationen ab dem Jahr 2005 im Szenariomodus (siehe Abb. 6), also nicht mit gemessenen Antriebsdaten. Sie werden daher z.B. mit einem mittleren Sonnenzyklus angetrieben und wissen noch nichts von dem besonders tiefen und anhaltenden Sonnenminimum 2005-2010.

Interne Schwankungen: El Niño, PDO & co.

Die stärkste interne Schwankung im Klimasystem auf dieser Zeitskala ist der Wechsel von El Niño zu La Niña – eine natürliche, zufällige „Klimaschaukel“ im tropischen Pazifik, kurz ENSO genannt (die Abkürzung steht für El Niño Southern Oscillation).

Dass El Niño für unsere Fragestellung wichtig ist sieht man schon daran, wie sehr sich der Trend ändert, wenn man nur 1998 weglässt (s.o.): El-Niño-Jahre sind besonders warm (siehe Grafik), und 1998 war das stärkste El-Niño-Jahr seit Beginn der Aufzeichnungen. Weitere Belege für die entscheidende Bedeutung von El Niño: korrigiert man mittels einer simplen Korrelationsanalyse den Effekt von ENSO und Sonnenzyklen aus den globalen Temperaturdaten heraus, bekommt man einen stetigen Erwärmungstrend ohne jede rezente Verlangsamung (siehe Grafik, Foster and Rahmstorf 2011); ENSO ist dabei für zwei Drittel der Korrektur verantwortlich. Und bringt man ein Klimamodell dazu, im tropischen Pazifik die beobachtete Abfolge von El Niño und La Niña nachzuspielen (statt selbst und damit in zufälliger Abfolge solche Ereignisse zu erzeugen), dann gibt das Modell auch die beobachtete globale Temperaturentwicklung inclusive „Pause“ wider (Kosaka and Xie 2013).

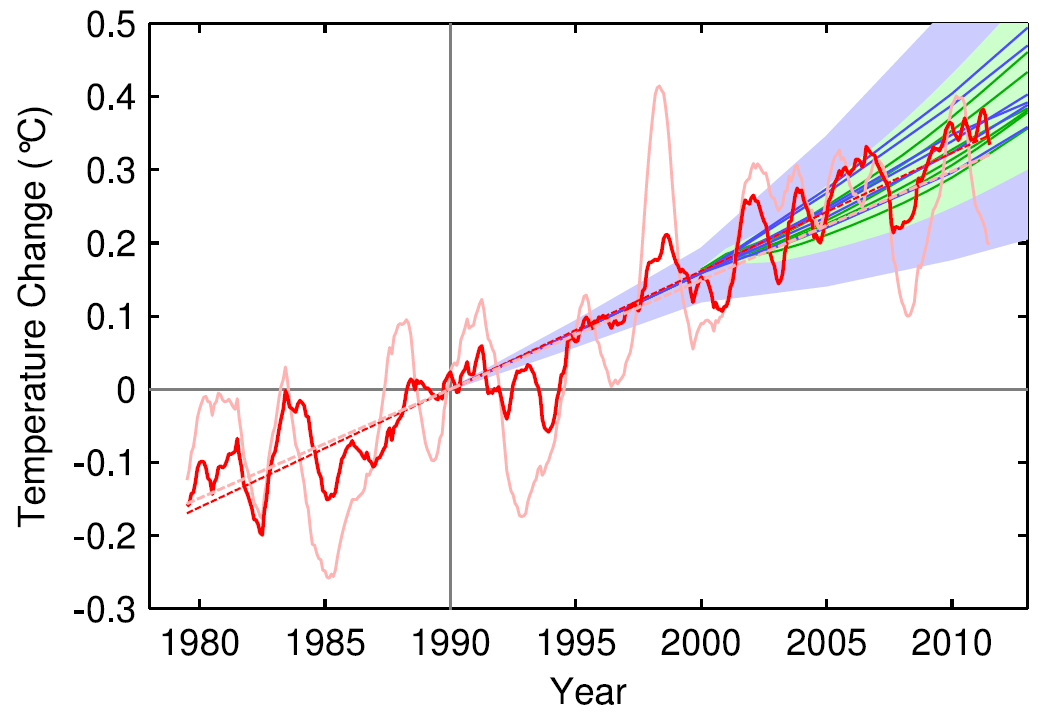

Man kann auch die Frage stellen, wie die beobachtete Erwärmung zu den Vorhersagen des IPCC passt. Das Ergebnis sieht so aus (Rahmstorf et al. 2011):

Abb. 3. Vergleich der globalen Temperatur (Mittelwert über 5 Datensätze, incl. 2 Satellitenreihen) mit den Projektionen aus dem 3. und 4. IPCC-Berichten. Rosa: die gemessenen Werte. Rot: Daten nach Bereinigung um ENSO, Vulkane und Sonnenaktivität durch eine multivariate Korrelationsanalyse. Die Daten sind als gleitendes Mittel über 12 Monate gezeigt. Aus Rahmstorf et al. 2012.

Und was ist mit der ozeanischen Wärmespeicherung? Die ist kein zusätzlicher Effekt, sondern gehört zum Mechanismus, durch den El Niño Jahre warm und La Niña Jahre kalt sind. Während El Niño gibt der Ozean gespeicherte Wärme ab, während La Niña nimmt er verstärkt Wärme auf. Die oft zitierten Messdaten über die Wärmespeicherung im Ozean sind also einfach nur ein weiterer Beleg dafür, dass El Niño eine entscheidende Rolle für die „Pause“ spielt.

Der führende US-Klimatologe Kevin Trenberth forscht seit zwanzig Jahren zu diesem Thema und hat gerade einen ausführlichen erklärenden Artikel dazu publiziert. Trenberth betont die Rolle der längerfristigen Schwankungen der Klimaschaukel ENSO, genannt pazifisch-dekadische Oszillation (PDO). Etwas vereinfacht gesagt: es geht darum, dass Phasen mit häufigern El Niño und Phasen mit häufigeren La Niña Bedingungen (wie derzeit) im tropischen Pazifik bis zu zwei Jahrzehnte anhalten können. Letzteres bringt eine anhaltend etwas langsamere Erwärmung an der Oberfläche unseres Planeten, weil dafür mehr Wärme tiefer im Ozean gespeichert wird. Ein zentraler Punkt dabei: selbst wenn die Oberflächentemperatur stagniert nimmt unser Planet weiter netto Wärme auf. Der zunehmende Treibhauseffekt führt zu einem Strahlungsungleichgewicht: wir absorbieren mehr Wärme von der Sonne als wir wieder ins All zurückstrahlen. Von dieser Wärme landet über 90% im Ozean, wegen der hohen Wärmekapazität von Wasser. Dass der Ozean sich weiterhin ungebremst aufheizt, belegt, dass der Treibhauseffekt keineswegs nachgelassen hat, wie wir hier gezeigt haben.

Wie wichtig der Effekt von El Niño tatsächlich ist, wird sich beim nächsten richtigen El- Niño-Ereignis zeigen. Ich habe bereits letztes Jahr vorhergesagt, dass nach dem nächsten El Niño wieder ein neuer Rekordwert der globalen Temperatur erreicht werden wird – eine Prognose, die sich wahrscheinlich schon bald bestätigen oder falsifizieren lassen wird.

Die arktische Datenlücke

Kürzlich haben Cowtan & Way gezeigt, dass die Erwärmung sich offenbar lange nicht so stark verlangsamt hat wie es die HadCRUT-Daten nahe legten. Nachdem sie mithilfe von Satellitendaten und einem schlauen statistischen Verfahren die Datenlücken im Netz der Wetterstationen aufgefüllt haben, beträgt der globale Trend seit 1998 0,12 Grad pro Jahrzehnt – also nur ein Viertel weniger als der seit 1980 gemessene Langzeittrend von 0,16 Grad pro Jahrzehnt. Das Wissen um diese Datenlücke ist auch nicht neu – Simmons et al. haben z.B. schon 2010 gezeigt, dass deshalb die globale Erwärmung in den HadCRUT Daten unterschätzt wird, und wir haben das bei Realclimate und KlimaLounge seit 2008 wiederholt diskutiert. Die NASA-Daten füllen seit jeher die Datenlücken durch Interpolation, allerdings mit einem einfacheren Verfahren, und zeigen dementsprechend auch kaum ein Nachlassen der Erwärmung.

Die räumlichen Muster

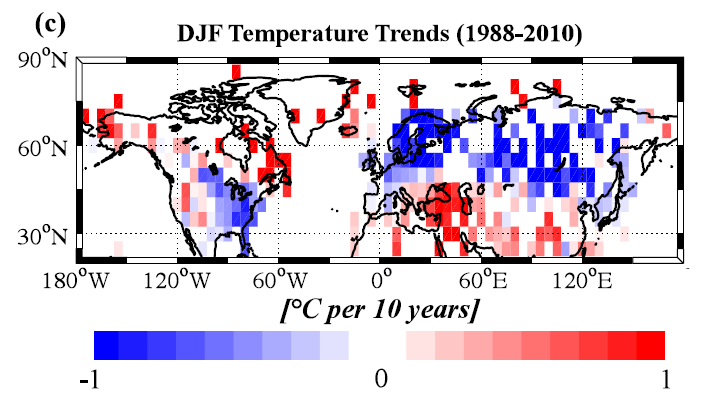

Cohen et al. haben vor zwei Jahren gezeigt, dass es vor allem die kalten Winter in Eurasien sind, die in den letzten Jahren zur Abflachung der globalen Erwärmungskurve beigetragen haben (siehe Abbildung).

Abb. 4. Beobachtete Temperaturtrends in den Wintermonaten. Trotz der deutlichen globalen Erwärmung im Jahresmittel gab es eine winterliche Abkühlung in Eurasien. CRUTEM3-Daten (nur Land!), aus Cohen et al. 2012.

Sie argumentieren, dass eine Erklärung für die „Pause“ in der globalen Erwärmung dieses besondere Muster erklären muss. Das ist aber nicht zwingend: es könnten sich einfach zwei unabhängige Mechanismen überlagern. Einer, der die globale Erwärmung dämpft – der müsste durch die globale Energiebilanz erklärbar sein. Und ein zweiter, der die kalten eurasischen Winter erklärt, ohne aber die globale Temperatur zu beeinflussen. Ich halte letzteres für wahrscheinlich – die zuletzt kalten Winter bei uns sind Teil des viel diskutierten „warm Arctic – cold continents“ Musters (siehe z.B. Overland et al. 2011) und könnten mit der schwindenden Eisdecke auf dem arktischen Ozean zusammenhängen, wie wir hier erläutert haben. Da die Wärme dabei nur verschoben wird und der eurasischen Kälte eine entsprechend wärmere Arktis gegenüber steht, beeinflusst dies kaum die globale Mitteltemperatur – außer man schaut sich die in einem Datensatz mit einer großen Datenlücke in der Arktis an…

Und die Summe?

Wie passt das jetzt alles zusammen? Wie oben begründet halte ich (ebenso wie Trenberth) natürliche Schwankungen, insbesondere ENSO und PDO, für den Hauptgrund der zuletzt langsameren Erwärmung. Aus Sicht der planetaren Energiebilanz ist die Wärmespeicherung im Ozean dabei der entscheidende Mechanismus.

Wenn die Erwärmung nach Bereinigung um ENSO, Vulkane und Sonnenzyklen nun aber schon stetig weiter läuft, würde die Korrektur der Arktislücke durch Cowtan&Way dann nicht bedeuten, dass die Erwärmung nach diesen Korrekturen sich sogar beschleunigt hat? Das könnte sein, aber nur um einen kleinen Betrag. Denn wie man in der Abb. 6 unseres Papers sieht, gibt es zwar nach der genannten Bereinigung in den GISS-Daten und den beiden Satellitenreihen keine Verlangsamung mehr, immer noch aber in den beiden Datensätzen mit der Arktislücke, also HadCRUT und NCDC. Zählt man die Trendkorrektur um 0,08 Grad pro Dekade von Cowtan & Way zu unserem bereinigten Trend ab 1998 hinzu, landet man bei etwa 0,2 Grad pro Dekade und damit praktisch demselben Wert wie in den GISS-Daten. Nimmt man noch die oben genannten Strahlungsantriebe hinzu (ohne die bereits berücksichtigte Sonnenaktivität) kommen vielleicht noch einige Hundertstel dazu. Im Ergebnis wäre das eine etwas schnellere Erwärmung als über den Gesamtzeitraum, aber wohl weniger als die im Zeitraum 1992-2006 gemessenen 0,29 Grad pro Dekade. Also nicht weiter aufregend. Zumal man auf Basis der Modellrechnungen ohnehin Trends um die 0,2 Grad pro Dekade erwartet, weil die keine konstante sondern eine sich allmählich beschleunigende Erwärmung vorhersagen. Was uns zum Vergleich mit Modellen bringt.

Vergleich mit Modellen

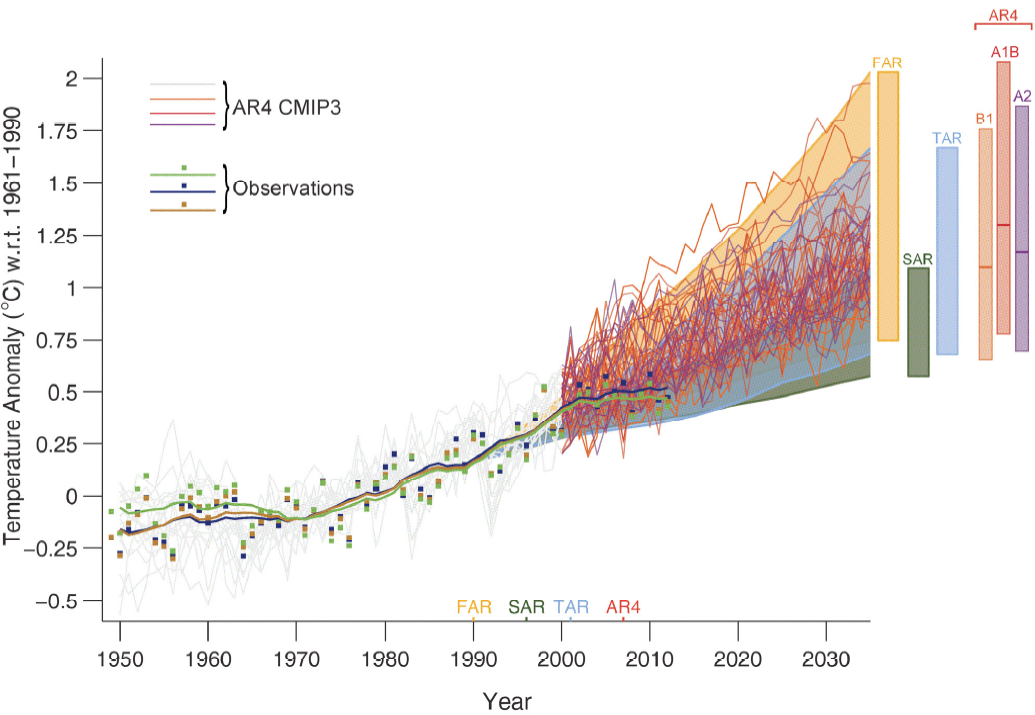

Abb. 5. Vergleich der drei eingangs gezeigten Messdatensätze mit früheren IPCC-Projektionen aus dem 1. (FAR), 2. (SAR), 3. (TAR) und 4. (AR4) IPCC-Bericht, sowie mit dem CMIP3 Modell-Ensemble. Wie man sieht bewegen sich die Daten innerhalb der Prognosen. Quelle: IPCC AR5, Abb. 1.4. (Kleine Fußnote: unseriöse “Klimaskeptiker” haben vor erscheinen des IPCC-Berichts eine frühere, noch fehlerhafte Entwurfsversion dieser Grafik in die Öffentlichkeit gebracht, obwohl sie in Blockschrift als vorläufiger Platzhalter gekennzeichnet war – aber von Watts, Vahrenholt, oder der Daily Mail kann man wohl nichts anderes erwarten.)

Beim Vergleich von Daten mit Modellen muss man eine zentrale Sache verstehen: die Modelle erzeugen auch interne Schwankungen, u.a. durch ENSO, aber da dies (ähnlich wie das Wetter im Modell) ein durch Zufall geprägter Prozess ist, verteilen sich die El Niños und La Niñas zufällig über die Jahre. Von daher wird ein Modell nur in seltenen Fällen zufällig eine Abfolge produzieren, die der realen Abfolge ähnelt und daher just von 1998 bis 2012 eine geringe Erwärmung produziert. Es gibt solche Modelle – siehe die erste Grafik oben – aber die meisten zeigen solche Phasen langsamer Erwärmung eben zu anderen Zeiten.

Der IPCC hat deshalb auch noch nie versucht den Klimaverlauf innerhalb von 15 Jahren vorherzusagen, weil der eben zu stark durch zufällige interne Schwankungen (wie El Niño) geprägt ist, die man bis heute nicht vorhersagen kann.

Alle Modelle zeigen aber solche Schwankungen – sodass niemand, der von der Sache etwas versteht, überrascht sein konnte, dass es solche Phasen geringer Erwärmung geben kann. Es hat sie in der Vergangenheit auch schon gegeben, z.B. ab 1982, wie Trenberth in seiner Abb. 4 zeigt.

Die folgende Grafik zeigt einen Vergleich der Beobachtungsdaten mit dem CMIP5-ensemble von Modellexperimenten, die für den aktuellen IPCC-Bericht gemacht wurden. Die Grafik zeigt, dass das El-Niño-Jahr 1998 am oberen Rand, die beiden letzten kühlen La-Niña-Jahre dagegen am unteren Rand der IPCC-Modellprognosen liegen (aus den oben erläuterten diversen Gründen). Die Temperaturen liegen aber (zumindest nach den Daten von Cowtan & Way) innerhalb des Bereichs, der von 90 % der Modelle aufgespannt wird.

Abb. 6. Vergleich von 42 CMIP5-Simulationen mit den Beobachtungsdaten. Der HadCRUT4-Wert für 2013 ist natürlich vorläufig noch ohne November und Dezember. (Quelle: DeepClimate.org)

Auf fehlerhafte Modelle deutet das also bislang nicht hin (für mehr dazu siehe unseren vorletzten, viel gelesenen Beitrag). Es belegt auch keine geringere Klimasensitivität, auch wenn ein Artikel vor einiger Zeit das vorgeschlagen hat (Otto et al. 2013). Trenberth et al. weisen darauf hin, dass schon die Wahl eines anderen Datensatzes der Ozeantemperaturen die von Otto et al. abgeschätzte Klimasensitivität um 0,5 Grad erhöht hätte. Zudem werden von Otto et al. nur die HadCRUT4 Temperaturdaten mit ihrer besonders geringen Erwärmung verwendet. Bei einer ehrlichen Betrachtung der gesamten Unsicherheit muss man zu dem Schluss kommen, dass ein so kurzer Zeitraum nicht ausreicht, um Rückschlüsse auf die Klimasensitivität zu ziehen.

Fazit

Die globale Temperatur ist in den letzten Jahren etwas langsamer gestiegen als zuvor, aber das bewegt sich im Rahmen der seit jeher vorhandenen natürlichen Schwankungen und auch im Rahmen dessen, was die Klimamodelle vorhergesagt haben – sogar trotz einiger kühlender Antriebsfaktoren wie dem tiefen Sonnenminimum. Es ist daher kein Grund, die Modelle für fehlerhaft zu halten. Es ist auch kein Grund, deshalb eine geringere Erwärmung in Zukunft zu erwarten – im Gegenteil, eher wird das Klimasystem im Rahmen der natürlichen Schwankungen wieder aufholen, etwa wenn die pazifisch-dekadische Oszillation wieder in eine warme Phase zurück schwingt. Schon jetzt sind die globalen Temperaturen wieder sehr hoch – der November war laut NASA-Daten mit einer Anomalie von + 0,77 °C wärmer als das bisherige Rekordjahr 2010 (+ 0,67 °C) und der wärmste November seit Beginn der Aufzeichnungen im Jahr 1880.

PS in eigener Sache: die KlimaLounge ist als einer von 20 Blogs für den Preis für den besten Wissenschaftsblog 2013 nominiert. Wer uns wählen möchte: einfach auf diesen Link gehen, KlimaLounge anklicken und per “vote” button abschicken.

Literatur

- K. Cowtan, and R.G. Way, "Coverage bias in the HadCRUT4 temperature series and its impact on recent temperature trends", Quarterly Journal of the Royal Meteorological Society, vol. 140, pp. 1935-1944, 2014. http://dx.doi.org/10.1002/qj.2297

- R.R. Neely, O.B. Toon, S. Solomon, J. Vernier, C. Alvarez, J.M. English, K.H. Rosenlof, M.J. Mills, C.G. Bardeen, J.S. Daniel, and J.P. Thayer, "Recent anthropogenic increases in SO2 from Asia have minimal impact on stratospheric aerosol", Geophysical Research Letters, vol. 40, pp. 999-1004, 2013. http://dx.doi.org/10.1002/grl.50263

- R.K. Kaufmann, H. Kauppi, M.L. Mann, and J.H. Stock, "Reconciling anthropogenic climate change with observed temperature 1998–2008", Proceedings of the National Academy of Sciences, vol. 108, pp. 11790-11793, 2011. http://dx.doi.org/10.1073/pnas.1102467108

- F. Estrada, P. Perron, and B. Martínez-López, "Statistically derived contributions of diverse human influences to twentieth-century temperature changes", Nature Geoscience, vol. 6, pp. 1050-1055, 2013. http://dx.doi.org/10.1038/ngeo1999

- G. Foster, and S. Rahmstorf, "Global temperature evolution 1979–2010", Environmental Research Letters, vol. 6, pp. 044022, 2011. http://dx.doi.org/10.1088/1748-9326/6/4/044022

- Y. Kosaka, and S. Xie, "Recent global-warming hiatus tied to equatorial Pacific surface cooling", Nature, vol. 501, pp. 403-407, 2013. http://dx.doi.org/10.1038/nature12534

- S. Rahmstorf, G. Foster, and A. Cazenave, "Comparing climate projections to observations up to 2011", Environmental Research Letters, vol. 7, pp. 044035, 2012. http://dx.doi.org/10.1088/1748-9326/7/4/044035

- A.J. Simmons, K.M. Willett, P.D. Jones, P.W. Thorne, and D.P. Dee, "Low‐frequency variations in surface atmospheric humidity, temperature, and precipitation: Inferences from reanalyses and monthly gridded observational data sets", Journal of Geophysical Research: Atmospheres, vol. 115, 2010. http://dx.doi.org/10.1029/2009JD012442

- J.L. Cohen, J.C. Furtado, M.A. Barlow, V.A. Alexeev, and J.E. Cherry, "Arctic warming, increasing snow cover and widespread boreal winter cooling", Environmental Research Letters, vol. 7, pp. 014007, 2012. http://dx.doi.org/10.1088/1748-9326/7/1/014007

- J.E. Overland, K.R. Wood, and M. Wang, "Warm Arctic—cold continents: climate impacts of the newly open Arctic Sea", Polar Research, vol. 30, pp. 15787, 2011. http://dx.doi.org/10.3402/polar.v30i0.15787

- A. Otto, F.E.L. Otto, O. Boucher, J. Church, G. Hegerl, P.M. Forster, N.P. Gillett, J. Gregory, G.C. Johnson, R. Knutti, N. Lewis, U. Lohmann, J. Marotzke, G. Myhre, D. Shindell, B. Stevens, and M.R. Allen, "Energy budget constraints on climate response", Nature Geoscience, vol. 6, pp. 415-416, 2013. http://dx.doi.org/10.1038/ngeo1836

Warum, Herr Rahmstorf, blenden Sie immer in der 1. Grafik an der rechten Seite die Legende mit den absoluten globalen Mitteltemperaturen von 14°C aus, obwohl dieser Wert auch in Ihrem Buch “DER KLIMAWANDEL” dort auf Seite 37 in der dortigen Grafik zu finden ist ?? Auch in Ihrem Kinderbuch praktizieren Sie “diesen Trick”.

Wollen Sie damit die Öffentlichkeit täuschen und hinters licht führen, dass seit über 100 Jahren der absolute globale Mittelwert von 15°C aus dem natürlichen Treibhauseffekt, den Sie ja auch in Ihrem Buch “DER KLIMAWANDEL” auf Seite 31 erwähnen, überhaupt nicht überschritten worden ist, und somit eine gefährliche globale Erwärmung seit über 100 Jahren überhaupt nicht festzustellen ist, wenn man die absoluten globalen Mitteltempeturen betrachtet.

Die WMO in Genf hatte den absoluten globalen Mittelwert von 14,47°C auch noch im Juli 2013 bestätigt.

Deshalb meine Frage: Warum blenden Sie laufend in Ihren aktuellen Publikationen diesen absoluten Wert von 14,5°C aus, Herr Ramstorf ?

Mit freundlichen Grüßen

Paul Bossert für die Unterstützer des

Klimamanifests von Heiligenroth

Das haben wir hier immer wieder mal erklärt, schauen Sie zB einmal hier unter “Basisperiode”:

Es wird nichts ausgeblendet, sondern der absolute globale Mittelwert ist (a) nur sehr ungenau bekannt und (b) in der Praxis irrelevant. Relevant sind Veränderungen der Temperatur, denn die haben Folgen für Mensch und Ökosysteme.

Sehr geehrter Herr Prof. Rahmstorf,

Ihre Antwort ist keine Antwort auf unsere Feststellungen und Fragestellungen, weil (a) SIE und Ihr Kollege Schellnhuber diese angeblich ungenauen absoluten Werte auch noch im März 2012 in der 7. Auflage in Ihrem Buch publiziert haben, die WMO diese absoluten Werte auch noch im Sommer 2013 publiziert hatte und (b) weil relative Werte aus einer mathematischen Logik nicht genau sein können, wenn die darauf basierenden absoluten Werte (angeblich) ebenfalls “nicht genau” sind.

Warum, Herr Rahmstorf, äussern Sie sich nicht zu der Diskrepanz, daß der aktuelle absolute globale Mittelwert von 14,5°C UNTERHALB (!) des Wertes aus dem natürlichen Treibhauseffekt von 15°C liegt, den Sie ebenfalls in Ihren Buch “DER KLIMAWANDEL” auf Seite 31 bei 15°C beschreiben?

Wie kann eine angeblich so gefährliche menschengemachte (!) globale Erwärmung seit Jahrzehnten existieren, wenn die 15°C aus dem natürlichen (!) Treibhauseffekt seit Jahrzehnten nicht überschritten worden sind?

Es befremdet uns so langsam, daß Sie nicht in der Lage sind, diese klargestellten Fragen zu beantworten.

Mit freundlichen Grüßen

Paul Bossert für die Unterstützer des

Klimamanifests von Heiligenroth

Lieber Herr Bossert, in unserem Buch ist (wie in vielen Lehrbüchern) erklärt, dass der natürliche Treibhauseffekt die Erde erst zu einem bewohnbaren Planeten macht, in dem er die mittlere Temperatur von sonst (theoretischen) -18°C um rund 33 Grad auf +15°C erhöht. Darüber sind wir uns einig, oder? Diese Rechnung illustriert einfach die Stärke des Treibhauseffekts.

Dabei hätten wir genausogut -19°C und +14°C schreiben können, weil der tatsächliche Mittelwert der globalen Temperatur nur auf ca. 1 Grad genau bekannt ist.

Wenn Sie ihn genauer wissen wollen, dann bräuchten Sie zigtausende Messstationen, weil die Temperatur kleinräumig stark variiert – etwa vom Talgrund bis zu einem zwei Kilometer entfernten Berggipfel. Die klimatische Veränderung der Temperatur korreliert dagegen großräumig mit einer Korrelationsskala von rund 1200 km, wie in der Fachliteratur belegt (u.a. Hansen&Lebedeff 1987). Denn diese Änderungen sind von großräumigen Effekten angetrieben (den steigenden Treibhausgasmengen) und nicht von kleinräumigen wie der Topographie. Das ist nicht gegen mathematische Logik, sondern es ist jedem messenden Wissenschaftler vertraut, dass man Veränderungen einer Größe präzise messen kann auch wenn die absolute Genauigkeit der Messung wesentlich geringer ist. Sie können z.B. auch die Veränderungen im Wasserstand eines Sees präzise Messen, ohne dessen absolute Tiefe zu kennen – dazu würden Sie den Wasserstand relativ zu einem beliebig definierten Referenzwert angeben, genau wie wir die Veränderung der globalen Temperatur relativ zu einem Referenzzeitraum angeben.

An der absoluten Zahl “15°C” ist nichts Besonderes – Klimawandel wird nicht ab 15°C gefährlich. Klimawandel ist gefährlich, weil es ein “Wandel” ist im Vergleich zu dem, was vorher war und woran wir angepasst sind. Beim Meeresspiegel sieht man das sofort: ein um 100 Meter höherer Meeresspiegel wäre völlig harmlos, wenn er schon seit Jahrtausendem auf diesem höheren Niveau wäre – denn dann hätten wir unsere Küstenstädte an der richtigen Stelle gebaut. Aber ein Anstieg um einen Meter (relativ zu dem, wo er die letzten Jahrhunderte war) ist gefährlich.

Hier würde Ihr Kommentatorenfreund insofern zustimmen, als dass Umstellungskosten zu vermeiden wären, weil die Umstellung (“Es wir wärmer”) zumindest auf den ersten Blick keinen kompensierenden Nutzen mit sich bringen dürfte.

Vermutlich auch auf den zweiten Blick nicht, insofern wäre der konservativen Forderung, dass das Klima gleich bleiben sollte, weil dies günstig wäre, zuzustimmen.

Aber warum sich der Schreiber dieser Zeilen hier meldet: Wenn die Umstellung vermeidenswert wäre, an und für sich das Problem wäre, warum wird dann von Extremwetterereignissen berichtet bzw. von deren Zunahme, wenn dieser Sachverhalt doch “nur” Umstellung bedeuten würde und nicht etwa etwas Schlechtes an sich?

MFG

Dr. W

Da z.B. die Hitzewelle im Sommer 2003 in Europa rund 70.000 Tote gefordert hat, finde ich persönlich die Zunahme solcher Extremereignisse “etwas Schlechtes an sich”.

Soweit Sie sich auf Hansen&Lebedef aus dem Jahr 1987 beziehen, verweisen wir darauf, dass diese beiden Herren im Jahr 1987 genau in dieser von Ihnen zitierten Studie den damaligen globalen Mittelwert bei ca. 15,4°C festgelegt hatten. Der SPIEGEL hatte darüber berichtet und ihr Kollege Peter Hennicke hatte diesen Wert vom 15,4°C in seinem Buch “Ozonloch und Treibhauseffekt” (1990) auf der Seite 71 in der dort verwendeten Grafik ausgewiesen. Wir informieren darüber in unserem Video von Kapitel 7 der “unbequemen Wahrheiten”: http://www.klimamanifest-von-heiligenroth.de/wp/?p=500

Es ist schon merkwürdig, dass Sie im Jahr 2008 in Ihrem Blogtext

https://scilogs.spektrum.de/klimalounge/klimawette-teil-2/

eine Grafik verwenden, die einen absoluten globalen Mittelwert unterhalb dieses damaligen Wertes von 15,4°C ausweist.

Es geht nicht zwingend um die Fragestellung, ob eine Temperaturerhöhung ab 15°C als gefährlich oder nicht-gefährlich anzusehen ist, sondern um die Feststellung, dass ein absoluter globaler Mittelwert UNTERHALB von 15°C zwingend als NATÜRLICH zu bewerten ist, wenn die von Ihnen präferierte Theorie vom natürlichen Treibhauseffekt von 15°C stimmen soll. Erst AB einem globalen Mittelwert von 15°C kann man zwingend von einer (vielleicht) menschengemachten globalen Erwärmung reden, vorher nicht. In den Anfangsjahren der Klimawissenschaft seit 1987, ab dem Zeitpunkt, an dem sich die Politik bzw. der Deutsche Bundestag sich in die Klimadebatte eingeschaltet hatte, hat die Klimwissenschaft gegenüber der Politik genau diese Argumentation von “15°C plus X” (vergl. Schönwiese 1992) verwendet.

Es wird alles in unserem Video von Kapitel 7 recherchiert dargestellt !!

Wir bitten Sie unsere Recherche zu kommentieren und nicht wieder zuzensieren. Wir werden diesen unseren Kommentar als Screenshot Nachweis sichern.

Paul Bossert für die Unterstützer

des Klimamanifests von Heiligenroth

Ich fürchte, Sie haben sich hier in ein grundlegendes Missverständnis verrannt – der Absolutwert der globalen Temperatur ist weder genau bekannt, noch hat er eine praktische Bedeutung. Da die globale Temperatur in der Erdgeschichte um mehrere Grad nach oben und unten geschwankt hat (z.B. letzte Eiszeit rund 5°C kälter als heute, Kreidezeit rund 5°C wärmer) ist es auch unsinnig, eine bestimmte Temperatur als “natürlich” zu bezeichnen.

Und zitieren Sie doch mal genau, wo Hansen & Lebedeff in ihrem Paper von 1987 die globale Temperatur “bei ca. 15,4 °C festgelegt” haben? Ich finde das dort nicht, das ganze Paper dreht sich um Temperaturveränderungen relativ zur Basisperiode 1951-1980. Unter den GISS-Daten – und das ist der in dem Paper von Hansen begründete Datensatz – steht seit jeher:

Wenn Sie ernst genommen werden wollen, sollten Sie es vielleicht mit ein paar weniger platten Unterstellungen, Großbuchstaben und Ausrufezeichen in Klammern versuchen, das HEMMT nämlich (!) den (!) LESEFLUSS und könnte den Leser (!) so langsam BEFREMDEN.

Und übrigens lernt man auch in der Schweiz, dass man 14,5°C auf 15°C aufrunden kann. Da muss man nicht die große Verschwörung auspacken!

Ich habe den Eindruck, dass die hypothetische globale Durchschnittstemperatur seit neuestem ein beliebter Spiel- und Tummelplatz für klimaskeptische Kreise geworden ist. Dabei fehlt allerdings diesen Kreisen die Einsicht bzw. das Verständnis dafür, dass es vollig egal ist, ob ein möglicher globaler Durchschnittswert nun 14,3 °C, 14,7 °C oder 15,1 °C beträgt.

Das wurde in diesem Blog schon öfters erörtert, und hier wird es nochmals ausführlich erklärt:

http://globalklima.blogspot.de/2009/04/warum-es-egal-ist-ob-es-eine-mittlere.html

Zu belegen bleibt die Erwartungshöhe der Prognosis, die sich laut IPCC und auf einen Durchschnitt bezogen, die die entwickelten Szenarien bilden, auf ca. +0,3 C / Dekade belaufen sollte.

Sollte sich die Erwartungshöhe auf die terrestrischen Oberflächentemperaturen bezogen absteifen, wäre mehr Zeit gewonnen um gegenzuwirken.

MFG

Dr. W

Das verstehe ich nicht – was genau sind die +0,3 C/Dekade und woher kommt diese Zahl?

Lieber Herr Dr. Rahmstorf, die +0,3 C / Dekade ergeben sich, wenn ein Durchschnittswert für die Erwartungshöhen einiger exemplarisch von der IPCC genannter Szenarien gebildet wird, die Jahre bis 2013/4 bis 2100 meinend.

Welche durchschnittliche Erwartungshöhe würden Sie denn entgegensetzen wollen, falls Sie dies tun möchten?

MFG

Dr. Webbaer

Mir war nur unklar, was Sie meinten. Wenn ich Sie recht verstehe sagen Sie nur, dass eine Erwärmung um drei Grad in hundert Jahren im Durchschnitt 0,3 Grad pro Jahrzehnt sind. Dies so anzugeben ist etwas verwirrend, weil die Erwärmung in solchen Szenarien sich ja allmählich beschleunigt, sodass dieser Durchschnitt typisch für die Erwärmungsraten um die Mitte des Jahrhunderts ist, ansonsten aber nicht. Am Anfang geht es langsamer, später schneller. Im Beitrag oben geht es ja um die Anstiegsrate zu Anfang des Jahrhunderts, und die Grafiken zeigen ja die Szenarien dafür.

In prähistorischer Zeit war der CO2-Gehalt ca. 180 ppm, er ist jetzt bei ca. 400 ppm, die Steigung beträgt zurzeit ca. 20 ppm / Dekade, die Klimasensitätsmodellierung fordert je Verdoppelung des atmosphärischen CO2-Gehalts +2 bis +4,5 C – insofern ist dem Schreiber dieser Zeilen Ihre Aussage ‘Am Anfang geht es langsamer, später schneller.’ leider weiterhin unklar, wenn eine Exponentialität definiert ist, in dem Sinne, dass die Verdoppelung des CO2-Gehalts zu einer statischen Temperaturzunahme führt.

Abschlußfrage: Es hat zwischen 1880/01, die bekannten Oberflächentemperaturdaten des GISS [1] betreffend, und 2013/11 eine Zunahme der terrestrischen Oberflächentemperaturen von ca. +0,8 C gegeben, was einem durchschnittlichen Anstieg von ca. 0,06 C / Dekade entspricht, Sie sind der Überzeugung, dass dieser Anstieg durchschnittlich 0,3 C / Dekade bis 2100 erreichen wird, korrekt?

MFG

Dr. W

[1] -> http://data.giss.nasa.gov/gistemp/tabledata_v3/GLB.Ts+dSST.txt

Die interne Variabilität und nicht eine tiefere Klimasensitivität erklärt also den Erwärmungs-Hiatus der letzten 15 Jahre. Damit ist auch die Schlussfolgerung des Papiers “Energy budget constraints on climate response” von Otto et. al

voreilig. Und doch scheint das Papier von Otto et. al. (und einige Vorgängerstudien, die eine tiefere ECS gefunden haben) bereits den AR5 des IPCC beeinflusst zu haben. Dort wurde nämlich die untere Schwelle für die Langzeit-Klimasensitivität von 2°C auf 1.5°C heruntergesetzt:

Michael Mann kritisiert den AR5 für diese Anpassung der ECS nach unten (hier)

Tatsächlich macht es natürlich einen Riesenunterschied aus ob sich die Temperatur bei CO2-Verdoppelung um 1.5 oder um 4.5 Celsisus erhöht. Das könnte genau der Unterschied zwischen einem verkraftbaren und einem katastrophalen Klimawandel sein.

Da fehlt doch noch eine Kleinigkeit bei den ansonsten sicherlich validen Zitaten…

s. WG1, ch. 12 und die entsprechende Literatur seit Knutti/Hegerl, 2007

Was hat sich denn beim mittleren Vergleichswert zwischen den diversen Untersuchungslinien geändert? War da nicht auch im 5th report die übliche Rede von “3 to 4”? Mit *gutem* Grund? Mit dem ebenso üblichen Zugeständnis an Vernunft und Redlichkeit, dass es auch gerne (und hoffentlich…) “nur” 2.9, 2.8 und wenn irgend möglich auch nur 2.7 sein *mögen*?

Hallo Martin Holzherr,

“Tatsächlich macht es natürlich einen Riesenunterschied aus ob sich die Temperatur bei CO2-Verdoppelung um 1.5 oder um 4.5 Celsisus erhöht. Das könnte genau der Unterschied zwischen einem verkraftbaren und einem katastrophalen Klimawandel sein.”

So wie es aussieht, entspricht die Spannweite an Ergebnissen von 1,5 bis 4,5°C bei einer Verdoppelung des CO2-Anteils dem aktuellen Wissensstand. Und es macht sehr wahrscheinlich einen großen Unterschied aus, wenn in der Realität bei einer konkreten Verdoppelung eine Erwärmung von 1,5°C oder 4,5°C stattfindet. Die Frage ist nur, welche Schlussfolgerungen zieht man daraus? Denn selbst 1,5°C innerhalb von 2-3 Generationen sind auch keine Kleinigkeit und werden die natürlichen Rahmenbedingungen merkbar verändern. Und selbst das Risiko, dass es noch mehr wird, kann man nicht so einfach ignorieren.

In solchen Situationen ist es oft allzu menschlich, wenn da einige nach dem Prinzip Hoffnung gehen wollen. Nach dem Motto “wird schon nicht so schlimm werden”.

Sehr geehrter Herr Prof. Rahmstorf,

wenn 1998 ein starkes El-Nino-Jahr war, dann mag es sein, dass wir seit 1999 in einem langfristigen La-Nina-Modus sind. Laut Artikel kann dieser bis zu 20 Jahren andauern.

Gesetzt, das wäre der Fall, dann müsste sich der Erwärmungstrend ungefähr ab 2020 wieder beschleunigen.

Würden Sie soweit gehen, dass sich um das Jahr 2020 entscheidet, ob die derzeitigen Modelle zum Temperaturanstieg tragfähig sind? Ich meine, an irgendeinem Punkt wird die Pause ja zu lang, als das man das dann noch innerhalb der Modelle erklären könnte. Wann sehen sie diesen “Punkt der Wahrheit” erreicht. 2020 oder eher oder später?

Mit freundlichen Grüßen

SGL

Wenn die gemessenen Temperaturen aus dem von Modellen aufgespannten Erwartungsbereich herauslaufen, dann muss man sich fragen, was an den Modellrechnungen nicht stimmt – der Antrieb oder das Modell selbst. Wann – oder ob jemals – das der Fall sein wird, hängt natürlich vom künftigen Verlauf der Temperaturen ab, sodass ich da keine Zahl nennen kann.

Na das kann ja was werden.

Ich denke das es vielen erst wirklich klar wird, wenn man mal knallharte Fakten wie diese gezeigt bekommt und dann mal ein paar Jahre in die Zukunft schaut.

Ich zum Beispiel hatte das komplett unterschätzt :O

Danke für den informativen Artikel, hatte bisher noch keinen Bericht gesehen oder gelsesen, der es derart verständlich und deutlich zeigt!

LG Hellma

Lieber Herr Rahmsdorf,

ich habe mir die Plattform zur Wahl des besten Wissenschaftsblog 2013 mal genauer angeschaut. Mir ist es mit recht einfachen Mitteln gelungen, Mehrfachvotes abzugeben (natürlich für Ihre Klimalounge). Von Skeptikern ist ja bekannt, dass sie teilweise gut vernetzt sind und sich gegenseitig in Foren, Buchrezensionen, etc. “hochbewerten”. Demgemäß wurde der unsägliche ScSk-Blog ja auch zweiter beim letztjährigen Voting. Ich kann mir gut vorstellen, dass die Fanatiker rund um ScSk alles daran setzen werden, das Ergebnis in ihre Richtung zu manipulieren.

Beste Grüße

Olga Stuss

Hier möchte ich darstellen, welche Konsequenzen das Papier von Otto et. al “Energy budget constraints on climate response” für den Temperaturverlauf in diesem Jahrhundert hat und seine Abschätzungen denen des IPCC AR5 gegenüberstellen.

Die von Otto et. al vorgelegte beste Abschätung der Transient Climate Response liegt bei 1.3°C. Damit wäre im Moment wo die atmosphärische CO2-Konzentration 560 ppm erreicht (Verdoppelung gegenüber präindustriell), die Temperatur um 1.3°C höher als präindustriell. Unter der Annhame, die CO2-Konzentration steige weiterhin um 2 ppmv pro Jahr, so wie sie das im Zeitraum 2000 bis 2013 getan hat, wäre der Zeitpunkt der CO2-Verdoppelung gegenüber präindustriell in den 2080er Jahren erreicht. Dann wäre die Temperatur nach Otto et al. um 1.3°C höher als präindustriell und damit 0.4-0.5°C höher als heute. Nach IPCC AR5-Bericht wären jedoch in den 2080er Jahren im Mittel 1.8°C Erwärmung zu erwarten.

Der in der Abbildung 2 dieses Artikels gezeigte Temperaturverlauf (Japan Met.Res Institute MRI A2 Run 5) zeigt dagegen in den 2080er Jahren einen Temperaturanstieg von 3.0°C gegenüber präindustriell. Unter Annahme des gleichen CO2-Anstiegs wie oben angenommen, wäre dies bereits knapp ausserhalb des vom IPCC AR5 angenommenen TCR-Bereich von 1-2.5°C (5-95% Vertrauensintervall)

Wie Alexander Otto in The “warming pause” and the transient climate response to a doubling of CO2 darlegt, haben seine wesentlich geringeren Einschätzungen der Transient Climate Response aber nur den Effekt, dass sich die Erwärmung um 15 Jahre verzögert, wenn der CO2-Ausstoss so weitergeht wie bis anhin:

Fazit: Bei unveränderter CO2-Emissionensentwicklung bis 2070 wird die Temperatur mit grosser Wahrscheinlichkeit weniger als 2°C bis 2050 ansteigen und weniger als 4°C bis 2100 (beides gegenüber der Temperatur um 1850). Eine weitere Erwärmung im 22. Jahrhundert steht bei diesem Emissionszenario aber bereits fest.

Sehr geehrter Herr Rahmstorf, Sie fragen:

“Und zitieren Sie doch mal genau, wo Hansen & Lebedeff in ihrem Paper von 1987 die globale

Temperatur “bei ca. 15,4 °C festgelegt” haben?”

Die NewYorkTimes hatte im Juni 1988 Hansen und Lebedeff zitiert:

http://www.klimamanifest-von-heiligenroth.de/wp/wpcontent/

uploads/2013/12/NYT_NewYorkTimes_19880624_GlobalWarming.pdf

Der SPIEGEL hatte diese Recherche in der SPIEGEL-Ausgabe 28/1988, Seite 158 übernommen:

http://wissen.spiegel.de/wissen/image/show.html?

did=13529172&aref=image036/2006/05/15/cq-sp198802801580159.pdf&thumb=false

Und Peter Hennicke hatte diese SPIEGEL-GRAFIK in seinem Buch “Ozonloch und Treibhauseffekt” im Jahr 1990 verwendet:

http://www.klimamanifest-von-heiligenroth.de/wp/wpcontent/

uploads/2013/12/Ozonloch_Treibhauseffekt_1990_Hennicke_Klima_15Grad_globaleMitteltemperatur_Titel_S71.pdf

Wir sind nicht diejenigen, die sich in die globale Erwärmung “verrannt” haben, sondern wir recherchieren nur das

“Verrennen” der Klimaforscher seit über 20 Jahren in die “globale Erwärmung”.

Bitte zensieren Sie unsere Hinweise nicht erneut, sondern kommentieren Sie unsere Recherchen mit den nötigen wissenschaftlichen Seriösität.

Mit freundlichen Grüßen

Paul Bossert für die Unterstützer des

Klimamanifests von Heiligenroth

Bitte die Stelle im Paper, es ist frei online verfügbar. Medienberichte sind hier nicht relevant, Sie sagten ja das stünde in dem Paper und ihre Kernthese war doch, dass Hansen und Lebedeff und nicht die Medien dies so festgelegt haben sollen.

Das “Paper” ist NICHT frei verfügbar. Es kommt jedesmal bei den Links die Meldung “not found”. Es existiert aber diese Webseite hier: http://iridl.ldeo.columbia.edu/SOURCES/.Indices/.HANSEN/.Global/.dataset_documentation.html

und mit roten Pfeilen von uns, hier:

http://www.klimamanifest-von-heiligenroth.de/wp/wp-content/uploads/2013/12/JamesHansen_15Grad_1987_rotMark.pdf

Hier ist das Paper: http://pubs.giss.nasa.gov/abs/ha00700d.html

Google bringt mir das auf Platz 1 und 2 bei Suche nach “Hansen Lebedeff 1987”.

Danke für den Link. Wahrlich ist in dem “Paper” kein Wert von “15,4°C zu finden. Merkwürdig ist allerdings, dass der Link zur .pdf-Datei den Dateinamen

mit “….deff_1.pdf” – also mit: Unterstrich 1 – trägt (http://pubs.giss.nasa.gov/docs/1987/1987_Hansen_Lebedeff_1.pdf), was den Anschein erweckt, dass es sich um eine modifizierte Datei im Vergleich zur Ursprünglichen Datei aus 1987 handeln könnte.

Aber man müsste dann mal die Universität von Columbia fragen, wie die Damen und Herren dort auf die “15,4°C” aufgrund des “Hansen-Lebedeff-Papers” von 1987 gekommen sind. Herr Rahmstorf dürfte dort die betreffenden Kontaktpersonen kennen. Denn auch Christian Schönwiese beruft sich im Jahr 1992 in seinem Buch “Klima im Wandel” auf Seite 75 in der Abb. 18 auf “Hansen&Lebedeff”.

Was die TAGESSCHAU-Grafik vom 27.12.2013 betrifft, so beruft sich die Grafik wohl auf eine alte Schönwiese-Grafik von dem Jahr 1995, die Schönwiese in seinem Buch “Klimaänderungen” im Jahr 1995 publiziert hatte, Nachweis als “PRIMÄRQUELLE” (!) hier:

http://www.klimamanifest-von-heiligenroth.de/wp/wp-content/uploads/2013/12/Schoenwiese_1995_Klimaaenderungen_web.pdf#page=4

Die TAGESSCHAU-Grafik vom 27.12.2013 hat die Buchseite 92 mit der dortigen “Abb. 25” farblich visuell “aufgepeppt”, aber die Kern-Aussage, Legendenbeschriftung und Skalierung ist nahezu identisch. Insbesondere die “15°C” als “Normal-Null-Wert” ist das beachtenswerte Kriterium, was den heutigen Klimaforschern ja nun “Kopfzerbrechen” bereitet, wo der aktuelle globale Mittelwert ja nur bei 14,5°C liegen soll (gemäß “Primärquellen”: Schellnhuber (2012), Rahmstorf (2012), Latif (2012), WMO-Genf (2013)).

Wir haben in unserem Archiv noch weitere “Klimawandel”-Publikationen (“Primärquellen”), wo genau diese Grafik mit der “15°C-Normal-Nulllinie” verwendet worden ist.

Mit freundlichen Grüßen

Paul Bossert für die Unterstützer des Klimamanifests

von Heiligenroth

Sie müssen vermutlich erst erklären, was genau ein Paper eigentlich ist.

Man könnte erstaunt sein warum die Erwartung einer Temperaturänderung sich immer auf den atmosphärischen Temperaturanstieg beziehen muss . Würde die Erwärmung sich ausschliesslich auf die Wassermassen auswirken (was natürlich langfristig unmöglich ist) wäre das in keinster Weise beruhigender .

Es wäre interessanter wenn jemand wie Herr Bossert seine Skepsis mithilfe nachvollziehbaren Argumenten darlegen würde. So empfinde ich es eher als zielungenaues Projektil eines Flächenbombardements .

Sehr geehrter Herr Rahmstorf,

schauen Sie mal, was auf TAGESSCHAU.DE ausgewiesen wird:

http://wetter.tagesschau.de/wetterthema/2013/12/27/klima-macht-geschichte.html

Auch auf TAGESSCHAU.DE wird also eine “Globale Erwärmung” erst ab ÜBER 15°C globale Mitteltemperatur ausgewiesen.

Mit freundlichen Grüßen

Paul Bossert für die Unterstützer des Klimamanifests

von Heiligenroth

Für den Unterstützer-Kreis des “Klimamanifests” ist offenbar eine simple und “freihand-gestylte” Tagesschau-Grafik eine reputable wissenschaftliche Studie. Wenn Sie noch mehr “Beweise” dieser Art liefern, laufen Sie allerdings Gefahr, sich allmählich lächerlich zu machen, und weckt zudem erhebliche Zweifel an der Methodik und Seriosität Ihres sog. Klimamanifests.

Es wurde an dieser Stelle schon oft geschrieben, dass eine Durchschnittstemperatur von 15 °C eine hypothetische Größe darstellt, die nicht genau bestimmt werden kann und als Basismesswert für die globale Erwärmung deshalb irrelevant ist. Ich frage mich, was daran so schwer zu begreifen ist … es sei denn, man will es nicht begreifen. .

Im IPCC-Bericht 2007 (“The Physical Science Basis”) steht auf Seite 97:

“the global mean surface temperature is about 14°C”

Basiert dieser Satz im IPCC-Bericht 2007 mit dem Wert von 14°C dann auch auf einer “hypothetischen Größe” ??

Und wenn man sich dann noch in diesem IPCC-Bericht 2007 auf Seite 947 die Behauptungen im Glossar/Anhang über den “Greenhouse Effect” anschaut, wo “14°C” ausgewiesen werden, Herr Rahmstorf in “DER KLIMAWANDEL” (Seite 31) aber “15°C” als Wert aus dem natürlichen Treibhauseffekt ausweist, dann haben sich 1°C globale Erwärmung (0,7°C bis 0,8°C globale Erwärmung seit 1850) schon wegen dieser angeblich “hypothetischen Größe” zwangsläufig in Luft aufgelöst.

Wir danken für diese erneute Bestätigung !!

Zitat:

“dann haben sich 1°C globale Erwärmung (0,7°C bis 0,8°C globale Erwärmung seit 1850) schon wegen dieser angeblich “hypothetischen Größe” zwangsläufig in Luft aufgelöst.”

Dieser Passus zeigt leider, dass Sie den Kern des Problems, der Ihnen in dutzenden von Beiträgen von Stefan Rahmstorf und anderen Kommentatoren versucht wurde zu erklären, immer noch nicht verstanden haben. Nicht einmal ansatzweise.

Sehr geehrter Herr Bossert,

sie wurden nun schon mehrfach aufgefordert ihre Aussagen mit einer Primärquelle zu belegen.

Warum machen sie das nicht einfach mal? Was hält sie davon ab? Warum verweisen sie immer wieder auf Medienberichte?

Oder sind für sie Medien, die über etwas Berichten was andere “behaupten/schreiben/sagen/zum Ausdruck bringen wollen/ publiziert haben/ etc. , eine Primärquelle?

MfG

Das Bild zeigt eine Jahrzehnte alte Paläoklima-Rekonstruktion. Sie soll relativ warme und relativ kalte Phasen aufzeigen – eine Methode, den Absolutwert der globalen Mitteltemperatur zu bestimmen, sind Proxidaten mit Sicherheit nicht – warum würden Sie das denen eher zutrauen als dem Messnetz der Wetterstationen? Zumal unser Leser ajki ja dankenswerterweise die Quelle verfolgt hat: dort findet sich die Grafik mit Copyright-Vermerk von einem Herrn Kehl, der als Quelle Dansgaard und Johnsen (1969) angibt. In diesem Paper findet sich tatsächlich eine der frühesten derartigen Rekonstruktionen – die stammt allerdings nur vom Camp Century Eisbohrkern in Grönland und gibt nur die dortige lokale Temperatur wider. In dem Originalpaper ist auch gar keine Temperaturskala an der Kurve dran, sondern nur die Sauerstoff-18 Isotopenanomalie (Willi Dansgaard und Sigfus Johnsen waren Pioniere bei der Entwicklung dieses Proxies für Temperatur). Wenn jemand da später den Wert “15 °C” an den Mittelwert drangeschrieben hat, hat das mit der Mitteltemperatur auf Grönland oder einer Bestimmung der globalen Mitteltemperatur mit Sicherheit nichts zu tun!

Der “Jemand” war Prof. Dr. Christian Schönwiese von der Uni Frankfurt, spätestens im Jahr 1995 (“Klimaänderungen”, Seite 92, Abb. 25: “nach Schönwiese 1994a”)

http://www.klimamanifest-von-heiligenroth.de/wp/wp-content/uploads/2013/12/Schoenwiese_1995_Klimaaenderungen_web.pdf#page=4

In einigen Ihrer Kommentare erwecken Sie möglicherweise bei einem Leser den Eindruck, als würden die Arbeiten/Veröffentlichungen von Herrn Prof. em. Schönwiese Ihre eigenen Ansichten in irgendeiner Form unterstützen. Das ist in gar keiner Hinsicht der Fall.

[…]

Für Interessierte sei auf die Webseite der JvGoethe-Universität hingewiesen, die für Herrn Schönwiese betrieben wird und unter anderem eine Publikationsliste enthält, die zum Teil auch (Anfang 2014) aktuelle Links enthält. Selbst eine ganz oberflächliche Sichtung von Veröffentlichungen macht klar, dass Sie die Arbeiten von Schönwiese nicht als Beleg für *irgendetwas* aus Ihrer Agenda “nutzen” können.

http://www2.uni-frankfurt.de/45306498/Publikationen

Sehr geehrter Herr Rahmstorf,

Danke für Ihren langen Artikel. Mir ist eines unklar: Mehrere Forschergruppen nehmen mittlerweile an, dass die Erwärmungspause bis in die 2030er Jahre andauern könnte. In diesem Fall wäre der Zeitraum sehr wohl klimatisch relevant und die mittlere Erwärmung reduziert:

Li et al. 2013 (Geophysical Research Letters), http://www.kaltesonne.de/?p=15274

Wyatt & Curry 2013 (Climate Dynamics), http://www.kaltesonne.de/?p=13580

Grund für die Verlängerung der Erwärmungspause wäre die AMO/PDO-Zyklik, die bis in diese Zeit kühlend wirken wird. Bei einer Gesamtzyklenperiode von 60 Jahren erscheint mir die Aufteilung 30/30 wärmend/kühlend logisch. Die wärmende Phase von AMO/PDO fiel bekanntlich in die Erwärmungszeit 1977-1998. Mehrere Studien kamen daher zu dem Schluss, dass 40-50% der beobachteten Erwärmung der letzten Jahrzehnte auf diese 60-Jahres-Ozeanzyklen zurückzuführen seien:

Tung & Zhou 2013 (PNAS), http://www.kaltesonne.de/?p=10093

Liu & Sui 2012, http://www.kaltesonne.de/?p=12692

Sehen Sie die Lage grundsätzlich anders oder wäre dies ein plausibles Szenario?

Mit freundlichen Grüßen

Frank Schneider

Diese Graphik kann bestenfalls eine schematische Darstellung sein. Als ob die “Kleine Eiszeit” einen globalen Temperaturabfall von nahezu 1°C verursacht hätte; Quatsch.

Wie wir wissen handelte es sich bei der “Kleinen Eiszeit” um eine Abkühlung bestimmter Areale auf der Nordhalbkugel.

Großartig. Einfach nur großartig.

X-mal wurde nun schon aufgefordert, irgendwelche Primärquellen zum Beleg für irgendwas zu nutzen – und was kommt nun ganz aufgeregt daher? Ein Verweis auf eine Übersichtsseite der *ARD*, verfasst von einem Mitglied der “Wetterredaktion”, die ihrerseits selbstverständlich keine Quelle ihrer Grafik nennt. Dafür sind die Denialists allüberall über dieses Bildchen vollkommen aus dem Häuschen und titeln ihre Blogbeiträge mit “German Television finally admits…” usw.

Wenigstens haben einige Übereifrige die wahrscheinliche Quelle für die aufgepeppte Grafik aufgetan. Die Kurve scheint von einer Instituts-Webseite der TU-Berlin zu stammen (PD Dr. Kehl) und zu Lern-/Ausbildungszwecken (innerhalb eines größeren Zusammenhangs) zu dienen. Überschrift: “Average near-surface temperatures of the northern hemisphere…” – *northern* statt “global”!

Dazu die Quellenangabe: “Modified after Dansgaard & Johnson (1969) and Schönwiese (1995)” – brandaktuell, sozusagen. Und inwieweit dort “modified” wurde, will man vielleicht lieber gar nicht erst wissen.

http://lv-twk.oekosys.tu-berlin.de//project/lv-twk/002-holozaene-optima-und-pessima.htm

Was wohl Dansgaard zu den kreativen Mißbräuchen seiner Forschung sagen würde?

Herr Rahmstorf hatte in diesem Jahr die Freundlichkeit, hier eine kurze Übersicht über den Stand der Dinge zur palaöklimatischen Datenlage in einer kleinen Reihe zu präsentieren (Mann, Shakun et.al., Marcott et. al., PAGES2K etc.). Schauen Sie sich doch wenigstens das einmal in Ruhe an – setzen Sie sich sozusagen in den Wheelchair. 😉

Hallo Herr Rahmstorf,

ich hätte 3 Fragen:

1.Stagnation der Erwärmung in den letzten Jahren: Die CMIP5-Simulationen ab dem Jahr 2005 im Szenariomodus arbeiten anscheinend mit mittleren (solaren) Antriebsdaten. Andererseits schreiben Sie, das die geringe Sonnenaktivität ca. ein Drittel der Verlangsamung der Erderwärmung der letzten Jahre erklären würde.Wieso werden nicht die tatsächlichen und prognostizierten Strahlungswerte der Sonne (z.B. TSI) hinzu gezogen, wenn doch anscheinend der Einfluss der Sonne- wie Sie selber schreiben – gar nicht so gering ist?

2. Der Klimawandel (Erwärmung) ist ihrer Ansicht nach gefährlich, weil er zu einer Anpassung und Veränderung des Menschen an gegebene Umstände führen muss. Was wäre, wenn es zu einer Abkühlung kommen würde? Wäre diese Anpassung des Menschens an die Natur dann einfacher? Wäre das besser für die Landwirtschaft und Nahrungsproduktion? Was würde mit heutigen Hafenstädten bei sinkendem Meeresspiegel passieren? Verstehen Sie mich nicht falsch, aber ich kann an der Erwärmung gar nicht so viel negatives finden! Die Gefahr durch zunehmende Stürme (bei einer weiteren Erwärmung) würde im Falle einer Abkühlung u.U. durch die Gefahr von Hungersnöten ersetzt. Das Ganze ist natürlich jetzt sehr einfach und “platt” beschrieben. Ich halte nur den Bezugspunkt “Jetzt gerade ist das Leben optimal hinsichtlich der Klimafaktoren und alles was wärmer ist, ist schlecht” für sehr willkürlich.

Vielen Dank

Th. Clauss

Zur ersten Frage: die Planung, Durchführung und Auswertung solcher Modellsimulationen dauert Jahre, die Veröffentlichung im IPCC-BEricht mit mehreren Begutachtungsphasen weitere Jahre, daher sind die Beobachtungsdaten wie TSI nur bis 2005 in diesen Modellrechnungen berücksichtigt.

Zur zweiten: eine globale Abkühlung um 3 Grad wäre vermutlich genauso schlimm oder schlimmer als eine Erwärmung um 3 Grad; Ökosysteme und menschliche Gesellschaft sind hochgradig an das Klima angepasst, das die letzten Jahrhunderte geherrscht hat.

Zur dritten: Es gibt ja bekanntlich nur drei Arten von Menschen: solche, die bis drei zählen können, und solche die es nicht können… (sorry dass ich mir diesen alten Scherz hier nicht verkneifen konnte).

Hallo Herr Rahmstorf,

vielen Dank für die schnelle Beantwortung. Sie haben völlig recht, wenn Sie die dritte Frage nicht gefunden haben – sie kommt allerdings jetzt:

Bedeuted die Beantwortung der ersten Frage, das Sie, bzw. die Klimaforschung sich nun mehr mit dem Einfluss von extraterrestrischen Energiequellen und deren Fluktuation beschäftigen und warum werden denn angesichts der Antwort von Frage 2, alle Anstrengungen nur hinsichtlich einer Begrenzung des Temperaturanstiegs gebündelt? Zum Verständnis: Ich habe Geowissenschaften studiert (u.a. an der UMASS) und habe deswegen nicht nur “den einen Blick” auf Zeiten mit steigenden Temperaturen. Die Amerikaner haben sich übrigens bereits damals – trotz Hockeyschlägerkurve – mit Themen wie Aerosole, kosmische Strahlung und Wolkenbildung als klimabeeinflussende Faktoren auseinander gesetzt.

Mit schönen Grüßen

Th. Clauss

Täuscht das, oder lese ich einiges an Suggestion (oder vielleicht Missverständnis) in ihrer Frage? Selbstverständlich befassen sich die Klimaforscher seit jeher mit allen Einflüssen auf die Energiebilanz der Erde. Meine eigene Forschungsarbeit als Paläoklimatologe etwa befasst sich seit zwei Jahrzehnten stark mit den Eiszeiten. Die von Ihnen genannten Themen sind alle ausführlich in den IPCC-Berichten diskutiert – lesen Sie doch zum Einstieg einfach mal dort nach, Sie finden den aktuellen Bericht online unter http://www.ipcc.ch.

Für alle:

Die ultimative “Primärquelle” für die existierenden und verwendeten ABSOLUTEN Globaltemperaturen von “14°C plus x” liegt auf Seite 1313 des “FullReport” der “Technical Summary” des IPCC5-Berichts.

http://www.climatechange2013.org/images/uploads/WGIAR5_WGI-12Doc2b_FinalDraft_All.pdf#page=1313

Die Normal-Null-Linie (schwarze Linie) liegt auch bei diesen beiden Grafiken bei 14,0°C (beobachtete (“observed”) Messwerte), wenn man sich in ein paar Minuten bei Sichtung der beiden Grafiken klarmacht, was die beiden Grafiken auf dieser Seite 1313 aussagen sollen und und wie der schmale Streifen am rechten Grafikrand mit den horizontalen farbigen Bandenlinien zu verstehen ist. Die jeweilige Bandenlinie gibt die Null-Linie – je nach Simulationsprogramm – an. Und für die beobachteten Messwerte (dicke, schwarze Linie) liegt die Normal-Null-Linie bei 14,0°C.

Also wo ist bei einer beachteten Globaltemperatur von 14,5°C die angeblich gefährliche globale Erwärmung, wenn der natürliche Treibhauseffekt bei 15°C festgelegt wird ??

Mit freundlichen Grüßen

Paul Bossert für die Unterstützer des

Klimamamifests von Heiligenroth

Ich fürchte, Sie haben es nicht verstanden – ich könnte mich aber hier nur wiederholen, dass es nicht auf den nur auf etwa 1 Grad genau bekannten Absolutwert der Temperatur ankommt, sondern dass das Problem deren Anstieg ist, der (wenn man die Energiebilanz unseres Planeten anschaut, also die Quelle der zusätzlichen Wärmeenergie) vom Anstieg der Treibhausgase durch unsere Emissionen verursacht wird. Einigen wir uns doch darauf, dass wir uns in diesem Punkt uneins bleiben werden, und beenden diese nur noch wenig erhellende Diskussion.

(Für diejenigen unserer Leser, die sich wundern, was das “Klimamanifest von Heiligenroth” eigentlich ist, sei noch auf diesen Artikel zu den Hintergründen verwiesen.)

Pingback:Kommt ein starker El Niño? › KlimaLounge › SciLogs - Wissenschaftsblogs

Pingback:Globale Temperatur 2013 › KlimaLounge › SciLogs - Wissenschaftsblogs

Pingback:Purzelnde Rekorde › KlimaLounge › SciLogs - Wissenschaftsblogs