Künstliche Intelligenz – ganz klein angefangen

BLOG: Heidelberg Laureate Forum

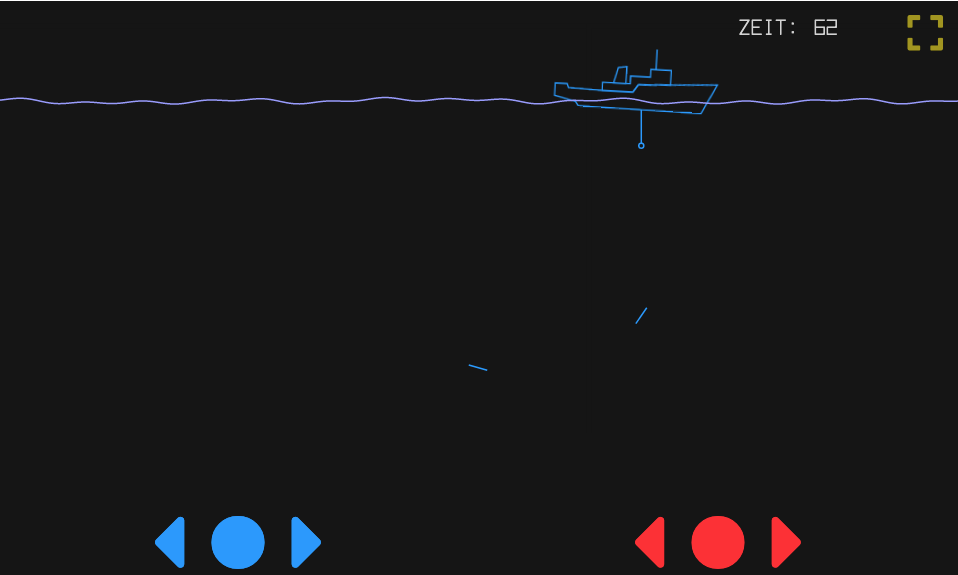

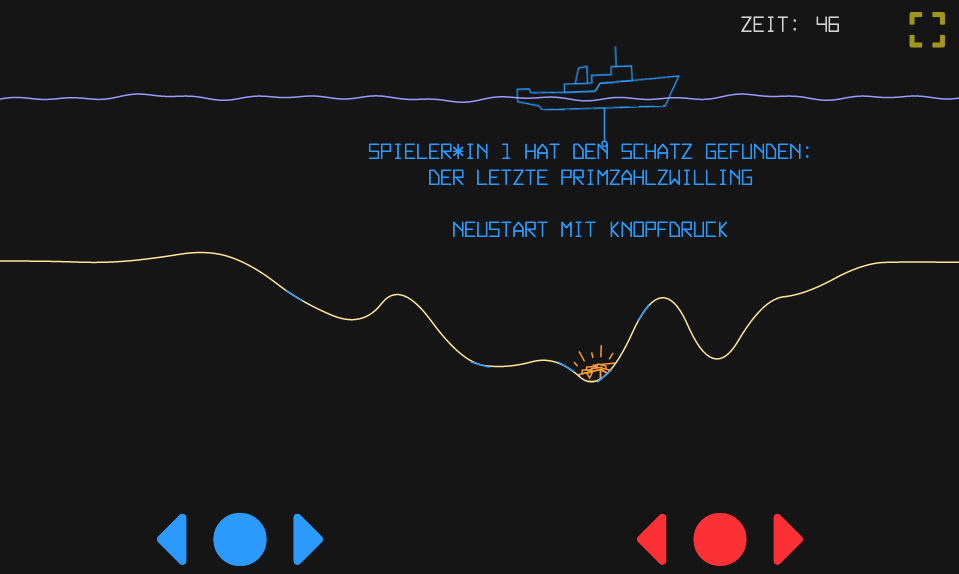

Am tiefsten Punkt des Meeresgrundes liegt ein Schatz, den es zu finden gilt – möglichst schnell, denn die Konkurrenz ist schon unterwegs. Mit meinem Schiff kann ich übers Meer fahren, an Punkten meiner Wahl ein Lot werfen und damit die Tiefe des Meeres an dieser Stelle bestimmen. Es ist unmöglich, so tief zu tauchen, dass man einen Überblick über die Gegend bekommt. Was ist ein gutes Verfahren, um an den Schatz zu kommen?

Das klingt nach einem klassischen Problem der numerischen Mathematik. Es gibt eine Funktion (die Höhe des Meeresgrundes in Abhängigkeit vom Ort auf der Oberfläche), deren Minimum ist gesucht, ich kann die Funktion zwar auswerten, das heißt an jeder Stelle ihren Wert bestimmen, aber das ist jedes Mal Aufwand, also möchte ich mir mit möglichst wenigen Auswertungen ein ausreichend klares Bild machen und vor allem mit möglichst wenig Aufwand das Minimum finden.

Für das Folgende denken wir uns die Meeresoberfläche und entsprechend den Meeresgrund eindimensional. Das vereinfacht das Nachdenken etwas, ohne dass allzu viel Wesentliches dabei verloren ginge.

Es ist auf jeden Fall eine gute Idee, ein Lot mit Tangentenfunktion zu verwenden. Das heißt, eine Funktionsauswertung misst nicht nur, wie tief der Boden liegt, sondern auch, wie steil er nach der einen oder der anderen Seite abfällt. Wenn zum Beispiel die beiden ersten Messungen so aussehen:

dann liegt es nahe zu vermuten, dass die tiefste Stelle zwischen den beiden liegt. Denn von links nach rechts geht’s bergab, und von rechts nach links ebenso, also muss dazwischen ein Minimum liegen. Und in diesem Fall stimmt es sogar:

Aber das muss nicht immer so sein. Vielleicht haben wir statt der absolut tiefsten Stelle nur eine kleine Mulde entdeckt; zwei solche lokalen Minima sind auch im Bild oben zu sehen. Wir müssen also einerseits ein einmal eingekreistes Minimum immer enger eingrenzen, bis wir den Schatz „mit bloßem Auge“ sehen können (was immer das in der abstrakten Situation heißen mag), andererseits uns im Rest des Meeres umschauen, ob es nicht irgendwo noch tiefer geht. Für Letzteres haben wir wenig Anhaltspunkte; wahrscheinlich ist per Zufall herumzustochern so gut wie jede andere Strategie, oder sogar besser. In dem Online-Spiel „Gradient Descent“ oder leibhaftig in der kürzlich eröffneten Ausstellung „I AM A. I.“, zu der das Spiel gehört, können Sie Ihre eigenen Fähigkeiten zur Schatzsuche erproben und vervollkommnen, mit oder ohne Gegenspieler.

So ziemlich alle Optimierungsprobleme – für die das genannte Online-Spiel nur ein radikal vereinfachtes Beispiel ist – haben dieses Dilemma, in jedem Moment zwischen zwei Strategien entscheiden zu müssen:

– Bin ich einem Minimum auf der Spur und versuche, ihm immer näher zu kommen? Dann werde ich meinen Suchpunkt ein bisschen in der Richtung verändern, in der ich das Minimum erwarte, hoffen, dass der Wert der Zielfunktion – in unserem Beispiel der Meeresboden – dadurch niedriger wird als zuvor, und wenn diese Hoffnung enttäuscht wird, diesen Schritt verwerfen und in eine andere Richtung weiterwandern. Diese Strategie heißt bei den Optimierern „gierig“ („greedy“): Nimm, was du kriegen kannst, und zwar sofort, und lass dich nicht auf eine vorübergehende Verschlechterung ein in der Hoffnung, hinter dem Hügel doch noch ein tieferes Tal zu finden.

– Oder fürchte ich, dass ich in einem lokalen Minimum feststecken könnte, und bin deswegen bereit, große Schritte zu machen und dabei auch Verschlechterungen in Kauf zu nehmen? Nennen wir diese Strategie, die die ganze Vielfalt der Möglichkeiten zu erkunden versucht, „explorativ“.

Allmählich werden Sie ein Gefühl dafür entwickeln, in welchem Verhältnis man die beiden Strategien einsetzt und wohin genau man in der konkreten Situation stochert: ein Lernprozess! Und das ist ein Beispiel für einen Lernprozess, den auch eine Maschine vollziehen kann. Typischerweise handelt es sich dabei um ein neuronales Netz; das ist ein Gerät, das dem Netz der Nerven in unserem Gehirn nachempfunden ist, allerdings in einer sehr groben Weise. Die klugen Gedanken, die wir uns machen, zum Beispiel „wenn es links abwärts geht und rechts davon aufwärts, dann muss dazwischen ein Minimum liegen“, sind in einem neuronalen Netz nicht einprogrammiert (wohl aber in dem „Bot“, dem Computerprogramm, das man sich in dem Online-Spiel als Gegenspieler dazuschalten kann). Das Netz lernt die entsprechenden Prinzipien, und zwar aus Erfahrung: indem es sehr viel mehr Situationen durchprobiert als unsereins. Darin ist es auch noch viel schneller als wir, weil es sich über jede einzelne Situation nicht entfernt so viele Gedanken macht. Am Ende erledigt das Netz die Schatzsuche um ein Vielfaches besser als jeder Mensch; aber auf unsere Ideen kommt es nicht, noch nicht einmal in irgendeinem übertragenen Sinn.

Das ist die große Schwäche der neuronalen Netze: Sie können sehr viele Aufgaben grandios bewältigen, aber niemals erklären, wie sie es eigentlich gemacht haben. In jedem übertragenen Sinn: Alles, was das Netz gelernt hat, steckt in einer – meistens sehr großen – Ansammlung von Zahlen, den „synaptischen Gewichten“. Die kann man problemlos aus dem Netz auslesen. Aber daraus etwas zu erschließen ist schwierig bis unmöglich. Wenn eine Bank ein solches Netz, an vergangenen Erfahrungen geschult, zur Einschätzung der Kreditwürdigkeit nutzt und ein Kunde fragt, warum sein Kreditantrag abgelehnt wurde, dann hat die Bank ein Problem.

Die Kunst, zwischen den beiden Strategien „gierig“ und „explorativ“ geschickt zu wechseln, mussten die Optimierer schon beherrschen, bevor die neuronalen Netze für derartige Aufgaben zur Verfügung standen. Und zwar auch bei richtig großen Problemen.

Der Klassiker unter ihnen ist das „Problem des Handlungsreisenden“, in der älteren Literatur zitiert als „travelling salesman problem“ (TSP), neuerdings gegendert als „travelling salesperson problem“. Der oder die Handlungsreisende muss, sagen wir, 20 vorgegebene Städte besuchen, darf aber deren Reihenfolge frei wählen und möchte den Weg mit der kürzesten Gesamtlänge finden. So viele Staubsaugervertreter*innen gibt es gar nicht mehr, dass deren Reiseplanung größere gedankliche Anstrengungen rechtfertigen würde; aber das TSP ist das, was man ein „benchmark problem“ nennt: Jeder, der ein neues Optimierungsverfahren erfunden hat, muss vorzeigen, wie gut es ein TSP löst, und dadurch wird es mit den Vorgängerverfahren vergleichbar. Und viele kombinatorische Optimierungsprobleme sind dem TSP so ähnlich, dass sich ein Lösungsverfahren für das benchmark problem leicht auf sie übertragen lässt: Tourenplanung für Lastwagen, Zuweisung von Aufgaben an verschiedene Maschinen, Fahrpläne für das U-Bahn-Netz, Stundenpläne für Schulen …

Kombinatorische Optimierungsprobleme unterscheiden sich von dem Schatzsuche-Spiel nicht nur in der schieren Größe, sondern auch noch in anderer Hinsicht. Man sucht den tiefsten Punkt in einem Raum mit sehr vielen Dimensionen. Und der Meeresgrund ist alles andere als glatt. Um genau zu sein, es gibt ihn gar nicht so richtig. Will sagen: Es gibt keine reellen Koordinaten, an denen man wackeln kann, um sich auf dem Meeresgrund zu bewegen. Beim TSP gibt es ohnehin nur endlich viele denkbare Lösungen – alle Reihenfolgen der abzuklappernden Städte –; da ist mit Begriffen wie Tangenten und Minimumssuche nach dem Schulverfahren sowieso nichts zu machen. Immerhin: Es gibt kleine Änderungen, die haben auch kleine Wirkungen, sozusagen eine zarte Andeutung von Stetigkeit. Wenn man die nicht hätte, bliebe einem sowieso nichts übrig, als blind in der Lösungsmenge herumzustochern.

Für den Wechsel zwischen gierigen und explorativen Strategien gibt es ein eingeführtes und sehr erfolgreiches Verfahren namens „simulated annealing“ („simuliertes Tempern“). Die Bezeichnung ist aus der Technik der Stahlherstellung entlehnt: Um das Material besonders hart und zäh zu machen, unterwirft man es mehreren Zyklen aus Erhitzung und Abkühlung. Erhitzen bringt die Atome zum Zappeln und weicht deren Bindungen etwas auf; Abkühlen gibt ihnen die Gelegenheit, neue und hoffentlich stabilere Bindungen zu knüpfen. Beim Optimieren ist Erhitzen die explorative Phase; der Prozess, der in dem abstrakten Raum der Möglichkeiten nach der optimalen Stelle sucht, bekommt sehr viel Bewegungsenergie und springt entsprechend wild in der Gegend herum. Beim Abkühlen kollert er allmählich an die tiefste Stelle, die aus seiner gegenwärtigen Position erreichbar ist.

Noch merkwürdiger ist der Sintflut-Algorithmus. Für sein Verständnis muss man bei der Zielfunktion das Vorzeichen umdrehen. Man sucht also nicht die tiefste Stelle im Meer, sondern den höchsten Berggipfel – was vom mathematischen Standpunkt aus ein völlig belangloser Wechsel der Perspektive ist. Am Anfang nimmt der Sintflut-Algorithmus jede Verschlechterung ohne Weiteres in Kauf. Der Prozess wandert also vollkommen ziellos durch die Landschaft. Aber dann wird diese Landschaft geflutet, und man darf überallhin gehen, nur nicht ins Wasser. Erstaunlicherweise landet man dabei in der Regel nicht auf irgendeinem mickrigen Hügel, sondern meistens auf einem Gipfel akzeptabler Höhe, nur knapp unter dem Mount Everest.

Oder der Bomben-Algorithmus, interessant für Probleme wie zum Beispiel die Aufteilung von Paketen mit verschiedenen Zielen auf verschiedene Lastwagen, wo es bereits ein erheblicher Aufwand ist, überhaupt eine „zulässige Lösung“ zu finden, also eine nicht unbedingt optimale, aber wenigstens praktikable Aufteilung. Kaum hat man eine solche zulässige Lösung gefunden, wirft man eine Bombe, das heißt man zerstört gezielt einen Teil der Lösung und baut sie dann wieder auf, nach einem gierigen Verfahren. Die Ergebnisse sind besser, als man von einem derart brutalen Vorgehen erwarten würde.

Alle diese Verfahren sind ausgiebig an echten Problemen erprobt worden. Erhebliche menschliche Intelligenz wurde aufgewandt, um die Details der Verfahren so zu gestalten, dass man in möglichst kurzer Zeit zu möglichst guten Lösungen kommt. Kann künstliche Intelligenz es der menschlichen an dieser Stelle gleichtun oder sie sogar übertreffen?

Das sieht zumindest im Moment eher durchwachsen aus. Vor etwa 20 Jahren blieben die Resultate noch in enttäuschender Weise hinter den hohen Erwartungen zurück. Die tiefen neuronalen Netze, die in jüngerer Zeit so spektakuläre Erfolge eingefahren haben, kamen erst danach. Aber auch sie haben in der kombinatorischen Optimierung nicht ohne Weiteres den Durchbruch gebracht. Das scheint erst neuerdings mit den grafischen neuronalen Netzen zu gelingen. Und auch die haben noch unter einem Standardproblem ihrer Art zu leiden: Sie brauchen sehr viele Trainingsdaten. Man muss also zunächst unter entsprechend hohem Aufwand eine große Zahl von Beispielproblemen gelöst haben und dem Netz als Trainingsmaterial vorlegen, damit dieses wenigstens ungefähr weiß, wo’s langgeht. Dann bringt es immerhin gute Lösungen zu Problemen vom selben Typ. Das ist für die Großspedition, die täglich ihre Lastwagenflotte aufs neue auf den Weg schicken muss, sogar attraktiv.

Auf das neuronale Netz, das vollkommen eigenständig neue Strategien entwickelt, wie das beim Go-Spiel gelungen ist, werden wir wohl noch ein Weilchen warten müssen.

Zitat: “ Das ist die große Schwäche der neuronalen Netze: Sie können sehr viele Aufgaben grandios bewältigen, aber niemals erklären, wie sie es eigentlich gemacht haben.“

Auch menschliche Experten können schneller urteilen, als dass sie ihr Urteil begründen können. Das bedeutet eben, dass auch menschliche Experten eine Art Bauchgefühl für Lösungen entwickeln ganz ähnlich wie neuronale Netze lernen zwischen präsentierten Datenpunkten auf richtige Art und Weise zu „interpolieren“ ohne einen tieferen Grund dafür angeben zu können.

Um den Lösungsweg zu erklären müssen sowohl Menschen als auch KI-Systeme oft auf andere Ressourcen zugreifen. Man kann ruhig sagen, dass die logische Schlussweise auch bei Menschen häufig nicht am Anfang steht, sondern eher der nachträglichen Rechtfertigung dient.

Letztlich kann man einem System aber wenig vertrauen, wenn es nicht sagen kann wie es zu seinen Lösungen kommt. Deshalb gibt es momentan Bestrebungen gibt, KI-Systemen mit einer Erklärungskomponente zu versehen.

Doch im Alltag geben auch wir Menschen uns oft mit einer Leistung zufrieden, selbst wenn wir nicht wissen wie sie zustande kommt. Beispielsweise erhält man den Fahrausweis, wenn man eine Testfahrt erfolgreich absolviert hat. Kein Experte fragt danach wie das der Prüfling gemacht hat, wenn er gut gefahren ist. Nur bei Fehlern wird nachgefragt.

Auf eine KI-Methode, die zu erklärbaren Schlüssen führt, möchte ich hier verweisen. Es ist die Methode Mixture of Experts bei der mehrere neuronale Netze eingesetzt werden, je eines für eine Teilaufgabe. Die Teillösungen, die die Einzelexperten liefern, werden dann durch erlernte Gewichtung zur Gesamtlösung zusammengefügt und das System kann dann angeben was der Beitrag der einzelnen neuronalen Netzwerke bei der Gesamtlösung war.

Ein gutes Beispiel dafür ist ExoMiner: A Highly Accurate and Explainable Deep Learning Classifier that Validates 301 New Exoplanets ExoMiner arbeitet hier recht ähnlich wie menschliche Experten für die Erkennung eines Exoplaneten: es ahmt nach, wie Domänenexperten diagnostische Tests beurteilen, um ein Transitsignal zu überprüfen. In der Conclusion des Artikels liest man dazu:

Ein weiteres Beispiel für eine Mixture of Experts findet man im Artikel Using Mixture of Expert Models to Gain Insights into Semantic Segmentation

Dort liest man in der Kurzzusammenfassung:

Kurzum: Experten müssen lernen, ihre Urteile/Entscheidungen zu erklären, denn es ist etwas anderes richtig zu urteilen und angeben zu können, warum man so urteilt.

Das gilt für menschliche und für maschinelle Experten gleichermassen.

Dies liegt daran, dass Erklärung Vertrauen erzeugen kann, nicht schlichte Behauptung, wie sie von AI beigebracht werden könnte, die dann sozusagen alles durchgerechnet haben könnte, aber nicht so haben muss.

Insofern kann es hier Skepsis geben, dennoch bleibt es im Denkbaren möglich, dass AI bspw. mathematische Beweise führt, die trotz eingesetzter sog. Monte Carlo Methoden korrekt sind.

Sich sozusagen doch i.p. mathematischer Beweisführung entscheidend zusammengerechnet hat.

(Wobei dann keine ‘Erklärungskomponente’ vorliegt bzw. so nur in einer langen Abfolge von Argumentation bereit gestellt werden kann, die kein Mensch (wie auch Bär) versteht.)

Christoph Pöppe schrieb (16. Feb 2022):

> Künstliche Intelligenz – ganz klein angefangen

> Am tiefsten Punkt des Meeresgrundes liegt ein Schatz, den es zu finden gilt – […]

Ein Schatz — mit der (ganz kleinen) Dicke Null (?!) …

Zitat aus obigem Artikel:

Ein neuronales Netz kann nicht nur das Minimum einer Funktion finden, nein sie kann die gesamte Funktion approximieren aufgrund der Datenpunkte, die ihr beim Training gegeben werden. Typischerweise gehören die Datenpunkte zu einem hochdimensionalen Problem (bei viele Klassifikationsaufgaben).

Approximieren der Funktion bedeutet, dass das neuronale Netz nach dem Training für Datenpunkte, die es noch nie gesehen hat, einen „vernünftigen“ Funktionswert liefert. Das genau ist das, was das neuronale Netz durch das Training gelernt hat: Neue Dinge, neue Daten am richtigen Ort in den gelernten Daten lokalisieren und den Funktionswert dazu ausgeben. Es hat sich nun herausgestellt, dass neuronale Netze geradezu beängstigend gute Funktionsapproximatoren sind. Inzwischen können sie die Lösungen von ganzen Klassen von Differentialgleichungen approximieren und das weit schneller und besser als die besten bekannten numerischen Verfahren.

Um ein Beispiel zum eben gesagten zu geben, nehme ich Bezug auf das Papier ON THE APPROXIMATION OF ROUGH FUNCTIONS WITH DEEP NEURAL NETWORKS

Die Kurzzusammenfassung dieser Arbeit lautet:

Das erstaunliche hier ist, dass DNNs (deep neural nets) sogar diskontinuierliche Funktionen und Funktionen, die Schockwellen modellieren approximieren können, also etwas vom schwierigsten überhaupt. Im Papier findet sich das folgende Beispiel:

Im Papier wird dann sogar bewiesen, dass DNNs, wenn richtig konfiguriert folgendes tun können:

Martin Holzherr schrieb (16.02.2022, 21:46 o’clock):

> […] Ein neuronales Netz kann nicht nur das Minimum einer Funktion finden, nein sie kann die gesamte Funktion approximieren aufgrund der Datenpunkte, die ihr beim Training gegeben werden. […]

> Es hat sich nun herausgestellt, dass neuronale Netze geradezu beängstigend gute Funktionsapproximatoren sind. […]

> Um ein Beispiel zum eben gesagten zu geben, nehme ich Bezug auf das Papier ON APPROXIMATION OF ROUGH FUNCTIONS WITH DEEP NEURAL NETWORKS [ T. DeRyck et al., https://www.sam.math.ethz.ch/sam_reports/reports_final/reports2020/2020-07_fp.pdf ]

Die dort vorgestellte Auffassung von »rough functions« lautet

> […] Im Papier findet sich das folgende Beispiel:

Womit sich herausstellt, dass die von T. DeRyck et al. vorgestellte Auffassung von »rough functions« geradezu beängstigend weit über das behandelte »first example« hinausgeht. Als ein anderes Beispiel einer »rough function« käme jedenfalls auch dieses in Betracht …

(das, lesbar formatiert als

“Plot[ (1/(x (1/2 -x)^2) – IntegerPart[ 1/(x (1/2 -x)^2) ] – 1/4) Sgn[ 1/(x (1/2 -x)^2) – IntegerPart[ 1/(x (1/2 -x)^2) ] – 1/2 ] + Sin[ 1/(Sin[ 1/x ] Sin[ 1/(1/2 – x) ]) ] + 5/4, { x, 0, 1 } ]”,

immerhin noch in die knapp 200 Eingabefelder von “Wolfram Alpha” hineinpasst; und insbesondere zur Veranschaulichung der Aufgabenstellung “Finde das Minimum!” dargestellt ist).

Steuerung eines Tokamaks durch ein neuronales Netzwerk

Das superheisse Plasma in einem Tokamak wird von Magnetfeldern in der Schwebe gehalten und zwar so, dass es die Wand nie berührt – oder besser gesagt nie berühren sollte. Doch es entstehen immer wieder starke Turbulenzen in solchen Plasmen und diese unter Kontrolle zu halten ist äusserst schwierig. Mindestens schwierig für Menschen, nicht unbedingt schwierig für ein künstliches neuronales Netzwerk, dass darauf trainiert wurde im Bruchteil von Sekunden auf Veränderungen im Plasma zu reagieren in dem es die Magnetfeldstärke verändert. Solch ein künstliches neuronales Netzwerk hat die Funktion erlernt, die hinter dem Zusammenhang zwischen Magnetfeld und Verhalten des Plasmas steckt. Der MIT-Review Artikel DeepMind’s AI can control superheated plasma inside a fusion reactor berichtet darüber. Dort liest man:

Fazit: Ein neuronales Netzwerk, das eine Funktion erlernt hat, kann diese Funktion in sehr kurzer Zeit für neue Eingangswerte auswerten – und das selbst dann, wenn die Funktion hochkomplex ist und sich anderen Verfahren nicht erschliesst.

Ergänzung: Der Nature Artikel Magnetic control of tokamak plasmas through deep reinforcement learning ist die Arbeit auf dem der im vorgängigen Kommentar zitierte MIT-Review-Artikel basiert.

Hier noch der letzte Teil der im Kapitel Discussion wiedergegeben Überlegungen:

Fazit: die magnetische Kontrolle von Tokamak Plasmas über ein auf Reinforcement Learning basierendes tiefes neuronales Netzwerk erlaubt eine bisher nicht mögliche flexible Kontrolle des Plasmas und könnte sogar dazu dienen, neue Tokamak-Designs zu entwickeln.

Das Video The Universal Approximation Theorem for neural networks ist für alle empfehlenswert, die wissen wollen, wie man ein einfaches neuronales Netz von Hand aufbaut (ohne Bibliothek) und wie man von Hand damit Funktionen approximieren kann.

Zudem ist das Video sehr kurz. Also empfehlenswert.

Wer bspw. hier mal schaut :

-> https://de.wikipedia.org/wiki/AlphaGo (‘ Zunächst lernt das Programm durch Analyse einer Datenbank von 30 Millionen Zügen, den Zug eines Menschen „vorherzusagen“. ‘ [1])

… könnte auf die Idee kommen, dass bei Anwendungen der sog. AI das menschengemachte Design entscheidend ist.

Gelegentlich wird auch, wenn die “AI” sozusagen gänzlich irrig wird, menschlich und korrigierend [2] eingegriffen, der Mensch sitzt auf der “AI” insofern wie eine Art Jockey, symbiotisch sozusagen.

Ginge diese Einschätzung für den werten hiesigen werten Inhaltegeber?

Luschdiek :

Denn an sich könnte sich hier schon eine deskriptive Funktionalität anschließen, die in Anbetracht der sinnhaften (!) Nutzung sog. Monte Carlo Methoden dann letztlich doch sinnlos erscheint.

Mit freundlichen Grüßen

Dr. Webbaer

[1]

versus :

‘Auf das neuronale Netz, das vollkommen eigenständig neue Strategien entwickelt, wie das beim Go-Spiel gelungen ist, werden wir wohl noch ein Weilchen warten müssen.’

[2]

Dr. Webbaer glaubt nicht passende Studien so falsch verstanden zu haben.

PS und Globalverweis, sozusagen :

-> http://www.google.de/search?q=ai+human+interference

Zitat: “ Das ist die große Schwäche der neuronalen Netze: Sie können sehr viele Aufgaben grandios bewältigen, aber niemals erklären, wie sie es eigentlich gemacht haben.“

Kürzlich geisterte diese Meldung durch die Medien: AI Can Guess Your Race Based On X-Rays, and Researchers Don’t Know How

Dort liest man:

Analoge Erscheinungen könnte es aber auch bei Menschen geben. So ist es denkbar, dass eine „Handleserin“ erstaunlich zutreffende Aussagen über einen „Kunden“ macht und dann dies sogar mit dem Verlauf von verschiedenen Handlinien (Lebenslinie, Liebeslinie, Kopflinie) begründet, wobei eine genauere Betrachtung dann zeigt, dass die Begründungen an den Haaren herbeigezogen sind, die Aussagen über den betreffenden Menschen aber doch einiges an sich haben. Es zeigt sich ja immer wieder, dass Menschen Begründungen für ihre Urteile oder auch ihr Verhalten abgeben, die in sich widersprüchlich, jedenfalls nicht überzeugend sind. Dennoch können sie recht haben. Alles was ihnen fehlt, ist die Gabe ihr Urteil oder Verhalten wasserdicht zu begründen.

Ich denke dennoch, dass die Fähigkeit zu kausalem und schlussfolgerndem Denken zentral ist für den Menschen. Doch diese Fähigkeit ist in der Evolution relativ spät entstanden und sie ist wohl etwas neues und sie, diese Fähigkeit zu rationalem Debken, ist noch nicht auf jeder Ebene im Einklang mit dem „tierischen Erbe“, dem instinktiv „richtigen“ Verhalten.

Systeme der AI können idT die Prädiktion erlauben, die weltliche, sie sind potentiell dann deutlich besser als die “Wahrsagerin”.

Weltlich ist aber auch hervorragenden Naturwissenschaftlern nicht möglich den Weltverlauf, sofern eine gewisse (eben : weltliche) Komplexität vorliegt, die hier trotz all der guten naturwissenschaftlichen Theoretisierung prohibitiv wirkt, was vglw. schnell geschehen kann, zuverlässig vorherzusagen und gar “wasserdicht” seine Prädiktion zu begründen.

Insofern behelfen sich bspw. die Klimawissenschaftler, die mit dem “CO2-zentrierten Erwärmungstrend” sind gemeint, mit Szenarien und i.p. terrestrischer zukünftiger Temperaturentwicklung, die Oberflächentemperaturen sind gemeint, mit Konfidenzintervallen, wobei gerne die 95 % – Konfidenzintervalle herangezogen werden.

Not bad (“nicht schlecht”), auch AI (dann vielleicht besser i.p. Prädiktion) wird am Naturproblem sozusagen nicht vorbeikommen, Dr. Webbaer will derartige Vorgehensweise nicht diskontieren, sondern nur loben, auch weil alternativlos.

>:->

Mit freundlichen Grüßen

Dr. Webbaer

Christoph Pöppe schrieb (16. Feb 2022):

> Am tiefsten Punkt des Meeresgrundes liegt ein Schatz, den es zu finden gilt – […]

> Mit meinem Schiff kann ich übers Meer fahren, an Punkten meiner Wahl ein Lot werfen und damit die Tiefe des Meeres an dieser Stelle bestimmen. […]

> Für das Folgende denken wir uns die Meeresoberfläche und entsprechend den Meeresgrund eindimensional. Das vereinfacht das Nachdenken etwas, ohne dass allzu viel Wesentliches dabei verloren ginge.

Etwas Wesentliches, das bei der Vorstellung von Schiffs-Domäne bzw. Meeresgrund-Zielbereich als (disjungierte) Mengen mit jeweils eindimensionaler (und sogar: einfacher) Geometrie, d.h. als sogenannte “einfache Kurven”, in einer (der Einfachheit halber) zweidimensionalen “Welt”, dennoch nicht verloren ginge, ist,

dass es Punkte und ganze Abschnitte des Meeresgrundes geben kann (zu denen insbesondere auch “der tiefste Punkt des Meeresgrundes” gehören könnte), die vom Schiff aus gar nicht durch ein “Lot” erreicht werden könnten.

Weil der Meeresgrund abschnittsweise “überhängt”.

(Was wiederum — als ein Spezialfall — vorliegen könnte, “weil” der Meeresgrund (auf seiner nassen, zur Meeresoberfläche hin in Prinzip verbindbaren Seite) konvex wäre.

(Wodurch der Meeresboden auf der nassen, aber vom Schiff per Lot nicht direkt erreichbaren Seite des Überhanges auch zwangsläufig tiefer als der Überhang läge.

(Was durchaus ein Indiz dafür wäre, dass, falls sich ausgerechnet am tiefsten Punkt des Meeresgrundes mal ein Schatz befunden haben sollte, er tatsächlich noch dort sein könnte.

)))

Ein “Scan” von geloteten Tiefenwerte würde dann auch nur eine Diskontinuität aufweisen (von der “Oberseite des Überhanges” zum “zugänglichen Meeresgrund”); aber “den tiefste Punkt des Meeresgrundes” womöglich gar nicht erreichen. Geschweige denn den vermeintlichen Schatz.

Frank Wappler schrieb (25.02.2022, 11:59 o’clock):

> […] Weil der Meeresgrund abschnittsweise “überhängt”.

> (Was wiederum — als ein Spezialfall — vorliegen könnte, “weil” der Meeresgrund (auf seiner nassen, zur Meeresoberfläche hin in Prinzip verbindbaren Seite)

… nicht …

> konvex wäre […]

… sondern konkav.

> Ein “Scan” von geloteten Tiefenwerte würde dann auch nur eine Diskontinuität aufweisen (von der “Oberseite des Überhanges” zum “zugänglichen Meeresgrund”

… der allerdings auch “nur” die Oberseite eines weiteren tieferliegende Überhanges sein könnte.

> aber “den tiefsten Punkt des Meeresgrundes” womöglich gar nicht erreichen. Geschweige denn den vermeintlichen Schatz.

Es ist aber aus dem Kontext schon klar, dass es nicht um einen echten Schatz im echten Meer geht, oder? Der metaphorische Schatz, von dem in meinem Beitrag die Rede ist (und der stellvertretend für das Minimum einer Funktion steht; in welchem Raum die Funktion lebt, wäre noch zu klären), hat einige Eigenschaften, die echten Schätzen abgehen:

Er ist nicht nur unendlich dünn, sondern auch punktförmig, was die Suche nach ihm eher schwieriger macht. Damit er überhaupt auffindbar ist, muss seine unmittelbare Umgebung wenigstens ein bisschen Auskunft über seine Position geben. Wenn man sich erst in dieser Umgebung befindet, kommt man dem Schatz mit einem geeigneten Iterationsverfahren beliebig nahe. Das reicht, for all practical purposes. Wir müssen uns also über Größe und Beschaffenheit des Schatzes keine weiteren Gedanken machen.

Auf unserem metaphorischen Meeresboden gibt es auch keine Überhänge! Sonst wäre das, dessen Minimum wir suchen, keine Funktion.

Echte Schätze im echten Meer zu suchen ist ein völlig anderes Problem. Dafür wäre auch die Methode mit dem Lot eher ungeeignet. Was ist, wenn die Meeresströmung eine Schicht Sand über den Schatz gelegt hat, so dass man ihn gar nicht mehr sehen kann? Und damit sind wir endgültig ab vom Thema.

Christoph Pöppe schrieb (25.02.2022, 14:56 o’clock):

> […] Auf unserem metaphorischen Meeresboden gibt es auch keine Überhänge!

Es freut mich, Gelegenheit für diese Klarstellung gegeben zu haben.

> Sonst wäre das, dessen Minimum wir suchen, keine Funktion.

Sofern das, dessen Minimum wir suchen, eine bestimmte Abbildung (gerichtete Beziehung) von Stellen des Meeresgrundes (sagen wir mal “Menge 𝒢”) auf Tiefen-Werten (“Menge 𝒯”) sein sollte,

handelt es sich eben doch jedenfalls um eine Funktion : 𝒢 → 𝒯 (die jedem Element der Domäne genau ein Element des Wertebereiches zuordnet); und zwar auch dann, falls die Geometrie des Meeresgrundes Überhänge aufweist.

Auch die im obigen SciLogs-Beitrag angedeuteten Abbildungen von Stellen der Meeresoberfläche (“Menge 𝒪”) auf Lotpunkte am Meeresgrund (“Menge ℒ”) bzw. auf Tiefen-Werte dieser Lotpunkte, sind jedenfalls ausdrücklich Funktionen. (In anderen. metaphorischen Worten:

So’n büschn Gischt müssen Kahn und Lot schon mal abkönn’.)

Nur die gerichtete Beziehung von Lotpunkten ℒ auf den Meeresgrund 𝒢 insgesamt wäre gerade dann keine Funktion, falls der Meeresgrund Überhänge aufwiese.

(Was er aber nicht soll.)

(Trotzdem wäre mal interessant, von einem Mathematiker zu erfahren, wie man auch solche gerichteten Beziehungen zwischen Mengen ℒ und 𝒢 in Notation fasst.

Zu blöd nur, dass es für immer noch kein “Frag-doch-mal-den-SciLog”-SciLog bereitgestellt ist!)

> Der metaphorische Schatz, von dem in meinem Beitrag die Rede ist […] ist nicht nur unendlich dünn,

… ach — gucke! …

> sondern auch punktförmig

Aus dem obigen SciLogs-Beitrag an sich geht das offenbar nicht hervor.

Also, bitteschön: Noch eine Klarstellung!

> Damit er überhaupt auffindbar ist, muss seine unmittelbare Umgebung wenigstens ein bisschen Auskunft über seine Position geben.

Das erfüllt eine “unmittelbare Umgebung” allein schon dadurch, dass sie als “unmittelbar” qualifiziert ist, anstatt als “irgendeine Umgebung”.

Und zwar ohne irgendwelche weiteren Anforderungen an die Geometrie und insbesondere womöglich an Knickfreiheit des Meeresgrundes 𝒢.

Im Übrigen suchen wir ja außerdem gar nicht unbedingt “DAS Minimum” einer Funktion, sondern, wie durch die groben Funktionen (Martin Holzherr, 16.02.2022, 21:46 o’clock) veranschaulicht, “ihr Infimum”, oder gar nur “eines ihrer Infima”.

(Womit das Thema “Lot mit Tangente” wohl einigermaßen erschöpfend behandelt wäre.)

> Wenn man sich erst in dieser Umgebung befindet, kommt man dem Schatz mit einem geeigneten Iterationsverfahren beliebig nahe.

Ein Verfahren, das geeignet ist, mit genug Ausdauer auf einem beschränkten Meeresgrund jeweils einem/jedem bestimmten Punkt mal beliebig nahe gekommen zu sein,

ist allerdings nicht unbedingt geeignet abzuschätzen, wie nahe man an jeweils einem bestimmten Punkt wäre, wenn man aufhört, das Verfahren anzuwenden.

Die Eignung eines/jedes der genannten “Iterationsverfahren”, zusammen mit bestimmten vermutlichen Eigenschaften der gegebenen Funktion und einer “unmittelbare Umgebung” eines ihrer Infima, läge wohl genauer darin, dass man “Schritt für Schritt” eine immer noch kleinere “unmittelbare Umgebung” finden und “dem Schatz näherkommen” würde.

> Das reicht, for all practical purposes. […]

Daran erkennt man den Anwender (von Mathematik)!

(Lies: “Der Schatz behält eine Ausdehnung!”.

(Sprich: “Die Ente bleibt draußen!” ;))

p.s.

> Echte Schätze im echten Meer zu suchen ist ein völlig anderes Problem.

Das Thema “schweres bzw. überschweres Wasser” möchte ich nur damit kommentieren, was der Herr Jaeger schon seit drei Wochen offenbar nicht wahr haben will:

Frank Wappler schrieb (25.02.2022, 18:37 o’clock):

> Nur die gerichtete Beziehung von Lotpunkten ℒ auf den Meeresgrund 𝒢 insgesamt wäre gerade dann keine Funktion, falls der Meeresgrund Überhänge aufwiese.

Stimmt doch gar nicht! —

sogar diese Beziehung ist jedenfalls eine Funktion : ℒ → 𝒢.

Aber:

im hypothetischen Falle von Überhängen kann von der Meeresoberfläche 𝒪 aus über (deren entsprechende) Lotpunkte ℒ und Tiefenwerte

nicht für alle Stellen des Meeresgrundes 𝒢 jeweils ein bestimmter Tiefenwert ermittelt bzw. ausgedrückt werden.

In anderen Worten: Die Funktion 𝒢 → 𝒯, deren Minimum o.Ä. von Interesse wäre, könnte dann nicht vom Schiff herkommen.

p.s. — Zur Notation: SciLogs-Kommentar-LaTeX-Test:

“\( \LaTeX \)” wird dargestellt als: “\( \LaTeX \)”.

Welch eine Konfusion!

Man muss vielleicht den Unterschied zwischen reiner und angewandter Mathematik klarmachen. Eigentlich gibt’s den Unterschied ja nicht, beide sind Mathematik. Aber sie stellen an ein und denselben Gegenstand eben doch verschiedene Fragen und kriegen entsprechend verschiedene Antworten.

In unserem Beispiel fragt die angewandte Mathematikerin, wie sie an den Schatz auf dem Meeresgrund kommt. Dazu stellt sie ein mathematisches Modell des Gesamtsystems auf, und zwar so, dass 1) sie es mit mathematischen Mitteln bearbeiten kann und 2) es das Wesentliche der Realität wiedergibt. Beide Forderungen zu erfüllen erfordert regelmäßig Kompromisse.

Das Modell, von dem ich gesprochen habe, unterstellt, der Schatz sei punktförmig und liege auf einem stetig differenzierbaren Meeresgrund. Das stimmt natürlich nicht; aber für manche Schätze mag es der Realität so nahe kommen, dass man etwas damit anfangen kann. Für einen Goldklumpen, der sich im Korallenriff verfangen hat, ist es offensichtlich ungeeignet.

Für den punktförmigen Schatz auf dem stetig differenzierbaren Meeresgrund kann man klassische Analysis betreiben, insbesondere mit Aussicht auf Erfolg über die Funktion nachdenken, die zu jedem gegebenen Punkt der Meeresoberfläche die Tiefe angibt, in der das Lot auf dem Meeresboden aufschlägt. (Zu diesem Zweck hat man ja diese unrealistische Annahme gemacht.) Das ist auch wirklich, in hinreichend guter Approximation, eine Funktion!

Was für ein mathematisches Konstrukt könnte Meeresboden mit Überhang beschreiben? Eine gewöhnliche Funktion offensichtlich nicht, die muss ja an jedem Punkt einen eindeutigen Wert haben. Die Werkzeugkiste der Mathematik hat auch für solche Fälle etwas vorrätig (Stichwort: der Meeresboden als zweidimensionale Mannigfaltigkeit, von mir aus mit Parametrisierung); aber die Werkzeuge sind kompliziert, und es stellt sich zuallererst die Frage, wozu man sie verwenden will. Zum Schatzsuchen? Theoretisch denkbar, praktisch eher abwegig.

Zur Modellierung der Hysterese (ein Magnet leistet dem Versuch, ihn umzupolen, hinhaltenden Widerstand, bis er dann doch umkippt; interessant für alle Datenspeichermedien, die mit Magnetismus arbeiten) arbeiten die Leute tatsächlich mit “Funktionen”, die eben keine Funktionen sind, sondern Kurven mit Überhang. Aber dafür muss man noch eine ganze Menge mehr Besteck aus der Kiste holen.

Frank Wappler schrieb (25.02.2022, 11:59 o’clock):

> […] p.s. […]

Ich stelle fest, dass dieses p.s. nach Veröffentlichung Kommentar-los entfernt wurde.

Christoph Pöppe schrieb (27.02.2022, 12:27 o’clock):

> Welch eine Konfusion!

Welch ein Elend, dass auch für diesen SciLog immer noch nicht dokumentiert ist, wie viele Links, insbesondere zu SciLogs-Artikeln, SciLogs-Kommentaren, oder zu Artikeln der (diversen Fragmente von) Wikipedia in einem Kommentar maximal zulässig sind!

> […] Was für ein mathematisches Konstrukt könnte Meeresboden mit Überhang beschreiben?

Na, wie schon ziemlich weit oben (im Kommentar 25.02.2022, 11:59 o’clock) beschrieben:

und zwar in Übereinstimmung und Konkretisierung der Vorgabe aus dem obigen SciLog-Beitrag:

Dabei sind wir uns ja hoffentlich auch darüber einig, dass eine Kurve eindimensional gedacht sein soll; dass “einfache Kurven” sich nicht selbst schneiden oder berühren sollen; und dass eine “Kurve als eigenständiges Object” bzw. als “Bild eines Weges, in der welt” aufgefasst sein soll.

Beispielhaft an Bildelementen in der ersten und in der zweiten Zeile von diesem Bild.

(Ein noch unmissverständlicheres und dabei sachdienliches verlinkbares Bild ist mir leider bislang nicht untergekommen; und leider besteht ja für SciLogs-Kommentatoren offenbar immer noch nicht die Möglichkeit, psfig-Befehle zu nutzen, um selbst angefertigte Zeichnungen einzureichen.)

Die durchgängige Kurve in der zweiten Zeile soll dabei auch verdeutlichen, dass Kurven mit mindestens einer konvexen Seite und insbesondere “Kurven mit Überhang” Knick-frei sein können.

In meinem vorausgehenden Kommentar (25.02.2022, 18:37 o’clock) habe ich die (Welt-)Punktmenge, aus denen der Meeresgrund als einfache, womögliche überhängende Kurve besteht, als 𝒢 bezeichnet.

> Das Modell, von dem ich gesprochen habe, unterstellt, der Schatz […] liege auf einem stetig differenzierbaren Meeresgrund.

Die Worte “differenzierbar” oder “Differenzierbarkeit” sind weder im obigen SciLog enthalten, noch in verausgehenden Kommentaren aufgetaucht! Also halte ich mir hiermit ein weiteres Mal zu gute, Gelegenheit auch für diese Klarstellung gegeben zu haben.

> […W]ozu [?]

Um Klarstellbares nicht unklar stehen zu lassen. Wozu wären SciLog-Kommentare denn sonst da?

> Zur Modellierung der Hysterese […] Kurven mit Überhang

Jedenfalls findet man zum Thema [[Hysterese]] Zeichnungen insbesondere mit geschlossenen Kurven, was an (gewisse Abschnitte von) Kurven mit Überhang erinnern mag.

> die eben keine Funktionen sind

Die Hysteresekurven entsprechen “erreichbaren” Paaren von Werten zweier Größen; hinsichtlich der “Hysterese von Magneten” ([[Ferromagnetismus#Hysterese]]) insbesondere bestimmte Werte-Paare von “Feldstärke H” und “mag. Flussdichte B”.

Es ist richtig, dass es keine “Funktion : { B } → { H }” gibt, die durch die Hysteresekurve (insgesamt) dargestellt wäre;

wobei als [[Definitionsmenge]] (alias [[Domäne]] die Menge { B } vorausgesetzt ist, d.h. der Wertebereich aller (relevanten) B-Werte.

Aber: im oben (25.02.2022, 18:37 o’clock) diskutierten Beispiel ist die Kurvenmenge 𝒢 selbst, an sich der Definitionsbereich einer Funktion : 𝒢 → 𝒯.

Außerdem wiederhole ich hiermit meine Bitte, eine (die) mathematische Notation für Beziehungen bereitzustellen, die ausdrücklich keine Funktionen sind (also z.B. die Beziehung zwischen den Mengen { B } und { H }, die durch die Hysteresekurve (insgesamt) dargestellt ist);

und, im Übrigen, meine Bitte um Bereitstellung eines “Frag-doch-mal-den-SciLog”-SciLogs.

Frank Wappler schrieb (28.02.2022, 11:50 o’clock):

> Christoph Pöppe schrieb (27.02.2022, 12:27 o’clock):

> > […] Das Modell, von dem ich gesprochen habe, unterstellt, der Schatz […] liege auf einem stetig differenzierbaren Meeresgrund.

An dieser Stelle wäre genaugenommen zu fragen, von genau welchen Differenzenquotienten hinsichtlich welcher Größe “im Nenner” dabei ein Grenzwert ermittelt werden soll.

(Dass die Funktionswerte, deren Differenzen jeweils “den Zähler” bilden, aus der Menge 𝒯 von “Tiefenwerten” stammen sollen, versteht sich bestimmt.)

> > Zur Modellierung der Hysterese […]

> Die Hysteresekurven entsprechen “erreichbaren” Paaren von Werten zweier Größen; hinsichtlich der “Hysterese von Magneten” ([[Ferromagnetismus#Hysterese]]) insbesondere bestimmte Werte-Paare von “Feldstärke H” und “mag. Flussdichte B”.

> Es ist richtig, dass es keine “Funktion : { B } → { H }” gibt, die durch die Hysteresekurve (insgesamt) dargestellt wäre;

> wobei als [[Definitionsmenge]] (alias [[Domäne]]) die Menge { B } vorausgesetzt ist, d.h. der Wertebereich aller (relevanten) B-Werte.

Ebenso richtig, und in Betrachtung der verlinkten Darstellungen von Hysteresekurven noch naheliegender, ist, dass es auch keine

“Funktion : { H } → { B }” gibt, die durch die Hysteresekurve (insgesamt) dargestellt wäre;

wobei als [[Definitionsmenge]] (alias [[Domäne]]) die Menge { H } vorausgesetzt ist, d.h. der Wertebereich aller (relevanten) H-Werte.

> Aber: […]

Ich fürchte, ich habe zwei schlechte Nachrichten für Sie.

1) Das mit dem Klarstellen ist eine nette Idee, aber es ufert in diesem Post bereits wieder aus (und in anderen auch). Natürlich kann man sich über die Details der stetigen Differenzierbarkeit unterhalten; dabei tauchen allerdings wieder andere klarstellungsbedürftige Dinge auf, und am Ende landen wir bei einem Lehrbuch über – zum Beispiel – klassische Analysis. Denn mit der Mathematik ist das so wie mit dem berüchtigten Witz vom Spucknapf: Es ist alles an einem Stück. Man könnte ewig weiter fragen. Da mitzuspielen halte ich weder für machbar noch für sinnvoll. Ein Post muss sich (naturgemäß) auf ein Thema beschränken, und ich sehe zu, dass ich beim Beantworten einigermaßen beim Thema bleibe. Wie man eine Hystereseschleife am besten beschreibt, gehört definitiv nicht mehr dazu.

2) Ihr Wunsch nach einem Briefkastenonkel für Mathematik oder gar für Wissenschaft allgemein (“Frag-den-SciLogs-SciLog”) ist nachvollziehbar, aber ich halte ihn für unerfüllbar. Ich persönlich kann das nicht leisten, und ich fürchte, die SciLogs werden das auch nicht einrichten. Immerhin, es gibt so etwas Ähnliches: eine Newsgroup namens de.sci.Mathematik. Jedermensch kann eine Frage hineinschreiben, und jeder, der sich angesprochen fühlt, wird antworten. Ob und mit welcher Qualität eine Antwort kommt, ist natürlich ein Glücksspiel …

Christoph Pöppe schrieb (06.03.2022, 17:16 o’clock):

> Ich fürchte, ich habe zwei schlechte Nachrichten für Sie.

Ich fürchte, das sind schlechte Nachrichten für SciLogs-Kommentatoren insgesamt. Danke immerhin für die Rückmeldung.

> 1) […] Man könnte ewig weiter fragen. Da mitzuspielen halte ich weder für machbar noch für sinnvoll. […]

Es kann allerdings bedrückend auf Mathematik-Interessierte wirken, wenn sich nicht einmal die obige Kontroverse einvernehmlich auflösen lässt,

– worin der eine unterbreitete:

» [Falls die Menge der Lotpunkte ℒ eine echte Teilmenge der Menge 𝒢 der Punkte des Meeresgrundes wäre, dann] wäre das, dessen Minimum wir suchen, keine Funktion. «,

– während der andere entgegensetzte:

» Die Beziehung zwischen Punkten des Meeresgrundes und dem Wertebereich von Tiefenwerten ist doch jedenfalls eine Funktion : 𝒢 → 𝒯; insbesondere auch dann, falls uns die Funktionswerte für bestimmte Argumente unbekannt wären (nämlich genau für jene Punkte von 𝒢, die nicht zur Menge ℒ gehören) «.

> Ein Post muss sich (naturgemäß) auf ein Thema beschränken, und ich sehe zu, dass ich beim Beantworten einigermaßen beim Thema bleibe. Wie man eine Hystereseschleife am besten beschreibt, gehört definitiv nicht mehr dazu.

Um so bedauerlicher, dass der eine das Thema »Hystereseschleife« oben überhaupt aufwarf, und der andere durch den Versuch, dessen mangelnde Relevanz darzulegen, diesbezüglich überhaupt Kenntnisnahme ausdrückte.

> 2) Ihr Wunsch nach einem Briefkastenonkel für Mathematik oder gar für Wissenschaft allgemein ([»“Frag-den-SciLog”-SciLog«]) ist nachvollziehbar, aber ich halte ihn für unerfüllbar. […]

Wer als SciLog-Administrator das Privileg genießt, ganze SciLog-Beiträge zu Themen seines Interesses gestalten und zur Diskussion stellen zu dürfen, dem mag freilich egal sein, ob für bloße SciLogs-Kommentatoren eine gewisse Hoffnung darauf bestünde, öffentlich und Barriere-frei Fragen zu eigenen Interessen zu formulieren;

wenigstens etwa wie hier (ohne LaTeX-Unterstützung),

oder womöglich wie im anderen Laden …

> Immerhin, es gibt so etwas Ähnliches: eine Newsgroup namens […]

???

Wer als SciLog-Administrator das Privileg genießt, ganze SciLog-Beiträge zu Themen seines Interesses gestalten und zur Diskussion stellen zu dürfen, dem scheint wohl sogar die Barriere-Freiheit des Kommentierens von SciLogs-Beiträgen (bzw. denen im weit und breit einzigen anderen Laden) unerheblich.

(Ganz zu schweigen vom Dokumentieren, wie viele Links denn nun in einem SciLogs-Kommentar maximal zulässig wären …)

Hm. Dann versuchen wir doch, die Kontroverse aufzulösen. Der Weg geht – wie üblich – über eine saubere Klärung der Begriffe.

Was genau verstehen die Teilnehmer der Diskussion unter „Meeresgrund“? Da wir unter Mathematikern sind, reden wir nicht vom echten Meer, sondern von einem mathematischen Modell des Meeres (samt Umgebung), also ist der Meeresgrund eine Menge von Punkten. Mit welcher Eigenschaft?

– Erster Versuch: Ein Punkt gehört zum Meeresgrund, wenn über ihm Wasser und unter ihm „Feststoff“ ist. „Drüber“ und „drunter“ sind klar definiert, wir haben ja Koordinaten, die uns sagen, wo oben und wo unten ist. „Feststoff“ ist ein Hilfsbegriff für alles, was nicht Wasser ist. Ein bisschen problematisch für Sand und Schlick, aber davon abstrahieren wir jetzt mal. Und Bewegung (Ebbe und Flut, Meeresströmungen und so) denken wir uns auch erstmal weg.

Das geht zunächst, aber aufpassen! Es soll ja auch um überhängende Felsen und sowas gehen. Die sind wer weiß wie geformt. Gehört ein Stück senkrecht abfallende Felswand noch zum Meeresgrund? Daher:

– Zweiter Versuch: Ein Punkt gehört zum Meeresgrund, wenn in einer Umgebung dieses Punktes sowohl Wasser als auch Feststoff vorkommen. Damit zählt die gesamte Oberfläche des Felsens, einerlei wie sie orientiert ist, zum Meeresgrund. Der Begriff „Umgebung“ kommt aus der Analysis (die Leute sagen gerne auch mal „epsilon-Umgebung“) und meint: Um als Grenzpunkt zweier Teilmengen (in unserem Kontext: Punkt des Meeresgrunds) durchzugehen, genügt es, wenn in beliebiger Nähe dieses Punktes Elemente beider Teilmengen vorkommen.

Wozu der begriffliche Aufwand? Weil die Mathematiker sich nicht nur für die Grenze zwischen Wasser und Feststoff interessieren, sondern auch für die Grenze zwischen zwei Teilmengen, die nur durch irgendwelche Eigenschaften definiert sind und von denen man sonst kaum etwas weiß. Da können dann sehr merkwürdige Dinge passieren; auf die will man vorbereitet sein.

Jetzt müssen wir nur noch vorausetzen, dass das Wasser nicht unendlich tief ist, also: Unter jedem Punkt der Oberfläche kommt irgendwann Feststoff.

Nun können wir endlich Funktionen definieren. Zu jedem Punkt des Meeresgrundes den Punkt der Oberfläche nehmen, der genau darüber liegt: Das ist offensichtlich eine Funktion. Sie definiert zu jedem Punkt des Definitionsbereichs (hier: des Meeresgrundes) genau einen Bildpunkt.

Eigentlich hätte man gerne die Umkehrung dieser Funktion: eine, die zu jedem Punkt der Oberfläche den Punkt des Meeresbodens ansagt, der genau darunter liegt. Aber die Funktion gibt’s im Allgemeinen nicht! Es gibt nämlich möglicherweise mehrere Punkte des Meeresbodens, die diese Voraussetzung erfüllen.

Man kann sich natürlich die Funktion zurechtdefinieren, die zu jedem Punkt der Oberfläche die Menge aller Meeresgrundpunkte liefert, die darunter liegen. Das geht widerspruchsfrei, also gibt’s die Funktion. Bloß kann man eigentlich nichts mit ihr anfangen, weswegen man sie in Büchern und Fachaufsätzen in der Regel nicht findet.

Dann gibt’s die Funktion, die zu jedem Punkt der Oberfläche den „Lotpunkt“ liefert, also den Punkt des Meeresgrundes, den das Lot zuerst trifft. Das würde heißen, man nimmt von den Mengen unserer mengenwertigen Funktion stets das oberste Element und hat wieder eine Funktion, die Punkte auf Punkte abbildet. Das funktioniert meistens – aber nicht im Prinzip! Diese Menge könnte aus unendlich vielen Punkten bestehen, die gegen einen höchsten Punkt konvergieren, aber dieser höchste Punkt gehört dann nicht zur Menge. Damit das nicht passiert, macht man die merkwürdige Definition mit der Umgebung (s. o.).

Oder man definiert eine Teilmenge des Meeresgrundes als die Menge aller höchsten Punkte des Meeresgrundes, also aller Punkte, die vom Lot getroffen werden. Das geht; auf diese Teilmenge beschränkt wird unsere erste Funktion sogar umkehrbar.

Was lernen wir aus diesem (schon wieder viel zu langen) Text? Definieren kann man vieles, das ist mathematisch sogar alles korrekt. Aber hinterher will man mit der Definition ja auch arbeiten. Und dann gibt es auf einmal nicht mehr so viel, was zu definieren sich lohnt.

Schreibfehler meinerseits.

Es muss heißen, „wenn in jeder Umgebung dieses Punktes sowohl Wasser …“ (nicht: „in einer Umgebung“).

Sorry.