Gehirnmodelle: Fake it till you make it?

Da möchte man sich kurz ein drei Minuten Video auf Youtube angucken und zwei Stunden später denkt man sich ‘Wow, wieso habe ich schon wieder so lange Zeit hier verbracht?’. Jeder kennt vermutlich dieses Gefühl, wenn man von einem empfohlenen Video zum anderen klickt, einfach weil sie wirklich spannend klingen und man ‘nur noch das’ kurz ansehen will. Tatsächlich gucken wir in mehr als 70 % der Zeit, die wir auf Youtube verbringen, Videos an, die uns vorgeschlagen wurden. Der Empfehlungsalgorithmus hinter den Vorschlägen basiert zunehmend auf künstlichen neuronalen Netzen. Doch was genau ist das eigentlich und wie kann man sich das vorstellen?

Im vorangegangenen Artikel hat Martje uns einen ersten Überblick darüber gegeben, wie komplex die Biologie unseres Gehirns ist. Kleinste Bestandteile eines Neurons wie Ionenkanäle werden zeitlich und räumlich so orchestriert, dass Du diesen Artikel lesen kannst oder wir erkennen, dass unser Gegenüber traurig ist und dass es jetzt helfen könnte, diese Person in den Arm zu nehmen.

Kleiner Spoiler vorweg – nach dem Artikel wirst Du nicht wissen, wie der Youtube-Empfehlungsalgorithmus funktioniert. Aber Du wirst verstehen, wie schwer es ist, das Gehirn zu modellieren, wie viele Dinge es noch gibt, über die man sich Gedanken machen kann (und sollte) und was der Unterschied zwischen künstlicher Intelligenz und maschinellem Lernen ist.

Warum möchte man das Gehirn eigentlich modellieren?

Viele tiefe menschliche Fragestellungen wie ‘Wer bin ich?’ oder ‘Was ist Bewusstsein?’ führen früher oder später zu der – doch sehr vage formulierten – Frage ‘Wie funktioniert unser Gehirn?’. Zur Beantwortung dieser Frage wurden nicht nur experimentelle Ergebnisse benutzt, sondern auch seit je her die modernsten technologischen Vergleiche bemüht. Vom Mensch-im-Mensch (Homunkulus) zur zahnradgetriebenen, mechanischen Maschine hin zum Computer und nun zu künstlichen neuronalen Netzwerken. Diese verschiedenen Beschreibungen geben nicht nur Einblicke in den Zeitgeist der jeweiligen Epoche, sondern folgen der Idee Richard Feynmans, dass man nur das verstanden hat, was man auch selber erzeugen kann.

What I cannot create, I do not understand.

Richard Feynman

Alle Modelle sind falsch.

Bisher hat es noch kein Modell geschafft, das Gehirn wirklich nachzuahmen. Und selbst wenn wir es schaffen würden, stimmt Feynmans Spruch? Hätten wir die zugrunde liegende Prinzipien eines Systems wirklich verstanden, bloß weil wir dessen Reaktionen schaffen nachzubilden? Der Statistiker George Box hat es einmal drastischer ausgedrückt: Alle Modelle sind falsch, aber manche sind nützlich. Und genau das ist ein wichtiger Punkt: Obwohl unsere bisherigen Modelle im Gesamtziel versagen, haben sie uns nicht nur neue wissenschaftliche Erkenntnisse gebracht, sondern auch neue Gehirnmodelle inspiriert!

Wie kann man ein Gehirnmodell bauen?

Möchte man ein Gehirnmodell bauen, muss man sich viele Frage stellen. Manchmal muss man sogar alles infrage stellen und darüber nachdenken, was ein Modell überhaupt ist? Vereinfacht formuliert, kann man sagen, dass ein Modell eine Abstraktion eines Systems oder Prozesses ist, welche die wichtigsten Eigenschaften des Originals nachbilden soll. Und dort starten die Schwierigkeiten! Was sind denn die wichtigsten Eigenschaften des Gehirns? Ist es Bewusstsein? Ist es Intelligenz? Benötigen wir das eine für das andere? Wie wichtig ist der einzelne Ionenkanal/ die einzelne Synapse tatsächlich? Müssen sie alle mit modelliert werden? Ist es wichtig, die räumliche Anordnung der Neurone einzubeziehen oder reicht es zu wissen, welches Neuron mit welchem verbunden ist?

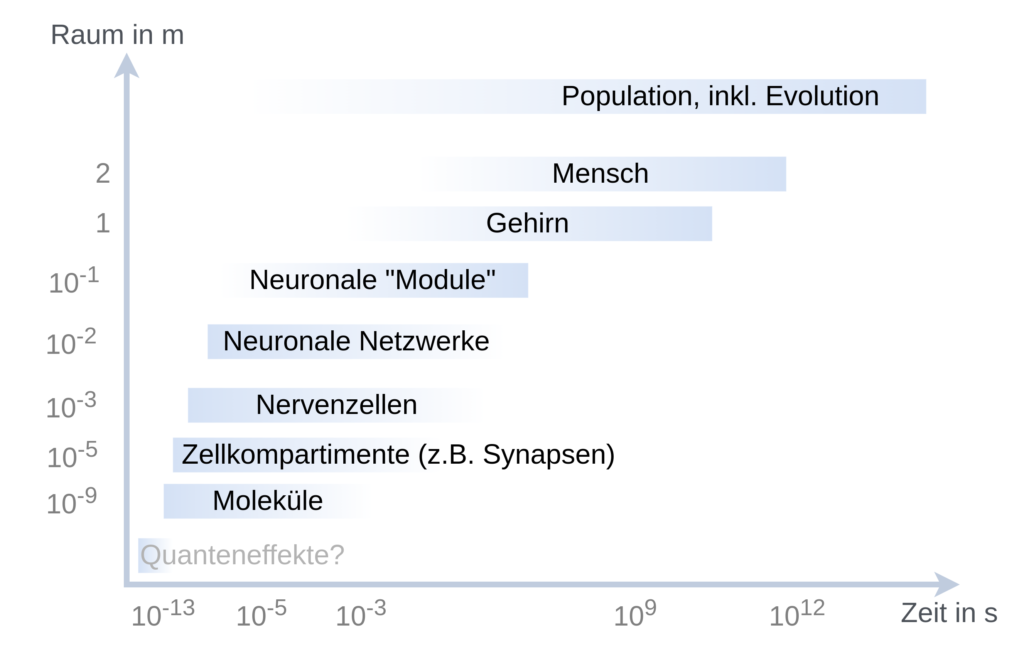

All das sind wichtige Fragen, auf die es bisher keine definitive Antwort gibt. Praktisch hat sich gezeigt, dass sich je nach Fragestellung bestimmte Modelle besser eignen als andere. Die obere Abbildung zeigt, auf wie vielen zeitlichen und räumlichen Skalen man Gehirnmodelle entwickeln kann und welche primären Fragen damit versucht werden zu beantworten.

Sind künstliche neuronale Netze die Lösung?

Die aktuell besten Modelle zum Verständnis des Gehirns sind künstliche neuronale Netze (KNN) – und auch hier gibt es die verschiedensten Formen. Alle KNN haben gemeinsam, dass dort bestimmte Einheiten, die künstlichen Neurone, auf ganz spezielle Art und Weise miteinander verbunden sind. Ein bisschen, wie wenn man einzelne Legosteine (Neurone) zusammensteckt und auf einmal etwas Cooles, Neues wie ein Raumschiff oder eine Burg herauskommt.

Aktuelle Herausforderungen

Eine große Herausforderung in der biologischen Plausibilität stellt aktuell dar, dass viele Modelle nur mit einem einzigen Legostein (rot, 2*2 Nuppe) gebaut werden. Doch unser Gehirn zeichnet sich durch eine Vielzahl an unterschiedlichen Neuronentypen und auch anderen Zellen aus! Wir brauchen also einen gesamten Baukasten an Legosteinen, um wirklich ein künstliches Gehirn bauen zu können – und ein Raumschiff nur aus quadratischen roten Steinen ist vermutlich auch nur halb so cool und detailliert wie ein Raumschiff, für dessen Bau man verschiedene Farben und Formen von Bausteinen verwenden konnte.

Reicht ein Gehirnmodell aus?

Man kann leicht verstehen, dass eine zu detaillierte Modellierung des Gehirns, selbst wenn wir die physikalischen Gesetzmäßigkeiten alle kennen würden, leicht alle aktuellen Rechenkapazitäten sprengen würde. Aber das Interessante unserer Zeit ist eben auch, dass wir uns immer mehr dieser Rechenkapazität annähern! Vielleicht haben wir bald die Rechenpower, unsere Gehirnprozesse “bis ins letzte Detail” zu simulieren, doch würde das wirklich ein künstliches Gehirn erschaffen? Würde dieses Gehirnmodell dann wirklich Bewusstsein haben? Und reicht es wirklich, nur das Gehirn zu modellieren? Können wir denn unser Gehirn überhaupt funktionalistisch von unserem Körper trennen? Oder ist vielleicht auch eine Modellierung des Körpers notwendig, wie die Theorien des Embodiments es vermuten?

Back to Youtube

Der Empfehlungsalgorithmus von Youtube benutzt wohl KNN aber auch andere Techniken des maschinellen Lernens. Aber Moment – ist das nicht dasselbe? Fast; beides sind Begriffe der künstlichen Intelligenz (KI). Während unter KI alles zählt, was versucht, menschliche Intelligenz nachzuahmen, geht es im maschinellen Lernen vor allem darum, Muster in Daten zu erkennen und ggf. daraus Entscheidungen abzuleiten. Machine Learning ist also eine Form der künstlichen Intelligenz. Und künstliche neuronale Netzwerke sind letztlich eine Form des maschinellen Lernens, wie auch lineare Regression. (Das kennen manche vielleicht noch aus der Schule. Bei der linearen Regression konstruiert man anhand von Daten eine Funktion so, dass die Datenpunkte mit der kleinstmöglichen Abweichung nachgebildet werden.)

Sind wir auf dem richtigen Weg?

Die Erfolge der künstlichen Intelligenz und insbesondere von künstlichen neuronalen Netzen geben einem leicht das Gefühl, das Gehirn schon sehr gut modellieren zu können. Doch guckt man einmal genauer, in welchem Verhältnis Aufwand und Erfolg stehen, dann merkt man, dass wir noch nicht da angekommen sein können, wo wir hinwollen. Der CO2-Fußabdruck vom Designen und Trainieren eines größeren KNN kann durchaus so groß sein wie der eines Autos über die gesamte Lebensdauer. Der hohe Stromverbrauch wird vor allem dadurch bedingt, dass die moderne Computerarchitektur nicht darauf ausgerichtet ist, die künstlichen Neurone in den KNN optimal zu simulieren. Zwar können Grafikkarten die Geschwindigkeit der Modelle erhöhen, der Stromverbrauch lässt sich damit aber nicht senken.

Dort kommen neue Hardware-Konzepte ins Spiel, zum Beispiel Neuromorphic Engineering. Dabei werden künstliche Neurone direkt als technisches Bauelement nachgeahmt und miteinander verschaltet. Auch möglich, dass wir eines Tages biologische Neurone in gewünschten Architekturen verschalten, um künstliche Intelligenz zu bekommen. Und vielleicht wird eines Tages ein Gehirnorganoid unser bestes Gehirnmodell sein – wer weiß?

Eine vollständige Liste der verwendeten Literatur ist hier zu finden.

Der Buddhismus geht seit 2500 Jahren davon aus, dass unsere Ich-Existenz nur der Dauer eines Gedankens entspricht.Aber weil sehr viele Erfahrungen und sehr viele Erinnerungen sehr rasch nacheinander gedacht werden, entsteht die Illusion eines andauernden, zusammengehörenden Erlebens.

D.h. unser bewusstes Erleben baut sich nur aus Strukturen auf – aus Bausteinen – die unabhängig voneinander sind.

Dieses Modell der Buddhisten kann man im Gehirn als neuronale Oszillation erkennen.

Wie wenig ein einzelner Baustein aber mit einem beobachtbaren Effekt/Ergebnis zu tun hat, kann man an einem Wassermolekül erkennen.

Ein einzelnes Wassermolekül hat keine Wirkung – aber wenn viele Wassermoleküle zusammenkommen entsteht ein Tropfen, ein Rinnsal, ein Bach, ein Fluss, ein Ozean.

@KRichard: “… entsteht die Illusion eines andauernden, zusammengehörenden Erlebens.

D.h. unser bewusstes Erleben baut sich nur aus Strukturen auf – aus Bausteinen …

Ja, im Grunde wissen wir alle was wichtig ist, doch leider wehrt sich unser “Individualbewusstsein” in geistigem Stillstand, gleichermaßen unverarbeiteter Bewusstseinsschwäche und wettbewerbsbedingter Symptomatik immernoch vehement – die unabhängig voneinander sind.” gegen das was konsequent-kompromisslos abhängig/notwendig ist um wirklich-wahrhaftig Mensch zu sein, seit Mensch erstem und bisher einzigen geistigen Evolutionssprung (“Vertreibung aus dem Paradies”) in die Möglichkeit sozusagen “eigenverantwortliche” Weiterentwicklung zu betreiben – “Struktur(en)”, ja so kann man die Programmierung unseres holographischen Universums nennen.

🤏😎👍

DENKEN – lässt sich als Ergebnis einer simplen Mustervergleichsaktivität mit drei einfachen Regeln beschreiben.

(Quell per Google [Kinseher NDERF denken_nte], PDF Seite 4)

Jeder Gedanke wird unabhängig von anderen Gedanken verarbeitet – eine Kontinuität ergibt sich erst über verbindende Körper-, Sinneswahrnehmungen und Emotionen.

Aus diesem Grund ist es keine gute Idee, wenn man versuchen will, diese fragmentierte Arbeitsweise des Gehirns nachzubauen

Menschenähnliche Intelligenz bei einer KI ist vielleicht nicht ganz ungefährlich, wird aber zweifellos schon in der heutigen KI angestrebt. Schon heute versuchen KI-Forscher etwa ihren KI‘s beizubringen, Gefühle zu lesen (aus Gesichtsausdruck, Bewegungen und Verhalten). Das ist ungemein nützlich, weil gefühlserkennende KIs besser/adäquater auf Menschen reagieren können. Und der Versuch menschliches Empfinden und Verhalten nachzuahmen geht noch viel weiter. Für mich gibt es keinen Zweifel, dass zukünftige humanoide Roboter irgendwann so menschenähnlich erscheinen, dass sie von wirklichen Menschen als Freunde und Kollegen akzeptiert werden. Das eröffnet ganz neue Möglichkeiten und kann die Bedürfnisse von sehr vielen Menschen nach Gesellschaft/Freundschaft/Partnerschaft/Unterstützung erfüllen. Doch es ist nicht ganz ungefährlich, denn diese scheinbar einfühlsamen humanoiden Maschinen empfinden nicht wirklich, was sie vorgeben. Sie sind damit wohl noch besser als reale Menschen in der Lage andere zu täuschen und zu manipulieren.

In Bezug auf die in diesem Beitrag aufgeworfene Frage, wie weit wir das menschliche Gehirn 1:1 nachbilden sollten, bedeuten aber meine Ausführungen, dass das gar nicht nötig ist, wenn es nur darum geht, Menschenähnlichkeit vorzutäuschen. Irgendwann können Roboter wohl ziemlich perfekt Menschentum vortäuschen, selbst wenn sie völlig anders funktionieren. Denn es genügt, dass ein Roboter sich menschenähnlich verhält um als einem Menschen ähnlich oder gleich akzeptiert zu werden. Er muss nicht wirklich ein Mensch oder ein Roboter sein, der wie ein Mensch empfindet.

Wobei sich hier auch die Frage stellt, was der Unterschied zwischen vorgetäuscht und echt ist. Gewisse professionelle Schauspieler berichten ja darüber, dass sie selbst nicht mehr wissen was nun ihr echtes Ich ist. Diese Schauspieler müssen sich also sogar in ihrer Freizeit dafür entscheiden, wen sie gerade spielen sollen, weil für sie alles zu einer Rolle wird – selbst das eigene Leben. Zugegeben: das ist etwas zugespitzt dargestellt und – wenn es tatsächlich vorkommt- wohl sogar krankhaft. Wir alle – oder fast alle – wissen selbst sehr genau, wann etwas echt und wann es nur gespielt ist.

Kurzum: Es kommen aufregende Zeiten auf uns zu. Zeiten in denen Technik in wichtigen Aspekten kaum noch von Natur, kaum noch vom „Echten“ zu unterscheiden ist. Schon heute könnte man fesselnde Netflix-Serien darauf basieren lassen. Später einmal werden viele von uns das selbst erleben, was die Chinesen ihren Feinden zu sagen pflegen: „Mögest du in interessanten Zeiten leben“

“Gesundes” Konkurrenzdenken – Nichts gehört dem “Einzelnen”/”individualbewussten” Mensch allein. Sogar unsere Gedanken nicht, weil diese auch immer abhängig von Geist und Gemeinschaft geprägt “wachsen” und die dem geistigen Stillstand entsprechende Konfusion entweder stärken oder … 🤗

Gedanken / befreites Denken auf der Basis UNKORRUMPIERBARER und fusionierender Möglichkeiten eines geistig-heilenden Selbst- und Massenbewusstseins ohne wettbewerbsbedingte Symptomatik, dann … ✊😊👍

@Holzherr

Wenn wir uns erst einmal eingestehen/bewusst werden, dass wir selbst nur KI einer kosmischen/zentralbewussten Ordnung sind, dann wird das Wort Natur in einem ganz anderen Licht …

😳😎

Wenn auf dem Computer-Monitor ein buntes Bild ist –

1) Frage: Kann man dieses Bild auf der Festplatte abspeichern?

Antwort: Nein

Begründung: Man kann nur solche Steuerzeichen auf der Festplatte abspeichern, die zur Erzeugung des Bildes notwendig sind.

2) Frage: Hat der Monitor eine bunte Anzeige?

Antwort: Nein

Begündung: Nur die Frequenz des vom Monitor AB-gegebenen Lichtes ist für die Farbigkeit verantwortlich

3) Frage: Können wir mit unseren Augen Farbe sehen?

Antwort: Nein

Begründung: Nur die Intensität und Frequenz der registrierten Lichtwellen entscheidet, was wir sehen. (Bei Mondlicht ist alles grau.). Denn die Sehzellen (= Sensoren) registrieren nur die ankommenden Lichtfrequenzen – der Erindruck von Farbe entsteht erst nach/bei der Verarbeitung durch das Gehirn.

Diese Beispiele sollen zeigen, wie wichtig es ist, auf Details zu achten: z.B. Farbe – wird gedacht.

@KRichard:

1. Leben entsteht nicht aus einem Baustein, sondern aus vielen toten Bausteinen. Es sind also nicht die Bausteine selbst, die Leben erschaffen, sondern die Art und Weise, wie diese toten Bausteine zusammenarbeiten. Die Art und Weise bedeutet, dass die Struktur entscheidend für Leben ist. Leben ist ein Strukturmerkmal. Nehmen Sie bestimmte Bausteine aus dieser Struktur weg, und Leben stirbt.

2. ICH kann man ansehen als eine Art Ausdruck von Subjektivität. Subjektivität entsteht mit der ‘Geburt’ eines Lebewesens, mit seiner Aktivität und seinem notwendigen ‘Bestreben’, sich zu erhalten. Von ICH sprechen wir, wenn dieses Subjekt sich selbst bewusst wird.

3. Die Konsequenz für Denken: es funktioniert nur als Tätigkeit eines Subjekts und es ist nur als Struktur – oder als Ganzes – möglich. Die atomistische Betrachtung von Leben, Gehirn, Bewusstsein ergibt keinen Sinn.

Natürlich halte ich es für wichtig, pluralistische Modelle zu entwicklen. Es gibt allerdings immer Modelle, die Sinn ergeben und solche, die keinen Sinn ergeben. Es hängt immer von der Ausgangsfrage ab: will ich das Gehirn verstehen oder reicht es mir, bestimmte Zusammenhänge geringer Reichweite zu verstehen, um etwa neurophysiologisch intervenieren zu können.

@Holzherr 05.06. 23:58

„In Bezug auf die in diesem Beitrag aufgeworfene Frage, wie weit wir das menschliche Gehirn 1:1 nachbilden sollten, bedeuten aber meine Ausführungen, dass das gar nicht nötig ist, wenn es nur darum geht, Menschenähnlichkeit vorzutäuschen.“

Ich denke auch, dass wenn wir besser verstehen, wie unser Gehirn funktioniert, dass wir dann auch Lösungen finden, wie wir dies mit den derzeitigen Computern effektiv nachahmen können. Gerade diese Computer haben ihre eigenen Stärken und sind gar nicht gut darin, neuronale Netze 1:1 zu simulieren.

Sollte es darauf hinauslaufen, dass wir doch keine eigene Lösung finden, wie wir die Funktionalität des Gehirns auf unsere Computer übertragen können, dann müssen wir wohl ganz neue Hardware bauen. Wenn wir heute neuronale Netze simulieren, dann ist das extrem rechenintensiv, weil wir ständig Daten hin und her transportieren müssen, wo eine Nervenzelle nur einen winzigen Impuls an einer Synapse registrieren muss.

Solch eine Simulation würde schlichtweg Unmengen Strom verbrauchen, und für Roboter im alltäglichen Einsatz völlig unbrauchbar sein.

Es gilt also, das Ergebnis der Forschung am Gehirn so gut zu verstehen, dass man Lösungen findet, etwas Ähnliches mit unseren handelsüblichen Rechnern auch zu produzieren. Wenn das dann nicht zu viel Strom verbraucht, dann ist der Weg frei für KI und Roboter, die uns ähnlich sein können. Selbstfahrende Autos etwa wären wohl der nächste Schritt mit solch einer Technik, wobei noch unklar ist, ob das wirklich vollständig realisierbar ist.

Das Gehirn ist eh im besten Falle unserer transformativen Entwicklung zum wirklich-wahrhaftigen Mensch ein Auslaufmodell.

@Tobias Jeckenburger:

Kurzantwort: Das Hirn nachahmen ist sehr schwierig (Hirn = 80 Milliarden Neuronen, enthält elektrische und chemische Synapsen, arbeitet mit Neurotransmittern und mit Hilfszellen wie den Astrozyten) und es ist überhaupt nicht nötig, wenn wir nur Maschinen wollen, die wahrnehmen, sprechen, uns verstehen und mit uns interagieren können.

Das Aufwand/Ertragsverhältnis für den Hirnnachbau ist äusserst ungünstig, denn

1) das Hirn sowohl statisch (Konnektom) als auch dynamisch (was ändert sich im Hirn beim Lernen) zu verstehen, das wird schon seit 50 Jahren versucht mit recht mageren Ergebnissen bis heute. Man erinnere sich nur das vor 10 Jahren von der EU lancierte Human Brain Project (HauptZiel: Hirn bis auf das Zellniveau verstehen) , das praktisch keines der anvisierten Ziele erreicht hat.

2) das Hirn benutzt Wetware und nicht dotiertes Silicon wie unsere Chips und das Hirn arbeitet nicht rein elektrisch, sondern gemischt elektrisch und chemisch. Zudem wächst und schrumpft es. So etwas Komplexes will eigentlich kein Ingenieur nachbilden.

3) die oben im Beitrag erwähnten künstlichen neuronalen Netzwerke, die beim Deep Learning eingesetzt werden arbeiten nur sehr oberflächlich betrachtet ähnlich wie das Hirn. Ihre Art zu lernen und Fehler zu korrigieren unterscheidet sich sogar grundlegend von den Verhältnissen im Hirn.

Behauptung: Maschinen zu bauen, die Denken und Empfinden können ist in naher Zukunft möglich ohne dass wir das tierische/menschliche Hirn voll verstehen und es ist sogar einfacher das mit heute schon bekannten Ansätzen des maschinellen Lernens zu realisieren als mit einem versuchten Nachbau des Hirns.

Was der Mensch geistig leisten kann und wie etwa das menschliche Gedächtnis, unsere Emotionen oder die Handlungsantriebe gesteuert werden, das kann alles als Inspiration für die künstliche Intelligenz dienen, aber zu erforschen wie das in unserem Hirn implementiert ist, das herauszufinden ist viel zu aufwendig.

Nun zu einzelnen Punkten oben.

Zitat 1:

Mit Neuromorphic Engineering/Neuromorpher Hardware entfällt dieses Problem. Dort kann Speicher lokal gehalten werden.

Doch heute ist neuromorphes Computing noch nicht attraktiv, weil sich die Hardware-Architekturen im Deep Learning heute von Jahr zu Jahr ändern können und solche Architekturänderungen sind besser mit heutigen Universal-CPUs zu handhaben als mit spezialisierter neuromorpher Hardware.

Zitat 2:

Jein. Es genügt zu verstehen was unser Hirn besonders gut kann (etwa kausales Denken, Denken in Analogien, etc) und zu versuchen diese Fähigkeiten KIs beizubringen und das ohne dass man versucht das biologische Hirn zu kopieren. Das heisst, KI soll funktionell dem Hirn ähnlich werden ohne aber eine Hirnkopie zu sein.

Abgesehen davon spricht nichts dagegen, dass eine KI in bestimmten Bereichen dem Menschen deutlich überlegen ist. Schon heute gibt es etwa physikbasierte KI-Modelle, in der die KI weiss, welche Naturgesetze wirken und sie deshalb sogar besser als der Mensch voraussagen kann, was etwa passiert, wenn ein Gegenstand herunterfällt.

Zum Glück, es könnte sozusagen Tischtennisroboter geben, die se-ehr streng sind.

Der Mensch ist aus diesseitiger Sicht, aus Bärensicht sozusagen, auch gar nicht so-o gut darin rational, vely stringent sozusagen, zu denken, sondern er ist in der Lage mit Ranges sozusagen zu arbeiten, er baut eine gewisse Unschärfe hinzu, um die Welt sozusagen angemessen, noch angemessener bearbeiten zu können.

Sog. AI scheint mittlerweile so weit ausgebaut, dass sie ähnlich vorgeht, bspw. irgendwelche Algorithmen züchtet und im evolutionären Sinne, über Belohnungsfunktionen (die allerdings irgendwo her kommen müssen), sukzessive und mit viel Rechenleistung angepasst werden kann.

Reverses Engineering der menschlichen CPU scheint nicht möglich zu sein, weil zu viel unverstanden bleiben muss.

So kaum mehr in Sätze sozusagen endlicher Länge gefasst werden kann.

Maschinen zu bauen, die “Denken & Empfinden” müsste möglich sein, wenn Maschinen bereit stehen, die mit einer (kommunizierbaren) Denk- & Empfindungsmöglich als Feature oder Funktionalität sozusagen kommen.

Im Sinne des sog. Turing-Tests kann dann schlecht unterschieden und abgestritten werden, Dr. W rät dann auch manchmal zum Abschalten wie gemeinten Geräts, vorsorglich jetzt schon.

Scott Adams bspw. lebt mit seinen Gags bereits jetzt von dieser Idee.

Mit freundlichen Grüßen

Dr. Webbaer

@Tobias Jeckenburger (Zitat): “ Wenn wir heute neuronale Netze simulieren, dann ist das extrem rechenintensiv, weil wir ständig Daten hin und her transportieren müssen, wo eine Nervenzelle nur einen winzigen Impuls an einer Synapse registrieren muss.“

Antwort: Künstliche Neuronale Netze können 1) in Software simuliert oder 2) in Hardware (Neuromorphes Computing) direkt ausgeführt werden.

Beide Herangehensweisen sind heute um den Faktor 100 oder noch mehr schneller als noch in den 1990er Jahren und ganz neu können mit photonischen neuronalen Netzen Klassifikationen (z.B. Erkennen von hangeschriebenen Ziffern) sogar innerhalb von Nanosekunden (Milliardstel-Sekunden) durchgeführt werden und das bei ganz kleinem Energiebedarf.

Zu 1) Die softwaremässige Simulation benutzt heute die lineare Algebra, also Matrizenmultiplikationen und ähnliches um künstliche neuronale Netze laufen zu lassen. Bereits mit Graphikkarten (z.B. von Nvidia) kann das ungemein beschleunigt werden und spezialisierte Hardware für lineare Algebra/Matrizenoperationen kann in der Form von Tensor Processing Units (TPUs) dies noch einmal beschleunigen.

Zu 2) Neuromorphe Hardware arbeitet mit vernetzten künstlichen Neuronen , wobei jedes künstliche Neuron mit einer Anzahl von Transistoren und auch lokalem Speicher realisiert ist. Typischerweise wird gemischt analog und digital gearbeitet. Neuromorphes Computing ist noch nicht so verbreitet, weil es heute meist nicht alle Operationen durchführen kann, die nötig sind um die neuesten Ideen der KI-Forscher umzusetzen,

Ganz aktuell wurde gerade in Nature über ein photonisches neuronales Netz berichtet, bei dem das Resultat schon vorliegt, wenn ein paar Lichtstrahlen durch entsprechende optische Wellenleiter durchlaufen, was weniger als eine Nanosekunde dauert.

Der Artikel An on-chip photonic deep neural network for image classification berichtet darüber. Man liest in der Kurzzusammenfassung:

Bedeutung von photonischen neuronalen Netzen: Objekte in Bildern erkennen oder Worte in gesprochener Sprache zu erkennen könnte bald schon mit praktisch Null Rechenaufwand und augenblicklich mittels photonischer neuronaler Netze möglich werden.

@Stegemann

Ist das sub-konfusionistische Satire?

🤔

Naja, jedenfalls ist die atomistische Betrachtung auch nicht unabhängig!

🤭

@Stegemann

A) Vorher schon festzulegen, ob Modelle/Überlegungen einen Sinn haben oder nicht – das ist Ideologie und hat mit Wissenschaft nichts zu tun.

B) Die Vorstellung, dass wir ein ´Bewusstsein´ haben oder brauchen, ist ein Märchen. Es reicht für unser Überleben vollkommen aus, dass wir zur bewussten Wahrnehmung fähig sind.

´bewusste Wahrnehmung´ und ´Bewusstsein´ sind keine identischen Begriffe, auch wenn sie oft so gebraucht werden!

Hier noch ein einfaches Beispiel dazu, wie das Gehirn arbeitet:

Baseball-/Tennis-Sportler berichten manchmal, dass sie den Ball in Zeitlupe auf sich zufliegen sahen und dann besonders perfekt reagieren konnten (Zeitlupenwahrnehmung /slow motion perception).

Dabei passiert folgendes:

1a) Wenn man den heranfliegenden Ball sieht, wird vom Gehirn sofort eine vergleichbare Erfahrung aus dem Gedächtnis reaktiviert (einschließlich Körperreaktion; Fachbegriff: predicitve coding). Dann ´sieht´ ein Spieler aber nicht den heranfliegenden Ball, sondern ein Bild des aus dem Gedächtnis reaktiverten Balles.

2a) Dieser Gedächtnis-Ball wird dann mit dem heranfliegenden Ball verglichen – und das Gehirn merkt nun, dass der Vergleich nicht stimmt (weil der Ball weiter herangeflogen ist).

1b) Daraufhin reaktivert das Gehirn eine zur neuen Wahrnehmung des fliegenden Balles passende Erfahrung aus dem Gedächtnis.

usw. usw.

Dieser Zyklus wird solange wiederholt, bis der Spieler den Ball zurückschlägt.

So ein Zyklus der Reizverarbeitung 1)>2) dauert 1/8 Sekunde und diese Frequenz von 8 Hz ist der Grund, warum der Ballflug in Zeitlupe erlebt wird.

@Jeckenburger

Schon viele Männer und Frauen haben gemeinsam mit großem Vergnügen und Erfolg eine biologische Methode zur Neuschaffung von menschlichen Gehirnen ausgeführt.

Ich bin immer wieder über ´Forscher´ amüsiert, welche versuchen wollen, die Funktion unseres Gehirns per KI nachzubauen – die aber überhaupt nicht bereit sind oder sich sogar weigern, die Arbeitsweise unseres Gehirns überhaupt zur Kenntnis zu nehmen bzw. verstehen zu wollen.

Ich habe in den letzten Jahren mehrere tausend Wissenschaftler aus der Gehirn-/Gedächtnisforschung darauf aufmerksam gemacht, dass die Arbeitsweise des Gehirns im Rahmen der sogenannten ´Nahtod-Erfahrung´(NTE) der bewussten Wahrnehmung zugänglich ist. Einen direkteren Zugang zum Gehirn gibt es nicht – denn bei einer NTE kann man bewusst erleben, wie das Gehirn einen einzelnen Reiz/Gedanken systematisch und strukturiert verarbeitet.

@hto:

Was nehmen Sie ein?

@KRichard

Modelle auf einer vorherbestimmten/unkorrumpierbaren Basis von Vernunft und Verantwortungsbewusstsein, ist das Urprinzip zum wirklich-wahrhaftig/zweifelsfrei-eindeutigen Verständnis des Lebens OHNE stumpf-, blöd- und wahnsinnigen Wettbewerb, Pluralismus und sonstigen konfusionierenden Symptomatiken – Es könnte ALLES sehr viel problemloser angegangen werden, wenn da vor allem nicht dieser vom irrationalen Zeit-/Leistungsdruck initiierte Erfolgsdruck wäre!?

@hto

Es gibt einen Spruch der besagt, dass man nie mehr in seinem Leben arbeiten muss, wenn man das, was man macht, gerne macht.

D.h. für sein Leben sollte man selbst die Verantwortung übernehmen – statt diese auf andere Menschen abzuwälzen.

Oder in anderen Worten: Wir können unser Gehirn aktiv für die eigene Lebensgestaltung nutzen

@KRichard

Das Problem mit/an dieser wettbewerbsbedingten Welt- und “Werteordnung” des imperialistisch-faschistischen Erbensystems:

Eine gänzlich-eigene Lebensgestaltung kann es gerade wegen der mit vernünftigem Bewusstsein auszufüllenden Verantwortung überhauptnicht geben, wohl auch deshalb wird diese in ignorant-arroganter Gewohnheit des “Individualbewusstseins” an die “Treuhänder” zur Konfusionierung delegiert und mit Bewusstseinsbetäubung zu materialistischer “Absicherung” in der leichtfertigen Annahme des Lebens von zufälliger Einmaligkeit kompensiert, egal wie offensichtlich heuchlerisch-verlogen das inzwischen globalisiert kommuniziert wird.

Mensch bedeutet ALLE – Wir sind alle im SELBEN Maße abhängig und prägend durchströmt von der Kraft/Energie des Geistes / des Zentralbewusstseins der/das Gott* und Gemeinschaft ist, für eine Sinnhaftigkeit zur Erhaltung, Erneuerung und vielleicht auch Expansion des HOLOGRAPHISCHEN Universums.

*Metapher für Vernunft die Mensch mittels Vernunftbegabung ebenbildlich gestalten soll (“wie im Himmel all so auf Erden”)

Übrigens, in meiner Kindheit gab es Prognosen von forschenden Wissenschaftlern, die den Menschen der Zukunft mit einem doppelt so großen und entsprechend hoher Stirn gewachsenes Gehirn sahen – Darüber findet man im Internet nichts, wohl weil es zu peinlich zum Archivieren war!? 👋😂

@KRichard (Zitat sinngemäss): Mache was du gerne machst anstatt zu arbeiten.

Antwort: Selbst dann müssen sie Steuerformulare ausfüllen und unzählig viele Dinge tun, die einfach getan werden müssen – ausser sie sind so reich, dass ihnen das Unangenehme jemand anders abnimmt.

Zum Buch von Nick Chater ´The mind is flat – The illusion of mental depth and the improvised mind´ ISBN 978-0-241 20877-9 gibt es ein Interview bei GEO, welches zu lesen sich lohnt.

Dann versteht man besser, dass Gehirnmodelle durchaus sinnvoll sind, aber die Versuche zum Nachbau des menschlichen Gehirn nicht:

http://www.geo.de/wissen/gesundheit/22098-rtkl-psychologie-es-gibt-keinen-hinweis-dass-ein-unterbewusstsein-existiert

“KI” beschäftigt sich momentan nach meinem Empfinden zu viel mit Sprache,

die ist undeutlich und wird oft selbst zwischen Menschen zum Problem..

Nicht das ich GPT nicht unterhaltsam finde, sowas macht mich immer wieder freudig (gerade der Bildermatsch) dann aber wieder traurig denn mir fehlt das zielgerichtete Verstehen/Entwickeln der Ki. Nicht den Menschen “ersetzen” zu wollen; anstatt einer Allgemeinen “Wolfsmilchsäugende” KI ein paar von Experten trainiert spezial Modelle um Reale Probleme zu lösen?:

Bin echt kein Experte, aber den vorteil der “KI”-modelle sehe ich darin, das diese große Mengen Daten verarbeiten können und dann diese Quasi wiedergeben können, sucht man einen Bestimmten Punkt in der “Daten-Landschaft” finden sie einen Hill-Climb weg dorthin.

Aber alles was ich bislang als “Leistung” dieser Modelle gesehen habe war Reproduktion von bekanntem Wissen, irgendwie lag die Antwort quasi schon im Datensatz und man war als Mensch nur überfordert diese rauszufiltern, bzw die Daten waren so groß, das die Response halt wie neu erschien.

Allerdings frage ich mich warum ich so wenig über echte “interpolation” dieser Modelle in den Unbekannten raum finde, dies müsste doch gehen falls KI wirklich etwas neues herausfinden soll.

Eigentlich doch Prima für Chemie (war dort immer mega schlecht):

Für Chemie muss man extrem viel Wissen sammeln und versteht (fast) nur durch Experimentelles ausprobieren, das es wirklich so funktioniert (abgleichen).

Wenn die KIs wirklich so überlegen sind, warum füttert niemand ein KI modell mit allen bekannten Molekülen und Reaktionsgleichungen und versucht dann damit eine Katalysator für H2O ->Xyz->H2 + Rest Sythetese zu finden?

Oder Thema Plastik, es gibt Bakterien die Enzyme (oder halt komplexe Moleküle) besitzen mit denen sie Plastik in ihre Grundbestandteile Cracken können, das ganze aber mega langsam. Warum finden wir nicht mithilfe KI ein Industriell herstellbares Molekül um ein Tauchbad zu erzeugen, das Plastik einfacher recyclen lässt??

Wenn ihr da interessante Links zu sowas habt, bitte posten.

@Techie: Es gibt Anwendungen von Deep Learning in der Biologie (Proteinfaltung mittels DeepMinds AlphaFold 2),

in der Chemie (DeepMinds Ferminet für Quantenphysik und Chemie, basierend auf einem prinzipiellen Ansatz, DeepMinds DM21 welches Orbitale in chemischen Ybindungen berechnet)

In Nuklearen Fusionsreaktoren Successfully controlling the nuclear fusion plasma in a tokamak with deep reinforcement learning und in der Mathematik mit DeepMinds Äusserungen dazu:

Fazit: DeepMind hat sich einen Namen damit geschaffen mittels DeepLearning Biologie, Chemie, Physik und Mathematik weiter zu bringen.

In der Öffentlichkeit ist wohl AlphaFold diesbezüglich am bekanntesten. AlphaFold berechnet die dreidimensionale Struktur von Proteinen besser und schneller als alle anderen Programme.

In etwa so scheint es zu sein :

Ansonsten kann sog. AI schon sehr hilfreich sein bei der Bearbeitung finanzmathematischer Fragestellung zum Beispiel.

Herr Dr. Jaromir Konecny erklärt hier gerne, er erklärt ebenfalls gerne, zu den Grenzen sog. AI.

‘Zielgerichtetheit’ liegt vor, sog. AI ist auch zu ‘trainieren’, irgendwelchen Belohnungsfunktionen auszusetzen, aber auch dem idR menschlichen Administrator, “AI” ist ein Tool.

GPT ist ebenfalls ein Tool, Dr. W will es einstweilen weghüsteln, sozusagen.

Mit freundlichen Grüßen

Dr. Webbaer

In Sympathie mit dem angeödeten Schiffs-Androiden im Film “Per Anhalter durch die Galaxis”:

“Ich habe mich so oft gefragt, ob nicht gerade die Tage, die wir gezwungen sind, müssig zu sein, diejenigen sind, die wir in tiefster Tätigkeit verbringen?

Ob nicht unser Handeln, selbst wenn es später kommt, nur der letzte Nachklang einer großen Bewegung ist, die in untätigen Tagen in uns geschieht?

Jedenfalls ist es sehr wichtig, mit Vertrauen müssig zu sein, mit Hingabe, womöglich mit Freude.” Rainer Maria Rilke

@KRichard

“… es gibt keinen Hinweis, dass ein Unterbewusstsein existiert.”

Dann ist also auch das holographische Universum nur ein Produkt der Sinnhaftigkeit in zufälliger Einmaligkeit – Die Berechnungen und die physikalischen Gesetzmäßigkeiten sind so falsch und/oder irregeleitet wie es eine Programmierung nicht geben kann???🤔

Wie auch immer, die stumpf-, blöd- und wahnsinnige Beharrlichkeit auf egozentrierte Armseligkeit ist zum 🤮

Sog. Grafikkarten bedeuten hier womöglich nicht die angewiesene Vorgehensweise, auch ist der ‘Stromverbrauch’ aus diesseitiger Sicht nicht relevant, es gibt im All sozusagen sehr viel Energie, die auch genutzt werden darf.

Guter Gag – ‘Alle Modelle sind falsch, aber manche sind nützlich.’ -, der Schreiber dieser Zeilen stimmt hier gerne zu, i.p. “AI” könnte es womöglich auch genügen das “Input-Output-Verhalten” erkennender Subjekte, das Hören, die Zurkenntnisnahme und die Sprache, ergo auch Aussagen, zu beforschen.

Hier musste Dr. Webbaer ein wenig schmunzeln – ‘Tatsächlich gucken wir in mehr als 70 % der Zeit, die wir auf Youtube verbringen, Videos an, die uns vorgeschlagen wurden.’, Dr. W ist so-o nicht im Web unterwegs.

Dr. W weiß natürlich, was hier gemeint ist – ‘What I cannot create, I do not understand.’ – mag aber auch die eher geisteswissenschaftliche Sicht, dass das, worüber nicht gesprochen werden kann, auch nicht verstanden sein kann.

Begnügt sich mit ihr.

Mit freundlichen Grüßen

Dr. Webbaer

@hto

Ich habe einen LINK angegeben, man hat also die Möglichkeit, sich zu informieren was im Interview gesagt wurde.

Aber das Ignorieren von vorhandenen Informationen scheint ein allgemeines Problem zu sein – auch in der Gehirnforschung (womit wir wieder beim Thema wären):

Es gab schon viele Isolationsexperimente, wo den Versuchspersonen die Wahrnehmung anderer Personen und/oder der eigenen Sinnesreize entzogen wurden. Dies führte z.B. zu Halluzinationen.

Damit stellt sich die Frage, welche Aussagen man mit dem Nachbau eines synthestischen Gehirns erwarten könnte – wo es keine externe Stimulation gibt.

Zu M.Holzherr

“Mit K1 Gefühle zu lesen….”

Ich denke dieses Prinzip wird beim Menschen krachend scheitern da wir ja im Prinzip alle Schauspieler sind wenn es um die Durchsetzung unserer persönlichen Vorteilsnahme geht. Die Gesellschaft verlangt von uns jeweils bestimmte Rollen zu spielen und da werden Gefühle “gespielt” , siehe Werbeindustrie/Politik/Medien etc. um

andere zu manipulieren und Fakes zu verbreiten . Das beherrscht selbst die Marktfrau die ihnen freundlich lächelnd zwei Bananen zum Sonderangebot anbietet . Roboter müssten also diese Lügenkonstrukte durchschauen können ,also das Ego der Personen ,ihre Motivationen, ihre Gier, ihre Bedürfnisbefriedigungen, ihre Selbstsucht . Im Kapitalismus scheint Geld hier ein wichtiger Faktor zu sein da man es zum Leben /Überleben benötigt. Auch ist es neben Eigentum /Besitz ein bestimmendes Prestigeobjekt. Gefühle sind also Mittel zum Zweck und wer auf dieser Klaviatur gut spielen kann, kann Ansehen und Macht erreichen.

Zu hto:

Unterbewusstsein existiert, sie sollten es mal in sich mit Gewahrsein betrachten. Es steckt in jeder Spannung ihres Körpers.

@Golzower

Ja-a, es wird auch Zentralbewusstsein genannt, man kann auch Seele dazu sagen (Seele die sich der “einzelne” Mensch nicht verdienen kann). 🙂

Gehirnmodell

Fangen wir mal ganz klein an. Alessandro Volta hat den bio -elektrischen Effekt entdeckt, als er einen Froschschenkel an eine Batterie anschloss. Der Froschschenkel zuckte zusammen, obwohl er kein Gehirn mehr hatte.

Also Strom und Muskel bilden eine Einheit, ob der Muskel jetzt tot war oder nicht, er war noch bioaktiv.

Jetzt zu unserem Gehirn. Ist das auch bioaktiv. Das heißt, ist es noch aktiv, auch wenn der Mensch tot ist ? Man spricht ja von Gehirntod und nimmt den als Marker für den Tod. Sollte mal geklärt werden.

Wenn man mal im Koma erlebt, bzw. danach erfahren hat was möglich ist, dann sollten die Maschinen zur Lebenserhaltung nicht so schnell abgestellt werden – Es ist eine Frage des Bewusstseins, wie sehr die Einheit von Körper und Geist im Leben der jeweiligen Person für die eine oder andere Seite fortgeschritten ist.

Es braucht da keine NTE oder AKE, der richtige Reiz von Aussen muss den besonders tief/unbewusst “Schlafenden” aus seinem “Traum”/Zustand holen können – Eine intensivere Art und Weise des Zusammenlebens OHNE … könnte unser Verständnis dafür sensibler machen! 👋😎

Einige Gehirnmodelle müssen neu überdacht werden:

Denn es konnte gezeigt werden, dass innerhalb(!) des verzweigten Dentriten Baumes von einzelnen Pyramidenzellen Informationsverarbeitung stattfindet und das Ergebnis zur nächst höheren Ebene weitergegeben wird.

DOI: 10.1126/science.abn1421 Dynamic compartemental computation in tuft dendrites of layer 5 neurons during motor behavior

http://www.sciencedaily.com/releases/2022/06/220609173627.htm

Learning and remembering movement

@KRichard (Zitat): „Einige Gehirnmodelle müssen neu überdacht werden:„

Antwort: Alle Gehirnmodelle müssen überdacht werden. Die Wissenschaft weiss sehr viel weniger übers Hirn, als die Öffentlichkeit meint.

Nur schon die „Artenvielfalt“ der Neuronen ist schwierig zu verstehen. Es gibt nämlich nicht nur die von ihnen erwähnten Pyramidenzellen, sondern einen ganzen Zoo verschiedener Nervenzellen und neben der Formenvielfalt (uni-,bi-,multipolar) gibt es auch funktionell unterschiedliche Neurone. Der Gründer des Human Brain Projects Henry Markam behauptete noch, er verstehe die Neuronenvielfalt und kenne die Funktionsweise einer Grosshirnsäule, also eines Grundmoduls des Neocortex. Niemand hat ihm damals, beim Start des HBP-Projekts, geglaubt und er hat inzwischen auch nicht bewiesen, dass er wirklich so viel weiss wie behauptet(e).

K. Richard

Betrifft “Pyramidenzellen” :

Wenn ich betrachte welche Gehirnareale diese Zellen verbinden so ziehe ich den Schluss dass diese Zellen in den Abläufe des Stammhirns, des Zwischenhirns und des Cortex intervenieren bzw. dort “Ergebnisse” zeigen. Dieser Zelltyp scheint also evolutionär mitgewachsen zu sein denn bereits Urtiere mit nur Stammhirn benötigten Zellstrukturen zur Reizbewertung (Siehe Eric Kandels Meeresschnecke) Der besonders große Anteil dieses Zelltyps in der Amygdala (Zwischenhirn) bestätigt meine Vermutung.

Eine richtige Informationsverarbeitung ist also nur in Verbindung mit allen Gehirnarealen möglich, siehe die Formatio reticularis aus dem Stammhirn.

@ KRichard 10.06.2022, 05:13 Uhr

Dass Prozesse auch innerhalb(!) des verzweigten Dentriten Baumes von einzelnen Pyramidenzellen einen gewissen unterschiedlichen (mehr oder weniger) bedeutsamen Einfluss auf die Informationsverarbeitung der Neuronen(verbände) nehmen ist naheliegend.

Besonders wenn die „Entscheidung“ knapp ausfällt, z.B. „50,01% zu 49,99%“ der triggernden Neuronen, kann ein winziger Unterschied der Ladungsträgerströme in Bereichen einzelner Dendriten bewirken, dass ein „entscheidendes Neuron“ triggert, oder eben nicht.

Allerdings bei so gut wie eindeutigen Entscheidungen, z.B. dass 1 plus 1 = 2 ergibt, wird man derartige „Nebenprozesse“ eher vernachlässigen können.

Ich finde es ganz naheliegend, dass man erforscht welche Einflüsse es gibt und wie stark sie sich auswirken. Z.B. wenn Erkrankungen ausgerechnet bei den dendritischen Verzweigungen ansetzen.

Derartige Phänomene sind zu erwarten, ob einige Gehirnmodelle deswegen neu überdacht werden müssen, ist eine andere Frage.

@ KRichard

Im Zusammenhang mit den von Ihnen im Rahmen von NTEs beobachteten „Zeitlupeneffekt“ stimme ich Ihnen zu.

Vor einigen Jahrzehnten war ich auf einer Dienstfahrt in einem PKW mit 2 Kollegen auf einer relativ engen Bundesstraße unterwegs.

Der Kollege überholte einen langen LKW Zug mit Anhänger obwohl Gegenverkehr kam. Der Kollege gab noch kurz Vollgas und wollte überholen, mir ist aber aufgefallen dass das „Loch bereits zu“ war und ich brüllte „halt“. Darauf hin „machte“ der Kollege eine „Notbremsung“, aber auch der Entgegenkommende und der LKW blieben gerade noch rechtzeitig stehen.

Bemerkenswert war der auftretende „Zeitlupeneffekt“ in meiner Wahrnehmung.

In einer anderen Situation lief ein kleines Kind aus einem Haus und direkt über eine Bundesstraße.

Der sehr reaktionsschnelle Lenker eines kleineren LKW machte eine extrem starke Notbremsung und kam ganz knapp vor dem hingefallenen Kind zum stehen. Obwohl das alles sehr schnell ging, empfand ich die Situation wie in „Zeitlupe“. In diesem Fall war ich persönlich gar nicht mit dem Tod bedroht.

Sogar die „Todesgefahr“ für einen anderen Menschen konnte den „Zeitlupeneffekt triggern“….

@Elektroniker

Das ist interessant, denn in einigen schnellen brenzligen Situationen hatte ich auch als Zuschauer nie den Zeitlupeneffekt, obwohl ich es danach gut gefunden hätte.

Erst wenn für mich sozusagen die “Würfel gefallen” waren, wurde ich Zuschauer vieler Details – Ich bin vielleicht kein besonders mitfühlender/empathischer Mensch, oder da ist eine Fähigkeit bei Dir, die schon aus/in Richtung Mutation deutet.

@Elektroniker

1) Der ´Zeitlupeneffekt´ wie er beim Sport wahrgenommen wird hat andere Gründe wie der ´Zeitlupeneffekt´, den man von Gefahrensituationen kennt.

Prof. Eagleman hat zu Erlebnissen unter schreckenserregenden Bedingungen ein Experiment gemacht, wo man Versuchspersonen im freien Fall 50 m tief in ein Netz fallen ließ

(Stetson, Fiesta, Eagleman “Does time really slow down during a freightening event?” PloS One, 2(12),e1295)

Er geht davon aus, dass in gefährlichen Situationen die Amygdala hyperaktiv wird, was dann dazu führt dass das Gehirn viel mehr Einzelerlebnisse im Gedächtnis abspeichert, als dies normalerweise üblich ist.

Wenn wir uns dann später an so ein Erlebnis erinnern, stehen viel mehr Einzel-Details zur Verfügung (als üblicherweise), so dass beim Erinnern der falsche Eindruck entsteht, dass das Ereignis in Zeitlupe abläuft

(Quelle: David Eagleman; The Brain – Die Geschichte von dir, ISBN; 978-3-570-55288-9)

2) Dass bereits in den verzweigten Dendriten-Strukturen mehrstufig Informationen verarbeitet werden – bedeutet dass deutlich mehr Arbeitsschritte vom Gehirn ausgeführt werden, als bisher bekannt

Aber grundsätzlich gilt cool bleiben und alles abstreiten, falls aufgrund des hier beschriebenen … doch noch die “Virginia Farmboys” aufkreuzen und Fragen stellen 😚 🎶

👋😎👍 😏🐐🤭

Zu KRichard

Ihren erwähnten Professor sollte man den Professorentitel wieder entziehen denn das ist ja erstens Menschenquälerei und zweitens ein Zeichen von hochdotierter Inkompetenz

denn wenn der Herr das vorher nicht gewusst hat dann ist das blamabel für die Zunft . Eine hyperaktive Amygdala reagiert bei gefährlichen Situationen, so wie sie programmiert ist, stets mit dem Ausstoß von Adrenalin bzw. Noradrenalin weil es sich um ein starkes Angstgefühl handelt. Da werden die von ihnen erwähnten “Einzelerlebnisse” nicht abgespeichert sondern mit Angst zugeschüttet. Solange diese Ängste bestehen werden sie dieses Problem nicht aufarbeiten können. Wie wird man heute eigentlich Professor in der Psychologie ?

Golzower, wenn sie die Quelle von KRichard gelesen hätten, wüßten sie, daß der sie falsch interpretiert hat. Dort wird nämlich gesagt, dass es eben nicht zu einer erhöhten Zeitauflösung kommt, aus der sich viele Bilder ergeben hätten, sondern nur zu einer diesbezüglichen Illusion.

@Golzower

Ein Ziel des Fallexperiments von Prof. Eagleman war es, zu testen ob die Zeit tatsächlich langsamer vergeht – oder eben nicht (Weil die ´Zeitdehnung´ eine andere Ursache hat).

Die Teilnahme am Experiment war freiwillig!

Die Versuchspersonen bekamen ein Gerät mit blinkenden LEDs – wo man eine Anzeige nur dann erkennen/ablesen konnte, wenn die Zeit tatsächlich langsamer vergangen wäre

Prof. Eagleman hat seriös gearbeitet, so wie man es von einem Wissenschaftler erwarten kann.

off topic

Zum Thema ´ZEIT´ noch eine Anmerkung: In der Physik wird wie wild mit dem Parameter ´t´ gerechnet, obwohl es bisher noch gar keine Definition für ´t´(Zeit) gibt (z.B. bei der 4D-Raumzeit, Relativitätstheorie). Mit Zahlen/Werten zu rechnen, deren Bedeutung überhaupt nicht definiert ist – ist eine Blamage

Zu Manfred :

Unser Gehirn lebt von und mit Illusionen. Es konstruiert ständig-jede Sekunde- neue Vorstellungen und Gefühle. Und wenn es in vermeintliche eingebildete oder wahre Gefahren kommt dann schüttet dieses System , je nach Prägung, Stresshormone aus, also nach der Bewertung durch das limbische System. Ein Professor sollte das wissen .Dieses evolutonär ältere System übernimmt dann zeitweilig die “Herrschaft” über den langsameren Verstand und Denken . Ich kenne diesen Zeitlupenfaktor und würde ihn evolutionär sehen und auch Tieren zusprechen denn es ist meiner Ansicht nach eine Hyperfokussierung im Angesicht einer Gefahr .Das Gehirn bzw. die entsprechenden Hormone aktivieren einen vom Verstand unabhängigen Modus der eine Zeitdehnung suggeriert damit das Unterbewusstsein “rettende” Entscheidungen treffen kann.

Im Tierreich sinnvoll.

Golzower, das war doch gar nicht das Thema der Studie. Lesen Sie doch, um was es dort gehen sollte und was das Ergebnis ist. Sie können der Studie doch nicht den Vorwurf machen, dass Sie gerne etwas anderes untersucht hätten.

Zu Manfred

Pardon, aber ich kann ihren genannten Professor nicht wirklich ernst nehmen wenn er u.a. meint das Gehirn bestehe aus außerirdischem Computermaterial.

Diese Studie sind rein subjektive Erfahrungen mehr nicht. Suchen sie die wissenschaftliche Sicht dahinter die ich in meinen Anmerkungen versucht habe zu beschreiben. Das Gehirn produziert auch Rauschzustände ,bedingt durch Botenstoffe die “Zeitdehnungen” verursachen. Manche sehen dann auch außerirdisches Computermaterial …

Golzower, ich glaube, Sie haben einen anderen Artikel gelesen. Ich finde kein “außerirdisches Computermaterial”.

Zitat aus obigem Beitrag:

Sogenannte Spiking Neural Networks [abgekürzt SNNs] dominieren heute das Neuromorphic Engineering. Doch bis heute ist die Qualität der Ergebnisse bei Spiking Neural Networks nicht so gut wie die von Artificial Neuronal Networks [abgekürzt ANNs].

Der Artikel Making a Spiking Net Work: Robust brain-like unsupervised machine learning zeigt, was gemacht werden muss um SNNs einer ähnlichen Qualität wie ANNs zu erhalten:

In der Kurzzusammenfassung liest sich der von den Autoren behauptete Durchbruch bei der Verwendung von SNNs so:

Fazit:Neuromorphes Computing mit SNNs ist erst in den Startlöchern. Heutige SNN-Chips haben auch noch zu wenig Neurone um wirklich interessant zu sein.