SPARC – ein Zündfunke für die Fusionsforschung?

BLOG: Formbar

Letzte Woche sorgte ein Artikel in der New York Times für einige Aufregung in den sozialen Medien (zugegebenermaßen, beschränkt auf den Teil der sozialen Medien, in dem Wissenschaft diskutiert wird, z.B. hier oder hier). Allein die Kommentarspalte der New York Times bringt es bisher auf über 400 Einträge.

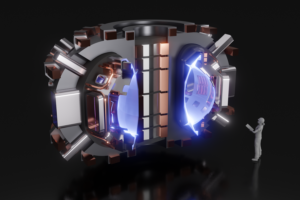

Im Kern ging es um eine neue, kompakte Variante eines Kernfusionsreaktors, Projektname SPARC, der schneller und günstiger als ITER zu fertigen sein, aber trotzdem ähnliche Performance liefern soll. Handelt es sich hier um eine weitere, eher leere weil nicht auf validen wissenschaftlichen Studien fußende Behauptung, wie zum Beispiel vor ein paar Jahren von Lockheed Martin gemacht, oder ist dieses mal vielleicht doch mehr dran? Dieser Artikel versucht sich in einer kurzen Beantwortung.

Um es gleich vorwegzunehmen: es ist ein vielversprechendes Projekt. Aber der Reihe nach. Zeitlich passend erschienen letzte Woche ebenfalls eine Reihe wissenschaftlicher Artikel (frei zugänglich) in einer renommierten Fachzeitschrift. In diesen Artikeln werden die physikalischen Grundlagen auf denen das SPARC Projekt beruht, diskutiert und erläutert. Das eingangs genannte Projekt von Lockheed Martin hat sich im Gegensatz dazu nur auf ein paar alte Artikel und ein wenig spezifisches Patent berufen. Wirklich nachvollziehbar und damit auch nachprüfbar ist der Ansatz so nicht. Ganz anderes also das SPARC Projekt, was in einer Kooperation von MIT und der Ausgründung Commonwealth Fusion Systems (CFS) entstanden ist.

Was ist, außer der ordentlichen wissenschaftlichen Vorgehensweise, nun so anders bei SPARC, dass es für soviel Aufregung sorgt? SPARC ist nicht der einzige oder gar erste Ansatz von privat-finanzierten Unternehmen sich an die Realisierung eines Fusionsreaktors zu machen. Aktuell forschen knapp 30 Firmen weltweit an verschiedenen Konzepten, hier eine Liste und hier noch eine.

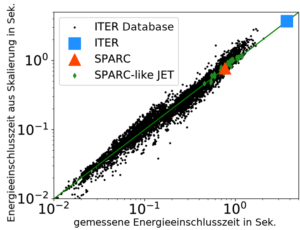

Mehrere dieser Unternehmen publizieren ihre Forschungsergebnisse und Ansätze ebenfalls in Fachzeitschriften. Allerdings basieren die Konzepte zum Teil auf mutigen Extrapolationen oder das Vordringen in relativ unbekannte physikalische Regionen. Einige der Ideen benötigen vergleichsweise wenig Kapital zur Realisierung, so dass es für Investoren lohnenswert ist, dort einzusteigen. Physikalisch interessant sind sie fast alle, so dass ich hoffe, dass ihre Anzahl in Zukunft eher steigen als fallen wird. Aber zurück zu SPARC: dessen Konzept basiert auf denselben Skalierungen und physikalischen Prinzipien wie ITER, hat also eine sehr solide Datenbasis. Der einzige Unterschied ist ein deutlich höheres Magnetfeld.

Um zu verstehen, warum ein höheres Magnetfeld von Vorteil ist, hole ich etwas weiter aus. Damit Kernfusion stattfindet, müssen sich die positiv geladenen Atomkerne sehr nahe kommen – ihr Abstand muss in der Größenordnung des Kernradius selber liegen. Atomkerne sind allerdings positiv geladen, also stoßen sie sich ab. Die den Kern zusammenhaltende Kraft, die starke Kernkraft, wirkt eben erst bei sehr kurzen Distanzen. Um diese Abstoßung zu überwinden, brauchen die Kerne eine sehr hohe Geschwindigkeit, also eine sehr hohe Energie. Die entsprechende Temperatur liegt bei über 100 Mio Grad. Materie geht hier in den Plasmazustand über. Plasmen bestehen aus geladenen Teilchen, was insofern von Vorteil ist, als dass man so eine Möglichkeit hat ein Plasma einzuschließen: normale Wandmaterialien halten keinen 100 Mio Grad stand, aber die geladenen Teilchen eines Plasmas können mit einem Magnetfeldkäfig eingesperrt werden.

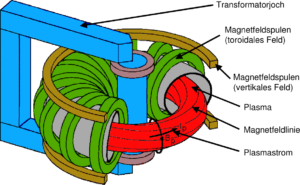

Zwei verschiedene Varianten eines solchen Magnetfeldkäfigs werden momentan an verschiedenen Forschungsstandorten auf der Welt untersucht: der Tokamak und der Stellarator. Ersterer erzeugt ein Teil des einschließenden Magnetfeldes durch einen im Plasma fließenden Strom. Dieser wird mittels des Transformator-Effekts induziert: in einer Primärwicklung wird eine Spannung hochgefahren, das Plasma stellt die Sekundärwicklung dar in welcher so eine Spannung induziert wird was dann einen Stromfluss zur Folge hat. Nachteil ist die (im Prinzip) inhärent gepulste Betriebsweise (nur wenn sich eine Spannung in der Primärwicklung ändert, kann eine Spannung in der Sekundärwicklung induziert werden), Vorteil ist die vergleichsweise unkomplizierte Konstruktion.

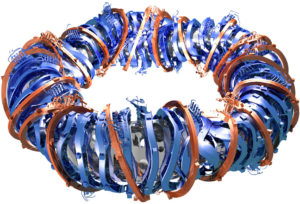

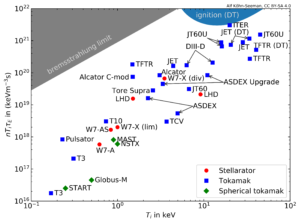

Im Stellarator hingegen wird das Magnetfeld komplett aus externen Spulen erzeugt, was den Vorteil hat, dass er für den Dauerbetrieb geeignet ist. Der Nachteil ist die deutliche komplexere Form der Magnetfeldspulen. Deswegen ist der Stellarator auch eine Generation hinter dem Tokamak zurück. Gemessen wird der Fortschritt in der Fusionsforschung oft mit dem Tripelprodukt: es ist das Produkt aus Plasmadichte, Plasmatemperatur und Energieeinschlusszeit (was ein Maß für die Wärmeisolation ist). Um ein sogenanntes brennendes Fusionsplasma zu erreichen, ein Plasma also bei dem die zur Aufrechterhaltung der Fusion notwendige Heizleistung zu überwiegendem Anteil aus der Fusionsreaktion selbst stammt, muss das Tripelprodukt einen bestimmten Wert überschreiten. In der Abbildung sieht man das Tripelprodukt aufgeschlüsselt nach Experimenttyp und es ist offensichtlich, dass der Tokamak hier führt.

Bei einem Produkt aus drei Größen hat man prinzipiell drei Möglichkeiten selbiges möglichst groß zu machen, allerdings sind Plasmadichte und -temperatur aus Stabilitätsgründen Grenzen gesetzt und diese hatte man bereits in den 1980 Jahren erreicht. Bleibt also nur die Energieeinschlusszeit. Diese macht bei der ITER einen wesentlichen Sprung gegenüber allen bisherigen Tokamaks. ITER ist ein momentan in Bau befindlicher Tokamak (in Südfrankreich), der das erste Mal mehr Energie freisetzen wird, als zur Aufheizung des Plasmas nötig war. Die Größe von ITER ist im wesentlich durch empirische Skalierungsgesetze definiert worden: so hat man ein für alle bisher betriebenen Tokamaks gültige Skalierung der Energieeinschlusszeit aufgestellt. Diese besagt dass man vor allem das Plasmavolumen und das Magnetfeld erhöhen sollte.

Beim Design für ITER hat man die maximal mögliche Magnetfeldstärke gewählt, welche der damals übliche Supraleiter, Nb3Sn, erreichen konnte. Überschreitet die Magnetfeldstärke nämlich einen kritischen Wert, so bricht die Supraleitung zusammen. Bliebt noch das Plasmavolumen, was man gerade so groß gewählt hat, damit ITER einen Q-Wert von 10 erreichen kann (Q ist dabei das Verhältnis von Fusionsleistung zu externer Heizleistung). Die ITER zugrunde liegenden Skalierungen sind allesamt aus einer breiten Basis an Experimenten erwachsen und werden mittlerweile auch von Simulationen & Modellierungen unterstützt. Insgesamt kann man sagen, dass ITER auf relativ konservativen Annahmen beruht und dessen Gelingen auch relativ wahrscheinlich ist. 2025 soll das erste Plasma gezündet werden, 2035 werden die ersten Experimente gefahren, bei denen dann der Q-Wert deutlich größer als 1 sein soll.

Parallel zu dem konventionellen Pfad, der zu ITER führt, liefen an einigen wenigen Standorten auf der Welt Untersuchungen und Modellierungen zu einem Tokamak mit deutlich höherem Magnetfeld. Obwohl klar war, dass die momentanen Supraleiter keine höheren Felder verkraften, war es doch zu aussichtsreich nicht die sogenannte Hochfeld-Linie der Tokamaks zu verfolgen – eben weil ein höheres Magnetfeld ein kleineres Plasmavolumen bei gleicher Energieeinschlusszeit ermöglicht. Und kleinere Plasmavolumina bedeuten geringere Kosten. Zusätzlich skaliert die Fusionsleistung stark mit der Magnetfeldstärke. Das MIT war einer dieser Orte mit ihrem 2016 stillgelegten Hochfeld-Tokamak Alcator C-Mod. Vor einigen Jahren wurde dort das ARC Konzept entwickelt, ein Demonstrator für ein Fusionskraftwerk basierend auf einem Hochfeld-Tokamak. Motiviert wurde diese Studie durch neue Fertigungsmöglichkeit von ReBCO (Rare-Earth Barium-Copper-Oxide) Supraleitern. Diese können bei wesentlich höheren Feldstärken als herkömmliche Supraleiter betrieben werden.

Als Zwischenschritt zu ARC existiert das SPARC-Projekt bereits seit einigen Jahren und hat auch mehrere Iterationen durchlaufen. In den jetzt erschienenen Artikeln haben die Kollegen vom MIT und von CFS ihr vorläufig finales Design vorgestellt und begründet wieso es so aussieht, wie es aussieht. Das ermöglicht nun eine gründliche Überprüfung durch die wissenschaftliche Gemeinschaft und eine Vorstellung der Artikel durch ihre Autoren per Videokonferenz Ende letzter Woche hatte mit über 400 Teilnehmern aus aller Welt regen Zulauf (die anschließende Frage- & Antwortrunde dauerte jeweils nochmal so lange wie die Vorträge selber). Das Interesse ist also groß und die Überprüfung durch die Gemeinschaft wird entsprechend gründlich sein.

Da SPARC immer noch ein konventioneller Tokamak ist und auf denselben Skalierungen wie ITER beruht, gibt es in dieser Hinsicht keine großen Extrapolationen. Die Verwendung der neuartigen Supraleiter erlaubt allerdings eine wesentlich höhere Magnetfeldstärke im Plasmazentrum von 12,2 Tesla gegenüber 5,3 Tesla bei ITER. Damit kann auch der Plasmastrom und der Plasmadruck bei höheren Werten betrieben werden, bevor das Plasma instabil wird. Zudem wird SPARC deutlich kleiner sein als ITER, der große Radius des Torus beträgt nur 1,85 m gegenüber 6,2 m bei ITER und der kleine Radius 0,57 m gegenüber 2,0 m.

SPARC wird, genau wie ITER, mit Deuterium und Tritium betrieben werden: die Deuterium-Tritium Fusion ist diejenige Reaktion, welche auch in einem potentiellen Kraftwerk basierend auf Tokamak oder Stellarator ablaufen wird. Mit einer geplanten Fusionsleistung von 50 MW – 140 MW (der erste Wert ist eine sehr zurückhaltende Schätzung, der zweite eine ITER-ähnliche Schätzung) würde SPARC hier neue Maßstäbe setzen, der bisherige Rekord liegt bei 16 MW (1997 von dem JET Tokamak aufgestellt). In der Deuterium-Tritium Fusion entsteht ein Helium-Kern (ein Alpha-Teilchen) und ein Neutron. Das Alpha-Teilchen ist geladen und wird somit auch vom Magnetfeldkäfig eingeschlossen. Tatsächlich ist es sogar essentiell für ein potentielles Kraftwerk, da es zur weiteren Aufheizung des Plasmas beitragen wird. SPARC würde erstmals ein Plasma mit einer signifikanten Fusionsleistung erzeugen, das ist aus physikalischer Sicht sehr spannend, da so etwas im Labor noch nicht umgesetzt wurde (und man so endlich die verschiedenen numerischen Simulationen mit Experimenten vergleichen kann). Damit würde SPARC für das weltweite Fusionsforschungsprogramm wertvolle Beiträge liefern. Q-Werte von 2-10 sind für SPARC als Ziel ausgegeben (bisheriger Rekord liegt bei 0,67 ebenfalls in JET erzeugt).

Im Gegensatz zu ITER wird es bei SPARC nur ein externes Heizsystem geben, entsprechend viel Überlegung ist in die Auslegung dieses Systems sowie in umfangreiche Simulationen gesteckt worden. SPARC wird für eine maximal 10 Sekunden dauernde Entladung ausgelegt sein, bei ITER sind es 30 min. Der Zeitplan von SPARC sieht vor, dass das Design 2021 abgeschlossen ist (eine offene Frage ist beispielsweise noch welches Wandmaterial verwendet wird). Weiterhin soll bis 2021 eine der großen Toroidalfeldspulen basierend auf dem ReBCO – Supraleitern gefertigt worden sein. Als wichtigen Zwischenschritt hat man den Supraleiter erfolgreich bei den hohen Magnetfeldstärken betreiben können.

Der Aufbau von SPARC soll 2021 beginnen und es ist bisher auch genügend Kapital für den Start der Konstruktion vorhanden. Bis 2025 soll SPARC aufgebaut sein und damit im selben Jahr wie ITER in Betrieb gehen. Im Gegensatz zu ITER soll SPARC allerdings von Anfang an auf volle Leistung ausgelegt sein, wobei man auch bei SPARC zunächst mit vorsichtigem Betrieb beginnen wird. Der genaue Zeitplan für den Betrieb wird noch zusammengebastelt, laut der Autoren der Artikel könnte man Ende 2026 mit vollem Deuterium-Tritium Experimenten rechnen. Das wäre dann deutlich vor ITER, wo selbiges 2035 geplant ist.

Der Zeitplan für SPARC ist meiner Meinung nach sehr ehrgeizig und die Kollegen sind sich dessen auch bewusst, gehen aber optimistisch an die ganze Sache ran. Ein befreundeter Kollege hat mir einmal gesagt, dass Zeitangaben von Wissenschaftlern grundsätzlich mit dem Faktor pi zu multiplizieren sind, wenn es sehr gute Wissenschaftler sind, dann vielleicht pi/2. Aber Ausnahmen bestätigen ja bekanntermaßen die Regel.

Im Gegensatz zu ITER gibt es bei SPARC relativ wenig Kontrollsysteme um eventuell auftretende Instabilitäten des Plasmas zu unterdrücken. Durch das hohe Magnetfeld wird SPARC allerdings auch weiter weg von einigen Stabilitätsgrenzen betrieben. Die Alpha-Teilchen könnten jedoch wiederum für zusätzliche Instabilitäten sorgen, hier wird erst der Experimentierbetrieb Erleuchtung bringen.

Die kurze Antwort der anfangs gestellten Frage ist jetzt doch etwas länger geworden, also fassen wir noch einmal kurz zusammen. SPARC ist ein neues Konzept für ein Fusionsexperiment, das erstmals mehr Energie freisetzen soll, als für die Aufheizung des Plasma nötig war. Im Gegensatz zu ITER werden Supraleiter verwendet, die bei wesentlich höherer Feldstärke betrieben werden können, was eine deutlich kompaktere Bauweise erlaubt. Damit ist SPARC schneller und günstiger zu bauen. SPARC basiert auf derselben breiten physikalischen Basis wie ITER, stellt also immer noch einen konventionellen Tokamak dar. Kritisch ist bei SPARC sicherlich die Fertigung der Supraleiter: zum einen muss gezeigt werden, dass man damit die großen Toroidalfeldspulen bauen kann (da wird es eine gewisse Lernkurve geben) und das diese dann auch so konstruiert sind, dass sie den enormen Kräften im Magnetfeld standhalten. Zudem ist der Zeitplan sehr ambitioniert.

In jedem Falle ein spannender Ansatz, bei dem die Fusionsforschung von einer Entwicklung außerhalb des eigenen Feldes profitieren könnte. Davon werden wir in nächster Zeit sicherlich noch einiges hören. Interessant wird es, wenn die erfolgreiche Fertigung der großen Spulen demonstriert wurde (soll 2021 passieren) – das könnte zu einer ganzen Reihe von weiteren Fusionsexperimenten führen. Es bleibt also spannend!

Update (12.10.2020): Mittlerweile wurde der wissenschaftliche Aufsatz zu dem HTS-Kabel, was erfolgreich in einem hohen Magnetfeld betrieben wurde, publiziert: https://doi.org/10.1088/1361-6668/abb8c0 (als nächstes muss nun die Fertigung einer Prototyp-Spule gezeigt werden).

Ja, sowohl SPARC wie auch ITER sind Forschungsreaktoren und damit Vorläufer möglicher zukünftiger kommerzieller Reaktoren.

ITER wird 2025 den Betrieb mit einem Wasserstoffplasma aufnehmen und erst 2035 Deuterium/Tritium-Gemische verwenden wie sie für die Energieerzeugung nötig sind. ITERs Nachfolger DEMO soll dann ab 2050 Elektrizität erzeugen.

SPARC wird ebenfalls 2025 in Betrieb gehen und schon bald nach Betriebsbeginn mit Deuterium/Tritium arbeiten und damit Fusionsenergie in Form von Wärme erzeugen. SPARCs Nachfolger ARC soll dann ab 2035 Strom erzeugen.

SPARC/ARC ist also ein FastTrack – Weg (lateinisch ITER) zur Deuterium/Tritium Fusion in einem dank hohen magnetischen Feldern sehr kompakten Tokamak. Dies kann aus sehr vielen Gründen misslingen – unter anderem wegen Materialproblemen (hohe Materialbelastung durch grosse Magnetfelder und grosse Neutronenflüsse), der inhärenten Schwierigkeit einen Dauerbetrieb zu unterhalten und dem möglichen Entweichen von radioaktivem Tritium aus dem Reaktor.

Gelingt, basierend auf SPARC aber die Entwicklung eines kommerziellen ARC- Reaktors (AffordableRobustCompact), wöre viel gewonnen, ist doch ARC nur halb so gross wie DEMO (dem Nachfolger von ITER) und hätte weniger als ein Achtel seines Volumens.

Dieser Vorteil von hohen Magnetfeldern für den Einschluss des Fusionsplasmas ist wohl auch der Grund dafür, dass auch andere Projekte versuchen mit hohen Magnetfeldern zu arbeiten. Darunter vor allem der sphärische Tokamak, der im britischen Versuch ST40 verfolgt wird (Zitat):

Prognose: Wenn Fusion je kommerziell eingesetzt wird, dann in kompakten Reaktoren, die in ein 20x20x20 Meter grosses Gebäude passen.

In der Tat basiert auch die Grundidee von Tokamak Energy und ihrem spherical tokamak auf der Verwendung dieser Supraleiter, die höhere Magnetfeldstärken erlauben. Allerdings ist der spherical tokamak doch ein wenig anders als der Tokamak, da deutlich kompakter. So ist zum Beispiel viel weniger (bis zu überhaupt kein) Platz für die innere Transformatorspule, so dass man das Plasma anderweitig zünden muss (was in kleinem Maßstab auch schon alles funktioniert). Die nochmal deutlich kompaktere Bauweise erlaubt auch noch weniger Platz für Neutronenschilde. Trotzdem ist auch der spherical tokamak immer noch ein Tokamak, so dass viele der Skalierungsgesetze auf denen ITER beruht auch hier anwendbar sind. Ich bin gespannt, was Tokamak Energy in naher Zukunft für experimentelle Resultate vorzeigen wird!

Habe selbst am Stellarator-Konzept an der mechanischen Auslegung mitgearbeitet. Die Magnetkräfte sind schon sehr hoch und stoßen an die Grenzen der Möglichkeit, sie zu beherrschen. Das ist beim Tokamak etwas einfacher, aber auch nicht ganz trivial, da die Spulenform eine momentenfreie Auflagerung zumindest erleichtert.

Ob man bei der kompakten Bauweise allerdings noch genügend Platz/Fläche hat, um die entstehende Wärme zwischen dem Spulenkäfig nach außen zu transportieren, wird sicherlich eine der Herausforderungen.

Auch die Wärmestrom- und Neutronenflußdichte, die auf die Plasmagefäßwände einwirkt, dürften bei dem kompakten Design nochmals größer sein als bei Iter.

Die Lebensdauer dieser Wände ist m.W. Ein noch nicht gelöstes Problem.

Aber durch die Arbeit an solchen Konzepten können die genannten Schwierigkeiten Schritt für Schritt erst verstanden und dann hoffentlich entschärft oder gelöst werden. Ich hoffe, daß sich die thermonukleare Zeitkonstante von ca. 30 Jahren endlich mal verringert. (Seit mehr als 50 Jahren versprechen die Forscher, daß der kommerzielle Einsatz in 30Jahren ab jetzt möglich sein werde…)

…you really believe in »earth based “Kernfusion”«?

…dream on…

Die ungeregelte Fusion innerhalb eines Sterns, basiert u.a. auf Gravitation, ohne das hier näher auszuführen.

Selbst wenn es zu einer Reaktorfusion kommt, bestehen zwei wesentliche Probleme. Erstens, das Aufrechterhalten eines geregelten, steuerbaren Prozesses und zweitens, die Abfuhr der Energie ohne den Erhalt des Magnetfeldes (lokal) zu (zer)stören…

Die Abfuhr der Energie ist tatsächlich kein Problem: die in der Fusionsreaktion entstehenden Neutronen tragen keine Ladung und werden daher auch nicht vom Magnetfeld eingeschlossen, sondern fliegen einfach auf die Wand. Diese wird heiß und die Wärme über Kühlmittel abgeführt, was dann im Endeffekt einfach eine Turbine antreibt um Strom zu erzeugen.

Das Aufrechterhalten der Fusion ist dagegen genau das, was man mit ITER oder auch SPARC lernen will. Zahlreiche numerische Studien zeigen auf, wie es gehen müsste, aber natürlich muss man das im Experiment verifizieren. Und ITER (und SPARC) ist immer noch ein physikalisches Experiment, so dass man entsprechend herum probieren (und auch diagnostizieren) kann, sollte tatsächlich etwas nicht so funktionieren, wie wir uns das gedacht haben.

Von daher bin ich fest von der “Earth based” Kernfusion überzeugt, ja 🙂

Herr Köhn–Seemann, der Vollständigkeit halber respektive zum Verständnis,

ich beziehe mich bei meiner Aussage nicht auf die (Zer-)Störung des Magnetfeldes durch hochenergetische Ladungsträger. Das Problem ist „sekundär“. Die Apparatur setzt eine kontinuierliche, homogene Magnetfeldanordnung voraus. Sobald die hochenergetischen Neutronen Energie abgeben, wird die technische »Basis der Energieaufnahme«, die stark gekühlt wird, Sie nennen das vereinfacht Wand, nun stark erhitzt. Bereits kleinste (thermische) Störungen führen zur Anisotropie des Magnetfeldes. Die früher oder später auftretenden Materialschäden sind immens. Die „Magnetfeldspulen“ beispielsweise werden in einem zeitlich sehr langen Prozess hergestellt und sind äußerst teuer. Diese werden, schlicht formuliert, lokal zu unbrauchbaren Metallklumpen verschmolzen, dann bricht das Magnetfeld komplett ein… das “Fusions-Energiewerk” ist anders als beabsichtigt vollbracht und steht in der Folge sehr lange still…

Sie haben dabei übersehen, dass die Supraleitenden Magnetfeldspulen nicht direkt dem Wärmefluss ausgesetzt sind, da ist eben noch eine Wand dazwischen. In dieser Wand befinden sich die sogenannten Blankets, welche die Wärme abführen – bei ITER werden die Blankets zum Beispiel in der Lage sein, etwas mehr als 700 MW thermische Ĺeistung abzuführen. Diese Blankets müssten in einem gedachten Fusionskraftwerk regelmäßig ausgetauscht werden, da sie durch den andauernden Neutronenfluss im Laufe der Zeit einfach “schlecht” werden (ich würde nicht so weit gehen, sie als “unbrauchbaren Metallklumpen” zu bezeichnen, aber sie müssen eben ausgetauscht werden). In JET, dem größte Tokamak der Welt, trainiert man das schon seit vielen Jahren (mittels remote handling).

Relevanter wird Ihr Kritikpunkt bei dem hier vorgestellten SPARC-Projekt, weil dieses kompakter ist und man damit auch etwas weniger Platz für diese Schilde hat. Aktuellen Designs zufolge (und den zugrunde liegenden Rechnungen) sollte das für SPARC selber kein Problem sein, bei einem weitergedachten Kraftwerk (ARC), wird das vermutlich eine Herausforderung darstellen.

Zitat:

Gemäss ARC: A compact, high-field, fusion nuclear science facility and demonstration power plant with demountable magnets

besitzt ARC aber ein flüssiges Blanket. Gegenüber ITER ist das eine Verbesserung, denn eine Materialverschlechterung gibt es in einer kontrollierten Blanketflüssigkeit keine und ein Austausch in regelmässigen Zeitabständen ist nicht nötig, kann die Blanketflüssigkeit doch ständig in ihrer Zusammensetzung kontrolliert werden. Hier noch die Aussagen zum Blanket, die man in der Zusammenfassung des von mir zitierten arxiv-Artikel findet:

Persönliche Einschätzung: ARC beziehungsweise ein kommerzieller Nachfolger von ARC könnte noch vor 2050 kommerziell „gehen“. Ähnliches gilt für den sphärischen Tokamak von Tokamak Energy bei dem die Entwickler selber das Jahr 2040 vorgeben. Aber kommerzielle nukleare Fusion wird es dennoch nur unter den denkbar günstigsten Umständen noch vor 2050 geben, denn von der Forschung zum kommerziellen Einsatz kann es ein weiter Weg (lateinisch ITER) sein.

Um sich argumentativ dem Thema nähern zu können, sollte man sich mit den Aspekten der Reaktorfusion mittels magnetischen Einschlusses, dem vermeintlichen Urprinzip, „unsere Sonne als Fusions-Vorbild“ und beispielsweise der Technik einer Wasserstoffbombe detailliert beschäftigt haben.

Seit den 1960er Jahren gilt »Kernfusion ist immer 30 Jahre entfernt« (nuclear fusion is always 30 years away). Bedeutet, die theoretische Modellphysik liefert(e) keine nennenswerten Impulse für praktische Anwendungen. Und mit jeder vermeintlichen technischen Weiterentwicklung wurden neue technische Probleme ans Tageslicht befördert. Ausführungen dazu sprengen den Rahmen eines Kommentarfeldes bei Weitem.

Exemplarisch Daniel Jasbby ein Physiker, der 25 Jahre lang an Kernfusionsexperimenten im Princeton Plasma Physics Lab in New Jersey gearbeitet hat und in den Bereichen Plasmaphysik und Neutronenproduktion im Zusammenhang mit der Forschung und Entwicklung im Bereich der Fusionsenergie arbeitete, erörtert die wesentlichen Probleme exemplarisch in den folgend aufgeführten Artikeln, die zur Orientierung auch weitere lesenswerte Quellen beinhalten.

ITER is a showcase … for the drawbacks of fusion energy [2018]

Voodoo Fusion Energy [2019]

Am Rande bemerkt

Plakativ formuliert: Wie zu vielen fundamentalen Fragen, ob Theoretische oder Experimental-Physik, melden sich die professionellen erfahrenen Kritiker erst “richtig” zu Wort, wenn ihre wissenschaftliche Karriere nicht mehr gefährdet ist.

Um Wissenschaft und Technik selbst nachvollziehen zu können respektive verstehen zu können, bedarf es mehr als rezitieren zu können. Und Englisch lesen zu können, ist, als interessierter Artikel und Kommentarleser, ein Muß.

Die Sonne taugt nicht wirklich als Fusions-Vorbild, vielleicht als Motivation, da der in ihr ablaufende Fusionsprozess, die pp-Kette, viel zu ineffizient ist. Auch ist mir die Analogie zur Wasserstoffbombe nicht klar.

In der Tat ist es so, dass seit 1958 die Fusion nur 25-30 Jahre entfernt ist. Die Fusionskonstante, wie sie ja oft scherzhaft genannt wird, hat mehrere Ursprünge. Zum einen hat in dem genannten Jahr (1958) eine internationale Konferenz zu dem Thema stattgefunden (Atoms for Peace in Genf), bei welcher der Tagungsleiter die Nachricht an die Öffentlichkeit verbreitet hat, dass Fusionskraftwerke ca. 25 Jahre entfernt seien. Viele renommierte Kollegen, allen voran einer der Väter des Tokamaks, fand das schon damals unglücklich und hatte eher mit dem Anfang des nächsten (also diesen) Jahrhunderts gerechnet.

Zudem hat die Bevölkerung miterlebt, wie es von der Kernspaltungsbombe zum Vorführkraftwerk nur ca. 10 Jahre gedauert hat, daher erwartete man ähnliches für die Fusion. Dann gibt es natürlich ganz einfach den Grund, dass man das Plasma damals nicht richtig verstanden hat. So basierten erste Kraftwerkskonzepte (das erste Patent wurde meines Wissens in England 1948 eingereicht) auf der Annahme, dass die Teilchen im Plasma im Wesentlichen ähnlich wie im idealen Gas miteinander wechselwirken (lediglich über etwas größere Distanzen aufgrund ihres elektrischen Feldes). Im Experiment hat man dann allerdings gesehen, dass das kollektive Verhalten des Plasmas eine große Rolle spielt, und das hatte man in den theoretischen Überlegungen nicht berücksichtigt. Das führt zu erheblich höheren Transportraten, was dann auch ein deutlich größeres Plasma erfordert.

Jetzt, viele Jahre und Publikationen später, ist es aber so, dass man mit ITER eben keine allzu großen Extrapolationen wagt, sondern sich auf einer sehr breite Basis an Experimenten stützt. Dazu gibt es mittlerweile Computermodelle, die dieses noch unterstützen.

Zu der Kritik von Daniel Jassby kann man zum einen entgegnen, dass ITER immer noch ein physikalisches Experiment ist und Groß-Forschungsanlagen erfordern nun mal hohe Anfangsinvestitionen, das liegt in der Natur der Sache. Die teilweise fehlgeleiteten Kommunikationen bezüglichen dem Unterschied zwischen der thermischen Leistung und der elektrischen Leistung ist sicherlich unglücklich, da gebe ich ihm recht, aber bereits seit vielen Jahren sehe ich auf den ITER – Vorträgen, dass diese Unterscheidung auch gemacht wird. Generell ärgert er sich viel über falsche Kommunikation, ich denke allerdings, dass diese Art der Kommunikation zum Glück in letzter Zeit weniger geworden ist.

Insgesamt gesehen wird der Energiebedarf der Menschheit enorm steigen und da muss man sich einfach alle Optionen offen halten und die Fusion stellt hier eine viel zu verlockende Option dar, als dass wir sie nicht erforschen sollten. Der finanzielle Aufwand ist verhältnismäßig gering (vergleicht man es etwa mit der Einspeisevergütung für “erneuerbare” Energien” – die ich hier nicht schlecht reden will!). Wir werden in Zukunft sicherlich einen Energiemix benötigen, Monokulturen sind fast immer schlecht, und da könnte die Fusion beispielsweise die Rolle von Grundlastkraftwerken übernehmen. Aber das müssen die zukünftigen Entscheidungsträger bestimmen, ich denke nur wir sollten ihnen so viele Optionen wie möglich bieten können.

Zustimmung. Allerdings spricht einiges gegen die Deuterium/Tritium-Fusion in Plasmen, die magnetisch eingeschlossen sind. Probleme sind die hohen Neutronenflüsse, das Entweichen von Tritium und die Aktivierung der Wandmaterialien, die durch den Neutronenbeschuss teilweise radioaktiv werden.

Wenn schon Fusion, dann mittels des folgenden Prozesses

p+ + 11B → 3 4He

denn dabei werden überhaupt keine Neutronen freigesetzt, der Prozess ist also neutronenlos.

Leider sind wir von dieser Form der Fusion aber zeitlich noch viel weiter entfernt als von der DT-Fusion, denn die nötige Aktivierungsenergie ist sehr gross. Der arxiv-Artikel Laser boron fusion reactor with picosecond petawatt block ignition beschreibt eine mögliche Realisation dieser Wasserstoff/Bor11-Fusion mittels eines extrem kurzen Laserpulses, der mindestens 10 Petawatt stark ist.

Eine aneutronic fusion wie es auf englisch heißt, wäre in der Tat sehr spannend! Allerdings benötigt man dazu, wie Sie das ja auch sagen, deutlich höhere Temperaturen – das hält allerdings beispielsweise TriAlphaEnergy nicht davon diesen Ansatz zu verfolgen.

Ja, entweder benötigt man extrem hohe Temperaturen wie bei der Wasserstoff – Bor11 Fusion oder man benötigt exotische Ausgangsmaterialien wie bei der Deuterium – Helium-3 Fusion, denn wo findet man Helium-3 ?

Dennoch gibt es mit Direct Fusion Drive ein Projekt eines Raketenantriebs, der mit der Deuterium – Helium-3 Fusion arbeitet und damit Deep Space Missionen beispielsweise zum Saturn-Mond Titan in 2 Jahren Flugzeit ermöglichen würde

Fazit: Einen Reaktor zu bauen, der die Deuterium – Helium-3 Fusion ausnützt scheint gar nicht so schwierig zu sein. Mit 20 Tonnen Helium-3 könnte man die ganze USA für ein Jahr mit Strom versorgen. Allerdings täuscht das: Um aus dem Mondregolith 20 Tonnen Helium-3 zu extrahieren müsste man 2 Milliarden Tonnen Mondmaterial umsetzen, was eine Industrie von der Grössenordnung der irdischen Kohleindustrie auf dem Mond benötigen würde.

Natürlich habe ich mich gefragt, wie man bei einem Neutron pro Fusionsreaktion, wie man genug Tritium her bekommt:

https://de.wikipedia.org/wiki/Kernfusionsreaktor#Tritiumbrüten_und_Neutronenvermehrung

Sie haben völlig recht, Karl, den Wandmodulen ist ein Neutronenvervielfacher hinzugefügt – zum Beispiel Beryllium, wie es in dem von Ihnen verlinkten Artikel auch geschrieben steht.

Ich möchte als Laie nicht mit den Fachleuten über Kernfusion diskutieren, aber jetzt mal ehrlich: Dieser unvorstellbare Aufwand bei der Kernfusion, nur um Hitze zu erzeugen, die dann primitiv in Strom umgewandelt wird…?

Die unbegrenzten Brennstoffreserven (gewinnbar aus Wasser), die inhärente nukleare Sicherheit, die Standortunabhängigkeit und die vernachlässigbaren Auswirkungen auf die Umwelt sprechen für die Kernfusion. Die gewaltigen Abmessungen von ITER/DEMO sprechen allerdings eher dagegen. Mit SPARC/ARC oder mit sphärischen Tokamaks aber sind Kernreaktoren denkbar, die so klein sind, dass sie sogar in zukünftigen Raumfahrzeugen eingesetzt werden könnten.

Der Forschungsartikel Approximation of the economy of fusion energy, der die Wirtschaftlichkeit eines ITER-Nachfolgers berechnet, kommt zu folgendem Ergebnis:

Danke für den Hinweis auf den Artikel, genau den kannte ich tatsächlich noch nicht. Darüber ist es dann tatsächlich so, dass man auch mit der DT Kernfusion im Endeffekt nur Hitze erzeugt und eine Turbine zum Laufen bringt – enttäuscht einfach, ich weiß 😉

Wie es scheint, könnte das generationenübergreifende Projekt ITER noch vor seiner Fertigstellung technisch überholt sein.

Eine rasche Weiterentwicklung der Magnetspulentechnik war, wie Sie schreiben, absehbar. Falls ReBCO im SPARC Projekt funktionieren sollte, wie erhofft, wäre ein “Upgrade” von ITER mit moderneren Magnetspulen denkbar, oder sinnvoll?

Ich schätze, dass auf dem Gebiet der Magnetspulentechnik noch weitere Fortschritte und Durchbrüche zu erwarten sind. Eine Schlüsseltechnik dafür sind ja supraleitende Materialen, die ja auch für viele andere zukunftsträchtige Technologien gebraucht werden. So weit ich weiß, hat man die Supraleitfähigkeit noch nicht vollständig verstanden, umso höher wäre ihr zukünftiges Potenzial einzuschätzen.

@ralph: Supraleitend sind auch ITERs Magnetspulen. Allerdings nutzt ITER die Tieftemperatursupraleitung während SPARC Hochtemperatursupraleiter benutzt. Hochtemperatursupraleiter ertragen höhere Magnetfelder als Tieftemperatursupraleiter, deshalb können in SPARC deutlich stärkere Magnetfelder erzeugt werden als in ITER.

Wie sie schreiben wurde ITER einfach zu früh geplant. Es wurde nämlich geplant als es noch keine Magnete mit Hochtemperatursupraleitern gab. Heute können solche ReBCO-Magnete Feldstärken bis zu 30 Tesla erzeugen, womit sie die ITER-Magneten um den Faktor 5 bis 6 übertreffen. Jetzt noch ITER umplanen, dafür ist es wohl zu spät. Zumal ein dermassen neu geplantes ITER dann wesentlich kleiner wäre als es heute ist.

Mit solchen Äusserungen wäre ich eher vorsichtig. Die Hochtemperatursupraleitung (“keramische Supraleiter”) ist bereits seit über 30 Jahren bekannt. Trotzdem setzen alle Anwendungen, in denen es um grosse Magnetfelder geht (MRT, NMR-Spektroskopie, hochauflösende Massenspektrometrie, Teilchenbeschleiniger) nach wie vor auf die herkömmlichen metallischen Supraleiter, weil man in den vergangenen 30 Jahren mit den Fertigungsproblemen der keramischen Supraleiter nicht wirklich weitergekommen ist. Wenn sich das jetzt offenbar geändert hat, wie im Artikel angedeutet, so ist das erfreulich, es war aber keineswegs absehbar.

@Alf Köhn-Seemann: haben Sie vielleicht einen Link hierzu:

? Fände ich hochspannend. Besten Dank im Voraus.

Diese Aussage ist ein Zitat aus der Frage & Antwort – Session nach den von mir genannten Vorträgen. Einer der Autoren sprach zum einen von den Fortschritten, sagte aber auch, dass die Details dazu noch nicht verraten werden. Die entsprechenden Veröffentlichungen sollen im Laufe des nächsten Jahres kommen. Da müssen wir uns also leider noch etwas gedulden – ich kann hier nur noch den Tipp geben, dass im Zuge des VULCAN – Tokamak Design einige Fortschritte bei diesen Supraleitern gemacht wurden, mehr weißt ich momentan auch nicht.

Hier nun das wissenschaftliche Paper zu dem HTS-Kabel, was erfolgreich in einem hohen Magnetfeld betrieben wurde: https://doi.org/10.1088/1361-6668/abb8c0 (Als nächstes muss nun die Fertigung einer Prototyp-Spule gezeigt werden).

Wie Martin Holzherr es schreibt, lässt sich ITER nicht mehr umplanen – es hat ja bereits der Zusammenbau des Gefäßes selber begonnen. Zudem ist es eben so, wie es aristius fuscus schreibt, und auch ich in meinem Artikel, dass eine richtige Toroidalfeldspule aus ReBCO erst noch gebaut werden muss. SPARC hat das bis zum Ende des nächstes Jahres versprochen, aber bisher wurden solche großen Spulen mit diesem Supraleiter eben noch nicht realisiert.

Danke für die Antworten. Falls die ReBCO Spulen bei SPARC funktionieren sollten, wäre das sich nicht das Ende der Fahnenstange, was die Magnetspulentechnik betrifft. Es könnte einen Investitionsschub für die Hochtemperatursupraleitung bedeuten.

In der Tat, das beträfe dann eine ganze Reihe von Anwendungen.

Anwendungen für Hochfeldmagneten und für REBCO gibt es in der Tat viele:

– Das National High Magnetic Field Laboratory hat im Jahr 2017 einen 32 Tesla Magneten mittels einer Kombination von YBCO (2 Spulen), Niob-Zinn (3 Spulen) und Niob-Titan (2 Spulen) für die Magnetfeldforschung gebaut.

– für die Magnetresonanztomographie sind mittelstarke REBCO-Magnete allein schon deshalb interessant, weil sie nicht so tief heruntergekühlt werden müssen. Das führt zu kleineren, billigeren Geräten

– REBCO-Magnete mit Feldstärken über 20 Tesla könnten einen Nachfolger des Large Hadron Colliders ermöglichen, der trotz fast gleich grossem Radius um vieles leistungsfähiger ist

Im Jahr 2019 gab es übrigens bereits 15 Firmen weltweit, die REBCO-Bänder anboten – einer davon can-superconductors.

Ein Bild eines technischen Problems:

http://members.chello.at/karl.bednarik/BORFUSIO.png

Bei dem Laser boron fusion reactor with picosecond petawatt block ignition

https://arxiv.org/ftp/arxiv/papers/1708/1708.09722.pdf

gibt es leider ein technisches Problem.

Wenn man die schnellen Alpha-Teilchen gegen ein statisches Feld

von 1,4 MV fliegen lässt, um sie zu bremsen, so wie im Bild 4,

was geschieht dann mit den Elektronen, die immer in der gleichen

Ladungs-Menge wie die positiven Ladungen auftreten müssen?

Die Elektronen werden zuerst auf 1,4 MeV beschleunigt und

neutralisieren dann die positiven Ladungen auf der Auffangfläche.

Diese beiden Vorgänge werden die Nutzung der Energie der

Alpha-Teilchen verhindern.

—–

Unabhängig davon, verlangt natürlich so viel heißes Plasma

nach der Anwendung eines Magnetohydrodynamischen Generators.

Allerdings trennt dabei ein Magnetfeld die Elektronen von

den positiven Ionen oder Alpha-Teilchen, bevor diese auf

die gleichnamig geladenen Auffangflächen gelenkt werden.

Mit den Neutronen hat man mit einem Magnetohydrodynamischen

Generator aber keinen Erfolg.

Sie haben natürlich recht, Karl, dass sich das Plasma nach außen hin elektrisch neutral verhält. Sollte es jetzt zu einem erhöhten Fluss (aus dem Plasma heraus) an positiv geladenen Ionen kommen, so lädt sich das Plasma entsprechend auf und die Transportverlustraten der Elektronen würden dann beispielsweise auch ansteigen um dem entgegenzuwirken – bei Stellarator funktioniert das zum Beispiel so, dort stellt sich dynamisch ein Gleichgewicht ein. Nun ist es in den p-11B Plasmen meist so, dass diese gepulst betrieben werden (ich muss das nochmal genau recherchieren) – also nur kurzzeitig existieren, so könnte man also dieses Problem auch umgehen.

Ich versuche nun, dieses technische Problem zu lösen:

Wenn die Alpha-Teilchen gegen ein elektrostatisches Feld

von 1,4 MV fliegen, dann werden sie so langsam, dass sie

schon von einer dünnen Metallfolie aufgehalten werden.

Die Elektronen durchfliegen die dünne Metallfolie mit

mehr als 1,4 MeV Energie, weil ja noch ihre thermische

Energie zur Beschleunigungsspannung dazu kommt.

Für das Auffangen der Elektronen gibt es dann außerhalb

der Metallfolie ein Metallblech, das gegen die Metallfolie

stark elektrostatisch negativ geladen ist, was die

Elektronen abbremsen soll.

Man sollte dabei aber die Erzeugung von störenden

Sekundärelektronen vermeiden.

Vielleicht ist dazu eine Anordnung von vielen

dünnen parallelen Metallfolien mit zunehmend höherer

elektrostatisch negativer Ladung geeignet.

Jede Metallfolie absorbiert jene Elektronen, die

in ihr ausreichend langsam geworden sind.

—–

Noch ein Bild und ein Text zum Magnetohydrodynamischen Generator:

https://de.wikipedia.org/wiki/Magnetohydrodynamischer_Generator

Die direkte Energieumwandlung ist in der Tat ein sehr spannendes Thema für sich (https://en.wikipedia.org/wiki/Direct_energy_conversion). Interessant ist vielleicht noch die Bemerkung, dass bei der Abbremsung von Ladungen auch immer Verluste in Form von Strahlung abgegeben werden, und diese können bei den hochenergetischen Alpha-Teilchen als Produkt der p-11B Fusion ganz beträchtlich werden. Ganz zu schweigen von den Problemen, überhaupt ein so heißes Plasma zu erzeugen, dass die p-11B Fusion einsetzt – dann steigen nämlich die Bremsstrahlungsverluste extrem an.

Dritter Beitrag, zweiter Nachtrag:

Wie verteilen sich die 8,7 MeV Energie der

Bor-11-Proton-Fusion auf die drei Alpha-Teilchen?

Bekommen dabei alle Alpha-Teilchen 2,9 MeV ab?

Ja, die Energie sollte sich gleichmäßig auf alle Alpha-Teilchen verteilen.

Zitat Alf Köhn-Seemann :

Ja, es gibt Dutzende von „innovativen“, Wunder versprechenden, Fusionsprojekten und viele davon sind sogar auf private Initiative hin entstanden und werden von businesss angels finanziert. Lockheed Martins Ansatz zur nuklearen Fusion, high-beta genannt, ist aber schon früher verfolgt worden und hat schon früher versagt. Auch LPP Fusions dense plasma focus nuclear fusion project basiert auf altbekannter Technologie, die noch nie funktioniert hat.

Wenn solche Projekte Geld erhalten, dann wohl nur darum, weil mit einem Durchbruch bei der nuklearen Fusion so grosse Hoffnungen verbunden sind.

Diese überbordendenden Erwartungen erklären aber auch, dass es Firmen wie Tae Technologies gibt (auch TriAlpha-Fusion genannnt) , eine Firma, die die schönste, umweltfreundlichste Form der Fusion verspricht – das aber mit Technologie, die noch kaum erprobt ist und die auch von der Theorie her auf dünnen Beinen steht.

Folgendes steht hinter den gossen Erwartungen in die nukleare Energie: die Hoffnung in unbegrenzte Energie, die mit minimalem Input, maximalen Output erzeugt und die überall eingesetzt werden kann, sowohl auf als auch unter der Erde, sowohl auf diesem Planeten, als auch überall sonst im Universum.

Viele verbinden mit dem erhofften, menschengemachten Fusionsfunken ein neues Zeitalter in dem all die Beschränkungen wegfallen, die heute noch das Leben und Streben der Menschen begrenzen.

Zu viele solcher Versprechungen schaden der öffentlichen Forschung – ich erlebe das auf Vorträgen selber immer wieder, wenn die Frage aufkommt, warum “wir” noch so lange brauchen, wo es doch Firmen wie Lockheed Martin gibt, die in 5 Jahren einen Energie freisetzenden Reaktor haben. Oft stehen hinter diesen Versprechen vermutlich einfach die Versuche, Investoren anzulocken. TriAlpha kommuniziert seit einigen Jahren etwas vorsichtiger und vor allem auch offener über ihre Forschungsergebnisse, allerdings geben ich Ihnen recht, die p-11B Fusion ist technisch noch sehr weit weg.

@Martin Holzherr 08.10. 17:47

„Viele verbinden mit dem erhofften, menschengemachten Fusionsfunken ein neues Zeitalter in dem all die Beschränkungen wegfallen, die heute noch das Leben und Streben der Menschen begrenzen.“

Brauchen wir das denn? Wenn wir in 40 oder 60 Jahren unsere Energie nachhaltig gewinnen, haben wir doch auch alles mit Energie versorgt, was man so braucht. Für eine unbegrenzte Zeit, auf Jahrtausende, eventuell auf Jahrmillionen. Die Technik entwickelt sich derweil weiter, die Produktivität steigt. Eine wirklich wesentliche Einschränkung kann ich mir kaum vorstellen. Wenn man ein 2-Tonnenfahrzeug zur Beförderung einer Person nutzt, so muss das wohl nicht sein, das wird eventuell teuer sein. Was relativ ist, wer genug Geld hat, der kann das immer machen.

Auch Kernspaltung wird wohl irgendwann den fallenden Preisen für Fotovoltaik zum Opfer fallen und nicht mehr konkurrenzfähig sein. Wenn jetzt dazwischen noch Kernfusion kommen sollte, so sieht das eher so aus, dass das erst was wird, wenn sowieso Wind, Sonne und Biomasse als Komplettpaket zu 100% ausgebaut sind, und das nicht mal allzu teuer.

Als Sciencefictionfan kann ich mir interstellare Reisen gut mit Kernspaltungsreaktoren als Energiequelle vorstellen. Der Weltraum ist eh recht radioaktiv, da kann man wenig verseuchen, wenn man erstmal der Schwerkraft der Erde entronnen ist. Wenn kleine Reaktoren mit hochangereichertem Uran schon in U-Boten gut funktionieren, könnte das auch was für Raumschiffe sein. Aber vielleicht ist hier die Kernfusion viel besser? Für bemannte Reisen innerhalb des Sonnensystems und richtig große Weltraumteleskope sind wohl die guten alten Sonnenkollektoren schon ganz gut. Die kann man auch ganz schön scalieren.

Für einen Traum von keinen wirklichen Beschränkungen brauche ich wohl keine Kernfusion, das geht auch ohne. Aber gespannt bin ich doch, ob solche Kernfusionskraftwerke mal funktionieren. Und halte die Forschung daran für sinnvoll.

Volle Zustimmung: Kernfusion bedeutet nicht ein Leben frei von jeglichen Beschränkungen zu leben – was man in der Tat manchmal liest. Im Gegenteil, wir werden um Einschränkungen nicht umhinkommen (wobei viele dieser “Einschränkungen” nicht wirklich Einschränkungen sind, wie Sie das ja auch angedeutet haben). Allerdings halte ich eine 100% Versorgung aus regenerativen Energiequellen schlicht für nicht machbar (weder technisch noch politisch – siehe Diskussion über Stromtrassen), es wird den Bedarf eines Energiemixes geben, und da könnte die Kernfusion in der Zukunft eine Rolle spielen.

@Tobias Jeckenburger: ehrlich gesagt verstehe ich die Begeisterung für Windturbinen und Solarpanel, die viele verbreiten, überhaupt nicht. Die ideale Energiequelle ist doch nicht ein Feld voll Solarpaneln oder eine Landschaft mit Windturbinen bis zum Horizont.

Die ideale Energiequelle ist vielmehr eine kleine unscheinbare Box in der man oben ein bisschen Wasser reintröpfeln lässt und wo hinten ein dickes Hochspannungskabel rauskommt.

Übrigens: Dadurch, dass Solarstrom billig ist, wenn gerade die Sonne scheint, dadurch werden Solarpanel nicht besser.

ich glaube, die Energieversorgung komplett auf Erneuerbare umzustellen, wird wohl die nächsten Jahrzehnte nicht funktionieren. Aktuell haben wir zwar ca. 40 – 50 % Erneuerbare im Strommix, aber bei der Primärenergie sind es bisher wohl nur 17% (https://www.umweltbundesamt.de/themen/klima-energie/erneuerbare-energien/erneuerbare-energien-in-zahlen#statusquo). Wir müssten also ca. 6x so viele Solarzellen, Windräder etc. aufstellen wie aktuell schon stehen (selbst wenn man mal davon absieht, dass man im Sommer die Energie für den Winter irgendwie speichern müsste). Als Alternative zur Kernfusion sehe ich sonst nur Desertec, das aber (bisher leider) kaum über ein Konzept hinausgekommen ist.

Noch eine Frage. Im Artikel steht: “…Bliebt noch das Plasmavolumen, was man gerade so groß gewählt hat, damit ITER einen Q-Wert von 10 erreichen kann…”

Wenn ich mich recht erinnere, soll in Iter auch ein Q von 30 erprobt werden.

In Wiki steht:

“Es soll eine etwa 10-fache Verstärkung der eingesetzten Heizleistung, also eine Fusionsleistung von etwa 500 MW erreicht werden. Damit ITER als erfolgreich gilt, muss dieser Zustand 400 Sekunden lang stabil bleiben. In einem anderen Betriebsmodus sind Brenndauern von bis zu einer Stunde vorgesehen bei einer Leistungsverstärkung von mindestens 5. Kurzzeitig und mit geringerer Heizleistung soll eine Leistungsverstärkung von über 30 erprobt werden, wie sie für kommerzielle Reaktoren vorgesehen ist”

ITER ist mit relativ konservativen Schätzungen auf Q=10 ausgelegt. Allerdings habe ich in der Tat auch schon einige Skalierungen gesehen, bei denen ITER Q=30 erreichen soll, wie Sie das sagen, Holger. Allerdings waren das alles “mutigere” Schätzungen, soll heißen mit deutlich größeren Unsicherheiten verbunden. Auf die schnelle habe jetzt kein Paper dazu gefunden (ich habe auf ein paar Konferenzen gesehen), werde aber eines nachliefern, sobald mir eines unter die Finger kommt.

Bei der Kernspaltung beträgt der Massenverlust rund 0,07 Prozent.

Bei der Kernfusion beträgt der Massenverlust rund 0,6 Prozent.

Durch die Kernfusion könnten die Raumschiffe daher schneller fliegen.

Bei den Kernspaltungs-Reaktoren kann man auf die schwere

Abschirmung verzichten, wenn man den Reaktor an einem

langen Stromkabel hinter dem Raumschiff her zieht.

Außerdem benötigen die schnellen Kernspaltungs-Reaktoren

keinen Moderator, was ebenfalls viel Gewicht einspart.

Es geht aber noch viel einfacher:

https://de.wikipedia.org/wiki/Orion-Projekt

Ich komme auf leicht andere Zahlen als Sie, Karl: bei der DT-Kernfusion beträgt der Unterschied der Masse von Ausgangsprodukt (also 4He + n) zu den Edukten (also D + T), 0.018835u (wobei u die atomare Masseneinheit ist, das sind dann 0.018835/5.0301 ≈ 0.4%. Bei der Spaltung von 235Uran hingegen komme ich auf ungefähr 0.1%. (Aber vielleicht haben Sie auch einfach andere Reaktionen genommen)

@Alf Köhn-Seemann 09.10. 08:50

„…,es wird den Bedarf eines Energiemixes geben, und da könnte die Kernfusion in der Zukunft eine Rolle spielen.„

Kann sein, das hängt wohl u.a. von den zukünftigen Preisen von Photovoltaik, der Überschussverwertung und den Backupkraftwerken einerseits und den Kosten für Kernfusionskraftwerke andererseits ab.

Auf jeden Fall produzieren Fusionskraftwerke weniger Atommüll als Kernspaltungsreaktoren. Man hat hier zwar reichlich Neutroneneinfang rund um das Fusionsplasma, aber dort werden wohl nicht so viel und nicht so langlebige radioaktiver Elemente produziert, auch weil man das Material entsprechend auswählen kann. Auch haben wir nicht die enorme Nachzerfallswärme wie bei der Kernspaltung, eine Kernschmelze oder gar eine Explosion wie in Tschernobyl ist wohl ausgeschlossen.

Oder haben wir hier doch eine maßgebliche Nachzerfallswärme, die bei Betriebsstörungen auch nach Beendigung der aktiven Fusionsreaktion noch so viel Wärme produziert, dass ein Ausfall der Kühlung zur Zerstörung der ganzen Anlage führt? Wenn das Material rund um das Fusionsplasma Neutronen einfängt, kann das zu Radioaktiven Elementen führen, die wiederum zeitverzögert Zerfallen und dabei entsprechend Wärme produzieren, auch wenn die gesamte Anlage abgeschaltet ist.

Oder haben wir hier doch eine maßgebliche Nachzerfallswärme, die bei Betriebsstörungen auch nach Beendigung der aktiven Fusionsreaktion noch so viel Wärme produziert, dass ein Ausfall der Kühlung zur Zerstörung der ganzen Anlage führt?

Nein. Im Gegenteil: die kleinste Störung lässt den Fusionsprozess zusammenbrechen.

Allerdings führen die hohen Neutronenströme zur Bildung von radioaktiven Elementen in der Wand des Reaktors. Solch ein Reaktor muss wohl ferngesteuert betrieben werden. Nach längerer Betriebsdauer darf niemand mehr allzu nahe kommen. Er muss vollautomatisch laufen und Umbauten sind ebenfalls von Robotern auszuführen und nicht von Menschen.

Sehr richtig, die kleinste Störung führt zum Erlischen des Plasmas. Die Wandmaterialien werden in der Tat radioaktiv aktiviert: die aktuell vorgesehenen Materialien muss man ca. 100 Jahre lagern, dann können sie wieder recycelt werden, also keine Endlagerung nötig. Fernwartung wird und wurde schon sehr ausführlich an JET trainiert, da ist man sehr gut drauf vorbereitet (aber, ja, das ist nötig).

Ein Nachtrag für Fanatiker:

Die Alpha-Teilchen der Bor-11-Proton-Fusion haben eine Energie von 2,9 MeV.

Das bedeutet, dass sie im Vakuum 3,9 Prozent der Lichtgeschwindigkeit haben.

Als Düse für das Raumschiffs-Triebwerk wäre eine magnetische Flasche notwendig.

Ein Bild dieses Science-Fiction-Triebwerks:

http://members.chello.at/karl.bednarik/BORFUSI0.png

Woher die 3,9 Prozent kommen:

6,644657E-27 kg Alpha Masse,

2,900000E+06 eV Alpha Energie,

1,602177E-19 J/eV Elektronenvolt in Joule,

4,646313E-13 J Alpha Energie,

E = ( m * v * v ) / 2,

v = Wurzel( 2 * E / m ),

11.825.866 m/s Alpha Geschwindigkeit,

299.792.458 m/s / c Lichtgeschwindigkeit,

0,039447 c Alpha Geschwindigkeit.

@Alf Köhn-Seemann 09.10. 15:08

„Die Wandmaterialien werden in der Tat radioaktiv aktiviert:…“

Meine Frage war noch, ob die Radioaktivität in den Wandmaterialien die Wand bei Ausfall der Kühlung eventuell so aufheizt, dass die ganze Anlage Schäden nehmen kann. Die Nachzerfallswärme wird ja auch dann weiter frei, wenn die Fusionsreaktion längst stillsteht.

Genau die Nachzerfallswärme ist bei Kernspaltungsreaktoren das Hauptsicherheitsproblem. Kann die nicht abgeführt werden, Heizen sich die Brennstäbe auf mehrere Tausend Grad auf und Schmelzen, obwohl die Kettenreaktion längst gestoppt wurde. So weit ich weiß, liegt die Nachzerfallswärme direkt nach dem Stopp der Kettenreaktion zunächst bei 6% der thermischen Leistung im Regelbetrieb und nimmt danach immer mehr ab. Man kann sich vorstellen, dass dies bei entsprechend großen Reaktoren immer noch eine gewaltige Heizleistung ist. Deshalb hatte man ja mit dem havarierten Tschernobyl-Reaktor noch wochenlang akute Probleme mit den vor sich hinkokelden Resten der ehemaligen Brennstäbe. Und in Fukushima waren sogar die ausgedienten Brennstäbe in den Abklingbecken immer noch ein Problem, und waren ohne Kühlung in Gefahr, aufgrund ihrer restlichen Nachzerfallswärme zu schmelzen, wenn ich das damals richtig verstanden habe.

Nein, denn mengenmässig entstehen nur wenig radioaktive Stoffe. In Milligrammmengen. Das hat praktisch keinen Heizeffekt ist aber schädlich für jeden, der in die Nähe kommt. Bei gewissen radioaktiven Stoffen genügen Milligramme an Mengen um grosse Aktivitätsdosen freizusetzen. Wenn es Gammastrahler sind, können sie recht weit strahlen und damit gesundheitsschädlich sein obwohl sie nur wenig Energie freisetzen.

Gute Frage: wie Martin Holzherr das ja auch schon geschrieben hatte, ist diese kein Problem, da die Wandmaterialien eben so gewählt sind, damit man dieses Problem nicht hat. Die Wandmaterialien sind zwar für eine gewisse Zeit radioaktiv nach dem Betrieb, aber die Nachwärme durch weitere Zerfälle sorgt nicht für strukturelle Probleme – leider habe ich da momentan auf die schnelle keine Quelle für gefunden, werde aber mal meine kernphysikalischen Freunde fragen (ich habe dazu mal was auf einer Tagung gehört, wo auch genau die Frage kam).

@Karl Bednarik 09.10. 11:39

„Die Alpha-Teilchen der Bor-11-Proton-Fusion haben eine Energie von 2,9 MeV.

Das bedeutet, dass sie im Vakuum 3,9 Prozent der Lichtgeschwindigkeit haben.

Als Düse für das Raumschiffs-Triebwerk wäre eine magnetische Flasche notwendig..“

Das würde ja bedeuten, das ein Bor-11-Proton-Fusionstriebwerk die Fusionsenergie gar nicht erst in Strom umwandeln muss, der dann wiederum ein Ionentriebwerk antreibt. Das spart Verluste bei der Umwandlung von Hitze in Strom, man muss keine Riesenmengen an Abwärme los werden und vor allem spart man jede Menge Gewicht.

Aber kann man sowas auch bauen?

Ich habe das Bild meines utopischen Triebwerks noch etwas verbessert:

http://members.chello.at/karl.bednarik/BORFUSI2.png

Der innere Teil dieses Triebwerks beruht auf diesem Artikel:

Laser boron fusion reactor with picosecond petawatt block ignition:

https://arxiv.org/ftp/arxiv/papers/1708/1708.09722.pdf

Ich habe nur um das kleine, starke und kurzlebige Magnetfeld der hier

beschriebenen Apparatur, noch ein großes, schwaches und langlebiges

Magnetfeld gelegt, um die Reaktionsprodukte in eine Richtung zu leiten.

Jetzt müsste nur noch die Laser-Zündung der Pellets gelingen.

Das ist derzeit noch nicht durchführbar.

Nachtrag:

Alpha-Teilchen mit eine Energie von 2,9 MeV haben bei

einer Magnetischen Flussdichte von 1 Tesla, die leicht

zu erreichen ist, einen Bahnradius von 0,245 Meter.

Die äußere magnetische Flasche wäre also realisierbar,

auch weil in ihr die Teilchendichte relativ gering ist.

Die innere magnetische Flasche, die vom Laserimpuls in den

Kondensator erzeugt wird, sollte einige Kilotesla haben.

Diese innere Apparatur ist natürlich sehr kurzlebig.

6,644657E-27 kg Alpha Masse,

1,182587E+07 m/s Alpha Geschwindigkeit,

3,204000E-19 Coulomb Alpha Ladung,

1 Tesla Magnetische Flussdichte,

m=(kg*m/s)/(C*T),

0,245 Meter Kreisbahnradius.

@Karl Bednarik: Danke für das Design des Triebwerks für interstellare Raketen. Teilen sie mir bitte mit wenn fertiggestellt, will unbedingt mitreisen.

Bedenken habe ich aber noch beim Treibstoffmagazin. Gibt es in einer Rakete genügend Platz um Treibstoffmagazine für eine mehrjährige Reise mitzuführen ?

Versuch einer Antwort: Nun vielleicht schon, wenn es an Bord eine Maschine gibt, die solche Treibstoffmagazine aus den mitgeführten Rohstoffen ständig erzeugt.

Das Video ARC Reactor!, das allerdings erst ab Minute 4:45 überhaupt auf die Kernfusion eingeht, erklärt detailliert die geplante Zusammensetzung des Solenoid-REBCO-Magneten , der bei SPARC verwendet werden soll. SPARC’s Magnetfeld soll 12 Tesla erreichen und damit, also mit dem erreichten Plasmaeinschluss, bereits 50 Mal mehr Fusionsenergie erzeugen als jeder bisherige Fusionsreaktor und dennoch ist SPARC deutlich kleiner als JET, ein schon 1996 gebauter Tokamak. Grund: der Magneteinschluss verbessert sich mit der vierten Potenz der Stärke des Magnetfelds. Das führt zu folgendem Gedankenexperiment: SPARC mit seinem 12 Tesla starken Magnetfeld passt in ein Einfamilienhaus, ein Tokamak mit 24 Tesla aber würde sogar in ein 3x3x3 Meter grosses Zimmer passen und wäre dabei ähnlich leistungsfähig wie SPARC.

Am Schluss des Videos wird dann gesagt, ein SPARC ähnlicher Fusionsreaktor könnte in die zweite Stufe von SpaceX‘s Starship passen. Eine Reise zum Mars wäre mit so einem Reaktor wohl tatsächlich schneller absolviert.

JET ging tatsächlich schon 1983 in Betrieb, Sie meinten vermutlich die Rekordexperimente, die wurden 1997 durchgeführt. Das Video könnte ein wenig irreführend sein, da eben die Fertigung einer solchen Toroidalfeldspule noch nicht gezeigt wurde – “lediglich”, dass das ReBCO-Tape bei hohen Feldstärken auch funktioniert.

Die Zukunft von REBCO – Hochfeldmagneten

Einfache Hochfeld REBCO-Magnete wurden schon einige gebaut und REBCO-Tapes und Magnete wurden auch bereits mit guten Ergebnissen auf ihr Langzeitverhalten getestet (vom National Highh Field Laboratory der USA).

Dennoch ist die Entwicklung von REBCO Hochfeldmagneten erst ganz am Anfang und gemäss Dipole Magnets above 20 Tesla: Research Needs for a Path via High-Temperature Superconducting

REBCO Conductors gibt es heute bereits 5 Tesla REBCO-Dipolmagnete (für zukünftige Beschleuniger) und REBCO-Dipolmagnete mit Feldstärken zwischen 10 und 14 Tesla werden für den Zeitraum 2023 bis 2025 erwartet. Der hier besprochene SPARC-Reaktor benötigt ein Solenoid mit einer Feldstärke von 12 Tesla. Solch ein grosser Rebco Magnet mit solch einer Feldstärke ist tatsächlich bis jetzt noch nicht gebaut worden und würde gemäss dem verlinkten Artikel erst 2023 zu erwarten sein.

An dieser Stelle der passende Verweis auf das im Anschluss an diesen Blogartikel erschienene Paper über die ReBCO-Supraleiter, die erfolgreich in hohem Feld getestet wurden: https://doi.org/10.1088/1361-6668/abb8c0 . Der nächste Schritt ist nun der Bau eines Prototypen einer Toroidalfeldspulen, um zu zeigen, dass man mit den Kräften umgehen kann. Dieses soll laut Autoren der SPARC-Studie allerdings bis einschließlich 2021 passiert sein.

Danke für den Link. VIPER-Kabel scheinen gemäss diesem Bericht wirklich Superkabel zu sein, fähig tausende Ein-/Ausschaltvorgänge von Strom/Feld zu überstehen, mechanisch robust mit Weiterleitung der induzierten Kräfte an externe Strukturen, mit guter Wärmeleitfähigkeit, gut zu verbinden mit andern Kabeln und externen Schnittstellen, , mit dem Versprechen bei Massenfabrikation sehr viel kostengünstiger zu werden als heute, etc., etc..

Beginnt mit HTS VIPER-Kabeln also ein neues Zeitalter in dem neben Magneten in Fusionsreaktoren, Teilchenbeschleunigern und Magnetresonanztomographen auch Windturbinen, Schiffsmotoren und Transformatoren mit Hochtemperatursupraleitern arbeiten? Wer weiss. Wir werden es in den nächsten 10 Jahren ja erleben. Und wenn es hinhaut, könnten in 20 Jahren sogar Containerschiffe und Raketen für den interplanetaren Raum mit Fusionsreaktoren ausgestattet sein, was dann die zweite Stufe des neuen Energie-Zeitalters wäre.

Am 15. 10.2020 schrieb auch Brian Wang auf NextBigFuture über VIPER (Zitat):

Falls das Hochtemperatur-Supraleiterkabe VIPER die versprochenen Leistungen erbringt, könnte tatsächlich ein neues Strom- und Magnetzeitalter beginnen und die Hochtemperatursupraleitung in unser Alltagsleben einziehen.

@Doch noch Kernfusion durch bessere Supraleiter

Ich hatte mich eigentlich längst damit abgefunden, dass die Zukunft der Energieerzeugung der Photovoltaik gehört. Einmal nachgerechnet, wie viel Platz das bräuchte:

2018 Bruttogesamtstromerzeugung von 649 TWh in Deutschland (Quelle wikipedia.org/wiki/Deutsche_Energiewirtschaft)

Pro Person ergibt das 649.000.000.000 / 82.000.000 = 7.915 Kwh. Wenn wir dies jetzt komplett mit Photovoltaik erzielen wollen, zunächst der Ertrag pro Quadratmeter im Jahr: 1000 KWh * 0,15% Wirkungsgrad macht 150 KWh/m², um 7915 KWh zu erzeugen braucht es also ca 53 m² Kollektorfläche.

Das ist etwas mehr als die durchschnittliche Wohnfläche. Das wäre in der Tat einiges an Fläche, die Dächer alleine reichen hier oft nicht, wir werden auf allen möglichen Flächen noch Photovoltaikpaneele unterbringen müssen.

Dazu kommt, das hier nur die derzeitige Stromerzeugung gerechnet wurde. Wenn wir komplett regenerativ sind, und auch Verkehr, Heizung und Prozessenergie abdecken, wird das noch 2 oder 3 mal mehr. Allerdings gibt es noch die Windenergie, Biomasse und auch noch das Aufstellen von Solarpaneelen rund ums Mittelmeer, wo der Ertrag pro m² mehr als doppelt so hoch wie in Deutschland sein kann. Dort könnten dann auch Synthesekraftstoffe produziert werden und auch eventuell noch Wasserstoffpipelines bis nach Deutschland verlegt werden.

Mir ging es jetzt nur um das zu erwartende Landschaftsbild. Also 53 m² bis das Doppelte pro Einwohner, ich denke, das wird sichtbar sein, aber noch ok. Was das alles kostet, auch die Speicherung und die Backupkraftwerke, das ist hier wichtiger.

Wenn das mit der Kernfusion doch noch was bezahlbares wird, warum nicht. Und wie sieht das eigentlich mit supraleitenden Fernstromtrassen aus? Das könnte eventuell das Landschaftsbild wieder verbessern, wenn das Erdkabel werden, und vor allem den regenerativen Strom besser und weiträumiger verteilen können.

@Tobias Jeckenburger: (Zitat) supraleitende Fernstromtrassen gibt es in China bereits zuhauf in Form von Hochspannungsgleichstromleitungen, die mit Spannungen bis zu 1 Million Volt Strom aus dem 3-Schluchtendamm oder Windturbinenstrom aus Nordwestchina in die industriellen Zentren im Süden transportieren. Mit solchen Stromtrassen könnte man kostengünstig ein rein erneuerbares Energiesystem aufbauen. Allerdings müsste das zugehörige Supergrid sich über mehrere Tausend Kilometer erstrecken. In Europa ist der Widerstand gegen solche Netze und Trassen wohl zu gross. Hier müsste man das in Tunneln führen, womit es zu teuer wäre – ausser Elon Musk bringt uns mit seiner Boring Company billige Tunnels en masse.

Kleine nukleare (Fusions-)Reaktoren würden aber auch dann vieles erst ermöglichen, was wir uns wünschen. Beispielsweise die Energieversorgung im Weltraum – auch dort wo kaum Sonne scheint, beispielsweise auf Ceres mit seinem unterirdischen Wasserreservoir oder dem Mars, dessen Oberfläche oft wochenlang von Sandstürmen verdunkelt ist.

Und noch wichtiger: Unsere (Energie-)Zukunft ist Strom, billiger Strom. Mit billigem Strom, der jederzeit fliesst, wenn man ihn braucht könnte man in Null Komma Nichts eine zu 100% grüne, CO2-freie Wirtschaft aufbauen. Wenn der Strom nur 3 Cents pro Kilowattstunde kostet, dann können sie damit sogar ihre Wohnung heizen und wenn der Strom noch „grün“ ist, können sie praktisch unkostenfrei selber „grün“ werden.

Und ja, nukleare Kleinreaktoren, die industriell fabriziert werden, könnten solch billigen Strom liefern. Und das überall. In der Sahara ebenso wie in Bonn, in Grönland ebenso wie in Washington.

Die Hochspannungsgleichstromleitungen sind zwar sehr verlustarm, im Vergleich zu den Hochspannungswechselstromleitungen, aber sie sind nicht supraleitend.

Die supraleitenden Fernstromtrassen müssten Erdkabel sein, denn sie müssten innen ein Rohr für den flüssigen Stickstoff haben, und sie müssten außen ein Rohr für die Wärmeisolation haben.

Ein wenig Wärmeisolation kommt auch von der umgebenden gefrorenen Erde.

Natürlich sorgt auch die Erzeugung des verdampfenden flüssigen Stickstoffs für Energieverluste.

Nachtrag:

Längere Erdkabel eignen sich fast nur für Gleichstrom, weil sie eine viel höhere elektrische Kapazität als die Freileitungen haben.

So ein Erdkabel ist praktisch ein großer Kondensator, der vom Wechselstrom ständig neu aufgeladen und umgeladen werden müsste.

@Karl Bednarik: danke für die Richtigstellung.

Hochspannungsgleichstromleitungen sind natürlich meist (oder sogar immer?) nicht supraleitend. Es gibt aber bereits supraleitende Stromleitungen im Einsatz in urbanen Stromnetzen in Chicago, Essen, Long Island und anderswo. Diese supraleitenden Kabel sind aber jeweils nur wenige Kilometer lang und haben nur Spannungen im Bereich von 100 Kilovolt. Sie können aber extrem hohe Stromengen übertragen weil in ihnen grosse Ströme fliessen. Und tatsächlich sind das wohl Wechselspannungsleitungen, denn ihr Zweck ist ja der Stromtransport im urbanen Netz und das arbeitet mit Wechselstrom.

Und ja, Fernleitungen mit Leistungen im Gigawattbereich müssen Gleichstromleitungen sein, sonst wären die Verluste zu hoch.

Ich denke auch, die existierenden Hochspannungsgleichstromleitungen sind bereits so gut und verlustarm, dass sie bereits die endgültige Lösung sind. Sie werden also auch in Zukunft nicht supraleitend sein.

Ergänzung zu Hochspannungsgleichstromleitungen: In der englischen Wikipedia liest man dazu (übersetzt von DeepL):

So ist es: Wer (zuverlässige) (Strom-)Verbindungen über grosse Distanzen hat, hat keine Probleme mehr mit der lokal schwankenden Stromproduktion.

@ Martin Holzherr 09.10.2020, 12:27 Uhr

Mich würde die Sicht von Physikern und Klimaforscher zum grundlegenden Energieproblem interessieren.

Wie steht es tatsächlich um die angeblich „beliebig verfügbare“ Windenergie?

Könnte es nicht massive negative Auswirkungen, zunächst einmal auf das Wetter geben, wenn sozusagen der Strombedarf für die „ganze Welt“ aus Windenergie bezogen würde?

Es könnte z.B. verhängnisvoll sein, wenn z.B. eine natürliche Hitzewelle auch nur um einige Wochen länger dauert als üblich und zuerst die Flora und danach die Fauna absterben könnte, weil nicht mehr genug Energie für den „Antrieb der Wolken“ zur Verfügung steht. Auch verheerende Waldbrände könnten auftreten.

Das Problem nicht in der sozusagen „statisch“ zur Verfügung stehenden „riesigen“ Energiemenge liegt, sondern in der „örtlichen Dynamik“.

Auf der anderen Seite könnten Solarstrompaneele den Vorteil haben, dass sie uns vor der allenfalls tatsächlich auftretenden Klimaerwärmung „abschirmen“ könnten und gleichzeitig zur Energieversorgung, sozusagen als Synergieeffekt, genutzt werden könnten?

Stromleitungen könnten für einen Ausgleich z.B, Tag – Nacht, ….. sorgen?

@Elektroniker: alle Windenergie für menschliche Zwecke abzapfen wäre wohl wirklich ein Problem. Aber es genügen weniger als 1% der weltweiten verfügbaren Windenergie um die Menschheit zu versorgen:

Allerdings erhühen viele Windturbinen tatsächlich die Oberflächentemperaturen wie man im Artikel Climatic Impacts of Wind Power liest.

@ Martin Holzherr

Ich bin zwar kein Klimaforscher, aber ich würde vermuten, dass der Grund dafür, dass es in „zentralen Bereichen“ der Kontinente Wüsten (Sahara, Gobi, …) deswegen gibt, weil zu wenig Windenergie zur Verfügung steht, um Regenwolken auch in diese Gebiete zu befördern.

Der „Wirkungsgrad“ der Prozesse dürfte sozusagen schlecht sein, bedeutet, der Energieeinsatz dürfte sehr hoch sein müssen, dennoch werden nur unzureichend Wolken „befördert“.

Es ist zwar klar, dass Windkraft einerseits Emissionen reduziert, aber die gleichzeitig durch die wärmeren Temperaturen auftretenden Effekte die Sie z.B. in ihrem Beitrag angeführt haben, könnten z.B. zur „Ausdünstung“ von CO2 führen (Permafrostböden, Waldbrände ….).

Nicht lineare, womöglich dynamische Rückkoppelungseffekte könnten allenfalls bewirken, dass statt vermeintlicher Einsparung von CO2, letztlich die Erderwärmung zusätzlich verstärkt wird.

Wenn wir besonderes Pech haben, bekommen wir, wegen der in meinem vorherigen Beitrag (Elektroniker 14.10.2020, 18:56 Uhr) angedeuteten „Dynamik“, womöglich neue Steppen/Wüstengebiete auch noch mitten im dicht bevölkerten Europa.

@Elektroniker: Treibhausgase sind nach heutigem Wissen die grössten Klimatreiber. Im Moment leben wir noch in einer Eiszeit (genauer einer Warmphase der Eiszeit, einer Interglazialphase). Warum leben wir seit 34 Millionen Jahren in einer halben Eiszeit (Südpol vereist) und seit 2.7 Millionen Jahren in einer vollen Eiszeit (Süd- und Nordpol verreist) ? Weil der atmosphärische CO2-Spiegel in den letzten 40 Millionen Jahren immer weiter gesunken ist. Jetzt aber verlassen wir gerade die Eiszeit, weil der Mensch den atmosphärischen CO2-Spiegel so stark erhöht hat.

Wenn wir in der Eiszeit bleiben wollen müssen wir die Treibhausgasemissionen auf alle Fälle senken, denn nichts hat einen grösseren Einfluss auf das Klima. Die zweite Frage ist dann auf welche andere Art und Weise als mit Kohle, Erdöl und Erdgas wir Energie für uns erzeugen. Selber denke ich wir müssen alle denkbaren Ersatzenergien in Betracht ziehen, denn es ist sehr schwierig von Kohle, Erdöl und Erdgas wegzukommen. Wenn wir uns beschränken wird es noch schwieriger.

Ist ITER der „richtige“ Weg oder ist SPARC der Funke, der alles zündet ?

Ich hätte auch fragen können: Ist NASAs Space Launch System der richtige Weg um in der Raumfahrt weiterzukommen oder ist es SpaceX Starship ?

Denn hier geht es mir um die Vorgehensweise. Und die scheint mir bei ITER und dem Space Launch System recht ähnlich, nämlich konservativ, basierend auf dem, was man sich in vielen Jahrzehnten erarbeitet hat.

Auch das SpaceXs Starship hat einiges gemeinsam mit SPARC. Nämlich die mehr experimentelle Herangehensweise aufgrund von Technologien, die gerade aktuell sind. In gewissem Sinn basieren aber SPARC und das Starship auf konventioneller, nicht revolutionärer Technologie und vor allem basieren beide auf etablierten Prinzipien in der Fusionsforschung respektive dem Raketenbau. Nur geht es beides Mal darum ein relativ hochgestecktes Ziel innerhalb einer Zeit zu erreichen in der das beteiligte Projektteam mit grosser Wahrscheinlichkeit zusammenbleibt und wo das Projekt überschaubar gross ist und alle Beteiligten eine als aufregend empfundene Projektidee einigt.

Ich denke, Projekte, die an der wissenschaftlich/technischen Front liegen, sollten alle eher so wie SPARC oder das Starship-Projekt organisiert sein, denn Multigenerationenprojekte wie ITER oder das Space Launch System passen nicht zu sich schnell entwickelnden Technologien und Wissenschaften.

Schwimmende Windkraftwerke und Solarkraftwerke auf hoher See, die zum Beispiel Methanol herstellen, sollten weniger schädlich für das Klima sein.

Man muss sie nicht unbedingt auf dem Meeresgrund verankern, und lange Stromkabel sind auch nicht notwendig.

Man verwendet einfach Treibanker und tiefer liegende Meeresströmungen.

Ab und zu holt ein Tankschiff das Methanol ab, denn Methanol ist problemlos lagerbar.

Man braucht für Methanol weder Drucktanks noch Kryotanks, und man kann es mit Wasser löschen, wenn es brennen sollte.

—–

Auf dem Meeresgrund der rund 400 Meter tiefen und rund 14 Kilometer breiten Gibraltar-Schwelle könnte man eine Menge Meeresströmungskraftwerke aufbauen.

Dort fließen rund 1 Million Kubikmeter salzhaltiges Tiefenwasser pro Sekunde mit rund 1 Meter pro Sekunde Strömungsgeschwindigkeit in den Atlantik.

Für die frei schwimmenden Windkraftwerke auf hoher See könnte man die Treibanker ebenfalls durch Meeresströmungskraftwerke ersetzen.

Nachtrag:

Falls die Meeresströmungskraftwerke auf dem Meeresgrund der Gibraltar-Schwelle den Abfluss des Mittelmeeres behindern, und dadurch seinen Meeresspiegel ansteigen lassen, dann muss man nur noch eine entsprechende Anzahl von oberflächennahen Meeresströmungskraftwerken einbauen, um auch den Zufluss zum Mittelmeer in einer vergleichbaren Weise zu behindern.

@Karl Bednarik: Guter Vorschlag, was den Produktionsort und das erzeugte Produkt, das Methanol angeht. Doch es ist unrealistisch, dass das alles andere ersetze. Und realisiert wird es nur, wenn es konkurrenzfähig ist.

Frage: Wenn es konkurrenzfähig wäre, hätten dann nicht private Investoren bereits ein solches Projekt unterstützt?

Die Konkurrenzfähigkeit und die Investitionen in die neuen Anlagen zur Energieerzeugung werden vom niedrigen Preis der fossilen Energieträger behindert.

Dazu kommt noch, dass die alten Anlagen zur Energieerzeugung von ihren Besitzern gerne weiter betrieben werden würden, weil sie diese schon bezahlt haben.

Rein theoretisch wären die schwimmenden Windkraftwerke den Tiefseebohrinseln für Erdöl technisch und finanziell überlegen.

Methanol verursacht keine Ölpest, weil es mit Wasser mischbar ist, und biologisch abgebaut werden kann.

Und natürlich wird es aus dem Kohlendioxid der Luft erzeugt.

Methanol rußt nicht beim Verbrennen, und erzeugt auch kein Schwefeldioxid, wie es rohes Erdöl macht.

Eventuell kann man die alten Tiefseebohrinseln für Erdöl als Ankerpunkte für die schwimmenden Windkraftwerke weiter verwenden.

—–

1 Million Kubikmeter Wasser mit 1 Meter pro Sekunde haben leider nur 500 Megawatt kinetische Energie.

Um die Umweltschützer zu erfreuen, müssten wir also das Projekt Atlantropa bei Gibraltar reaktivieren.

🙂

Konkurrenzfähigkeit und damit Zukunftsfähigkeit sehe ich für genau 3 Technologien, die es heute schon gibt und die die Zuverlässigkeit von strombasierten Energiesystemen massiv verbessern können – und genau das brauchen wir in einer clean-Energy Zukunft in der Strom die dominierende Energieform ist.

Diese 3 Stromtechnologien sind: Batterien, vernetzte Stromfernleitungen (Supergrids) und nukleare Reaktoren wie die hier vorgestellten Reaktoren SPARC/ARC.

Warum? Weil in einer von Strom dominierten Energiezukunft, einer Zukunft, in der die „luxuriöseste“ Form der Energie, nämlich Strom, dominiert, nur Technologien eine Chance haben, die möglichst wenig des wertvollen Gutes Strom verschwenden.

Strom und Prozesswärme sind die Zukunft der Energie. Strom wird in Wärmepumpen, Klimaanlagen, BEVs, etc gebraucht, Prozesswärme wiederum wird in vielen industriell wichtigen chemischen Reaktionen und Verfahren benötigt wie etwa Trocknen, Schmelzen oder Schmieden. Neuere nukleare Reaktoren, die bei hohen Temperaturen arbeiten, können neben Strom auch Prozesswärme liefern.

Synthetische Treibstoffe wie Methanol werden in einer Clean-Energy Zukunft nur eine kleine Rolle spielen, denn sie benötigen von der Quelle bis zum Endbenutzer 4 bis 5 Mal pro soviel Strom wie wenn man den Strom direkt konsumieren würde.

@Martin Holzherr 16.10 10:04

„Diese 3 Stromtechnologien sind: Batterien, vernetzte Stromfernleitungen (Supergrids) und nukleare Reaktoren wie die hier vorgestellten Reaktoren SPARC/ARC.“

Ich denke, Batterien sind noch nicht so kostengünstig, und die sollten auch noch besser recyclingfähiger werden, und eignen sich also vorerst vor allem für Fahrzeuge. Die Fernstromleitungen brauchen noch viel Zeit, und sind sicher auch nicht ganz billig. Und die Reaktoren wie SPARC, aber auch die von Ihnen anderswo gelobten Flüssigsalzkernspaltungsreaktoren sind noch gar nicht entwickelt bzw. schon gar nicht im Masseneinsatz, und entsprechend sind ihre Kosten wohl noch nicht bekannt. Wenn die zu teuer sind, dann ist das zwecklos.

Wenn sich die Preise so entwickeln, wie Sie das erwarten, dann passt das aber alles gut zusammen.

Wenn nicht, sind alternativ dann eben entsprechend mehr Photovoltaik und Windenergie zu installieren, erstmal die Elektromobilität umzusetzen, und die dann noch anfallenden erheblichen Überschüsse in Wasserstoff zu verwandeln und weiterzuverarbeiten. Zusätzlich kann man rund ums Mittelmeer noch etwas mehr Photovoltaik installieren, und eventuell ein paar Wasserstoffpipelines von dort nach Norden verlegen. Mehr Stromleitungen können wir bei der Variante auch gut gebrauchen.

Dazu passen dann Backupgaskraftwerke, die vorerst noch mit Erdgas laufen können und schon mal akut die Kohlekraftwerke ersetzen, bis genug überschüssiger Wasserstoff bzw. daraus hergestelltes Methan zur Verfügung steht. Dieses Synthesemethan und weitere Synthetische Energieträger lassen sich Saisonal ganz gut speichern. Was ohnehin an Methan in Biogasanlagen anfällt, könnte man dann auch zwischenspeichern und mit als Backup in den Gaskraftwerken verstromen.

Wenn sich die Preise entsprechend entwickeln, insbesondere wenn die Photovoltaik noch mal wesentlich billiger wird, kann ich mir diese Variante ohne Kernenergie durchaus als die Kostengünstigste vorstellen. Aber das weis man jetzt noch nicht, schätze ich.

Forschung an Fusionskraftwerken erscheint mir hier allemal sinnvoll, auch wenn es eventuell am Ende nur in Spezialanwendungen wie der Raumfahrt angewendet wird, weil der so erzeugte Strom für den Masseneinsatz einfach zu teuer ist. Sollten Fusionskraftwerke in fernerer Zukunft, wenn das Treibhausgasproblem eigentlich schon gelöst ist, doch noch massentauglich werden, dann kann man ja auch entsprechend Windräder und Photovoltaikanlagen nach Ablauf ihre Lebensdauer einfach nicht mehr erneuern, was dann auch das Landschaftsbild wieder verbessern kann.

Unabhängig von der Produktionsseite kann ich mir auch einen sparsameren Lebensstil vorstellen. Also weniger Fliegen, kleinere Autos bzw. Fahrradfahren sowie durchaus auch kleinere Wohnungen. Das würde sicherlich die Energiewende wesentlich beschleunigen können, auch weil das eingesparte Geld direkt in die angesprochenen technischen Lösungen investiert werden kann. Ich vermute mal, das den heute jungen Menschen von Fridays for Future auch eine Verbesserung der Konsumseite vorschwebt. Denen erscheint das Problem einfach deswegen so dringend, weil sie auch 2080 noch einen bewohnbaren Lebensraum brauchen.

Tobias Jeckenburger (Zitat):

Ich behaupte mal frech, sie reden da von Wasserstoff als Lösung, weil gerade im Internet etc. viel davon geredet wird bis hin zu Investitions- und Aktienempfehlungen. Zudem ist Wasserstoff auch eine gute Ausrede dafür jetzt nichts zu tun, den wir müssen ja noch auf den Wasserstoff warten, bevor wir richtig loslegen können.

Dabei kehrt das Thema Wasserstoff etwa alle 20 Jahre wieder und jeder der es durchrechnet muss zum Schluss kommen, dass eine starke Ausrichtung auf Wasserstoff als Speicherlösung bedeutet, dass andere Lösung versagt haben und man bei der denkbar schlechtesten Lösung angekommen ist. Um beispielsweise die saisonalen Schwankungen der Solarenergie mit gespeichertem Wasserstoff auszugleichen müssten riesige Mengen Wasserstoff zuerst durch bundesdeutsch tausende von Elektrolyseure erzeugt, dann gespeichert und schliesslich wieder verstromt werden wobei im günstigsten Fall 20 bis 30% des ursprünglich gewonnen Stroms übrigblieben. Oder verkürzt: Wasserstoff löst das Problem der schwankenden Stromproduktion durch Erneuerbare, das aber auf denkbar schlechte Art und Weise. Dass die Erneuerbaren-Gemeinde überhaupt darauf kommt, hat mit den jetzt tieferen Erzeugungskosten für Solarstrom und Windstrom zu tun, was dann zur Idee führt, dass man den Überschussstrom, der ja quasi gratis ist, ja in Wasserstoff umwandeln kann. Doch wirklich gratis ist Solarstrom nicht, denn er kostet ja auch Land, das man mit Solarpaneln überdeckt und wenn stark auf Wasserstoff als Speichermedium gesetzt wird, kann der Landbedarf für Solarpanel sich ohne weiteres verdoppeln.