Durchbruch in der Fusionsforschung! Durchbruch in der Fusionsforschung?

So, oder so ähnlich könnte man die Diskussion über die neuesten Resultate der Trägheitsfusion zusammenfassen. Ist es denn nun ein Durchbruch? Das lässt sich mit einem klaren „Jein“ beantworten, bedarf also einer Erklärung.

Es geht um Kernfusion, also den Prozess der Energiefreisetzung durch das Verschmelzen, das Fusionieren, von leichten Atomkernen. Die Sonne macht uns vor wie es gehen könnte, allerdings ist der dort ablaufende Prozess viel zu ineffizient als das wir ihn auf der Erde „nachbauen“ wollen. Stattdessen nimmt man die Fusion von schwerem und überschwerem Wasserstoff, von Deuterium und Tritium. Warum das so ist, habe ich früher schon einmal erklärt.

Um Fusion zu erreichen, muss man positiv geladene Atomkerne so nahe zusammenbringen, dass die starke Kernkraft (auch starke Wechselwirkung genannt) wirkt. Da sich die Kerne aufgrund ihrer Ladung jedoch zunächst einmal abstoßen, brauchen sie viel Energie um diese Abstoßung zu überwinden. Energie ist hierbei in Temperatur zu übersetzen und bei den erforderlichen Temperaturen liegt die Materie im Plasmazustand vor. Die zwei erfolgreichsten Konzepte, Fusion in einem Kraftwerk umzusetzen, sind die magnetische Fusion und die Trägheitsfusion, auch Intertialfusion genannt. Um erstere soll es heute mal nicht gehen, wir sehen uns die Trägheitsfusion an und wollen versuchen zu verstehen, was die neuen Resultate bedeuten. Dazu müssen wir auch klären, was es eigentlich bedeutet, wenn man von „erfolgreichen“ Konzepten spricht und wie man diesen Erfolg misst.

Zunächst also zur Trägheitsfusion. Die grundlegende Idee ist hierbei, dass man den Brennstoff innerhalb kürzester Zeit komprimiert und zwar so stark, dass die Kerne sich nahe genug kommen, um den Fusionsprozess zu starten. Durch die Fusion wird dann Energie freigesetzt und diese zusätzliche Energie zündet den komprimierten Brennstoff, wobei diese „Zündungswelle“ schneller durch den (immer noch stark komprimierten) Brennstoff läuft, als dass dieser aufgrund des enormen Druckes wieder auseinanderstreben kann. Der Brennstoff wird also durch seine eigene Massenträgheit dort gehalten, daher auch der Name Trägheitsfusion. Supernova vom Typ 1a oder auch Wasserstoff-Bomben funktionieren nach diesem Prinzip.

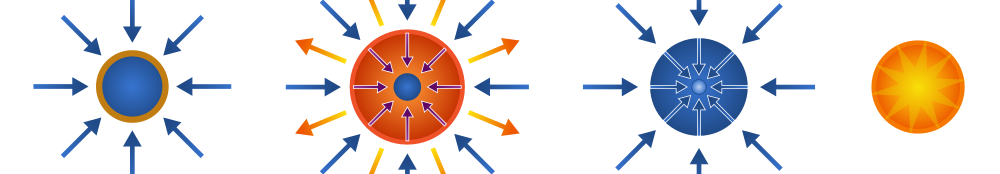

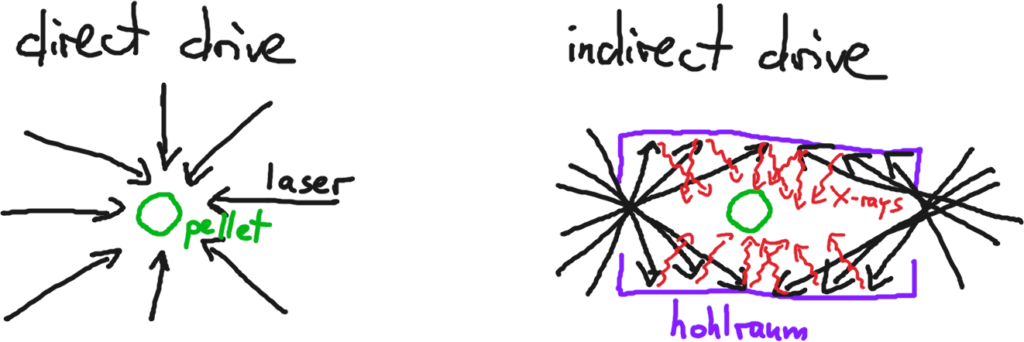

Nun sind Wasserstoff-Bomben im Labor etwas unpraktisch, daher wird die Kompression hier auf andere Art und Weise erreicht: z.B. mit Hochleistungslasern. Die Laser werden dabei auf ein Brennstoffkügelchen, auch als Pellet bezeichnet, fokussiert, welches ungefähr die Größe eines Pfefferkorns hat. Geschützt durch eine äußere Hülle, befindet sich in dem Pellet ein gefrorenes Deuterium-Tritium-Gemisch. Mittels der Laser wird die äußere Hülle des Pellets geheizt. Diese geht in den Plasmazustand über und dehnt sich blitzartig nach außen hin aus, sie explodiert gewissermaßen (sie wird „ablatiert“). Die Ablation erzeugt einen Rückstoß nach innen und eine Schockwelle läuft durch das Pellet bis ins Zentrum. Dort entstehen dann gewaltige Drücke, in der Größenordnung von 100 Mrd. Atmosphären. Diese Drücke führen zu einer Aufheizung des Brennstoffs im Zentrum, es wird Kompressionsarbeit verrichtet, auf ca. 100 Mio. Grad Celsius, was einen Faktor 10 wärmer ist als im Zentrum der Sonne. Erste Fusionsprozesse setzen ein und die entstehenden Fusionsprodukte, allen voran die positiv geladenen Alpha-Teilchen, führen zu einer weiteren Aufheizung und im Idealfall läuft die oben beschriebene Zündungswelle ab. Das alles passiert im Bruchteil einer Sekunde (ns – Bereich).

Bild: Benjamin D. Esham, gemeinfrei.

Ein großes Problem bestand bisher darin, eine gleichmäßige Aufheizung der äußeren Hülle sicherzustellen, denn kleinste Asymmetrien werden sofort verstärkt und führen zu einer ungleichmäßigen Druck- bzw. Kompressionswelle und verringern die Effizienz stark. Diese Verstärkung von Unregelmäßigkeiten kennt man aus der Hydrodynamik von der Rayleigh-Taylor-Instabilität, ein schönes Video zur Veranschaulichung ist z.B. folgendes:

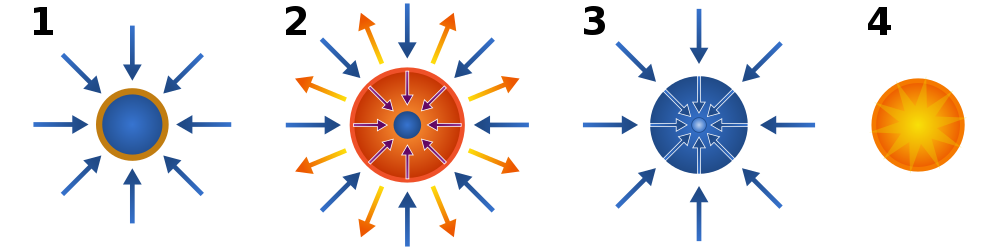

Die direkte Aufheizung der Pellethülle, welche man als „direct drive“ bezeichnet, war bisher immer mit solchen Asymmetrien verbunden, deswegen wurde der „indirect drive“ entwickelt: die Laserstrahlen heizen nun die inneren Wände einer kleinen Kapsel auf. Die Wände erhitzen sich stark, verdampfen und emittieren dabei Röntgenstrahlung, welche sich gleichmäßig, isotrop, im Inneren der Kapsel ausbreitet. Die spektrale Verteilung der Röntgenstrahlung, also ihre Frequenzverteilung, ist durch die Temperatur der Wände bestimmt, man spricht von Schwarzkörper- oder auch Hohlraumstrahlung. Entsprechend wird die Kapsel als Hohlraum bezeichnet. Wandmaterialien mit hoher Kernladungszahl, wie z.B. Gold, sorgen für eine hohe Emissivität. Da die Röntgenstrahlung das Innere der Kapsel isotrop ausfüllt, man spricht auch von einem „Röntgenbad“, kann man so eine gleichmäßige Aufheizung der Hülle des Pellets erreichen, welche sich wiederum im Inneren des Hohlraum befindet. Damit hat man das Problem der asymmetrischen Aufheizung umgangen, allerdings mit dem Nachteil, dass nun ein zusätzlichen Element, die Hohlraum-Kapsel, benötigt wird.

Bild: Alf Köhn-Seemann, CC BY-SA 4.0

Nach dieser etwas länglichen Einleitung können wir jetzt die neuesten Resultate besprechen, die einiges an Medienrummel verursacht haben. Genauer gesagt geht es dabei um Ergebnisse der National Ignition Facility (NIF) aus dem letzten Jahr, die letzte Woche in nature veröffentlicht wurden. NIF beherbergt die leistungsfähigste Laseranlage der Welt: auf einer Fläche von grob 3 Fußballfeldern werden 192 Laserstrahlen mit einer Energie von 1.9 MJ in eine Kammer mit einem Durchmesser von ca. 10 m gelenkt, in dessen Zentrum sich die Hohraum-Kapsel mit dem Brennstoff-Pellet befindet. In dem Paper schreiben die Autoren, dass sie erstmal ein brennendes Plasma im Labor erzeugt hätten („we achieve a burning-plasma state“). Hier müssen wir nochmal ein wenig ausholen und zurück zu dem eingangs erwähnten „Erfolg“ von Fusionsexperimenten kommen.

Erfolg wird in der Fusionsforschung oft mit dem Verstärkungsfaktor Q gemessen, der im Wesentlichen die durch Fusionsprozesse freigesetzte Leistung vergleicht mit anderen Heiz- oder Verlustprozessen im Plasma. Je nach exakter Definition ergeben sich einige Unterschiede. Die Autoren des Papers benutzen hier eine in der Trägheitsfusion übliche Definition:

Qα = Heizung durch in der Fusion erzeugte Alpha-Teilchen / Heizung des Plasmas

Die Heizung des Plasmas ist dabei durch die Kompressionsarbeit gegeben (Druck multipliziert mit Volumenänderung). Alternativ gibt es z.B. noch eine Definition, welche die Fusionsheizung mit der nur dem Fusionsbrennstoff zugeführten Heizung vergleicht, die wir hier mit QBrennstoff bezeichnen. Da nur ein Teil der Heizung tatsächlich in den Brennstoff geht, ist es nicht verwunderlich, dass QBrennstoff > 1 tatsächlich schon in 2014 erreicht wurde. Nun (Anfang 2021) wurde aber Qα > 1 erreicht, also ein „brennendes“ Plasma erzeugt. Das ist insofern von Bedeutung, als dass jetzt die Heizung durch Alpha-Teilchen dominant ist, etwas das man vorher nicht im Labor untersuchen konnte. Physikalisch also sehr interessant. Ermöglicht wurde diese Verbesserung u.a. durch ein optimiertes Design von Pellet und Hohlraum: das Pellet wurde etwas größer gemacht, was eine wesentliche Erhöhung der Kompressionsheizung zur Folge hat. Größermachen klingt einfach, man muss aber aufpassen, dass das größere Pellet und dessen ablatierende Hülle nicht in die Laserstrahlen gerät, die ja nur die Innenwände des Hohlraums erhitzen sollen. Hier war einiges an Optimierungsarbeit notwendig, offensichtlich erfolgreich.

Insgesamt wurden während der einzelnen Experimente jeweils ca. 170 kJ an Fusionsenergie freigesetzt. Setzt man dieses mit der Energie ins Verhältnis, welche die Laser in die Kammer eingekoppelt haben, 1.9 MJ, bekommt man eine weitere Definition für den Gewinn Q, dessen Wert mit ca. 0.09 deutlich unter 1 liegt. Und genau hier beginnen teilweise die Missverständnisse in einigen Berichten. Qα > 1 bedeutet nicht, dass die Trägheitsfusion den technischen Durchbruch erreicht hat und es bald lauter Kraftwerke basierend auf der Trägheitsfusion geben wird. Qα > 1 ist ein notwendiger, sehr wichtiger Schritt auf dem Weg zu einer insgesamt positiven Energiebilanz. Aber es gibt eben noch einige weitere Schritte, wie zum Beispiel das Verwenden von effizienteren Lasern (NIF verwendet Laser mit einer Effizienz von knapp unter einem Prozent) oder einer deutlichen Erhöhung der Repetitionsrate (für ein Kraftwerk bräuchte man wohl grob 10 Schüsse pro Sekunde, NIF kann aufgrund der Abkühlzeit der Laser nur sehr wenige Schüsse pro Tag machen). Aber NIF sollte auch kein Kraftwerk sein oder eine insgesamt positive Energiebilanz haben, genauso wenig wie beispielsweise ITER oder W7-X (bei denen dieses Missverständnis auch immer mal wieder auftritt).

Bild: Alf Köhn-Seemann, CC BY-SA 4.0

Am Ende des nature – Papers wird es noch einmal richtig interessant: dort berichten die Autoren von einem Experiment im August letzten Jahres, bei dem die Fusionsenergie 1.3 MJ beträgt, also deutlich über den angegeben 170 kJ liegt. Vergleicht man dieses mit der eingekoppelten Laserenergie von 1.9 MJ erhält man einen Wert von ca. 0.7. Weitere Details sollen in kommenden Publikationen vorgestellt werden. Es bleibt also spannend!

Das ist noch reine Grundlagenforschung in einer v.a. militärisch orientierten Anlage. Allerdings versuchen verschiedene Fusionsstartups die Mängel der NIF bei der Trägheitsfusion durch andere Ansätze zu beheben, z.B. durch effizientere Laser (Marvel Fusion, München, wollen Protium/leichten Wasserstoff mit Bor11 fusionieren), Plasmakanonan (HyperJetFusion) oder (asymmetrischen) Schockwellen (First Light Fusion). Dennoch halte ich in näherer Zukunft den am besten getesteten Tokamak mit magnetischem Einschluss für am Aussichtsreichsten (Commonwealth Fusion Systems (USA/Massachusetts) und Tokamak Energy/UK).

Ja, das ist in der Tat reine Grundlagenforschung. Ein Punkt, den ich auch nicht diskutiert hatte, irgendwann wurde der Artikel dann doch zu lang, sind die Anforderungen an das Pellet: da ist man von einer Serienproduktion noch sehr weit entfernt. Darüber hinaus stimmt es natürlich, dass NIF einen militärischen Zweck hat: Simulationen zu Kernwaffen benchmarken, da man sonst nirgends so hohe Energiedichten im Labor erzeugen kann. Aber die vorgestellten Ergebnisse sind schon spannend, bin neugierig, wie die nochmal deutlich vergrößerte Fusionsausbeute in den letzten Experimenten zu erklären ist.

Davon abgesehen würde ich persönlich allerdings auch auf magnetisch eingeschlossene Plasmen setzen.

Fast Ignition wäre heute wohl der richtige Ansatz für kommerzielle Laserfusion. Dabei werden zwei Laserpulse verwendet. Der erste komprimiert das Brennstoffkügelchen, der zweite nur Femtosekunden dauernde Petawatt starke Laserpuls entzündet es dann und bringt es zum Brennen.

NIF benutzt nicht nur veraltete Lasertechnologie, sondern verzichtet auch auf den vielversprechenden Ansatz der Zeistufigkeit.

Das Institut for Laser Engineering in Osaka hat mit Fast ignition erste vielversprechende Resultate erhalten. Das europäische Hiper-Projekt will ebenfalls auf die Fast Ignition Technologie setzen.

Ergänzung: Die Ohio State University beschäftigt sich ebenfalls mit Fast Ignition. Auf der Website Fast ignition inertial confinement fusion liest man dazu:

Ergänzung 2: In der englischsprachigen Wikipedia liest man zu Fast Ignition:

Fazit: Fast Ignition verspricht eine Reduzierung der nötigen Laserenergie um den Faktor 10 im Vergleich zum Laserfusionsansatz von NIF. Allerdings ist Fast Ignition noch wenig erforscht und es gibt kaum experimentelle Daten.

Fast ignition ist in der Tat ein interessanter Ansatz, hat aber auch seine eigenen Herausforderungen (z.B. das Timing, dann die durch den “cone” in der Hülle bedingte Asymmetrie). Mit den aktuellen Ergebnissen von NIF ist das fast ignition Konzept auch deutlich hinter dem einfachen indirect drive – was nicht heißt, dass man das in Zukunft kombinieren könnte. Allerdings ist NIF dafür momentan nicht ausgelegt. HiPer was ein interessantes Konzept, ich bin gespannt wie es damit (genauer mit einem potentiellen Nachfolger, der die Konzept-Studie ersetzt und aktualisiert) weitergeht, da könnten die letzten Resultate von NIF neuen Wind in die Segel bringen.

Ergänzung: Fast Ignition ist auch mit indirect drive möglich, also mit einem ganz ähnlichen Ansatz wie er beim National Ignition Facility verfolgt wird. Darüber berichten Forscher aus dem Laser Fusion Research Center, CAEP, Mianyang, China. In der Kurzzusammenfassung von Enhanced energy coupling for indirect-drive fast-ignition fusion targets ( Verbesserte Energiekopplung für schnell zündende Fusionsziele mit indirektem Antrieb ) liest man dazu:

Beurteilung Fast Ignition 💥ist in meinen Augen ein Muss, weil nur Fast Ignition kleine Laserfusionsanlagen ermöglicht und nur kleine Fusionsanlagen den Weg zur kommerziellen Kernfusion öffnen. Allerdings ist indirect drive 🚍in meinen Augen in einer kommerziellen Kernfusionsanlage ♨️meiner Meinung nach ebenfalls nicht möglich, denn bei jeder Zündung 💥wird ja die Hohlraumkapsel 🎾, die indirect drive ermöglicht, zerstört. Solch eine vergoldete Kapsel 🎾 ist so teuer, dass sich ihre Kosten über die erzeugte Energie nicht wieder einspielen lässt.

Schreibfehler:

“…dass die Kerne sich nahe genug kommen um den Fusionsprozess zu starten.”

Hier fehlt ein Komma nach “kommen”.

“Durch die Fusion wird dann Energie freigesetzt und diese zusätzliche Energie zündet den komprimierten Brennstoff, wobei diese „Zündungswelle“ schneller durch den (immer noch stark komprimierten) Brennstoff läuft, als dass dieser aufgrund des enormen Druckes wieder auseinander streben kann.”

Es heißt “auseinanderstreben”.

In der Tat, “auseinander streben” meint etwas anderes^^

Ist korrigiert

Schreibfehler: “Nun sind Wasserstoff-Bomben im Labor etwas unpraktisch, daher wird die Kompression hier auf andere Art und Weisen erreicht…”

Es heißt: andere Art und Weise.

Oder wollte der Autor sagen: andere Arten und Weisen?

Ebenfalls korrekt, ist berichtigt.

Die Kernfusion ist die vielversprechendste Energieform, denn das Deuterium in einer Badewanne voller Wasser und das in zwei Smartphones enthaltene Lithium genügen als Rohstoffe für einen energieerzeugenden Prozess in einem Fusionskraftwerk, der einen Europäer 80 Jahre lang mit Strom versorgen könnte. Auch und gerade im Vergleich zu Erneuerbaren schneidet Kernfusion sehr gut ab, denn nur schon um Deutschland allein mit Solarenergie zu versorgen benötigt man mindestens die Fläche des Saarlandes und weltweit bräuchte es etwa 2 Millionen Quadratkilometer Fläche und damit deutlich mehr Fläche als heute für den Anbau von Reis weltweit genutzt wird.

Doch bis jetzt ist die kommerziell genutzte Kernfusion nur eine Vision, denn bis jetzt gibt es nicht einmal einen Forschungsreaktor, der im Permanentbetrieb mehr Energie per Fusion erzeugt, als in ihn hineingesteckt wird.

Dass eine solch vielversprechende Energieform immer noch so wenig erforscht ist, liegt unter anderem daran, dass selbst Forschungsreaktoren schon riesige Gebäude füllen und viele Milliarden kosten. Und bis sie realisiert sind können sie schon veraltet sein, denn in den typischen 10 Jahren+ Bauzeit können Forschung und Technologie schon sehr viel weiter sein als zu Beginn des Baus.

Der Bau der National Ignition Facility, über deren Laserfusionsexperimente hier berichtet wird, begann 1997 und sollte bei veranschlagten Baukosten von etwa 1 Milliarden Dollar im Jahr 2004 beendet sein. Bereit für den Betrieb war NIF jedoch erst 2009 bei Kosten von über 4 Milliarden Dollar. Das wurde damals als grosse Kosten- und Zeitüberschreitung betracht ist aber vergleichbar mit ITER (dem Riesentokamak in Frankreich), der 3 bis 4 Mal mehr kostet als veranschlagt und der ebenfalls viel später in Betrieb geht als geplant.

NIF ging mit veralteter, ineffizienter Lasertechnologie in Betrieb und ITER mit veralteter, leistungsschwacher Magnettechnologie. ITER droht jetzt sogar von Commonwealth Fusion Systems [CFS] mit einem Tokamak überholt zu werden, dessen Plasmavolumen 40 Mal kleiner und dessen Kosten 10 Mal kleiner sind. Commonwealth Fusion Systems SPARC-Tokamak privat finanziert könnte mit weniger als 100 Forschern letztlich mehr zur Kernfusionsforschung beitragen als das von 35 Staaten finanzierte ITER mit seinen 1000 Mitarbeitern. Und alles darum, weil sich ITERs Projektierungs- und Bauphase über mehrere Jahrzehnte hinzieht und die Forschung in diesen Jahrzehnten nicht stillsteht.

Heute hört man ja oft: Nuklearfusion kann nichts zu einer nachhaltigen Energieversorgung beitragen, weil sie in den nächsten 30 Jahren nicht zur Verfügung steht – mindestens nicht in kommerzieller Form. Dahinter steckt implizit die Annahme, in 30 Jahren käme die gesamte Weltenergie aus Heeren von Solarpanels und Windturbinen. Doch auch diese Einschätzung dürfte sich als völlig falsch erweisen. Denn wenn Deutschland seine letzten Kohlekraftwerke erst 2038 abstellt, dann dürfte Indien das noch viel später tun. Zudem kommen Erneuerbare bis heute nicht ohne Erdgas aus. Deutschland plant gerade einen massiven Zubau von Erdgaskraftwerken und weltweit hat die Erdgasnutzung immer nur zugenommen und sie nimmt weiter zu obwohl die Verbrennung von Erdgas mit CO2-Emissionen verbunden ist – und das nicht zu knapp.

Nukleare Fusion kann also noch zum Zuge kommen. Und wenn sie zum Zuge kommt, bedeutet das eine praktisch unsichtbare Energieversorgung, denn anstatt einer Welt mit 2 Millionen Quadratkilometern Solarpanels kriegen wir dann eine Welt mit 20‘000 Fussballfeldern voller Fusionskraftwerke und die begnügen sich mit einer 10‘000 fach kleineren Fläche als es Solarpanel tun würden.

Die Erneuerbaren haben neben der mangelnden Akzeptanz, wenn es darum geht wo denn genau das Windrad jetzt stehen soll (möglichst nicht in Sichtweite des eigenen Gartens), natürlich auch noch das Problem der mittelfristigen Speicherung (gerade Flauten und windstille Perioden über mehrere Tage, vielleicht sogar einige wenige Wochen, sind ein großes Problem).

Zum SPARC – ITER Vergleich: SPARC ist ein tolles und spannendes Experiment, ITER allerdings auch. Vor allem Dingen ist ITER wesentlich besser mit Diagnostiken bestückt, als SPARC, wo es nur ein Minimum davon geben soll. Selbst wenn ITER also bezogen auf den Fusions-Output des Plasmas überholt werden sollte (der Zeitplan von SPARC ist sehr optimistisch), dann hat ITER immer noch seine Berechtigung, da es eine ganze Reihe wichtiger Experimente ermöglichen wird, die man in SPARC nicht machen kann.

@Alf Köhn-Seemann (Zitat):

Ja, ITER ist ein Forschungsreaktor in dem in jahrelangem Betrieb sehr viele Daten erhoben werden. Von diesem Blickwinkel her betrachtet ist ITER sehr viel besser als SPARC.

Weniger gut sieht es für ITER aus, wenn man ITER und SPARC als Vorläufer von kommerziellen Reaktoren betrachtet, denn ITER will überhaupt erst im Jahr 2035 eigentliche Fusionsexperimente durchführen (Zitat):

Das aber bedeutet, dass DEMO, also der Nachfolger von ITER erst um das Jahr 2050 realisiert werden kann. Und das ist in mrinen Augen zu spät.

SPARC dagegen soll 2025 den vollen Fusionsbetrieb aufnehmen mit einem Q von 2 und die Ergebnisse sollen dann den Bau eines kommerziellen Reaktors steuern, dessen Bau bereits 2030 beginnen kann und der folgende Spezifikation besitzt (gemäss Wikipedia):

Fazit: Bei ITER steht Forschung im Vordergrund, bei SPARC die Erprobung eines Hochfeld-Tokamaks, der dann die Auslegung eines wenige Jahre später folgenden kommerziellen Kernfusionsreaktors bestimmt.

SPARC ist der unmittelbare Vorläufer eines kommerziellen Kernfusionsreaktors, ITER dagegen dient der Kernfusions-Forschung und soll mehr als 10 Jahre allein diesem Zweck dienen. In Commonwealth Fusion Systems Raises $1.8 Billion in Funding to Commercialize Fusion Energy liest man zu SPARC:

Mit andern Worten: Bei SPARC und ARC geht es letztlich um den kommerziellen Einsatz der Nuklearfusion noch in den 2030er Jahren. ITER und DEMO planen die kommerzielle Phase erst nach dem Jahr 2050.

…”Die Sonne macht uns vor wie es gehen könnte”…

eben nicht.

Ein zentraler Wirkmechanismus ist durch die Gravitation begründet…

Diese hat in irdischen Fusionsversuchen keinerlei Bedeutung!

Ich hatte geschrieben, wie es gehen könnte, und Gravitation ist eben eine Art des Einschlusses (neben z.B. magnetischem Einschluss und Trägheitseinschluss) – die allerdings auf der Erde nicht realisiert werden kann, und ich hatte auch nicht geschrieben, dass man versucht diese Art des Einschlusses auf der Erde zu realisieren.

Die Sachlage ist schwierig, weil wir mehrgleisig denken, handeln ( und bezahlen ) müssen.

Selbst wenn wir in 30 Jahren eine Vorstellung von der “kommerziellen” Nutzung der Kernfusion hätten ( und im Grunde haben wir seit 50 Jahren die Dauer-Vorstellung, dass es in 5 Jahren soweit sei ), wissen wir doch nicht, ob diese Vorstellung dann möglicherweise doch “geht nicht” lauten würde. Demzufolge müssen wir jetzt schon alles daran setzen, mit den aktuell verfügbaren Energiemaschinen genügend fossil-CO₂-freien Strom zu erzeugen, nicht nur für den Strombedarf selbst, sondern auch, um einen Überschuss zum Speichern und zum Umwandeln in H₂, CH₄ oder langkettige flüssige KW zu haben. Da kommen neben Laufwasserkraftwerken ( begrenzte Kapazität ) eben PVA und WKA in Frage, dazu auch K(ernspaltungs)KW, in “alter” ( muss ja nicht unbedingt vom Tchernobyl-Typ sein ), wie auch in neuer Technik. Sicher brauchen WKA und PVA viel Platz, das ist ein Nachteil der geringen Energiedichte ( Vorteil: weniger gefährlich ), aber die Fläche für PVA kann auch da sein, wo wir Beschattung nicht als nachteilig bewerten. Bei den WKA kostet der Sockel Platz, aber ich denke, dass für die Angaben für den Flächenbedarf auch die Abstände zwischen den Türmen in Rechnung gestellt werden, zwischen den Türmen ( ihren Sockeln ) könnte hingegen auch Reis ( irgendein Getreide ) angebaut werden oder könnten Tiere weiden ( oder lokaler “Urwald” entstehen ).

Wenn wir dann mal mit der Kernfusion erfolgreich sind, können wir nach und nach die andere Technik auslaufen lassen, nicht einfach stilllegen und abreißen, sondern statt zu renovieren/reparieren dann abbbauen.

Wir beklagen ja sonst die “Wegwerfgesellschaft”, aber bei unserer aktuellen Art der Energiewende machen wir genau das.

@Karl Maier: Klar läuft alles parallel weiter. Wobei aber gilt: wenn alle gleichzeitig die gleiche Technologie wollen, kommt es mit ziemlicher Sicherheit zu Verknappungen. Auch für Windkraftanlagen braucht es Rohstoffe. Und zwar nicht nur Kupfer und Stahl, sondern auch seltene Erden.

Martin Holzherr

05.02.2022, 03:29 Uhr

Zwei Anmerkungen:

a) Angesichts der Diskussionen um Stromtrassen und WKA-Standorten, angesichts der zaghaften ersten Andeutungen von PVA über landwirtschaftlich genutzten Flächen und Straßen/Plätzen, angesichts des schleppenden Fortschritts bei den Energiespeichern ( als wäre das ein “Hexenwerk” wie die Kernfusion ) kann ich kein “läuft alles parallel” sehen, es ist eher ein einbeiniges Hinken mit Krücken.

b) Unser Problem ist scheint’s “das Beste oder nichts, also nichts”. Generatoren lassen sich auch ohne Seltenerd-Magnete bauen. Das ist ein Abwägen zwischen η ( Ertrag ) und Kosten. Ich denke, dass es bei den konventionellen Eisenwerkstoffen weniger ein Problem sein wird. Beim Kupfer müssen wir uns sowieso ernsthaft was überlegen, dieses Element ist in der Erdkruste eh nicht so häufig.

Die Verwendung des “überschüssigen” Stroms aus Erneuerbaren spielt in der Tat eine wichtige Rolle, da gebe ich Ihnen völlig recht und da gibt es ja auch vielfältige Ansätze (wie die von Ihnen angesprochenen). Dass bei erfolgreicher Kernfusion nicht einfach andere Grundlastkraftwerke direkt stillgelegt werden, dürfte sich schon wegen bestehender Verträge nicht umsetzen lassen. Außerdem werden sich auch die Kernfusionskraftwerke weiterentwickeln, die erste Generation wird sicherlich nicht die effizienteste sein.

@Maier 05.02. 00:06

„Wenn wir dann mal mit der Kernfusion erfolgreich sind, können wir nach und nach die andere Technik auslaufen lassen, nicht einfach stilllegen und abreißen, sondern statt zu renovieren/reparieren dann abbbauen.“

Sehe ich auch so. Ich schätze mal, dass spätestens nach 30 Jahren eine PVA oder WKA erneuert werden muss. So wäre ein Übergang zu Fusionskraftwerken dann in Ruhe zu realisieren, so weit das dann Sinn macht, und sonst kann man eben die Altanlagen erneuern.

“Wir beklagen ja sonst die “Wegwerfgesellschaft”, aber bei unserer aktuellen Art der Energiewende machen wir genau das.“

Ein vernünftiges Recycling täte überall Not, wo größere oder wertvolle Stoffmengen anfallen. Hier müsste auch der Gesetzgeber mal mehr Vorgaben machen, dass die Industrie schon bei der Produktentwicklung darauf achtet, dass man einen Ersatz von Altanlagen möglichst komplett mit den recycelten Rohstoffen fertig bekommt.

Ich habe den Begriff “Wegwerfgesellschaft” mit einem 😉 auf unsere im Prinzip noch viele Jahre nutzbaren K(ern)KW gemünzt.

Zum (Miß-)Verständnis des Wirkungsgrades

Sabine Hossenfelder (Theoretische Physikerin) bringt es auf den Punkt…

Sie äußert sich im Oktober 2021 u.a. folgendermaßen…

„Der Betrieb von Fusionsreaktoren erfordert eine Menge Energie, und der größte Teil dieser Energie geht nicht in das Plasma. Wenn man das Plasma mit einem Magnetfeld in einem Vakuum einschließt, muss man riesige Magnete betreiben, sie kühlen und die Energie aufrechterhalten. Und einen Laser zu pumpen ist auch nicht gerade energieeffizient. Diese Energien tauchen niemals in dem normalerweise angegebenen Energiegewinn auf.

Das Q-Plasma berücksichtigt auch nicht, dass, wenn man ein Kraftwerk betreiben will, die vom Plasma erzeugte Wärme noch in elektrische Energie umgewandelt werden muss, und das geht nur mit einem begrenzten Wirkungsgrad, optimistischerweise vielleicht fünfzig Prozent. Das hat zur Folge, dass der Q-Gesamtwert viel niedriger ist als der Q-Plasma-Wert…

Wie kann eine solche Verwechslung überhaupt passieren? Ich meine, das ist keine Raketenwissenschaft. Die Gesamtenergie, die in den Reaktor geht, ist größer als die Energie, die in das Plasma geht. Und doch verstehen Wissenschaftsautoren und Journalisten dies ständig falsch. Sie verwechseln die grundlegendste Tatsache in einer Angelegenheit, die sich auf Dutzende von Milliarden an Forschungsgeldern auswirkt.“… Quelle

@Dirk Freyling (Zitat): „ Das hat zur Folge, dass der Q-Gesamtwert viel niedriger ist als der Q-Plasma-Wert…“

Klar. Nur behaupte ich: das wissen doch alle – mindestens alle Fusionsforscher und die meisten Physiker. Konkret hört man aus der Fusionsgemeinde, dass der Q-Plasma-Wert ♨️ mindestens 10 betragen muss, bis man an einen kommerziellen Einsatz überhaupt denken kann.

Warum dann wird jetzt in den Medien 📰 oft so getan, als stünde der kommerzielle Einsatz der Kernfusion unmittelbar bevor? Für mich ist der Grund klar: weil jetzt erstmals privates Kapital in Milliardenhöhe in gewisse Fusionsprojekte gesteckt wird. Und diese Geldgeber brauchen eine positive Berichterstattung und zusätzlich einen rosigen Zukunftsausblick 🔮, damit sie ihr Investment rechtfertigen können.

Beim Quantencomputing ⚛️ beobachtet man etwas ganz ähnliches. Da wird in den Medien der Eindruck erweckt, der Quantencomputer tauche gleich um die nächste Ecke auf.

Allerdings muss man in Bezug auf die Kernfusion sagen: Wenn einmal die Bedingungen für Zündung und Plasmabrennen erreicht sind, darf mit grossen Energiegewinnen gerechnet werden – vorausgerechnet natürlich, das Gerät übersteht/überlebt die Energiefreisetzung 💣 überhaupt.

Zu der Antwort von @Martin Holzherr lässt sich noch hinzufügen, dass man ein kommerzielles Kraftwerk basierend auf dem Tokamak-Prinzip deswegen auch ungefährt mit einem Q_plasma = 30 betreiben will. Das Missverständnis über die Definition des Q-Werte liegt z.T. leider auch in der “sekundären” Berichterstattung, also bspw. von Nicht-Experten verfasste Berichte, die nicht durchgesehen werden und dann in den Medien landen. Unter Physikern ist das in der Tat bekannt – aber wir sind uns dieses Missverständnis bewusst und achten seit einiger Zeit darauf dieses immer klar zu sagen bei öffentlichen Veranstaltungen.

@Maier 05.02. 00:06

„Ich habe den Begriff “Wegwerfgesellschaft” mit einem 😉 auf unsere im Prinzip noch viele Jahre nutzbaren K(ern)KW gemünzt.“

In der Tat hat das was von Verschwendung. Ein Neubau von KKWs stehe ich durchaus kritisch gegenüber, auch weil wohl einfach zu teuer. Aber die Altanlagen noch ein paar Jahre zu betreiben, und noch ein paar Jahre länger als saisonales Backup, das hätte ganz gut gepasst.

OK, ist wohl mit Restrisiko, und auch der Atommülll kann noch viel teurer werden als gedacht. Aber gerade bei den Spannungen mit Russland jetzt die 3 KKWs und noch 3 Kohlekraftwerke auszumustern, erscheint ungut. Das war aber wohl schon seit Jahren so geplant. Wenn jetzt der russische Gasnachschub wegfällt, werden wir uns darüber noch sehr ärgern, scheint mir.

@Holzherr 05.02. 13:57

„Allerdings muss man in Bezug auf die Kernfusion sagen: Wenn einmal die Bedingungen für Zündung und Plasmabrennen erreicht sind, darf mit grossen Energiegewinnen gerechnet werden – vorausgerechnet natürlich, das Gerät übersteht/überlebt die Energiefreisetzung 💣 überhaupt.“

Ein Potential ist offenbar vorhanden. Insbesondere mittelgroße Anlagen wären sehr gut zu gebrauchen. Und wenn die Kernfusion am Ende doch nur für interstellare Raumschiffe taugt, weil viel zu teuer, dann haben wir auch nicht umsonst in die Forschung investiert.

Naja, “umsonst in die Forschung investiert” haben wir sowieso nicht, denn Erkenntnis wird man auch jeden Fall gewonnen haben 🙂

Bei der Fusionsforschung handelt es sich immer noch um Kernforschung.

“Der Teufel steckt im Detail”, sagt der Volksmund. Bei der Fusion werden wir ebenso Neutronenstrahlung bekommen mit dem Entstehen von leichten Nukliden.

Der radioaktive Müll ist das Problem.

@hwied (Zitat) “Der radioaktive Müll ist das Problem“

Bei der Kernfusion entsteht kein langlebiger radioaktiver Abfall. Lediglich die Wände des Reaktors werden durch die Neutronenstrahlung aktiviert, was bedeutet, dass in den Wänden radioaktive Elemente entstehen. Die Lösung des Problems ist einfach: Man wartet nach Beendigung der Betriebsdauer einfach 100 bis 300 Jahre. Nach dieser Zeit ist die Radioaktivität abgeklungen.

Übrigens: Sogar sämtlicher hochradioaktiver Abfall, der in Kernspaltungsanlagen (Atomkraftwerken) bis jetzt erzeugt wurde, hat in zwei Gebäuden der Grösse eines Walmarts Platz. Das durch technische Prozesse erzeugte CO2 hat jedoch jedes Jahr die Masse des Bodensees, also mehr als 40 Milliarden Tonnen. Und ganz ähnlich wie langlebiger radioaktiver Abfall bleibt das CO2, das der Mensch in die Luft bläst tausende von Jahre in der Atmosphäre.

Martin Holzherr

06.02.2022, 13:37 Uhr

Bei allen Kraftwerkstypen, bei denen Strahlung auftritt, sehe ich weniger Probleme bei den am Ende verstrahlten Werkstoffen ( der “Brennstoffrestmüll” bei den K(ern)KW ist eine andere Problematik ), sondern bei den Werkstoffeigenschaften während des Betriebs. Solange Neutronen eingefangen und damit stabile Isotope erzeugt werden, bleiben wohl die Eigenschaften weitgehend erhalten. Wandeln die aber um ( Neutron -> Proton + xy ), erzeugen wir neue Elemente mit anderen chemischen Eigenschaften und damit anderen Werkstoffeigenschaften. Zerplatzt ein Atom im Werkstoff, haben wir eine Leerstelle im Kristallgitter und viele davon verändern auch die Mechanik. Das muss man einplanen und entsprechend “vorhalten”.

Ein wichtiger Punkt, den Sie da ansprechen @Karl Maier. Das spielt auch bei der Wahl des Wandmaterials eine wichtige Rolle und es ist klar, dass die erste Wand nach einer gewissen Betriebsdauer ausgetauscht werden muss (mittels “remote handling”, also über ferngesteuerte Roboter). Ein interessanter alternativer Ansatz ist, eine fließendes/flüssige erste Wand zu nehmen. ITER wird in jedem Fall wichtige Erkenntnisse zum Thema Wandmaterial liefern.

“Die Worte les’ ich wohl, allein mir fehlt der Technik-Glaube …”

Gleich bei welcher Form einer Reaktionskammer, es gibt immer ein “seiten…”, ein “unten…” und ein “oben…”, da bin ich mal gespannt, wie da ein “flüssiger” Strahlungsschutzvorhang aussehen könnte, ganz abgesehen davon, dass auf einer Seite ein recht hohes Vakuum ( = Dampfdruck ) herrscht ( erhalten bleiben sollte ) und die Brühe doch recht heiß wird ( = Dampfdruck ) …

Ja, das klingt schon etwas abenteuerlich, aber eine flüssige erste Wand hätte schon einige Vorteile, da sie sich regelmäßig erneuert. Es wurden auch schon einige Experimente dazu durchgeführt, eine Idee, waren zum Beispiel mit flüssigem Litium benetzte Wandteile, die dabei immer wieder von hinten “nachbenetzt” wurden, ähnlich wie ein Schwamm (sie sowjetischen Kollegen hatten so etwas getestet), ist auf jeden Fall ein aktives Forschungsgebiet.

Martin Holzherr,

die Alternative sollen nicht die Kraftwerke sein mit Kohle oder Öl , sondern die Solarenergie oder die Wind- und Wasserkraft. Die alten Pumpspeicherwerke sind immer noch eine solide Option.

Das mit dem hochradioaktiven Abfall stimmt, unsere “Endlager” mit dem schwach radioaktiven Abfall sind dagegen übervoll. Der macht das Grundwasser radioaktiv. Und man bemerkt es kaum. Die Franzosen haben uns schon angemahnt, die Belastung von Mineralwässern aus dem Schwarzwald bekannt zu geben. Das geschieht nämlich nicht, und die Alphastrahlung ist nur schwer zu messen.

@hwied: bis jetzt brauchen sie immer noch Gaskraftwerke um unterbruchsfrei Strom zu erzeugen.

Die alten Pumpspeicherwerke sind immer noch eine solide Option.

Qualitativ ( in der Theorie ) ja, quantitativ ( in der Praxis ) eher nein, als Minuten- bis Stundenspeicher für eine begrenzte Region aber schon. Die Einzelkapazität ist begrenzt, die Anzahl möglicher Standorte ist begrenzt und wie man bei den “Argumenten” gegen den geplanten Pumpspeicher in Atdorf gesehen hat:

Die wechselnden Wasserstände im Ober- und Unterbecken sind eine Katastrophe für Tier- und Pflanzenwelt und – das Schlimmste – man könnte ja sogar “Atomstrom” ( heute vielleicht “Kohlestrom” ) damit zwischenspeichern!

Selbst wenn man die hohlen Fundamente der WKA-Türme ( Kapazität? ) auf dem Berg als Oberbecken benutzt ( will, irgendwo bei Crailsheim meine ich ), es bleibt das Unterbecken im Tal mit wechselnden Wasserständen, ebenso, wenn man im Ruhrgebiet die Schächte und Stollen benutzen will, es bleibt da die Frage nach dem Oberbecken. Selbst wenn man Kugeldruckluftspeicher im Bodensee versenken und den Wasserdruck in der Tiefe ausnutzen will, bleibt bei hinreichender Kapazitität ( Größe ) der Anlage die Frage nach dem Wasserstand …

Belastung von Mineralwässern aus dem Schwarzwald

Radioaktivität ist fast überall gegenwärtig, aus natürlichen Gründen. Überall dort, wo Gestein aus dem Erdinnern ( Vulkane ) kommt, kommen langlebige strahlende Isotope ans Tageslicht, durch die natürlichen Vorgänge werden diese dann auch noch verfrachtet und aufkonzentriert. So gibt es an einigen Orten “strahlende” Monazitsande ( dort leben Menschen ), es gibt “strahlendes” Radon ( dort leben Menschen ). In Gabun hat man auch in einer Uranerzlagerstätte einen natürlichen Kernreaktor gefunden, der vor 2 Ga für 500 ka aktiv war.

Selbst beim Verbrennen von Steinkohle muss man mit Radioaktivität im Kamin rechnen, wenn nämlich auf Grund des Vorkommens viel Nebengestein mit abgebaut und mit verfeuert wird, im Ruhrgebiet kam dann aus dem Kamin eines K(ohle)KW ( ungefiltert ) mehr Strahlung als aus dem Abluftkamin eines normalen K(ern)KW.

@Karl Maier(Zitat): “ So gibt es an einigen Orten “strahlende” Monazitsande ( dort leben Menschen ),“

Ja, die natürliche Radioaktivität, auch Background-Radioaktivität ist an einigen Orten um das 50-fache höher als im deutschen Durchschnitt (=2.1 Millisievert pro Jahr) und bis jetzt konnten bei den Menschen, die dort leben noch keine negativen Auswirkungen nachgewiesen werden.

Beispiel 1 Guarapari, eine brasilianische Küstenstadt

Beispiel 2 Ramsar im Iran

Fazit: Die Hintergrunds-Radioaktivität unterscheidet sich von Ort zu Ort und ist an einigen Orten über den gesetzlich erlaubten Werten, die etwa in Deutschland gelten.

Die stärkste Quelle an natürlicher Radioaktivität trägt jeder in sich selbst. Es ist Kalium-40, ein Isotop des lebenswichtigen Elements Kalium. Vor einer Milliarde Jahre gab es noch doppelt so viel Kalium-40 auf der Erde wie heute, denn die Halbwertszeit von Kalium-40 beträgt 1.28 Milliarden Jahre.

Ja, und einige Orte und Lagerstätten weiter weg von ihren jeweiligen Küsten.

>Die Strände von Trivandrum und Travancore in Südindien bestehen aus großen Mengen Sand mit hohem Gehalt an Monazit. [ Dazu ] die Küstenstreifen vor Rio de Janeiro, Bahia, Espírito Santo und Paraíba (Parahyba) in Brasilien.<

Radioaktive "Heilmittel" gab es auch bei uns mal, auch die nachts leuchtenden Ziffern von Armbanduhren …

Es ist nicht so einfach, ich erinnere mich noch an einen Besuch in der Asse:

Nachdem wir den Bunker gesehen hatten, wo die Fässern abgekippt und dann mit Salz zugeschüttet wurden, kamen wir an einer Tür vorbei, hinter der ein Strahlenmessplatz der Uni Braunschweig eingerichtet war.

"Klar, da die Fässer, hier der Messplatz", haben wir geunkt.

Der Führer hat uns dann aufgeklärt: An dieser Stelle sei der Platz in der Nähe der Uni, der ( über den Förderschacht ) leicht zugänglich sei und dazu … und dazu die geringste Strahlenbelastung in weitem Umkreis böte, aus der Erde, aus den Baustoffen und aus dem All, der Messplatz diene zum Kalibrieren der Messgeräte auf Null!

Martin Holzherr,

nicht die langfristig beste Lösung wird gewählt, sondern die aktual preisgünstigste.

So gesehen hat die Fusionstechnik schlechte Karten, sie ist zu teuer.

Man denke auch an den Wust von Sicherheitsvorschriften.

Ich hatte es alle 4 Jahre mit etwa 600 Seiten neu überarbeiteten Sicherheitsvorschriften zu tun.

@hwied : Die Kosten der Fusionstechnik sind schlicht nicht bekannt.

Die Kosten von Windrädern und Solarpanel werden sehr stark ansteigen sobald die dafür benötigten Rohstoffe knapp werden.

Und die werden mit Sicherheit knapp. Weil es ja Unmengen davon braucht. Die deutsche Bundesregierung rechnet damit, dass sie bis zu 2% der Landesoberflöche mit Windrädern überdecken muss. Das tönt zuerst nach wenig, ist aber bei kirchturmhohen Windrädern recht viel.

In der Tat sind die Kosten der Fusionstechnik nicht ganz leicht abzuschätzen, aber es gibt natürlich auch Studien dazu: vor allem wird hierbei untersucht, wie der Strompreis skaliert mit einigen Parameters eines Fusionskraftwerks, beispielsweise dem Plasma-Beta, was in etwa angibt, wieviel Plasma man pro Magnetfeld bekommt. Skaliert man von ITER zu DEMO und nimmt dieses als Kraftwerk an, so landet man bei Strompreisen die in unser heutiges Stromnetz passen. Aber da gibt es eben noch einige Parameter, denen man noch ein paar Freiheiten zugestehen muss. Sollten sich die Hochtemperatur-Supraleiter bewähren, könnte diese beispielsweise den Preis drücken (weil man dann mehr Magnetfeldstärke pro Spule bekommt und so auch “mehr” Plasma, soll heißen besseren Einschluss), um nur mal einen Punkt zu nennen.

Karl Maier,

bei einem dichtbesiedelten Land wie Deutschland sind ihre Argumente richtig. Wir können ja auch Technologietransfer betreiben. In Spanien ist genug Platz für Speicherkraftwerke. Die können tagsüber mit Solarenergie das Wasser hochpumpen und nachts wieder ablassen.

Die “Technologie” von Pumpspeicherwerken ist Allgemeingut, da können/brauchen wir keinen Technologietransfer betreiben. Die Frage ist einerseits die Geographie ( genügend Platz bei genügend großem Höhenunterschied ), und abgesehen von Wasser andererseits, warum “die Spanier” ihr Land dazu nutzen sollten, um Strom an D zu verkaufen, anstatt ihn selber zu nutzen. Dazu müssten “die Franzosen” bereit sein, Stromtrassen zu erdulden, die den Strom von Spanien durch Frankreich hindurch nach D leiten. Und wie kommt der Strom von der deutschen Grenze ins Landesinnere, wenn wir schon nicht mal “Südlink” so richtig hinkriegen?

Karl Maier,

, Sie haben es ja angedeutet, meine Vorschläge dienten nur dazu darüber nachzudenken, dass wir uns in der EU befinden, das hat sich bei den Energielieferanten noch nicht herumgesprochen, da herrscht Konkurrenzdenkenken vor. Und im Falle Ostseepipeline ist sogar der Frieden in Gefahr.

Meine Meinung: Die Ostseepipeline hat neben der Ukraine die Stimmung in der EU ziemlich vergiftet.

Ein Hauptfehler war, dass Frau Merkel die Interessen der Polen ignoriert hat.

@hwied (Zitat): Ein Hauptfehler war, dass Frau Merkel die Interessen der Polen ignoriert hat.

Auch die Interessen der Ukrainer wurden ignoriert. Oder zählen sie die Ukraine bereits zu Russland.

Martin Holzherr,

die Geschichte beginnt nicht bei 0.

Russland und Ukraine gehörten mindestens 500 Jahre zusammen.

Ob freiwillig oder unfreiwillig kann ich nicht klären.

Auf jeden Fall ist der Beitrittsantrag der Ukraine zur Nato eine ernste Sache, die wir auch ernst nehmen sollten. Wir haben zu lange ohne Krieg gelebt und uns an die Sicherheit gewöhnt. Die Benzinpreise stagnieren gerade, aber der Dax sinkt. Das ist ein schlimmes Ohmen.

Man sollte das Problem mit Fingerspitzengefühl angehen und nicht Truppen nach Polen senden. Das ist ein falsches Signal.

@hwied: Sie gehören zu den nicht wenigen Deutschen, die Putin eine Einflusssphäre im Osten zugestehen und die auch China (xi jinping) das Recht für einen Einmarsch in Taiwan geben.

Warum ist das so? Mir scheint folgende Erklärung naheliegend. Deutsche fühlen sich als grosse Nation (80 Millionen Einwohner) und sie gestehen grossen Nationen mehr Rechte zu als kleinen und schwachen. Der russische Bär darf also schon einmal seine Pranken über den Hag ausstrecken und China als Weltmacht eine paar Nachbarn zertrampeln.

Weil das so ist bin ich schon lange dafür, dass man Grossstaaten auflöst. Für das Grosse sorgt dann die UNO.

@Holzherr 06.02. 13:37

„Übrigens: Sogar sämtlicher hochradioaktiver Abfall, der in Kernspaltungsanlagen (Atomkraftwerken) bis jetzt erzeugt wurde, hat in zwei Gebäuden der Grösse eines Walmarts Platz.“

Und doch zuviel, um es auf dem Mond endzulagern. Der Transport wäre zu teuer. Aber nicht zu viel, um alles in ein Endlager zentral für die ganze Welt zu deponieren.

Aber wer will das haben? Das Giftpotential ist unbeschreiblich. In Tschernobyl hat der Reaktorinhalt eines einzigen Betriebsjahres eines einzigen Reaktors eine Fläche von ca. 60 x 60 km auf Jahrtausende unbewohnbar gemacht. Und wir haben 440 KKWs weltweit mit je etwa 40 Betriebsjahren. Das gibt ein Giftpotential von 440 x 40 = 17600 Reaktorkatastrophen, das alles in diese zwei Walmarts passt. Und wenn man tatsächlich das Klimaproblem mit KKWs lösen will, wird das ganz schnell noch sehr viel mehr.

Dagegen ist die Kernfusion wohl recht harmlos, wenn man das Material, dass verstrahlt werden kann, so wählen kann, dass durch den Neutroneneinfang keine langlebigen Radionuklide entstehen. Im Betrieb könnte das aber durchaus schwierig und kostentreibend werden, wenn Anlagenteile so radioaktiv werden, dass man sich ihnen nicht mehr nähern kann.

Das Problem beim KKW-Atommüll ist dagegen ja gerade die Langlebigkeit. In 500.000 Jahren passiert mit einer Endlagerstätte geologisch gesehen womöglich allerhand. Senkungen, Hebungen, Eiszeiten, Erdbeben, Verwerfungen, Vulkanausbrüche etc., da mit muss man rechnen. Wenn sich die Lagerstätte im Jahr nur um 1 mm hebt, sind das in 500.000 Jahren 500 m. Wenn dann da z.B. noch Eiszeitgletscher drüberrutschen, und anfangen die Lagerstätte zu destabilisieren oder gar wieder auszugraben, dann ist es zu spät, dann ist der Schaden gigantisch.

@Tobias Jeckenburger: Langlebigen hochradioaktiven Abfall wandelt man am besten in kurzlebigen um. Transmutation nennt man das. Es sind nur gerade schwere Elemente (Aktiniden oder Transurane genannt) welche langlebig sind. Und wie transmutiert man sie?

Mit einem Kernfusionsreaktor. Denn der liefert genau die starken Neutronenflüsse, welche die Transmutation ermöglichen.

Einen Teil der Antworten geben Sie ja schon selbst:

Wenn sich in 500 ka die Endlagerstätte bis zur Erdoberfläche vorgearbeitet hat ( oder die Erdoberfläche hinunter … ), wie viel von dem einstmals strahlenden Abfall ist dann noch vorhanden?

Zu dem Thema habe ich mal eine interessante Ausführung gehört:

Man vergräbt das Endlager etwa 500 Meter unter der Erde, zugänglich nur durch einen Schacht, der später verfüllt wird. Oben bringt man eine Tafel an ( aus Titan zB ), auf der ( Stein von Rosetta ) in verschiedenen Sprachen auf das Endlager unter Tage hier an dieser Stelle hingewiesen wird, dazu platziert man Informationen darüber in möglichst vielen Bibliotheken.

Fall a): Solange der Staat existiert, kann er überwachen, dass da niemand ein Loch gräbt…

Fall b): Falls der Staat nicht mehr existiert und da ein Spinner mit bösen Absichten später mal an das Material ‘rankommen will, so ist er ein Spinner, denn es gibt leichter zugängliche Vorräte mit besser für Missetaten geeignetem Material …

Fall c): Die Überlieferung ist abgerissen, es kann niemand die Schrift auf der Tafel lesen oder die Tafel ist weg, und jemand will ausgerechnet da ein tiefes Loch graben – wenn die Überlieferung so abgerissen ist, fehlt auch die Technik, ein tiefes Loch zu graben …

Fall d): Die Überlieferung ist abgerissen, eine Technik wurde entwickelt, um ein tiefes Loch zu graben, und man fördert so ein komisches Zeug zutage, wo die Personen dann schnell krank werden und einige sterben – wenn man dann kein Spinner ist, würde man das Loch aus Eigenschutz sofort wieder zumachen und eine Tafel zur Warnung anbringen …

Ich denke, dass wir uns mit der Langzeitwirkung eines Endlagers zu viele unnütze Gedanken machen, die näher liegende Probleme sind, ein solches Endlager werkstoff- und temperaturmäßig für einen stationären Zustand für die kommenden 500 Jahre zu bauen, wenn das gelingt, ist es quasi “dauerfest”, dann kann uns nur noch die Geologie ärgern. Die Salzdome in Norddeutschland existieren seit dem Perm ( Zechstein, ~ 270 Millionen! Jahre ), das ist ~550x so lange, wie wir schätzen, dass das Endlager sicher sein muss.

Ähnliche Ausführungen habe ich auch mal gelesen, das ist ein ganz eigenes Forschungsgebiet (wie man über viele, viele Generationen hinweg die Nachricht/Warnung einer gefährlichen Lagerstätte erhalten kann).

@Maier 07.02. 17:18

„Wenn sich in 500 ka die Endlagerstätte bis zur Erdoberfläche vorgearbeitet hat ( oder die Erdoberfläche hinunter … ), wie viel von dem einstmals strahlenden Abfall ist dann noch vorhanden?“

Bei einer Halbwertszeit von 50.000 Jahren hätten wir in 500.000 Jahren nach dann 10 Habwertszeiten immer noch 0,1% des Problems. Aus 17600 Reaktorkatastrophen an Giftpotential bleiben immer noch 17,6 übrig. Auch dass will niemand haben. Und wenn es nach 250.000 Jahren schon schief geht, haben wir noch ca. 3% und damit 528 Reaktorkatastrophen auf Lager. Das wird kein nur lokales Problem sein.

„…ein solches Endlager werkstoff- und temperaturmäßig für einen stationären Zustand für die kommenden 500 Jahre zu bauen, wenn das gelingt, ist es quasi “dauerfest”, dann kann uns nur noch die Geologie ärgern. Die Salzdome in Norddeutschland existieren seit dem Perm ( Zechstein, ~ 270 Millionen! Jahre ), das ist ~550x so lange, wie wir schätzen, dass das Endlager sicher sein muss.“

Ich fürchte ja gerade, dass die Geologie uns ärgern wird. Ich bin kein Geologe, aber die Salzstöcke werden vermutlich über die Hunderttausende von Jahren immer wieder gequetscht, verschoben oder gebrochen, und in diesem Zuge immer wieder auch Salzmasse durch Grundwasser verlieren, dass angesichts von aktiven Verwerfungen einsickert und woanders wieder zutage tritt.

Gerade ein Endlager für sehr viel Atommüll wird sich im Laufe der Jahrtausende immer weiter aufheizen, und dann Grundwasser aufsteigen lassen, dass als warme Quellen die Oberfläche erreicht, und damit dann das riesige Giftpotential freisetzt.

Ich hätte wirklich keine Lust, unserer Nachwelt solche Risiken zu hinterlassen. Ich würde mich eher für eine einfache Lagerung der Castoren in Hallen aussprechen, bis uns was besseres als Vergraben einfällt.

Also etwa eine Aufarbeitung der abgebrannten Brennstäbe in verschiedene Fraktionen. Eine Fraktion kann spaltbares Material sein, das in KKWs dann wieder verwendet werden kann. Eine andere Fraktion kann Atommüll mit relativ kurzen Halbwertszeiten sein, das kann man in Endlagern vergraben. Und wenn noch eine Fraktion übrig bleibt, die langlebig und nicht spaltbar ist, kann man die dann auf den Mond bringen. Oder transmutieren, wie @Holzherr das vorschlägt. Je nachdem, was billiger ist.

Wenn die Zivilisation in den nächsten 50 Jahren schon zusammenbricht, stehen die Castoren dann immer noch in den Hallen herum. Das ist sicher auch nicht gut. Aber ansonsten wird es irgendwie gehen, aber eben eher teurer als gedacht. Das sollte man einpreisen, und nicht einfach dem Steuerzahler überlassen.

Gute Lösungen für den hochradioaktiven Abfall sind

1) Transmutation von langlebigen zu kurzlebigen Radionukliden

2) Sehr tiefe Entsorgung durch ein mehrere tausend Kilometer tiefes Bohrloch

Zu 2): Heute ist die Entsorgung in mittlere Tiefen geplant oft kombiniert mit Rücknahmefähigkeit. Doch eine Entsorgung in sehr grosse Tiefen hat gegenüber der Entsorgung in mittlere Tiefen weitere Vorteile. So gibt es in sehr grosser Tiefe eine andere chemische Umgebung und es ist eine dauernde Isolation von der Umwelt garantiert. In der Wikipedia liest man dazu:

Die Lösung 1) nämlich die Tramsmutation von langlebigem zu kurzlebigem Abfall wird durch Neutronenbestrahlung ermöglicht und eine ideale Neutronenquelle ist ein Kernfusionsreaktor.

Sie sind in der Tat kein Geologe.

Die Salzdome in Norddeutschland sind seit ihrer Entstehung ungestört, sie existieren auch nur deshalb, weil eben kein Grundwasser eindringt – und vor allem nicht abfließen kann. In einen Salzdom eindringendes Wasser erzeugt eine gesättigte Sole und damit ist Schluss, nur wenn diese Sole abfließen kann und neues Wasser eindringen, wird das Salz ausgelaugt. In einen geologisch gestörten Salzdom würde nur ein Schwachkopf ein Endlager einbauen – und ich persönlich habe auch Vorbehalte, was die Erschließung eines nativen Salszdoms ( unbeeinträchtigt von Bergbau ) “von oben” angeht, aber das ist meine persönliche Einstellung, ich würde seitlich weit genug weg einen Schacht abteufen, dann waagerecht bis unter die Sohle des Doms und dann von unten nach oben arbeiten.

Auch Ihre Vorstellung davon, dass sich das Endlager im Laufe der Jahrtausende immer weiter aufheizen würde, zeigt, dass Ihnen technische thermomechanische Vorgänge an sich fremd sind. Ich habe ganz bewusst von 500 Jahre und werkstoff- und temperaturmäßig für einen stationären Zustand und quasi “dauerfest” geschrieben, wobei “500 Jahre” je nach Umgebung ( Salz, Granit, Ton ) um den Faktor 5 – 10 zu hoch sein wird, aber ich will hier keine Diskussionen um den Begrif “thermisch stationärer Betrieb eines Endlagers” anzetteln.

Mich stört auch Ihre Wortwahl von den Reaktorkatastrophen, weil ein störungsfreier Betrieb mit “serienmäßigem” Brennstoffrestmüll eben keine Katastrophe ist, Sie erzeugen mit solcher Wortwahl nur “Stimmung”, die einer logischen und sachdienlichen Diskussion abträglich ist.

Sicher, je tiefer, desto sicherer könnte man annehmen. Aber was ist “tief”? Ich hatte da was in Erinnerung und habe nachgeschaut:

Die südafrikanische Bergbaugesellschaft AngloGold Ashanti baut dort in drei Bergwerken Gold ab. Die Gruben sind mit bis zu 4000 Metern Teufe die tiefsten der Welt.

Da stand auch was von Planungen bis 5.000 m Teufe, aber der Hinweis ist veraltet.

Die Technik existiert also, einen Schacht mit nennenswertem Querschnitt bis 5 km in die Tiefe zu graben und sogar Menschen dort arbeiten zu lassen, reicht das für ein Endlager mit begrenzten Aufenthalt des Personals?

Am sichersten schiene natürlich ein Schacht vor einer Subduktionszone, da würde das Material über die Zeiten in den Erdmantel abtauchen, wo es sowieso schon genügend davon gibt. Das Problem aber wäre, dass parallel in einem Abstand hinter dem “Ereignishorizont” Vulkane exitieren, die das erhitzte und wegen des mitgeschleppten Wassergehalts niedrig schmelzende Krustenmaterial wieder ausspucken …

Martin Holzherr

Die Kernkraft mit KKWs wird uns noch lange erhalten bleiben, schon als Quelle für Plutonium. Darum gibt es ja den Streit mit dem Iran.

Die Fusionstechnologie wird uns auch noch lange beschäftigen, wer die beherrscht, der kann die Welt wirtschaftlich beherrschen, weil sie ja billiger werden soll , ob das stimmt, bleibt noch offen.

Solche Langzeitprojekte können sich nur große Staaten leisten wie die USA, Rußland oder China.

Und damit sind wir bei der politischen Seite, solche Staaten konkurrieren eben nicht nur wirtschaftlich, sondern auch militärisch. Rußland wollte ja ein eigenes GPS System aufbauen, man hört gar nichts mehr davon.

Jetzt zu ihrer Bemerkung mit dem Zugeständnis an Rußland,, ich selbst bin sogar nachträglich gegen die Deutsche Reichsgründung 1871, die war die Ursache für die Weltkriege des 20. Jahrhunderts.

Rußland fühlt sich als Rechtsnachfolger der Sowjetunion

und das kann man nicht ignorieren, wenn man an friedlicher Koexistenz interessiert ist. Es ist schon schizophren, dass China unser Welthandelspartner ist und gleichzeitig jammern wir über die Einschränkung der Bürgerrechte in Honkong.

Den weiteren Kommentar erspare ich Ihnen.

@hwied: Wirtschaftlich kann man mit fast allen Ländern verkehren, denn Güter und Dienstleistungen austauschen bedeutet auch mindestens in einem Bereich Vertrauen aufbauen. Wenn aber Länder andere bedrohen dann sollte man dem entgegentreten und das ganz unabhängig davon ob der Bedroher ein kleines oder ein grosses Land ist.

In meinen Augen ist ein wichtiger Zweck der UNO gerade der, jedem Mitgliedsland einen gewissen Schutz zu gewähren. Einen Schutz durch Rechtsgarantien. Es fehlt bei der UNO nur noch die nötige Macht um diese Rechtsgarantien durchzusetzen.

Martin Holzherr,

es ist sehr gut, dass es die UNO gibt. Was hätte Chrustschow gemacht, wenn er nicht mit seinem Schuh auf das Pult hätte schlagen können.

Die Israelis sehen in der UNO das Symbol internationalen Versagens.

Die Chinesen sind wenigstens bemüht den schönen Schein aufrecht zu erhalten.

Auch Putin gibt sich Mühe, er hat ja eine schöne Frau, Macron verbreitet derweil Optimismus.

Was man von Biden halten wird, wir werden es noch erleben. DT war in Bezug auf Rußland eindeutig.

Um beim Thema zu bleiben, wer wird als Erster “Heureka” bei der Fusionstechnik schreien.?

Die kalte Fusion war ja auch schon ein Thema.

@hwied: sie verbreiten hier eine deutsche Bierstubengemütlichkeit in der sich auch Leute wie Gerhard Schröder und Gestalten, die sich auf Gewohnheitsrecht berufen, wohl fühlen würden

Im Zusammenhang mit der „unendlich“ vorhandenen Windenergie hätte ich eine Frage an Physiker, Klimawissenschaftler, Meteorologen…

Vor vielen Jahrzehnten habe ich im Geographieunterricht gehört, dass z.B. hauptsächlich die Winde, die vom Golf von Biskaya (Wetterküche für Zentraleuropa) ausgehen, zu „schwach“ sind, ausreichend Wolken, z.B. in die Steppenlandschaft Ungarns (Puszta) zu „treiben“. Genau deswegen die Gegend unter Wassermangel leidet.

Bedeutet, wenn Frankreich ebenfalls seine Ostküste mit Windrädern vollpflastern würde, massiv Windenergie entzogen würde, wie in D an der Nordküste, sollten diese Steppengebiete noch größer werden, zumal länger dauernde Trockenperioden zum Schaden der Vegetation zumindest noch länger dauern würden.

Ist die These haltbar, dass der Energieentzug durch Windenergie zu vernachlässigen ist? Dass mit Sicherheit keine Probleme wie Trockenheit auftreten können?

Elektroniker

08.02.2022, 15:10 Uhr

Es ist bekannt, dass eine “raue” Oberfläche bremsend auf die randnahe Strömung wirkt.

Das nutzt man beispielsweise im flachen Norddeutschland schon lange mittels Hecken und “Knicks” ( Ackerrandbewuchs ) aus, um die Bodenerosion durch den Wind zu vermindern, in England und Irland baut man Steinwälle dafür. Wälder haben auch eine bremsende Wirkung, das wäre für eine WKA-Anlage dann ein Problem, wenn der Rotor im unteren Durchgang quasi die Baumwipfel streift, das gäbe einen schlechten Wirkungsgrad. Deshalb baut man ja auch die WKA in den Wäldern mit ~ 150 – 200 Meter Nabenhöhe, da ist schon der Wind deutlich ungestörter. Es gibt auch einen geografischen Einfluss, in einer alten Publikation habe ich mal gelesen, dass die mittlere Windstärke an der Nordseeküste etwa der in den deutschen Mittelgebirgen bei ~ 500 – 800 Metern entspräche und noch weiter weg im Alpenraum stiege diese Grenzfläche auf ~ 1.500 Meter an.

Also keine Sorge, der Wind, der an der französischen, belgischen, niederländischen und deutschen Küste weht, schafft es nie bis Ungarn, ob da nun WKA stehen oder nicht.

Wenn Sie den Einfluss einer “Windbremse” sehen wollen, schauen Sie mal auf die Niederschlagshöhenkarte von Mitteldeutschland – im Wind- und Regenschatten des Harzes liegt beispielsweise Erfurt, wo man durchaus landwirtschaftlichen Nutzen aus den Harzföhn bedingten Umständen zieht.

Na. also die Steinwälle sind eher der Not geschuldet, das die in den Wällen liegenden Steine vorher einst weit gestreut in der Gegend rumlagen und Landwirtschaft unmöglich machten. Das Phänomen ist auch in Schweden überall zu sehen, wo wirklich auch überall Steine rumliegen und man mit dem Spaten kaum ins Erdreich kommt.

Das die Wälle dann auch Winde ableiten, die sonst über die Fläche gehen würden, ist damals kein Thema gewesen.

Wir sollten unsere Vorfahren nicht für dämlich halten, nur weil sie weniger “gewusst” haben als wir heute ( meinen zu wissen ).

Sicher lagen die Steine auf dem Feld “im Weg”, aber in Norddeutschland habe ich gesehen, dass diese nicht sorgfältig zu Wällen am Rand der Felder aufgeschichtet wurden, sondern auf einer Art Abfallhaufen irgendwo nebenan abgelegt waren.

Wir können von hier und heute aus nur raten, was Henne und was Ei war.

Mit Intelligenz oder Schläue hat das alles wenig zu tun. Behaviorismus und Notwendigkeit und praktische Vernunft ist da eher wirksam. Steinwälle um eine Fläche sind mit erheblich weniger Arbeit verbunden, weil die Steine kürzere Strecken bewegt werden müssen.

Zentrale Haufen dagegen müssen einen höheren Sinn gehabt haben, der ideel es sinnvoll erscheinen liess, sie nicht nur an den nächsten Rand einer Fläche zu wuchten.

Was norddeutsche Steinhaufen angeht, kann damit zu tun haben, das Steine auch Baumaterial sind (auf den brit. Inseln kennt man sehr viele Feldsteinhäuser aber in Norddeutschland höchstens Kirchen aus Feldsteinen) und im norddeutschen Sediment-/Schwemmland eben eher selten sind. Daraus ergibt sich, das Norddeutsche die Steine zentral sammelten, um Gemeindeinteressen damit zu ermöglichen (Kirchenbau), während auf den Inseln sie sowieso überall rumlagen und sogar üblicherweise Wohnhäuser für Menschen damit gebaut werden konnten.

“Intelligenz”, die gegen den Wind Steinwälle bauen wollen würde, ähnelt der Intelligenz, die sich zur Aufgabe machte, einen Fells auf den Berg zu wuchten und nach Misserfolg es immer wieder versuchen täte.

Wenn ich also konstatiere, das die briten damals pure praktische Vernunft walten liessen, als sie Steinwälle bauten, kommt man vielleicht auch auf Stonehenge, deren Steine 200 Kilometer über Land und Meer transprotiert sein sollen (geologisch bestätigt).

Welche praktische vernunft oder Intelligenz das wohl veranlasst hat?

Die Antwort ist darin zu sehen, das die “blauen Steine” von Stonehenge aus einer Region stammen, in der signifikant erhöhte Werte von Radioaktivität gemessen werden kann (welche in den blauen Steinen enthalten ist).

Schwermetalle haben einen subtilen Einfluß auf unser Gehirn und Bewusstsein und erzeugen neben anderen Symptomatiken auch Religiösität und Ideologiiserung. Aus solchen Konstitutionen geht der Hang zum Symbolischen einher.

Deswegen hat das damals expandierende Volk in Wales Steine bis nach Südosten transportiert, wo sich eine Gruppe aus Wales ansiedelte. Der Stein (der blaue Stein) war ihnen heilig, und mit ihm wurde Macht und Erfolg verbunden oder auch nur ein gutes Gefühl (was sich durch die neuronale Manipulation erklärte). Das war einerseits Ideologie, aber andererseits eben auch Tatsache. Wissen, wie das genau zusammenhängt, konnten das die Menschen damals nicht.

Aber in ihnen war die Saat des Symbolischen aufgekeimt und unmittelbar mit dem “blauen Stein” verknpüft

Und so war der Limes kein physisches Bollwerk gegen einfallende Barbaren, sondern ein Zeichen, ein symbolisches Bollwerk, das ein Signal senden soll. Die Chinesissche Mauer war es grundsätzlich genauso, aber die Chinesen haben diese Mauer in einem gewissen Größenwahn gleich wirklich groß gebaut. Abgehalten hat es die Mongolen aber dann doch nicht.

Und den Wind hätten 50 cm Wälle auch nicht abgehalten, was die Menschen damals sicher schnell erkannt hätten – auch ganz ohne Intelligenz und dem Fetisch dazu, sich aus promille-Werten Wirkungen zu versprechen, die sie aus purer Ansicht für unmöglich ansehen und die praktische Vernunft sie auch gar nicht damit aufhalten liess, wie in der Moderne allem mit Intelligenz begegnet werden will, wo Ethik, Moral und Redlichkeit (praktische Vernunft also) ausreichte, um Probleme zu lösen.

@Elektroniker 08.02. 15:10

„Ist die These haltbar, dass der Energieentzug durch Windenergie zu vernachlässigen ist? Dass mit Sicherheit keine Probleme wie Trockenheit auftreten können?“

Ich schätze mal, dass es kein Problem wäre, in Wettersimulationen die derzeitigen und zukünftigen Windräder so einzubinden, dass sich klären ließe, ob hier eine Wetteränderung aufgrund der Windenergienutzung stattfindet.

@Unkraine offtopic

Einmischungen in Bürgerkriege empfehlen sich meistens nicht. Dass Russen in die Krim und den Dombas einmarschiert sind, ist eher ok, immerhin leben dort mehrheitlich Russen. Wir haben mit der Ukraine nichts vergleichbares zu tun, außer das hier Gasleitungen verlegt sind, die Russisches Gas auch zu uns bringen.

Dass die USA selten länger als ein Jahr ohne konkreten Feind auskommen, ist natürlich für uns als Nato-Mitglied zuweilen ärgerlich, und in diesem Fall auch gefährlich. Auch ein Wirtschaftskrieg, der uns von der russischen Gasversorgung abscheidet, könnte erhebliche Auswirkungen haben. Die USA haben uns vor etlichen Monaten angeboten, dass auch sie uns gerne mit Erdgas beliefern würden. Nicht dass das hier der eigentliche Grund für die aktuellen Spannungen ist.

Wenn im Vorfeld von Kriegen der CIA was von sich gibt, dann kann man dem jedenfalls erfahrungsgemäß leider nicht vertrauen. Ich frage mich auch, was Russland mit der Westukraine anfangen will. Da ist recht wenig zu holen, scheint mir. Ein Interesse, einen Frieden zu schließen, und die besetzten Gebiete dabei zu behalten wäre allerdings ziemlich nachvollziehbar. Ich fände das jedenfalls eine gut Idee, immerhin leben dort mehrheitlich Russen. Nach 7 Jahren Krieg könnte man das mal beenden, finde ich.

@Tobias Jeckenburger (Zitat): Dass Russen in die Krim und den Dombas einmarschiert sind, ist eher ok, immerhin leben dort mehrheitlich Russen.

Genau mit dem gleichen Grund hat Hitler in der Tschechoslowakei eingegriffen, weil dort vor allem Deutsche lebten.

Deutschland liefert an Saudiarabien tödliche Waffen für den Krieg in Jemen, nicht aber an die Ukraine, denn die Russen als Freunde Deutschlands sollen geschont werden.

Im Donbass starben schon mehr als 15‘000 Menschen und für viele Deutsche ist das ok.

Deutschland sympathisiert mit alten Mächten wohl aus einer Art Sentimentalität. Doch was für eine Sentimentalität ist das. Ich erinnere mich an einen alten Gymnasiallehrer, der erzählte wie sie in der Wehrmacht im Osten Männer an den nächsten Baum geknüpft haben während sie ihre Frauen zu Tode gefickt hatten. Sentimentale Erinnerungen halt einfach.

Die Natur (das Universum) kompensiert ihre Ineffiziens durch Effektivität.

Deswegen mag es so scheinen, das man auf der Erde eine wirtschaftliche Kernfusion hinbekommen kann. Also eine Fusion, die mehr Energie freisetzt, als sie zur Auslösung verbraucht.

Allerdings widerspricht es nach meiner Auffassung trotzdem noch der anerkannten Aussage darüber, das ein echtes perpetuum mobile physikalisch unmöglich ist.

Wie kann der Widerspruch aufgelösst werden?

Ein Kernfusionsprozess ist ja kein perpetuum mobile, es wird einfach nur eine Energieform in eine andere umgesetzt: beim Verschmelzen zweier leichter Atomkerne, wird Bindungsenergie frei, und zwar in Form von Bewegungsenergie, also Wärme, und das ist im Grunde auch schon alles. Es ist nur ganz grob einen Faktor 10^6 effizienter als chemische Energiefreisetzungsprozesse, da hier die Atomkerne betroffen sind und nicht die Atomhüllen.

Das perpetuum mobile als Prinzip/Maschine, die mehr Kraft erzeugt, als sie zur Krafterzeugung aufwenden muß, ist ja nur die symbolische Darstellung dessen, für was dieses Prinzip stehen soll und das es physikalisch nicht funktionieren können soll.

Prinzipiel muß diese Annahme auch für die Kernfusion gelten. Es sei denn, das situative Besonderheiten im Prozess auf der Erde eine Fusion durch Bedingungen effizienter erzeugen können, als sie das ganze Sonnensystem bedingen und also diese auf der Erde erzeugte Fusion effizienter abläuft, als in der Sonne.

Nicht unmöglich, aber doch irgendwie fantastisch.

Und ob dann sogar mehr Energie erzeugt werden kann, als aufgewendet werden muß, ist ebenfalls unwahrscheinlich.

Was an ihrer Einlassung auf meinem Kommentar steht dafür, das meine Zweifel in der Sache widerlegt wären?

Tatsächlich ist die auf der Erde ablaufende Fusion um Größenordnungen effizienter als in der Sonne. In letzterer läuft überwiegend die Proton-Proton-Kette, wo es für ein einzelnes Proton ca. 10^10 Jahre dauert, bis es auf ein zweites Proton zum Fusionieren trifft. Die Deuterium-Tritium-Fusion hat bei ähnlichen Bedingen einen ca. 10^26 höhere Wahrscheinlichkeit einzutreten, als die Proton-Proton-Fusion.

ich halte die Fusion auch nicht für die Energieerzeugung der Zukunft. Jedenfalls dann nicht, wenn sie systembedingt mit konventioneller Turbinentechnik kombiniert werden muß, um Wärmeenergie in Drehimpuls umzuwandeln. Was üblicherweise mit Wasserdampf getan wird. Das ist das Prinzip same old same old… nur mit noch heisserem Feuer. Und die Wärmenergieerzeugung hat auch ganz unabhängig vom CO2-Problem Einfluß auf das Klima und die Atmosphäre. Und von den Flüssen und Meeren ganz abgesehen. Es ist letztlich egal, ob die Wärmeenergie durch die Verbrennung von fossilen Rohstoffen mit dem CO2 in die Atmosphäre kommt, oder mit Wasserdampf. Sie ist dann da und bewirkt gleiches, wie beim CO2-Problem.

Vom Prinzip her müsste man eine Art Fusion oder Atomreaktion auslösen, aus der direkt Elektronen hervorgehen, die einen Stromfluß für die Energieversorgung erzeugen.

Mir scheint das nicht unmöglich.

Die sollen natürlich trotzdem daran arbeiten, eine Kernfusion kontrolliert erzeugen zu können. Das wären dann allerdings mehr Forschungsreaktore, anstatt Kraftwerke zur Energieerzeugung.

Tatsächlich existierende Forschungsansätze, wo man Fusionsprozesse in Reaktoren fährt, bei denen keine Neutronen entstehen, sondern ausschließlich geladene Teilchen, die man dann in einem elektrischen Feld abbremsen kann um so die Energie zu gewinnen. Nachteil all dieser Reaktionen ist allerdings, dass sie eine wesentlich höhere Temperatur erfordern, als das bei der Deuterium-Tritium Fusion der Fall ist. Letztere gilt es also als erstes zu meistern, danach können wir dann weitermachen 🙂

Ich würde die Fusion, wie sie derzeit angestrebt wird (und nur in Verbindung mit Umwandlung in Drehimpuls funktioniert) ganz konkret nur als Forschungsgegenstand verfolgen, aber die Energieerzeugung sowieso mit anderen Konzepten verfolgen. Jede Zukunftsvision, das “diese” Fusion die Energieerzeugung der Zukunft sein wird, sollten also vernunftsbedingt unterlassen werden. Denn ein nur noch heisses Feuer für die traditionelle Turbinentechnologie/Wasserdampferzeugung macht aus vielen Betrachtungen keinen Sinn. Darunter sind auch schlicht ökologisch kritische Gründe (Erwärmung der Biotope an Flüssen, Seen und Meeren).

Technologiekonzeptionel und Zukunftsvisionär macht ein Wasserdampfkraftwerk auf einem Raumschiff so viel Sinn, wie der Daumen zum Nasebohren. Nicht unmöglich, aber unpraktisch.

Prinzipiel scheint man diese Fusion nun ja schon “gemeistert” zu haben. Weshalb es jetzt genau richtig wäre, den einen Weg auf ein Forschungskonzept zu reduzieren, und den anderen Weg (direkte Potentialerzeugung) massiv zu verfolgen.

@ Karl Maier 08.02.2022, 18:09 Uhr

Ich habe weniger Effekte der Bodenerosion gemeint, die das Problem natürlich noch einmal komplexer machen.

Vermutlich wird das Wasser im Prinzip von Winden vom Meer in das Landesinnere „getrieben“. Möglicherweise in den Pol näheren Bereichern eher mehr (vom Jetstream angeregt?) als in den Äquatorzonen.

Möglicherweise spielen in den Grenzbereichen (Meer – Land) auch sich z.B. durch Windräder verursachte, aufschaukelnde Wirbel eine Rolle. Da könnten sehr viele und sehr große Windräder, zumindest zu bestimmten Zeiten, Einfluss auf den „Wolkentransport“ nehmen.

Interessant wäre es auch, eine Art „Wirkungsgrad“ des Systems zur Stromgewinnung zu kennen. Es wäre denkmöglich, dass sehr viel Windenergie nötig ist, die sozusagen beim „Wolkentransport“ fehlt, um relativ wenig elektrische Energie zu gewinnen, der „Wirkungsgrad“ sehr schlecht sein könnte.

Das könnte verhängnisvoll sein, wenn man künftig rund 50 % des Weltenergieverbrauches durch Wind substituieren möchte.

In der Sahara gibt es offenbar praktisch keine Wolken, keinen Regen. Würde es regnen, würde das Wasser sofort verdunsten.

Bei Google habe ich nur gefunden, dass es wissenschaftliche Arbeiten gibt, die eine gewisse geringe Bodenerwärmung in der Nähe von Windparks belegen.

Die von mir erwähnte verminderte Winderosion ( siehe auch https://www.spektrum.de/news/agroforst-die-renaissance-der-ackerbaeume/1981693 ) sollte nur darauf hinweisen, dass es durchaus Strömungsbremsen gibt. Auch die Tatsache, dass eine WKA theoretisch maximal 49% ( technisch weniger ) aus der Strömung des Windes gewinnen kann, weist ja darauf hin, dass hinter der Anlage eben diese 49% dem Wind “fehlen” ( und der Wind in einer Wirbelschleppe abläuft ). Das gilt aber nur für die Menge der Luft, die durch die Fläche des Rotorkreises geht.

In der Sahara gibt es zwar kaum bis keinen Regen, aber es gibt dort auch keine Bäume und auch keine WKA – insofern hat es andere Gründe, warum es dort nicht regnet. In der Zeit, als wir “Eiszeit” hatten, soll die Sahara grün gewesen sein und noch in römischer Zeit war Nordafrika die Kornkammer Roms. Heute gibt es durchaus noch viel Wind in der Sahara, so viel, dass der Straub von dort bis zum Amazonasbecken getragen wird und dort die Pflanzen düngt.

Sicher sind in Spanien viele Bäume für den Schiffsbau abgeholzt worden, aber dass dort nicht wieder Bäume nachgewachsen sind, hat was mit dem Klima allgemein und nichts mit WKA zu tun.

Die Erkenntnisse über den Einfluss von Windparks habe ich auch gelesen, es geht aber dort eben nur um die “Nähe”. Ich möchte es mal so formulieren: Wenn wir einem Teil des Windes knapp 49% der Energie entziehen – von nichts kommt halt nur nichts.

@Köhn-Seemann 08.02. 21:13

„…,sondern ausschließlich geladene Teilchen, die man dann in einem elektrischen Feld abbremsen kann um so die Energie zu gewinnen.“

Das wäre ja ganz genial, wenn das möglich wäre. Das erspart ja nicht nur den Aufwand an Turbinen und Generatoren, sondern verdoppelt auch gleich den Wirkungsgrad.

Und wenn wir das dann in interstellaren Raumschiffen nutzen, brauchen wir auch nicht mehr die Abwärme loswerden, die sonst bei der Stromerzeugung über Dampf anfällt. Nebenbei kann dann auch die erzeugte Fusionsenergie direkt dazu genutzt werden, um einen Antriebsstrahl von sehr hoher Geschwindigkeit zu erzeugen, ohne die Energie überhaupt erst in Elektrizität umzuwandeln. Das ist jetzt ja echt mal Technik, die begeistert.

Die Bor11-Proton–Reaktion erzeugt ja schonmal keine Neutronen, die die Atome der umgebenden Anlagenteile einfangen, und dann radioaktiv davon werden können. Was die Radioaktivität noch angeht: Erzeugt denn das Fusionsplasma bei mehr als 100 Mio Grad nicht auch Gammastrahlung, die von Atomen der Umgebung absorbiert werden kann?

Das Wärmeproblem bestünde weiterhin. Da Abwärme nicht über Gase abgeleitet werden können, muß sie über Strahlung abgegeben werden. Was andere Probleme aufwirft, wenn Menschen in der Nähe sein müssen/sollen (Wie das so auf einem Raumschiff sein soll).

Das man eine Fusion auch dazu nutzen kann, direkt gerichtete Impuls-Antriebskraft zu erzeugen, ist mir noch nicht in den Sinn gekommen.

Nukleare Fusion: Methoden und Firmen

Nukleare Fusion bedeutet das Verschmelzen von Atomkernen unter Abgabe von Energie. Die beiden Wasserstoffisotope Deuterium und Tritium verschmelzen beispielsweise bei hoher Temperatur (100 Millionen Grad) oder/und hohem Druck zu Helium und es werden Neutronen dabei freigesetzt. Bei hoher Temperatur bilden Deuterium und Tritium ein elektrisch leitendes Plasma (leitet so gut wie Kupfer) und Fusionsreaktoren nutzen das aus.

Es gibt folgende Methoden zur nukleare Fusion in einem Gemisch von Deuterium und Tritium:

– Langanhaltender Magnetischer Einschluss in donutförmigen Ring 🍩 für Minuten bis Stunden. Tokamaks und Stellaratoren nutzen dies. Je stärker das Magnetfeld desto kleiner können Tokamaks und Stellaratoren sein. Tokamaks sind hochsymmetrisch aufgebaut und erzeugen im Betrieb einen elektrischen Strom im Plasma, Stellaratoren jedoch sind kompliziert verdrehte Ringe ohne elektrischen Strom im Plasma, die aber im Gegensatz zu Tokamaks einen Dauerbetrieb ermöglichen.

– Trägheitseinschluss 🎾des Plasmas, das in einer nur hundertstel Sekunden dauernden Kompression eines Brennstoffkügelchens entsteht, wenn es bestrahlt oder mit Teilchen beschossen wird. Die Laserfusion direkt (UV-Laser) oder indirekt (Umwandlung von Licht in Röntgenstrahlung) nutzt das. Von Fast Ignition spricht man, wenn zwei Lichtpulse benutzt werden, ein Lichtpuls für die Kompression des Brennstoffkügelchens und ein zweiter zum Zünden der Fusionsreaktion. Fast Ignition ermöglicht einen bis zu 10 Mal kleineren Laser.

– Erzeugen eines ringförmigen Plasmoids mit Field Reversed Configuration. 💍💨. Das ist ein kurzanhaltender magnetischer Einschluss und eine magnetische Kompression in einem Plasmoid, also einem rauchringartigen Plasma, zusammengehalten von geschlossene Magnetlinien. Anlagen erzeugen oft zwei Plasmoide, die aufeinander geschossen werden.

– Magnetized Target Fusion 💣 kombiniert Magnetfelder mit anderen Verfahren und fusioniert in schnell aufeinander folgenden Pulsen. Viele exotische Methoden gehören in diese Kategorie

– Z-Pinch➿: Selbstkompression des Plasmas durch einen viele Millionen Ampère starken elektrischen Strom, der durch das Plasma fliesst. Das erzeugt ein starkes Magnetfeld, das das Plasma komprimiert. Z-Pinch sind äusserst einfache Anlagen, die allerdings bis jetzt nie Fusionsbedingungen erreichen konnten, weil das komprimierte Plasma instabil ist und zur Seite ausweicht.

Nun zu einigen konkreten, jetzt im Aufbau befindlichen Fusionsanlagen.

Tokamak-Experimente 🍩:

– ITER ist ein Schwachfeld-Tokamak mit einem Aussenradius des Tokamakrings von 6.2 Meter und einem Plasmavolumen von 837 Kubikmeter (9x9x9 Meter). ITER erzeugt im Innern ein Magnetfeld von 5.3 Tesla (Tieftemperatur-Supraleitung) . Es soll 2025 in Betrieb gehen und 2035 erstmals ein volles Fusionsplasma erzeugen.

– SPARC ist ein Starkfeld-Tokamak mit einem Aussenradius des Tokamakrings von 1.85 Meter hat ein Plasmavolumen von 20 Kubikmeter. Er erzeugt an der Spule 20 Tesla (Hochtemperatur-Supraleitung) und im Innern 12.2 Tesla. Das doppelt so grosse Magnetfeld von SPARC im Vergleich zu ITER hat eine 8 Mal so grosse Wirkung und ermöglicht es erst, dass SPARC so klein ist. SPARC passt ohne weiteres in ein Einfamilienhaus während ITER in einem 30x30x30 Meter grossen Gebäudekomplex sitzt. SPARC soll 2025 bereits ein volles Fusionsplasma erzeugen und sein Nachfolger ARC (Affordable RobustCompact) soll in den 2030er Jahren Energie erzeugen.

Stellarator-Experimente 🍩:

– Renaissance Fusion will einen Starkfeld Stellarator bauen, der mit Hochtemperatursupraleitung und einer Wand aus flüssigem Metall arbeitet. Das entspricht in etwa SPARC nur eben mit einem Stellarator anstatt einem Tokamak.

Plasmoid-Experimente 💨💍:

– Helion basiert auf zwei ringförmigen Plasmoiden, die aufeinander zuschiessen. Im Kollisionspunkt entsteht eine Vorstufe einer vollen Fusion mit sich stark ändernden Feldern, die von Helion direkt in elektrischen Strom umgewandelt werden soll. Helion will also ohne Dampfturbine auskommen und zudem soll nicht das radioaktive Tritium, sondern Helium-3 als Fusionsrohstoff eingesetzt werden. Helion will Helium-3 selber herstellen. Helion existiert schon lange und verspricht schon lange vieles.

– TAE Technologies hat einen Ansatz, der dem von Helion stark ähnelt, der aber auf einfachere Art Strom erzeugen will. Wie Helion existiert TAE Technologies schon lange und verspricht schon lange vieles.

Magnetized Target Fusion 💣

– General Fusion (Magnetized Target Fusion) : In eine im Kreis sich drehende Schicht aus flüssigem Metall wird das Fusionsplasma hineingedrückt und mittels Magneten in einem Plasmaring (einem Plasmoid) eingeschlossen, der dann durch Stempel, die den Ring umgeben zusammengedrückt wird bis die Fusionsreaktion einsetzt. Die Fusionsenergie (Strahlung/Wärme) wird in der flüssigen, zirkulierenden Wand aus Metall aufgefangen und über einen Wärmeaustauscher auf eine stromerzeugende Dampfturbine übertragen. Ein gewagter Ansatz, der noch nie experimentell versucht wurde.

Z-Pinch – Experimente ➿: