Schöne, neue, intelligente Welt – wie künstliche Intelligenz uns allen helfen kann

In intelligenten Robotern und Geräten mit künstlicher Intelligenz steckt unheimlich großes Potential, um das Leben der Menschen zum Positiven zu verändern.

Und das beste ist: Das ist gar keine Zukunftsmusik. Es passiert jetzt gerade. Knapp fünf Millionen Haushaltsroboter wurden letztes Jahr verkauft und für 2018 werden 38 Millionen erwartet, prognostizierte Noel Sharkey, einer der Direktoren der Stiftung für verantwortungsvolle Robotics und Teilnehmer der Podiumsdiskussion zu künstlicher Intelligenz beim Heidelberg Laureate Forum.

Haushaltsroboter, die Rasen mähen, beim kochen helfen, im Krankenhaus helfen und alten Menschen Gesellschaft leisten. Es werden nicht nur immer mehr Geräte, sie werden auch immer besser. Holger Schwenk von Facebook Artificial Intelligence Research Paris zitierte Moore’s law und prophezeite, dass bis in 10 Jahren neuronale Netze das menschliche Gehirn mit seinen 10^11 Neuronen und 10^16 Rechenschritten pro Sekunde übertreffen würden.

Genauso wenig, wie Flugzeuge Flügel haben, die genau denen von Vögeln nachgebiet sind, bilde künstliche Intelligenz das Gehirn nach, sondern lasse sich davon inspirieren, dozierte Schwenk.

Die Vorteile der Roboter und die Anwendungen sind beinahe grenzenlos. Sie können zum Beispiel in Coktailbars die Drinks mixen. Oder Hamburger zubereiten. Der Rekord liegt aktuell wohl bei 400 Stück pro Stunde, wie Sharkey meinte. Schlange bei Burgerking und McDonalds ade.

Beim sogenannten “Deep Learning” lernt eine am Anfang recht einfältige Maschine anhand tausender Trainings- und Testdatensätzen zum Beispiel Elemente auf Bildern zu erkennen, und kann so alte Aufnahmen nachkolorieren. Oder Gesichter erkennen. Oder Handschriften lesen (und schreiben). Oder Videos analysieren. In Echtzeit, wie Jim Hendler, einer der Gründer des sogenannten “Semantic Web” vorführte.

Und wenn eine Maschine Videos analysieren und darauf reagieren kann, kann sie das auch ich der realen Welt. Selbstfahrende Autos sind ein Beispiel hierfür. Wenn alle Fahrzeuge autonom führen, gäbe es keine “Phantomstaus” mehr. Ampeln wären überflüssig und der Verkehr an Kreuzungen könnte wie auf dem eingebundenen Video fließen.

Kurzfilm “Rush Hour” von Fernando Livschitz

Künstliche Intelligenz kommt auch im größeren Maßstab zum Einsatz. Vom intelligenten Verkehrsmanagement zu Smart Cities mit Smart Grids, also der dezentralen Produktion und dem intelligenten Verbrauch von Energie. Ein Aspekt der in der Hot Topic Session von Dirk Helbig, Professor für Computational Social Science an der ETH Zürich, nur gestreift wurde.

Smart Watches messen uns mit bis zu sechzehn unterschiedlichen Sensoren aus und planen maßgeschneiderte und potentiell lebensverlängernde Fitnessprograme. Sie schlagen in Ausnahmesituation Alarm und können uns so sogar das Leben retten. Von der Altenpflege bis zur Kinderbetreung. Alles könnte von Robotern und intelligenten Wearbles unterstützt und übernommen werden.

Raj Reddy von der Carnegie Mellon Universität erinnerte ganz zu Anfang der Session an die 3 Milliarden Menschen, die kaum oder gar nicht lesen können und denen daher der Zugang zu moderner Technik verwehrt bleibe.

Jener Teil der Menschheit stelle einen unvorstellbar großen Markt da, der durch Geräte erschlossen werden könnte, die durch künstliche Intelligenz fähig wären, die Benutzer auch ohne Eingabegreäte zu verstehen.

Was für eine neue Welt. Schön wäre sie. Oder?

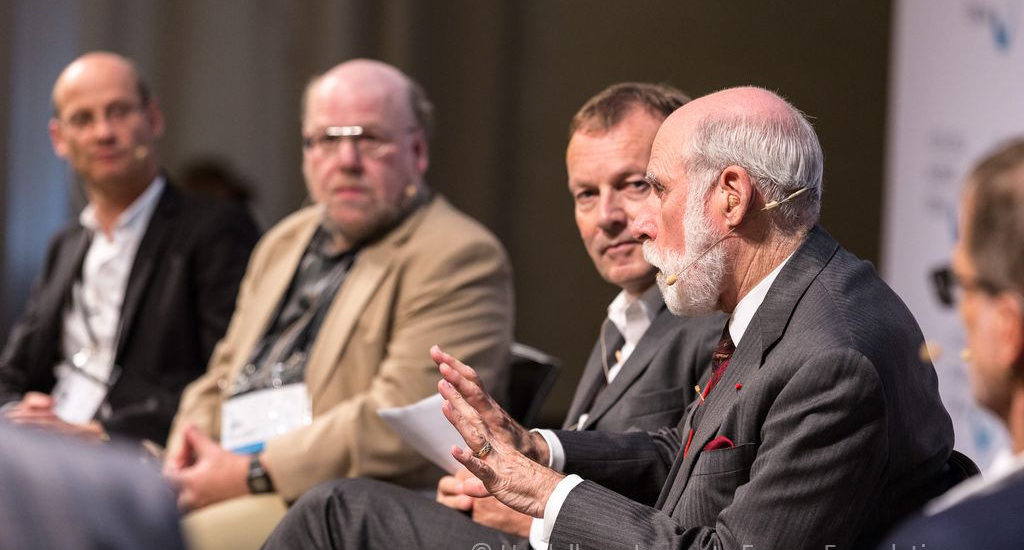

Dieser Artikel ist der erste Teil einer zweiteiligen Serie über die Hot Topic Session zu künstlicher Intelligenz beim vierten Heidelberg Laureate Forum. Die Diskussion wurde von Christoph Drösser moderiert. Auf dem Podium saßen: Vint Cerf, Thomas Dreier, Dirk Helbig, Jim Hendler, Raj Reddy, Holger Schwenk und Noel Sharkey.

Vielleicht ist es nicht mehr weit von (Zitat)

und die trotz Analphabetismus sich dank künstlicher Intelligenz und Spracheingabe an die moderne Welt annabeln können

bis zu einer Welt ohne jede menschliche Schwäche.

wären doch noch viel smarter, wenn es gar keine dummen (ohne Gänsefüsschen) Menschen mehr gäbe sondern nur noch wirklich smarte Bewohner. Smarte Bewohner, so smart, dass sie nur von erneuerbarer Energie leben können, denn während Dunkelflauten (kein Wind,keine Sonne) bleiben sie nach Entladen ihrer Batterie einfach off-World bis dann der nächste Stromstoss sie wieder ins Leben kapatulpiert.

Schöne neue Welt. Was werden die smarten elektrischen Bewohner der smarten Zukunftststädte wohl für eine Art Small Talk betreiben? Das wäre interessant zu wissen, nur kann das vielleicht keiner der heute umherwuselnden Schlabberwesen namens Mensch mehr in Erfahrung bringen – weil es diese Schlabberwesen gar nicht mehr gibt, weil sie durch etwas besseres abgelöst wurden.

Martin Holzherr, ich habe das Gefühl, dass für dich Teil 2 des Artikels interessanter sein dürfte.

Ja, Tobias Meier, ich habe – verführt durch eine paar Formulierungen in diesem Beitrag – eine dystopische Fantasie entwickelt. Deshalb jetzt das Positive:

– Artificial Intelligence im Jahr 2016 bedeutet angesichts der Bestrebungen von Firmen wie Google, Facebook, Apple und den Entwicklern von autonomen Fahrzeugen folgendes: Die Maschine kann nun typisch menschliche Leistungen vollbringen wie Gesichts- und Mustererkennung oder Objektidentifizierung in einer Fotographie (wo ist das Kind, der Affe und das Auto (der BMWi3)). Noch vor 10 Jahren undenkbar – heute Routine

– Es gibt jetzt AI-Standardverfahren, welche aus einem Berg von wenig strukturierten Daten (beispielsweise Fotographien, You-Tube-Sequenzen, Astronomischen Surveys, LHC-Ereignissen) Strukturen und Abläufe herausfiltern können. Zu diesen Verfahren zählen Deep Learning (Nicht oder nur schwach überwachte und gesteurte Merkmalsextraktion über mehrere Hierarchiestufen hinweg (vom Pixel zu Kanten und schliesslich Gesichtern) wobei verschachtelte neuronale Netze zum Zug kommen ) und viele unter Deep Learning subsumierte statistische, probabilistische und von neuronalen Netzen her bekannte Verfahren.

– Es gibt Aussicht auf deutliche Leistungssteigerungen von Verfahren der künstlichen Intelligenz wie dem Deep Learning, wenn sich die Hardware entsprechend verbessert – entweder durch schnellere und mehr Prozessoren oder durch spezialisierte Hardwarearchitekturen. Grund: Deep Learning – Techniken zeigen mit zunehmender Trainingszeit kaum eine Plateaubildung, sondern es ergeben sich stetig bessere Erkennungsleistungen je länger die Trainingszeit dauert.

– Allein schon die bestehenden AI-Verfahren können in immer mehr Anwendungsbereiche eindringen, wobei viele alltagsnahe Anwendungen denkbar sind.

Es gibt aber auch starke Beschränkungen in bestehender AI: Das semantische Verständnis von heutigen AI-Systemen ist sehr beschränkt. Sie können keine Schlussfolgerungen ziehen, die mehrere Domänen einschliessen. Ein mit Deep-Learning trainierter Bereich kann nicht mit anderen kommunizieren. Es gibt auch kein AI-System welches menschliche Sprache auf solch tiefe Art versteht wie wir Menschen es tun (wir hören auch Nebenbedeutungen, Konsequenzen, Einstellungen und Haltungen aus sprachlichen Äusserungen heraus).

Wenn im obigen Artikel davon gesprochen wird, Roboter würden bald Einzug in jeden Haushalt nehmen, so stimmt das vielleicht für spezialisierte Roboter wie autonome Staubsauger und autonome Rasenmäher. Es wird aber auch absehbare Zeit keine Roboter geben, die eine Haushalt führen können inklusive Einkaufen, Kochen, Bettenmachen, Aufräumen etc.

Fazit: AI-Software kann nun früher Menschen vorbehaltene Tätigkeiten ausführen. Zudem kann sie mit grossen Datenmengen umgehen und darin Strukturen und Muster erkennen. AI-Software fehlt aber bis heute ein tieferes semantisches Verständnis weswegen es bis auf weiteres keine Roboter geben wird welche die Kompetenz eines Butlers oder Hausdieners erreichen werden.